구글 AI 영상이 또 멋지네요! 올인원 범용 비주얼 인코더 VideoPrism, 30가지 SOTA 성능 기능 업데이트

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB앞으로

- 2024-02-26 09:58:241341검색

AI 영상모델 소라가 인기를 얻은 이후 메타, 구글 등 주요 기업들은 한 발 물러나 연구하고 OpenAI를 따라잡았습니다.

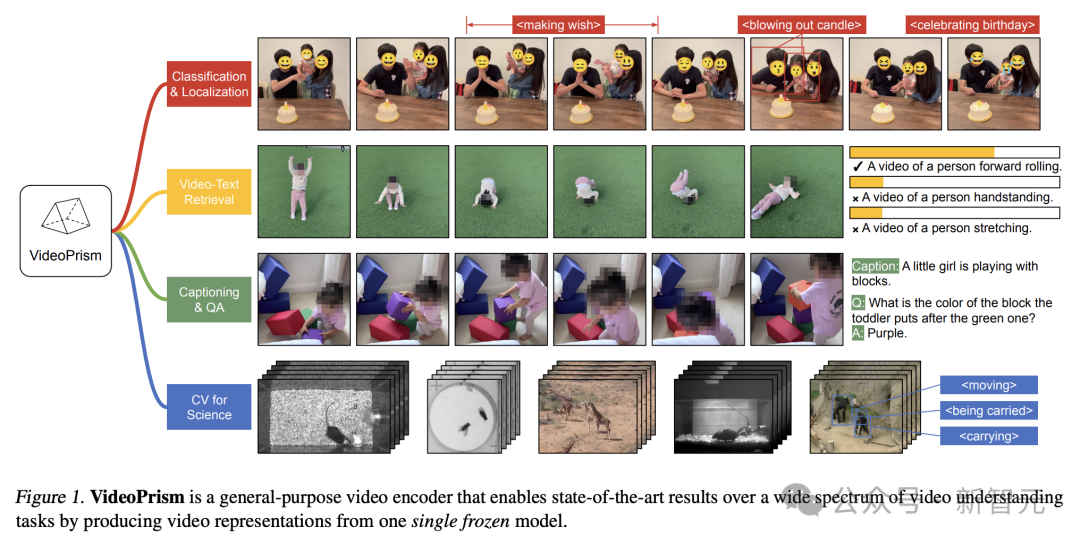

최근 Google 팀의 연구원들은 범용 비디오 인코더인 VideoPrism을 제안했습니다.

단일 동결 모델을 통해 다양한 영상 이해 작업을 처리할 수 있습니다.

Pictures

Pictures

문서 주소: https://arxiv.org/pdf/2402.13217.pdf

예를 들어 VideoPrism은 아래 동영상에서 촛불을 불고 있는 사람들을 분류하고 위치를 찾을 수 있습니다.

Pictures

Pictures

비디오 텍스트 검색, 텍스트 내용을 기반으로 비디오의 해당 콘텐츠를 검색할 수 있습니다.

Pictures

Pictures

또 다른 예를 들어 아래 비디오를 설명해보세요. 어린 소녀가 빌딩 블록을 가지고 놀고 있습니다.

QA 질문과 답변도 진행할 수 있습니다.

- 녹색 블록 위에 놓인 블록은 무슨 색인가요?

- 보라색.

Pictures

Pictures

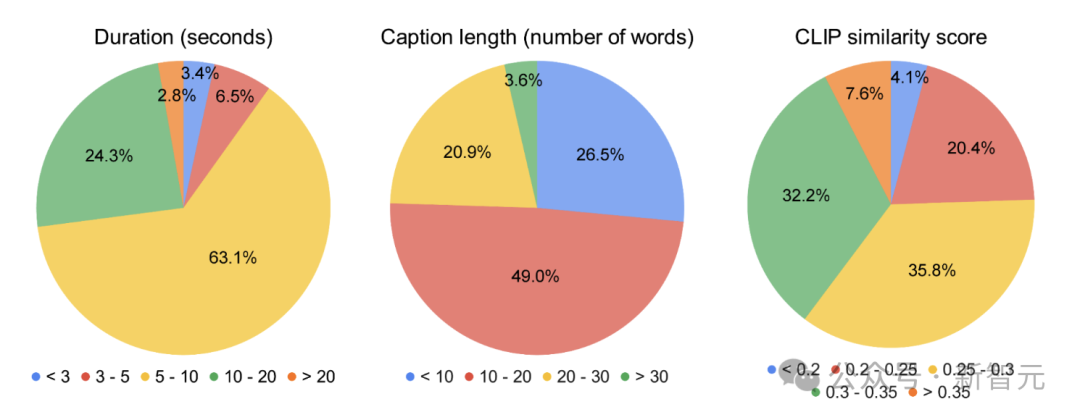

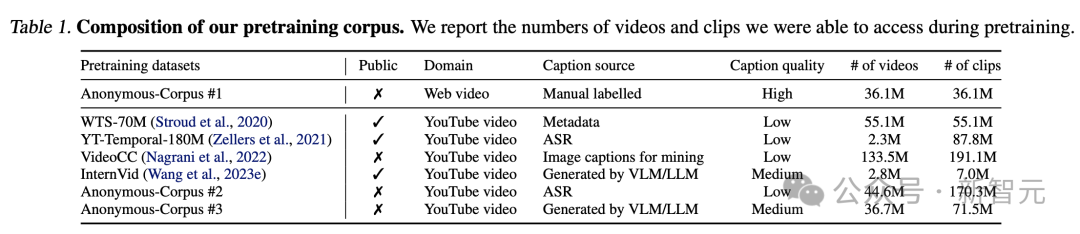

연구원들은 3,600만 개의 고품질 비디오 자막 쌍과 잡음이 있는 병렬 텍스트(예: ASR 전사 텍스트)가 포함된 5억 8,200만 개의 비디오 클립을 포함하는 이기종 코퍼스에서 VideoPrism을 사전 훈련했습니다.

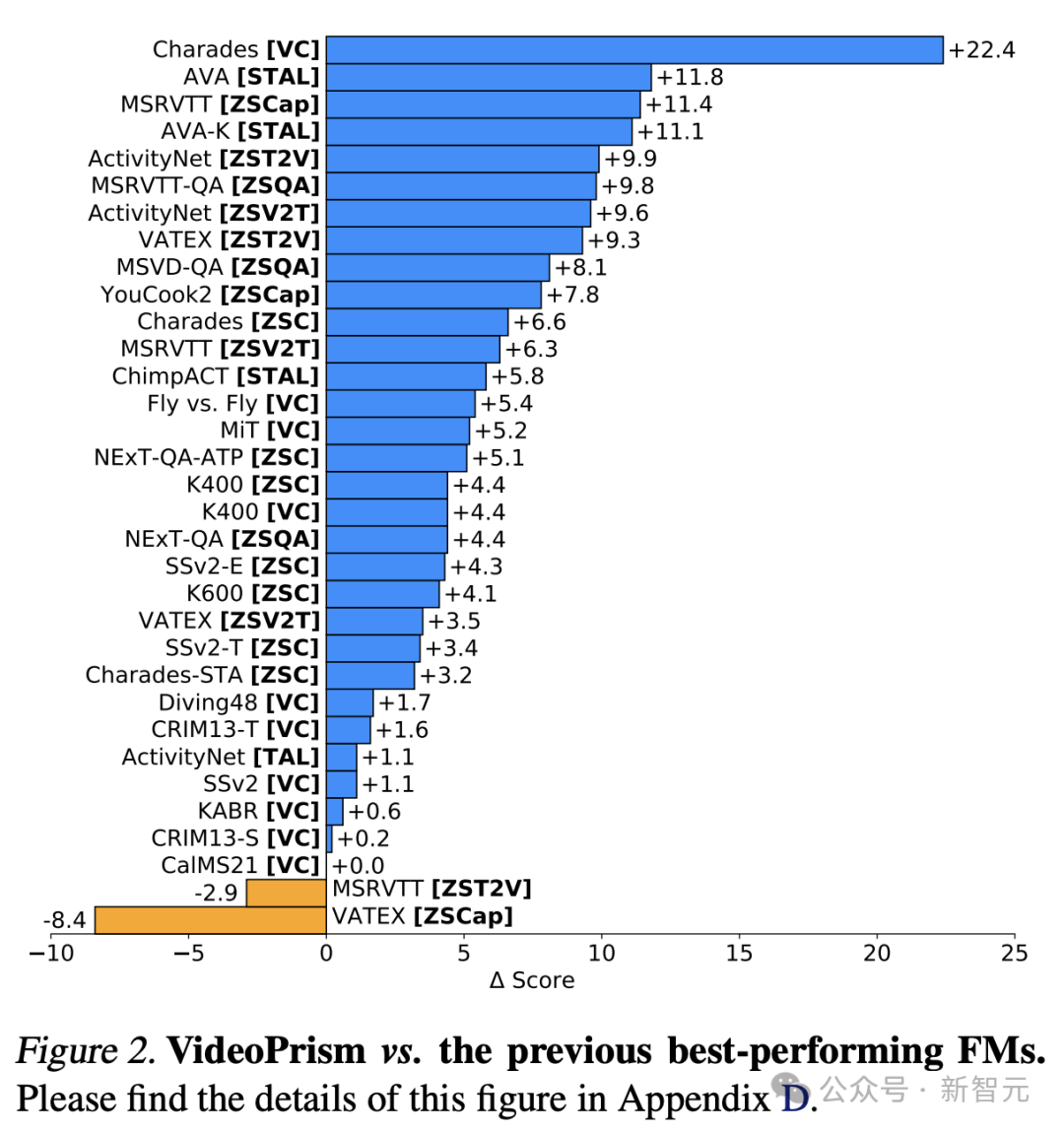

VideoPrism이 33개의 비디오 이해 벤치마크 테스트에서 30개의 SOTA를 갱신했다는 점은 언급할 가치가 있습니다.

Pictures

Pictures

Universal Visual Encoder VideoPrism

현재 ViFM(비디오 기반 모델)은 거대한 말뭉치 전반에 걸쳐 새로운 기능을 잠금 해제할 수 있는 엄청난 잠재력을 가지고 있습니다.

이전 연구는 일반적인 영상 이해에 있어 큰 진전을 이루었지만, 진정한 '기본 영상 모델'을 구축하는 것은 여전히 어려운 목표입니다.

이에 대응하여 Google은 분류, 현지화, 검색, 자막, 질문 답변(QA)을 포함한 광범위한 비디오 이해 작업을 해결하도록 설계된 범용 시각적 인코더인 VideoPrism을 출시했습니다.

VideoPrism은 CV 데이터세트는 물론 신경과학, 생태학과 같은 과학 분야의 CV 작업에 대해서도 광범위하게 평가됩니다.

단일 냉동 모델을 사용하여 최소한의 체력으로 최첨단 성능을 달성하세요.

또한 Google 연구원들은 이 고정 인코더 설정이 이전 연구를 동시에 따르며 실용적인 실용성뿐만 아니라 높은 계산 비용과 비디오 모델 미세 조정을 고려했다고 말합니다.

Pictures

Pictures

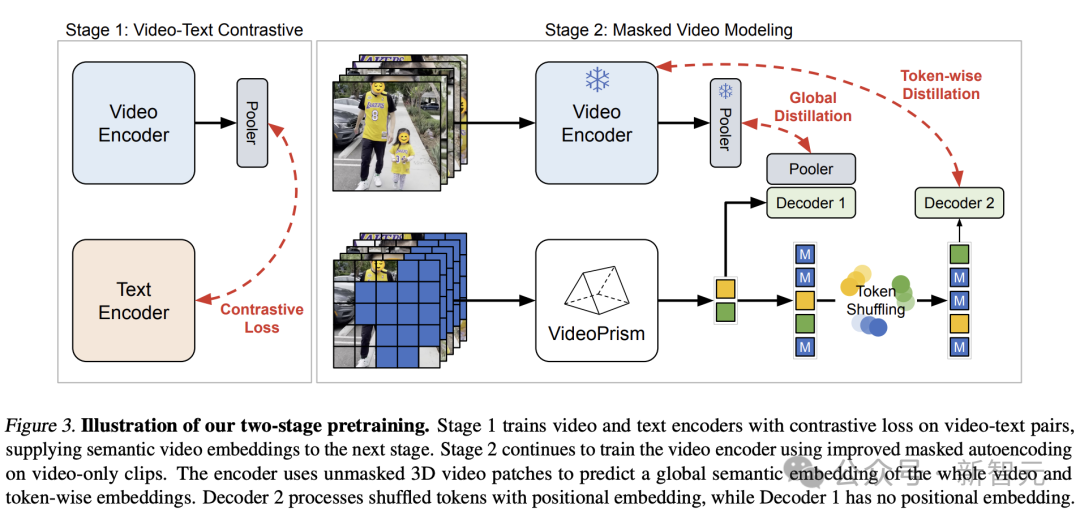

디자인 구조, 2단계 학습 방법

VideoPrism의 디자인 컨셉은 다음과 같습니다.

사전 학습 데이터는 기본 모델(FM)의 기초입니다. ViFM에 이상적인 사전 학습 데이터는 전 세계 모든 동영상의 대표 샘플입니다.

이 샘플에서는 대부분의 동영상에 콘텐츠를 설명하는 평행 텍스트가 없습니다.

그러나 이러한 텍스트를 학습하면 비디오 공간에 대한 귀중한 의미론적 단서를 제공할 수 있습니다.

따라서 Google의 사전 학습 전략은 주로 비디오 모드에 초점을 맞추면서 사용 가능한 비디오-텍스트 쌍을 최대한 활용해야 합니다.

데이터 측면에서 Google 연구원은 3,600만 개의 고품질 비디오 자막 쌍과 시끄러운 병렬 텍스트(예: ASR 전사본, 생성된 자막 및 검색된 텍스트) 코퍼스가 포함된 5억 8,200만 개의 비디오 클립을 풀링하여 필요한 사전 학습을 대략적으로 계산했습니다.

사진

사진

Pictures

Pictures

모델링 측면에서 저자는 먼저 다양한 품질의 모든 비디오-텍스트 쌍에서 의미론적 비디오 임베딩을 비교 학습합니다.

그런 다음 시맨틱 임베딩은 전역적으로 지정되고 광범위한 순수 비디오 데이터를 사용하여 정제된 레이블이 지정되어 아래 설명된 마스크된 비디오 모델링을 개선합니다.

자연어에서의 성공에도 불구하고 마스크된 데이터 모델링은 원시 시각적 신호의 의미론 부족으로 인해 CV에 여전히 어려운 과제입니다.

기존 연구에서는 간접적인 의미론(예: CLIP을 사용하여 모델이나 토크나이저를 안내하거나 암시적 의미론을 사용하여 이 과제를 해결함)을 차용하거나 이를 암시적으로 일반화(예: 시각적 패치 라벨 지정)하여 높은 마스킹 속도와 경량성을 결합합니다.

위 아이디어를 바탕으로 Google 팀은 사전 학습 데이터를 기반으로 한 2단계 접근 방식을 채택했습니다.

Pictures

Pictures

첫 번째 단계에서는 모든 비디오-텍스트 쌍을 사용하여 비디오 인코더와 텍스트 인코더를 정렬하는 대조 학습이 수행됩니다.

이전 연구를 바탕으로 Google 팀은 대칭 교차 엔트로피 손실 최소화를 수행하여 배치의 모든 비디오-텍스트 쌍의 유사성 점수를 최소화했습니다.

그리고 CoCa의 이미지 모델을 사용하여 공간 인코딩 모듈을 초기화하고 WebLI를 사전 학습에 통합합니다.

손실을 계산하기 전에 MAP(Multi-Head Attention Pooling)을 통해 비디오 인코더의 기능을 집계합니다.

이 단계에서는 비디오 인코더가 언어 감독으로부터 풍부한 시각적 의미를 학습할 수 있으며, 결과 모델은 두 번째 단계 훈련을 위한 의미 비디오 임베딩을 제공합니다.

Pictures

Pictures

두 번째 단계에서는 인코더가 계속 훈련되고 두 가지 개선이 이루어집니다.

- 모델은 마스크되지 않은 입력 비디오를 기반으로 첫 번째 단계의 비디오 수준 글로벌 임베딩 및 토큰을 예측해야 합니다. 패치 삽입

- 인코더의 출력 토큰은 단축키 학습을 피하기 위해 디코더로 전달되기 전에 무작위로 섞입니다.

특히 연구원들의 사전 훈련은 비디오의 텍스트 설명과 상황에 따른 자체 감독이라는 두 가지 감독 신호를 활용하여 VideoPrism이 외모 및 행동 중심 작업에서 좋은 성능을 발휘할 수 있도록 합니다.

실제로 이전 연구에 따르면 비디오 캡션은 주로 외모 단서를 드러내는 반면 상황에 맞는 감독은 행동 학습에 도움이 되는 것으로 나타났습니다.

Pictures

Pictures

실험 결과

다음으로 연구원들은 광범위한 비디오 중심 이해 작업에서 VideoPrism을 평가하여 그 기능과 일반성을 입증했습니다.

주로 다음 네 가지 범주로 나뉩니다.

(1) 일반적으로 분류 및 시공간 위치 지정을 포함한 영상 이해만

(2) 제로샷 비디오 텍스트 검색

(3) 제로샷 비디오 자막 및 품질 검사

(4 ) 과학의 CV 작업

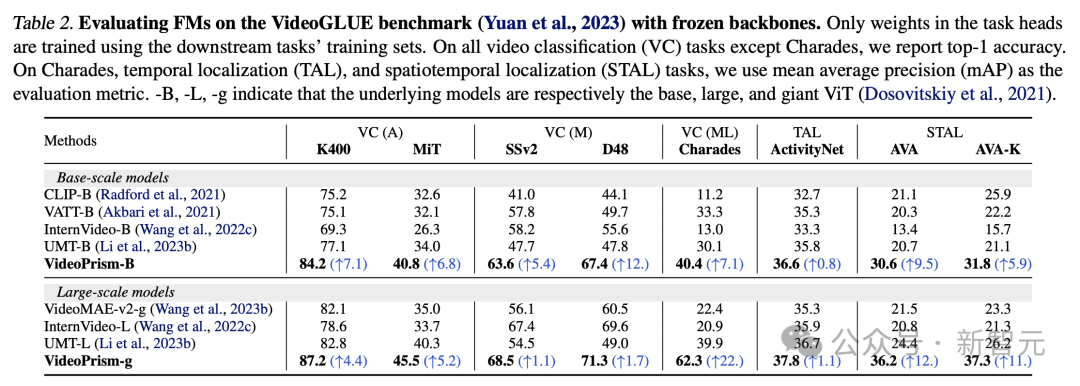

분류 및 시공간 위치 파악

표 2는 VideoGLUE의 동결된 백본 결과를 보여줍니다.

VideoPrism은 모든 데이터 세트의 기준보다 훨씬 뛰어난 성능을 발휘합니다. 또한 VideoPrism의 기본 모델 크기를 ViT-B에서 ViT-g로 늘리면 성능이 크게 향상됩니다.

모든 벤치마크에서 두 번째로 좋은 결과를 달성한 기준 방법은 없다는 점은 주목할 가치가 있습니다. 이는 이전 방법이 비디오 이해의 특정 측면을 목표로 개발되었을 수 있음을 시사합니다.

그리고 VideoPrism은 이러한 광범위한 작업을 계속해서 개선하고 있습니다.

이 결과는 VideoPrism이 다양한 비디오 신호를 하나의 인코더에 통합한다는 것을 보여줍니다. 즉, 여러 입도의 의미, 모양 및 모션 큐, 시공간 정보, 다양한 비디오 소스(예: 온라인 비디오 및 대본 공연)에 대한 견고성입니다.

이미지

이미지

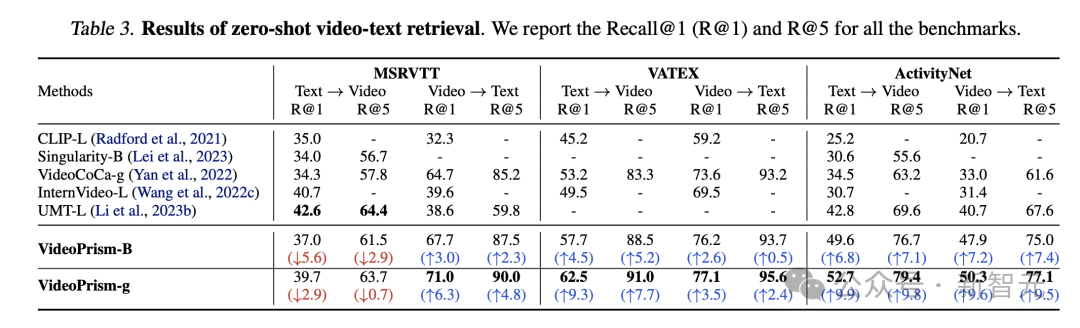

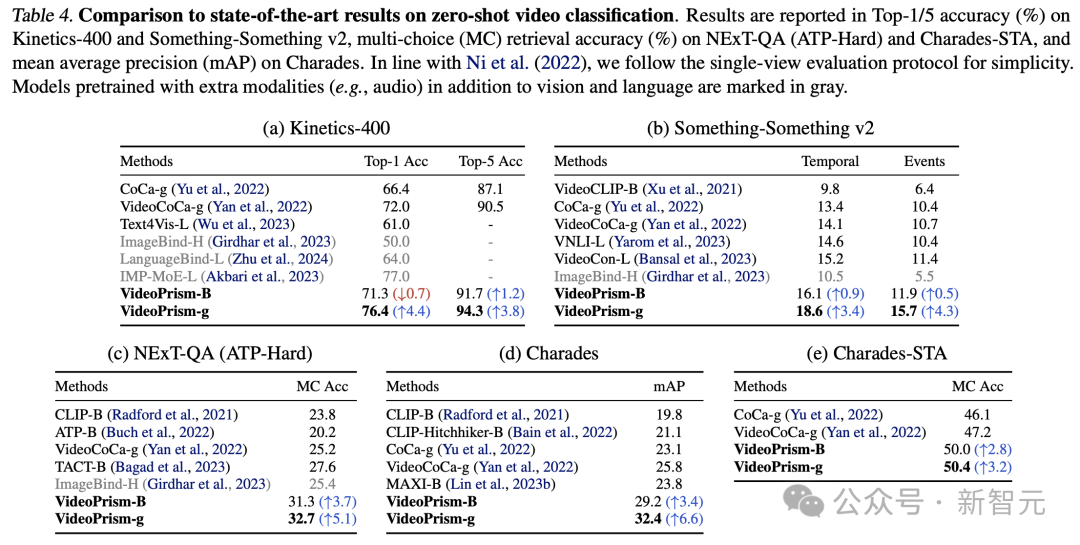

제로샷 비디오 텍스트 검색 및 분류

표 3과 표 4는 각각 비디오 텍스트 검색 및 비디오 분류 결과를 요약합니다.

VideoPrism의 성능은 여러 벤치마크를 갱신하며 까다로운 데이터 세트에서 VideoPrism은 이전 기술에 비해 매우 중요한 개선을 달성했습니다.

Pictures

Pictures

기본 모델 VideoPrism-B에 대한 대부분의 결과는 실제로 기존 대형 모델보다 성능이 뛰어납니다.

게다가 VideoPrism은 도메인 내 데이터와 추가 양식(예: 오디오)을 사용하여 사전 훈련된 표 4의 모델과 비슷하거나 훨씬 더 뛰어납니다. 제로샷 검색 및 분류 작업의 이러한 개선은 VideoPrism의 강력한 일반화 기능을 반영합니다.

Pictures

Pictures

제로 샘플 영상 자막 및 품질 확인

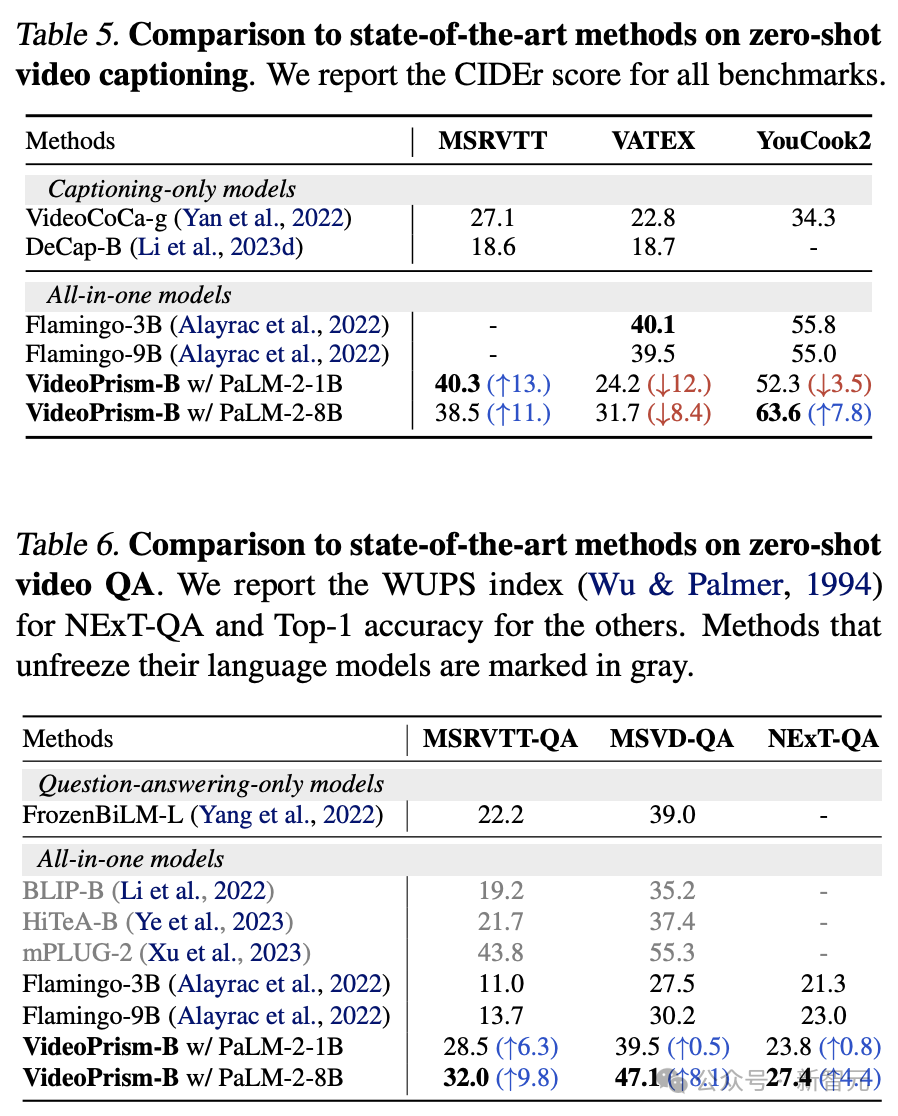

표 5와 표 6은 각각 제로 샘플 영상 자막과 QA 결과를 보여줍니다.

간단한 모델 아키텍처와 소수의 어댑터 매개변수에도 불구하고 최신 모델은 여전히 경쟁력이 있으며 VATEX를 제외하고는 시각적 및 언어 모델을 동결하는 최고의 방법 중 하나입니다.

결과는 VideoPrism 인코더가 비디오-음성 생성 작업에 잘 일반화된다는 것을 보여줍니다.

사진

사진

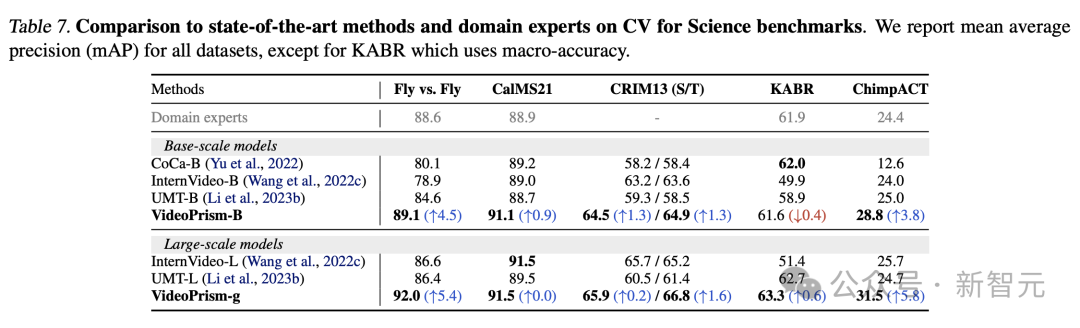

과학 영역의 CV 작업

Universal ViFM은 모든 평가에서 공유 고정 인코더를 사용하며 단일 작업 전용 도메인별 모델과 비슷한 성능을 제공합니다.

특히 VideoPrism은 기본 규모 모델을 사용하여 도메인 전문가 모델보다 최고의 성능을 발휘하는 경우가 많습니다.

대규모 모델로 확장하면 모든 데이터 세트의 성능을 더욱 향상시킬 수 있습니다. 이러한 결과는 ViFM이 다양한 분야에서 비디오 분석을 크게 가속화할 수 있는 잠재력을 가지고 있음을 보여줍니다.

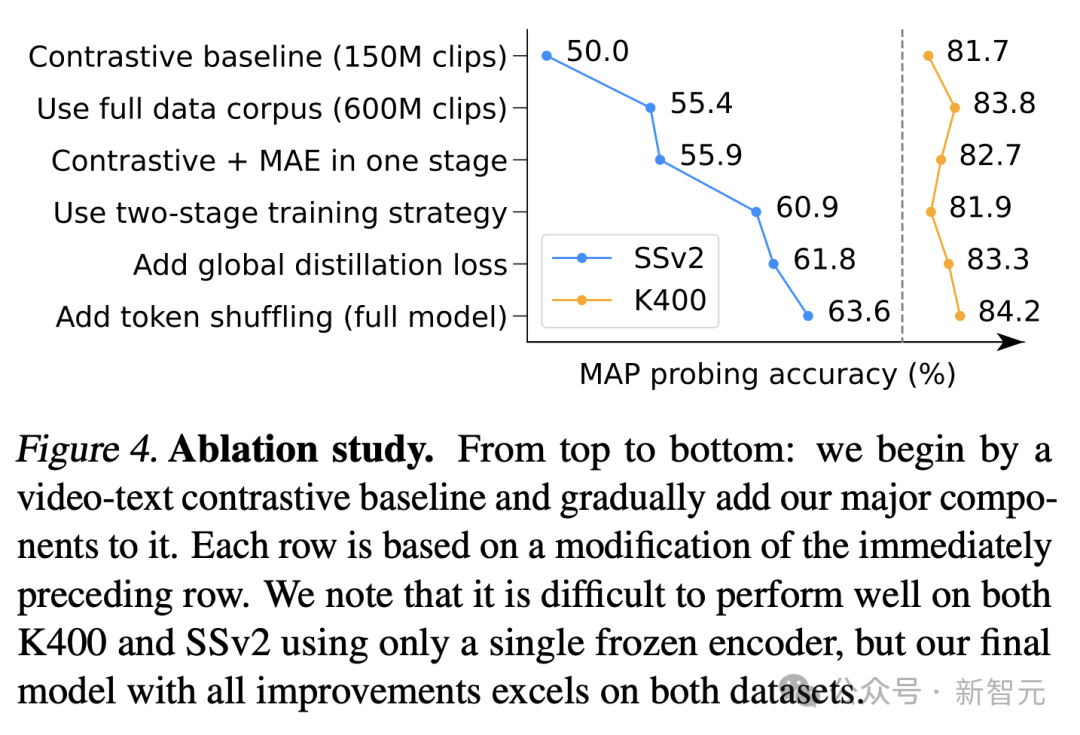

절제 연구

그림 4는 절제 결과를 보여줍니다. 특히 SSv2에 대한 VideoPrism의 지속적인 개선은 비디오의 동작 이해를 촉진하는 데 있어 데이터 관리 및 모델 설계 노력의 효율성을 입증합니다.

비교 기준선은 이미 K400에서 경쟁력 있는 결과를 달성했지만 제안된 글로벌 증류 및 토큰 셔플링은 정확성을 더욱 향상시킵니다.

Pictures

Pictures

참고자료:

https://arxiv.org/pdf/2402.13217.pdf

https://blog.research.google/2024/02/videoprism-foundational-visual-encoder .html

위 내용은 구글 AI 영상이 또 멋지네요! 올인원 범용 비주얼 인코더 VideoPrism, 30가지 SOTA 성능 기능 업데이트의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!