머신러닝의 ReLU 기능 이해

- 王林앞으로

- 2024-01-22 22:36:102060검색

ReLU 기능이란 무엇인가요?

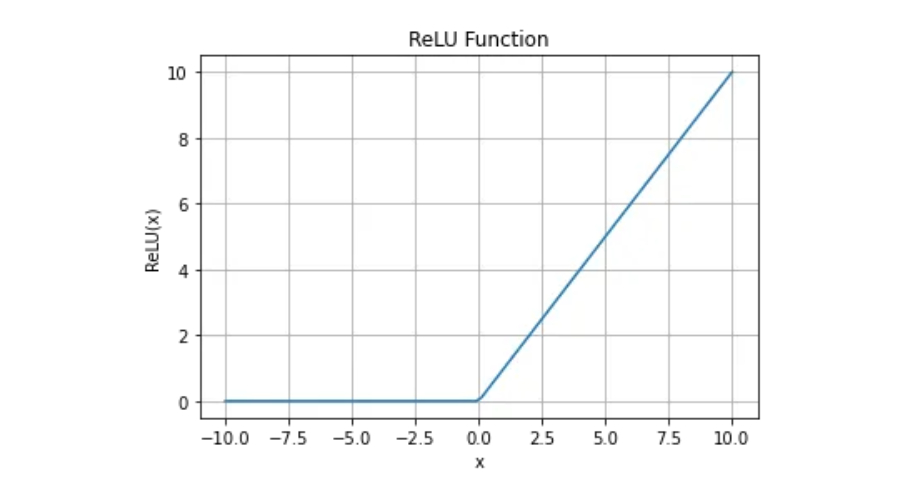

ReLU 함수는 f(x)=max(0,x)로 정의되는 수학 함수입니다. 여기서 x는 실수입니다. 간단히 말해서, x가 0보다 작거나 같으면 함수는 0을 반환합니다. 그렇지 않으면 x를 반환합니다.

ReLU 함수의 연속성과 미분성

미분 가능 함수의 경우 먼저 연속이어야 합니다. ReLU 함수는 연속성 요구 사항을 충족하지만 x=0에서의 도함수는 존재하지 않으므로 이 시점에서는 ReLU 함수를 미분할 수 없습니다.

그렇다면 ReLU 함수가 아직도 딥러닝에 사용되는 이유는 무엇일까요?

ReLU 함수는 x=0에서 미분 가능하지 않지만 최적화 알고리즘을 미세 조정하면 딥러닝에 적용할 수 있습니다. 경사하강법은 비용 함수를 최소화하는 데 사용되는 최적화 알고리즘입니다. ReLU 함수에 x=0에서 정의된 도함수가 없으면 이를 0이나 다른 값으로 설정하고 최적화 프로세스를 계속할 수 있습니다. 이러한 방식으로 ReLU 함수의 비선형 특성을 활용하여 딥러닝 모델의 성능을 향상시킬 수 있습니다.

일반적으로 ReLU 활성화 함수는 딥러닝 네트워크에서 가장 널리 사용되는 활성화 함수 중 하나입니다. 단순성과 높은 계산 효율성으로 인해 훈련 중 수렴을 향상시키는 중요한 도구입니다. x=0에서는 미분할 수 없지만 경사하강법 적용에는 영향을 미치지 않습니다. 따라서 ReLU 기능은 기계 학습 분야에서 다양하고 강력한 도구입니다.

ReLU 함수의 장점

1. 간단한 계산.

정류기 함수는 구현이 매우 간단하며 max() 함수가 필요합니다.

2. 표현 희소성

희소 표현은 학습 속도를 높이고 모델을 단순화하는 데 도움이 되기 때문에 표현 학습에서 바람직한 속성입니다. 이를 통해 신경망의 숨겨진 계층 활성화에 하나 이상의 실제 0 값이 포함될 수 있습니다. 이는 음수 입력도 실제 0 값을 출력할 수 있음을 의미합니다. 이 기능을 통해 신경망은 대규모 데이터를 더 효과적으로 처리하고 컴퓨팅 및 스토리지 리소스의 필요성을 줄일 수 있습니다. 따라서 희소 표현은 신경망의 성능과 효율성을 최적화하는 데 매우 중요합니다.

3. 선형 동작

정류기 함수는 선형 활성화 함수와 비슷하게 보이고 동작합니다. 선형 또는 선형에 가까운 동작의 최적화에 적합합니다.

위 내용은 머신러닝의 ReLU 기능 이해의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!