SAM을 사용하여 안정적인 다중 모드 3D 감지를 위한 RoboFusion

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB앞으로

- 2024-01-16 14:03:211267검색

논문 링크: https://arxiv.org/pdf/2401.03907.pdf

Multi-modal 3D detector는 안전하고 신뢰할 수 있는 자율주행 인식 시스템을 연구하기 위해 설계되었습니다. 깨끗한 벤치마크 데이터 세트에서 최첨단 성능을 달성하지만 실제 환경의 복잡성과 가혹한 조건은 종종 무시됩니다. 동시에 VFM(Vision Foundation Model)의 출현으로 다중 모드 3D 감지의 견고성과 일반화 기능을 향상시키는 것은 자율 주행에서 기회와 과제에 직면해 있습니다. 따라서 저자는 SAM과 같은 VFM을 활용하여 OOD(배포 외) 소음 시나리오를 해결하는 RoboFusion 프레임워크를 제안합니다.

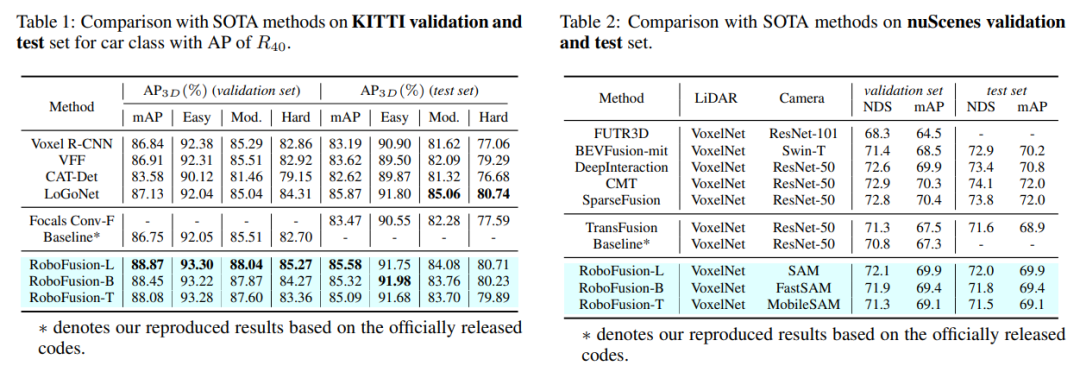

먼저 SAM-AD라는 자율주행 시나리오에 원본 SAM을 적용합니다. SAM 또는 SAMAD를 다중 모달 방법과 정렬하기 위해 AD-FPN을 도입하여 SAM에서 추출한 이미지 특징을 업샘플링합니다. 소음과 기상 간섭을 더욱 줄이기 위해 웨이블릿 분해를 사용하여 깊이 안내 이미지의 소음을 제거합니다. 마지막으로, 과도한 노이즈를 억제하면서 유익한 기능을 향상시키기 위해 융합된 기능에 적응적으로 가중치를 다시 부여하는 self-attention 메커니즘을 사용합니다. RoboFusion은 VFM의 일반화와 견고성을 활용하여 점차적으로 소음을 줄여 다중 모드 3D 객체 감지의 탄력성을 향상시킵니다. 결과적으로 RoboFusion은 KITTIC 및 nuScenes-C 벤치마크 결과에 따라 시끄러운 장면에서 최첨단 성능을 달성합니다.

이 논문에서는 SAM과 같은 VFM을 활용하여 깨끗한 장면에서 OOD 시끄러운 장면에 이르기까지 3D 다중 모드 객체 감지기를 적용하는 RoboFusion이라는 강력한 프레임워크를 제안합니다. 그 중에서도 SAM의 적응 전략이 핵심이다.

1) 분할 결과를 추론하는 대신 SAM에서 추출된 특징을 사용합니다.

2) AD 시나리오를 위해 사전 훈련된 SAM인 SAM-AD가 제안되었습니다.

3) VFM을 다중 모드 3D 검출기와 정렬하기 위한 특징 업샘플링 문제를 해결하기 위해 새로운 AD-FPN이 도입되었습니다.

잡음 간섭을 줄이고 신호 특성을 유지하기 위해 DGWA(Deep Guided Wavelet Attention) 모듈이 도입되어 고주파 및 저주파 잡음을 효과적으로 감쇠합니다.

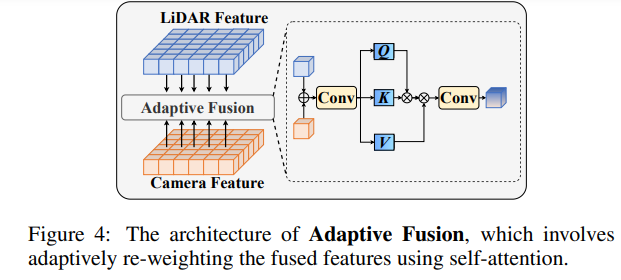

포인트 클라우드 기능과 이미지 기능을 융합한 후 적응형 융합을 통해 기능의 가중치를 다시 조정하여 기능의 견고성과 노이즈 저항성을 향상합니다.

RoboFusion 네트워크 구조

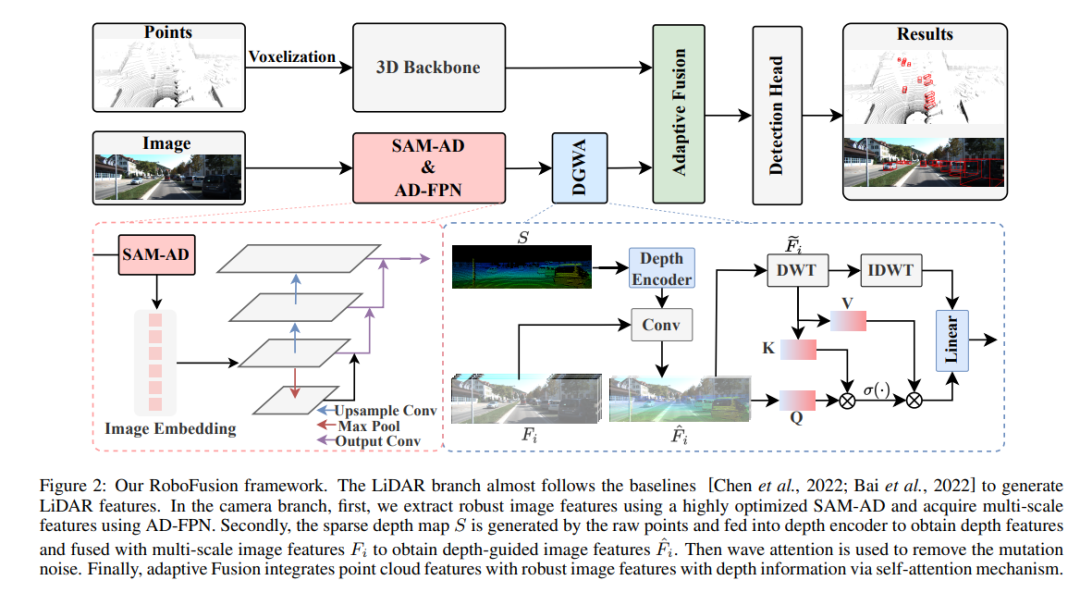

RoboFusion 프레임워크는 아래에 나와 있으며, 해당 LiDAR 분기는 기준선 [Chen et al., 2022; Bai et al., 2022]을 따라 LiDAR 기능을 생성합니다. 카메라 부문에서는 고도로 최적화된 SAM-AD 알고리즘을 먼저 사용하여 강력한 이미지 특징을 추출하고 AD-FPN과 결합하여 다중 규모 특징을 얻습니다. 다음으로, 원본 포인트를 사용하여 희소 깊이 맵(S)을 생성하고, 이를 깊이 인코더에 입력하여 깊이 특징을 얻고, 멀티스케일 영상 특징과 융합하여 깊이 유도 영상 특징을 얻습니다. 그런 다음 변동 주의 메커니즘을 통해 돌연변이 노이즈가 제거됩니다. 마지막으로, 적응형 융합은 포인트 클라우드 기능과 깊이 정보가 있는 강력한 이미지 기능을 결합하는 Self-Attention 메커니즘을 통해 달성됩니다.

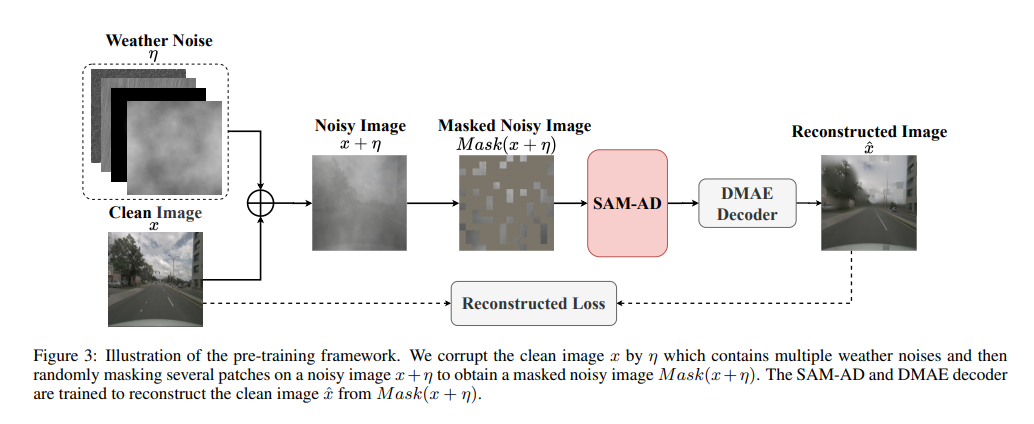

SAM-AD: SAM을 AD(자율 주행) 시나리오에 추가로 적용하기 위해 SAM은 SAM-AD를 획득하도록 사전 훈련됩니다. 구체적으로, 성숙한 데이터 세트(예: KITTI 및 nuScenes)에서 다수의 이미지 샘플을 수집하여 기본 AD 데이터 세트를 구성합니다. DMAE 이후 SAM은 그림 3과 같이 AD 시나리오에서 SAM-AD를 얻도록 사전 훈련됩니다. x를 AD 데이터 세트(예: KITTI 및 nuScenes)의 깨끗한 이미지로 표시하고 eta를 x를 기반으로 생성된 노이즈 이미지로 표시합니다. 소음 유형과 심각도는 각각 4가지 기상 조건(즉, 비, 눈, 안개, 햇빛)과 1~5까지의 5가지 심각도 수준에서 무작위로 선택되었습니다. MobileSAM의 이미지 인코더인 SAM을 인코더로 사용하는 반면 디코더 및 재구성 손실은 DMAE와 동일합니다.

AD-FPN. 큐 가능한 분할 모델인 SAM은 이미지 인코더, 큐 인코더 및 마스크 디코더의 세 부분으로 구성됩니다. 일반적으로 VFM을 학습하려면 이미지 인코더를 일반화한 다음 디코더를 학습해야 합니다. 즉, 이미지 인코더는 다운스트림 모델에 고품질의 강력한 이미지 임베딩을 제공할 수 있는 반면, 마스크 디코더는 의미론적 분할을 위한 디코딩 서비스만 제공하도록 설계되었습니다. 게다가 우리에게 필요한 것은 큐 인코더에 의한 큐 정보 처리보다는 강력한 이미지 기능입니다. 따라서 우리는 강력한 이미지 특징을 추출하기 위해 SAM의 이미지 인코더를 사용합니다. 그러나 SAM은 ViT 시리즈를 이미지 인코더로 활용하여 다중 스케일 기능을 배제하고 고차원 저해상도 기능만 제공합니다. [Li et al., 2022a]에서 영감을 받아 표적 탐지에 필요한 다중 규모 기능을 생성하기 위해 ViT를 기반으로 다중 규모 기능을 제공하는 AD-FPN이 설계되었습니다!

견고한 이미지 특징을 추출하는 SAM-AD 또는 SAM의 능력에도 불구하고 2D 도메인과 3D 도메인 사이의 격차는 여전히 존재하며 손상된 환경에서 기하학적 정보가 부족한 카메라는 종종 노이즈를 증폭시키고 부정적인 전송 문제를 유발합니다. 이러한 문제를 완화하기 위해 우리는 DGWA(Deep Guided Wavelet Attention) 모듈을 제안하는데, 이는 다음 두 단계로 나눌 수 있습니다. 1) 깊이 안내 네트워크는 이미지 특징과 포인트 클라우드의 깊이 특징을 결합하여 이미지 특징 전에 기하학을 추가하도록 설계되었습니다. 2) Haar 웨이블릿 변환을 사용하여 이미지의 특징을 4개의 하위 대역으로 분해한 다음 Attention 메커니즘을 통해 하위 대역의 정보 특징에 대한 노이즈를 제거할 수 있습니다!

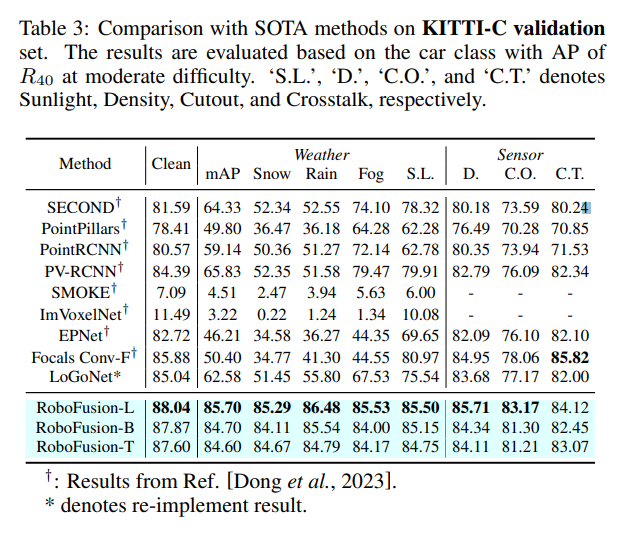

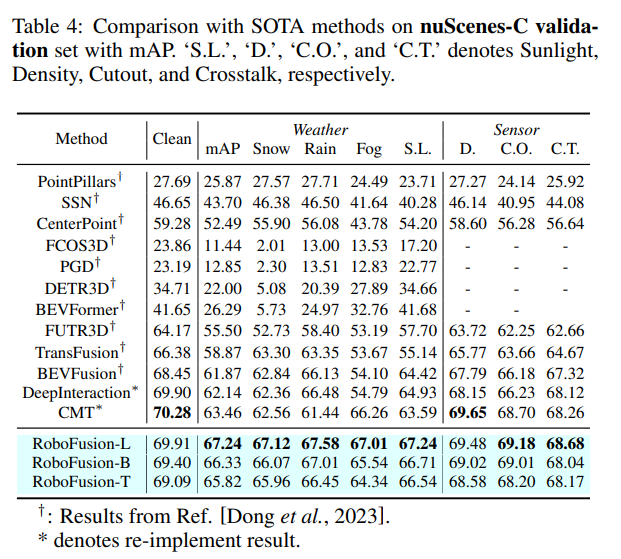

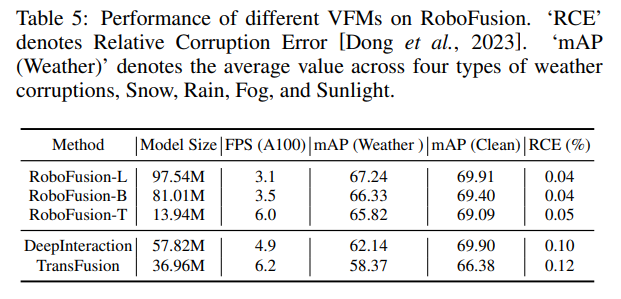

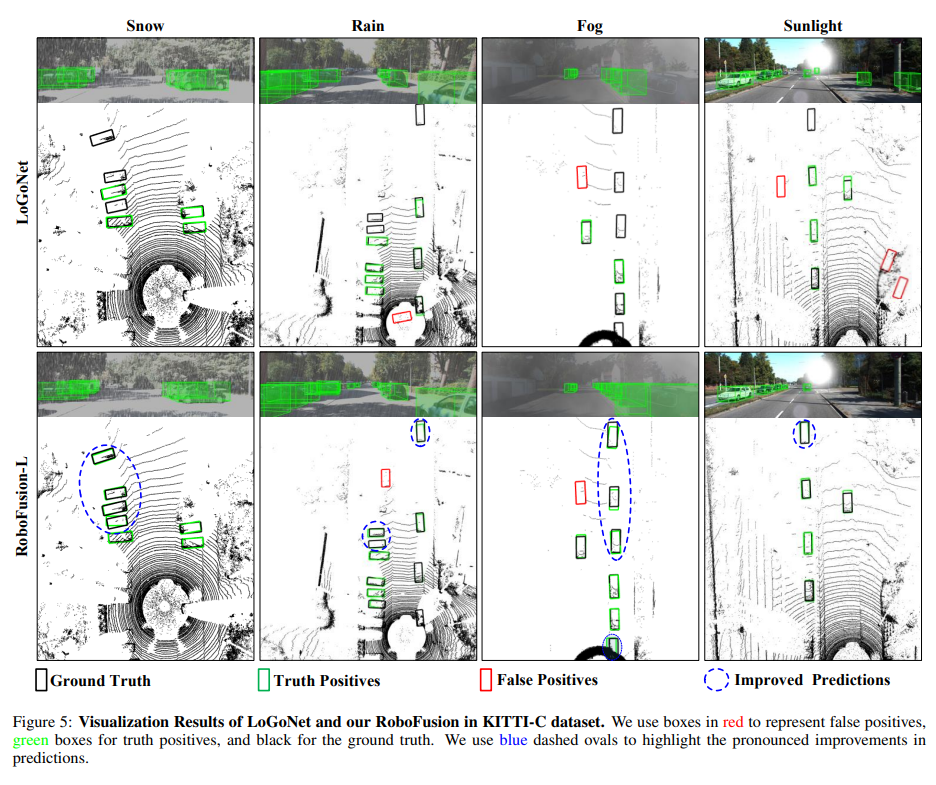

실험적 비교

원본 링크: https://mp.weixin.qq.com/s/7 8y1 KyipHeUSh5sLQZy-ng

위 내용은 SAM을 사용하여 안정적인 다중 모드 3D 감지를 위한 RoboFusion의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!