Alibaba의 새로운 mPLUG-Owl 업그레이드는 두 세계의 장점을 모두 갖추고 있으며 모달 협업을 통해 MLLM의 새로운 SOTA가 가능해졌습니다.

OpenAI GPT-4V와 Google Gemini는 모두 매우 강력한 다중 모드 이해 기능을 입증했으며 MLLM(다중 모드 대형 모델)의 신속한 개발을 촉진했으며 업계에서 가장 인기 있는 연구 방향이 되었습니다.

MLLM은 다양한 시각-언어 개방형 과제에서 뛰어난 지시 따르기 능력을 달성했습니다. 다중 모드 학습에 대한 이전 연구에서 서로 다른 양식이 서로 협력하고 촉진할 수 있다는 것이 밝혀졌지만 기존 MLLM 연구는 주로 다중 모드 작업의 능력을 향상하고 모드 협업의 이점과 모드 간섭의 영향 사이의 균형을 맞추는 방법에 중점을 둡니다. 그 문제를 해결해야합니다.

논문을 보려면 다음 링크를 클릭하세요: https://arxiv.org/pdf/2311.04257.pdf

다음 코드 주소를 확인하세요: https://github.com/X -PLUG/mPLUG -Owl/tree/main/mPLUG-Owl2

ModelScope 체험 주소: https://modelscope.cn/studios/damo/mPLUG-Owl2/summary

HuggingFace 체험 주소 링크: https: //huggingface.co/spaces/MAGAer13/mPLUG-Owl2

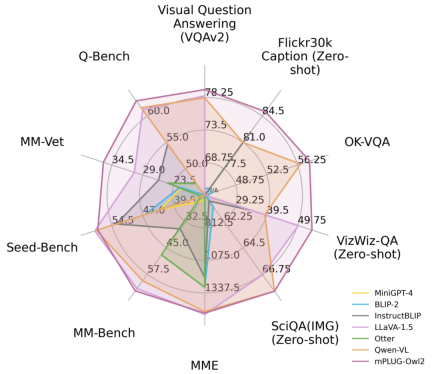

이 문제에 대응하여 Alibaba의 다중 모드 대형 모델 mPLUG-Owl이 대대적으로 업그레이드되었습니다. 모달 협업을 통해 일반 텍스트와 다중 모달리티 모두의 성능을 향상시켜 LLaVA1.5, MiniGPT4, Qwen-VL 및 기타 모델을 능가하고 다양한 작업에서 최고의 성능을 달성합니다. 특히 mPLUG-Owl2는 공유 기능 모듈을 활용하여 다양한 양식 간의 협업을 촉진하고 각 양식의 특성을 유지하기 위해 모달 적응 모듈을 도입합니다. 간단하고 효과적인 디자인으로 mPLUG-Owl2는 일반 텍스트 및 다중 모드 작업을 포함한 다양한 분야에서 최고의 성능을 달성합니다. 모달 협력 현상에 대한 연구는 미래의 다중 모드 대형 모델 개발에도 영감을 제공합니다

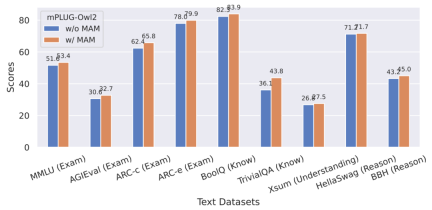

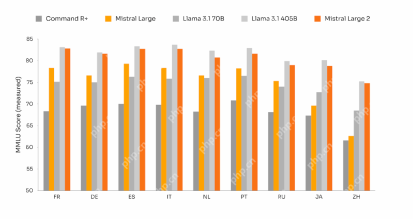

그림 1 기존 MLLM 모델과의 성능 비교

방법 소개 원래 의미를 바꾸지 않는다는 목적을 달성하려면 내용을 중국어로 다시 작성해야 합니다.

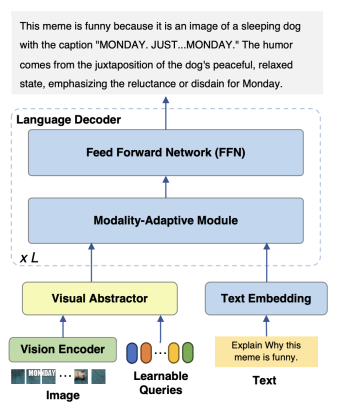

mPLUG-Owl2 모델은 주로 세 부분으로 구성됩니다.

Visual Encoder: ViT-L/14를 시각적으로 사용 인코더, 입력 해상도 H x W 비율의 이미지는 H/14 x W/14의 시각적 토큰 시퀀스로 변환되어 Visual Abstractor에 입력됩니다.

Visual Extractor: 입력 언어 모델의 시각적 시퀀스 길이를 줄이면서 사용 가능한 쿼리 집합을 학습하여 높은 수준의 의미 특징을 추출합니다.

언어 모델: LLaMA-2-7B가 텍스트 디코더로 사용됩니다. 그림 3과 같이 모달 적응 모듈을 설계했습니다.

그림 2 mPLUG-Owl2 모델 구조

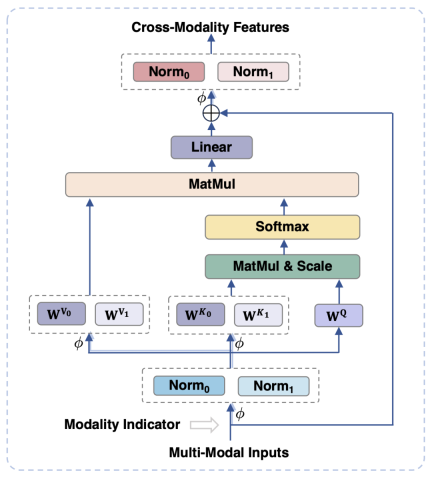

기존 작업에서는 시각적 특징을 텍스트의 의미 공간에 매핑하는 것이 일반적입니다. 그러나 이 접근 방식은 각각의 특성을 무시합니다. 시각적 정보와 텍스트 정보의 의미 세분성 불일치로 인해 모델 성능에 영향을 미칠 수 있습니다. 이 문제를 해결하기 위해 본 논문에서는 시각적 언어적 표현을 분리하여 각 양식의 고유한 속성을 유지하면서 시각적 및 텍스트 기능을 공유 의미 공간에 매핑하는 양식 적응 모듈(MAM)을 제안합니다.

그림 3은 모달 적응 모듈의 개략도를 보여줍니다.

그림 3에 표시된 것은 기존 Transformer와 비교하여 모달 적응 모듈의 주요 설계는 다음과 같습니다.

-

모듈의 입력 및 출력 단계에서 LayerNorm 작업은 두 양식의 각 기능 분포에 적응하기 위해 시각적 및 언어 양식에 대해 각각 수행됩니다.

Self-Attention 연산에서는 시각적 양식과 언어 양식에 대해 별도의 키와 값 투영 행렬을 사용하지만, 이런 방식으로 키와 값 투영 행렬을 분리하여 불일치가 발생합니다. 의미론적 세분성을 달성할 수 있으므로 두 모드 간의 간섭을 피할 수 있습니다.

동일한 FFN을 공유함으로써 두 양식이 서로 간의 협력을 촉진할 수 있습니다

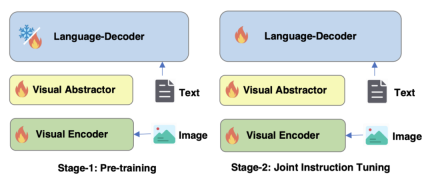

그림 4 mPLUG-Owl2

의 훈련 전략 최적화그림 4에 표시된 것처럼 mPLUG-Owl2의 교육에는 사전 교육과 교육 미세 조정의 두 단계가 포함됩니다. 사전 훈련 단계는 주로 시각적 인코더와 언어 모델의 정렬을 달성하는 것입니다. 이 단계에서는 Visual Encoder와 Visual Abstractor가 훈련 가능하며, 언어 모델에서는 Modality에 의해 추가된 시각적 관련 모델 가중치만 있습니다. 적응형 모듈이 갱신됩니다. 명령어 미세 조정 단계에서는 모델의 모든 매개변수가 텍스트 및 다중 모드 명령어 데이터(그림 5 참조)를 기반으로 미세 조정되어 모델의 명령어 추종 능력을 향상시킵니다.

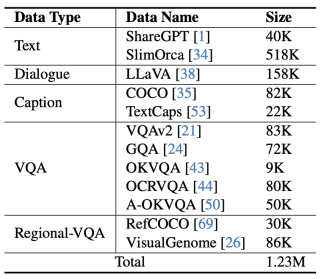

그림 5 mPLUG-Owl2

실험 및 결과

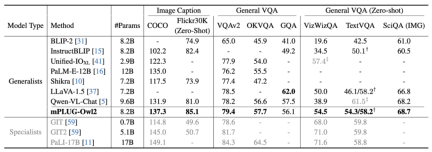

그림 6 이미지 설명 및 VQA 작업 성능

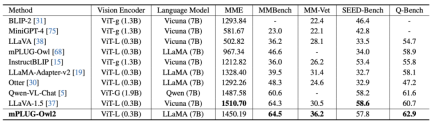

그림 7 MLLM 벤치마크 성능

은 그림 6과 그림 7에 표시되어 있으며, 이는 전통적인 이미지 설명, VQA 및 기타 시각적 언어 작업이든 MMBench, Q-Bench 및 다중 모드 대형을 위한 기타 벤치마크 데이터 세트이든 상관없습니다. mPLUG-Owl2 모델은 모두 기존 작업보다 더 나은 성능을 달성합니다.

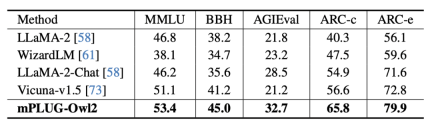

그림 8 순수 텍스트 벤치마크 성능

그림 9 모달리티 적응 모듈이 순수 텍스트 작업 성능에 미치는 영향

또한 모달 협업의 영향을 평가하기 위해 순수 텍스트 작업 텍스트 작업의 영향과 관련하여 저자는 자연어 이해 및 생성에서 mPLUG-Owl2의 성능도 테스트했습니다. 그림 8에서 볼 수 있듯이 mPLUG-Owl2는 다른 명령어 미세 조정 LLM에 비해 더 나은 성능을 달성합니다. 그림 9는 일반 텍스트 작업의 성능을 보여줍니다. 모달 적응 모듈이 모달 협업을 촉진하므로 모델의 검사 및 지식 기능이 크게 향상되었음을 알 수 있습니다. 저자는 멀티모달 협업을 통해 모델이 시각적 정보를 활용해 언어로 설명하기 어려운 개념을 이해할 수 있게 되고, 이미지 속 풍부한 정보를 통해 모델의 추론 능력을 향상시키며, 간접적으로는 모델의 추론 능력을 강화하기 때문이라고 분석한다. 텍스트.

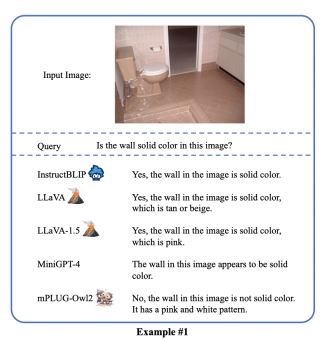

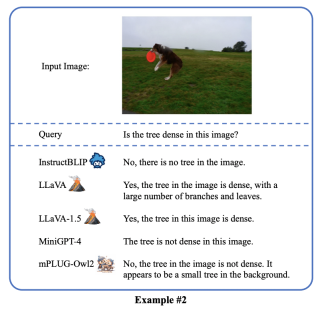

mPLUG-Owl2는 뛰어난 다중 모드 이해 기능을 보여주고 다중 모드 환각을 성공적으로 완화합니다. 이 멀티모달 기술은 Tongyi Stardust, Tongyi Zhiwen 등 Tongyi 핵심 제품에 적용되었으며, ModelScope 및 HuggingFace 오픈 데모

위 내용은 Alibaba의 새로운 mPLUG-Owl 업그레이드는 두 세계의 장점을 모두 갖추고 있으며 모달 협업을 통해 MLLM의 새로운 SOTA가 가능해졌습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

tfidfvectorizer를 사용하여 텍스트 문서를 TF-IDF 행렬로 변환하십시오Apr 18, 2025 am 10:26 AM

tfidfvectorizer를 사용하여 텍스트 문서를 TF-IDF 행렬로 변환하십시오Apr 18, 2025 am 10:26 AM이 기사에서는 텍스트 데이터 분석을위한 자연 언어 처리 (NLP)의 중요한 도구 인 TF-IDF (Trember Inverse Inverse Frequency) 기술이라는 용어를 설명합니다. TF-IDF

Langchain을 사용하여 스마트 AI 에이전트 구축 : 실용 가이드Apr 18, 2025 am 10:18 AM

Langchain을 사용하여 스마트 AI 에이전트 구축 : 실용 가이드Apr 18, 2025 am 10:18 AMLangchain으로 AI 요원의 힘을 발휘하십시오 : 초보자 가이드 할머니가 chatgpt와 대화를 나누게함으로써 할머니에게 인공 지능의 경이로움을 보여 주 상상해보십시오. th

MISTRAL BARGE 2 : 라마 3.1 405B에 도전 할만 큼 강력합니까?Apr 18, 2025 am 10:16 AM

MISTRAL BARGE 2 : 라마 3.1 405B에 도전 할만 큼 강력합니까?Apr 18, 2025 am 10:16 AMMistral Barge 2 : Mistral AI의 강력한 오픈 소스 LLM에 대한 깊은 다이빙 Meta AI의 최근 Llama 3.1 Models Family of Meta Ai의 출시 다음에는 Mistral AI가 현재까지 가장 큰 모델을 공개했습니다. Mistral Barge 2.

안정적인 확산의 소음 일정은 무엇입니까? - 분석 VidhyaApr 18, 2025 am 10:15 AM

안정적인 확산의 소음 일정은 무엇입니까? - 분석 VidhyaApr 18, 2025 am 10:15 AM확산 모델의 소음 일정 이해 : 포괄적 인 가이드 AI에 의해 생성 된 디지털 아트의 멋진 영상에 사로 잡혀 기본 역학에 대해 궁금해 한 적이 있습니까? 핵심 요소는 "소음 일정, & Quo입니다

GPT-4O로 대화적인 챗봇을 구축하는 방법? - 분석 VidhyaApr 18, 2025 am 10:06 AM

GPT-4O로 대화적인 챗봇을 구축하는 방법? - 분석 VidhyaApr 18, 2025 am 10:06 AMGPT-4O를 사용하여 상황에 맞는 챗봇 구축 : 포괄적 인 가이드 AI와 NLP의 빠르게 진화하는 환경에서 챗봇은 개발자와 조직에 없어서는 안될 도구가되었습니다. 진정으로 매력적이고 지능적인 채팅을 만드는 주요 측면

2025 년 AI 에이전트 구축을위한 상위 7 개 프레임 워크Apr 18, 2025 am 10:00 AM

2025 년 AI 에이전트 구축을위한 상위 7 개 프레임 워크Apr 18, 2025 am 10:00 AM이 기사는 AI 에이전트를 구축하기위한 7 가지 주요 프레임 워크 (목표 달성, 결정 및 행동을위한 자율 소프트웨어 엔티티)를 탐구합니다. 전통적인 강화 학습을 능가하는이 요원들은 고급 계획 및 이성을 활용합니다.

I 형과 II 형 오류의 차이점은 무엇입니까? - 분석 VidhyaApr 18, 2025 am 09:48 AM

I 형과 II 형 오류의 차이점은 무엇입니까? - 분석 VidhyaApr 18, 2025 am 09:48 AM통계 가설 테스트에서 유형 I 및 유형 II 오류 이해 새로운 혈압 약물을 검사하는 임상 시험을 상상해보십시오. 이 시험은 약물이 혈압을 크게 낮추지 만 실제로는 그렇지 않습니다. 이것은 유형입니다

Sumy Library를 통한 자동 텍스트 요약Apr 18, 2025 am 09:37 AM

Sumy Library를 통한 자동 텍스트 요약Apr 18, 2025 am 09:37 AMSumy : AI 기반 요약 보조원 끝없는 문서를 살펴 보는 데 지쳤습니까? 강력한 파이썬 라이브러리 인 Sumy는 자동 텍스트 요약을위한 간소화 된 솔루션을 제공합니다. 이 기사는 Sumy의 능력을 탐구하여 Throug를 안내합니다

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

MinGW - Windows용 미니멀리스트 GNU

이 프로젝트는 osdn.net/projects/mingw로 마이그레이션되는 중입니다. 계속해서 그곳에서 우리를 팔로우할 수 있습니다. MinGW: GCC(GNU Compiler Collection)의 기본 Windows 포트로, 기본 Windows 애플리케이션을 구축하기 위한 무료 배포 가능 가져오기 라이브러리 및 헤더 파일로 C99 기능을 지원하는 MSVC 런타임에 대한 확장이 포함되어 있습니다. 모든 MinGW 소프트웨어는 64비트 Windows 플랫폼에서 실행될 수 있습니다.

SublimeText3 영어 버전

권장 사항: Win 버전, 코드 프롬프트 지원!

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

Eclipse용 SAP NetWeaver 서버 어댑터

Eclipse를 SAP NetWeaver 애플리케이션 서버와 통합합니다.

PhpStorm 맥 버전

최신(2018.2.1) 전문 PHP 통합 개발 도구