사진을 찍으면 동영상이 생성됩니다. 입을 벌리고 고개를 끄덕이는 것, 감정, 분노, 슬픔, 기쁨을 모두 입력으로 제어할 수 있습니다.

- 王林앞으로

- 2023-12-03 11:17:21942검색

최근 Microsoft에서 실시한 연구에 따르면 비디오 처리 소프트웨어 PS가 얼마나 유연한지 밝혀졌습니다.

이 연구에서는 AI에게 사진을 주기만 하면 사진 속 인물의 비디오를 생성할 수 있습니다. , 캐릭터의 표정과 움직임을 텍스트를 통해 제어할 수 있습니다. 예를 들어, "입을 벌려라"라는 명령을 내리면 영상 속 캐릭터는 실제로 입을 벌리게 됩니다.

슬픈 명령을 내리면 슬픈 표정을 짓고 머리를 움직입니다.

"놀라움"이라는 명령이 주어지면 아바타의 이마 라인이 함께 압착됩니다.

또한 가상 캐릭터의 입 모양과 움직임을 음성과 동기화하는 음성을 제공할 수도 있습니다. 또는 아바타가 모방할 수 있는 라이브 비디오를 제공할 수 있습니다

아바타의 움직임에 대해 고개를 끄덕이거나 돌리거나 기울이는 등 더 많은 사용자 정의 편집이 필요한 경우 이 기술도 지원됩니다

이 연구는 GAIA(Generative AI for Avatar, Generative AI for Avatar)라고 불리며, 그 데모가 소셜미디어를 통해 퍼지기 시작했습니다. 많은 사람들이 그 효과에 감탄하고 죽은 사람을 "부활"시키는 데 사용하기를 희망합니다.

그러나 일부 사람들은 이러한 기술의 지속적인 발전으로 인해 온라인 비디오가 진짜와 가짜를 구별하기 어렵게 만들거나 범죄자에 의해 사기에 이용될 것이라고 걱정합니다. 앞으로도 사기방지 대책은 더욱 강화될 것으로 보입니다.

GAIA의 혁신적인 점은 무엇인가요?

제로 샘플 말하는 가상 캐릭터 생성 기술은 음성을 기반으로 자연스러운 영상을 합성하여 생성된 입 모양, 표정, 머리 자세가 음성 내용과 일치하도록 하는 것을 목표로 합니다. 이전 연구에서는 일반적으로 각 가상 캐릭터에 대한 특정 모델의 특정 훈련 또는 조정이 필요하거나 추론 중에 템플릿 비디오를 활용하여 고품질 결과를 달성해야 합니다. 최근 연구자들은 단순히 대상 아바타의 인물 이미지를 외형 기준으로 활용하여 제로샷 말하는 아바타를 생성하는 방법을 설계하고 개선하는 데 집중하고 있다. 그러나 이러한 방법은 일반적으로 작업의 난이도를 줄이기 위해 워핑 기반 모션 표현 및 3DMM(3D Morphable Model)과 같은 도메인 사전을 사용합니다. 이러한 경험적 방법은 효과적이긴 하지만 다양성을 제한하고 부자연스러운 결과를 초래할 수 있습니다. 따라서 데이터 배포를 통한 직접 학습이 향후 연구의 초점입니다

이 기사에서 Microsoft 연구원은 음성 및 단일 인물 사진에서 자연스럽게 말하는 사람을 합성할 수 있는 GAIA(Generative AI for Avatar)를 제안했습니다. 도메인 사전은 생성 프로세스 중에 제거됩니다.

프로젝트 주소: https://microsoft.github.io/GAIA/관련 프로젝트의 세부 정보는 이 링크에서 확인할 수 있습니다

문서 링크: https://arxiv.org/pdf/ 2311.15230 .pdf

Gaia는 두 가지 주요 통찰력을 공개합니다.

-

음성을 사용하여 가상 캐릭터의 움직임을 주도하고, 가상 캐릭터의 배경과 모습은 영상 내내 변하지 않습니다. 이에 영감을 받아 이 논문은 각 프레임의 동작과 모양을 분리합니다. 여기서 모양은 프레임 간에 공유되지만 동작은 각 프레임마다 고유합니다. 음성에서 동작을 예측하기 위해 본 논문에서는 동작 시퀀스를 동작 잠재 시퀀스로 인코딩하고 입력 음성을 조건으로 한 확산 모델을 사용하여 잠재 시퀀스를 예측합니다. 표정과 머리 자세가 매우 다양하기 때문에 대규모의 다양한 데이터 세트가 필요합니다. 따라서 본 연구에서는 연령, 성별, 피부타입, 말하기 스타일이 서로 다른 16K명의 고유한 화자로 구성된 고품질의 말하는 아바타 데이터세트를 수집하여 생성 결과를 자연스럽고 다양하게 만들었습니다.

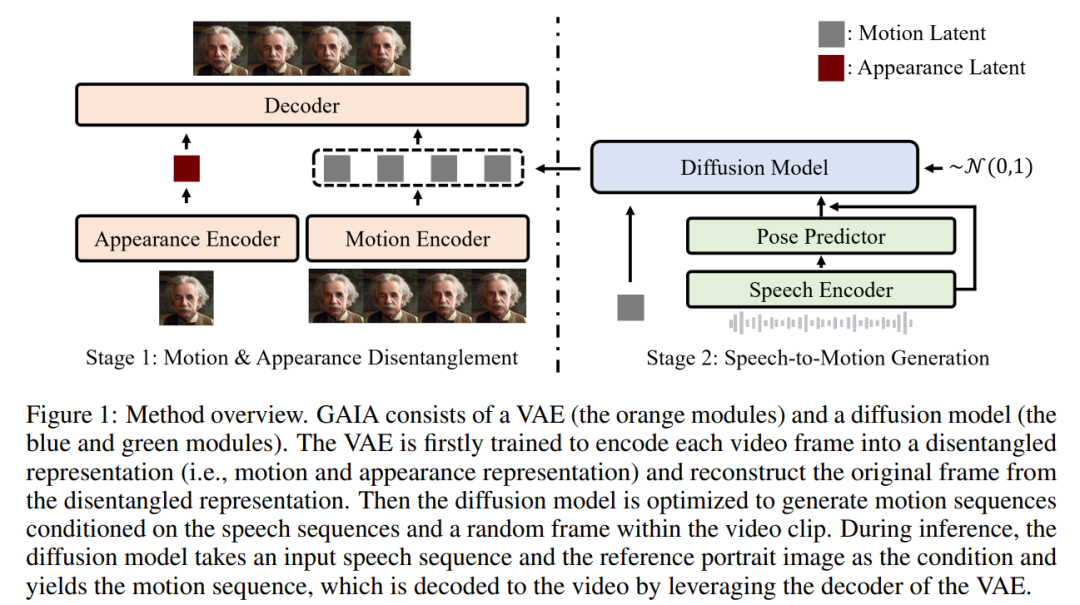

위의 두 가지 통찰력을 바탕으로 본 논문에서는 VAE(Variational Autoencoder)(주황색 모듈)와 확산 모델(청색 및 녹색 모듈)으로 구성된 GAIA 프레임워크를 제안합니다.

VAE의 주요 기능은 움직임과 모습을 분해하는 것입니다. 두 개의 인코더(모션 인코더 및 모양 인코더)와 디코더로 구성됩니다. 훈련 중에 모션 인코더에 대한 입력은 얼굴 랜드마크의 현재 프레임이고, 모양 인코더에 대한 입력은 현재 비디오 클립에서 무작위로 샘플링된 프레임입니다.

이 두 인코더의 출력을 기반으로 이후에 현재 프레임을 재구성하기 위해 최적화된 디코더. 훈련된 VAE를 얻으면 모든 훈련 데이터에 대한 잠재적인 동작(예: 모션 인코더의 출력)을 얻게 됩니다.

이 두 인코더의 출력을 기반으로 이후에 현재 프레임을 재구성하기 위해 최적화된 디코더. 훈련된 VAE를 얻으면 모든 훈련 데이터에 대한 잠재적인 동작(예: 모션 인코더의 출력)을 얻게 됩니다.

그런 다음 이 문서에서는 음성에서 무작위로 샘플링된 프레임을 기반으로 동작을 예측하도록 훈련된 확산 모델을 사용합니다. 비디오 클립 모션 잠재 시퀀스를 통해 생성 프로세스에 대한 모양 정보 제공

추론 프로세스에서 대상 가상 캐릭터의 참조 초상화 이미지가 주어지면 확산 모델은 이미지와 입력 음성 시퀀스를 조건으로 사용하여 음성 내용을 따르는 모션 잠재 시퀀스. 생성된 모션 잠재 시퀀스와 참조 초상화 이미지는 VAE 디코더를 통과하여 말하는 비디오 출력을 합성합니다.

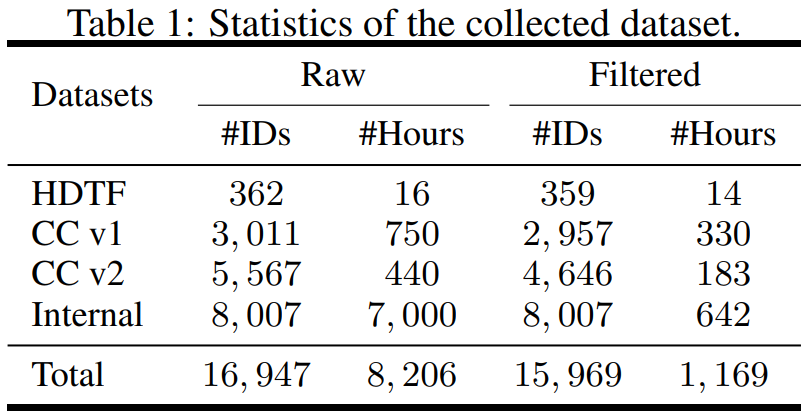

이 연구는 HDTF(고화질 말하는 얼굴 데이터 세트) 및 캐주얼 대화 데이터 세트 v1&v2(CC v1&v2)를 포함한 다양한 소스에서 데이터 세트를 수집하여 데이터 측면에서 구조화되었습니다. 이 세 가지 데이터 세트 외에도 연구에서는 7K 시간의 비디오와 8K 화자 ID가 포함된 대규모 내부 말하기 아바타 데이터 세트도 수집했습니다. 데이터 세트의 통계적 개요는 표 1에 나와 있습니다.

필요한 정보를 학습하기 위해 이 기사에서는 훈련 데이터의 품질을 보장하기 위한 몇 가지 자동 필터링 전략을 제안합니다. 움직임이 보이려면 아바타의 정면 방향이 카메라를 향해야 합니다.

안정성을 보장하기 위해 영상 속 얼굴 움직임은 매끄럽고 빠르게 흔들리지 않아야 합니다.

안정성을 보장하기 위해 영상 속 얼굴 움직임은 매끄럽고 빠르게 흔들리지 않아야 합니다.

극단적인 경우를 걸러내기 위해; 입술 움직임과 말이 일치하지 않는 경우 아바타를 삭제해야 합니다. 마스크를 착용하거나 무음 프레임을 유지하세요.

- 이 문서에서는 필터링된 데이터에 대해 VAE 및 확산 모델을 교육합니다. 실험 결과에서 이 논문은 세 가지 주요 결론을 얻었습니다.

- GAIA는 자연성, 다양성, 입술 동기화 품질 및 시각적 품질 측면에서 우수한 성능으로 제로 샘플 말하기 가상 캐릭터 생성이 가능합니다. 연구원의 주관적인 평가에 따르면 GAIA는 모든 기본 방법을 훨씬 능가합니다.

- 훈련 모델의 크기는 150M에서 2B까지이며 결과는 더 큰 모델이 더 나은 결과를 생성하기 때문에 확장 가능하다는 것을 보여줍니다.

GAIA는 제어 가능한 말하기 아바타 생성 및 텍스트 명령 아바타 생성을 포함하여 다양한 애플리케이션을 가능하게 하는 일반적이고 유연한 프레임워크입니다.

- GAIA의 효과는 어떤가요?

- 실험 중에 연구에서는 GAIA를 FOMM, HeadGAN 및 Face-vid2vid를 포함한 세 가지 강력한 기준과 비교했습니다. 결과는 표 2에 나와 있습니다. GAIA의 VAE는 이전의 비디오 기반 기준에 비해 일관된 개선을 달성하여 GAIA가 모양과 동작 표현을 성공적으로 분해한다는 것을 보여줍니다.

-

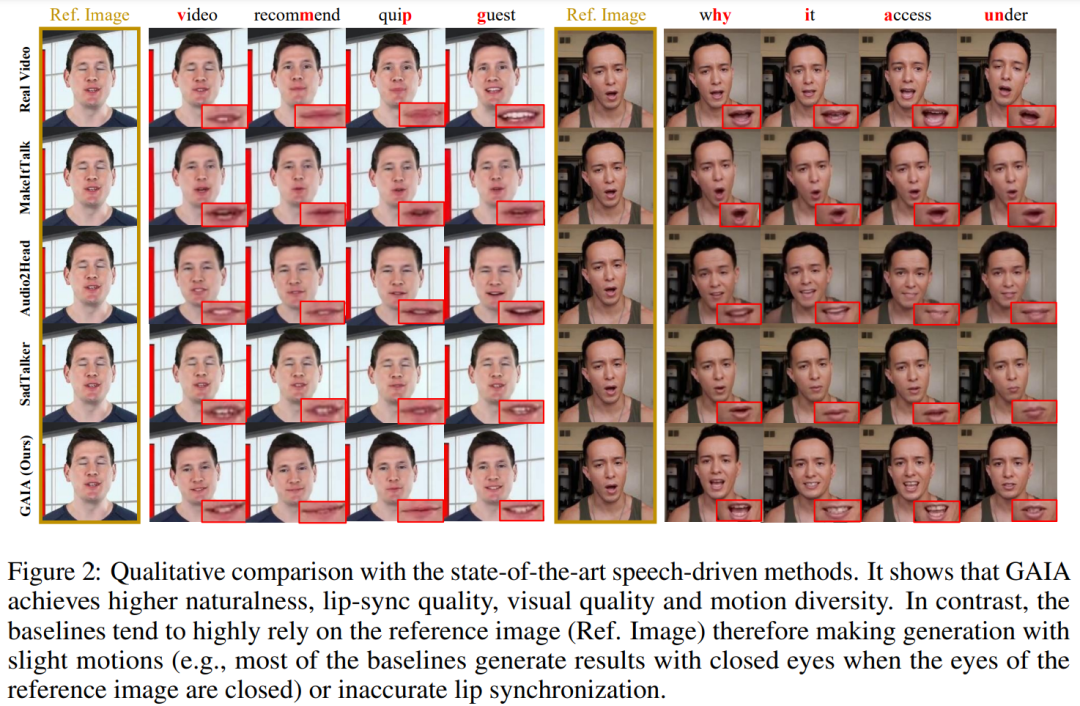

음성 기반 결과. 음성 기반 말하기 아바타 생성은 음성에서 동작을 예측하여 달성됩니다. 표 3과 그림 2는 GAIA와 MakeItTalk, Audio2Head 및 SadTalker 방법의 정량적, 정성적 비교를 제공합니다.

주관적 평가 측면에서 GAIA가 모든 기본 방법보다 훨씬 뛰어난 성능을 보인다는 것은 데이터를 통해 분명합니다. 보다 구체적으로, 그림 2에서 볼 수 있듯이 참조 이미지에 눈을 감았거나 비정상적인 머리 자세가 있더라도 기본 방법의 생성 결과는 일반적으로 참조 이미지에 크게 의존하는 반면 GAIA는 다양한 참조 이미지에서 좋은 성능을 나타냅니다. 더 높은 자연스러움, 높은 입술 동기화, 더 나은 시각적 품질 및 모션 다양성으로 견고하고 결과를 생성합니다

표 3에 따르면 최고의 MSI 점수는 GAIA에서 생성된 비디오가 뛰어난 모션 안정성을 가지고 있음을 보여줍니다. Sync-D 점수는 8.528로 실제 영상 점수(8.548)에 가까워 생성된 영상의 립싱크가 우수함을 알 수 있습니다. 표 6에 자세히 설명된 대로 확산 훈련이 없는 모델이 더 나은 FID 점수를 달성한 것으로 나타났기 때문에 이 연구는 다양한 머리 자세의 영향을 받았을 수 있는 기준선과 비슷한 FID 점수를 달성했습니다.

위 내용은 사진을 찍으면 동영상이 생성됩니다. 입을 벌리고 고개를 끄덕이는 것, 감정, 분노, 슬픔, 기쁨을 모두 입력으로 제어할 수 있습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!