전 세계가 여전히 NVIDIA H100 칩에 집착하고 AI 컴퓨팅 성능에 대한 증가하는 수요를 충족하기 위해 이를 미친 듯이 구매하는 동안, 월요일 현지 시간에 NVIDIA는 대규모 AI 모델 훈련을 위한 최신 AI 칩 H200을 조용히 출시했습니다. 비교. 이전 세대 제품인 H100에 비해 H200의 성능이 약 60~90% 향상되었습니다.

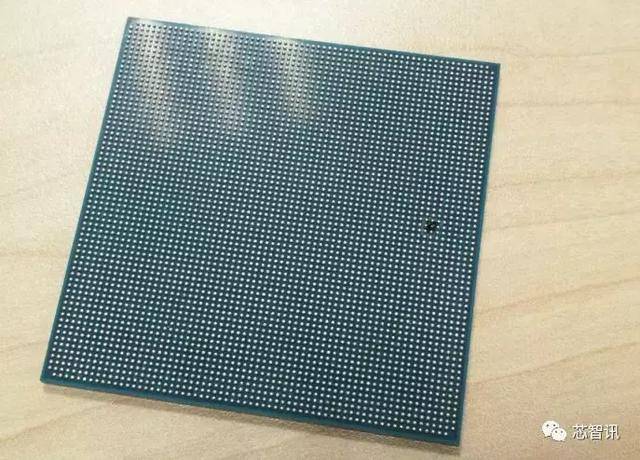

H200은 H100과 같은 Hopper 아키텍처를 기반으로 하는 업그레이드 버전입니다. 주요 업그레이드에는 141GB의 HBM3e 비디오 메모리가 포함됩니다. 비디오 메모리 대역폭은 H100의 3.35TB/s에서 4.8TB/s로 증가했습니다. NVIDIA 공식 웹사이트에 따르면 H200은 HBM3e 메모리를 사용하는 회사 최초의 칩이기도 합니다. 이 메모리는 더 빠르고 용량이 크기 때문에 대규모 언어 모델에 더 적합합니다. NVIDIA는 "HBM3e를 통해 NVIDIA H200은 초당 4.8TB의 141GB 메모리를 제공합니다. 이는 A100에 비해 거의 2배의 용량과 2.4배의 대역폭 을 제공합니다." 공식 사진에 따르면 H200의 대형 모델 Llama 2와 GPT-3.5의 출력 속도는 각각 H100의 1.9배, 1.6배

이며, 고성능 컴퓨팅 HPC에서의 속도는 듀얼 코어의 110배에 달합니다. x86 CPU 시간.H200은 내년 2분기에 출시될 것으로 예상되며 엔비디아는 아직 가격을 발표하지 않았습니다.

그러나 H100 및 기타 AI 칩과 마찬가지로 Nvidia는 H200 칩을 중국 제조업체에 공급하지 않습니다.올해 10월 17일, 미국 상무부는 칩에 대한 새로운 수출 통제 규정

을 발표했습니다. 특히 고성능 AI 칩에 대한 통제가 더욱 엄격해졌습니다. 매우 중요한 새로운 규정 중 하나는 고급 컴퓨팅 칩에 대한 제한된 표준을 조정하고 새로운 "성능 밀도 임계값"을 매개변수로 설정하는 것입니다. 새로운 규정에 따라 NVIDIA China의 '스페셜 에디션' H800 및 A800의 중국 수출이 제한되었습니다.최첨단 AI 칩이 부족하면 단기적으로는 국내 AI 산업 발전에 몇 가지 어려움이 따르겠지만 기회도 있습니다.

첫째, Baidu의 최근 1,600개의 Huawei Ascend 910B 칩 주문과 같은 국내 컴퓨팅 전원 칩을 교체할 수 있는 기회

가 있습니다. 두 번째로, 수요와 공급의 불일치로 인해컴퓨팅 전원 임대 가격 상승이 컴퓨팅 전원 임대에 도움이 될 것입니다. 기업. 휴이나테크놀로지는 엔비디아 A100 칩이 내장된 고성능 컴퓨팅 서버의 컴퓨팅 파워 서비스 요금을 100% 인상한다고 14일 밝혔다. 첨단 공정 생산 능력 부족 문제로 인해 개발이 가속화될 것으로 예상됩니다. 그렇다면 Huawei Shengteng 외에 국내 컴퓨팅 능력을 갖춘 또 누가 배너를 들고 다닐 수 있을까요? 산업 체인과 관련된 회사는 무엇입니까? 간접적으로 이익을 얻을 것으로 예상되는 다른 방향은 무엇입니까? 국내 AI 컴퓨팅 파워 독립통제의 4대 혜택 방향과 대표 기업들이 "AI 컴퓨팅 파워를 독립적으로 관리하는 것이 필수입니다

"라는 특별 주제를 제작했습니다. 도움이 필요한 친구들은 아래 QR 코드를 스캔하거나 WeChat 보조자(hzkyxjyy)를 추가하세요. 무료로 다운로드하거나 친구 서클에서 읽어보세요. 추가가 성공적으로 완료되면 모든 과거 보고서와 향후 각 특별 보고서를 무료로 읽을 수 있습니다.

위 내용은 NVIDIA는 새로운 AI 칩 H200을 출시하여 성능이 90% 향상되었습니다! 중국의 컴퓨팅 파워가 자주적인 돌파를 달성했습니다!의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

新标题:英伟达H200发布:HBM容量提升76%,大幅提升大模型性能90%的最强AI芯片Nov 14, 2023 pm 03:21 PM

新标题:英伟达H200发布:HBM容量提升76%,大幅提升大模型性能90%的最强AI芯片Nov 14, 2023 pm 03:21 PM11月14日消息,英伟达(Nvidia)在当地时间13日上午的“Supercomputing23”会议上正式发布了全新的H200GPU,并更新了GH200产品线其中,H200依然是建立在现有的HopperH100架构之上,但增加了更多高带宽内存(HBM3e),从而更好地处理开发和实施人工智能所需的大型数据集,使得运行大模型的综合性能相比前代H100提升了60%到90%。而更新后的GH200,也将为下一代AI超级计算机提供动力。2024年将会有超过200exaflops的AI计算能力上线。H200

传联发科拿下谷歌服务器AI芯片大单,将供应高速Serdes芯片Jun 19, 2023 pm 08:23 PM

传联发科拿下谷歌服务器AI芯片大单,将供应高速Serdes芯片Jun 19, 2023 pm 08:23 PM6月19日消息,据中国台湾媒体报道,谷歌(Google)为了研发最新的面向服务器的AI芯片,已经找来联发科合合作,并计划交由台积电5nm制程代工,计划明年初量产。报道称,消息人士透露,这次谷歌与联发科的合作,将由联发科提供串行器及解串器(SerDes)方案,并协助整合谷歌自研的张量处理器(TPU),助力谷歌打造最新的服务器AI晶片,性能将比CPU或GPU架构更强大。业界指出,谷歌目前的多项服务都与AI有关,早在多年前就投入到了深度学习技术当中,发现运用GPU来进行AI运算成本十分昂贵,因此谷歌决

AI的下一个热门:英伟达B100芯片和OpenAI GPT-5模型的巅峰表现Nov 18, 2023 pm 03:39 PM

AI的下一个热门:英伟达B100芯片和OpenAI GPT-5模型的巅峰表现Nov 18, 2023 pm 03:39 PM号称世界最强AI芯片英伟达H200亮相后,业内开始期待英伟达更强大的B100芯片,与此同时,今年以来最红的初创AI公司OpenAI已经开始研发更强大、更复杂的GPT-5模型。国泰君安在最新的研报中指出,性能无边的B100与GPT5预计在2024年发布,重磅升级或释放前所未有的生产力。该机构表示,看好AI进入快速发展的成长期,能见度持续至2024年。相较于前几代产品,B100和GPT-5究竟有多强大?英伟达和OpenAI已经给出了预告:B100速度可能是H100的4倍以上,而GPT-5可能会实现超

耐能推出最新款AI芯片KL730,驱动轻量级GPT解决方案的大规模应用Aug 17, 2023 pm 01:37 PM

耐能推出最新款AI芯片KL730,驱动轻量级GPT解决方案的大规模应用Aug 17, 2023 pm 01:37 PMKL730在能效方面的进步使得解决了人工智能模型落地方面最大的瓶颈——能源成本,相较于行业及以往耐能的芯片,提高了3到4倍KL730芯片支持最先进的轻量级GPT大语言模型,如nanoGPT,并提供每秒0.35-4tera的有效计算能力AI公司耐能今日宣布发布KL730芯片,该芯片集成了车规级NPU和图像信号处理(ISP),将安全而低能耗的AI能力赋能到边缘服务器、智能家居及汽车辅助驾驶系统等各类应用场景中。总部位于圣迭戈的耐能以其开创性的神经处理单元(NPU)而闻名耐能最新款芯片KL730旨在实

英伟达推出全新AI芯片H200,性能大幅提升90%!中国算力实现自主突破!Nov 14, 2023 pm 05:37 PM

英伟达推出全新AI芯片H200,性能大幅提升90%!中国算力实现自主突破!Nov 14, 2023 pm 05:37 PM当全球还在为英伟达H100芯片痴迷并疯狂购买以满足持续增长的AI算力需求之时,当地时间周一,英伟达悄然推出了最新的AI芯片H200,用于AI大模型的训练,相比于其前一代产品H100,H200的性能提升了约60%到90%。H200是英伟达H100的升级版,与H100同样基于Hopper架构,主要升级包括141GB的HBM3e显存,显存带宽从H100的3.35TB/s增加到了4.8TB/s。据英伟达官网消息,H200也是公司第一款使用HBM3e内存的芯片,这种内存速度更快,容量更大,因此更适合大语言

耐能公司宣布推出最新的AI芯片KL730Aug 17, 2023 am 10:09 AM

耐能公司宣布推出最新的AI芯片KL730Aug 17, 2023 am 10:09 AM根据原话,可以将其重写为:(全球TMT2023年8月16日讯)AI公司耐能,总部位于圣迭戈,以其开创性的神经处理单元(NPU)而闻名,宣布发布KL730芯片。该芯片集成了车规级NPU和图像信号处理(ISP),并将安全而低能耗的AI能力赋予边缘服务器、智能家居及汽车辅助驾驶系统等各类应用场景KL730芯片在能效方面取得了巨大的突破,相较于以往的耐能芯片,其能效提升了3至4倍,比主要行业同类产品提高了150%~200%。该芯片具备每秒0.35-4tera的有效计算能力,可以支持最先进的轻量级GPT大

天玑8300发布:CPU、GPU性能超越8Gen2,实现旗舰级生成式AI能力Nov 22, 2023 am 08:21 AM

天玑8300发布:CPU、GPU性能超越8Gen2,实现旗舰级生成式AI能力Nov 22, 2023 am 08:21 AM天玑9300最近在旗舰手机芯片领域取得了领先地位,成功超越了竞争对手。在高出货量的次旗舰市场上,联发科展现出了新的竞争力11月21日下午,联发科技正式发布了新一代次旗舰芯片天玑8300。新一代芯片在性能、能效和生成式AI等方面都有了大幅度的提升,实现了旗舰级的体验。在活动中,MediaTek无线通信事业部副总经理李彦辑博士表示:「天玑8300具备高能效的端侧AI能力,支持旗舰级存储,提供卓越的游戏、影像、多媒体娱乐体验,以全面的平台革新,将为高端智能手机市场开辟更多新机遇。」天玑8300采用了4

AI芯片,全球缺货!May 30, 2023 pm 09:53 PM

AI芯片,全球缺货!May 30, 2023 pm 09:53 PM谷歌CEO将AI革命比作人类对火的使用,但现在为该行业提供燃料的数字火种——AI芯片,很难获得。驱动AI运行的新一代先进芯片几乎都是由英伟达制造的,随着ChatGPT爆火出圈,市场对英伟达图形处理芯片(GPU)的需求远远超过了供应。帮助企业构建聊天机器人等AI模型的初创公司Lamini的联合创始人兼首席执行官SharonZhou表示:“因为存在短缺,所以关键在于你的朋友圈。”“就像疫情期间的厕纸一样。”这种情况限制了亚马逊和微软等云服务提供商向ChatGPT的创建者OpenAI等客户提供的计算能

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

mPDF

mPDF는 UTF-8로 인코딩된 HTML에서 PDF 파일을 생성할 수 있는 PHP 라이브러리입니다. 원저자인 Ian Back은 자신의 웹 사이트에서 "즉시" PDF 파일을 출력하고 다양한 언어를 처리하기 위해 mPDF를 작성했습니다. HTML2FPDF와 같은 원본 스크립트보다 유니코드 글꼴을 사용할 때 속도가 느리고 더 큰 파일을 생성하지만 CSS 스타일 등을 지원하고 많은 개선 사항이 있습니다. RTL(아랍어, 히브리어), CJK(중국어, 일본어, 한국어)를 포함한 거의 모든 언어를 지원합니다. 중첩된 블록 수준 요소(예: P, DIV)를 지원합니다.

MinGW - Windows용 미니멀리스트 GNU

이 프로젝트는 osdn.net/projects/mingw로 마이그레이션되는 중입니다. 계속해서 그곳에서 우리를 팔로우할 수 있습니다. MinGW: GCC(GNU Compiler Collection)의 기본 Windows 포트로, 기본 Windows 애플리케이션을 구축하기 위한 무료 배포 가능 가져오기 라이브러리 및 헤더 파일로 C99 기능을 지원하는 MSVC 런타임에 대한 확장이 포함되어 있습니다. 모든 MinGW 소프트웨어는 64비트 Windows 플랫폼에서 실행될 수 있습니다.

SublimeText3 영어 버전

권장 사항: Win 버전, 코드 프롬프트 지원!

DVWA

DVWA(Damn Vulnerable Web App)는 매우 취약한 PHP/MySQL 웹 애플리케이션입니다. 주요 목표는 보안 전문가가 법적 환경에서 자신의 기술과 도구를 테스트하고, 웹 개발자가 웹 응용 프로그램 보안 프로세스를 더 잘 이해할 수 있도록 돕고, 교사/학생이 교실 환경 웹 응용 프로그램에서 가르치고 배울 수 있도록 돕는 것입니다. 보안. DVWA의 목표는 다양한 난이도의 간단하고 간단한 인터페이스를 통해 가장 일반적인 웹 취약점 중 일부를 연습하는 것입니다. 이 소프트웨어는

VSCode Windows 64비트 다운로드

Microsoft에서 출시한 강력한 무료 IDE 편집기

뜨거운 주제

1374

1374 52

52 40

40 19

19