4K 품질의 3D 합성 비디오는 더 이상 슬라이드쇼에서 정지되지 않으며, 새로운 방법으로 렌더링 속도가 30배 이상 향상됩니다.

- 王林앞으로

- 2023-10-19 14:21:04641검색

4K 화질, 60프레임 동영상은 일부 앱에서 회원만 볼 수 있지만 AI 연구자들은 이미 4K 수준의 3D 동적 합성 동영상을 달성했으며 영상이 매우 매끄럽습니다.

실생활에서 우리가 접하는 대부분의 영상은 2D입니다. 이런 영상을 볼 때 우리는 배우들 사이를 걷거나 공간의 한구석으로 걸어가는 등 보는 각도를 선택할 수가 없다. VR과 AR 기기의 등장으로 이러한 단점이 보완되었습니다. 3D 영상을 통해 관점을 바꿀 수 있고 마음대로 움직일 수도 있어 몰입도가 크게 향상되었습니다.

그러나 이런 종류의 3D 다이나믹 장면을 합성하는 것은 화질과 부드러움 측면에서 항상 어려움이 있었습니다.

최근 저장대학교, Xiangyan Technology 및 Ant Group의 연구원들이 이 문제에 도전했습니다. "4K4D: 4K 해상도의 실시간 4D 뷰 합성"이라는 논문에서 그들은 고해상도 3D 동적 장면 합성의 렌더링 속도를 크게 향상시키는 4K4D라는 포인트 클라우드 표현 방법을 제안했습니다. 특히 RTX 4090 GPU를 사용하면 최대 80FPS의 프레임 속도에서 4K 해상도, 최대 400FPS의 프레임 속도에서 1080p 해상도로 렌더링할 수 있습니다. 전체적으로 이전 방식보다 30배 이상 빠르며, 렌더링 품질도 SOTA에 이른다.

다음은 논문 소개입니다.

논문 개요

- 논문 링크: https://arxiv.org/pdf/2310.11448.pdf

- https ://z ju3dv. github .io/4k4d/

동적 뷰 합성은 캡처된 비디오에서 동적 3D 장면을 재구성하고 몰입형 가상 재생을 만드는 것을 목표로 합니다. 이는 컴퓨터 비전 및 컴퓨터 그래픽의 장기적인 연구 문제입니다. 이 기술의 유용성의 핵심은 높은 충실도로 실시간 렌더링이 가능하여 VR/AR, 스포츠 방송, 예술적인 퍼포먼스 캡처에 사용할 수 있다는 것입니다. 기존 접근 방식은 동적 3D 장면을 질감이 있는 메시의 시퀀스로 표현하고 복잡한 하드웨어를 사용하여 이를 재구성합니다. 따라서 일반적으로 통제된 환경으로 제한됩니다.

최근 암시적 신경 표현은 미분 렌더링을 통해 RGB 비디오에서 동적 3D 장면을 재구성하는 데 큰 성공을 거두었습니다. 예를 들어, "다시점 비디오의 신경 3D 비디오 합성"은 대상 장면을 동적 방사장으로 모델링하고 볼륨 렌더링을 사용하여 이미지를 합성하고 이를 입력 이미지와 비교 및 최적화합니다. 인상적인 동적 뷰 합성 결과에도 불구하고 기존 방법은 값비싼 네트워크 평가로 인해 1080p 해상도로 이미지를 렌더링하는 데 몇 초 또는 몇 분이 걸리는 경우가 많습니다.

정적 뷰 합성 방법에서 영감을 받은 일부 동적 뷰 합성 방법은 비용이나 네트워크 평가 횟수를 줄여 렌더링 속도를 향상시킵니다. 이러한 전략을 통해 MLP 맵은 41.7fps로 전경 동적 수치를 렌더링할 수 있습니다. 그러나 MLP 맵의 실시간 성능은 중간 해상도(384×512)의 이미지를 합성할 때만 달성할 수 있으므로 렌더링 속도 문제는 여전히 남아 있습니다. 4K 해상도 이미지를 렌더링할 때 속도가 1.3FPS로 느려졌습니다.

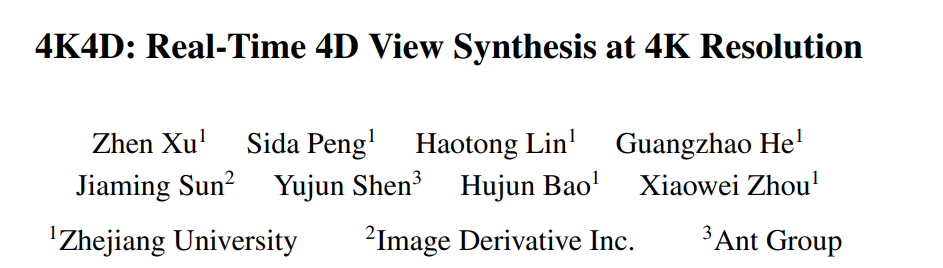

이 논문에서 연구원들은 동적 3D 장면을 모델링하고 렌더링하기 위한 새로운 신경 표현인 4K4D를 제안합니다. 그림 1에서 볼 수 있듯이 4K4D는 렌더링 속도에서 이전 동적 뷰 합성 방법보다 훨씬 뛰어나며 렌더링 품질에서도 경쟁력이 있습니다.

저자는 핵심 혁신이 4D 포인트 클라우드 표현과 하이브리드 외관 모델에 있다고 밝혔습니다. 특히 동적 장면의 경우 공간 조각 알고리즘을 사용하여 거친 포인트 클라우드 시퀀스를 얻고 각 포인트의 위치를 학습 가능한 벡터로 모델링합니다. 또한 4D 형상 그리드를 도입하여 각 점에 특징 벡터를 할당하고 이를 MLP 네트워크에 입력하여 점의 반경, 밀도 및 SH(구형 고조파) 계수를 예측했습니다. 4D 특징 메쉬는 포인트 클라우드에 공간 정규화를 자연스럽게 적용하여 최적화를 더욱 강력하게 만듭니다. 연구원들은 4K4D를 기반으로 하드웨어 래스터화를 사용하여 전례 없는 렌더링 속도를 달성하는 차별화 가능한 깊이 필링 알고리즘을 개발했습니다.

연구원들은 MLP 기반 SH 모델이 역동적인 장면의 모습을 표현하기 어렵다는 것을 발견했습니다. 이러한 문제를 완화하기 위해 SH 모델과 결합하여 장면의 모습을 표현하는 이미지 혼합 모델도 도입했습니다. 중요한 디자인은 이미지 블렌딩 네트워크를 보는 방향과 독립적으로 만들어 훈련 후에 미리 계산하여 렌더링 속도를 향상시킬 수 있다는 것입니다. 양날의 검인 이 전략은 이미지 혼합 모델을 보는 방향을 따라 분리되게 만듭니다. 이 문제는 연속 SH 모델을 사용하여 해결될 수 있습니다. 연구진이 제안한 하이브리드 외관 모델은 SH 모델만 사용하는 3D Gaussian Splatting에 비해 입력 영상에서 캡처한 정보를 최대한 활용하여 렌더링 품질을 효과적으로 향상시킵니다.

새로운 방법의 효과를 검증하기 위해 연구원들은 NHR, ENeRF-Outdoo, DNA-Rendering 및 Neural3DV를 포함하여 널리 사용되는 여러 다중 뷰 동적 새 뷰 합성 데이터 세트에서 4K4D를 평가했습니다. 광범위한 실험에 따르면 4K4D는 렌더링 속도가 훨씬 더 빠를 뿐만 아니라 렌더링 품질 측면에서도 SOTA 기술보다 훨씬 뛰어납니다. RTX 4090 GPU를 사용하는 새로운 방법은 1080p 해상도의 DNA 렌더링 데이터세트에서 400FPS를 달성하고 4K 해상도의 ENeRF-Outdoor 데이터세트에서 80FPS를 달성합니다.

방법 소개

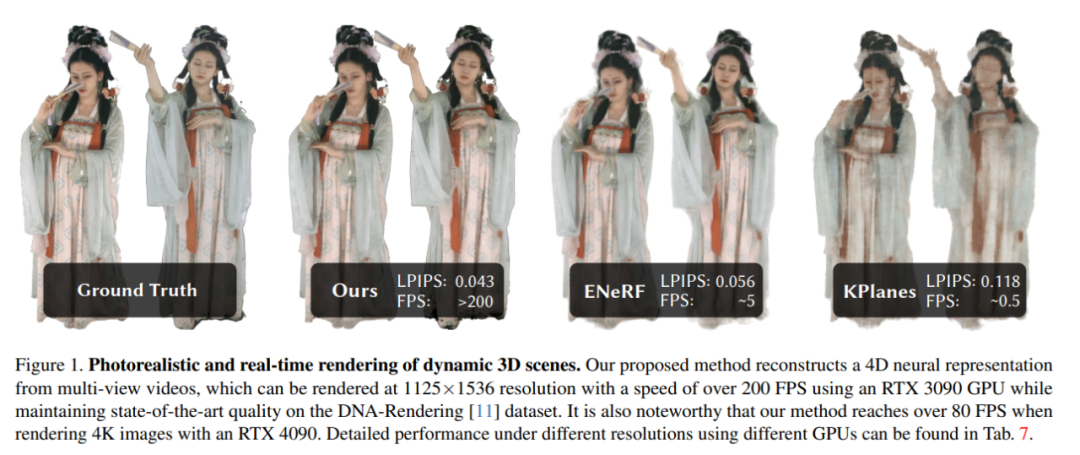

다이내믹한 3D 장면을 포착한 멀티뷰 영상을 바탕으로 본 논문에서는 대상 장면을 재구성하고 실시간으로 뷰 합성을 수행하는 것을 목표로 합니다. 모델 아키텍처 다이어그램은 그림 2에 나와 있습니다.

그런 다음 이 기사에서는 포인트 클라우드를 사용하여 동적 장면을 모델링하는 관련 지식을 소개합니다. 이는 4D 임베딩, 기하학적 모델 및 외관 모델의 관점에서 시작됩니다.

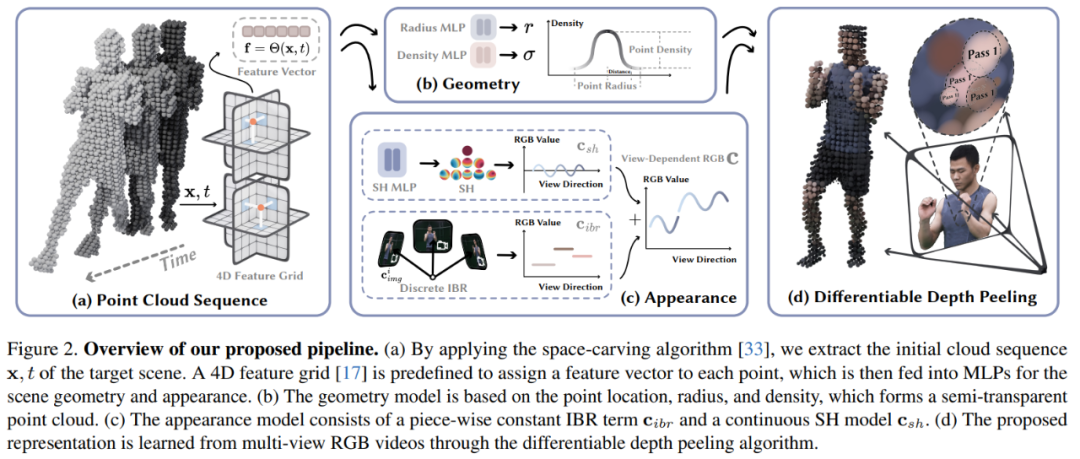

4D 임베딩: 대상 장면의 대략적인 포인트 클라우드가 주어지면 이 논문에서는 신경망과 기능 메시를 사용하여 동적 기하학과 모양을 표현합니다. 특히 이 기사에서는 먼저 6개의 특징 평면 θ_xy, θ_xz, θ_yz, θ_tx, θ_ty 및 θ_tz를 정의하고 K-평면 전략을 사용하여 이 6개 평면을 사용하여 4D 특징 필드 Θ(x, t)를 모델링합니다.

기하학 모델: 거친 포인트 클라우드를 기반으로 동적 장면 기하학은 각 점의 세 가지 속성(항목), 즉 위치 p ∈ R^3, 반경 r ∈ R 및 밀도 σ ∈ R을 학습하여 표현됩니다. 그런 다음 이 점을 사용하여 공간에서 점 x의 부피 밀도가 계산됩니다. 점 위치 p는 최적화 가능한 벡터로 모델링됩니다. 반경 r과 밀도 σ는 식(1)의 특징 벡터 f를 MLP 네트워크에 공급하여 예측됩니다.

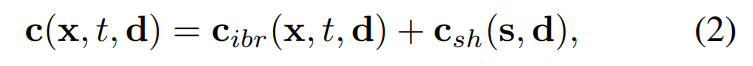

외관 모델: 그림 2c에서 볼 수 있듯이 이 논문에서는 이미지 블렌딩 기술과 SH(구면 조화 함수) 모델을 사용하여 하이브리드 외관 모델을 구축합니다. 여기서 이미지 블렌딩 기술은 이산 뷰 외관 c_ibr을 나타내고 SH 모델은 연속적인 뷰 종속 모양을 나타냅니다. c_sh의 모양입니다. t번째 프레임의 점 x에 대해 뷰 방향 d의 색상은 다음과 같습니다.

차별화 가능한 깊이 필링

이 기사에서 제안한 동적 장면 표현은 다음과 같이 렌더링할 수 있습니다. 깊이 필링 알고리즘을 사용하여 이미지를 생성합니다.

연구원들은 K 렌더링 패스로 구성된 깊이 필링 알고리즘을 구현하기 위해 맞춤형 셰이더를 개발했습니다. 즉, 연구원은 특정 픽셀 u에 대해 다단계 처리를 수행했습니다. 마지막으로 K개의 렌더링 후에 픽셀 u는 정렬 지점 세트 {x_k|k = 1, ..., K}를 얻었습니다.

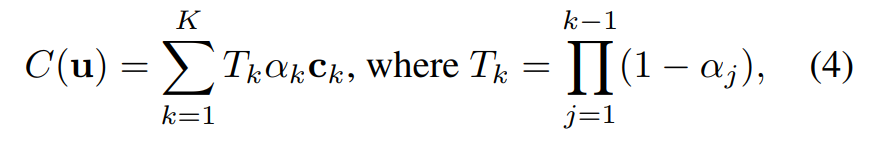

이 점 {x_k|k = 1, ..., K}을 기반으로 볼륨 렌더링에서 픽셀 u의 색상은 다음과 같이 표현됩니다.

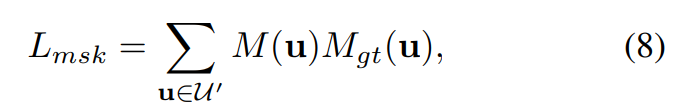

학습 과정에서 렌더링된 픽셀 색상 C(u)가 주어지면 이 논문에서는 이를 실제 픽셀 색상 C_gt(u)와 비교하고 다음 손실 함수를 사용하여 엔드투엔드 방식으로 모델을 최적화합니다.

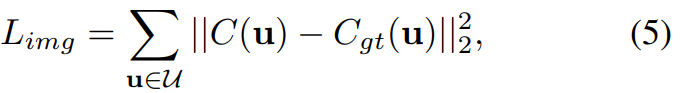

또한 이 문서에서는 지각 손실:

및 마스크 손실:

최종 손실 함수는 다음과 같이 정의됩니다.

실험하고 결과

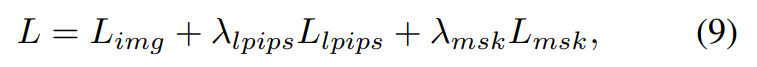

이 문서에서는 DNA 렌더링, ENeRF-Outdoor, NHR 및 Neural3DV 데이터세트에 대한 4K4D 방법을 평가합니다. DNA-Rendering 데이터 세트에 대한

결과는 표 1에 나와 있습니다. 결과는 4K4D 렌더링 속도가 SOTA 성능을 갖춘 ENeRF보다 30배 이상 빠르며 렌더링 품질이 더 우수하다는 것을 보여줍니다.

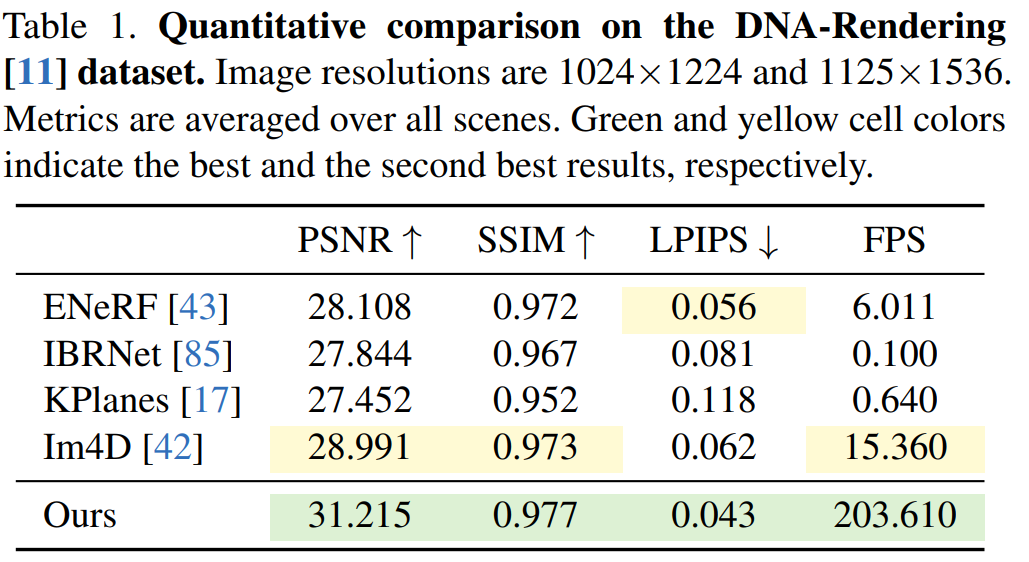

DNA 렌더링 데이터 세트의 질적 결과는 그림 5에 나와 있습니다. KPlanes는 4D 동적 장면의 상세한 모양과 형상을 복구할 수 없지만 다른 이미지 기반 방법은 고품질 외관을 생성합니다. 그러나 이러한 방법은 폐색 및 가장자리 주변에 흐릿한 결과를 생성하여 시각적 품질을 저하시키는 경향이 있는 반면, 4K4D는 200FPS 이상의 정확도 높은 렌더링을 생성할 수 있습니다.

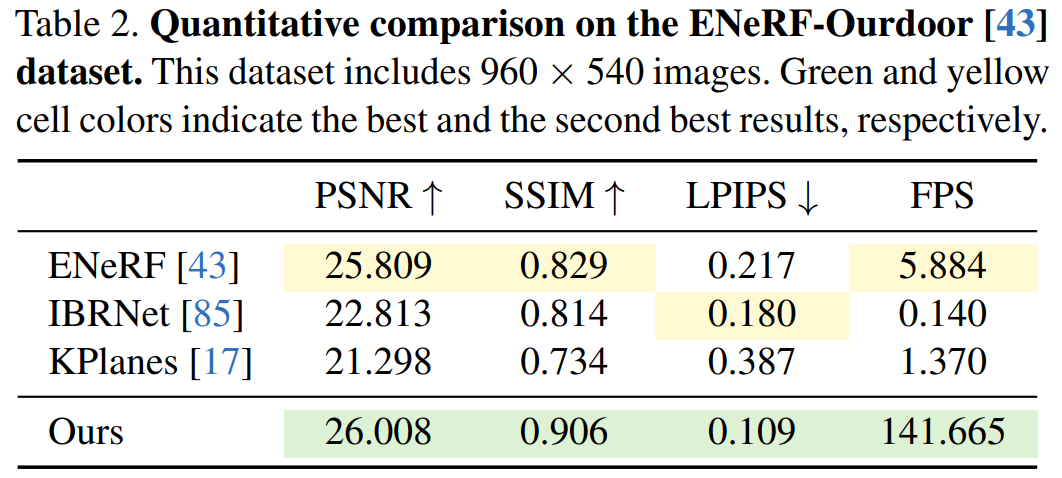

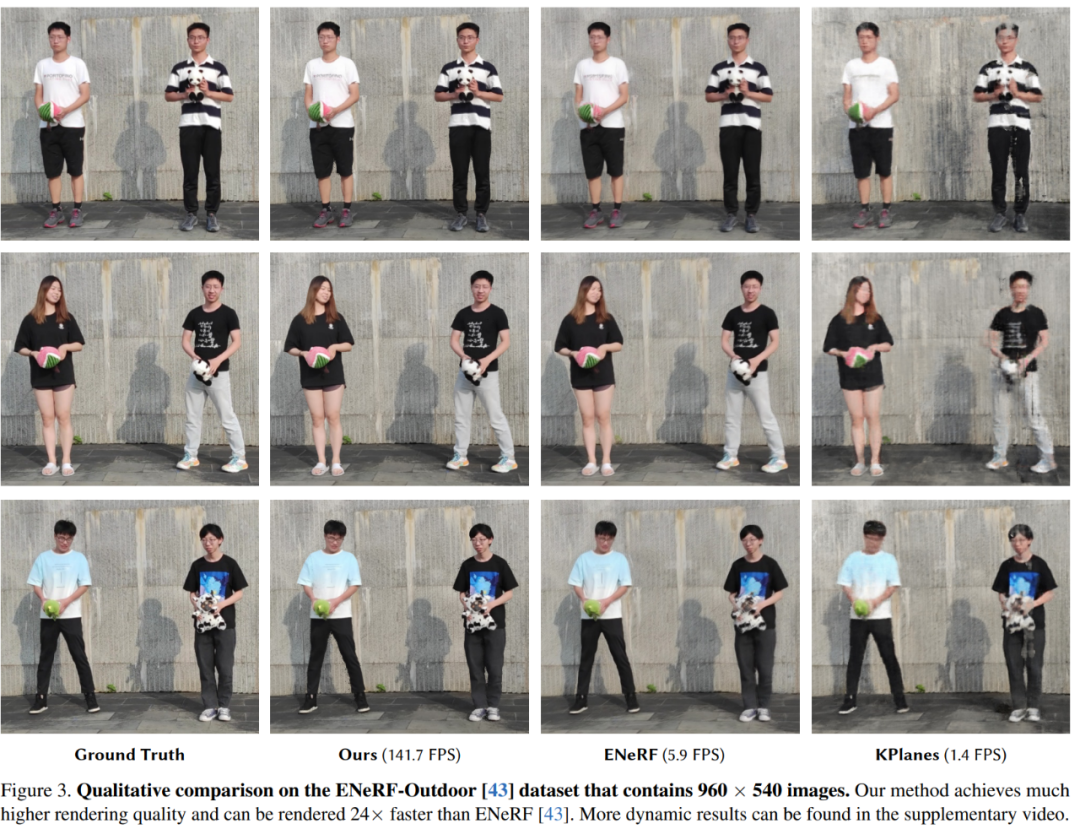

다음 실험에서는 ENeRFOutdoor 데이터세트에 대한 다양한 방법의 정성적, 정량적 결과를 보여줍니다. 표 2에서 볼 수 있듯이 4K4D는 140FPS 이상으로 렌더링할 때 여전히 훨씬 더 나은 결과를 얻었습니다.

ENeRF와 같은 다른 방법은 흐릿한 결과를 생성하는 반면, K-Planse는 그림 3과 같이 이미지 가장자리 주위에 검은색 아티팩트를 포함합니다. 동적 인체와 다양한 배경 영역을 재구성할 수 없습니다. .

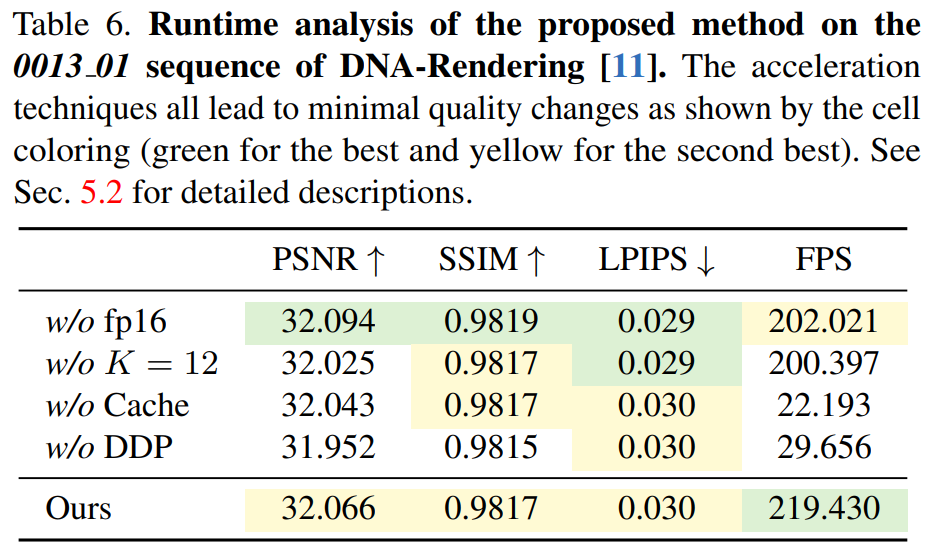

표 6은 미분 깊이 필링 알고리즘의 효율성을 보여 주며, 4K4D는 CUDA 기반 방법보다 7배 이상 빠릅니다.

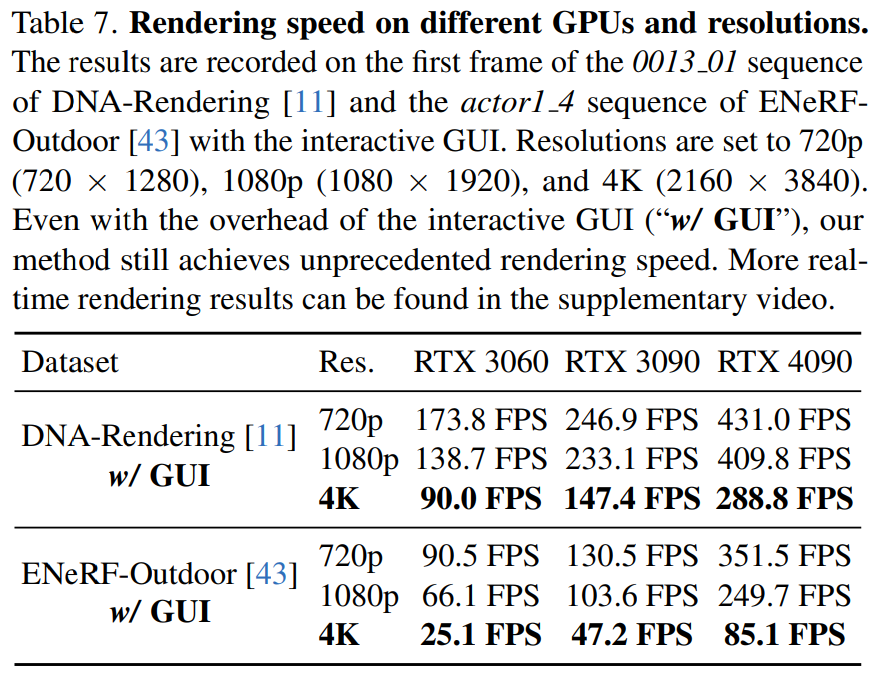

이 기사에서는 표 7의 다양한 해상도에서 다양한 하드웨어(RTX 3060, 3090 및 4090)에서의 4K4D 렌더링 속도도 보고합니다.

자세한 내용은 원본을 확인해주세요.

위 내용은 4K 품질의 3D 합성 비디오는 더 이상 슬라이드쇼에서 정지되지 않으며, 새로운 방법으로 렌더링 속도가 30배 이상 향상됩니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!