대화형 AI 봇과 상호작용해 본 적이 있다면 매우 실망스러운 순간을 기억하실 것입니다. 예를 들어, 전날 대화에서 언급한 중요한 사항은 AI에 의해 완전히 잊어버렸습니다...

대부분의 LLM은 시험을 위해 벼락치기 공부를 하는 학생들처럼 제한된 맥락만 기억할 수 있기 때문입니다. 조사를 통해 "진실이 드러날 것"이다.

AI 비서가 채팅에서 몇 주, 몇 달 전의 대화를 상황에 맞게 참조할 수 있거나 AI 비서에게 수천 페이지에 달하는 보고서를 요약해달라고 요청할 수 있다면 부러워하지 않을까요?

LLM이 더 잘 기억하고 더 많은 내용을 기억할 수 있도록 연구자들은 열심히 노력해 왔습니다. 최근 MIT, Meta AI, Carnegie Mellon University의 연구진은 언어 모델이 끝없는 텍스트를 원활하게 처리할 수 있도록 하는 "StreamingLLM"이라는 방법을 제안했습니다

- 논문 주소: https://arxiv.org /pdf/2309.17453.pdf

- 프로젝트 주소: https://github.com/mit-han-lab/streaming-llm

StreamingLLM은 모델 고유의 "주의 집중 싱크"를 식별하고 저장하는 방식으로 작동합니다. ” (주의가 가라앉음) 추론을 위해 초기 토큰을 고정합니다. 최신 토큰의 롤링 캐싱과 결합된 StreamingLLM은 정확성을 저하시키지 않고 추론 속도를 22배 향상시킵니다. 단 며칠 만에 이 프로젝트는 GitHub 플랫폼에서 2500개의 별을 얻었습니다.

특히 StreamingLLM은 이전 게임의 점수를 정확하게 기억할 수 있는 언어 모델입니다. 긴 계약이나 토론의 내용. AI 어시스턴트의 메모리를 업그레이드하는 것처럼 더 많은 작업 부하를 완벽하게 처리할 수 있습니다

다음으로 기술적인 세부 사항을 살펴보겠습니다.

방법 혁신

일반적으로 LLM은 사전 훈련 중 주의 집중 기간으로 제한됩니다. 이 창 크기를 확장하고 훈련 및 추론 효율성을 향상시키기 위한 많은 이전 작업이 있었지만 LLM의 허용 가능한 시퀀스 길이는 여전히 제한되어 있어 지속적인 배포에 적합하지 않습니다.

본 논문에서 연구자는 LLM 스트리밍 응용 프로그램의 개념을 처음 소개하고 "효율성과 성능을 희생하지 않고 무한히 긴 입력으로 LLM을 배포할 수 있는가?"라는 질문을 제기했습니다.

LLM을 무한히 긴 입력에 적용할 때 입력 스트림을 사용하면 두 가지 주요 과제에 직면하게 됩니다.

1 디코딩 단계에서 변환기 기반 LLM은 그림 1에 표시된 것처럼 모든 이전 토큰의 키 및 값 상태(KV)를 캐시합니다. a) 이로 인해 과도한 메모리 사용이 발생하고 디코딩 대기 시간이 증가할 수 있습니다.

2. 기존 모델에는 길이 추정 기능이 제한되어 있습니다. 즉, 시퀀스 길이가 사전 훈련 중에 설정된 주의 창을 초과하는 경우에도 마찬가지입니다. 장시간 사용하면 성능이 저하됩니다.

직관적인 방법은 Window Attention(그림 1b)이라고 합니다. 이 방법은 가장 최근 토큰의 KV 상태에 대해 고정 크기 슬라이딩 창만 유지할 수 있지만 이는 안정적인 메모리 사용 및 디코딩을 보장합니다. 캐시가 채워진 후 속도가 빨라지지만 시퀀스 길이가 캐시 크기를 초과하거나 첫 번째 토큰의 KV를 제거하면 모델이 충돌합니다. 또 다른 방법은 슬라이딩 윈도우를 다시 계산하는 것입니다(그림 1c 참조). 이 방법은 생성된 각 토큰에 대해 가장 최근 토큰의 KV 상태를 재구성합니다. 성능은 강력하지만 윈도우 내에서 2차 주의를 계산해야 합니다. 결과가 상당히 느려지므로 실제 스트리밍 애플리케이션에는 적합하지 않습니다.

창 주의 실패를 연구하는 과정에서 연구원들은 흥미로운 현상을 발견했습니다. 그림 2에 따르면 이러한 태그가 언어 모델링 작업과 관련되어 있는지 여부에 관계없이 많은 수의 주의 점수가 초기 태그에 할당됩니다.

연구원들은 이러한 토큰을 "주의력 풀"이라고 부릅니다. 의미론적 의미는 부족하지만 많은 관심 점수를 차지합니다. 연구원들은 이 현상을 Softmax(모든 컨텍스트 토큰의 어텐션 점수 합이 1이 되도록 요구함)에 기인한다고 생각합니다. 현재 쿼리가 이전의 많은 토큰과 강하게 일치하지 않더라도 모델은 여전히 이러한 불필요한 어텐션을 전송해야 합니다. . 값은 합이 1이 되도록 어딘가에 할당됩니다. 초기 토큰이 "풀"이 되는 이유는 직관적입니다. 자동 회귀 언어 모델링의 특성으로 인해 초기 토큰은 거의 모든 후속 토큰에 표시되므로 어텐션 풀로 훈련하기가 더 쉽습니다.

위의 통찰력을 바탕으로 연구원은 StreamingLLM을 제안했습니다. 이는 제한된 주의 창으로 훈련된 주의 모델이 미세 조정 없이 무한히 긴 텍스트를 처리할 수 있도록 하는 간단하고 효율적인 프레임워크입니다.

StreamingLLM은 주의 풀의 주의 가치가 높다는 사실을 활용합니다. 실제로 이러한 주의 풀을 유지하면 다음을 수행할 수 있습니다. 주의 점수 분포를 정규 분포에 가깝게 만듭니다. 따라서 StreamingLLM은 관심 풀 토큰의 KV 값(초기 토큰 4개만 있으면 충분함)과 슬라이딩 윈도우의 KV 값만 유지하면 관심 계산을 고정하고 모델 성능을 안정화할 수 있습니다.

Llama-2-[7,13,70] B, MPT-[7,30] B, Falcon-[7,40] B 및 Pythia [2.9,6.9,12] B를 포함한 StreamingLLM 사용 모델 400만 개 이상의 토큰을 안정적으로 시뮬레이션할 수 있습니다.

슬라이딩 창을 다시 계산하는 것과 비교했을 때 StreamingLLM은 성능에 영향을 주지 않고 22.2배 더 빠릅니다.

Evaluation

그림 3과 같이 20K 범위에 대한 실험에서 레이블이 지정된 텍스트의 경우 StreamingLLM의 당혹감은 다음과 같습니다. 슬라이딩 윈도우를 다시 계산하는 Oracle 기준선과 유사합니다. 동시에, 입력 길이가 사전 훈련 기간을 초과하면 Dense attention이 실패하고, 입력 길이가 캐시 크기를 초과하면 window attention이 정체되어 초기 태그가 제거됩니다

그림 5 추가 StreamingLLM의 신뢰성이 입증되었으며 다양한 모델 계열 및 크기를 포괄하는 400만 개 이상의 토큰을 포함하여 특이한 크기의 텍스트를 처리할 수 있습니다. 이러한 모델에는 Llama-2-[7,13,70] B, Falcon-[7,40] B, Pythia-[2.8,6.9,12] B 및 MPT-[7,30] B

이 포함됩니다. 이후 연구원들은 "어텐션 풀"이라는 가설을 확인하고 언어 모델이 사전 훈련될 수 있으며 스트리밍 배포 중에 하나의 어텐션 풀 토큰만 필요하다는 것을 증명했습니다. 특히 모든 훈련 샘플 시작 시 지정된 주의 풀로 학습 가능한 추가 토큰을 추가할 것을 제안합니다. 연구원들은 1억 6천만 개의 매개변수로 언어 모델을 처음부터 사전 훈련함으로써 우리의 방법이 모델의 성능을 유지할 수 있음을 입증했습니다. 이는 동일한 수준의 성능을 달성하기 위해 여러 초기 토큰을 주의 풀로 다시 도입해야 하는 현재 언어 모델과 뚜렷한 대조를 이룹니다.

마지막으로 연구원들은 StreamingLLM의 디코딩 지연 시간과 메모리 사용량을 재계산 슬라이딩 윈도우와 비교하고 단일 NVIDIA A6000 GPU에서 Llama-2-7B 및 Llama-2-13B 모델을 사용하여 테스트했습니다. 그림 10의 결과에 따르면 캐시 크기가 증가함에 따라 StreamingLLM의 디코딩 속도는 선형적으로 증가하는 반면 디코딩 지연은 2차적으로 증가합니다. 실험에 따르면 StreamingLLM은 각 토큰의 속도가 최대 22.2배까지 증가하여 인상적인 속도 향상을 달성하는 것으로 입증되었습니다.

위 내용은 최대 4백만 개의 토큰 컨텍스트와 22배 더 빠른 추론을 갖춘 StreamingLLM은 인기를 얻었으며 GitHub에서 별 2,500개를 받았습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

从VAE到扩散模型:一文解读以文生图新范式Apr 08, 2023 pm 08:41 PM

从VAE到扩散模型:一文解读以文生图新范式Apr 08, 2023 pm 08:41 PM1 前言在发布DALL·E的15个月后,OpenAI在今年春天带了续作DALL·E 2,以其更加惊艳的效果和丰富的可玩性迅速占领了各大AI社区的头条。近年来,随着生成对抗网络(GAN)、变分自编码器(VAE)、扩散模型(Diffusion models)的出现,深度学习已向世人展现其强大的图像生成能力;加上GPT-3、BERT等NLP模型的成功,人类正逐步打破文本和图像的信息界限。在DALL·E 2中,只需输入简单的文本(prompt),它就可以生成多张1024*1024的高清图像。这些图像甚至

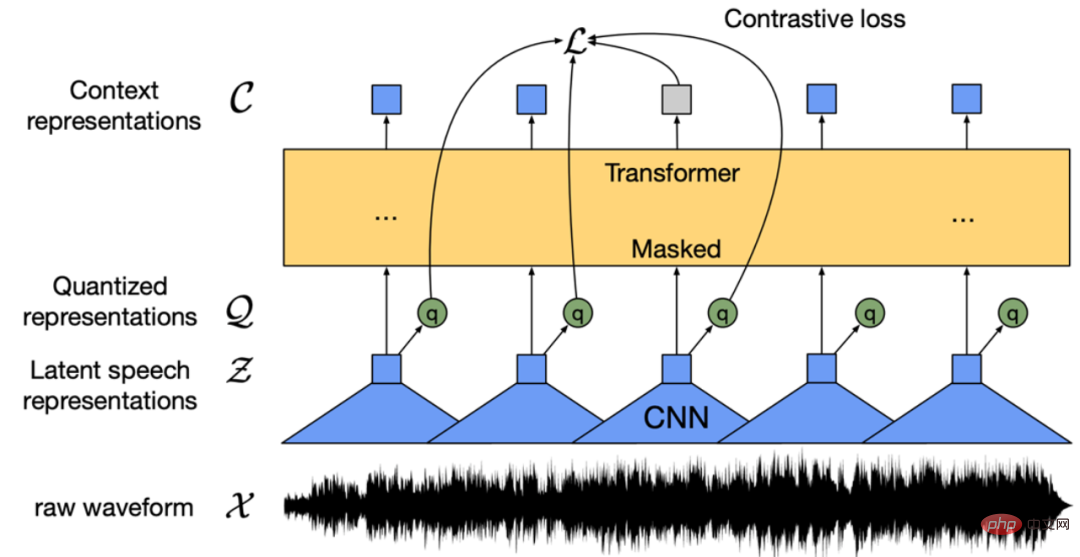

找不到中文语音预训练模型?中文版 Wav2vec 2.0和HuBERT来了Apr 08, 2023 pm 06:21 PM

找不到中文语音预训练模型?中文版 Wav2vec 2.0和HuBERT来了Apr 08, 2023 pm 06:21 PMWav2vec 2.0 [1],HuBERT [2] 和 WavLM [3] 等语音预训练模型,通过在多达上万小时的无标注语音数据(如 Libri-light )上的自监督学习,显著提升了自动语音识别(Automatic Speech Recognition, ASR),语音合成(Text-to-speech, TTS)和语音转换(Voice Conversation,VC)等语音下游任务的性能。然而这些模型都没有公开的中文版本,不便于应用在中文语音研究场景。 WenetSpeech [4] 是

普林斯顿陈丹琦:如何让「大模型」变小Apr 08, 2023 pm 04:01 PM

普林斯顿陈丹琦:如何让「大模型」变小Apr 08, 2023 pm 04:01 PM“Making large models smaller”这是很多语言模型研究人员的学术追求,针对大模型昂贵的环境和训练成本,陈丹琦在智源大会青源学术年会上做了题为“Making large models smaller”的特邀报告。报告中重点提及了基于记忆增强的TRIME算法和基于粗细粒度联合剪枝和逐层蒸馏的CofiPruning算法。前者能够在不改变模型结构的基础上兼顾语言模型困惑度和检索速度方面的优势;而后者可以在保证下游任务准确度的同时实现更快的处理速度,具有更小的模型结构。陈丹琦 普

解锁CNN和Transformer正确结合方法,字节跳动提出有效的下一代视觉TransformerApr 09, 2023 pm 02:01 PM

解锁CNN和Transformer正确结合方法,字节跳动提出有效的下一代视觉TransformerApr 09, 2023 pm 02:01 PM由于复杂的注意力机制和模型设计,大多数现有的视觉 Transformer(ViT)在现实的工业部署场景中不能像卷积神经网络(CNN)那样高效地执行。这就带来了一个问题:视觉神经网络能否像 CNN 一样快速推断并像 ViT 一样强大?近期一些工作试图设计 CNN-Transformer 混合架构来解决这个问题,但这些工作的整体性能远不能令人满意。基于此,来自字节跳动的研究者提出了一种能在现实工业场景中有效部署的下一代视觉 Transformer——Next-ViT。从延迟 / 准确性权衡的角度看,

Stable Diffusion XL 现已推出—有什么新功能,你知道吗?Apr 07, 2023 pm 11:21 PM

Stable Diffusion XL 现已推出—有什么新功能,你知道吗?Apr 07, 2023 pm 11:21 PM3月27号,Stability AI的创始人兼首席执行官Emad Mostaque在一条推文中宣布,Stable Diffusion XL 现已可用于公开测试。以下是一些事项:“XL”不是这个新的AI模型的官方名称。一旦发布稳定性AI公司的官方公告,名称将会更改。与先前版本相比,图像质量有所提高与先前版本相比,图像生成速度大大加快。示例图像让我们看看新旧AI模型在结果上的差异。Prompt: Luxury sports car with aerodynamic curves, shot in a

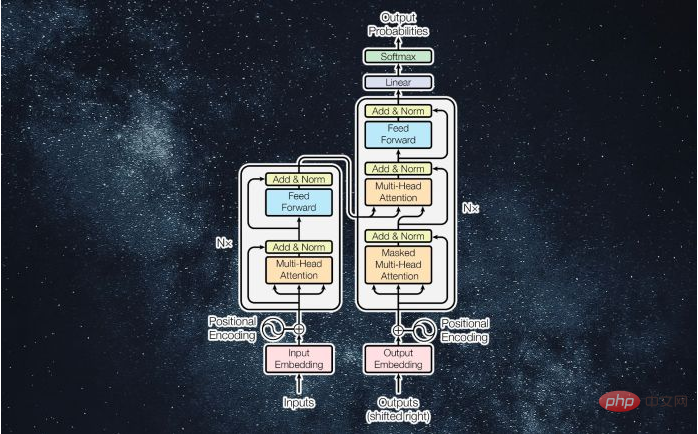

什么是Transformer机器学习模型?Apr 08, 2023 pm 06:31 PM

什么是Transformer机器学习模型?Apr 08, 2023 pm 06:31 PM译者 | 李睿审校 | 孙淑娟近年来, Transformer 机器学习模型已经成为深度学习和深度神经网络技术进步的主要亮点之一。它主要用于自然语言处理中的高级应用。谷歌正在使用它来增强其搜索引擎结果。OpenAI 使用 Transformer 创建了著名的 GPT-2和 GPT-3模型。自从2017年首次亮相以来,Transformer 架构不断发展并扩展到多种不同的变体,从语言任务扩展到其他领域。它们已被用于时间序列预测。它们是 DeepMind 的蛋白质结构预测模型 AlphaFold

五年后AI所需算力超100万倍!十二家机构联合发表88页长文:「智能计算」是解药Apr 09, 2023 pm 07:01 PM

五年后AI所需算力超100万倍!十二家机构联合发表88页长文:「智能计算」是解药Apr 09, 2023 pm 07:01 PM人工智能就是一个「拼财力」的行业,如果没有高性能计算设备,别说开发基础模型,就连微调模型都做不到。但如果只靠拼硬件,单靠当前计算性能的发展速度,迟早有一天无法满足日益膨胀的需求,所以还需要配套的软件来协调统筹计算能力,这时候就需要用到「智能计算」技术。最近,来自之江实验室、中国工程院、国防科技大学、浙江大学等多达十二个国内外研究机构共同发表了一篇论文,首次对智能计算领域进行了全面的调研,涵盖了理论基础、智能与计算的技术融合、重要应用、挑战和未来前景。论文链接:https://spj.scien

AI模型告诉你,为啥巴西最可能在今年夺冠!曾精准预测前两届冠军Apr 09, 2023 pm 01:51 PM

AI模型告诉你,为啥巴西最可能在今年夺冠!曾精准预测前两届冠军Apr 09, 2023 pm 01:51 PM说起2010年南非世界杯的最大网红,一定非「章鱼保罗」莫属!这只位于德国海洋生物中心的神奇章鱼,不仅成功预测了德国队全部七场比赛的结果,还顺利地选出了最终的总冠军西班牙队。不幸的是,保罗已经永远地离开了我们,但它的「遗产」却在人们预测足球比赛结果的尝试中持续存在。在艾伦图灵研究所(The Alan Turing Institute),随着2022年卡塔尔世界杯的持续进行,三位研究员Nick Barlow、Jack Roberts和Ryan Chan决定用一种AI算法预测今年的冠军归属。预测模型图

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

PhpStorm 맥 버전

최신(2018.2.1) 전문 PHP 통합 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

에디트플러스 중국어 크랙 버전

작은 크기, 구문 강조, 코드 프롬프트 기능을 지원하지 않음

mPDF

mPDF는 UTF-8로 인코딩된 HTML에서 PDF 파일을 생성할 수 있는 PHP 라이브러리입니다. 원저자인 Ian Back은 자신의 웹 사이트에서 "즉시" PDF 파일을 출력하고 다양한 언어를 처리하기 위해 mPDF를 작성했습니다. HTML2FPDF와 같은 원본 스크립트보다 유니코드 글꼴을 사용할 때 속도가 느리고 더 큰 파일을 생성하지만 CSS 스타일 등을 지원하고 많은 개선 사항이 있습니다. RTL(아랍어, 히브리어), CJK(중국어, 일본어, 한국어)를 포함한 거의 모든 언어를 지원합니다. 중첩된 블록 수준 요소(예: P, DIV)를 지원합니다.