'소셜 마스터' GPT-4! 표현을 해석하고 심리학에 대해 추측하는 방법을 안다.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB앞으로

- 2023-07-22 20:29:131491검색

활기찬 대화와 잔소리가 가득한 활기찬 칵테일 파티에 참석하고 있다고 상상해 보세요.

이 때, 당신은 구석에 행복하게 숨어 있는 여유로운 관찰자입니다. 그러나 파티의 중심에 있지 않더라도 사람들의 언어적, 비언어적 신호를 읽으면 서로 다른 사람들 사이의 사회적 관계를 쉽게 파악하고 무슨 일이 일어나고 있는지 이해할 수 있으며 심지어 공개적이거나 은밀한 사회적 메시지를 해독할 수도 있습니다.

LLM이 이 수준의 사회적 기술을 재현할 수 있다면 어떨까요? 아니, 그게 바로 코코마인드다.

영상을 열면 모델이 캐릭터의 표정을 분석하고 캐릭터의 감정에 대해 결론을 내리기 시작합니다.

그런 다음 오른쪽 프롬프트 표시줄에 질문을 하면 AI가 영상 속 소셜 퍼즐의 저류를 추가로 분석할 수도 있습니다.

(솔직히 말해서 일부 사람들에게는 어렵습니다.)

Pictures

Pictures

Koko Mind에는 150개의 복잡한 다자간 사회적 상호 작용과 무료 텍스트 질문 및 답변이 포함되어 있습니다.

데이터 다양성과 확장성을 보장하고 데이터 오염을 방지하기 위해 모든 사회적 상호 작용, 질문 및 답변은 GPT-4에서 생성된 후 인간 전문가에 의해 검증됩니다.

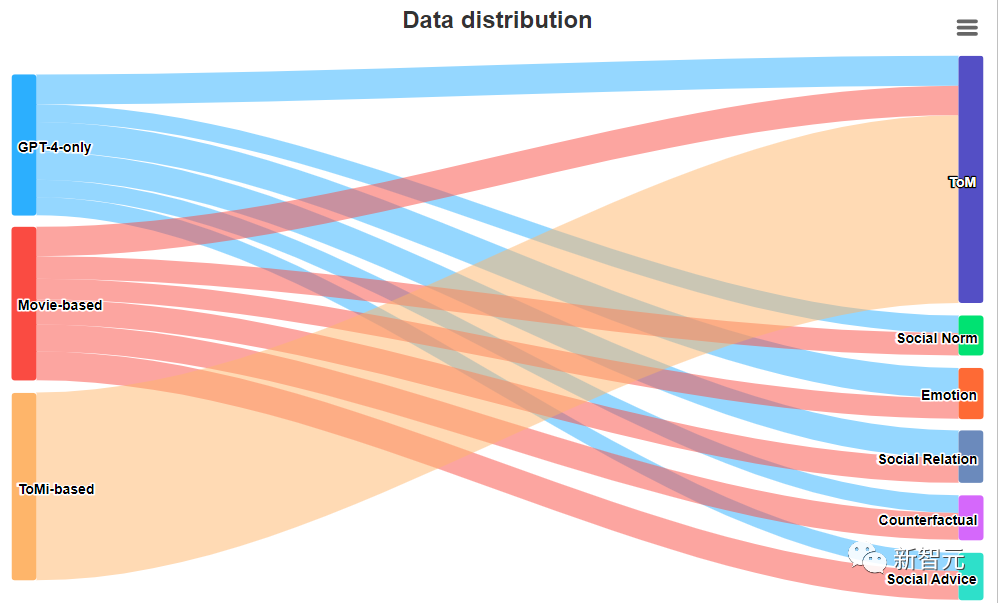

분석 데이터는 세 가지 소스를 기반으로 합니다.

-

GPT-4 전용: 이 하위 집합은 힌트를 통해서만 GPT-4에서 생성됩니다.

-

영화 기준 : 데이터 오염을 방지하기 위해 이 부분은 2022년 이후 개봉한 영화에서 추출한 다양한 장면을 기준으로 합니다. GPT-4는 핵심 본질을 유지하면서 자체 요소를 추가하여 이러한 장면을 형성하는 역할을 담당합니다.

- ToMi 기반: 이 섹션에는 시뮬레이션된 데이터세트 ToMi를 기반으로 한 데이터가 포함되어 있습니다. 여기에는 마음 이론에 대한 고전적인 테스트인 물리적 개체를 다른 장소로 이동하는 작업이 포함됩니다. 물론 이러한 사회적 상호 작용은 GPT-4에 의해 수정되고 확장되어야 합니다.

세 가지 데이터 소스의 비율은 다음과 같습니다.

그림

그림

각 사회적 상호 작용에 대해 연구자는 사회적 이해와 밀접하게 관련된 다음 측면을 탐색하기 위해 다양한 질문을 합니다.

-

마음 이론: 다른 사람의 정신 상태와 관점에 대한 이해를 평가하는 질문입니다.

-

사회 규범: 상황에서 사회적 가치와 규범을 식별하기 위해 고안된 질문입니다.

-

감정 인식: 맥락에서 감정적인 요소를 식별하고 이해하는 것을 목표로 하는 문제입니다.

-

사회적 관계: 대인 관계의 역동성과 관계에 중점을 둡니다.

-

반사실 질문: 대안적인 결과나 가능성을 탐색하기 위해 고안된 가상 쿼리입니다.

- 사회적 조언: 특정 상황과 관련된 조언이나 권장 조치를 제안하는 질문입니다.

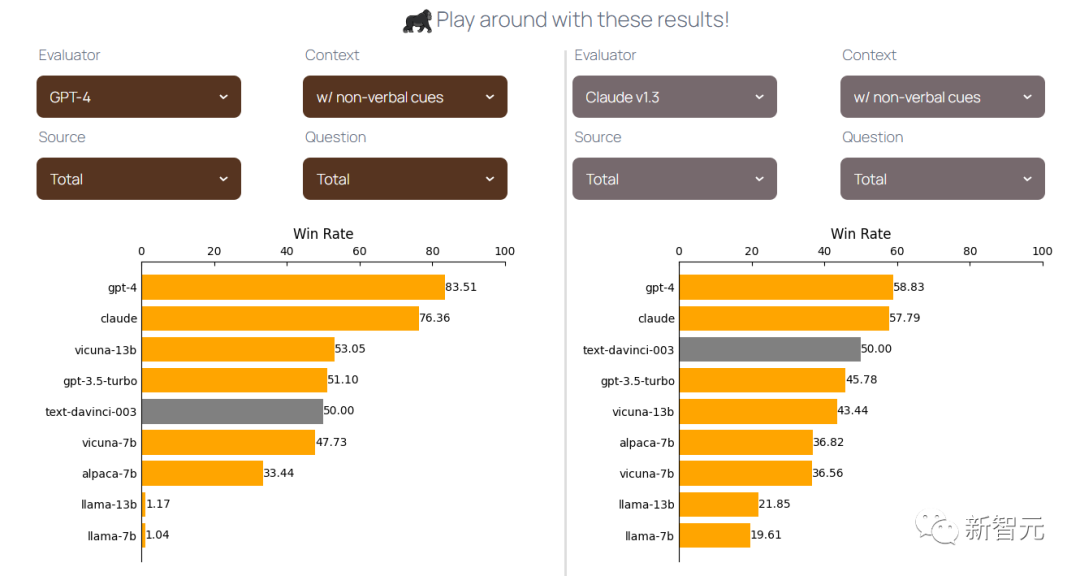

연구원들은 AlpacaEval 이후 다양한 모델을 평가하기 위해 text-davinci-003을 참조 자료로 사용했습니다.

연구원들은 괄호 안의 비언어적 신호를 문맥에서 제거했습니다(예: 긴장해서 커피를 마시는 것 등).

다음은 몇 가지 흥미로운 내용입니다.

-

두 모델 중 GPT-4는 Claude에 비해 우승 모델을 식별하는 데 더 큰 확신과 확신을 보였습니다.

-

Claude는 상황에 비언어적 단서가 없고 상호 작용이 전적으로 GPT-4에 의해 생성되거나 영화를 기반으로 하는 경우 GPT-4보다 성능이 뛰어납니다.

- 그리고 맥락에 비언어적 단서가 포함되어 있으면 GPT-4가 항상 Claude보다 낫습니다.

(한 가지 가능한 설명은 GPT-4가 추가적인 비언어적 정보를 더 잘 이해할 수 있는 다중 모드 모델이라는 것입니다.)

블로그 게시물에서 연구원들은 성능을 명확하게 볼 수 있는 표를 그렸습니다. 각 모델의.

Pictures

Pictures

결과는 여러 면에서 흥미롭지만 특정 제한 사항도 있습니다. 첫째, Koko Mind는 상대적으로 작기 때문에 연구자 결론의 광범위한 적용 가능성과 포괄성이 제한될 수 있습니다.

두 번째로 Koko Mind의 모든 상호 작용은 GPT-4에 의해 생성되며 수동 확인이 필요하므로 데이터 세트 확장이 어렵습니다.

또한 Koko Mind는 데이터 세트에서 인간이 검증한 답변을 제공하지만 연구원들은 이러한 답변을 평가 시 참조로 사용하지 않았으며 이러한 답변은 GPT-4에 의해 생성되었으므로 GPT-4에 편향될 수 있습니다. .

향후 연구에서는 인간이 검증한 기계 생성 참조 답변을 사용하여 모델을 평가하는 방법에 중점을 둘 수 있습니다.

물론, 종류의 한계에도 불구하고 연구자들은 여전히 Koko Mind를 사회 지능, 다중 모드 언어 모델 등과 관련된 미래 연구의 발판으로 간주합니다.

위 내용은 '소셜 마스터' GPT-4! 표현을 해석하고 심리학에 대해 추측하는 방법을 안다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!