다중 모드 제어 가능 이미지 생성을 위한 통합 모델이 출시되었으며 모든 모델 매개변수 및 추론 코드는 오픈 소스입니다.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB앞으로

- 2023-06-06 17:12:041308검색

- 문서 주소: https://arxiv.org/abs/2305.11147

- 코드 주소: https://github.com/salesforce/UniControl

- 프로젝트 홈페이지: https://shorturl.at/lmMX6

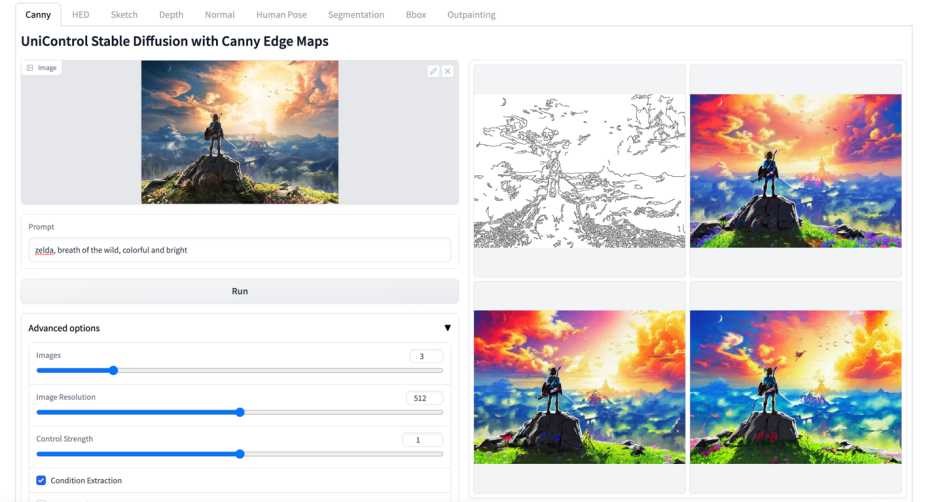

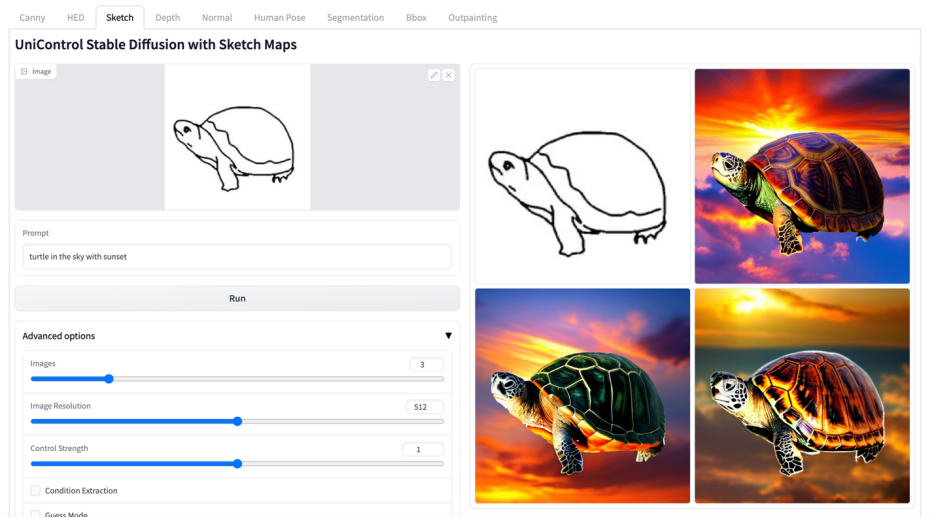

소개: Stable Diffusion은 강력한 시각적 생성 능력을 보여줍니다. 그러나 공간적, 구조적 또는 기하학적 제어를 통해 이미지를 생성하는 데는 종종 부족합니다. ControlNet [1] 및 T2I-adpater [2]와 같은 작업은 다양한 양식에 대해 제어 가능한 이미지 생성을 달성하지만 단일 통합 모델에서 다양한 시각적 조건에 적응할 수 있는 능력은 아직 해결되지 않은 과제로 남아 있습니다. UniControl은 단일 프레임워크 내에 제어 가능한 다양한 C2I(조건-이미지) 작업을 통합합니다. UniControl이 다양한 시각적 조건을 처리할 수 있도록 하기 위해 저자는 다양한 C2I 작업에 동시에 적응할 수 있도록 다운스트림 조건부 확산 모델을 조정하는 작업 인식 HyperNet을 도입했습니다. UniControl은 9가지 C2I 작업에 대한 교육을 받았으며 강력한 시각적 생성 기능과 제로샷 일반화 기능을 보여줍니다. 저자는 모델 매개변수와 추론 코드를 오픈 소스로 공개했습니다. 데이터 세트와 학습 코드도 가능한 한 빨리 오픈 소스로 공개될 예정입니다.

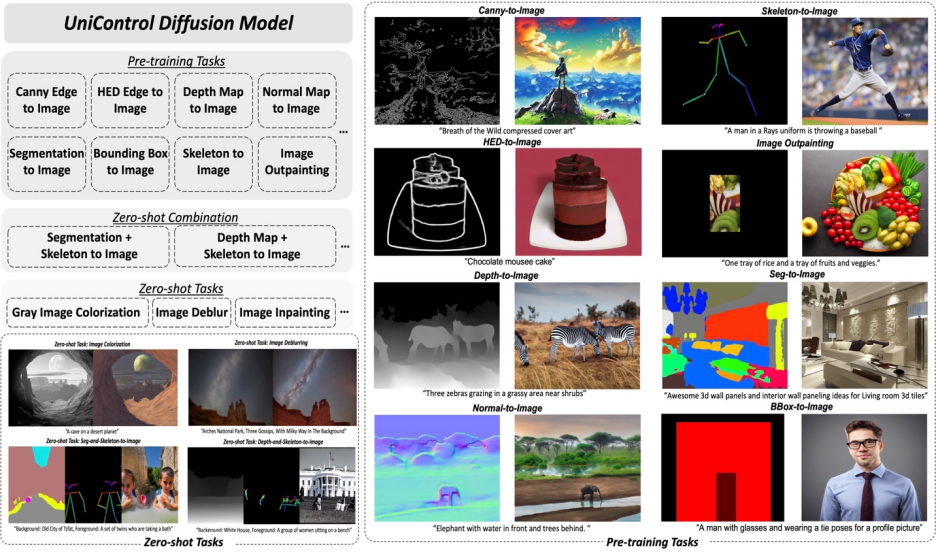

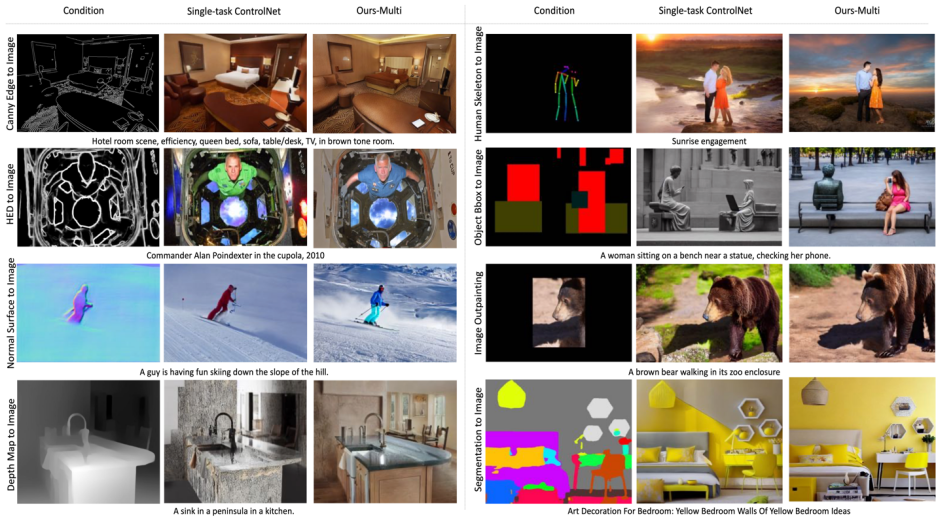

그림 1: UniControl 모델은 여러 사전 훈련 작업과 제로샷 작업으로 구성됩니다.

동기: 기존 제어 가능한 이미지 생성 모델은 모두 단일을 목표로 합니다. 그러나 Taskonomy[3]와 같은 작업은 서로 다른 시각적 양식 간에 기능과 정보가 공유된다는 것을 입증합니다. 따라서 이 기사에서는 통합된 다중 모드 모델이 큰 잠재력을 가지고 있다고 믿습니다.

해결책: 이 기사에서는 UniControl에서 다중 모드 조건 생성 기능을 구현하기 위해 MOE 스타일 어댑터 및 작업 인식 HyperNet을 제안합니다. 그리고 저자는 9개의 주요 작업, 2천만 개 이상의 이미지 조건 프롬프트 트리플 및 이미지 크기 ≥512를 포함하는 새로운 데이터 세트 MultiGen-20M을 만들었습니다.

장점: 1) 더 컴팩트한 모델(1.4B #params, 5.78GB 체크포인트), 여러 작업을 구현하기 위한 더 적은 매개변수. 2) 더욱 강력해진 시각적 생성 기능과 제어 정확도. 3) 본 적이 없는 방식에 대한 제로샷 일반화 능력.

1. 소개

생성 기본 모델은 자연어 처리, 컴퓨터 비전, 오디오 처리 및 로봇 제어와 같은 분야에서 인공 지능이 상호 작용하는 방식을 변화시키고 있습니다. 자연어 처리에서 InstructGPT 또는 GPT-4와 같은 생성 기반 모델은 다양한 작업에서 우수한 성능을 발휘하며 이러한 멀티태스킹 기능은 가장 매력적인 기능 중 하나입니다. 또한, 보이지 않는 작업을 처리하기 위해 제로샷 또는 퓨샷 학습을 수행할 수 있습니다.

그러나 시각 영역의 생성 모델에서는 이러한 멀티 태스킹 기능이 눈에 띄지 않습니다. 텍스트 설명은 생성된 이미지의 내용을 제어하는 유연한 방법을 제공하지만 픽셀 수준의 공간적, 구조적 또는 기하학적 제어를 제공하는 데는 종종 부족합니다. ControlNet, T2I 어댑터와 같은 최근의 인기 있는 연구에서는 SDM(안정 확산 모델)을 향상하여 정밀한 제어를 달성할 수 있습니다. 그러나 CLIP과 같은 통합 모듈로 처리할 수 있는 언어 단서와 달리 각 ControlNet 모델은 교육받은 특정 양식만 처리할 수 있습니다.

이전 연구의 한계를 극복하기 위해 본 논문에서는 언어와 다양한 시각적 조건을 모두 처리할 수 있는 통합 확산 모델인 UniControl을 제안합니다. UniControl의 통합 설계를 통해 교육 및 추론 효율성이 향상되고 제어 가능 생성이 향상됩니다. 반면 UniControl은 다양한 시각적 조건 간의 고유한 연결을 활용하여 각 조건의 생성 효과를 향상시킵니다.

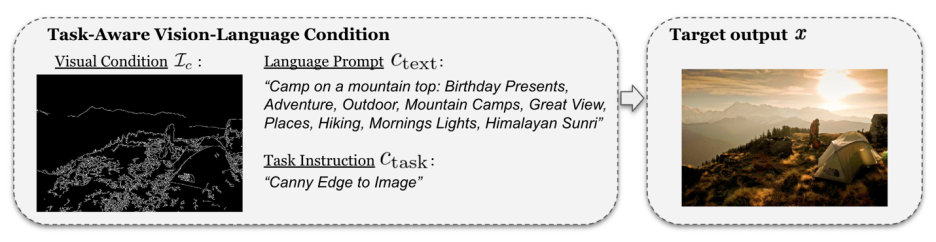

UniControl의 통합 제어 가능 생성 기능은 두 부분으로 구성됩니다. 하나는 "MOE 스타일 어댑터"이고 다른 하나는 "작업 인식 HyperNet"입니다. MOE 스타일 어댑터에는 약 70K 매개변수가 있으며 다양한 양식에서 하위 수준 기능 맵을 학습할 수 있습니다. 작업 인식 HyperNet은 작업 지침을 자연어 프롬프트로 입력하고 다운스트림 모델 매개변수를 변조하기 위해 다운스트림 네트워크에 내장할 작업 임베딩을 출력할 수 있습니다. 다양한 모달 입력에 적응합니다.

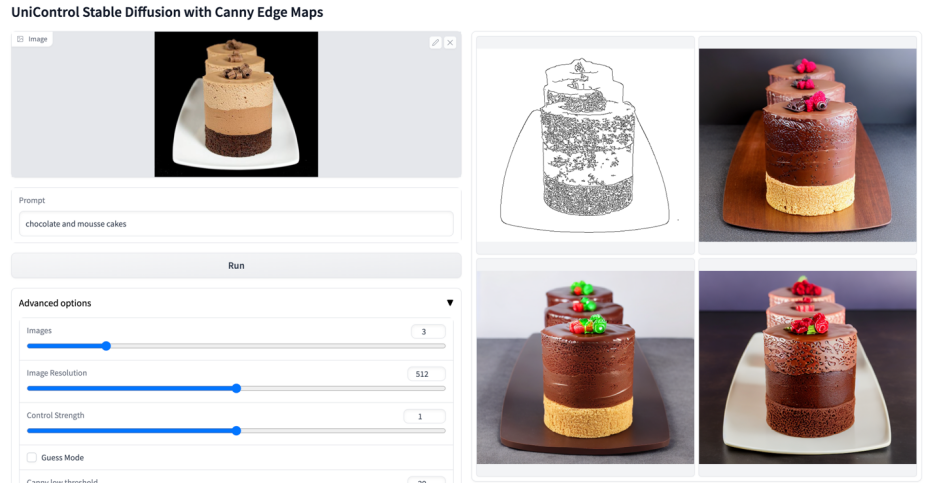

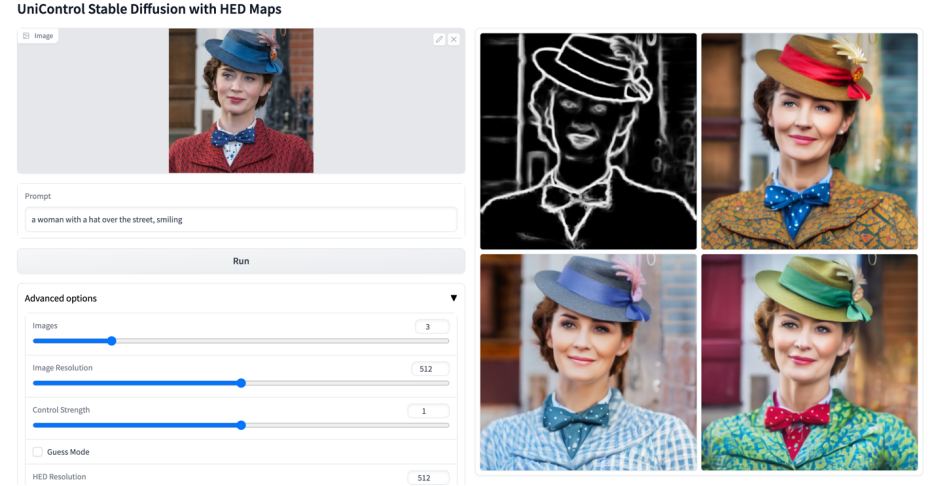

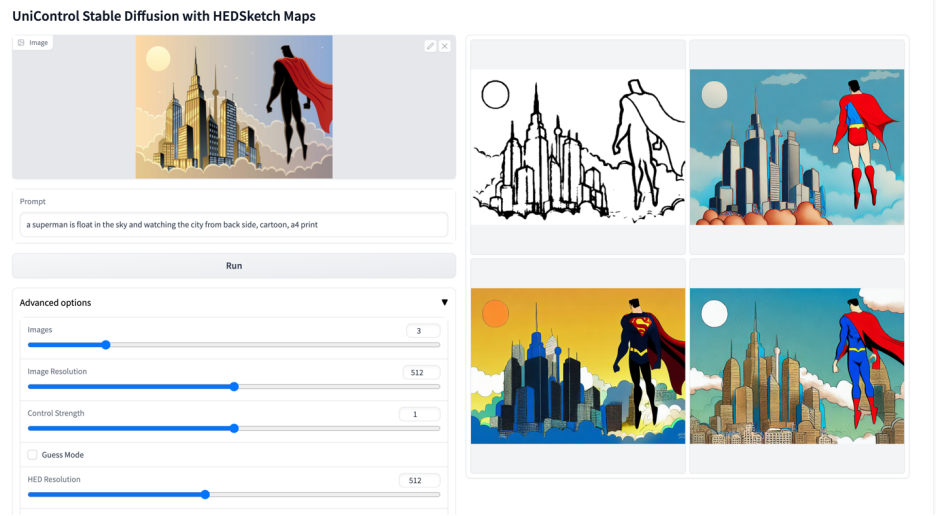

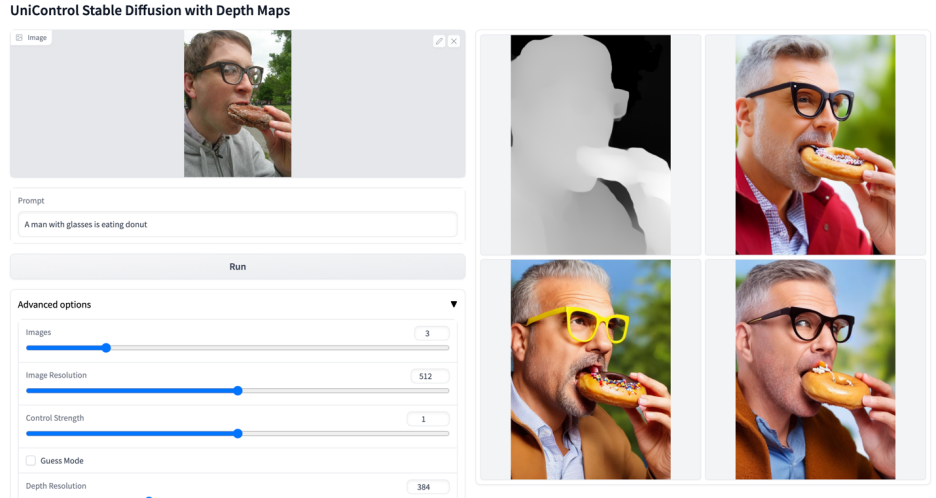

이 연구에서는 에지(Canny, HED, Sketch), 영역 매핑(Segmentation, Object Bound) Box), 뼈대(인간 뼈대), 기하학(깊이, 법선 표면) 및 이미지 편집(이미지 아웃페인팅). 그런 다음 연구에서는 NVIDIA A100 하드웨어에서 UniControl을 5,000 GPU 시간 이상 훈련했습니다(새로운 모델은 현재도 계속 훈련되고 있습니다). 그리고 UniControl은 새로운 작업에 대한 제로샷 적응성을 보여줍니다.

본 연구의 기여는 다음과 같이 요약할 수 있습니다.

- 본 연구는 제어 가능한 비전 생성을 위해 다양한 시각 조건(1.4B #params, 5.78GB 체크포인트)을 처리할 수 있는 통합 모델인 UniControl을 제안합니다.

- 이 연구에서는 5가지 범주의 9가지 작업을 포괄하는 2천만 개 이상의 이미지-텍스트-조건 트리플이 포함된 새로운 다중 조건 시각적 생성 데이터 세트를 수집했습니다.

- 이 연구에서는 다양한 시각적 조건 간의 본질적인 관계를 학습함으로써 통합 모델 UniControl이 단일 작업별로 제어된 이미지 생성 성능을 능가한다는 것을 입증하기 위한 실험을 수행했습니다.

- UniControl은 제로샷 방식으로 보이지 않는 작업에 적응하는 능력을 보여줌으로써 개방형 환경에서 광범위하게 사용할 수 있는 가능성과 잠재력을 보여줍니다.

2. 모델 디자인

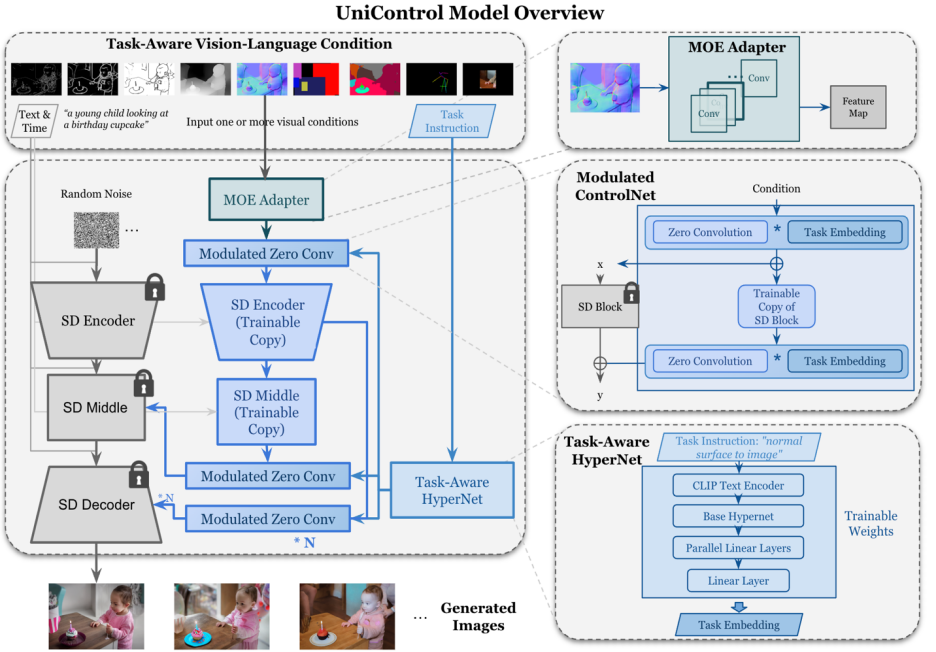

그림 2: 모델 구조. 여러 작업을 수용하기 위해 연구에서는 작업당 약 70K 매개변수가 있는 MOE 스타일 어댑터와 7개의 제로 컨벌루션 레이어를 변조하는 작업 인식 HyperNet(~12M 매개변수)을 설계했습니다. 이 구조를 통해 단일 모델에서 다중 작업 기능을 구현할 수 있으므로 다중 작업의 다양성을 보장할 뿐만 아니라 기본 매개변수 공유도 유지됩니다. 동등한 스택 단일 작업 모델(모델당 약 1.4B 매개변수)에 비해 모델 크기가 크게 감소합니다.

UniControl 모델 설계는 두 가지 속성을 보장합니다.

1) 다양한 형식의 하위 수준 기능 간의 정렬 불량을 극복합니다. 이를 통해 UniControl은 모든 작업에서 필요하고 고유한 정보를 학습할 수 있습니다. 예를 들어 모델이 분할 맵을 시각적 조건으로 사용하는 경우 3D 정보가 무시될 수 있습니다.

2) 업무 전반에 걸쳐 메타지식을 학습할 수 있습니다. 이를 통해 모델은 작업 간의 공유 지식과 작업 간의 차이점을 이해할 수 있습니다.

이러한 속성을 제공하기 위해 모델에는 MOE 스타일 어댑터와 작업 인식 HyperNet이라는 두 가지 새로운 모듈이 도입되었습니다.

MOE 스타일 어댑터는 컨볼루션 모듈 세트이며, 각 어댑터는 다양한 낮은 수준의 시각적 조건의 기능을 캡처하기 위해 UniControl로 사용되는 MOE(Mixture of Experts Model)에서 영감을 받은 별도의 양식에 해당합니다. 이 어댑터 모듈에는 약 70,000개의 매개변수가 있으며 계산 효율성이 매우 높습니다. 그런 다음 시각적 특징은 처리를 위해 통합 네트워크에 공급됩니다.

작업 인식 HyperNet은 작업 명령 조건을 통해 ControlNet의 제로 컨볼루션 모듈을 조정합니다. HyperNet은 먼저 작업 지침을 작업 임베딩에 투영한 다음 연구원들은 ControlNet의 제로 컨볼루션 레이어에 작업 임베딩을 주입합니다. 여기서 작업 임베딩은 제로 컨볼루션 계층의 컨볼루션 커널 행렬 크기에 해당합니다. StyleGAN [4]과 유사하게 본 연구에서는 두 개를 직접 곱하여 컨볼루션 매개변수를 변조하고 변조된 컨볼루션 매개변수를 최종 컨볼루션 매개변수로 사용합니다. 따라서 각 작업의 변조된 제로 컨볼루션 매개변수가 다릅니다. 이는 각 양식에 대한 모델의 적응성을 보장합니다. 또한 모든 가중치가 공유됩니다.

3. 모델 훈련

SDM 또는 ControlNet과 달리 이러한 모델의 이미지 생성 조건은 단일 언어 신호 또는 canny와 같은 단일 유형의 시각적 조건입니다. UniControl은 다양한 작업의 다양한 시각적 조건과 언어적 신호를 처리해야 합니다. 따라서 UniControl의 입력은 소음, 텍스트 프롬프트, 시각적 조건 및 작업 지시의 네 부분으로 구성됩니다. 그 중 시각적 조건의 양상에 따라 자연스럽게 과제지시를 얻을 수 있다.

이러한 학습 쌍을 생성하여 이 연구에서는 DDPM[5]을 채택하여 모델을 학습합니다.

4. 실험 결과

그림 6: 테스트 세트 시각적 비교 결과. 테스트 데이터는 MSCOCO [6] 및 Laion [7]

에서 가져온 것입니다. 본 연구에서 재현된 공식 또는 ControlNet과의 비교 결과는 그림 6에 나와 있습니다. 자세한 결과는 논문을 참조하십시오.

5.제로샷 작업 일반화

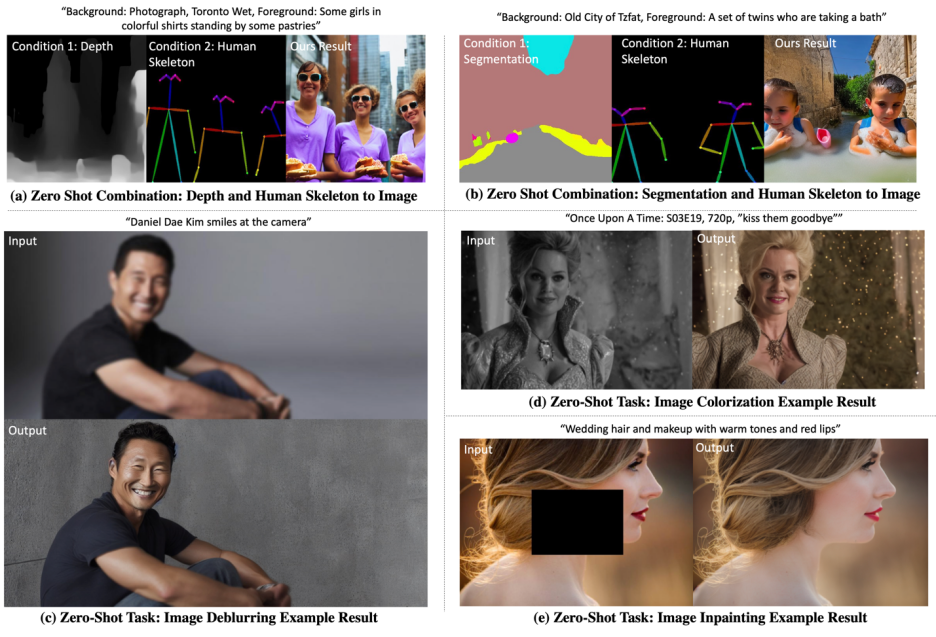

모델은 다음 두 가지 시나리오에서 제로샷 능력을 테스트합니다.

혼합 작업 일반화: 이 연구에서는 두 가지 서로 다른 시각적 조건을 UniControl에 대한 입력으로 간주합니다. 분할 맵과 인간 골격의 혼합, 특정 키워드 "배경" 및 "전경"이 텍스트 프롬프트에 추가되었습니다. 또한, 이 연구는 하이브리드 작업 지침을 "분할 맵 및 인간 골격을 이미지로"와 같은 두 가지 작업을 결합하기 위한 지침의 하이브리드로 다시 작성합니다.

새로운 작업 일반화: UniControl은 보이지 않는 새로운 시각적 조건에서 제어 가능한 이미지를 생성하는 데 필요합니다. 이를 달성하려면 보이지 않는 작업과 보이는 사전 훈련된 작업 간의 관계를 기반으로 작업 가중치를 추정하는 것이 중요합니다. 작업 가중치는 임베딩 공간에서 작업 지침의 유사성 점수를 수동으로 할당하거나 계산하여 추정할 수 있습니다. MOE 스타일 어댑터는 예상된 작업 가중치로 선형적으로 조립되어 보이지 않는 새로운 시각적 조건에서 얕은 특징을 추출할 수 있습니다.

시각화된 결과는 그림 7에 나와 있습니다. 더 많은 결과는 논문을 참조하세요.

그림 7: 제로샷 작업에 대한 UniControl의 시각화 결과

6. 요약

일반적으로 UniControl 모델은 제어 다양성을 통해 제어 가능한 비전 생성을 제공합니다. 새로운 기본 모델을 제공합니다. 이러한 모델은 이미지 생성 작업에 대한 더 높은 수준의 자율성과 인간 제어를 달성할 수 있는 가능성을 제공할 수 있습니다. 본 연구는 이 분야의 발전을 더욱 촉진하기 위해 더 많은 연구자들과 논의하고 협력하기를 기대합니다.

더 많은 영상

위 내용은 다중 모드 제어 가능 이미지 생성을 위한 통합 모델이 출시되었으며 모든 모델 매개변수 및 추론 코드는 오픈 소스입니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!