헬스케어 분야에 인공지능에 대한 행동강령이 있어야 할까요?

- 王林앞으로

- 2023-05-31 12:53:191258검색

생성 AI의 부상으로 인해 AI 윤리학자는 의료 분야에서 진화하는 이 기술을 사용할 때 발생할 수 있는 위험을 줄이기 위한 프레임워크를 제안하게 되었습니다. 동시에 ChatGPT의 OpenAI CEO는 미국 국회의원들에게 인간의 안전을 보장하기 위해 인공지능 규제를 시작할 것을 촉구했습니다.

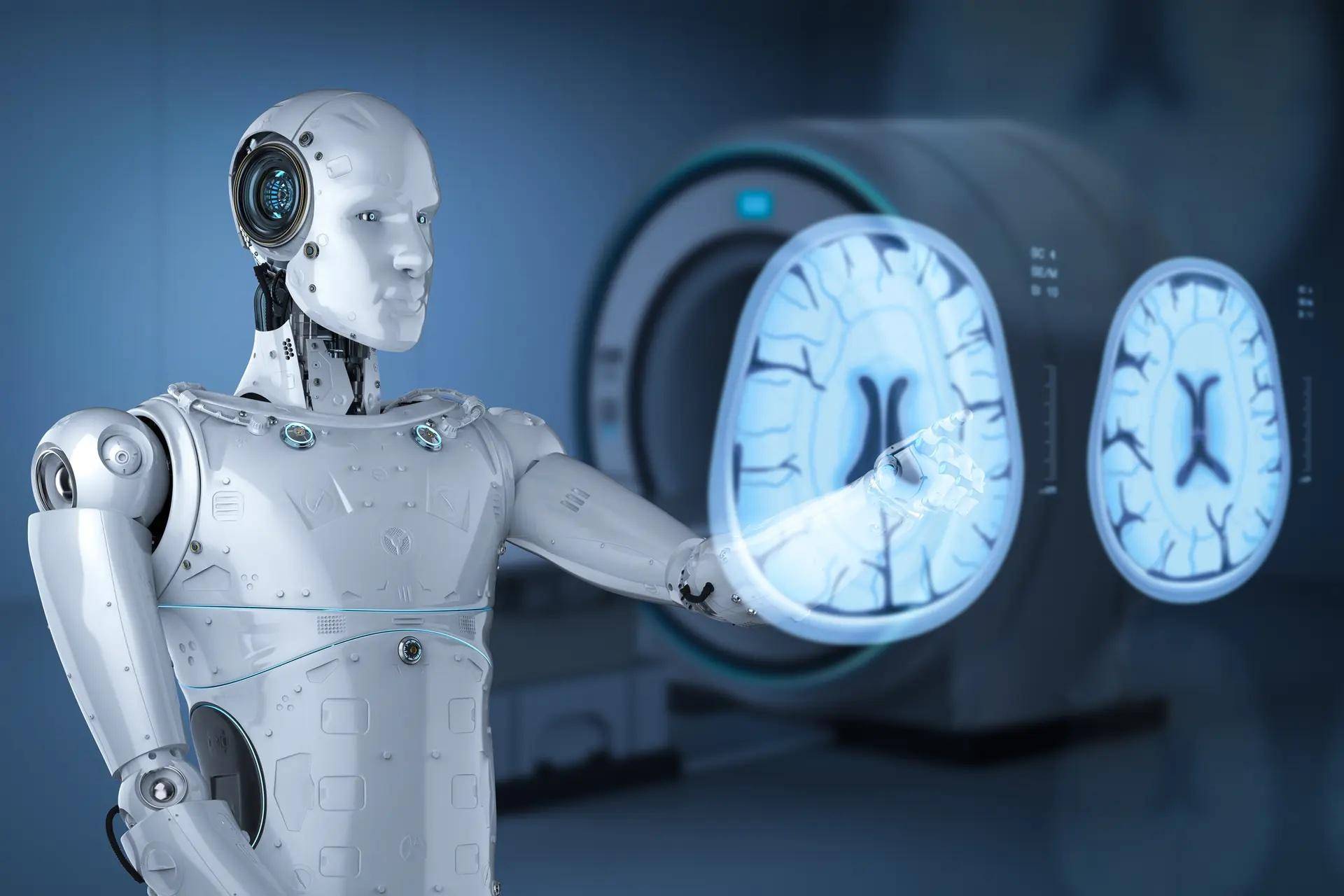

위: 생성 인공 지능의 등장으로 인해 의료 분야에서의 사용을 규제하기 위한 프레임워크 도입에 대한 요구가 촉발되었습니다.

SF 작가 아이작 아시모프(Isaac Asimov)는 1942년 단편 소설 "런어라운드(Runaround)"에서 로봇 공학의 3가지 법칙을 제안했습니다. 그는 최근 몇 년간 생성 인공 지능(Genetive Artificial Intelligence)의 등장을 목격하기 훨씬 전인 1992년에 사망했습니다.

Generative AI에는 훈련된 데이터를 사용하여 텍스트, 이미지, 오디오, 비디오 및 컴퓨터 코드를 포함한 새로운 콘텐츠를 만들 수 있는 ChatGPT 또는 DALL-E와 같은 알고리즘이 포함되어 있습니다. LLM(대형 언어 모델)은 자기 지도 또는 반 지도 학습을 사용하여 레이블이 지정되지 않은 대량의 텍스트에 대해 훈련된 신경망인 생성 인공 지능의 핵심 구성 요소입니다.

현재 생성 인공지능의 역량은 기하급수적으로 성장하고 있습니다. 의료 분야에서는 대규모 환자 데이터 세트를 통해 학습하여 환자 결과를 예측하고, 놀라운 정확도로 희귀 질환을 진단하고, 사전 학습 없이 미국 의료 면허 시험에 합격하는 데 사용되었습니다.

AI가 의료 분야에 진출하여 의사, 간호사 및 기타 의료 전문가를 대체할 가능성이 있기 때문에 AI 윤리학자인 Stefan Harrer는 생성 AI를 의학에 사용하기 위한 프레임워크를 제안했습니다.

Haller는 디지털 건강 협력 연구 센터(DHCRC)의 최고 혁신 책임자이자 건강 인공 지능 컨소시엄(CHAI)의 회원입니다. 그는 생성 AI 사용의 문제점은 확실히 거짓이거나 부적절하거나 위험한 콘텐츠를 생성하는 능력이라고 말했습니다.

Stephen Haller는 다음과 같이 말했습니다. “효율적인 지식 검색의 본질은 올바른 질문을 하는 것이며, 비판적 사고의 기술은 LLM이 이러한 임무를 완수할 수 없는 세계 모델의 타당성을 평가하여 답변을 탐색하는 능력에 달려 있습니다.”

Haller는 생성 AI가 의료를 변화시킬 잠재력이 있다고 믿지만 아직은 그렇지 않습니다. 이를 위해 그는 의료 분야에서 생성 AI로 인한 위험을 완화할 수 있는 10가지 원칙을 포함하는 윤리 기반 규제 프레임워크의 도입을 권장했습니다.

- AI를 인간 의사 결정자를 강화하지만 대체하지는 않는 보조 도구로 설계합니다.

- 성능, 사용량, 영향에 대한 지표를 생성하고 의사 결정을 돕기 위해 AI를 사용할 시기와 방법을 설명하고 잠재적인 편견을 검색하도록 AI를 설계합니다.

- 타겟 사용자 그룹의 가치 체계를 기반으로 하고 이를 준수하는 인공지능을 설계합니다.

- 개념이나 개발 작업 초기부터 AI의 목적과 용도를 공지합니다.

- 인공지능 훈련에 사용되는 모든 데이터 소스를 노출합니다.

- AI 생성 콘텐츠에 명확하고 투명하게 라벨을 붙일 수 있도록 AI를 디자인하세요.

- 데이터 개인 정보 보호, 보안 및 성능 표준에 따라 AI를 정기적으로 감사합니다.

- 감사 결과를 기록 및 공유하고, 사용자에게 AI 기능, 제한 사항 및 위험에 대해 교육하고, 알고리즘 재교육 및 업데이트를 통해 AI 성능을 향상시킵니다.

- 인력개발 인력 채용 시 공정한 근무와 안전한 근무 기준을 적용하세요.

- AI 훈련에 데이터를 사용할 수 있는 시기를 명확하게 정의하는 법적 판례를 확립하고 훈련 데이터, AI 생성 콘텐츠 및 이 데이터를 사용하여 내린 인간 결정의 영향을 관리하기 위한 저작권, 책임 및 책임 프레임워크를 확립합니다.

흥미롭게도 Stephen Haller의 프레임워크는 ChatGPT의 Open AI CEO인 Sam Altman의 요청과 일치합니다. 그는 미국 국회의원들에게 AI가 인간에게 발생할 수 있는 잠재적 위험에 영향을 미치지 않도록 정부 규제를 도입할 것을 촉구했습니다. 2015년 Elon Musk의 지원을 받아 OpenAI를 공동 창립한 Sam Altman은 정부가 보다 강력한 AI 모델을 출시하기 전에 라이선스 및 테스트 요구 사항을 도입할 것을 제안했습니다.

유럽에서는 다음 달 유럽의회에서 인공지능 법안이 표결될 예정입니다. 법안이 통과되면 생체인식 감시, 감정 인식, 치안 유지에 사용되는 일부 인공지능 시스템이 금지될 수 있다.

스티븐 할러의 다소 일반적인 프레임워크는 AI가 인간을 대체할 위험이 있는 많은 작업장에 적용될 수 있습니다. 이는 사람들(심지어 기술을 개발하는 사람들도 포함)이 인공 지능의 세계에 잠시 멈춰야 한다고 요구하는 시점에 나온 것으로 보입니다.

의료산업은 다른 고용산업에 비해 더 큰 위험에 직면해 있나요? 그러한 프레임워크가 유익한가요? 더 중요한 것은 AI가 발전하는 속도를 고려할 때 실제로 위험을 줄일 수 있을까요? 아마도 시간만이 이러한 질문에 대한 답을 줄 수 있을 것입니다.

친구들이 마음에 든다면 "새로운 소식을 알아보세요"에 주목해주세요!

위 내용은 헬스케어 분야에 인공지능에 대한 행동강령이 있어야 할까요?의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!