GPT-4 추론이 1750% 향상되었습니다! Princeton Tsinghua Yao 졸업생은 LLM이 반복적으로 생각할 수 있도록 새로운 'Thinking Tree ToT' 프레임워크를 제안했습니다.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB앞으로

- 2023-05-30 16:25:35871검색

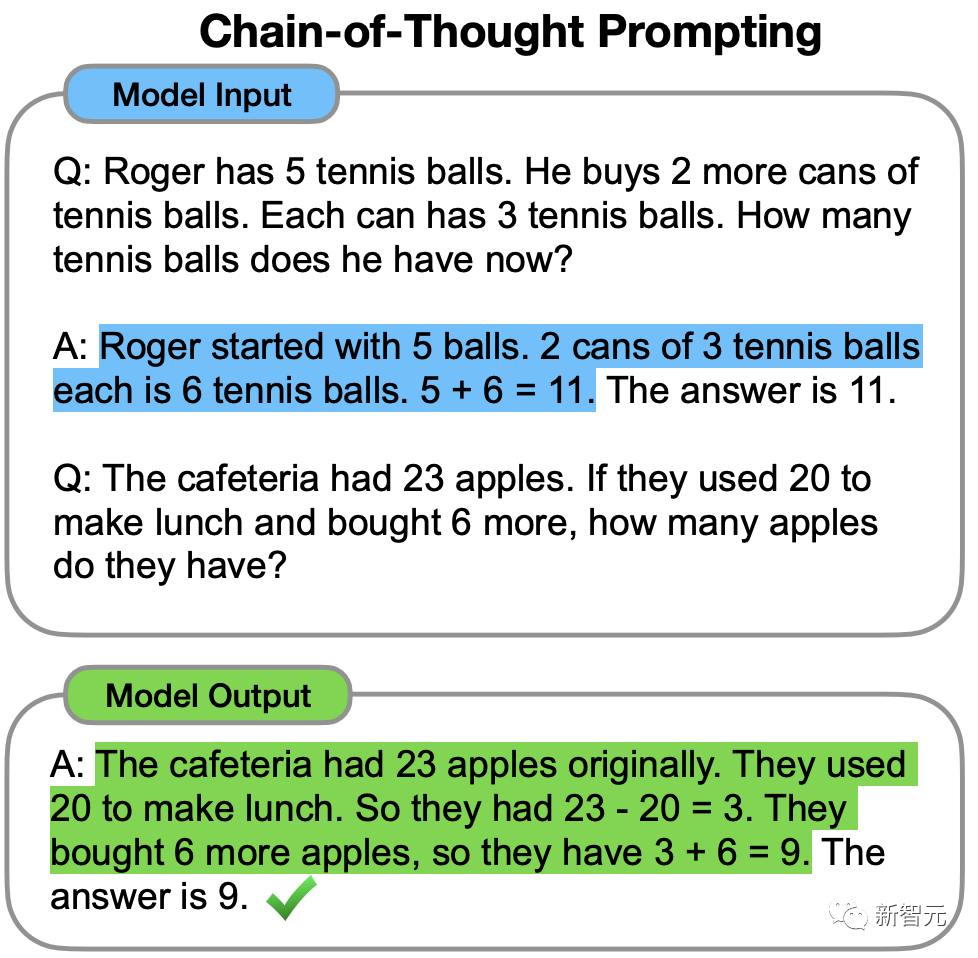

2022년, 전 Google Brain 중국 과학자 Jason Wei는 CoT가 LLM의 추론 능력을 향상시킬 수 있다는 사고 체인에 대한 선구적인 연구에서 처음 제안했습니다.

하지만 LLM은 사고 사슬에도 불구하고 매우 간단한 질문에 실수를 할 때가 있습니다.

최근 프린스턴 대학교와 Google DeepMind의 연구원들은 새로운 언어 모델 추론 프레임워크인 "생각의 나무"(ToT)를 제안했습니다.

ToT는 현재 널리 사용되는 "사고 체인" 방법을 일반화하여 언어 모델을 안내하고 일관된 텍스트 단위(사고)를 탐색하여 문제의 중간 단계를 해결합니다.

논문 주소: https://arxiv.org/abs/2305.10601

프로젝트 주소: https://github.com/kyegomez/tree-of-thoughts

간단히 말하면 "Thinking Tree"를 통해 LLM은 다음을 수행할 수 있습니다.

· 다양한 추론 경로 제공

· 각각을 평가한 후 다음 실행 계획 결정

· 필요한 경우 앞으로 또는 뒤로 추적 글로벌 의사 결정을 달성하기

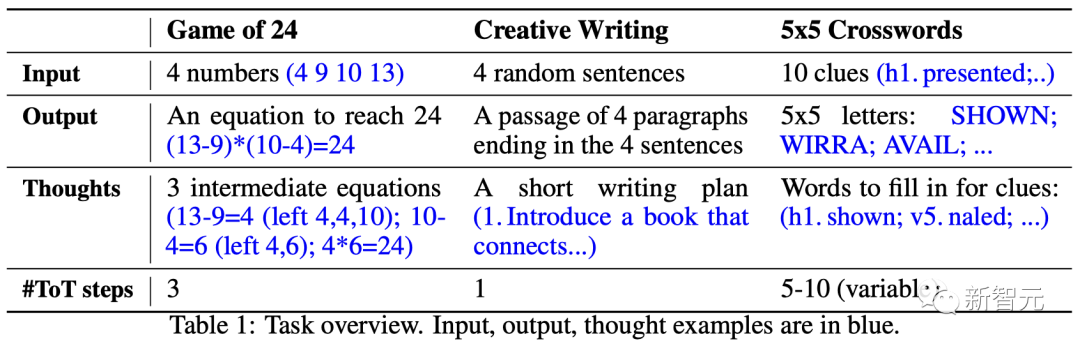

논문의 실험 결과에 따르면 ToT는 세 가지 새로운 작업(24포인트 게임, 창의적 글쓰기, 미니 크로스워드 퍼즐) 문제 해결 능력에서 LLM의 성능을 크게 향상시키는 것으로 나타났습니다.

예를 들어 24점 게임에서 GPT-4는 4%의 과제만 해결했지만 ToT 방식의 성공률은 74%에 달했습니다.

LLM이 "계속해서 생각하게"

텍스트를 생성하는 데 사용되는 대규모 언어 모델 GPT 및 PaLM은 이제 광범위한 작업을 수행할 수 있는 것으로 입증되었습니다.

이러한 모든 모델의 발전의 기초는 여전히 원래 텍스트를 생성하고 왼쪽에서 오른쪽 방식으로 토큰 수준 결정을 내리는 데 사용된 "자동 회귀 메커니즘"입니다.

그렇다면 이러한 간단한 메커니즘이 "일반적인 문제를 해결하기 위한 언어 모델"을 구축하는 데 충분할 수 있습니까? 그렇지 않다면 현재 패러다임에 도전하는 문제는 무엇이며 실제 대안 메커니즘은 무엇이어야 합니까?

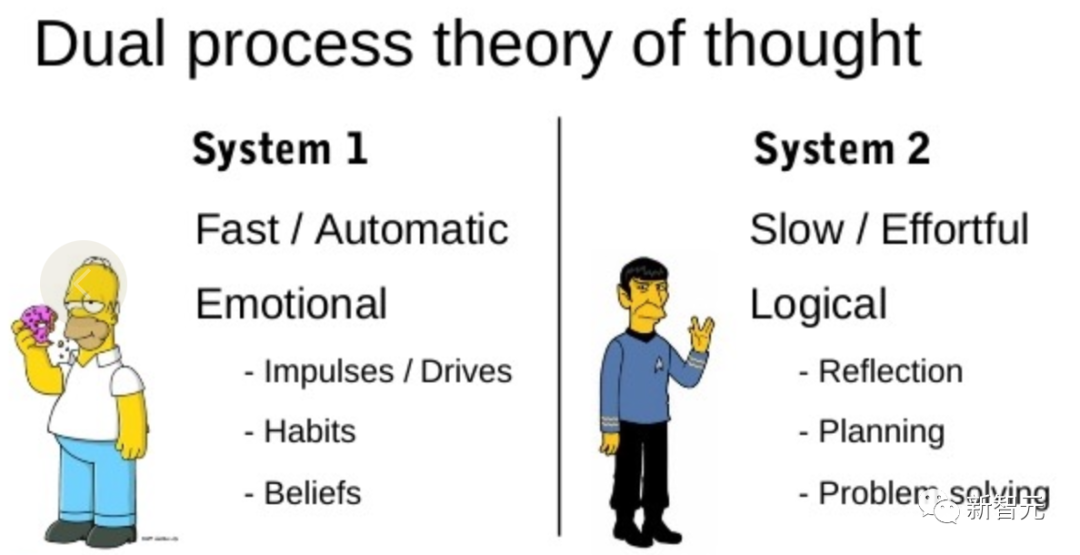

이 문제에 대한 단서를 제공하는 것은 바로 "인간 인식"에 관한 문헌입니다.

"이중 프로세스" 모델에 대한 연구에 따르면 인간에게는 빠르고 자동적인 무의식 모드인 "시스템 1"과 느리고 신중하며 의식적인 모드인 "시스템 2"라는 두 가지 의사 결정 모드가 있는 것으로 나타났습니다.

토큰 수준 선택과 언어 모델의 간단한 연관은 "시스템 1"을 연상시킬 수 있으므로 이 기능은 "시스템 2" 계획 프로세스에서 향상될 수 있습니다.

"시스템 1"을 사용하면 LLM이 하나만 선택하는 것이 아니라 현재 선택에 대한 여러 대안을 유지하고 탐색할 수 있는 반면, "시스템 2"는 현재 상태를 평가하고 적극적으로 예측하고 되돌아보며 보다 전체적인 결정을 내릴 수 있습니다.

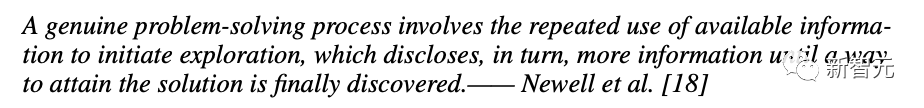

이러한 계획 프로세스를 설계하기 위해 연구자들은 인공 지능과 인지 과학의 기원을 추적하여 과학자 Newell, Shaw 및 Simon이 1950년대에 탐구하기 시작한 계획 프로세스에서 영감을 얻었습니다.

Newell과 동료들은 문제 해결을 트리로 표현되는 "문제 공간을 결합하여 검색하는 것"으로 설명합니다.

문제를 해결하는 과정에서는 마침내 해결책을 찾을 때까지 기존 정보를 반복적으로 활용하여 탐색하고 더 많은 정보를 얻어야 합니다.

이 관점은 일반적인 문제를 해결하기 위해 LLM을 사용하는 기존 방법의 2가지 주요 단점을 강조합니다.

1 로컬에서 LLM은 사고 과정, 즉 트리 분기에서 다양한 연속성을 탐색하지 않습니다.

2. 전반적으로 LLM에는 이러한 다양한 옵션을 평가하는 데 도움이 되는 어떤 유형의 계획, 전망 또는 되돌아보기도 포함되지 않습니다.

이러한 문제를 해결하기 위해 연구자들은 언어 모델을 사용하여 일반적인 문제를 해결하는 사고 트리 프레임워크(ToT)를 제안했고, 이를 통해 LLM은 다양한 사고 추론 경로를 탐색할 수 있었습니다.

ToT 4단계 방법

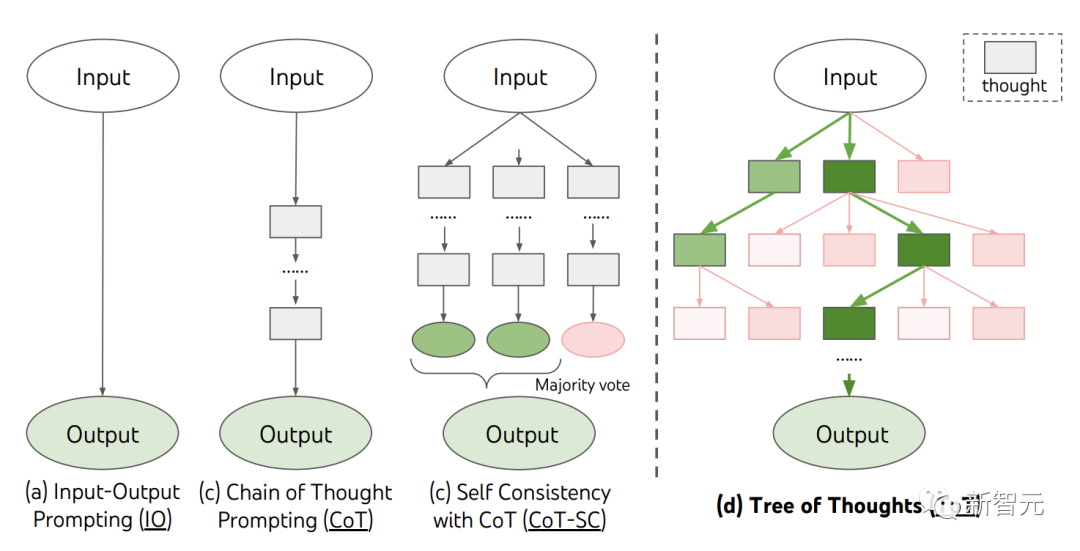

현재 IO, CoT, CoT-SC 등 기존 방법은 연속적인 언어 시퀀스를 샘플링하여 문제를 해결합니다.

그리고 ToT는 '생각나무'를 적극적으로 관리하고 있습니다. 각각의 직사각형 상자는 생각을 나타내며, 각 생각은 문제 해결의 중간 단계 역할을 하는 일관된 언어 순서입니다.

ToT는 모든 문제를 트리 검색으로 정의합니다. 여기서 각 노드는 지금까지 입력과 생각의 순서에 대한 부분적인 솔루션을 나타내는 상태입니다.

ToT는 특정 작업을 수행할 때 4가지 질문에 답해야 합니다.

중간 프로세스를 사고 단계로 분해하는 방법, 각 상태에서 잠재적인 아이디어를 생성하는 방법, 상태를 경험적으로 평가하는 방법, 사용 .

1. 사고 분해

CoT는 명시적인 분해 없이 사고를 일관되게 샘플링하는 반면, ToT는 문제의 속성을 사용하여 중간 사고 단계를 설계하고 분해합니다.

질문에 따라 아이디어는 몇 단어(크로스워드 퍼즐), 방정식(24점) 또는 전체 작문 계획(창의적 글쓰기)이 될 수 있습니다.

일반적으로 아이디어는 LLM이 의미 있고 다양한 샘플을 생성할 수 있을 만큼 충분히 "작아야" 합니다. 예를 들어, 완전한 책을 생성하는 것은 일관되기에는 너무 "큰" 경우가 많습니다.

그러나 아이디어는 LLM이 문제 해결에 대한 전망을 평가할 수 있을 만큼 "큰" 것이어야 합니다. 예를 들어, 토큰 생성은 평가하기에는 너무 "작은" 경우가 많습니다.

2. 생각 생성기

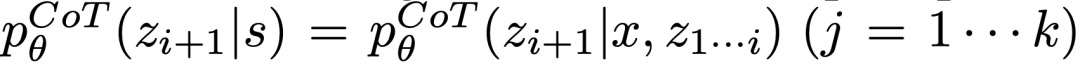

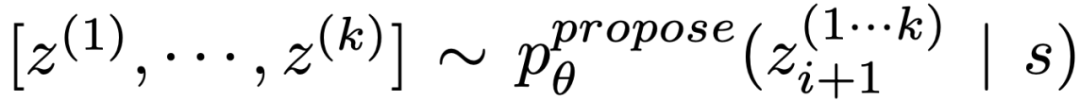

트리 상태  에 따라 2가지 전략을 통해 다음 사고 단계에 대한 k개의 후보를 생성합니다.

에 따라 2가지 전략을 통해 다음 사고 단계에 대한 k개의 후보를 생성합니다.

(a) CoT 프롬프트에서 샘플링  생각:

생각:

은 사고 공간이 풍부할 때(모든 아이디어가 문단인 것처럼) 더 잘 작동하고  는 다양성으로 이어질 수 있습니다.

는 다양성으로 이어질 수 있습니다.

(b) "제안 프롬프트"를 사용하여 아이디어를 순서대로 제안합니다:

. 이는 사고 공간이 제한적일 때 더 잘 작동하므로(예: 각 생각은 단지 하나의 단어나 줄일 뿐임) 동일한 맥락에서 서로 다른 아이디어를 제시하면 중복을 피할 수 있습니다.

3. 상태 평가자

상태 평가자는 검색 알고리즘에 대한 경험적 알고리즘으로 문제 해결의 진행 상황을 평가하여 어느 것을 결정합니다. 상태를 어떤 순서로 탐색해야 하는지 알아보세요.

휴리스틱은 검색 문제를 해결하는 표준 방법이지만 일반적으로 프로그래밍(DeepBlue)되거나 학습(AlphaGo)됩니다. 여기에서 연구자들은 LLM을 통해 상태에 대해 의식적으로 추론할 수 있는 세 번째 옵션을 제안합니다.

해당되는 경우 이 사려 깊은 휴리스틱은 절차적 규칙보다 더 유연하고 학습된 모델보다 더 효율적일 수 있습니다. 사고 생성기를 사용하여 연구원들은 상태를 독립적으로 또는 함께 평가하는 2가지 전략도 고려했습니다. 즉, 각 상태에 독립적으로 값을 할당하고 상태에 걸쳐 투표하는 것입니다.

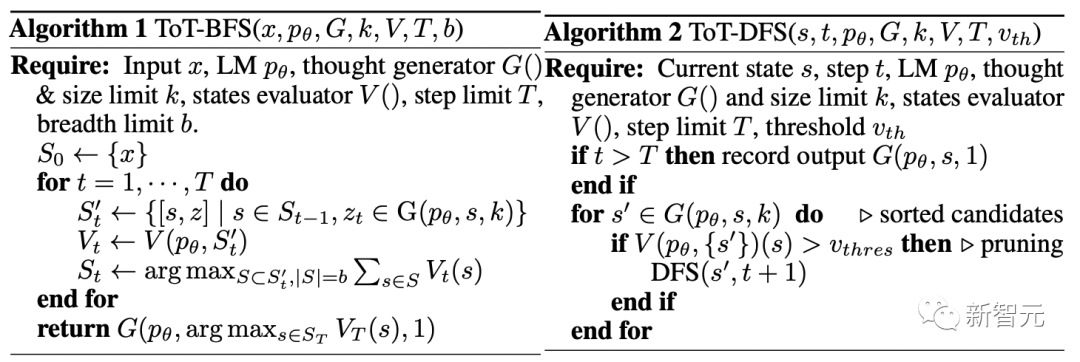

4. 검색 알고리즘

마지막으로 ToT 프레임워크에서 사람들은 트리 구조를 기반으로 다양한 검색 알고리즘을 플러그 앤 플레이할 수 있습니다.

연구원들은 여기서 비교적 간단한 2가지 검색 알고리즘을 탐색했습니다.

알고리즘 1 - BFS(Breadth First Search)는 각 단계에서 b의 가장 유망한 상태 집합을 유지합니다.

알고리즘 2 - 깊이 우선 검색(DFS)은 최종 출력에 도달할 때까지 가장 유망한 상태를 먼저 탐색합니다. 그렇지 않으면 상태 평가자가 현재 임계값에서 문제를 해결하는 것이 불가능하다고 간주합니다. 두 경우 모두 DFS는 탐색을 계속하기 위해 s의 상위 상태로 역추적합니다.

위에서 자기 평가와 의식적인 의사 결정을 통해 휴리스틱 검색을 구현하는 LLM의 방법은 참신합니다.

Experiments

이를 위해 팀은 테스트를 위한 세 가지 작업을 제안했습니다. 심지어 가장 진보된 언어 모델인 GPT-4도 표준 IO 프롬프트 또는 CoT(생각의 사슬) 프롬프트에서 매우 풍부합니다.

Game of 24

24는 4개의 숫자와 기본 산술 연산(+-*/)을 사용하여 24를 얻는 것이 목표인 수학적 추론 게임입니다.

예를 들어 "4 9 10 13"을 입력하면 대답의 출력은 "(10-4)*(13-9)=24"가 될 수 있습니다.

ToT 설정

팀은 모델의 사고 과정을 3단계로 분류했으며, 각 단계는 중간 방정식입니다.

그림 2(a)와 같이 각 노드에서 "왼쪽"의 숫자를 추출하고 LLM이 가능한 다음 단계를 생성하도록 요청합니다. (각 단계에서 주어지는 "제안 프롬프트"는 동일합니다)

그 중 팀은 ToT에서 BFS(Breadth-First Search)를 수행하고 각 단계에서 최고의 b=5 후보자를 유지합니다.

그림 2(b)에 표시된 것처럼 LLM은 각 사고 후보를 최대 24까지 "확실히/가능/불가능"으로 평가하라는 메시지를 표시합니다. "너무 크다/너무 작다"라는 상식을 바탕으로 불가능한 부분적 해결책을 제거하고, 나머지 "가능한" 항목을 유지합니다.

Results

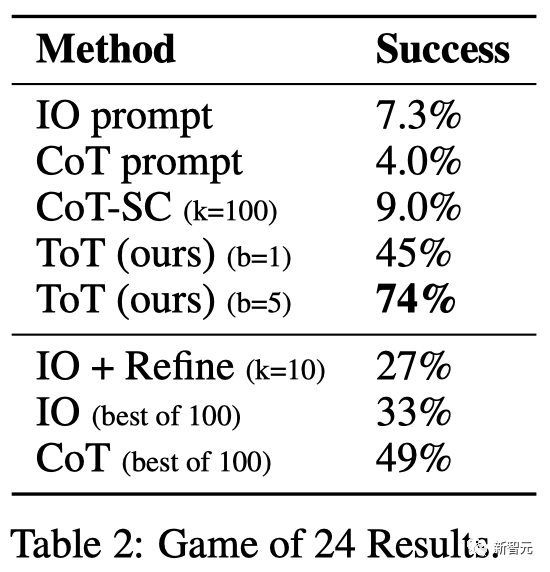

표 2에서 볼 수 있듯이 IO, CoT 및 CoT-SC 프롬프트 방법은 작업에서 제대로 수행되지 않았으며 성공률은 7.3%, 4.0% 및 9.0에 불과했습니다. %. 이에 비해 ToT는 너비가 b=1일 때 45%, b=5일 때 74%의 성공률을 달성했습니다.

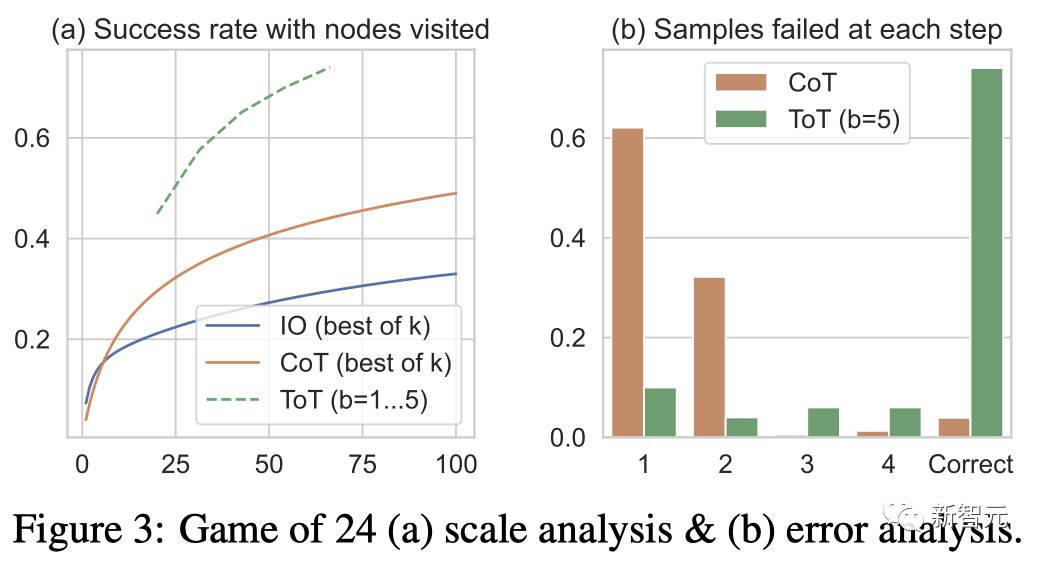

팀에서는 성공률을 계산하기 위해 가장 좋은 k 샘플(1≤k≤100)을 사용하여 IO/CoT의 예측 설정도 고려하고 그림 3(a)에 5가지 성공률을 표시했습니다.

예상대로 CoT는 IO보다 확장성이 뛰어나며 최고의 100개 CoT 샘플은 49%의 성공률을 달성하지만 여전히 ToT에서 더 많은 노드(b>1)를 탐색하는 것보다 나쁩니다.

오류 분석

그림 3(b)는 작업에 실패한 단계, 즉 Think(CoT) 또는 All b Think(ToT)에서 CoT 및 ToT 샘플을 분석합니다. 유효하지 않거나 24세에 도달할 수 없습니다.

CoT 샘플의 약 60%가 첫 번째 단계, 즉 처음 세 단어(예: "4+9")에서 실패했다는 점은 주목할 가치가 있습니다.

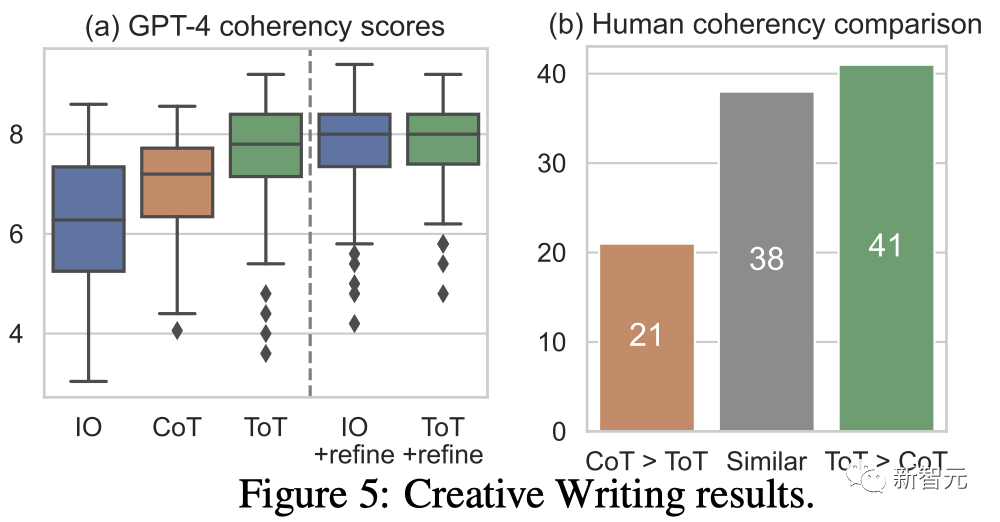

창의적인 글쓰기

다음으로 팀에서는 창의적인 글쓰기 작업을 디자인했습니다.

그 중 입력은 임의의 4개의 문장이고, 출력은 일관된 단락이어야 하며, 각 단락은 각각 4개의 입력 문장으로 끝납니다. 이러한 작업은 개방적이고 탐색적이며 창의적인 사고와 고급 계획에 도전합니다.

팀에서는 각 작업의 무작위 IO 샘플에 대해 반복 최적화(k≤5) 방법도 사용한다는 점에 주목할 가치가 있습니다. 이 방법에서 LLM은 입력 제약 조건과 마지막 항목을 기반으로 단락이 "완전히 일관성"인지 여부를 결정합니다. 생성된 단락이 아닌 경우 최적화된 단락을 생성합니다.

ToT 설정

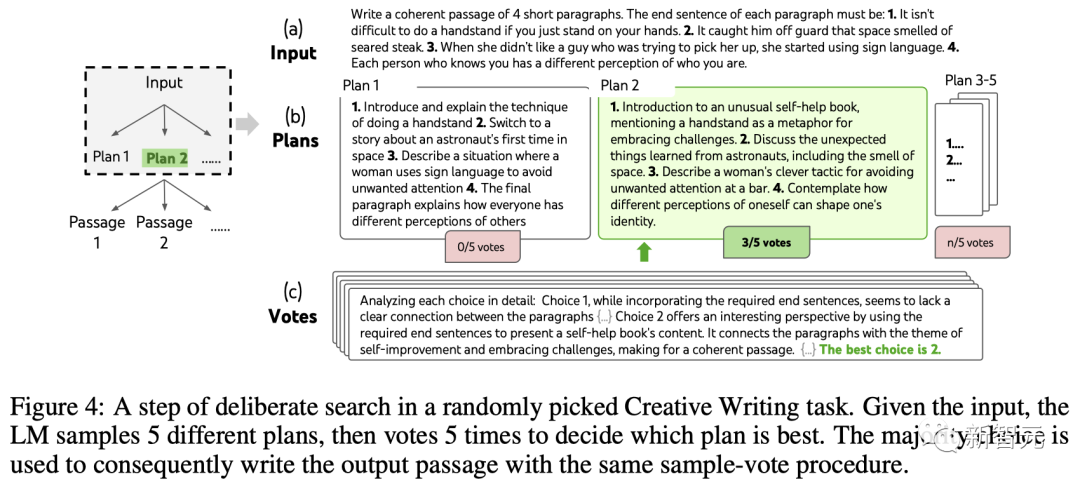

팀은 깊이 2(단 1개의 중간 사고 단계)로 ToT를 구축했습니다.

LLM은 먼저 k=5 계획을 생성하고 투표하여 가장 좋은 계획을 선택한 다음(그림 4), 가장 좋은 계획을 기반으로 k=5 단락을 생성한 다음 투표하여 가장 좋은 계획을 선택합니다.

간단한 제로 샷 투표 프롬프트("다음 선택 사항을 분석하고 지침을 구현할 가능성이 가장 높은 결정")를 사용하여 두 단계에 걸쳐 5표를 얻었습니다.

Results

그림 5(a)는 100개 작업 중 평균 GPT-4 점수를 보여줍니다. 여기서 ToT(7.56)는 IO(6.19) 및 CoT(6.93)보다 평균으로 간주됩니다. 일관된 단락.

이러한 자동 평가는 시끄러울 수 있지만 그림 5(b)는 인간이 100개 단락 쌍 중 41개에서 ToT를 선호하고 CoT에서는 21개만 선호한다는 것을 보여줌으로써 이를 보여줍니다(나머지 38개 쌍은 "유사한 일관성"으로 간주됨). 이 결과를 확인하십시오.

마지막으로 이 자연어 작업에서는 반복 최적화가 더 효과적입니다. 즉, IO 일관성 점수를 6.19에서 7.67로, ToT 일관성 점수를 7.56에서 7.91로 향상시킵니다.

i.i.d나 순차적 생성이 아닌 기존 사고를 최적화하여 새로운 사고를 생성할 수 있는 세 번째 방법이라고 볼 수 있다고 팀에서는 믿고 있습니다.

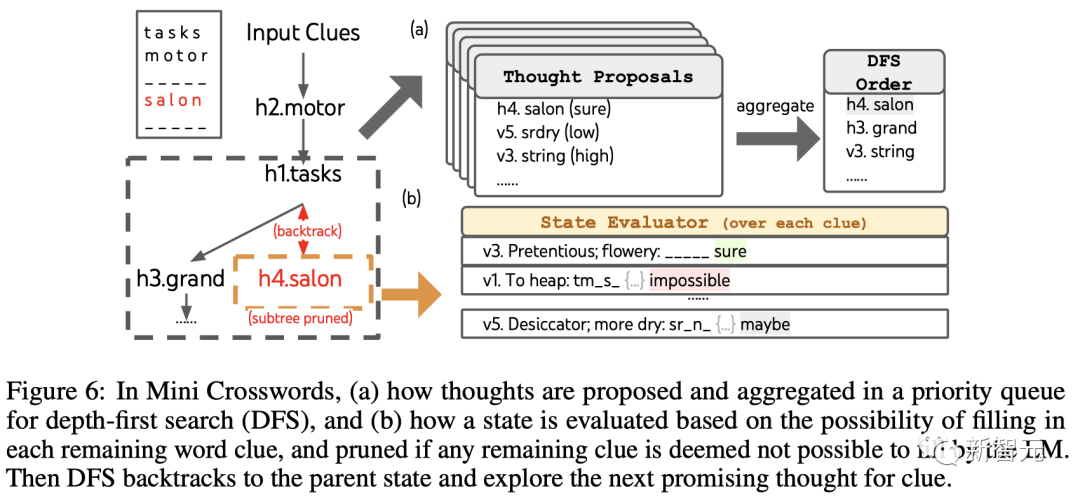

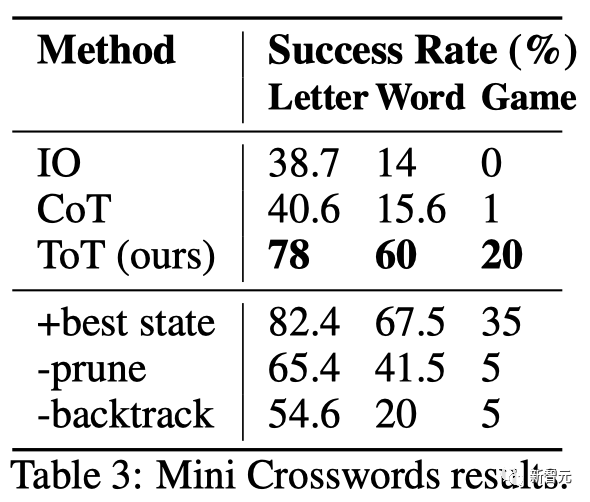

미니 크로스워드

24점 게임과 창의적인 글쓰기에서 ToT는 상대적으로 얕습니다. 출력을 완료하려면 최대 3개의 사고 단계가 필요합니다.

마지막으로 팀은 5×5 미니 크로스워드 퍼즐을 통해 더 어려운 질문을 설정하기로 결정했습니다.

다시 말하지만, 목표는 단순히 과제를 해결하는 것이 아니라 일반적인 문제 해결사로서 LLM의 한계를 연구하는 것입니다. 자신의 마음을 들여다보고 목적 있는 추론을 영감으로 사용하여 탐색을 안내하세요.

ToT 설정

팀은 깊이 우선 검색을 활용하여 상태가 더 이상 유망하지 않을 때까지 성공 가능성이 가장 높은 후속 단어 단서를 계속 탐색한 다음 원래 상태로 되돌아갑니다. 대안적인 생각을 탐구하는 부모 상태.

검색이 가능하도록 하기 위해 후속 생각은 단어나 문자로 채워진 내용을 변경하는 것을 제한하므로 ToT에는 최대 10개의 중간 단계가 있습니다.

생각 생성을 위해 팀은 각 상태의 모든 기존 생각(예: 그림 6(a)의 상태에 대한 "h2.motor; h1.tasks")을 나머지 단서의 문자 제약 조건(예: , "v1.To heap: tm___;..."), 이를 통해 다음 단어의 위치와 내용을 채우기 위한 후보를 얻습니다.

중요하게도 팀은 LLM에게 다양한 아이디어에 대한 신뢰도 점수를 제공하도록 요청하고 이를 제안서에 집계하여 다음에 탐색할 아이디어 순위 목록을 얻습니다(그림 6(a)).

상태 평가를 위해 팀은 마찬가지로 각 상태를 나머지 단서에 대한 문자 제한으로 변환한 다음 각 단서가 주어진 제한 내에 채워질 가능성이 있는지 평가합니다.

남은 단서가 "불가능"하다고 간주되면(예: "v1. To heap: tm_s_") 해당 상태의 하위 트리 탐색이 정리되고 DFS는 상위 노드로 역추적됩니다. 다음으로 가능한 단서를 탐색해 보겠습니다. 후보자.

Results

표 3에서 볼 수 있듯이 IO 및 CoT의 프롬프트 방법은 단어 수준 성공률이 16% 미만으로 좋지 않은 반면 ToT는 모든 지표를 크게 향상시켰습니다. 단어 수준 성공률 60%, 게임 20개 중 4개를 해결했습니다.

IO와 CoT에는 다른 단서를 시도하고, 결정을 변경하고, 역추적하는 메커니즘이 부족하다는 점을 고려하면 이러한 개선은 놀라운 일이 아닙니다.

제한 사항 및 결론

ToT는 LLM이 보다 자율적이고 지능적으로 결정을 내리고 문제를 해결할 수 있도록 하는 프레임워크입니다.

ToT에 의해 생성된 표현 테이블이 암시적 하위 수준 토큰 값이 아닌 읽기 가능한 고급 언어 추론 형식이기 때문에 모델 결정의 해석 가능성과 인간과의 정렬 가능성이 향상됩니다.

GPT-4가 이미 매우 능숙한 작업의 경우 ToT가 필요하지 않을 수 있습니다.

또한 ToT와 같은 검색 방법에는 작업 성능을 향상시키기 위해 더 많은 리소스(예: GPT-4 API 비용)가 필요하지만 ToT의 모듈식 유연성을 통해 사용자는 이러한 성능-비용 균형을 맞춤 설정할 수 있습니다.

그러나 LLM이 보다 실제적인 의사 결정 응용 프로그램(예: 프로그래밍, 데이터 분석, 로봇 공학 등)에 사용됨에 따라 ToT는 앞으로 등장할 보다 복잡한 작업을 연구할 수 있는 새로운 기회를 제공할 수 있습니다.

저자 소개

Shunyu Yao(Yao Shunyu)

논문의 제1저자 Shunyu Yao는 프린스턴대학교 박사과정 4년차이자 졸업 전 졸업생입니다. 칭화대학교 야오(Yao)학급 출신.

그의 연구 방향은 단어 게임(CALM), 온라인 쇼핑(WebShop), 추론을 위한 Wikipedia 탐색(ReAct), 또는 동일한 아이디어를 기반으로 언어 에이전트와 세계 간의 상호 작용을 생성하는 것입니다. 어떤 작업을 수행하기 위한 모든 도구.

평생 독서, 농구, 당구, 여행, 랩을 좋아합니다.

Dian Yu

Dian Yu는 Google DeepMind의 연구 과학자입니다. 이전에 그는 UC Davis에서 박사 학위를 취득하고 New York University에서 학사 학위를 취득했으며, 컴퓨터 과학 및 금융을 복수 전공했습니다(연기도 조금 했습니다).

그의 연구 관심 분야는 언어의 속성 표현과 다국어 및 다중 모드 이해이며 주로 대화 연구(오픈 도메인 및 작업 지향 포함)에 중점을 둡니다.

Yuan Cao

Yuan Cao는 Google DeepMind의 연구 과학자이기도 합니다. 이전에는 Shanghai Jiao Tong University에서 학사 및 석사 학위를, Johns Hopkins University에서 박사 학위를 받았습니다. 그는 또한 Baidu의 수석 건축가로도 활동했습니다.

Jeffrey Zhao

Jeffrey Zhao는 Google DeepMind의 소프트웨어 엔지니어입니다. 이전에는 카네기 멜론 대학교에서 학사 및 석사 학위를 취득했습니다.

위 내용은 GPT-4 추론이 1750% 향상되었습니다! Princeton Tsinghua Yao 졸업생은 LLM이 반복적으로 생각할 수 있도록 새로운 'Thinking Tree ToT' 프레임워크를 제안했습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!