환각? 머스크의 TruthGPT도 이를 처리할 수 없습니다! OpenAI 공동 창립자는 그것이 복잡하다고 말합니다.

- WBOY앞으로

- 2023-05-23 19:13:04691검색

지난달 머스크는 슈퍼 AI 연구 개발을 6개월 중단하라고 필사적으로 요구했습니다.

얼마 지나지 않아 Lao Ma는 가만히 있지 못하고 TruthGPT라는 AI 플랫폼 출시를 공식 발표했습니다.

Musk는 TruthGPT가 우주의 본질을 이해하려고 노력하는 "가장 큰 진리 추구 인공 지능"이 될 것이라고 말한 적이 있습니다.

그는 우주 이해에 관심을 갖는 AI가 인류를 멸종시킬 가능성은 낮다고 강조했습니다. 왜냐하면 우리는 우주의 흥미로운 부분이기 때문입니다.

그러나 지금까지 "환상"을 처리할 수 있는 언어 모델은 없습니다.

최근 OpenAI의 공동 창립자는 TruthGPT의 높은 이상을 실현하는 것이 왜 그렇게 어려운지 설명했습니다.

TruthGPT 이상은 거품인가요?

머스크의 X.AI가 만들고자 하는 TruthGPT는 정직한 언어 모델입니다.

이를 통해 ChatGPT를 직접 타겟팅합니다.

이전에 ChatGPT와 같은 AI 시스템은 잘못된 출력과 같은 전형적인 환각 사례를 생성하고 특정 정치적 신념에 대한 보고서를 지원하기도 했기 때문입니다.

ChatGPT를 사용하면 사용자가 언어 모델을 더 효과적으로 제어하여 문제를 해결할 수 있지만 "환상"은 여전히 OpenAI, Google 및 Musk의 인공 지능 회사가 향후 처리해야 할 핵심 문제입니다.

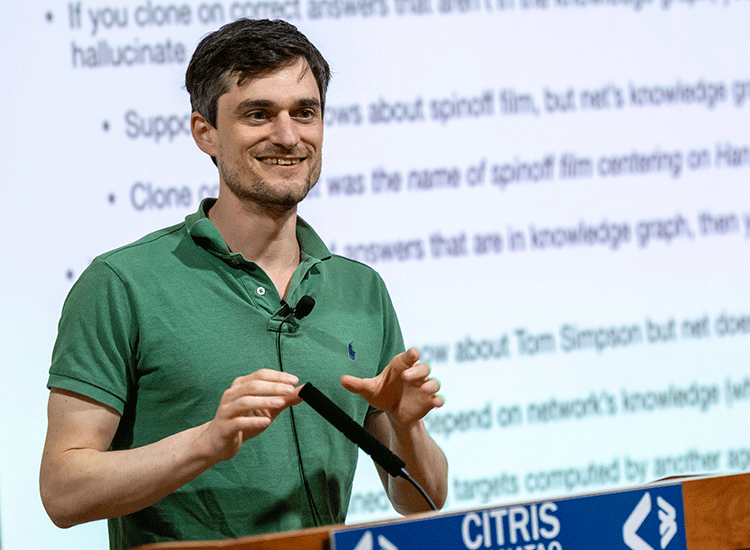

OpenAI 공동 창립자이자 연구원인 John Schulman은 "RL 및 진실성 – 진실을 향하여 GPT"라는 강연에서 이러한 과제와 이에 대처하는 방법에 대해 논의했습니다.

왜 “환각”이 있나요?

Schulman에 따르면 환각은 대략 두 가지 유형으로 나눌 수 있습니다.

1. "패턴 완성 동작", 즉 언어 모델은 자체 불확실성을 표현할 수 없고 프롬프트에서 전제에 질문을 던지거나 계속할 수 없습니다. 실수하기 전에.

2. 모델이 잘못 추측했습니다.

언어 모델은 학습 데이터의 사실을 자체 네트워크에 포함하는 지식 그래프를 나타내기 때문에 미세 조정은 이 지식 그래프에서 작동하고 토큰 예측을 출력하는 함수를 학습하는 것으로 이해될 수 있습니다.

예를 들어, 미세 조정 데이터 세트에는 "스타워즈 장르는 무엇입니까?"라는 질문과 "공상 과학"이라는 대답이 포함될 수 있습니다.

이 정보가 원래 훈련 데이터에 이미 있는 경우, 즉 지식 그래프의 일부인 경우 모델은 새로운 정보를 학습하지 않고 동작을 학습하여 정답을 출력합니다. 이러한 종류의 미세 조정을 "행동 복제"라고도 합니다.

그런데 문제는 미세 조정 데이터 세트에 "한 솔로의 스핀오프 영화 이름이 무엇인가요?"라는 질문이 나온다는 것입니다.

그러나 "Solo"라는 대답이 원래 훈련 데이터 세트의 일부가 아닌 경우(지식 그래프의 일부도 아님) 네트워크는 대답을 모르더라도 대답하는 방법을 학습합니다.

실제로는 정확하지만 지식 그래프에는 없는 답변을 사용하여 답변을 미세 조정하여 네트워크가 답변을 제작하도록 가르칩니다. 즉, "환각"을 생성합니다. 반대로, 잘못된 답으로 훈련하면 네트워크가 정보를 보류하게 됩니다.

따라서 행동 복제는 이상적으로 항상 네트워크 지식을 기반으로 해야 하지만 명령 조정과 같은 데이터세트를 생성하거나 평가하는 인간 작업자는 이 지식을 모르는 경우가 많습니다.

Schulman에 따르면 이 문제는 Alpaca 공식의 경우처럼 다른 모델이 미세 조정된 데이터 세트를 생성할 때도 존재합니다.

그는 지식 그래프가 더 작은 소규모 네트워크가 ChatGPT의 출력을 사용하여 답변을 제공하고 지침을 따르는 방법을 배울 뿐만 아니라 더 자주 환각하는 방법도 배울 것이라고 예측합니다.

OpenAI는 어떻게 환각과 싸우나요?

우선 간단한 질문의 경우 언어 모델은 대부분의 경우 답을 알고 있는지 예측할 수 있으며 불확실성도 표현할 수 있습니다.

따라서 Schulman은 데이터 세트를 미세 조정할 때 모델이 불확실성을 표현하는 방법, 전제가 변경되는 상황에 대처하는 방법, 오류가 인정되는 상황을 학습해야 한다고 말했습니다.

이러한 상황의 인스턴스는 모델에 제공되어 학습할 수 있어야 합니다.

그러나 모델은 아직 타이밍 훈련이 부족합니다. 즉, 이러한 작업을 언제 수행해야 할지 모릅니다.

Schulman은 이것이 강화 학습(RL)이 작용하는 곳이라고 말했습니다. 예를 들어 인간 피드백을 기반으로 한 인간 피드백을 통한 강화 학습(RLHF)이 있습니다.

RL을 적용하면 모델은 "행동 경계"를 학습하고 언제 어떤 행동을 수행할지 학습할 수 있습니다.

또 다른 어려움은 출처를 검색하고 인용하는 능력입니다.

질문은 행동 복사 기능과 RLHF가 있는데 왜 ChatGPT가 여전히 환각을 느끼는 걸까요?

이유는 문제 자체의 난이도에 있습니다.

위 방법은 짧은 질문과 답변에는 적합하지만 ChatGPT에서 흔히 발생하는 긴 형식 설정에서는 다른 문제가 발생합니다.

한편으로는 완전히 틀린 답이 나올 가능성은 거의 없습니다. 대부분의 경우 오답과 정답이 섞여 있습니다.

심한 경우에는 코드 100줄의 실수일 수도 있습니다.

다른 경우에는 정보가 전통적인 의미에서 잘못된 것이 아니라 오히려 오해의 소지가 있습니다. 따라서 ChatGPT와 같은 시스템에서는 정보 내용이나 정확성 측면에서 출력의 품질을 측정하기가 어렵습니다.

그러나 이 측정은 복잡한 행동 경계를 훈련하도록 설계된 RL 알고리즘에 매우 중요합니다.

현재 OpenAI는 RLHF의 순위 기반 보상 모델을 사용합니다. 이 모델은 두 답변 중 어느 것이 더 낫다고 생각하는지 예측할 수 있지만 어느 답변이 더 좋고 얼마나 유익한지 명확히 하는 효과적인 신호를 제공하지 않습니다. 정확하거나 정확합니다.

Schulman은 미세한 행동 경계를 학습하기 위해 모델에 피드백을 제공하는 능력이 부족하다고 말했습니다. 그리고 이런 미세한 행동 경계가 환상을 해결할 수 있는 방법이다.

또한 이 프로세스는 RLHF 라벨링 프로세스의 인적 오류로 인해 더욱 복잡해집니다.

따라서 Schulman은 RL을 환각을 줄이는 중요한 방법 중 하나로 간주하지만 여전히 해결되지 않은 문제가 많다고 믿습니다.

올바른 행동을 안내하기 위해 위에서 언급한 보상 모델이 어떤 모습이어야 하는지를 제외하고, RLHF는 현재 인간의 판단에만 의존합니다.

이로 인해 지식 창출이 더 어려워질 수 있습니다. 미래에 대한 예측은 때로는 덜 설득력 있는 프레젠테이션으로 이어지기 때문입니다.

그러나 Schulman은 지식의 생성이 언어 모델의 다음 중요한 단계라고 믿습니다. 동시에 그는 미래를 예측하고 추론 규칙을 제공하는 것과 같은 문제의 이론적 구성이 다음 유형의 개방형 문제라고 믿습니다. 긴급히 해결해야 합니다.

Schulman은 가능한 해결책 중 하나는 다른 AI 모델을 사용하여 언어 모델을 훈련시키는 것이라고 말했습니다.

OpenAI도 이 방법이 AI 정렬에 매우 의미가 있다고 믿습니다.

ChatGPT 설계자

ChatGPT 설계자인 John Schulman은 박사 과정을 밟고 있던 2015년 초 공동 창립자 중 한 명으로 OpenAI에 합류했습니다.

Schulman은 인터뷰에서 OpenAI에 합류한 이유를 다음과 같이 설명했습니다.

저는 인공 지능에 대한 연구를 하고 싶습니다. 저는 OpenAI가 야심찬 사명을 갖고 있으며 일반 인공 지능을 구축하는 데 전념하고 있다고 생각합니다. .

당시에는 AGI에 대해 이야기하는 것이 조금 이상해 보였지만, 그것에 대해 생각하는 것이 합리적이라고 생각했고 AGI에 대해 이야기할 수 있는 자리에 있고 싶었습니다.

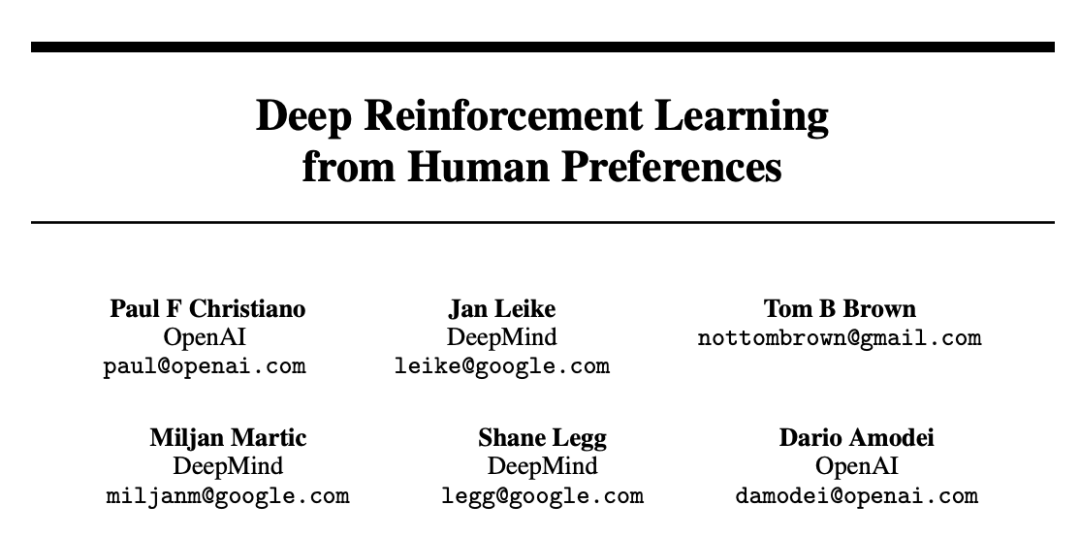

또한 Schulman에 따르면 인간 피드백 강화 학습(RLHF)을 ChatGPT에 도입하려는 OpenAI의 아이디어는 17년 전으로 거슬러 올라갑니다.

당시 그는 OpenAI 회원이기도 하며 이 방법을 언급한 "Deep Reinforcement Learning from Human Preferences"라는 논문을 발표했습니다.

문서 주소: https://arxiv.org/pdf/1706.03741.pdf

OpenAI 보안 팀이 이 작업에 전념하는 이유는 모델의 일관성을 원하기 때문입니다. 인간 기본 설정을 사용하여 모델이 실제로 인간의 말을 듣고 인간이 원하는 것을 수행하도록 시도합니다.

GPT-3 교육을 마쳤을 때 Schulman은 전체 연구 방향의 잠재력을 보았기 때문에 이러한 추세에 합류하기로 결정했습니다.

ChatGPT를 처음 사용했을 때의 첫 반응이 어땠는지 묻는 질문에 Schulman의 말은 "감정 없음"을 드러냈습니다.

작년에 ChatGPT가 출시되어 많은 사람들의 두뇌를 순간적으로 폭발시켰던 기억이 납니다.

그리고 OpenAI 내부의 어느 누구도 ChatGPT에 열광하지 않습니다. 출시된 ChatGPT는 GPT-3.5 기반의 약한 모델이었기 때문에 당시 동료들은 GPT-4를 가지고 놀고 있었습니다.

그 당시 OpenAI에서는 이미 훈련된 더 강력하고 똑똑한 모델이 있었기 때문에 ChatGPT에 대해 아무도 흥분하지 않았습니다.

Schulman은 미래의 인공 지능의 다음 개척지에 대해 AI가 더 어려운 작업에서 계속 발전하고 있으며, 그러면 인간이 무엇을 해야 하는지, 그리고 어떤 작업에서 인간이 전반적으로 성공할 수 있는지에 대한 질문이 생긴다고 말했습니다. -작업 규모를 조정하고 싶으신가요? 모델의 도움으로 더 많은 영향력을 발휘하고 더 많은 작업을 수행할 수 있습니다.

위 내용은 환각? 머스크의 TruthGPT도 이를 처리할 수 없습니다! OpenAI 공동 창립자는 그것이 복잡하다고 말합니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!