GPT4ALL: 최고의 오픈 소스 대규모 언어 모델 솔루션

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB앞으로

- 2023-05-17 11:02:312593검색

개인에게 연구 및 상업적 목적으로 언어 응용 프로그램을 만들 수 있는 포괄적인 리소스를 제공하는 오픈 소스 언어 모델 생태계가 성장하고 있습니다.

이 기사에서는 누구나 ChatGPT와 유사한 챗봇을 개발할 수 있는 포괄적인 빌딩 블록을 제공하여 특정 사용 사례를 뛰어넘는 GPT4ALL에 대해 자세히 살펴봅니다.

GPT4ALL 프로젝트란 무엇인가요?

GPT4ALL은 최첨단 오픈 소스 대규모 언어 모델을 사용할 때 필요한 모든 지원을 제공할 수 있습니다.. 오픈 소스 모델 및 데이터 세트에 액세스하고, 제공된 코드를 사용하여 훈련 및 실행하고, 웹 인터페이스 또는 데스크톱 애플리케이션을 사용하여 상호 작용하고, 분산 컴퓨팅을 위해 Langchain 백엔드에 연결하고, 간편한 통합을 위해 Python API를 사용할 수 있습니다.

개발자는 최근 단어 질문, 다단계 대화, 코드, 시, 노래 및 이야기를 포함하여 선별된 대규모 보조 상호 작용 코퍼스에 대해 훈련된 Apache-2 라이선스 GPT4All-J 챗봇을 출시했습니다. 접근성을 높이기 위해 거의 모든 사람이 CPU에서 모델을 실행할 수 있도록 Python 바인딩과 채팅 UI도 출시했습니다.

데스크톱에 로컬 채팅 클라이언트를 설치하여 직접 사용해 볼 수 있습니다.

- Mac/OSX(https://gpt4all.io/installers/gpt4all-installer-darwin.dmg)

- Windows(https://gpt4all.io/installers/gpt4all-installer-win64.exe)

- Ubuntu (https://gpt4all.io/installers/gpt4all-installer-linux.run)

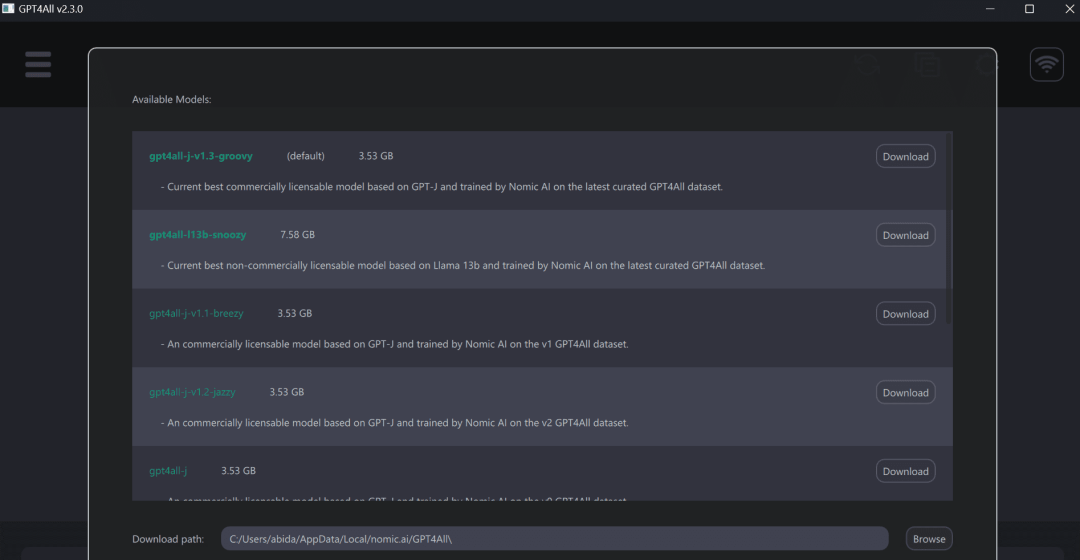

이후 GPT4ALL 프로그램을 실행하고 원하는 모델을 다운로드 받으세요. 여기(https://github.com/nomic-ai/gpt4all-chat#manual-download-of-models)에서 모델을 수동으로 다운로드하고 GUI의 모델 다운로드 대화 상자에 표시된 위치에 설치할 수도 있습니다.

GPT4ALL을 사용하면 노트북에서 더 나은 경험을 할 수 있으며 빠르고 정확한 응답을 얻을 수 있습니다. GPT4ALL은 매우 사용자 친화적이기 때문에 기술 지식이 없는 사람이라도 쉽게 사용할 수 있습니다.

GPT4ALL Python 클라이언트

GPT4ALL에는 Python, TypeScript, 웹 채팅 인터페이스 및 Langchain 백엔드가 있습니다.

이 섹션에서는 nomic-ai/pygpt4all을 사용하여 모델에 액세스하기 위한 Python API를 살펴보겠습니다.

- PIP를 사용하여 Python GPT4ALL 라이브러리를 설치하세요.

<code>pip install pygpt4all</code>

- http://gpt4all.io/models/ggml-gpt4all-l13b-snoozy.bin에서 GPT4All 모델을 다운로드하세요. 여기에서도 사용 가능합니다(https://github.com/nomic-ai/gpt4all-chat# 수동-모델 다운로드)를 통해 다른 모델을 찾아보세요.

- 텍스트 콜백 함수를 만들고, 모델을 로드하고, mode.generate() 함수에 힌트를 제공하여 텍스트를 생성하세요. 자세한 내용은 라이브러리 설명서(https://nomic-ai.github.io/pygpt4all/)를 확인하세요.

<code>from pygpt4all.models.gpt4all import GPT4Alldef new_text_callback(text):print(text, end="")model = GPT4All("./models/ggml-gpt4all-l13b-snoozy.bin")model.generate("Once upon a time, ", n_predict=55, new_text_callback=new_text_callback)</code>

또한 변환기를 사용하여 추론을 다운로드하고 실행할 수 있습니다. 모델명과 버전만 알려주세요. 이 기사의 예는 최신의 향상된 v1.3-groovy 모델에 액세스하는 것입니다.

<code>from transformers import AutoModelForCausalLMmodel = AutoModelForCausalLM.from_pretrained("nomic-ai/gpt4all-j", revisinotallow="v1.3-groovy")</code>

시작하기

nomic-ai/gpt4all 저장소에서 교육 및 추론을 위한 소스 코드, 모델 가중치, 데이터 세트 및 문서를 얻을 수 있습니다. 먼저 일부 모델을 시험해 본 다음 Python 클라이언트 또는 LangChain을 사용하여 통합할 수 있습니다.

GPT4ALL은 CPU 수량화 GPT4All 모델 체크포인트를 제공합니다. 액세스하려면 다음을 수행해야 합니다.

- Direct Link 또는 [Torrent-Magnet]에서 gpt4all-lora-Quantized.bin 파일을 다운로드합니다.

- 이 리소스 라이브러리를 복제하고 다운로드한 bin 파일을 채팅 폴더로 이동하세요.

- 적절한 명령을 실행하여 모델에 액세스합니다.

- M1 Mac/OSX: cd chat;./gpt4all-lora-Quantized-OSX-m1

Linux: cd chat;./gpt4all-lora-Quantized-linux- x86

- Windows(PowerShell): CD 채팅;./gpt4all-lora-Quantized-win64.exe

- Intel Mac/OSX: CD 채팅;./gpt4all-lora-Quantized-OSX-intel

Hugging Face Spaces로 가서 Gpt4all의 데모를 시험해 볼 수도 있습니다.

Gpt4all

의 사진ㅋㅋㅋ (https://github.com/nomic-ai/gpt4all)Python API:nomic-ai/pygpt4all(https://github.com/nomic-ai/pygpt4all)- 模型:nomic-ai/gpt4all- j(https://huggingface.co/nomic-ai/gpt4all-j)

- 数据集:nomic-ai/gpt4all-j-prompt- Generations(https://huggingface.co/datasets/nomic-ai/gpt4all -j-prompt- Generations)

- 허깅 페이스演示:Gpt4all(https://huggingface.co/spaces/Monster/GPT4ALL)

- ChatUI:nomic-ai/gpt4all-chat: gpt4all-j chat(https:// github.com/nomic-ai/gpt4all-chat)

- GPT4ALL后端:GPT4ALL - ????LangChain 0.0.154(https://python.langchain.com/en/latest/modules/models/llms/integrations) /gpt4all.html)

위 내용은 GPT4ALL: 최고의 오픈 소스 대규모 언어 모델 솔루션의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!