Lava Alpaca LLaVA가 여기에 있습니다. GPT-4처럼 사진을 보고 채팅할 수 있으며 초대 코드가 필요하지 않으며 온라인으로 플레이할 수 있습니다.

- PHPz앞으로

- 2023-05-12 14:28:141279검색

GPT-4의 이미지 인식 기능은 언제 온라인 상태가 되나요? 이 질문에는 아직 답변이 없습니다.

하지만 연구 커뮤니티에서는 더 이상 기다리지 못하고 DIY를 시작했습니다. 가장 인기 있는 프로젝트는 MiniGPT-4라는 프로젝트입니다. MiniGPT-4는 자세한 이미지 설명 생성, 손으로 쓴 초안으로 웹사이트 생성 등 GPT-4와 유사한 많은 기능을 보여줍니다. 또한 저자는 주어진 이미지를 기반으로 이야기와 시를 만들고, 이미지에 표시된 문제에 대한 솔루션을 제공하고, 음식 사진을 기반으로 사용자에게 요리 방법을 가르치는 등 MiniGPT-4의 다른 새로운 기능을 관찰했습니다. 이 프로젝트는 출시 3일 만에 거의 10,000개의 별을 받았습니다.

오늘 소개할 프로젝트 - LLaVA(Large Language and Vision Assistant)는 마이크로소프트 위스콘신대학교-매디슨 연구진이 공동으로 발표한 멀티모달 대규모 언어입니다. 연구 및 컬럼비아 대학교 모델.

- 논문 링크: https://arxiv.org/pdf/2304.08485.pdf

- 프로젝트 링크: https://llava-vl.github.io/

이 모델은 다중 모드 GPT-4에 가까운 일부 이미지 및 텍스트 이해 기능을 보여줍니다. GPT-4에 비해 85.1%의 상대 점수를 달성했습니다. Science QA를 미세 조정하면 LLaVA와 GPT-4의 시너지 효과로 92.53% 정확도의 새로운 SoTA가 달성됩니다.

다음은 Heart of the Machine의 시험 결과입니다(자세한 결과는 기사 끝 부분에서 확인하세요).

논문 개요

인간은 여러 채널을 통해 세계와 상호 작용합니다. 비전, 언어 등 다양한 채널은 특정 개념을 표현하고 전달하는 데 있어 고유한 장점을 갖고 있으며, 다중 채널 접근 방식은 세상을 더 잘 이해하는 데 도움이 되기 때문입니다. 인공지능의 핵심 목표 중 하나는 시각적 또는 언어적 지시와 같은 다중 모드 지시를 효과적으로 따르고, 인간의 의도를 충족시키며, 실제 환경에서 다양한 작업을 완료할 수 있는 보편적인 비서를 개발하는 것입니다.

이를 위해 커뮤니티에서는 언어 향상을 기반으로 한 시각적 모델을 개발하는 추세가 있었습니다. 이러한 유형의 모델은 분류, 감지, 분할, 그래픽은 물론 시각적 생성 및 시각적 편집 기능과 같은 개방형 시각적 이해에 대한 강력한 기능을 갖추고 있습니다. 각 작업은 모델 설계에서 암시적으로 고려된 작업 요구 사항과 함께 대규모 시각적 모델에 의해 독립적으로 해결됩니다. 게다가 언어는 이미지 내용을 설명하는 데에만 사용됩니다. 이로 인해 언어는 시각적 신호를 언어적 의미론(인간 의사소통을 위한 공통 채널)에 매핑하는 데 중요한 역할을 하지만, 이로 인해 모델에서는 종종 상호작용성과 사용자 지침에 대한 적응성이 제한되는 고정 인터페이스가 발생하게 됩니다.

반면에 LLM(대형 언어 모델)은 언어가 범용 지능형 보조자를 위한 범용 대화형 인터페이스로서 더 광범위한 역할을 할 수 있음을 보여주었습니다. 공통 인터페이스에서는 다양한 작업 지침이 언어로 명시적으로 표현될 수 있으며 엔드투엔드 훈련된 신경망 도우미가 작업을 완료하기 위해 모드를 전환하도록 안내할 수 있습니다. 예를 들어, 최근 ChatGPT 및 GPT-4의 성공은 인간의 지시에 따라 작업을 완료하는 LLM의 힘을 입증했으며 오픈 소스 LLM 개발의 물결을 촉발시켰습니다. 그 중 LLaMA는 GPT-3와 유사한 성능을 갖춘 오픈소스 LLM이다. Alpaca, Vicuna, GPT-4-LLM은 기계에서 생성된 다양한 고품질 명령 추적 샘플을 활용하여 LLM의 정렬 기능을 향상시켜 독점 LLM에 비해 인상적인 성능을 보여줍니다. 불행하게도 이러한 모델의 입력은 텍스트뿐입니다.

이 기사에서 연구자들은 지시 조정을 다중 모달 공간으로 확장하여 일반 시각 보조 도구를 구축하기 위한 길을 닦는 최초의 시도인 시각적 지시 조정 방법을 제안합니다.

특히 이 문서는 다음과 같은 기여를 합니다.

- 다중 모드 명령 데이터. 오늘날 주요 과제 중 하나는 시각적 및 언어적 명령 데이터가 부족하다는 것입니다. 이 논문에서는 ChatGPT/GPT-4를 사용하여 이미지-텍스트 쌍을 적절한 명령 형식

- 대형 다중 모드 모델로 변환하는 데이터 재구성 접근 방식을 제안합니다. 연구진은 CLIP의 오픈소스 시각 인코더와 언어 디코더 LLaMA를 연결해 LMM(Large Multimodal Model)인 LLaVA를 개발하고, 생성된 시각-언어 명령 데이터에 대해 엔드 투 엔드 미세 조정을 수행했습니다. 경험적 연구는 LMM 명령 조정을 위해 생성된 데이터를 사용하는 것의 효율성을 검증하고 시각적 에이전트를 따르는 범용 명령을 구축하기 위한 보다 실용적인 기술을 제공합니다. GPT-4를 사용하여 다중 모드 추론 데이터 세트인 Science QA에서 최첨단 성능을 달성합니다.

- 오픈 소스. 연구원들은 생성된 다중 모드 명령 데이터, 데이터 생성 및 모델 훈련을 위한 코드 라이브러리, 모델 체크포인트, 시각적 채팅 데모 등의 자산을 대중에게 공개했습니다.

LLaVA 아키텍처

이 문서의 주요 목표는 사전 훈련된 LLM 및 비전 모델의 기능을 효과적으로 활용하는 것입니다. 네트워크 아키텍처는 그림 1에 나와 있습니다. 이 논문에서는 여러 오픈 소스 순수 언어 교육 조정 작업에서 효율성이 입증되었기 때문에 LLaMA 모델을 LLM fψ(・)로 선택했습니다.

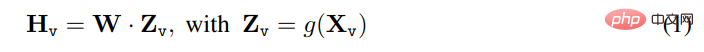

입력 이미지 X_v에 대해 이 기사에서는 사전 훈련된 CLIP 시각적 인코더 ViT-L/14를 사용하여 시각적 특징 Z_v=g(X_v)를 처리하고 얻습니다. 실험에는 마지막 Transformer 레이어 전후의 메쉬 특징이 사용되었습니다. 이 기사에서는 간단한 선형 레이어를 사용하여 이미지 기능을 단어 임베딩 공간에 연결합니다. 구체적으로, 훈련 가능한 투영 행렬 W를 적용하여 Z_v를 언어 모델의 단어 임베딩 공간과 동일한 차원을 갖는 언어 임베딩 토큰 H_q로 변환한 후:

일련의 시각적 토큰 H_v를 얻습니다. 이 간단한 투영 방식은 가볍고 저렴하며 데이터 중심 실험을 빠르게 반복할 수 있습니다. 또한 Flamingo의 Gated Cross-Attention 메커니즘과 BLIP-2의 Q-former 또는 객체 수준 기능을 제공하는 기타 시각적 인코더와 같이 이미지와 언어 기능을 연결하기 위한 더 복잡한(그러나 비용이 많이 드는) 방식을 고려할 수도 있습니다. 샘.

실험 결과

다중 모드 챗봇

연구원들은 LLaVA의 이미지 이해 및 대화 기능을 시연하기 위해 챗봇 예제 제품을 개발했습니다. LLaVA가 시각적 입력을 처리하는 방법을 추가로 연구하고 지침을 처리하는 능력을 입증하기 위해 연구원들은 먼저 표 4와 5에 표시된 원본 GPT-4 논문의 예를 사용했습니다. 사용되는 프롬프트는 이미지 콘텐츠에 맞아야 합니다. 비교를 위해 이 기사에서는 해당 논문에서 다중 모드 모델 GPT-4의 프롬프트와 결과를 인용합니다. ㅋㅋㅋ GPT-4. 두 이미지 모두 장면을 이해하고 질문 지침에 답할 수 있는 LLaVA 데이터 세트의 범위를 벗어났습니다. 대조적으로, BLIP-2와 OpenFlamingo는 적절한 방식으로 사용자 지시에 응답하기보다는 이미지 설명에 중점을 둡니다. 더 많은 예가 그림 3, 그림 4 및 그림 5에 나와 있습니다.

정량평가 결과는 표 3과 같다.

ScienceQA

ScienceQA에는 풍부한 도메인 다양성을 갖춘 3가지 테마, 26가지 주제, 127가지 카테고리 및 379가지 기술을 다루는 21,000개의 다중 모드 객관식 질문이 포함되어 있습니다. 벤치마크 데이터 세트는 각각 12726, 4241 및 4241 샘플을 사용하여 훈련, 검증 및 테스트 부분으로 나뉩니다. 이 글에서는 GPT-3.5 모델(text-davinci-002)과 CoT(Chain of Thought) 버전이 없는 GPT-3.5 모델, LLaMA-Adapter 및 MM-CoT(Multimodal Thought Chain)의 두 가지 대표적인 방법을 비교합니다[57 ]는 이 데이터 세트에 대한 현재 SoTA 방법이며, 그 결과는 표 6에 나와 있습니다.

시험 피드백

논문에 제공된 시각화 사용 페이지에서 Machine Heart도 일부 그림과 지침을 입력하려고 시도했습니다. 첫 번째는 Q&A의 일반적인 여러 사람이 수행하는 작업입니다. 테스트 결과 인원 수를 셀 때 더 작은 대상은 무시되고, 사람이 겹치는 경우 인식 오류가 발생하며, 성별에 대한 인식 오류도 있는 것으로 나타났습니다.

다음으로 사진 이름을 지정하거나 사진을 기반으로 이야기를 들려주는 등 몇 가지 생성 작업을 시도했습니다. 모델이 출력하는 결과는 여전히 이미지 내용을 이해하는 쪽으로 편향되어 있어 생성 능력을 강화할 필요가 있습니다.

이 사진에서는 인체가 겹쳐져 있어도 인원수를 정확하게 식별할 수 있습니다. 그림 설명이나 이해력 측면에서 볼 때, 이 글의 작업에는 아직 볼만한 부분이 있고, 2차 창작의 여지가 있습니다.

위 내용은 Lava Alpaca LLaVA가 여기에 있습니다. GPT-4처럼 사진을 보고 채팅할 수 있으며 초대 코드가 필요하지 않으며 온라인으로 플레이할 수 있습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!