최신 연구, GPT-4의 단점이 드러났습니다! 언어의 모호함을 잘 이해할 수 없습니다!

- PHPz앞으로

- 2023-05-11 21:52:041671검색

자연어 추론(NLI)은 자연어 처리에서 중요한 작업으로 주어진 전제와 가정을 바탕으로 전제에서 가설을 추론할 수 있는지 여부를 판단하는 것이 목표입니다. 그러나 모호성은 자연어의 본질적인 특징이기 때문에 모호성을 다루는 것도 인간의 언어 이해에 있어서 중요한 부분이다. 인간의 언어 표현이 다양하기 때문에 모호성 처리는 자연어 추론 문제를 해결하는 데 어려움 중 하나가 되었습니다. 현재 질의응답 시스템, 음성인식, 지능형 번역, 자연어 생성 등 다양한 자연어 처리 알고리즘이 시나리오에 적용되고 있지만, 이러한 기술로도 모호성을 완전히 해결하는 것은 여전히 매우 어려운 작업이다.

NLI 작업의 경우 GPT-4와 같은 대규모 자연어 처리 모델은 어려움에 직면합니다. 한 가지 문제는 언어의 모호함으로 인해 모델이 문장의 진정한 의미를 정확하게 이해하기 어렵다는 것입니다. 또한 자연어의 유연성과 다양성으로 인해 서로 다른 텍스트 간에 다양한 관계가 존재할 수 있으며 이는 NLI 작업의 데이터 세트를 매우 복잡하게 만듭니다. 이는 또한 자연어 처리 모델의 보편성과 다양성에 영향을 미칩니다. 중요한 도전. 따라서 모호한 언어를 다루는 데 있어 향후 대형 모델의 성공 여부가 중요할 것이며, 대형 모델은 대화형 인터페이스, 필기 도구 등의 분야에서 널리 사용되고 있다. 모호성을 다루는 것은 다양한 상황에 적응하고, 의사소통의 명확성을 향상시키며, 오해의 소지가 있거나 기만적인 말을 식별하는 능력을 높이는 데 도움이 됩니다.

대형 모델의 모호성을 논의하는 이 문서의 제목은 "We're Afraid..."라는 말장난을 사용합니다. 이는 모호성을 정확하게 모델링하는 언어 모델의 어려움에 대한 현재의 우려를 표현할 뿐만 아니라 에 설명된 언어에 대한 힌트도 제공합니다. 종이 구조. 또한 이 기사에서는 사람들이 자연어를 보다 정확하게 이해 및 생성하고 모델의 새로운 혁신을 달성하기 위해 강력하고 새로운 대형 모델에 실제로 도전하기 위한 새로운 벤치마크를 개발하기 위해 열심히 노력하고 있음을 보여줍니다.

논문 제목: We're Afraid Language Models Are n't Modeling Ambiguity

논문 링크: https://arxiv.org/abs/2304.14399

코드 및 데이터 주소: https://github.com/alisawuffles/ambient

이 글의 저자는 사전 훈련된 대형 모델이 다양한 해석이 가능한 문장을 인식하고 구별하는 능력을 가지고 있는지 연구하고, 모델이 다양한 읽기와 해석을 어떻게 구별하는지 평가할 계획입니다. 그러나 기존 벤치마크 데이터에는 모호한 예가 포함되어 있지 않은 경우가 많으므로 이 문제를 탐색하려면 자체 실험을 구축해야 합니다.

기존의 NLI 3방향 주석 방식은 자연어 추론(NLI) 작업에 사용되는 주석 방법을 말하며, 주석 작성자는 원본 텍스트와 가설 간의 관계를 나타내기 위해 3개의 레이블 중 하나의 레이블을 선택해야 합니다. 세 가지 레이블은 일반적으로 "수반", "중립" 및 "모순"입니다.

저자는 NLI 작업 형식을 사용하여 실험을 수행했으며, 암시 관계에 대한 전제 또는 가정의 모호성의 영향을 통해 모호성을 특성화하는 기능적 접근 방식을 채택했습니다. 저자는 다양한 어휘, 구문 및 화용적 모호성을 다루고 더 광범위하게 여러 가지 메시지를 전달할 수 있는 문장을 다루는 AMBIENT(Ambiguity in Entailment)라는 벤치마크를 제안합니다.

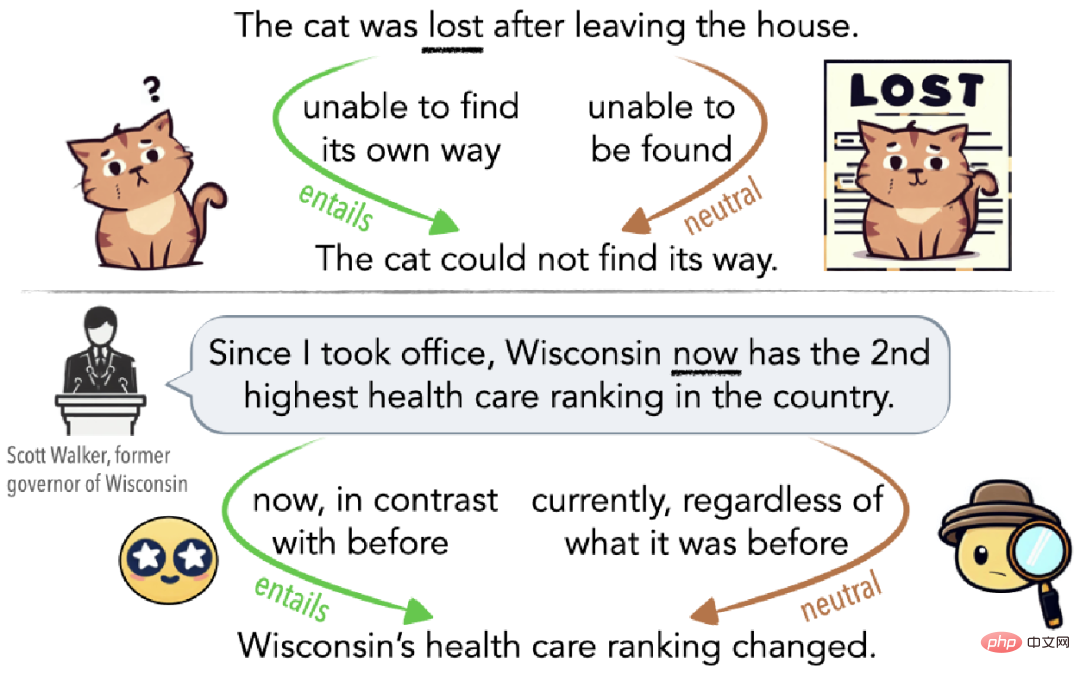

그림 1에서 볼 수 있듯이 모호함은 무의식적인 오해일 수도 있고(그림 1 상단) 청중을 오도하기 위해 의도적으로 사용될 수도 있습니다(그림 1 하단). 예를 들어, 고양이가 집을 떠난 후 길을 잃으면 집으로 가는 길을 찾을 수 없다는 의미에서 길을 잃습니다(함축 가장자리). 며칠 동안 집에 돌아오지 않으면 다른 사람들이 길을 잃었다는 의미에서 길을 잃습니다. 어떤 의미에서는 그것을 찾을 수 없습니다(중립적인 측면).

▲ 그림 1 Cat Lost가 설명하는 모호성의 예

AMBIENT 데이터 세트 소개

선택된 예

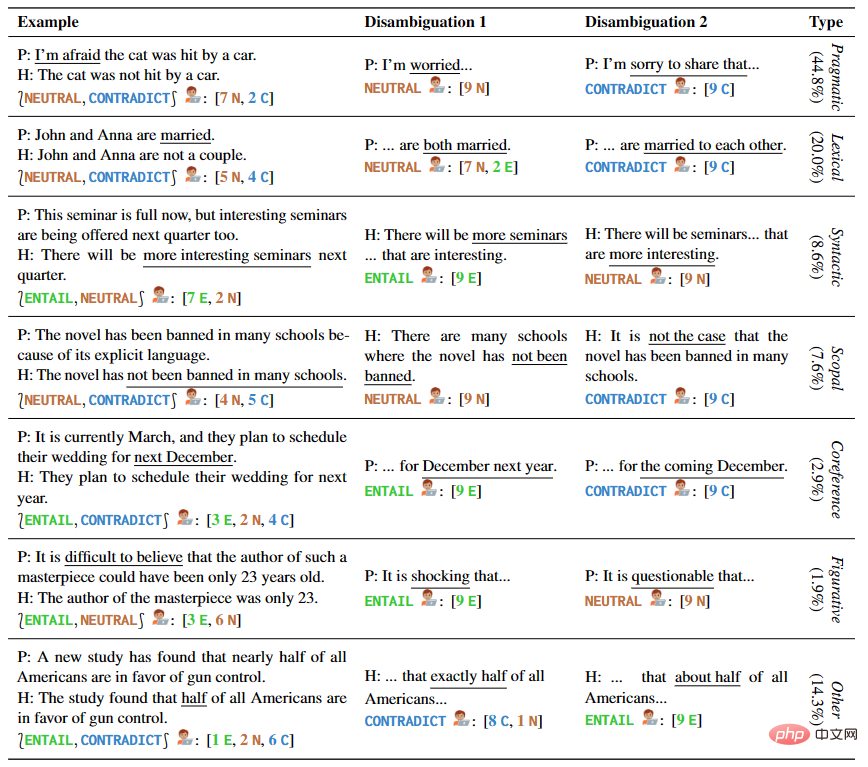

저자는 손으로 쓴 샘플과 현대의 샘플을 포함하여 다양한 유형의 모호성을 다루는 1645개의 문장 샘플을 제공합니다. NLI가 있습니다. 데이터 세트 및 언어학 교과서. AMBIENT의 각 예에는 표 1에 표시된 대로 다양한 가능한 이해에 해당하는 레이블 세트와 각 이해에 대한 명확성 재작성이 포함되어 있습니다.

▲표 1 선택한 예제의 전제 및 가정 쌍

생성된 예제

연구원들은 또한 다양한 모호성 상황에 대한 보다 정확한 포괄적인 적용을 위해 라벨이 지정되지 않은 대규모 NLI 예제 코퍼스를 구축하기 위해 과잉 생성 및 필터링 방법을 채택했습니다. 이전 작업에서 영감을 받아 추론 패턴을 공유하는 전제 쌍을 자동으로 식별하고 동일한 패턴을 가진 새로운 예를 생성하도록 장려하여 말뭉치의 품질을 향상시킵니다.

주석 및 확인

이전 단계에서 얻은 예제에는 주석 및 주석이 필요합니다. 이 과정에는 두 명의 전문가의 주석, 한 명의 전문가의 검증 및 요약, 일부 저자의 검증이 포함되었습니다. 한편, 37명의 언어학 학생들은 각 예에 대한 레이블 세트를 선택하고 명확성 재작성을 제공했습니다. 주석이 달린 이러한 모든 예시는 필터링 및 검증되어 1,503개의 최종 예시가 탄생했습니다.

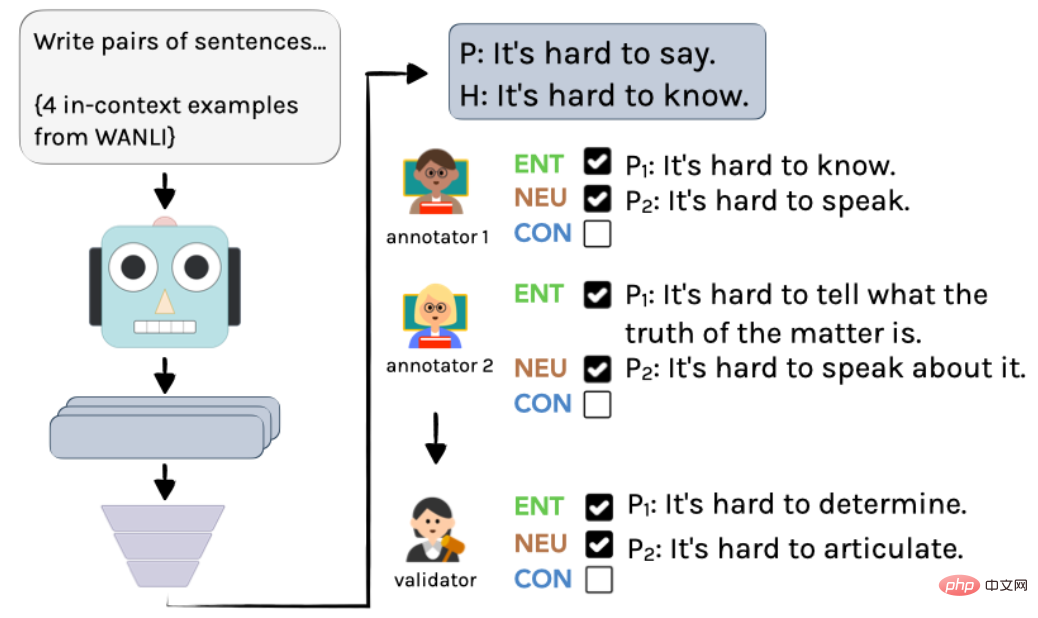

구체적인 프로세스는 그림 2에 나와 있습니다. 먼저 InstructGPT를 사용하여 레이블이 없는 예제를 만든 다음 두 명의 언어학자가 독립적으로 주석을 답니다. 마지막으로 작성자의 통합을 통해 최종 주석 및 주석을 얻습니다.

▲ 그림 2 AMBIENT에서 예제 생성을 위한 주석 프로세스

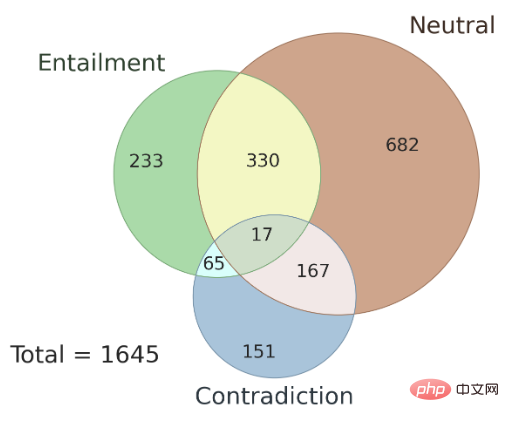

또한 여기에서는 서로 다른 주석자 간의 주석 결과 일관성 문제와 AMBIENT 데이터 세트에 존재하는 모호성 유형에 대해서도 논의합니다. 저자는 이 데이터 세트에서 무작위로 100개의 샘플을 개발 세트로 선택하고 나머지 샘플을 테스트 세트로 사용했습니다. 그림 3은 세트 레이블의 분포를 보여주며 각 샘플에는 해당 추론 관계 레이블이 있습니다. 연구에 따르면 모호한 경우 여러 주석자의 주석 결과가 일관되며 여러 주석자의 공동 결과를 사용하면 주석 정확도를 향상시킬 수 있습니다.

▲ 그림 3 AMBIENT의 세트라벨 분포

모호함이 '불일치'를 설명하나요?

이 연구는 전통적인 NLI 3방향 주석 방식에서 모호한 입력에 주석을 달 때 주석자의 동작을 분석합니다. 연구에 따르면 주석 작성자는 모호성을 인식할 수 있으며 모호함이 라벨링 차이의 주요 원인이므로 시뮬레이션된 예에서 "일치"가 불확실성의 원인이라는 대중적인 가정에 도전하는 것으로 나타났습니다.

이 연구에서는 AMBIENT 데이터 세트가 사용되었으며 9명의 크라우드소싱 작업자가 모호한 각 예에 주석을 달기 위해 고용되었습니다.

작업은 세 단계로 나뉩니다.

- 모호한 예에 주석 달기

- 가능한 다른 해석 식별

- 모호하지 않은 예에 주석 달기

그 중 2단계에서는 가능한 세 가지 설명에 두 가지가 포함됩니다. 의미는 문장과 유사합니다. 그러나 완전히 똑같지는 않습니다. 마지막으로 가능한 각 설명에 대해 원래 예제로 대체되어 세 개의 새로운 NLI 예제를 얻고 주석자는 각각 레이블을 선택하도록 요청됩니다.

이 실험의 결과는 다음과 같은 가설을 뒷받침합니다. 단일 라벨링 시스템에서 원본 퍼지 예제는 매우 불일치한 결과를 생성합니다. 즉, 문장에 라벨을 붙이는 과정에서 사람들은 모호한 문장에 대해 서로 다른 판단을 내리게 되어 불일치하게 됩니다. 결과. 그러나 작업에 명확성 단계를 추가하면 주석 작성자는 일반적으로 문장에 대한 여러 가능성을 식별하고 검증할 수 있었고 결과의 불일치가 대부분 해결되었습니다. 따라서 명확성은 주석 작성자의 주관성이 결과에 미치는 영향을 줄이는 효과적인 방법입니다.

대형 모델의 성능을 평가해 보세요

Q1. 명확성과 관련된 콘텐츠를 직접 생성할 수 있나요?

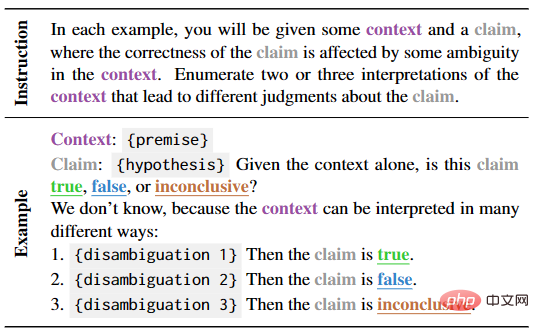

이 부분의 초점은 명확성과 컨텍스트에 해당하는 레이블을 직접 생성하는 언어 모델의 학습 능력을 테스트하는 것입니다. 이를 위해 저자는 표 2에 표시된 대로 자연스러운 단서를 구축하고 자동 및 수동 평가를 사용하여 모델 성능을 검증했습니다.

▲표 2 전제가 불분명할 때 명확성 작업을 생성하기 위한 Few-shot 템플릿

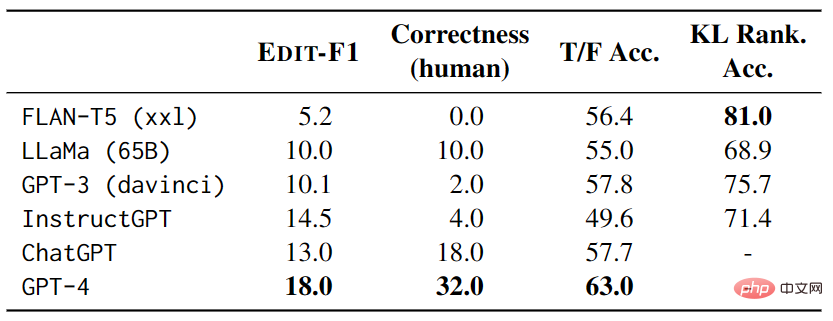

테스트에서 각 예는 4개의 다른 테스트 예를 컨텍스트로 포함하고 EDIT-F1 측정항목과 사람의 평가를 사용하여 점수와 정확성을 계산합니다. . 표 3에 표시된 실험 결과는 GPT-4가 테스트에서 가장 좋은 성능을 발휘하여 EDIT-F1 점수 18.0%, 인간 평가 정확도 32.0%를 달성했음을 보여줍니다. 또한, 대형 모델은 가설을 직접 확인하거나 거부하기 위해 명확화 중에 추가 컨텍스트를 추가하는 전략을 채택하는 경우가 종종 관찰되었습니다. 그러나 인간의 평가는 모호성의 원인을 정확하게 보고하는 모델의 능력을 과대평가할 수 있다는 점에 유의하는 것이 중요합니다.

▲표 3 AMBIENT의 대형 모델 성능

Q2. 합리적인 설명의 타당성을 식별할 수 있나요?

이 부분에서는 주로 모호한 문장을 식별하는 대형 모델의 성능을 연구합니다. 연구원들은 참과 거짓 진술의 일련의 템플릿을 만들고 모델에 대한 제로샷 테스트를 통해 참과 거짓 사이의 예측을 선택하는 데 대형 모델이 얼마나 잘 수행되는지 평가했습니다. 실험 결과에 따르면 가장 좋은 모델은 GPT-4이지만 모호성을 고려하면 GPT-4는 네 가지 템플릿 모두의 모호한 해석에 답하는 데 있어 무작위 추측보다 성능이 떨어집니다. 또한, 대형 모델은 질문 측면에서 일관성 문제가 있으며, 동일한 모호한 문장에 대한 서로 다른 해석 쌍에 대해 모델 내부에 모순이 있을 수 있습니다.

이러한 결과는 대형 모델의 모호한 문장에 대한 이해를 향상시키고 대형 모델의 성능을 더 잘 평가하는 방법에 대한 추가 연구가 필요함을 시사합니다.

Q3. 다양한 해석을 통한 개방형 연속 생성 시뮬레이션

이 부분에서는 주로 언어 모델을 기반으로 한 모호성 이해 능력을 연구합니다. 언어 모델은 주어진 상황에서 가능한 다양한 해석 하에서 텍스트 연속성에 대한 예측을 비교하여 테스트됩니다. 모호성을 처리하는 모델의 능력을 측정하기 위해 연구자들은 KL 발산을 사용하여 해당 컨텍스트에서 주어진 모호성과 주어진 올바른 컨텍스트 하에서 모델에 의해 생성된 확률 및 기대 차이를 비교함으로써 모델의 "놀라움"을 측정했습니다. , 모델의 능력을 추가로 테스트하기 위해 명사를 무작위로 대체하는 "간섭 문장"을 도입했습니다.

실험 결과에 따르면 FLAN-T5의 정확도가 가장 높지만 다양한 테스트 모음(LS에는 동의어 대체, PC에는 철자 오류 수정, SSD에는 문법 구조 수정 포함)의 성능 결과가 일치하지 않습니다. 그 모호함은 여전히 심각한 과제입니다.

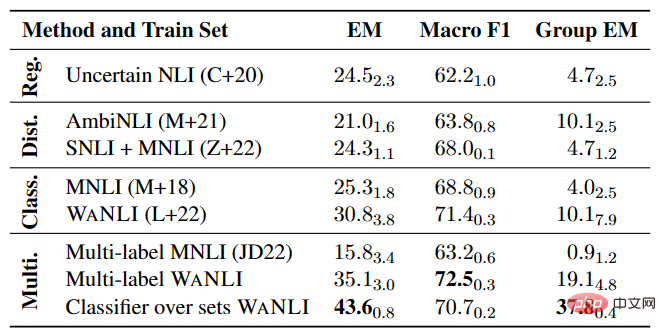

다중 라벨 NLI 모델 실험

표 4에서 볼 수 있듯이 특히 다중 라벨 NLI 작업에서 라벨 변경이 포함된 기존 데이터에 대한 NLI 모델을 미세 조정하는 데는 여전히 개선의 여지가 많습니다.

▲표 4 AMBIENT의 다중 레이블 NLI 모델 성능

오도하는 정치적 발언 탐지

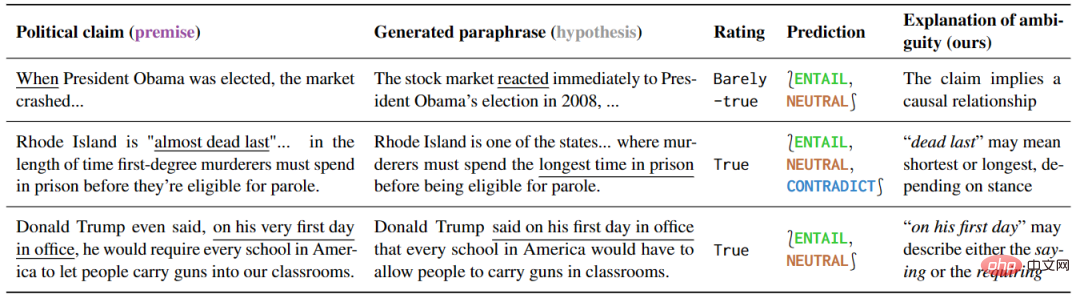

이 실험은 정치적 발언을 이해하는 다양한 방식을 연구하고 다양한 이해 방식에 민감한 모델이 효과적으로 사용될 수 있음을 증명합니다. . 연구 결과는 Table 5와 같다. 모호한 문장의 경우 일부 설명 해석은 모호성을 유지하거나 특정 의미를 명확하게 표현할 수 있기 때문에 자연스럽게 모호성을 제거할 수 있다.

▲표 5 이 기사의 탐지 방법은 정치적 발언을 모호하게 표시합니다

또한 이 예측의 해석을 통해 모호성의 근원을 밝힐 수 있습니다. 저자들은 오탐지 결과를 추가로 분석함으로써 사실 확인에서 언급되지 않은 많은 모호성을 발견했으며, 이는 오해를 방지하는 데 있어 이러한 도구의 큰 잠재력을 보여줍니다.

요약

이 기사에서 지적한 것처럼 자연어의 모호성은 모델 최적화의 핵심 과제가 될 것입니다. 향후 기술 발전에서는 자연어 이해 모델이 텍스트의 맥락과 요점을 더욱 정확하게 파악하고, 모호한 텍스트를 처리할 때 더 높은 민감도를 발휘할 수 있을 것으로 기대합니다. 모호성을 식별하기 위해 자연어 처리 모델을 평가하기 위한 벤치마크를 확립하고 이 영역에서 모델의 한계를 더 잘 이해할 수 있지만 이는 여전히 매우 어려운 작업입니다.

Xi Xiaoyao 기술 토크 원본

저자 IQ가 여기저기 떨어졌어요, Python

위 내용은 최신 연구, GPT-4의 단점이 드러났습니다! 언어의 모호함을 잘 이해할 수 없습니다!의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!