Python을 사용하여 포인트 클라우드 지면 감지 구현

- 王林앞으로

- 2023-05-09 17:28:082558검색

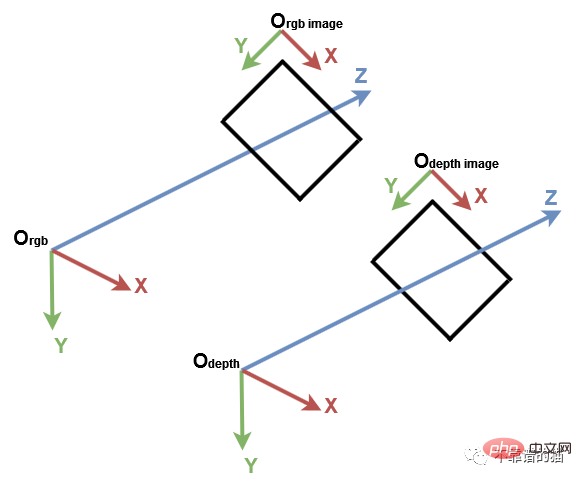

1. 컴퓨터 비전 좌표계

시작하기 전에 컴퓨터 비전의 전통적인 좌표계를 이해하는 것이 중요합니다. 그 다음에는 Open3D와 Microsoft Kinect 센서가 있습니다. 컴퓨터 비전에서 이미지는 별도의 2D 좌표계로 표현됩니다. 여기서 x축은 왼쪽에서 오른쪽으로, y축은 위쪽과 아래쪽을 가리킵니다. 카메라의 경우 3D 좌표계의 원점은 카메라의 초점에 있으며, x축은 오른쪽을 가리키고 y축은 아래를 가리키며 z축은 앞쪽을 가리킵니다.

컴퓨터 비전 좌표계

먼저 필요한 Python 라이브러리를 가져옵니다.

import numpy as np import open3d as o3d

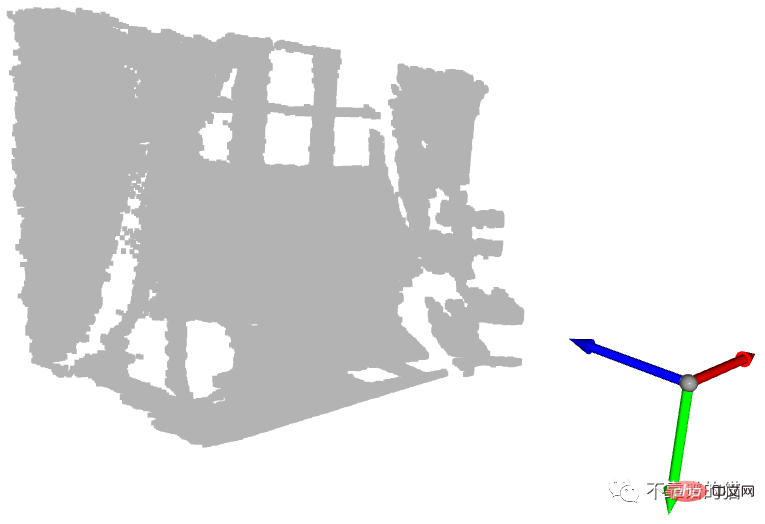

더 나은 이해를 위해 PLY 파일에서 포인트 클라우드를 가져오고 Open3D를 사용하여 기본 3D 좌표계를 만든 다음 표시해 보겠습니다.

# Read point cloud:

pcd = o3d.io.read_point_cloud("data/depth_2_pcd.ply")

# Create a 3D coordinate system:

origin = o3d.geometry.TriangleMesh.create_coordinate_frame(size=0.5)

# geometries to draw:

geometries = [pcd, origin]

# Visualize:

o3d.visualization.draw_geometries(geometries)

좌표계 원점과 함께 표시된 포인트 클라우드

파란색 화살표는 Z축, 빨간색 화살표는 X축, 녹색 화살표는 Y축입니다. Open3D 좌표계와 동일한 좌표계로 포인트 클라우드가 표현되는 것을 확인할 수 있습니다. 이제 각 축의 최소값과 최대값으로 점을 구해 보겠습니다.

# Get max and min points of each axis x, y and z: x_max = max(pcd.points, key=lambda x: x[0]) y_max = max(pcd.points, key=lambda x: x[1]) z_max = max(pcd.points, key=lambda x: x[2]) x_min = min(pcd.points, key=lambda x: x[0]) y_min = min(pcd.points, key=lambda x: x[1]) z_min = min(pcd.points, key=lambda x: x[2])

인쇄할 수도 있지만 더 나은 시각화를 위해 각 점 위치에 구를 만듭니다. 기본적으로 Open3D는 원점 위치에 3D 형상을 생성합니다.

구를 주어진 위치로 이동하려면 변환 변환이 필요합니다. 아래 예제에서 구는 벡터 [1,1,1]에 의해 변환됩니다.

예제로 돌아가서 각 구에 색상을 지정해 보겠습니다. 각 위치에 대해 구를 만들고 해당 위치로 변환합니다. 그런 다음 올바른 색상을 할당하고 마지막으로 이를 디스플레이에 추가합니다.

# Colors: RED = [1., 0., 0.] GREEN = [0., 1., 0.] BLUE = [0., 0., 1.] YELLOW = [1., 1., 0.] MAGENTA = [1., 0., 1.] CYAN = [0., 1., 1.] positions = [x_max, y_max, z_max, x_min, y_min, z_min] colors = [RED, GREEN, BLUE, MAGENTA, YELLOW, CYAN] for i in range(len(positions)): # Create a sphere mesh: sphere = o3d.geometry.TriangleMesh.create_sphere(radius=0.05) # move to the point position: sphere.translate(np.asarray(positions[i])) # add color: sphere.paint_uniform_color(np.asarray(colors[i])) # compute normals for vertices or faces: sphere.compute_vertex_normals() # add to geometry list to display later: geometries.append(sphere) # Display: o3d.visualization.draw_geometries(geometries)

실제로 y축은 점의 높이를 나타냅니다. 현실 세계에서 가장 높은 공은 노란색 공이고 가장 낮은 공은 녹색 공입니다. 그러나 y축이 아래쪽을 향하고 있으므로 노란색 구체의 값이 가장 작고 녹색 구체의 값이 가장 큽니다.

또 다른 흥미로운 구는 원점에 있는 청록색 구입니다. 이전 튜토리얼에서 언급했듯이 깊이 값이 0인 픽셀은 노이즈 포인트이므로 원점에 위치한 포인트는 이러한 노이즈 픽셀에서 계산된 포인트입니다(z=0이면 x=0, y=0).

2. 지상 감지

이제 몇 가지 중요한 사항을 살펴보았으니, 이전 예에서 녹색 구체는 지상에 있습니다. 정확히 말하면 그 중심은 지상점인 y축의 가장 높은 지점에 해당한다. 지면 감지를 위해 y_max를 사용하여 모든 점의 색상을 녹색으로 변경한다고 가정합니다.

포인트 클라우드를 표시하면 모든 지면 점이 녹색이 아니라는 것을 알 수 있습니다. 실제로 이전 녹색 구의 중심에 해당하는 점 하나만 녹색입니다. 이는 깊이 카메라의 정확도와 노이즈 때문입니다.

이 제한을 극복하려면 y 좌표가 [y_max-threshold, y_max]인 지점이 지상 지점으로 간주되도록 임계값을 추가해야 합니다. 이를 위해 y_max를 얻은 후 각 점의 y 좌표가 간격 내에 있는지 확인한 다음 색상을 녹색으로 설정합니다. 마지막으로 포인트 클라우드의 색상 속성이 업데이트되고 결과가 표시됩니다.

# Define a threshold: THRESHOLD = 0.075 # Get the max value along the y-axis: y_max = max(pcd.points, key=lambda x: x[1])[1] # Get the original points color to be updated: pcd_colors = np.asarray(pcd.colors) # Number of points: n_points = pcd_colors.shape[0] # update color: for i in range(n_points): # if the current point is aground point: if pcd.points[i][1] >= y_max - THRESHOLD: pcd_colors[i] = GREEN# color it green pcd.colors = o3d.utility.Vector3dVector(pcd_colors) # Display: o3d.visualization.draw_geometries([pcd, origin])

이 경우에는 바탕색을 나타내는 점만 녹색으로 색칠하겠습니다. 실제 응용 프로그램에서는 지면을 추출하여 로봇이나 시각 장애인 시스템과 같이 보행 가능한 영역을 정의하거나 인테리어 디자인 시스템과 같은 물체를 그 위에 배치합니다. 또한 제거할 수 있으므로 장면 이해 및 객체 감지 시스템에서와 같이 나머지 지점을 분할하거나 분류할 수 있습니다.

3. 정리된 포인트 클라우드

우리는 포인트 클라우드가 3D 포인트의 집합으로 정의된다는 것을 알고 있습니다. 집합은 순서가 없는 구조이므로, 집합으로 표현되는 포인트 클라우드를 비조직 포인트 클라우드라고 합니다. RGB 매트릭스와 유사하게 구성된 포인트 클라우드는 포인트의 x, y 및 z 좌표를 나타내는 3개 채널이 있는 2D 매트릭스입니다. 행렬 구조는 인접한 점 간의 관계를 제공함으로써 최근접 이웃 알고리즘과 같은 일부 알고리즘의 시간 복잡도를 줄입니다.

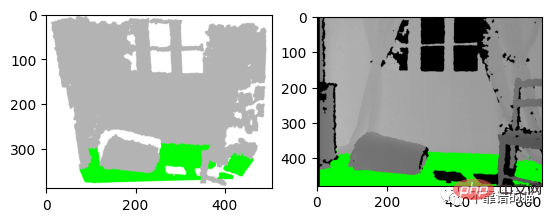

예를 들어, 우리는 연구 논문을 작성 중이며 탐지 알고리즘의 결과를 그래프 형식으로 표시하려고 합니다. 아래 그림과 같이 포인트 클라우드의 스크린샷을 찍거나 깊이 이미지에 결과를 표시할 수 있습니다. 제 생각에는 두 번째 옵션이 가장 좋습니다. 이 경우 깊이 픽셀의 위치를 저장하기 위해 체계적인 포인트 클라우드가 필요합니다.

左:3D 可视化的屏幕截图 右:深度图像的结果

让我们从之前的深度图像创建一个有组织的点云。我们首先导入相机参数。我们还导入深度图像并将其转换为3通道灰度图像,以便我们可以将地面像素设置为绿色:

import imageio.v3 as iio

import numpy as np

import matplotlib.pyplot as plt

# Camera parameters:

FX_DEPTH = 5.8262448167737955e+02

FY_DEPTH = 5.8269103270988637e+02

CX_DEPTH = 3.1304475870804731e+02

CY_DEPTH = 2.3844389626620386e+02

# Read depth image:

depth_image = iio.imread('../data/depth_2.png')

# Compute the grayscale image:

depth_grayscale = np.array(256 * depth_image / 0x0fff, dtype=np.uint8)

# Convert a grayscale image to a 3-channel image:

depth_grayscale = np.stack((depth_grayscale,) * 3, axis=-1)要计算一个有组织的点云,我们使用与上一篇教程相同的方法(Python:基于 RGB-D 图像的点云计算)。我们没有将深度图像扁平化,而是将jj和ii重塑为与深度图像相同的形状,如下所示:

# get depth image resolution: height, width = depth_image.shape # compute indices and reshape it to have the same shape as the depth image: jj = np.tile(range(width), height).reshape((height, width)) ii = np.repeat(range(height), width).reshape((height, width)) # Compute constants: xx = (jj - CX_DEPTH) / FX_DEPTH yy = (ii - CY_DEPTH) / FY_DEPTH # compute organised point cloud: organized_pcd = np.dstack((xx * depth_image, yy * depth_image, depth_image))

如果你打印出创建的点云的形状,你可以看到它是一个有3个通道的矩阵(480,640,3)。如果你觉得这个代码很难理解,请回到之前的教程(Python:基于 RGB-D 图像的点云计算)。

类似地,我们像上面那样检测地面,但不是更新点的颜色并显示点云,而是更新灰度图像的像素并显示它:

# Ground_detection: THRESHOLD = 0.075 * 1000# Define a threshold y_max = max(organized_pcd.reshape((height * width, 3)), key=lambda x: x[1])[ 1]# Get the max value along the y-axis # Set the ground pixels to green: for i in range(height): for j in range(width): if organized_pcd[i][j][1] >= y_max - THRESHOLD: depth_grayscale[i][j] = [0, 255, 0]# Update the depth image # Display depth_grayscale: plt.imshow(depth_grayscale) plt.show()

4.结论

在本教程中,为了熟悉点云,我们引入了默认坐标系统,并实现了一个简单的地面检测算法。事实上,地面检测在某些应用(如导航)中是一项重要的任务,文献中已经提出了几种算法。实现算法简单;它认为最低点是地面。然而,它的限制是,深度相机必须与地面平行,这是大多数现实应用的情况不是这样的。

위 내용은 Python을 사용하여 포인트 클라우드 지면 감지 구현의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!