HuggingGPT: AI 작업을 위한 마법의 도구

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB앞으로

- 2023-05-08 18:40:191454검색

소개

일반인공지능(AGI)은 인간과 마찬가지로 지적 작업을 이해하고, 처리하고, 대응할 수 있는 인공지능 시스템이라고 생각할 수 있습니다. 이는 인간의 두뇌가 어떻게 작동하는지에 대한 깊은 이해가 필요한 어려운 작업입니다. 그러나 ChatGPT의 출현으로 인해 연구 커뮤니티에서는 이러한 시스템을 개발하는 데 큰 관심을 불러일으켰습니다. Microsoft는 HuggingGPT(Microsoft Jarvis)라는 핵심 AI 기반 시스템을 출시했습니다.

HuggingGPT의 새로운 기능과 작동 방식에 대한 세부 정보를 살펴보기 전에 먼저 ChatGPT의 문제와 복잡한 AI 작업을 해결하는 데 어려움을 겪는 이유를 이해하겠습니다. ChatGPT와 같은 대규모 언어 모델은 텍스트 데이터를 해석하고 일반 작업을 처리하는 데 능숙합니다. 그러나 그들은 종종 특정 작업에 어려움을 겪고 터무니없이 반응할 수 있습니다. 복잡한 수학 문제를 해결하는 동안 ChatGPT에서 가짜 응답을 받았을 수 있습니다. 반면에 우리는 Stable Diffusion과 DALL-E와 같은 전문가 수준의 AI 모델을 보유하고 있는데, 이들은 각각의 주제 영역에 대해 더 깊이 이해하고 있지만 더 넓은 범위의 작업을 처리하는 데 어려움을 겪고 있습니다. LLM과 전문 AI 모델 간의 연결을 설정하지 않으면 LLM의 잠재력을 완전히 활용하여 까다로운 AI 작업을 해결할 수 없습니다. 이것이 HuggingGPT가 하는 일이며, 두 가지 장점을 결합하여 보다 효과적이고 정확하며 다재다능한 AI 시스템을 만듭니다.

HuggingGPT가 무엇인가요?

Microsoft가 최근 발표한 논문에 따르면 HuggingGPT는 LLM의 강력한 기능을 컨트롤러로 활용하여 이를 기계 학습 커뮤니티(HuggingFace)의 다양한 AI 모델과 연결하여 외부 도구를 사용하여 작업 효율성을 향상시킬 수 있습니다. HuggingFace는 개발자와 연구원에게 수많은 도구와 리소스를 제공하는 웹사이트입니다. 또한 다양한 전문적이고 고정밀 모델을 보유하고 있습니다. HuggingGPT는 이러한 모델을 다양한 영역과 모드의 복잡한 AI 작업에 적용하여 인상적인 결과를 얻었습니다. 텍스트와 이미지 측면에서 OPenAI GPT-4와 유사한 다중 모드 기능을 갖추고 있습니다. 그러나 인터넷에 연결해 주기도 하며, 이에 대해 질문할 수 있는 외부 웹 링크를 제공할 수도 있습니다.

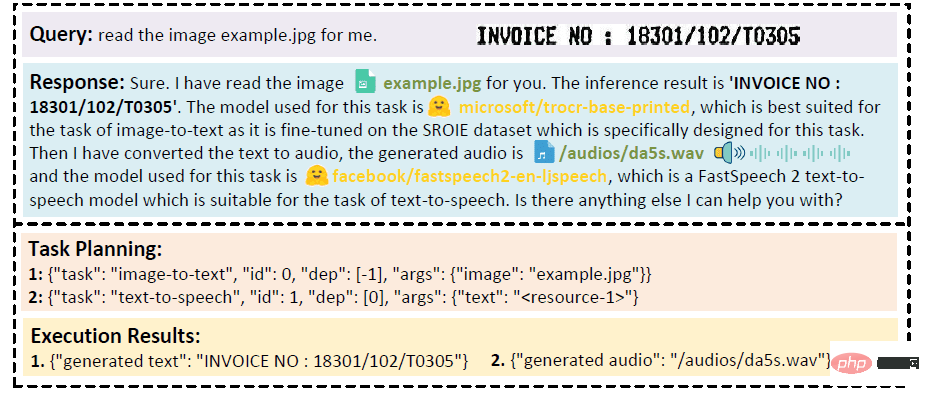

모델이 이미지에 적힌 텍스트를 오디오로 읽기를 원한다고 가정해 보세요. HuggingGPT는 가장 적합한 모델을 사용하여 이 작업을 순차적으로 수행합니다. 먼저 이미지에서 텍스트를 내보내고 그 결과를 오디오 생성에 사용합니다. 답변 내용은 아래 이미지에서 확인하실 수 있습니다. 정말 놀랍습니다!

비디오 및 오디오 모드의 다중 모드 협력에 대한 정성 분석

HuggingGPT는 어떻게 작동합니까?

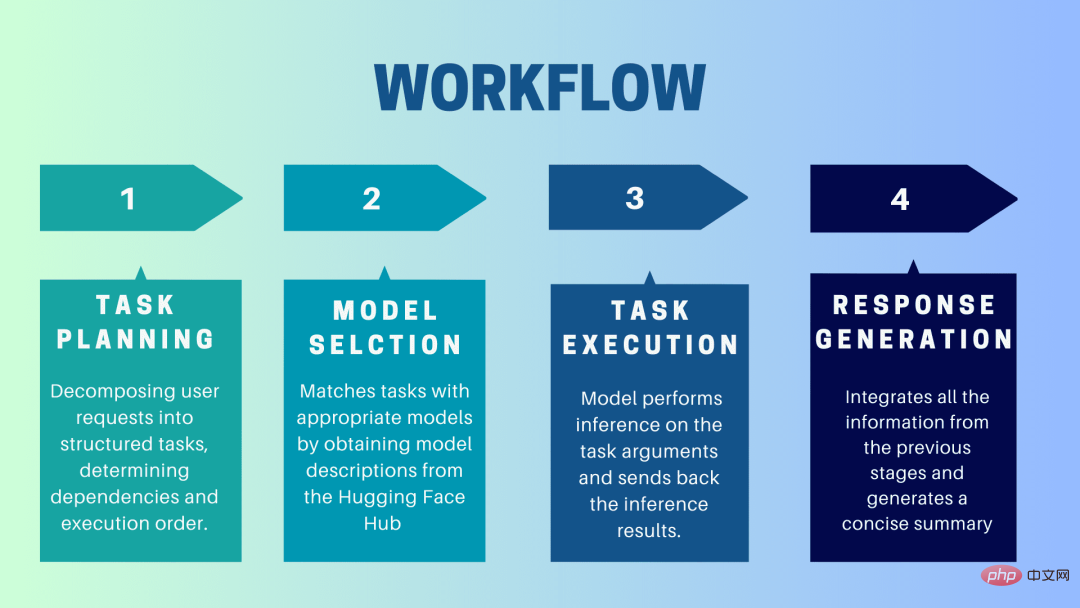

HuggingGPT는 LLM을 인터페이스로 사용하여 사용자 요청을 전문가 모델에 보내는 협업 시스템입니다. 사용자 프롬프트부터 응답 수신까지의 전체 프로세스는 다음과 같은 개별 단계로 분해될 수 있습니다.

1. 작업 계획

이 단계에서 HuggingGPT는 ChatGPT를 활용하여 사용자 프롬프트를 이해한 다음 쿼리를 작고 관리 가능한 크기로 분해합니다. 운영 작업. 또한 이러한 작업의 종속성을 식별하고 작업이 실행되는 순서를 정의합니다. HuggingGPT에는 작업 구문 분석을 위한 4개의 슬롯, 즉 작업 유형, 작업 ID, 작업 종속성 및 작업 매개변수가 있습니다. HuggingGPT와 사용자 간의 채팅은 녹음되어 리소스 기록을 보여주는 화면에 표시됩니다.

2. 모델 선택

HuggingGPT는 사용자 환경과 사용 가능한 모델을 기반으로 상황에 맞는 작업 모델 할당 메커니즘을 사용하여 특정 작업에 가장 적합한 모델을 선택합니다. 이 메커니즘에 따르면 모델 선택은 처음에는 작업 유형에 따라 모델을 필터링하는 객관식 질문으로 간주됩니다. 이후 다운로드 수를 기준으로 모델 순위를 매겼는데, 이는 모델 품질을 신뢰할 수 있는 척도로 간주되기 때문입니다. 이 순위에 따라 Top-K 모델이 선정됩니다. 여기서 K는 모델 수를 반영하는 상수일 뿐입니다. 예를 들어 3으로 설정하면 다운로드가 가장 많은 3개의 모델이 선택됩니다.

3. 작업 실행

여기서 작업은 특정 모델에 할당되어 추론을 수행하고 결과를 반환합니다. 이 프로세스를 보다 효율적으로 만들기 위해 HuggingGPT는 동일한 리소스가 필요하지 않은 한 다양한 모델을 동시에 실행할 수 있습니다. 예를 들어, 고양이와 개 사진을 생성하라는 메시지가 표시되면 다양한 모델을 병렬로 실행하여 이 작업을 수행할 수 있습니다. 그러나 때로는 모델에 동일한 리소스가 필요할 수 있으므로 HuggingGPT는 리소스를 추적하기 위해

4. 응답 생성

마지막 단계는 사용자에게 응답을 생성하는 것입니다. 첫째, 이전 단계의 모든 정보와 추론 결과를 통합한다. 정보는 구조화된 형식으로 제공됩니다. 예를 들어 이미지에서 사자 수를 감지하라는 메시지가 표시되면 감지 확률과 함께 적절한 경계 상자가 그려집니다. LLM(ChatGPT)은 이 형식을 사용하여 인간 친화적인 언어로 렌더링합니다.

HuggingGPT 설정

HuggingGPT는 자연어 텍스트를 생성할 수 있는 심층 신경망 모델인 Hugging Face의 최첨단 GPT-3.5 아키텍처를 기반으로 구축되었습니다. 로컬 컴퓨터에서 설정하는 방법에 대한 단계는 다음과 같습니다.

시스템 요구 사항

기본 구성에는 Ubuntu 16.04 LTS, 최소 24GB VRAM, 최소 12GB(최소), 16GB(표준) 또는 80GB(전체)가 필요합니다. ) RAM, 최소 284GB의 디스크 공간이 필요합니다. 또한 damo-vilab/text-to-video-ms-1.7b에는 42GB, ControlNet에는 126GB, stable-diffusion-v1-5에는 66GB, 기타 리소스에는 50GB의 공간이 필요합니다. "라이트" 구성의 경우 Ubuntu 16.04 LTS만 필요합니다.

시작하기 위한 단계

먼저 server/configs/config.default.yaml 파일의 OpenAI Key와 Hugging Face Token을 사용자의 키로 교체하세요. 또는 환경 변수 OPENAI_API_KEY 및 HUGGINGFACE_ACCESS_TOKEN에 각각 넣을 수 있습니다.

다음 명령을 실행합니다.

서버의 경우:

- Python 환경을 설정하고 필요한 종속성을 설치합니다.

<code># 设置环境cd serverconda create -n jarvis pythnotallow=3.8conda activate jarvisconda install pytorch torchvision torchaudio pytorch-cuda=11.7 -c pytorch -c nvidiapip install -r requirements.txt</code>

- 필요한 모델을 다운로드하세요.

<code># 下载模型。确保`git-lfs`已经安装。cd modelsbash download.sh # required when `inference_mode` is `local` or `hybrid`.</code>

- 서버 실행

<code># 运行服务器cd ..python models_server.py --config configs/config.default.yaml # required when `inference_mode` is `local` or `hybrid`python awesome_chat.py --config configs/config.default.yaml --mode server # for text-davinci-003</code>

이제 웹 API 엔드포인트에 HTTP 요청을 보내 Jarvis 서비스에 액세스할 수 있습니다.

- /hugginggpt 엔드포인트로 요청을 보내고 POST 메서드를 사용하여 전체 서비스에 액세스하세요.

- /tasks 엔드포인트에서는 POST 메서드를 사용하여 1단계의 중간 결과에 액세스합니다.

- /results 엔드포인트에서는 POST 메서드를 사용하여 1~3단계의 중간 결과에 액세스합니다.

이러한 요청은 JSON 형식이어야 하며 사용자를 대신하여 입력된 정보 목록을 포함해야 합니다.

웹의 경우:

- 서버 모드에서 awesome_chat.py 애플리케이션을 시작한 후 컴퓨터에 node js 및 npm을 설치하세요.

- 웹 디렉터리로 이동하여 다음 종속성을 설치합니다.

<code>cd webnpm installnpm run dev</code>

- 다른 디렉터리에 있는 경우 http://{LAN_IP_of_the_server}:{port}/를 web/src/config/index.ts의 HUGGINGGPT_BASE_URL로 설정합니다. 머신에서 웹 클라이언트를 실행합니다.

- 동영상 생성 기능을 사용하려면 H.264로 ffmpeg를 수동으로 컴파일하세요.

<code># 可选:安装 ffmpeg# 这个命令需要在没有错误的情况下执行。LD_LIBRARY_PATH=/usr/local/lib /usr/local/bin/ffmpeg -i input.mp4 -vcodec libx264 output.mp4</code>

- ChatGPT로 다시 전환하려면 설정 아이콘을 두 번 클릭하세요.

CLI의 경우:

CLI를 사용하여 Jarvis를 설정하는 것은 매우 간단합니다. 아래에 언급된 명령을 실행하세요.

<code>cd serverpython awesome_chat.py --config configs/config.default.yaml --mode cli</code>

Gradio의 경우:

Gradio 데모는 Hugging Face Space에서도 호스팅됩니다. OPENAI_API_KEY 및 HUGGINGFACE_ACCESS_TOKEN을 입력한 후 실험해 볼 수 있습니다.

로컬에서 실행하려면:

- 필요한 종속성을 설치하고 Hugging Face Space에서 프로젝트 저장소를 복제한 후 프로젝트 디렉터리로 이동합니다.

- 다음 명령을 사용하여 모델 서버를 시작한 후 Gradio 데모를 시작합니다.

<code>python models_server.py --config configs/config.gradio.yamlpython run_gradio_demo.py --config configs/config.gradio.yaml</code>

- 브라우저에서 http://localhost:7860에 있는 데모에 액세스하고 다양한 입력을 입력하여 테스트하세요.

- 옵션으로 다음 명령을 실행하여 데모를 Docker 이미지로 실행할 수도 있습니다.

<code>docker run -it -p 7860:7860 --platform=linux/amd64 registry.hf.space/microsoft-hugginggpt:latest python app.py</code>

참고: 궁금한 사항은 공식 Github Repo(https://github.com/microsoft/JARVIS)를 참고해주세요.

최종 생각

HuggingGPT에는 여기서 강조해야 할 특정 제한 사항도 있습니다. 예를 들어 시스템의 효율성은 주요 병목 현상이며 HuggingGPT는 앞서 언급한 모든 단계에서 LLM과의 여러 상호 작용이 필요합니다. 이러한 상호 작용으로 인해 사용자 경험이 저하되고 대기 시간이 늘어날 수 있습니다. 마찬가지로 최대 컨텍스트 길이는 허용되는 토큰 수에 따라 제한됩니다. 또 다른 문제는 시스템의 신뢰성입니다. LLM이 프롬프트를 잘못 해석하고 잘못된 작업 순서를 생성하여 전체 프로세스에 영향을 미칠 수 있기 때문입니다. 그럼에도 불구하고 복잡한 AI 작업을 해결할 수 있는 잠재력이 크며 AGI의 좋은 발전입니다. 이번 연구가 AI의 미래를 어떤 방향으로 이끌지 기대해 보자!

위 내용은 HuggingGPT: AI 작업을 위한 마법의 도구의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!