현재 영어가 아닌 텍스트 및 이미지 생성 모델의 선택은 제한되어 있으며 사용자는 모델에 들어가기 전에 프롬프트를 영어로 번역해야 하는 경우가 많습니다. 이로 인해 추가적인 운영 부담이 발생할 뿐만 아니라 번역 과정에서 언어 및 문화적 오류가 생성된 이미지의 정확성에 영향을 미치게 됩니다.

Zhiyuan Research Institute의 FlagAI 팀은 Stable Diffusion과 결합된 다국어 사전 훈련 모델을 사용하여 텍스트와 이미지를 지원하는 다국어 텍스트 및 이미지 생성 모델인 AltDiffusion-m18을 훈련시켜 효율적인 훈련 방법을 개척했습니다. 18개 언어로 이미지 생성.

중국어, 영어, 일본어, 태국어, 한국어, 힌디어, 우크라이나어, 아랍어, 터키어, 베트남어, 폴란드어, 네덜란드어, 포르투갈어, 이탈리아어, 스페인어, 독일어, 프랑스어, 러시아어를 포함합니다.

Huggingface: https://huggingface.co/BAAI/AltDiffusion-m18

GitHub: https://github.com/FlagAI-Open/FlagAI/blob/master/examples/AltDiffusion-m18

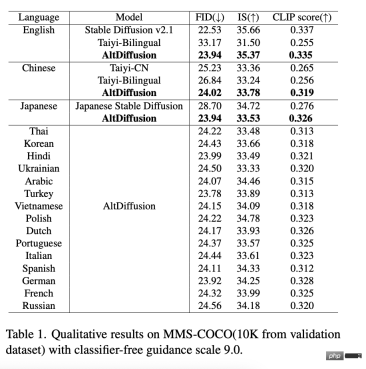

AltDiffusion-m18 영어 FID, IS, CLIP 점수의 객관적인 평가는 Stable Diffusion 95~99% 효과에 도달하여 중국어와 일본어에서 최적 수준에 도달하는 동시에 텍스트 및 이미지 생성 모델의 공백을 메웠습니다. 나머지 15개 언어는 다국어 텍스트 및 그래픽 생성에 대한 업계 수요가 매우 높습니다. 본 연구에 조언을 제공해주신 안정확산연구팀에 특별히 감사드립니다.

또한 AltDiffusion-m18 관련 혁신 기술 보고서 "AltCLIP: 확장된 언어 기능을 위한 CLIP의 언어 인코더 변경"이 ACL 2023의 결과에 채택되었습니다.

기술 하이라이트

1 새로운 AltCLIP, 다국어 T2I 모델의 효율적이고 저렴한 구축

지난해 출시된 AltDiffusion-m9에서 Zhiyuan 팀은 Stable Diffusion v1을 기반으로 언어 타워를 혁신적으로 교체했습니다. 4 다국어 타워용 AltCLIP과 9개 언어의 다국어 데이터로 미세 조정되어 원래 영어 전용 Stable Diffusion을 확장하여 9개 언어를 지원합니다.

AltCLIP: https://github.com/FlagAI-Open/FlagAI/tree/master/examples/AltCLIP-m18

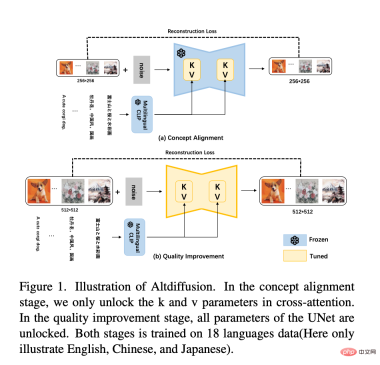

그리고 AltDiffusion-m18은 Stable Diffusion v2.1을 기반으로 훈련되었습니다. Stable Diffusion v2.1의 새로운 언어 타워는 OpenCLIP의 반전된 두 번째 레이어입니다. 따라서 새로운 AltCLIP은 OpenCLIP의 반전된 두 번째 레이어를 증류 대상으로 사용하여 m9를 기반으로 CrossAttention 레이어 K만 사용합니다. Unet의 V 행렬은 아래 그림과 같이 2단계 학습 방법으로 확장됩니다.

- 1단계: m9 실험 초기에 미세 조정이 발견되었습니다. K 및 V 행렬은 주로 텍스트와 이미지의 개념 정렬을 학습합니다. 따라서 m18 학습의 첫 번째 단계에서는 계속해서 18개 언어의 데이터를 사용하여 K 및 V 행렬을 미세 조정합니다. 또한, 이미지의 해상도를 512*512에서 256*256으로 줄여도 이미지의 의미 정보가 손실되지 않는다는 것이 실험을 통해 입증되었습니다. 따라서 텍스트-이미지 개념 정렬 학습의 첫 번째 단계에서는 256*256의 해상도를 훈련에 사용하므로 훈련 속도가 빨라진다.

- 두 번째 단계: 생성된 이미지의 품질을 더욱 향상시키기 위해 512*512의 해상도를 사용하여 18개 언어의 데이터에서 Unet의 전체 매개변수를 학습합니다. 또한, 분류자 없는 지침 추론을 제공하기 위한 무조건 훈련을 위해 텍스트의 10%가 삭제됩니다.

- 또한 생성 품질을 더욱 향상시키기 위해 분류자가 없는 안내 학습 기술이 채택되었습니다.

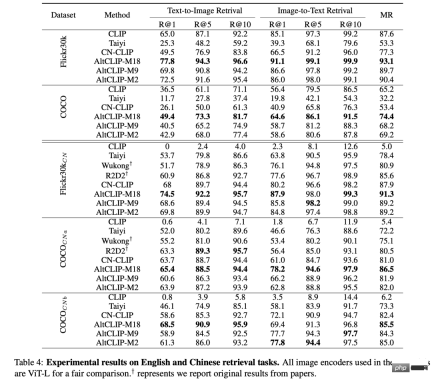

최신 평가 결과 AltCLIP-m18은 CLIP을 능가하며 중국어 및 영어 제로샷(제로 샘플) 검색 작업에서 최적 수준에 도달한 것으로 나타났습니다. ⬇️

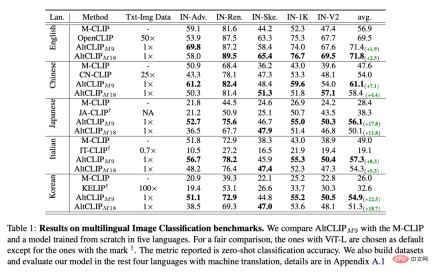

다국어 이미지 분류 벤치마크에서 AltCLIP-m9(초기) 버전, 9개 언어 지원)은 AltCLIP-m18을 사용하여 최적의 수준에 도달합니다. ⬇️

마찬가지로 AltCLIP의 혁신적인 타워 변경 아이디어 덕분에 AltDiffusion-m18은 원래 CLIP 모델 및 생태학적 도구를 기반으로 구축된 Stable Diffusion에 원활하게 액세스할 수도 있습니다. , Stable Diffusion WebUI, DreamBooth 등 Stable Diffusion을 지원하는 모든 도구를 AltDiffusion-m18에 적용할 수 있습니다. 시작하기가 쉽고 뛰어난 플레이 가능성을 제공합니다!

2 뛰어난 성능과 정확한 디테일로 다국어 생성 효과가 정렬됩니다.

새로운 AltCLIP의 축복으로 AltDiffusion-m18은 영어 FID, IS, CLIP 점수 평가에서 원래의 Stable Diffusion 효과의 95~99%를 달성했으며 중국어, 일본어를 포함한 17개 언어에서 가장 앞선 성능을 달성했습니다. 자세한 데이터는 다음 표에 나와 있습니다.

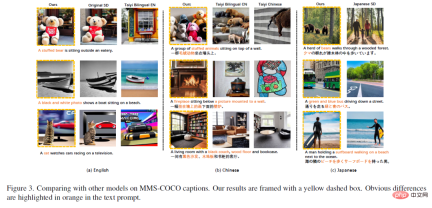

영어, 중국어, 일본어에서 AltDiffusion-m18은 다른 모델 생성 결과보다 우수한 결과와 더 정확한 세부 정보를 제공합니다.

위 그림 (a) 중국어 AltDiffusion-m18은 원본 Stable Diffusion과 매우 일치하는 결과를 생성할 수 있으며 "곰 인형", "흑백 사진", "고양이" 등 신속한 이해에서 다른 국내 중국어-영어 이중 언어 모델보다 우수합니다. " 등 국내 타 한-영 이중언어 모델에서는 생성되지 않는 개념을 AltDiffusion에서는 성공적으로 생성할 수 있습니다. 중국어와 일본어에서도 동일한 현상이 발생합니다.

위 (b)의 "검은색 소파, 나무 바닥"은 AltDiffusion-m18에 의해서만 올바르게 생성됩니다.

위 (c)의 "bears"는 Japanese Stable Diffusion이 "human"을 잘못 생성하지만 AltDiffusion-m18은 "bear"를 올바르게 생성할 수 있습니다.

또한 Zhiyuan FlagEval 팀은 텍스트 및 이미지 생성 모델 평가 도구인 ImageEval을 개발했습니다. 평가 후 AltDiffusion-m18의 엔터티 객체 및 엔터티 수량 차원의 정확도는 국내 피어 모델의 정확도를 각각 11% 및 10% 초과합니다. (참고: ImageEval 평가 방법 및 결과는 가까운 시일 내에 공개될 예정이므로 조정).

3 다국어 텍스트 및 그림 생성 모델을 위한 참조 시스템을 제공하는 작은 언어 텍스트 및 그림의 구세주

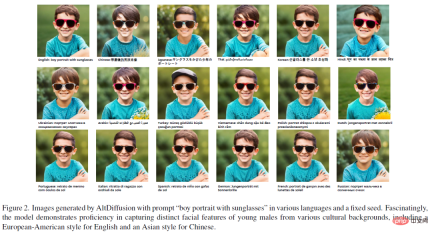

AltDiffusion-m18은 다국어 데이터에서 다양한 언어의 편견을 학습하여 사용자가 언어 번역 문턱을 넘을 수 있도록 돕습니다. 문화 번역을 우회하여 언어 뒤에 있는 문화적 정보의 손실을 줄입니다. 아래 그림에서 볼 수 있듯이 중국어와 일본어 프롬프트로 생성된 어린 소년의 얼굴 윤곽은 '아시아 스타일'에 더 가깝고, 영어와 기타 유럽 언어 프롬프트로 생성된 어린 소년은 '유럽과 미국 스타일'에 가깝습니다.

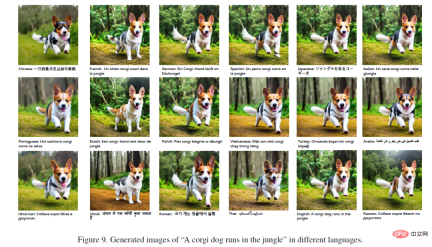

더 흥미로운 점은 다양한 언어로 동물 프롬프트에 의해 생성된 그림의 세부 사항도 다르다는 것입니다. 아래 그림에서 볼 수 있듯이, 서로 다른 언어로 생성된 사진은 전체적으로 일관성이 높지만, 사진의 배경이나 코기의 얼굴 특징의 디테일에는 미묘한 차이가 있습니다.

일반적으로 AltDiffusion-m18은 다국어 텍스트 및 이미지 생성 모델에 대한 기본 참조 프레임을 제공합니다. 스페인어, 독일어, 프랑스어가 모국어인 사용자는 마음속 프롬프트를 영어로 번역하지 않고도 AIGC의 재미를 즐길 수 있습니다. AI 교육 전문가는 DreamBooth, ControlNet 및 LoRA를 결합하여 AltDiffusion-m18을 기반으로 더욱 최적화하거나 다른 언어로 코퍼스 미세 조정을 사용하여 더 나은 텍스트 및 이미지 생성 효과를 얻을 수도 있습니다.

동시에 대규모 모델 알고리즘, 모델 및 도구를 위한 원스톱 오픈 소스 프로젝트인 FlagAI(github.com/FlagAI-Open/FlagAI)에서는 추론 훈련을 위한 도구와 API도 제공하여 누구나 쉽게 사용할 수 있습니다. AltDiffusion-m18을 빠르게 다운로드하여 사용하세요.

위 내용은 다국어 텍스트 및 이미지 생성을 위한 다목적 도구인 AltDiffusion-m18의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

신속한 엔지니어링에서 생각의 그래프는 무엇입니까?Apr 13, 2025 am 11:53 AM

신속한 엔지니어링에서 생각의 그래프는 무엇입니까?Apr 13, 2025 am 11:53 AM소개 신속한 엔지니어링에서 "Thought of Thought"는 그래프 이론을 사용하여 AI의 추론 과정을 구성하고 안내하는 새로운 접근법을 나타냅니다. 종종 선형 S와 관련된 전통적인 방법과 달리

Genai 에이전트와 함께 조직의 이메일 마케팅을 최적화하십시오Apr 13, 2025 am 11:44 AM

Genai 에이전트와 함께 조직의 이메일 마케팅을 최적화하십시오Apr 13, 2025 am 11:44 AM소개 축하해요! 당신은 성공적인 사업을 운영합니다. 웹 페이지, 소셜 미디어 캠페인, 웹 세미나, 컨퍼런스, 무료 리소스 및 기타 소스를 통해 매일 5000 개의 이메일 ID를 수집합니다. 다음 명백한 단계는입니다

Apache Pinot을 사용한 실시간 앱 성능 모니터링Apr 13, 2025 am 11:40 AM

Apache Pinot을 사용한 실시간 앱 성능 모니터링Apr 13, 2025 am 11:40 AM소개 오늘날의 빠르게 진행되는 소프트웨어 개발 환경에서 최적의 애플리케이션 성능이 중요합니다. 응답 시간, 오류율 및 자원 활용과 같은 실시간 메트릭 모니터링 메인이 도움이 될 수 있습니다.

Chatgpt가 10 억 명의 사용자를 쳤습니까? Openai CEO는'몇 주 만에 두 배가되었습니다Apr 13, 2025 am 11:23 AM

Chatgpt가 10 억 명의 사용자를 쳤습니까? Openai CEO는'몇 주 만에 두 배가되었습니다Apr 13, 2025 am 11:23 AM"얼마나 많은 사용자가 있습니까?" 그는 자극했다. Altman은“마지막으로 우리가 마지막으로 말한 것은 매주 5 억 명의 행위자이며 매우 빠르게 성장하고 있다고 생각합니다. 앤더슨은 계속해서“당신은 나에게 몇 주 만에 두 배가되었다고 말했습니다. “저는 그 개인이라고 말했습니다

Pixtral -12B : Mistral AI의 첫 번째 멀티 모드 모델 -Anuctics VidhyaApr 13, 2025 am 11:20 AM

Pixtral -12B : Mistral AI의 첫 번째 멀티 모드 모델 -Anuctics VidhyaApr 13, 2025 am 11:20 AM소개 Mistral은 최초의 멀티 모드 모델, 즉 Pixtral-12B-2409를 발표했습니다. 이 모델은 Mistral의 120 억 개의 매개 변수 인 NEMO 12B를 기반으로합니다. 이 모델을 차별화하는 것은 무엇입니까? 이제 이미지와 Tex를 모두 가져갈 수 있습니다

생성 AI 응용 프로그램을위한 에이전트 프레임 워크 - 분석 VidhyaApr 13, 2025 am 11:13 AM

생성 AI 응용 프로그램을위한 에이전트 프레임 워크 - 분석 VidhyaApr 13, 2025 am 11:13 AM쿼리에 응답 할뿐만 아니라 자율적으로 정보를 모으고, 작업을 실행하며, 여러 유형의 데이터 (텍스트, 이미지 및 코드를 처리하는 AI 구동 조수가 있다고 상상해보십시오. 미래처럼 들리나요? 이것에서

금융 부문에서 생성 AI의 응용Apr 13, 2025 am 11:12 AM

금융 부문에서 생성 AI의 응용Apr 13, 2025 am 11:12 AM소개 금융 산업은 효율적인 거래 및 신용 가용성을 촉진함으로써 경제 성장을 주도하기 때문에 모든 국가 개발의 초석입니다. 거래가 발생하는 용이성 및 신용

온라인 학습 및 수동 공격 알고리즘 안내Apr 13, 2025 am 11:09 AM

온라인 학습 및 수동 공격 알고리즘 안내Apr 13, 2025 am 11:09 AM소개 소셜 미디어, 금융 거래 및 전자 상거래 플랫폼과 같은 소스에서 전례없는 속도로 데이터가 생성되고 있습니다. 이 지속적인 정보 스트림을 처리하는 것은 어려운 일이지만

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

드림위버 CS6

시각적 웹 개발 도구

맨티스BT

Mantis는 제품 결함 추적을 돕기 위해 설계된 배포하기 쉬운 웹 기반 결함 추적 도구입니다. PHP, MySQL 및 웹 서버가 필요합니다. 데모 및 호스팅 서비스를 확인해 보세요.

DVWA

DVWA(Damn Vulnerable Web App)는 매우 취약한 PHP/MySQL 웹 애플리케이션입니다. 주요 목표는 보안 전문가가 법적 환경에서 자신의 기술과 도구를 테스트하고, 웹 개발자가 웹 응용 프로그램 보안 프로세스를 더 잘 이해할 수 있도록 돕고, 교사/학생이 교실 환경 웹 응용 프로그램에서 가르치고 배울 수 있도록 돕는 것입니다. 보안. DVWA의 목표는 다양한 난이도의 간단하고 간단한 인터페이스를 통해 가장 일반적인 웹 취약점 중 일부를 연습하는 것입니다. 이 소프트웨어는

MinGW - Windows용 미니멀리스트 GNU

이 프로젝트는 osdn.net/projects/mingw로 마이그레이션되는 중입니다. 계속해서 그곳에서 우리를 팔로우할 수 있습니다. MinGW: GCC(GNU Compiler Collection)의 기본 Windows 포트로, 기본 Windows 애플리케이션을 구축하기 위한 무료 배포 가능 가져오기 라이브러리 및 헤더 파일로 C99 기능을 지원하는 MSVC 런타임에 대한 확장이 포함되어 있습니다. 모든 MinGW 소프트웨어는 64비트 Windows 플랫폼에서 실행될 수 있습니다.

SecList

SecLists는 최고의 보안 테스터의 동반자입니다. 보안 평가 시 자주 사용되는 다양한 유형의 목록을 한 곳에 모아 놓은 것입니다. SecLists는 보안 테스터에게 필요할 수 있는 모든 목록을 편리하게 제공하여 보안 테스트를 더욱 효율적이고 생산적으로 만드는 데 도움이 됩니다. 목록 유형에는 사용자 이름, 비밀번호, URL, 퍼징 페이로드, 민감한 데이터 패턴, 웹 셸 등이 포함됩니다. 테스터는 이 저장소를 새로운 테스트 시스템으로 간단히 가져올 수 있으며 필요한 모든 유형의 목록에 액세스할 수 있습니다.