매개 변수는 절반으로 줄어들고 CLIP만큼 좋습니다. 시각적 변환기는 픽셀에서 시작하는 이미지와 텍스트의 통일을 실현합니다.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB앞으로

- 2023-05-05 20:43:051647검색

최근에는 Transformer를 기반으로 한 대규모 멀티모달 훈련을 통해 시각, 언어, 오디오 등 다양한 분야에서 최첨단 기술의 발전이 이루어졌습니다. 특히 컴퓨터 비전 및 이미지 언어 이해에서는 사전 훈련된 단일 대형 모델이 특정 작업에 대해 전문가 모델보다 성능이 뛰어날 수 있습니다.

그러나 대규모 다중 모드 모델은 양식 또는 데이터 세트별 인코더 및 디코더를 사용하는 경우가 많으며 이에 따라 프로토콜이 포함됩니다. 예를 들어, 이러한 모델에는 데이터세트별 전처리를 사용하거나 작업별 방식으로 다른 부분을 전송하는 등 해당 데이터세트에서 모델의 여러 부분을 훈련하는 여러 단계가 포함되는 경우가 많습니다. 이러한 패턴과 작업별 구성 요소는 새로운 사전 훈련 손실이나 다운스트림 작업을 도입할 때 추가적인 엔지니어링 복잡성과 과제를 초래할 수 있습니다.

따라서 모든 양식 또는 양식의 조합을 처리할 수 있는 단일 엔드 투 엔드 모델을 개발하는 것은 다중 모드 학습을 향한 중요한 단계가 될 것입니다. 이번 글에서는 구글리서치(구글브레인팀)와 취리히 연구진이 주로 이미지와 텍스트에 집중할 예정이다.

문서 주소: https://arxiv.org/pdf/2212.08045.pdf

많은 주요 통합이 다중 모드 학습 프로세스를 가속화합니다. 첫째, Transformer 아키텍처가 일반 백본 역할을 할 수 있고 텍스트, 시각 자료, 오디오 및 기타 영역에서 우수한 성능을 발휘할 수 있다는 것이 입증되었습니다. 둘째, 많은 논문에서는 입력/출력 인터페이스를 단순화하거나 여러 작업을 위한 단일 인터페이스를 개발하기 위해 다양한 양식을 단일 공유 임베딩 공간에 매핑하는 방법을 탐구합니다. 셋째, 양식의 대안적 표현을 통해 한 영역의 신경 구조 또는 다른 영역에서 설계된 훈련 절차를 활용할 수 있습니다. 예를 들어 [54]와 [26,48]은 각각 텍스트와 오디오를 나타내며 이러한 형식을 이미지(오디오의 경우 스펙트로그램)로 렌더링하여 처리됩니다.

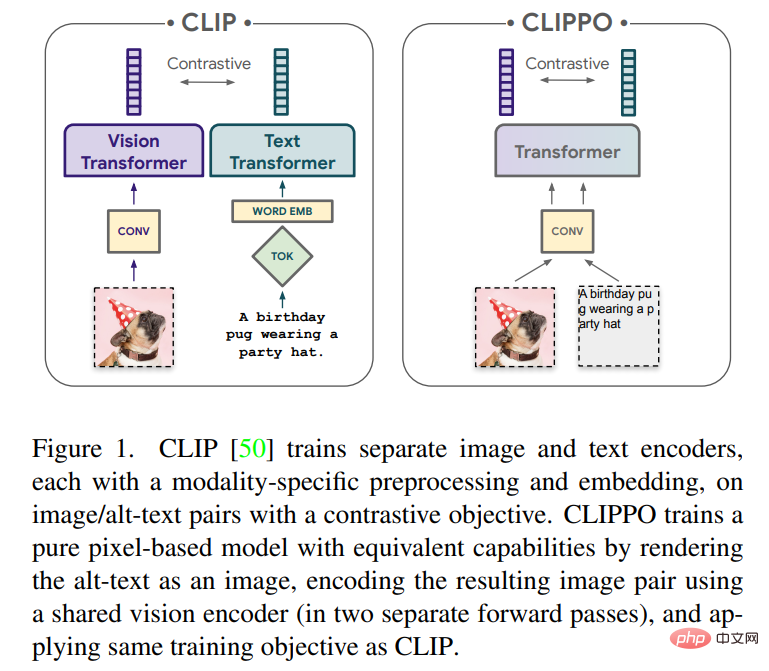

이 기사에서는 순수 픽셀 기반 모델을 사용하여 텍스트와 이미지의 다중 모드 학습을 살펴봅니다. 모델은 시각적 입력이나 텍스트 또는 둘 다를 모두 RGB 이미지로 렌더링하는 별도의 시각적 변환기입니다. 모든 양식은 하위 수준 기능 처리를 포함하여 동일한 모델 매개변수를 사용합니다. 즉, 양식별 초기 컨볼루션, 토큰화 알고리즘 또는 입력 임베딩 테이블이 없습니다. 모델은 CLIP 및 ALIGN으로 대중화된 대조 학습이라는 단 하나의 작업으로만 학습됩니다. 따라서 이 모델을 CLIP-Pixels Only(CLIPPO)라고 합니다.

CLIPPO는 이미지 분류 및 텍스트/이미지 검색을 위해 설계된 주요 작업에서 특정 타워 양식이 없음에도 불구하고 CLIP과 유사하게 수행합니다(1-2% 유사성 이내). 놀랍게도 CLIPPO는 왼쪽에서 오른쪽으로의 언어 모델링, 마스크된 언어 모델링 또는 명시적인 단어 수준 손실 없이 복잡한 언어 이해 작업을 수행할 수 있습니다. 특히 GLUE 벤치마크에서 CLIPPO는 ELMO+BiLSTM+attention과 같은 기존 NLP 기준보다 성능이 뛰어납니다. 또한 CLIPPO는 픽셀 기반 마스크 언어 모델보다 성능이 뛰어나 BERT 점수에 접근합니다.

흥미롭게도 CLIPPO는 그러한 데이터에 대해 사전 학습된 적이 없음에도 불구하고 단순히 이미지와 텍스트를 함께 렌더링할 때 VQA에서 좋은 성능을 달성합니다. 기존 언어 모델과 비교하여 픽셀 기반 모델의 즉각적인 이점은 미리 결정된 어휘가 필요하지 않다는 것입니다. 결과적으로, 클래식 토크나이저를 사용하는 동급 모델에 비해 다국어 검색 성능이 향상되었습니다. 마지막으로, 연구에서는 CLIPPO를 훈련할 때 이전에 관찰된 모달 간격이 감소한 경우도 있음을 발견했습니다.

방법 개요

CLIP은 데이터 세트에서 다목적 비전 모델을 훈련하기 위한 강력하고 확장 가능한 패러다임으로 부상했습니다. 특히 이 접근 방식은 웹에서 대규모로 자동 수집할 수 있는 이미지/대체 텍스트 쌍을 사용합니다. 결과적으로 텍스트 설명은 종종 혼란스럽고 단일 키워드, 키워드 세트 또는 잠재적으로 긴 설명으로 구성될 수 있습니다. 이 데이터를 사용하여 두 개의 인코더, 즉 대체 텍스트를 포함하는 텍스트 인코더와 공유 잠재 공간에 해당 이미지를 포함하는 이미지 인코더가 공동으로 훈련됩니다. 두 인코더는 해당 이미지와 대체 텍스트의 임베딩이 유사하면서도 다른 모든 이미지 및 대체 텍스트의 임베딩과는 다르지 않도록 하는 대조 손실을 사용하여 학습됩니다.

학습된 인코더 쌍은 여러 가지 방법으로 사용될 수 있습니다. 텍스트 설명으로 고정된 시각적 개념 세트를 분류할 수 있습니다(제로샷 분류). 임베딩을 사용하여 텍스트 설명이 있는 이미지를 검색할 수 있으며 그 반대의 경우도 마찬가지입니다. 그러나 대안적으로 시각적 인코더는 레이블이 지정된 데이터 세트를 미세 조정하거나 고정된 이미지 인코더 표현에 대해 머리를 교육하여 감독 방식으로 다운스트림 작업으로 전송될 수 있습니다. 원칙적으로는 텍스트 인코더를 독립적인 텍스트 임베딩으로 사용할 수 있지만, 이 애플리케이션에 대한 심층적인 연구는 아무도 수행하지 않은 것으로 보고되었으며, 일부 연구에서는 품질이 낮은 대체 텍스트를 인용하여 언어 모델링 성능이 취약했습니다. 텍스트 인코더.

이전 작업에서는 공유 변환기 모델(단일 타워 모델 또는 1T-CLIP이라고도 함)을 사용하여 이미지 및 텍스트 인코더를 구현할 수 있음을 보여주었습니다. 여기서 이미지는 패치 삽입을 사용하여 삽입되고 토큰화된 텍스트는 별도의 사용으로 삽입됩니다. 단어 삽입 . 양식별 임베딩을 제외하고 모든 모델 매개변수는 두 양식 간에 공유됩니다. 이러한 유형의 공유는 일반적으로 이미지/이미지-언어 작업의 성능 저하를 초래하지만 모델 매개변수 수도 절반으로 줄입니다.

CLIPPO는 이 아이디어를 한 단계 더 발전시켰습니다. 즉, 텍스트 입력이 빈 이미지에 렌더링된 다음 초기 패치 삽입을 포함하여 완전히 이미지로 처리됩니다(그림 1 참조). 이전 작업과의 비교 훈련을 통해 단일 시각적 인터페이스를 통해 이미지와 텍스트를 이해할 수 있는 단일 시각적 변환기 모델을 생성하고, 이미지, 이미지 언어 및 순수 언어 이해 문제를 해결하는 데 사용할 수 있는 솔루션을 제공합니다.

CLIPPO는 다중 모달 다양성 외에도 텍스트 처리, 즉 적절한 토크나이저 및 어휘 개발의 일반적인 어려움을 완화합니다. 이는 텍스트 인코더가 수십 개의 언어를 처리해야 하는 대규모 다국어 설정의 맥락에서 특히 흥미롭습니다.

이미지/대체 텍스트 쌍에 대해 훈련된 CLIPPO는 공개 이미지 및 이미지 언어 벤치마크에서 1T-CLIP과 동등한 성능을 발휘하고 GLUE 벤치마크에서 강력한 기본 언어 모델과 경쟁하는 것을 확인할 수 있습니다. 그러나 대체 텍스트는 품질이 낮고 일반적으로 문법적 문장이 아니기 때문에 대체 텍스트만으로는 언어 이해를 학습하는 것이 근본적으로 제한됩니다. 따라서 언어 기반 대비 훈련을 이미지/대체 텍스트 대비 사전 훈련에 추가할 수 있습니다. 구체적으로, 텍스트 코퍼스에서 샘플링된 연속 문장 쌍, 다른 언어로 번역된 문장 쌍, 번역 후 문장 쌍, 누락된 단어가 있는 문장 쌍을 고려해야 합니다.

실험 결과

시각적 및 시각적 언어 이해

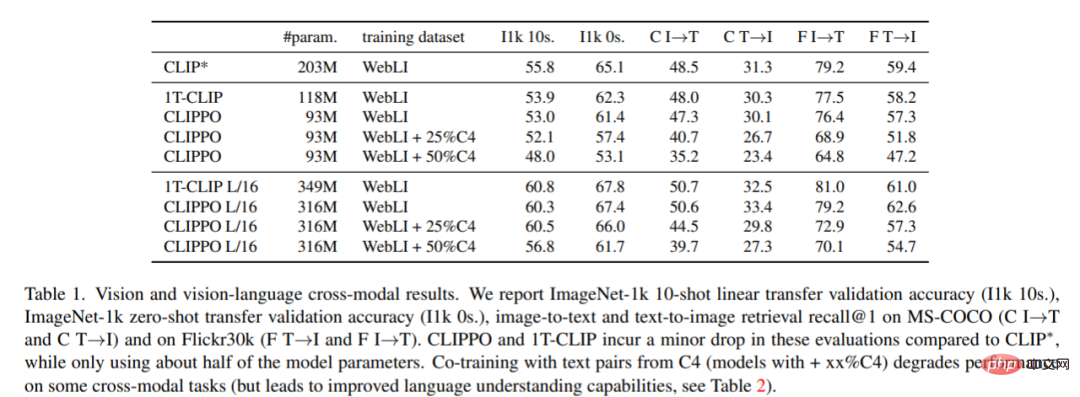

이미지 분류 및 검색. 표 1은 CLIPPO의 성능을 보여주며, CLIPPO와 1T-CLIP이 CLIP* 대비 2~3%포인트 절대적인 감소를 보이는 것을 알 수 있다.

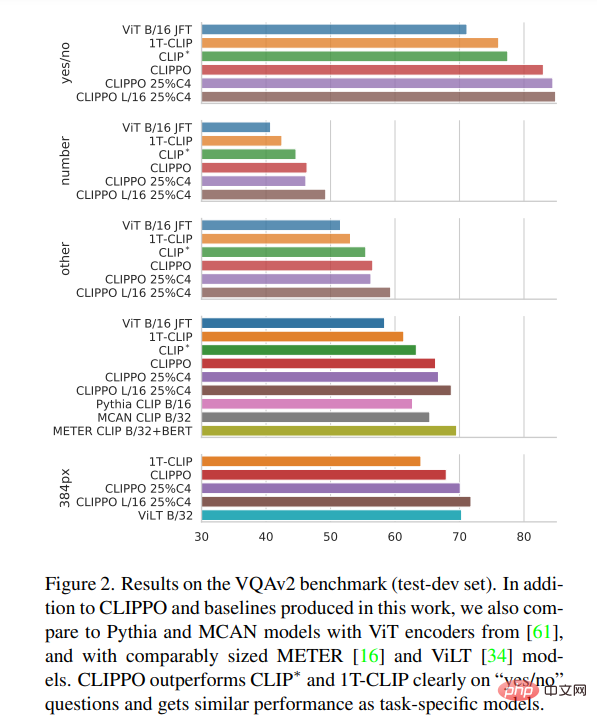

VQA. 모델과 기준선의 VQAv2 점수는 그림 2에 보고되어 있습니다. CLIPPO는 CLIP*, 1T-CLIP 및 ViT-B/16보다 성능이 뛰어나 66.3점을 획득한 것을 볼 수 있습니다.

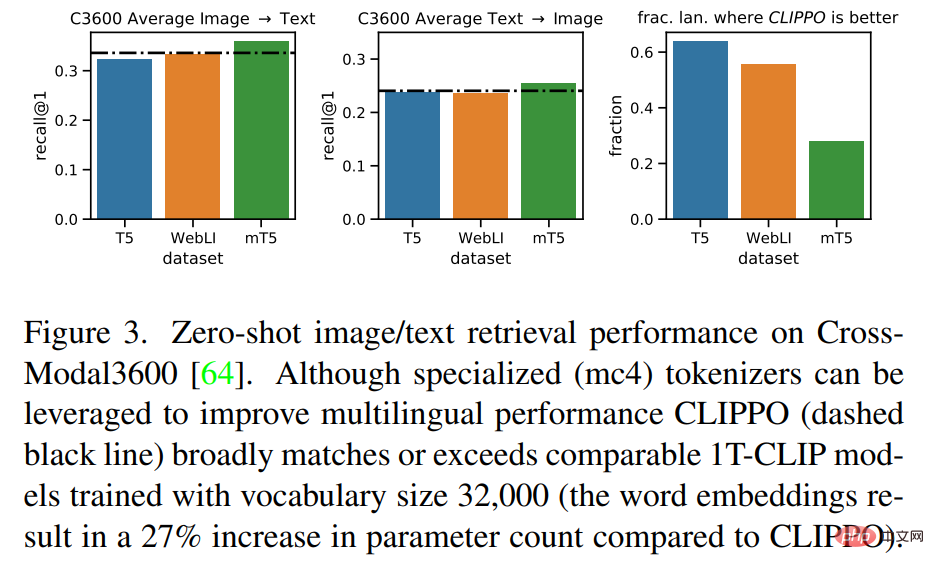

다국어 비전 - 언어 이해

그림 3은 CLIPPO가 이러한 기준에 필적하는 검색 성능을 달성한다는 것을 보여줍니다. mT5의 경우 추가 데이터를 사용하면 성능이 향상될 수 있습니다. 이러한 추가 매개변수와 데이터를 다국어 컨텍스트에서 활용하는 것은 CLIPPO의 흥미로운 미래 방향이 될 것입니다.

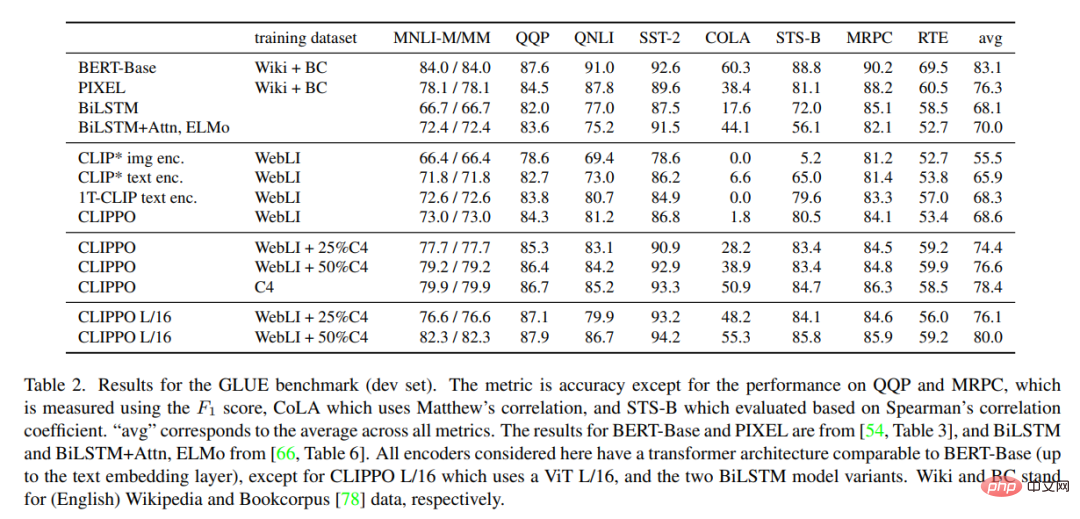

언어 이해

표 2는 CLIPPO에 대한 GLUE 벤치마크 결과와 기준선을 보여줍니다. WebLI에서 훈련된 CLIPPO는 대규모 언어 코퍼스에서 훈련된 깊은 단어 임베딩이 있는 BiLSTM+Attn+ELMo 기준과 경쟁적이라는 것을 관찰할 수 있습니다. 또한 CLIPPO 및 1T-CLIP은 표준 대조 언어 비전 사전 훈련을 사용하여 훈련된 언어 인코더보다 성능이 우수하다는 것을 알 수 있습니다.

자세한 연구 내용은 원문을 참고해주세요.

위 내용은 매개 변수는 절반으로 줄어들고 CLIP만큼 좋습니다. 시각적 변환기는 픽셀에서 시작하는 이미지와 텍스트의 통일을 실현합니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!