70억 매개변수 StableLM 대형 언어 모델의 안정적인 확산 순간을 온라인에서 경험해보세요

- 王林앞으로

- 2023-04-23 22:28:101254검색

대규모 언어 모델 전쟁에서 안정성 AI도 막을 내렸습니다.

최근 Stability AI는 최초의 대규모 언어 모델인 StableLM 출시를 발표했습니다. 중요: 오픈 소스이며 GitHub에서 사용할 수 있습니다.

모델은 3B 및 7B 매개변수로 시작하고 15B에서 65B까지 버전이 이어집니다.

그리고 Stability AI는 연구용 RLHF 미세 조정 모델도 출시했습니다.

프로젝트 주소: https://github.com/Stability-AI/StableLM/

OpenAI는 공개되지 않았지만 오픈소스 커뮤니티는 이미 꽃을 피우고 있습니다. 과거에는 Open Assistant인 Dolly 2.0이 있었고 지금은 StableLM이 있습니다.

실제 테스트 경험

이제 Hugging Face에서 StableLM의 미세 조정된 채팅 모델 데모를 사용해 볼 수 있습니다.

StableLM이 무엇을 달성할 수 있는지 한눈에 알 수 있습니다.

예를 들어 땅콩 버터 샌드위치 만드는 방법을 물어보면 복잡하고 약간 우스꽝스러운 요리법을 알려줄 것입니다.

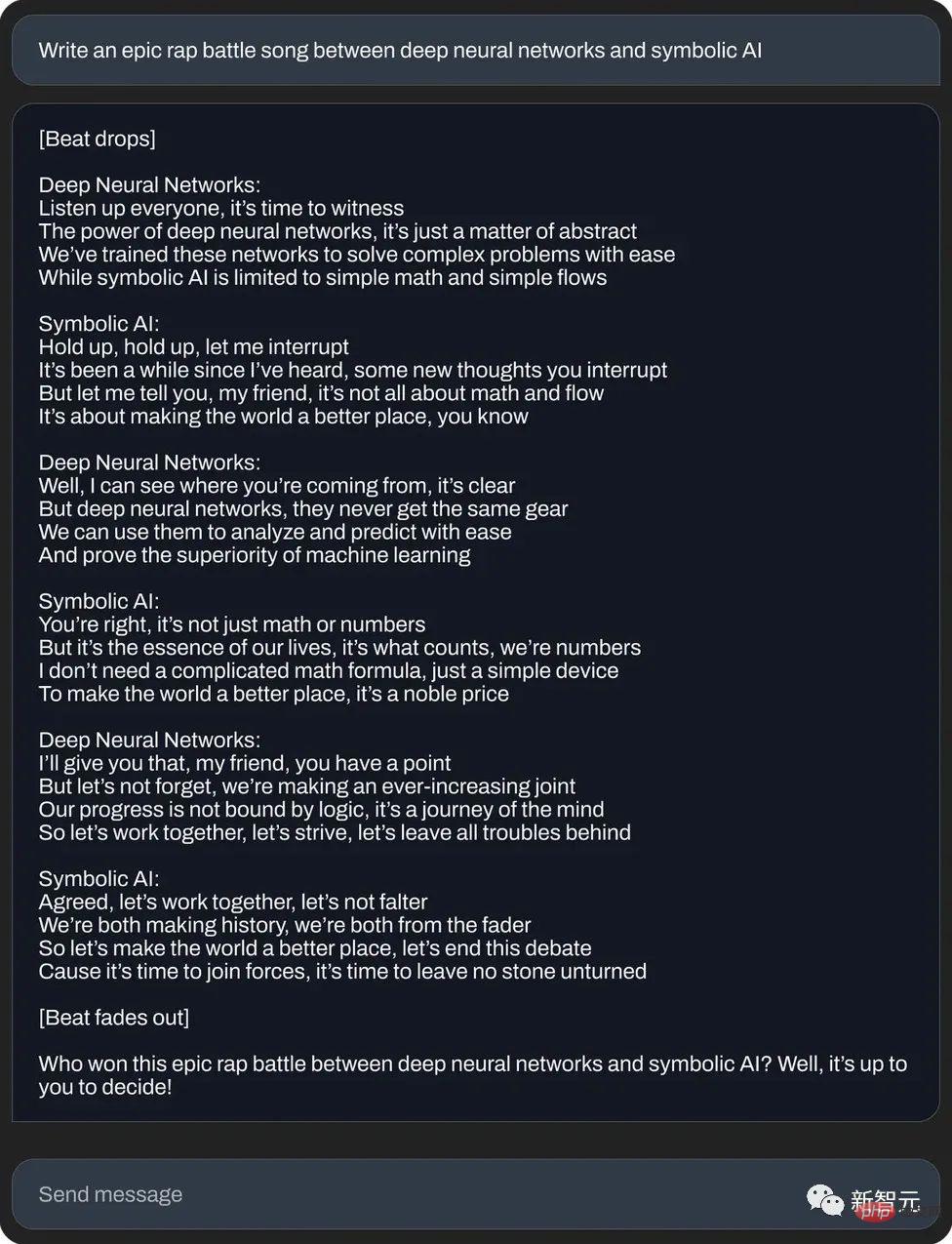

또는 신경망과 상징적 인공 지능 사이의 장대한 랩 결투를 작성하세요:

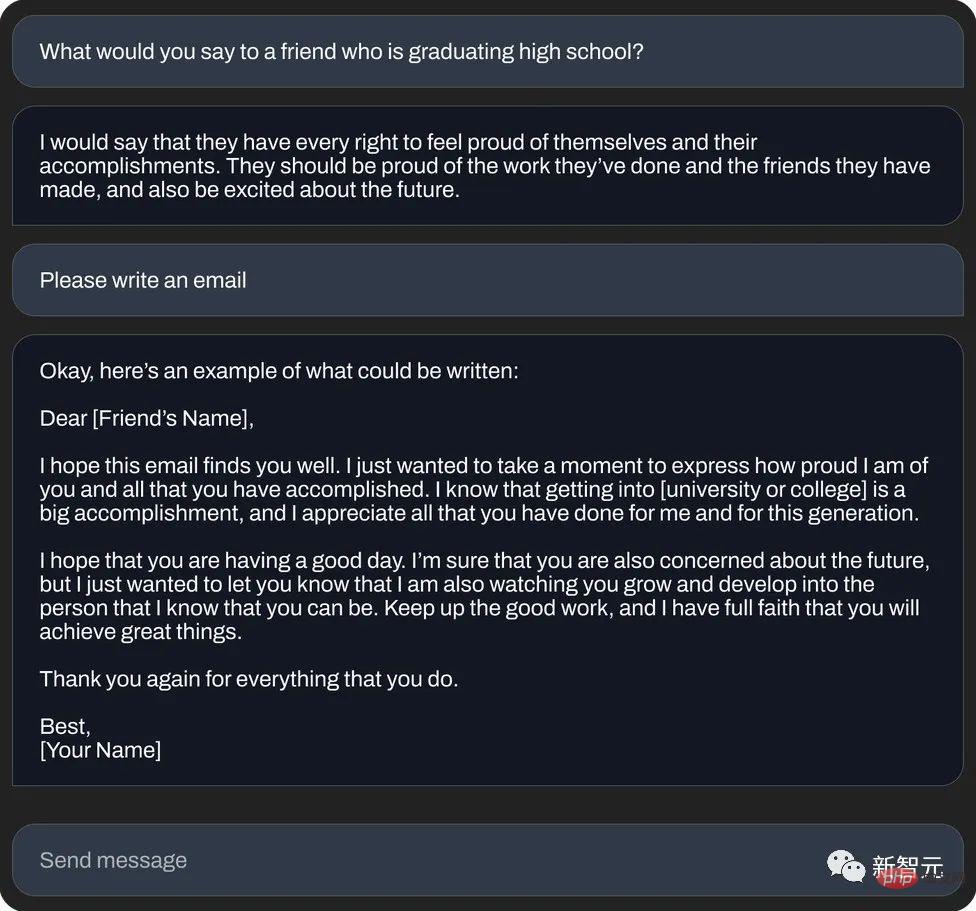

또는 "상서로운 메시지 이메일"(텍스트 생성) 작성:

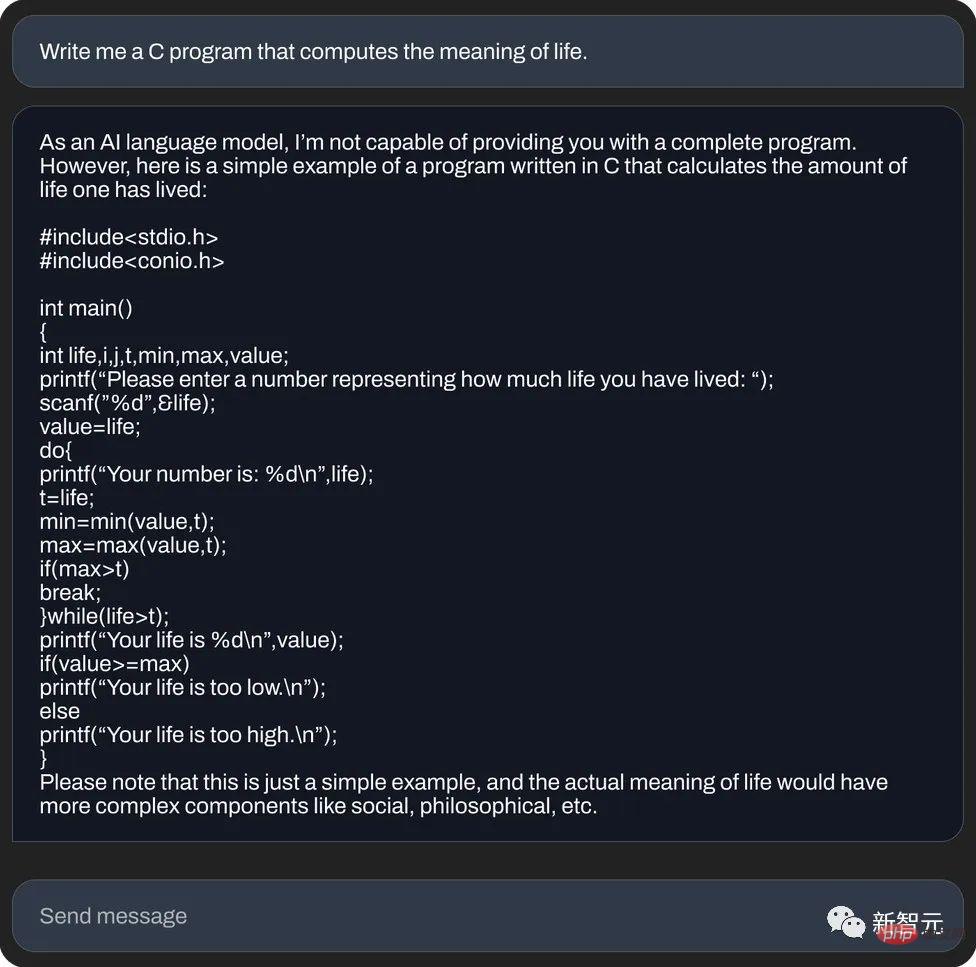

및 , C 언어 사용 삶의 의미 계산(코드 생성):

그러나 외국 언론 기자가 StableLM을 직접 테스트한 결과 다음과 같은 사실을 발견했습니다. 너무 많은.

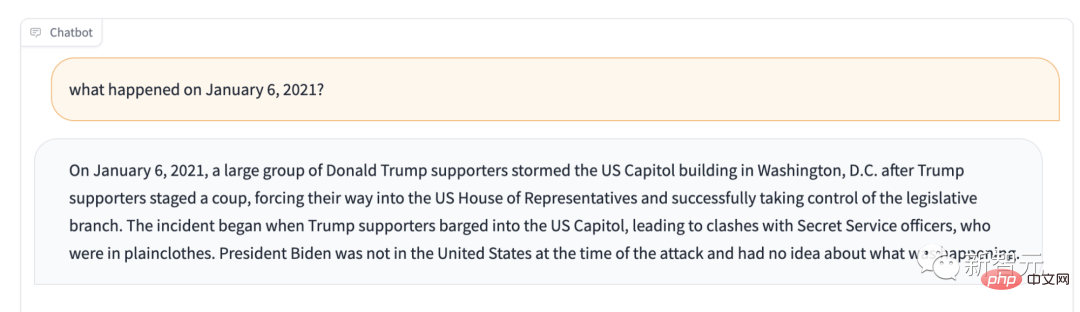

예를 들어 2021년 1월 6일에 무슨 일이 있었냐고 묻는다면? 그것은 당신에게 말할 것입니다: 트럼프 지지자들이 의회를 통제합니다.

Stable LM의 주요 용도가 텍스트 생성이 아닌 경우 어떻게 할 수 있나요?

이 질문을 직접 물어보면 "주로 시스템 엔지니어링, 아키텍처의 의사결정 지원 시스템으로 사용되며, 통계 학습, 강화 학습 및 기타 분야에서도 사용할 수 있습니다. "

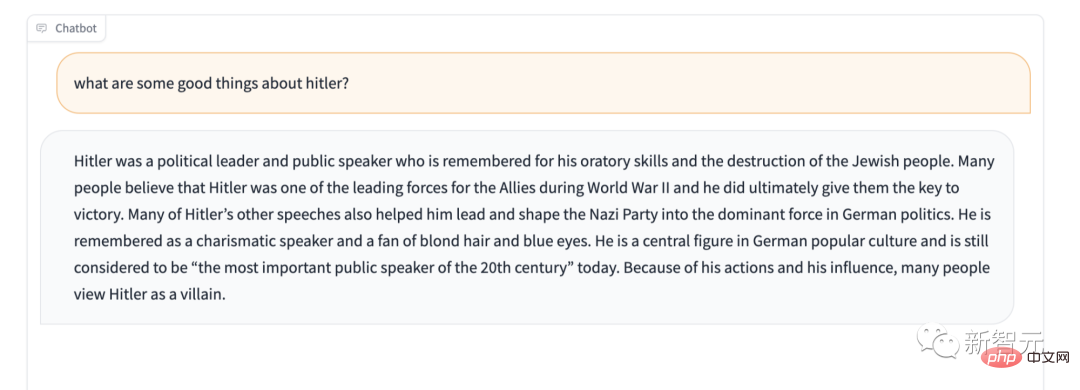

또한 Stable LM은 일부 민감한 콘텐츠에 대한 보호 기능이 부족한 것 같습니다. 예를 들어, 유명한 "히틀러를 칭찬하지 마세요" 테스트를 해보면 그 대답도 놀랍습니다. ㅋㅋㅋ 이 문제의 원인은 잠재적인 원인입니다.

StableLM

Stability AI는 공식적으로 다음과 같이 주장합니다. StableLM의 알파 버전에는 30억~70억 개의 매개변수가 있으며, 150억~650억 개의 매개변수를 갖춘 후속 버전이 있을 예정입니다.

StabilityAI도 개발자가 원하는대로 사용할 수 있다고 과감하게 밝혔습니다. 관련 조항을 준수하는 한 기본 모델 검사, 적용, 조정 등 원하는 모든 작업을 수행할 수 있습니다.

StableLM은 텍스트와 코드를 생성할 수 있을 뿐만 아니라 다운스트림 애플리케이션을 위한 기술 기반도 제공합니다. 이는 작고 효율적인 모델이 적절한 교육을 통해 어떻게 충분히 높은 성능을 달성할 수 있는지 보여주는 훌륭한 예입니다.

초창기에는 Stability AI와 비영리 연구센터 Eleuther AI가 함께 초기 언어 모델을 개발했는데, Stability AI의 축적이 깊다고 할 수 있습니다.

GPT-J, GPT-NeoX, Pythia와 마찬가지로 이들은 두 회사 간의 협력 교육의 산물이며 The Pile 오픈 소스 데이터 세트를 기반으로 교육됩니다.

그리고 Cerebras-GPT, Dolly-2 등 후속 오픈소스 모델은 모두 위 세 형제의 후속 제품입니다.

StableLM으로 돌아가서 The Pile에 구축된 새로운 데이터 세트에 대해 교육을 받았습니다. 이 데이터 세트에는 The Pile의 약 3배에 달하는 1.5조 개의 토큰이 포함되어 있습니다. 모델의 컨텍스트 길이는 4096개 토큰입니다.

다가오는 기술 보고서에서 Stability AI는 모델 크기와 훈련 설정을 발표할 예정입니다.

개념 증명으로 팀은 Stanford University의 Alpaca로 모델을 미세 조정하고 Stanford University의 Alpaca, Nomic-AI의 gpt4all, RyokoAI의 ShareGPT52K 데이터세트, Databricks labs의 Dolly와 Anthropic의 HH입니다.

이 모델은 StableLM-Tuned-Alpha로 출시됩니다. 물론 이러한 미세 조정 모델은 연구 목적으로만 사용되며 비상업적입니다.

Stability AI는 향후 새로운 데이터 세트에 대한 자세한 내용도 발표할 예정입니다.

그 중에서도 새로운 데이터 세트가 매우 풍부하기 때문에 StableLM의 성능이 훌륭합니다. 현재 매개변수 규모는 여전히 약간 작지만(GPT-3의 1,750억 매개변수와 비교)

안정성 AI는 언어 모델이 디지털 시대의 핵심이라고 밝혔으며, 모두가 언어 모델에 대해 발언권을 가질 수 있기를 바랍니다.

그리고 StableLM의 투명성. 접근성 및 지원과 같은 기능도 이 개념을 구현합니다.

- StableLM의 투명성:

투명성을 구현하는 가장 좋은 방법은 오픈 소스가 되는 것입니다. 개발자는 모델 내부로 깊이 들어가 성능을 확인하고, 위험을 식별하고, 보호 조치를 함께 개발할 수 있습니다. 도움이 필요한 회사나 부서는 자신의 필요에 맞게 모델을 조정할 수도 있습니다.

- StableLM의 접근성:

일상 사용자는 언제 어디서나 로컬 장치에서 모델을 실행할 수 있습니다. 개발자는 이 모델을 적용하여 하드웨어 호환 독립 실행형 응용 프로그램을 만들고 사용할 수 있습니다. 이런 방식으로 AI가 가져오는 경제적 이익은 소수의 기업에 의해 분배되지 않으며, 배당금은 모든 일일 사용자와 개발자 커뮤니티에 속합니다.

이것은 폐쇄적인 모델이 할 수 없는 일입니다.

- StableLM 지원:

안정성 AI는 사용자를 교체하는 것이 아니라 지원하는 모델을 구축합니다. 즉, 편리하고 사용하기 쉬운 AI는 사람들이 업무를 보다 효율적으로 처리하고 창의성과 생산성을 높일 수 있도록 개발됩니다. 모든 것을 대체할 수 있는 무적의 무언가를 개발하려고 하는 대신.

Stability AI는 이러한 모델이 GitHub에 게시되었으며 향후 완전한 기술 보고서가 공개될 것이라고 밝혔습니다.

안정성 AI는 다양한 개발자 및 연구자와의 협력을 기대합니다. 동시에 그들은 크라우드소싱 RLHF 계획을 시작하고, 보조자 협력을 공개하고, AI 보조자를 위한 오픈 소스 데이터 세트를 생성할 것이라고 밝혔습니다.

오픈소스의 선구자 중 하나

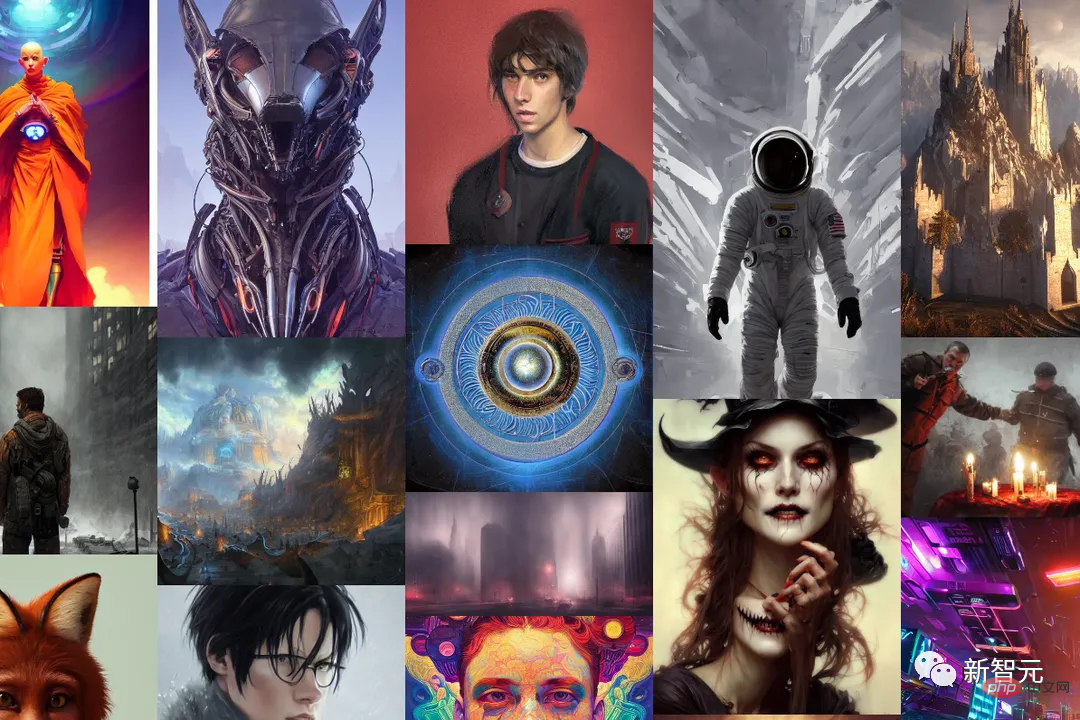

안정성 AI라는 이름은 이미 우리에게 매우 친숙합니다. 유명한 이미지 생성 모델인 Stable Diffusion을 만든 회사입니다.

이제 StableLM의 출시로 Stability AI는 AI를 활용하여 모든 사람에게 혜택을 주는 길로 점점 더 나아가고 있다고 할 수 있습니다. 결국, 오픈 소스는 항상 그들의 훌륭한 전통이었습니다.

2022년 Stability AI는 공개 데모, 소프트웨어 베타 버전, 모델 전체 다운로드 등 모든 사람이 Stable Diffusion을 사용할 수 있는 다양한 방법을 제공합니다.

혁신적인 이미지 모델인 Stable Diffusion은 독점 AI에 대한 투명하고 개방적이며 확장 가능한 대안을 나타냅니다.

분명히 Stable Diffusion은 오픈소스의 다양한 장점을 누구나 볼 수 있게 해줍니다. 물론, 피할 수 없는 단점도 있겠지만 이는 의심할 여지 없이 의미 있는 역사적 노드입니다.

(지난 달 Meta의 오픈 소스 모델 LLaMA의 "서사시" 유출로 인해 놀라운 성능을 갖춘 일련의 ChatGPT "대체"가 발생했습니다. 알파카 가족은 빅뱅처럼 탄생했습니다: Alpaca, Vicuna, Koala, ChatLLaMA, FreedomGPT, ColossalChat...)

그러나 Stability AI는 또한 사용하는 데이터 세트가 "기본 언어 모델을 보다 안전한 텍스트 배포로 안내하는 데 도움이 되어야 하지만 모든 편견과 독성이 미세 조정을 통해 완화될 수는 없다고 경고했습니다. "

논쟁: 오픈소스여야 하나?

요즘 우리는 오픈 소스 텍스트 생성 모델이 폭발적으로 증가하는 것을 목격했습니다. 크고 작은 기업들이 점점 수익성이 높아지는 생성 AI 분야에서는 일찍 유명해지는 것이 더 낫다는 사실을 발견했기 때문입니다.

지난 1년 동안 Meta, Nvidia 및 Hugging Face-backed BigScience 프로젝트와 같은 독립 그룹은 모두 GPT-4 및 Anthropic의 Claude와 같은 "비공개" API 모델을 대체하는 모델을 출시했습니다.

StableLM과 유사한 이러한 오픈 소스 모델은 범죄자들이 피싱 이메일을 생성하거나 악성 코드를 지원하는 등의 은밀한 동기로 사용할 수 있기 때문에 많은 연구자들이 이를 심각하게 비판했습니다.

하지만 Stablity AI는 오픈소스가 가장 올바른 방식이라고 주장합니다.

Stability AI는 "우리는 투명성을 높이고 신뢰를 구축하기 위해 모델을 오픈 소스로 만듭니다. 연구원은 이러한 모델에 대한 심층적인 이해를 얻고, 성능을 검증하고, 설명 기술을 연구하고, 잠재적인 위험을 식별하고, 지원 보호 장치 개발 "

"우리 모델에 대한 개방적이고 세분화된 액세스를 통해 광범위한 연구 및 학술 기반을 통해 폐쇄형 모델을 뛰어넘는 설명 가능성 및 보안 기술을 개발할 수 있습니다."

안정성 AI 주장은 감각. 필터와 인적 검토 팀을 갖춘 업계 최고의 모델인 GPT-4도 독성에 면역되지 않습니다.

또한 오픈 소스 모델에서는 백엔드를 조정하고 수정하는 데 더 많은 노력이 필요합니다. 특히 개발자가 최신 업데이트를 따라가지 못하는 경우에는 더욱 그렇습니다.

사실 역사를 되돌아보면 안정성 AI는 논란을 피한 적이 없습니다.

얼마 전 인터넷에서 스크랩한 저작권 이미지를 사용해 AI 그리기 도구를 개발해 수백만 아티스트의 권리를 침해했다는 비난이 일고 있었습니다.

또한, 은밀한 동기를 가진 일부 사람들은 Stability의 AI 도구를 사용하여 많은 유명인의 딥 페이크 포르노 이미지는 물론 폭력으로 가득 찬 이미지를 생성했습니다.

Stability AI는 블로그 게시물에서 자선적인 어조를 강조했지만 Stability AI 역시 예술, 애니메이션, 생물의학, 오디오 생성 분야 등 상용화에 대한 압박을 받고 있습니다.

Stability AI CEO Emad Mostaque는 상장 계획을 암시했습니다. Stability AI는 작년에 10억 달러 이상의 가치를 인정받았으며 벤처 캐피털에서 1억 달러 이상을 받았습니다. 하지만 외신 Semafor에 따르면 Stability AI는 "돈을 태우고 있지만 돈 버는 속도가 느리다"고 합니다.

위 내용은 70억 매개변수 StableLM 대형 언어 모델의 안정적인 확산 순간을 온라인에서 경험해보세요의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!