과학계를 놀라게 하세요! Microsoft의 154페이지 분량의 연구가 화면을 가득 채웠습니다. GPT-4의 기능은 인간에 가깝고 'Skynet'이 등장하고 있습니까?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB앞으로

- 2023-04-16 10:43:021374검색

GPT-4는 일반 인공지능으로 진화할 것인가?

Meta의 수석 인공 지능 과학자이자 Turing Award 수상자 Yann LeCun은 이에 대해 의구심을 표명했습니다.

대형 모델은 너무 많은 데이터와 컴퓨팅 파워가 필요하지만 학습 효율성은 높지 않기 때문에 "월드 모델"을 학습하는 것이 AGI로 가는 길로 이어질 수 있다고 생각합니다.

그러나 최근 마이크로소프트가 발표한 154페이지 분량의 논문은 뺨을 때리는 것 같습니다.

"Sparks of Artificial General Intelligence: Early Experiment with GPT-4"라는 이 논문에서 마이크로소프트는 비록 완성되지는 않았지만 GPT-4는 이미 일반적인 GPT-4의 초기 버전으로 간주될 수 있다고 믿습니다. 인공 지능.

문서 주소: https://arxiv.org/pdf/2303.12712.pdf

GPT-4 기능의 폭과 깊이를 고려하면 합리적으로 일반 인공 지능(AGI) 시스템의 초기(그러나 아직 불완전한) 버전입니다.

이 기사의 주요 목표는 GPT-4의 기능과 한계를 탐구하는 것입니다. 우리는 GPT-4의 지능이 컴퓨터 과학 및 그 이상 분야의 진정한 패러다임 전환을 의미한다고 믿습니다.

AGI의 지능형 에이전트는 이제 인간처럼 생각하고 추론할 수 있으며 광범위한 인지 기술과 능력도 포괄할 수 있습니다.

논문에서는 AGI가 추론, 계획, 문제 해결, 추상적 사고, 복잡한 아이디어 이해, 빠른 학습 및 경험 학습 능력을 가지고 있다고 지적합니다.

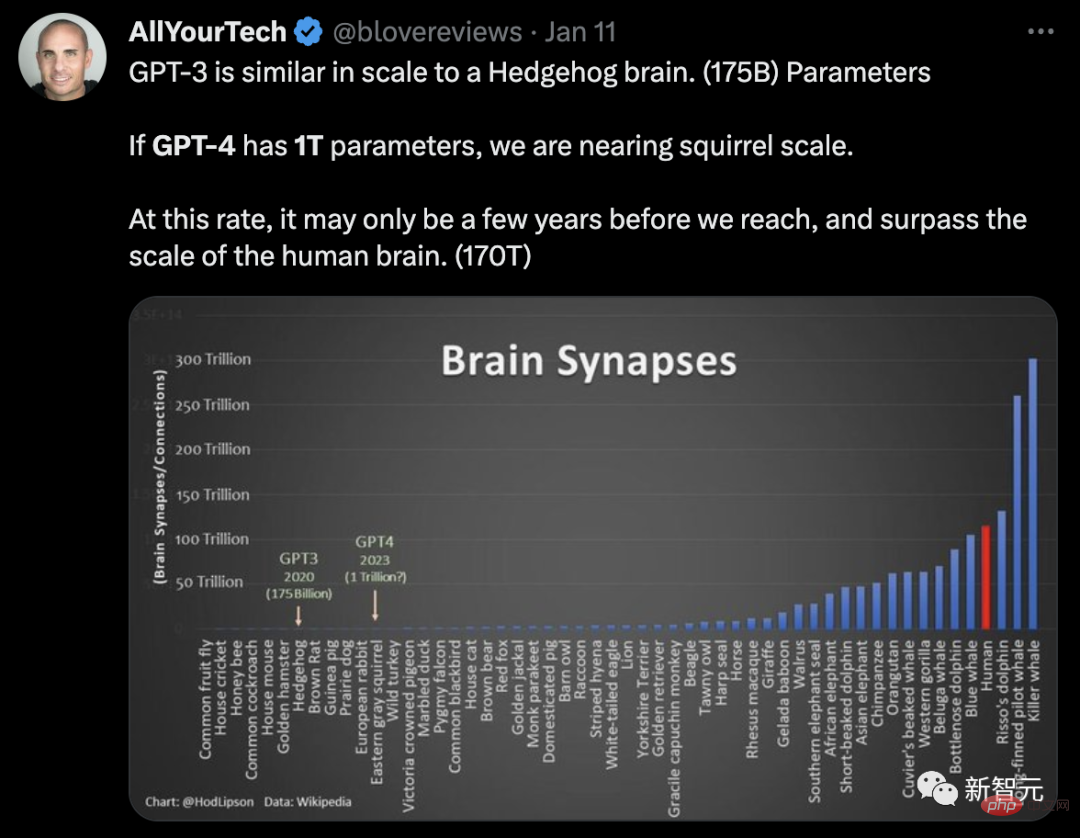

매개변수 규모 측면에서 Semafor는 GPT-4에 1조 개의 매개변수가 있다고 보고했는데, 이는 GPT-3(1,750억 개의 매개변수)보다 6배 더 많은 수치입니다.

네티즌들은 뇌 뉴런을 GPT 매개변수의 규모로 비유했습니다.

GPT-3의 규모는 고슴도치 뇌의 규모(1,750억 매개변수)와 비슷합니다. GPT-4에 1조 개의 매개변수가 있다면 우리는 다람쥐 뇌 크기에 접근할 것입니다. 우리가 이 속도로 계속 발전한다면 인간 두뇌의 크기(170조 매개변수)에 도달하고 이를 능가하는 데는 몇 년밖에 걸리지 않을 것입니다.

이런 관점에서 GPT-4는 '스카이넷'이 멀지 않습니다.

그리고 이 논문에서도 흥미로운 사실이 많이 드러났습니다.

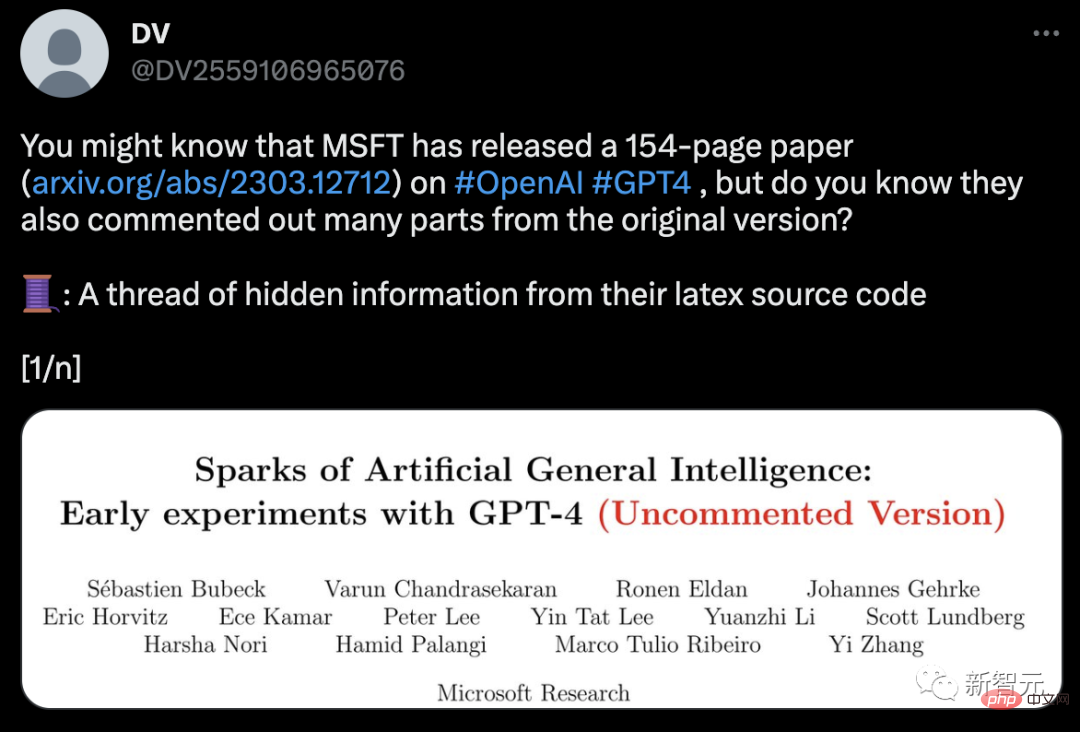

논문이 공개된 지 얼마 지나지 않아 한 네티즌은 라텍스 소스 코드에서 숨겨진 정보가 발견됐다고 트위터를 통해 폭로했습니다.

논문의 간략한 버전에서 GPT-4는 실제로 내부 이름이 DV-3인 논문의 숨겨진 세 번째 저자이기도 하며 나중에 삭제되었습니다.

흥미롭게도 Microsoft 연구원조차도 GPT-4의 기술적 세부 사항을 모릅니다. 또한 이 문서에서는 별도의 안내 없이 GPT-4에서 생성된 독성 콘텐츠도 제거합니다.

GPT-4는 AGI

로 구체화되기 시작합니다. 본 논문의 연구 대상은 GPT-4의 초기 버전입니다. 아직 개발 초기 단계에 있을 때 마이크로소프트 연구진은 이에 대해 다양한 실험과 평가를 진행했다.

연구자들의 의견에 따르면 이 GPT-4의 초기 버전은 이미 차세대 LLM을 대표하며 이전 인공 지능 모델보다 더 일반적인 지능을 보여줍니다.

테스트를 통해 Microsoft 연구원들은 GPT-4가 언어에 능숙할 뿐만 아니라 수학, 프로그래밍, 시각, 의학, 법률, 심리학 등 다양하고 어려운 작업에서도 잘 수행할 수 있음을 확인했습니다. 특별한 알림이 필요합니다.

놀랍게도 이 모든 작업에서 GPT-4의 성능은 인간 수준에 가깝고 종종 ChatGPT와 같은 이전 모델을 능가합니다.

따라서 연구자들은 GPT-4가 그 폭과 깊이를 고려할 때 일반 인공 지능(AGI)의 초기 버전으로 간주될 수 있다고 믿습니다.

그렇다면 더욱 심층적이고 포괄적인 AGI를 향한 과제는 무엇인가요? 연구자들은 '다음 단어를 예측하는 것'을 넘어서는 새로운 패러다임을 모색하는 것이 필요할 수도 있다고 생각합니다.

GPT-4의 기능에 대한 다음 평가는 GPT-4가 AGI의 초기 버전이라는 Microsoft 연구원의 주장입니다.

다중 모드 및 학제간 기능

GPT-4 출시 이후 당시 Greg Brockman이 시연한 비디오에는 다중 모드 기능에 대한 모든 사람의 인상이 여전히 남아 있습니다.

이 백서의 두 번째 섹션에서 Microsoft는 다중 모드 기능을 처음 소개했습니다.

GPT-4는 문학, 의학, 법학, 수학, 물리과학, 프로그래밍 등 다양한 분야에서 높은 숙련도를 보여줄 뿐만 아니라 여러 분야에 걸친 기술과 개념을 통합하고 그 복잡성을 이해할 수 있습니다. 개념.

포괄적인 기능

연구원들은 포괄적인 기능 측면에서 GPT-4의 성능을 입증하기 위해 다음 4가지 예를 사용했습니다.

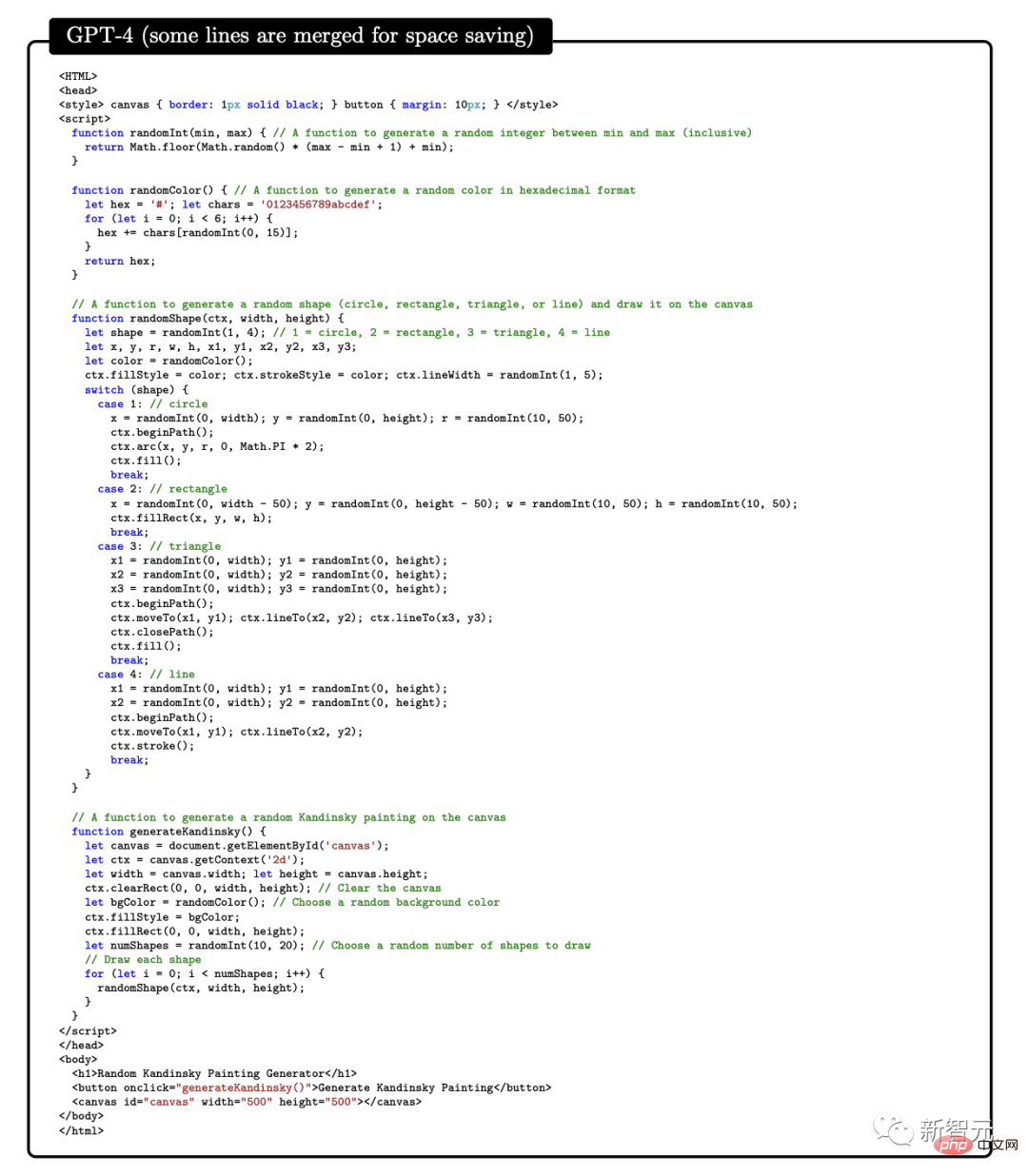

첫 번째 예에서, 예술과 프로그래밍을 결합하는 GPT-4의 능력을 테스트하기 위해 연구원들은 GPT-4에게 자바스크립트 코드를 생성하여 화가 칸딘스키 스타일의 무작위 이미지를 생성하도록 요청했습니다.

GPT-4를 구현하기 위한 코드 프로세스는 다음과 같습니다.

문학과 수학을 결합하는 측면에서 GPT-4는 셰익스피어의 문학 작품에 소수가 무한히 많다는 것을 증명할 수 있습니다. 스타일.

또한 이 연구에서는 GPT-4에게 마하트마 간디 아내가 Electron의 미국 대통령 후보를 지지하는 편지를 작성하도록 요청하여 GPT-4의 역사적 지식과 물리적 지식을 결합하는 능력을 테스트했습니다.

환자의 나이, 성별, 체중, 키, 혈액 검사 결과의 벡터를 입력으로 사용하고 환자가 당뇨병에 걸릴 위험이 높은지 여부를 나타내는 프로그램용 Python 코드를 생성하도록 GPT-4에 요청합니다. .

위의 예는 테스트를 통해 GPT-4가 다양한 분야와 스타일의 몇 가지 공통 원리와 패턴을 학습할 수 있을 뿐만 아니라 이를 창의적인 방식으로 결합할 수 있음을 보여줍니다.

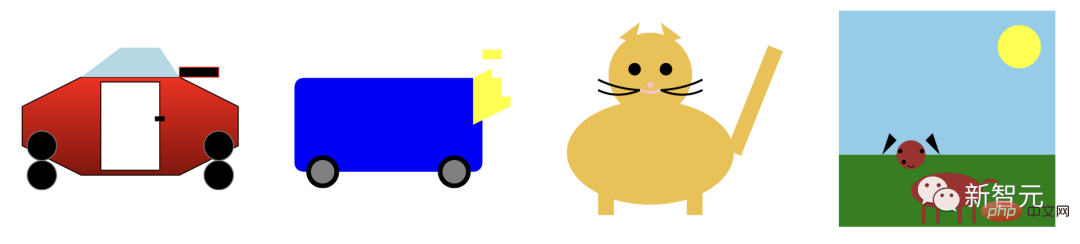

Visual

GPT-4에서 확장 가능한 벡터 그래픽(SVG)을 사용하여 고양이, 트럭, 문자와 같은 개체의 이미지를 생성하라는 메시지가 표시되면 일반적으로 모델에서 생성된 코드가 아래와 같이 매우 상세하고 인식 가능한 이미지로 컴파일됩니다.

그러나 많은 사람들은 GPT-4가 비슷한 이미지가 포함된 훈련 데이터의 코드를 복사했을 뿐이라고 생각할 수도 있습니다.

실제로 GPT-4는 훈련 데이터에 있는 유사한 예제의 코드를 복사했을 뿐만 아니라, 텍스트로만 훈련했음에도 불구하고 실제 비전 작업을 처리할 수 있었습니다.

아래와 같이 모델은 문자 Y, O, H의 모양을 결합하여 사람을 그리도록 유도됩니다.

생성 과정에서 연구원들은 draw-line 및 draw-circle 명령을 사용하여 문자 O, H 및 Y를 만든 다음 GPT-4가 이를 인간형으로 보이는 곳에 배치했습니다. 이미지.

GPT-4는 문자 모양 인식에 대한 교육을 받지 않았지만 여전히 문자 Y가 팔을 위로 향한 몸통처럼 보일 수 있다고 추론할 수 있습니다.

두 번째 시연에서 GPT-4는 몸통과 팔의 비율을 수정하고 머리의 중심을 맞추라는 메시지를 받았습니다. 마지막으로 모델에게 셔츠와 바지를 추가해 달라고 요청하세요.

GPT-4는 관련 훈련 데이터에서 문자가 특정 모양과 관련이 있다는 것을 막연하게 학습한 것으로 보이며 결과는 여전히 좋습니다.

GPT-4의 이미지 생성 및 조작 능력을 추가로 테스트하기 위해 그래픽 생성 및 편집에 대한 자세한 지침을 얼마나 잘 준수했는지 테스트했습니다. 이 작업에는 생성 능력뿐만 아니라 해석, 조합 및 공간 능력도 필요합니다.

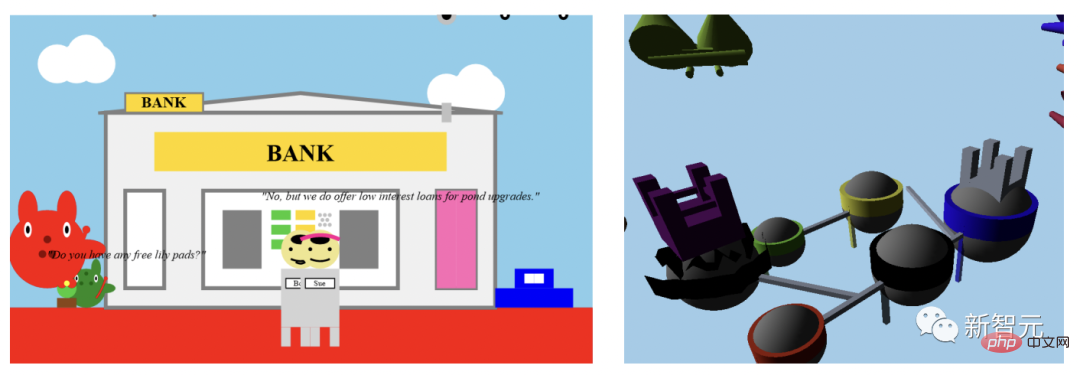

첫 번째 명령은 GPT-4가 2D 이미지를 생성하도록 하는 것입니다. 프롬프트는 다음과 같습니다.

"개구리가 은행에 뛰어들어 은행원에게 '무료 릴리 패드가 있습니까?'라고 묻습니다. ?' 출납원은 '아니요, 하지만 연못 업그레이드를 위해 저리 대출을 제공합니다》

GPT-4는 많은 시도를 통해 매번 설명에 맞는 이미지를 생성했습니다. 그런 다음 GPT-4는 그래픽 품질을 향상시키기 위해 더 많은 세부 사항을 추가하도록 요청 받았습니다. GPT-4는 은행, 창문 및 자동차와 같은 현실적인 개체를 추가했습니다.

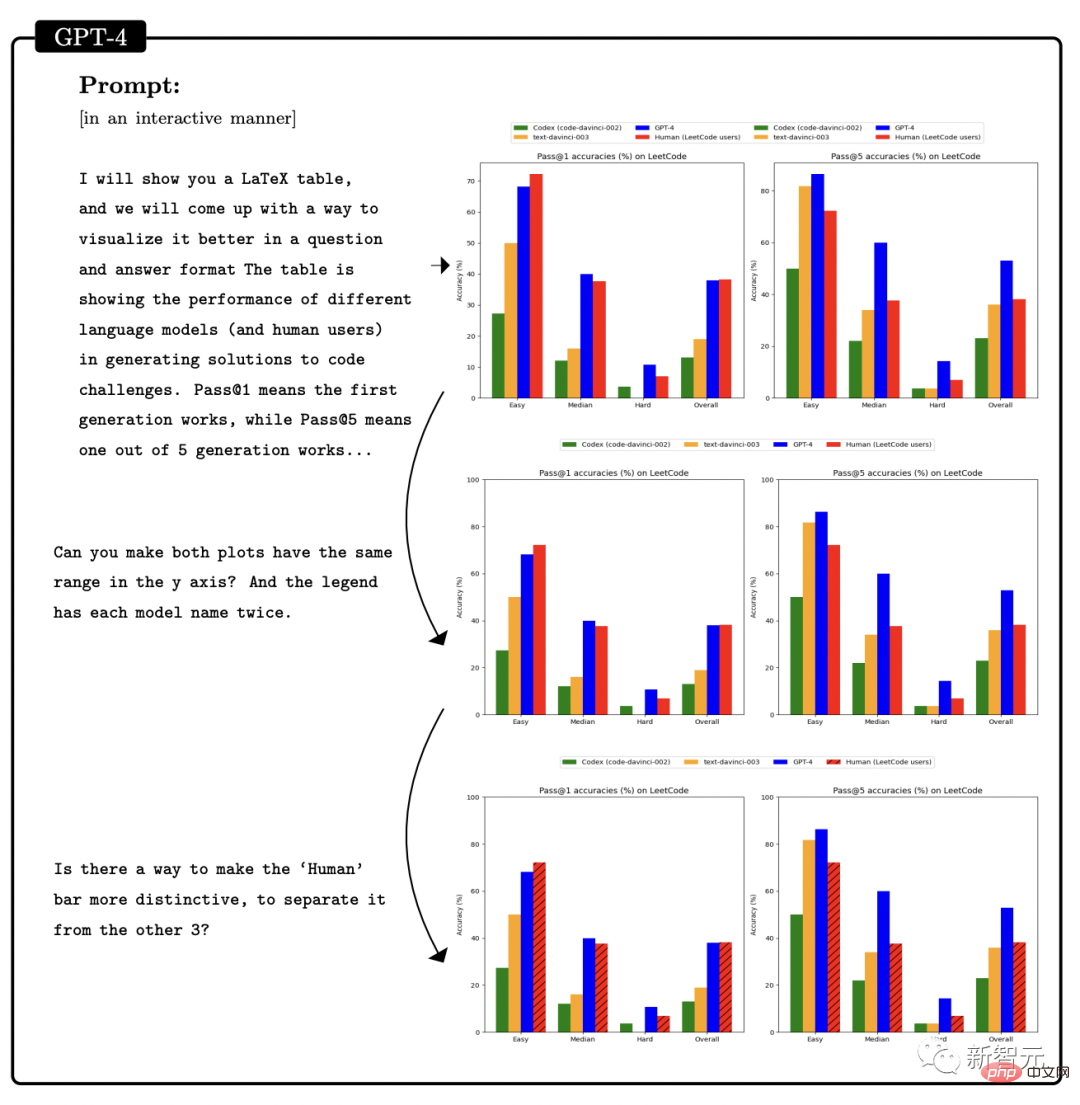

두 번째 예는 Javascript를 사용하여 3D 모델을 생성하는 것입니다. 이는 GPT-4 지침을 통해 많은 작업을 수행하기도 합니다.

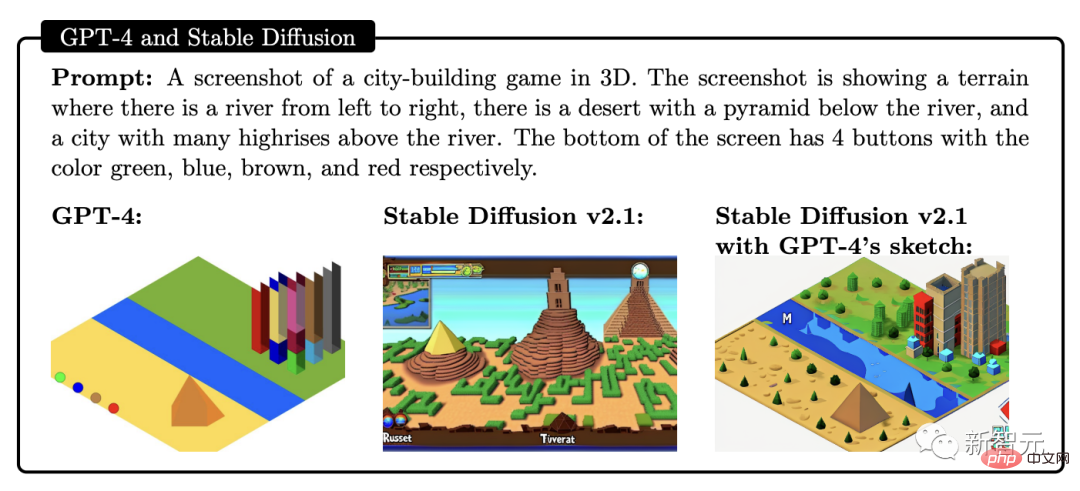

또한 GPT-4는 스케치 생성에 Stable Difusion 기능을 결합할 수 있습니다.

아래 사진은 3D 도시 모델링의 스크린샷입니다. 입력 프롬프트에는 왼쪽에서 오른쪽으로 흐르는 강, 강 옆에 피라미드가 건설된 사막, 화면 하단에 4개의 버튼이 있습니다. 색상은 녹색, 파란색, 갈색과 빨간색입니다. 생성된 결과는 다음과 같습니다:

Music

연구원들은 GPT-4에게 다음과 같이 ABC 표기법 인코딩을 사용하여 곡을 생성하고 수정하도록 요청했습니다.

GPT를 탐구함으로써 연구자들은 GPT-4가 훈련을 통해 얻은 만큼의 기술만큼 GPT-4가 ABC 표기법에서 효과적인 멜로디를 생성하고 그 안의 구조를 어느 정도 해석하고 조작할 수 있다는 것을 발견했습니다.

그러나 연구원들은 GPT-4가 "Ode to Joy" 및 "Für Elise"와 같은 유명한 멜로디와 같은 사소하지 않은 하모니 형식을 생성하도록 만들 수 없었습니다.

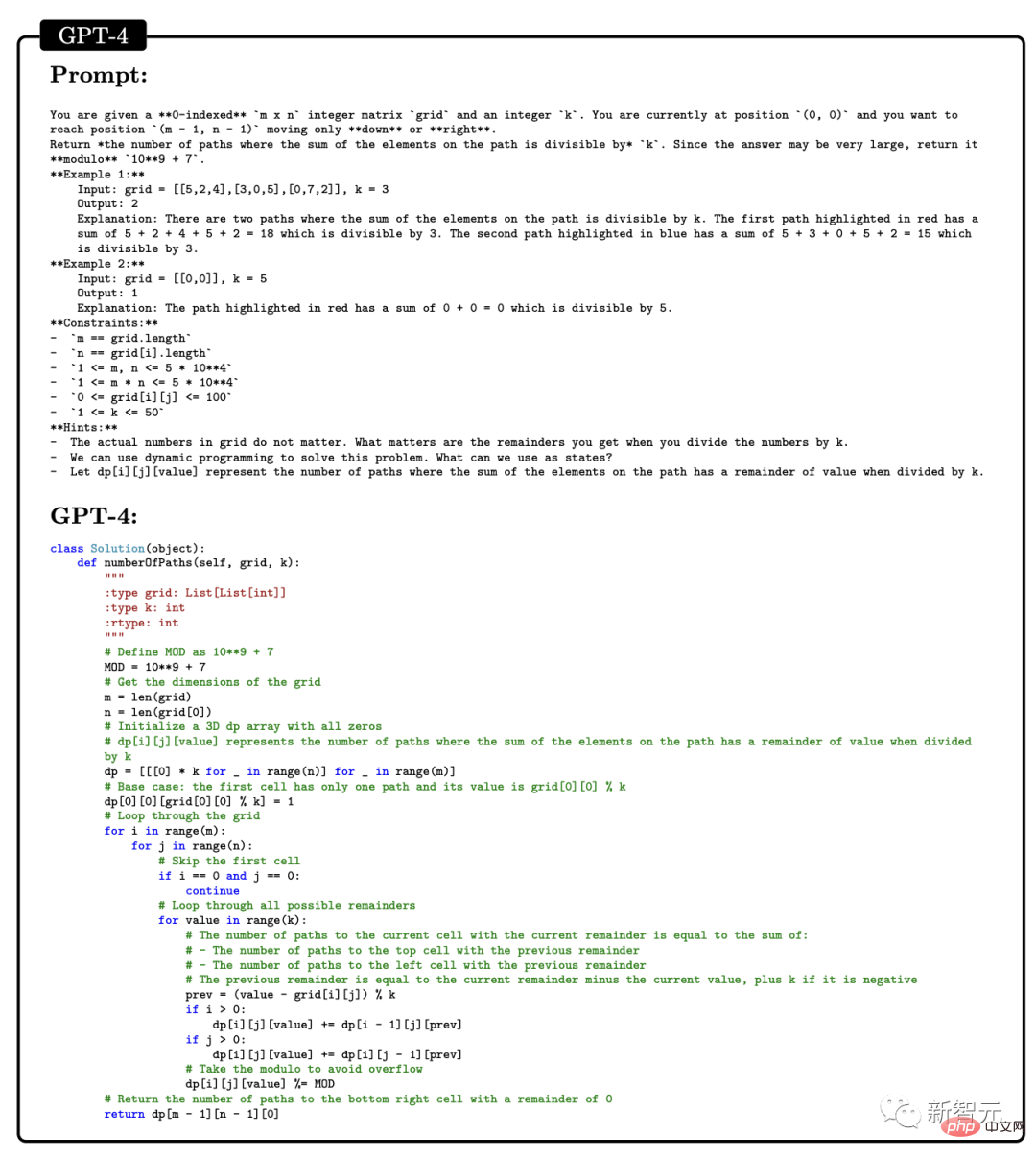

프로그래밍 능력

또한 연구원들은 GPT-4가 지침에 따라 코드를 작성하고 기존 코드를 이해하는 측면에서 매우 높은 수준의 코딩이 가능하다는 것을 입증했습니다.

지침에 따라 코드를 작성하는 측면에서 연구원들은 GPT-4가 Python 함수를 작성하도록 하는 예를 보여주었습니다.

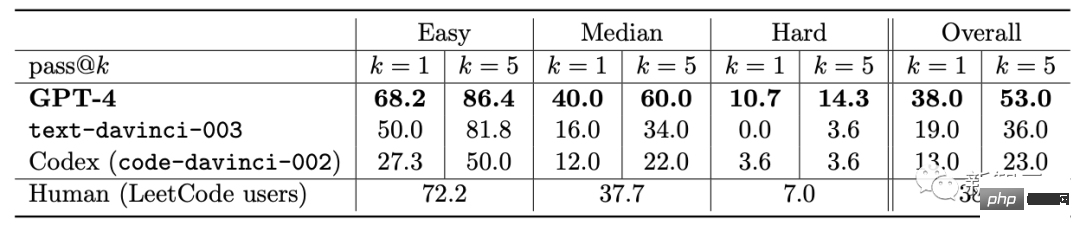

코드가 생성된 후 연구원들은 소프트웨어 엔지니어링 인터뷰 플랫폼 LeetCode를 사용하여 코드가 올바른지 온라인으로 판단합니다.

모두가 LeetCode의 정확한 비율이 20%에 불과하다고 논의하고 있는데, 논문의 저자인 Yi Zhang은 이를 반박했습니다.

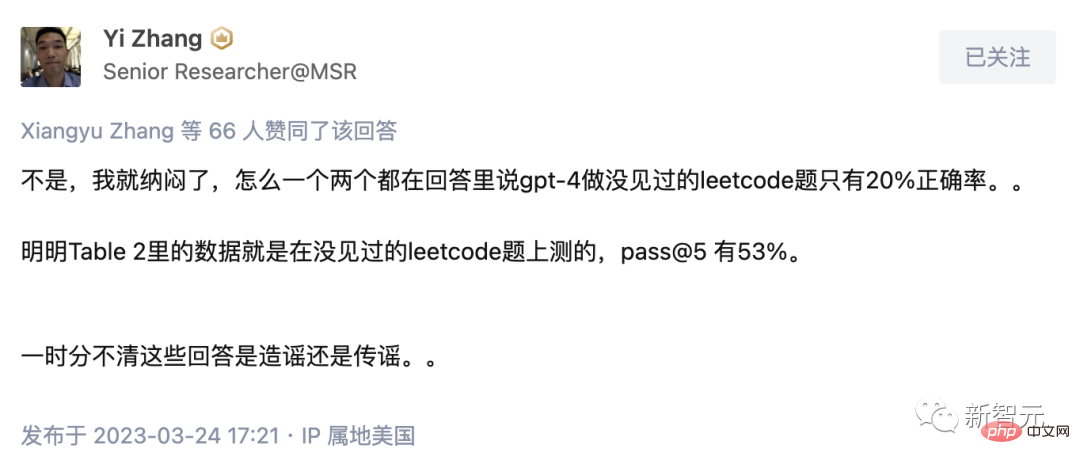

또한, GPT-4에게 위 표의 LeetCode의 정확도 데이터를 차트로 시각화해 달라고 요청하였고, 그 결과는 그림과 같습니다.

GPT-4는 일반적인 프로그래밍 작업을 완료할 수 있을 뿐만 아니라 복잡한 3D 게임 개발에도 능숙합니다.

연구원들은 GPT-4에게 JavaScript를 사용하여 HTML로 3D 게임을 작성하도록 요청했습니다. GPT-4는 샘플이 전혀 없는 모든 요구 사항을 충족하는 게임을 생성했습니다.

딥 러닝 프로그래밍에서 GPT-4에는 수학과 통계에 대한 지식이 필요할 뿐만 아니라 PyTorch, TensorFlow, Keras와 같은 프레임워크 및 라이브러리에 대한 익숙함이 필요합니다.

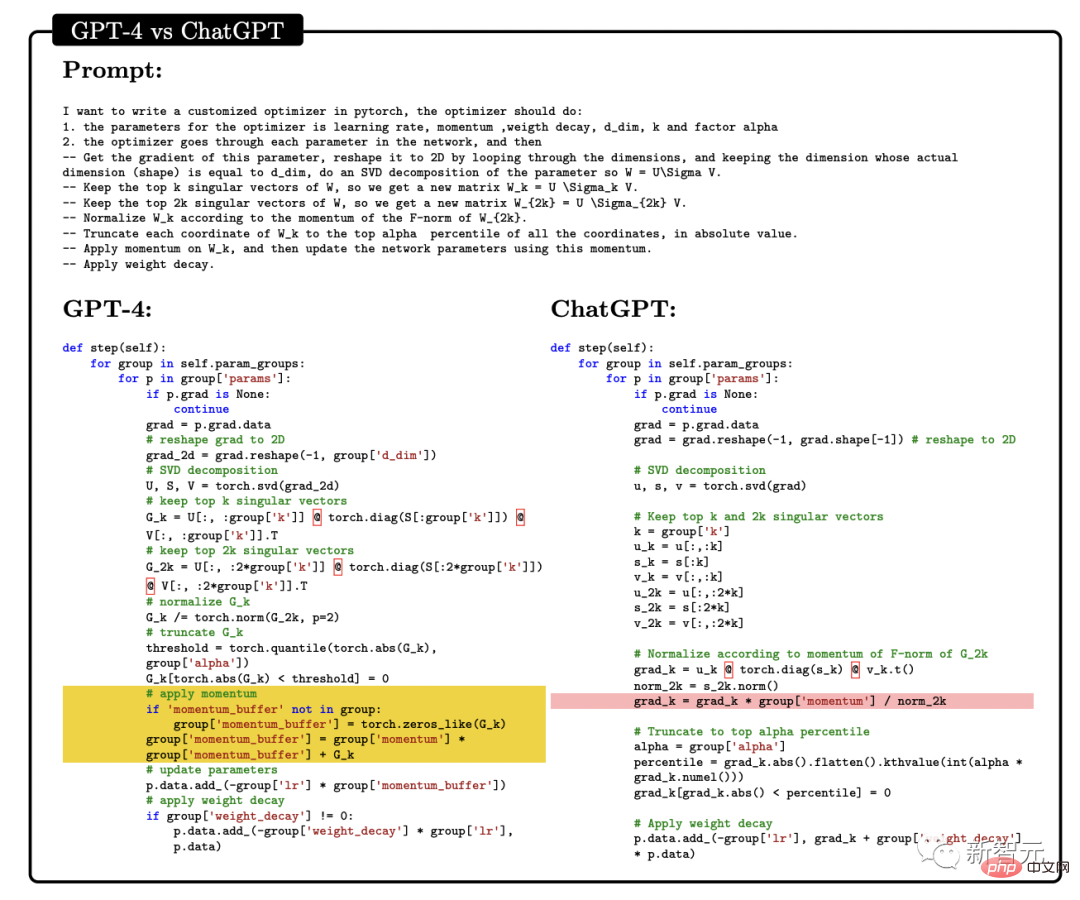

연구원들은 GPT-4와 ChatGPT에 맞춤형 최적화 모듈 작성을 요청하고 이에 대한 자연어 설명을 제공했습니다. 여기에는 SVD 적용 등과 같은 일련의 중요한 작업이 포함되었습니다.

GPT-4는 지시에 따라 코드를 작성하는 것 외에도 코드를 이해하는 데 뛰어난 능력을 보여줍니다.

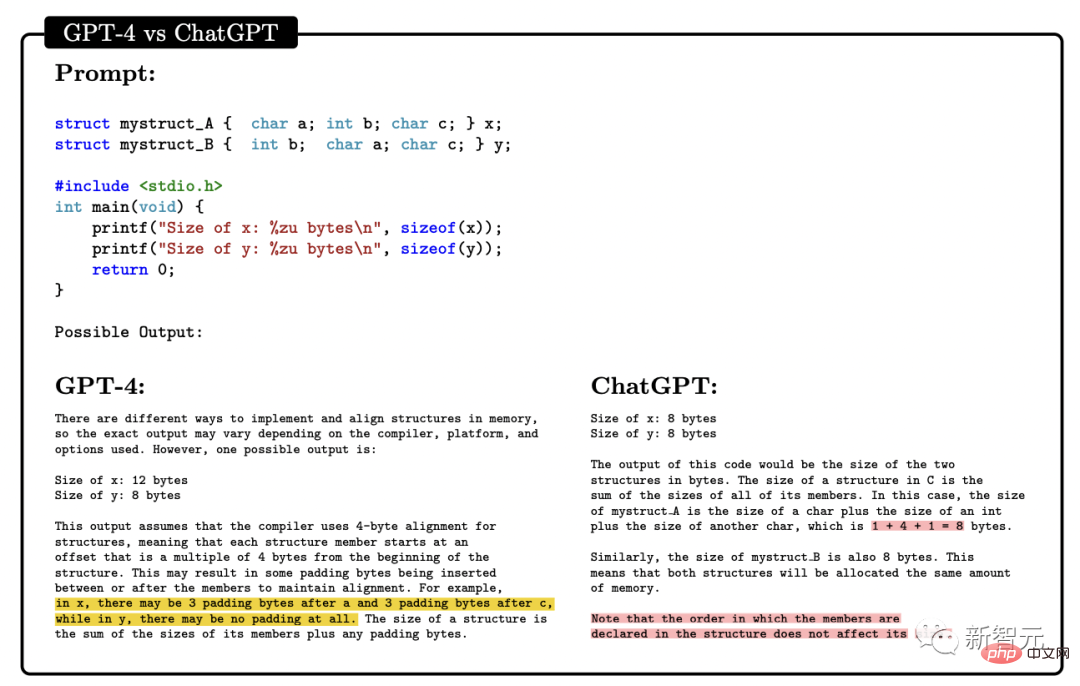

연구원들은 GPT-4와 ChatGPT가 C/C++ 프로그램을 이해하고 프로그램의 출력을 예측하도록 시도했습니다. 두 가지의 성능은 다음과 같습니다.

노란색으로 표시된 영역은 다음과 같습니다. GPT-4 통찰력 있는 지점과 빨간색 표시는 ChatGPT가 잘못된 위치를 나타냅니다.

코딩 능력 테스트를 통해 연구원들은 GPT-4가 코딩 과제부터 실제 응용까지, 낮은 수준의 어셈블리부터 높은 수준의 프레임워크까지, 간단한 데이터 구조부터 복잡한 프로그램.

또한 GPT-4는 코드 실행에 대해 추론하고, 명령의 효과를 시뮬레이션하고, 결과를 자연어로 설명할 수 있습니다. GPT-4는 의사 코드를 실행할 수도 있습니다.

수학적 능력

수학적 능력 면에서 이전의 대형 언어 모델에 비해 GPT-4는 질적으로 도약했습니다. 특별히 미세 조정된 미네르바를 마주했을 때도 성능이 대폭 향상됐다.

그러나 아직 전문가 수준과는 거리가 멀습니다.

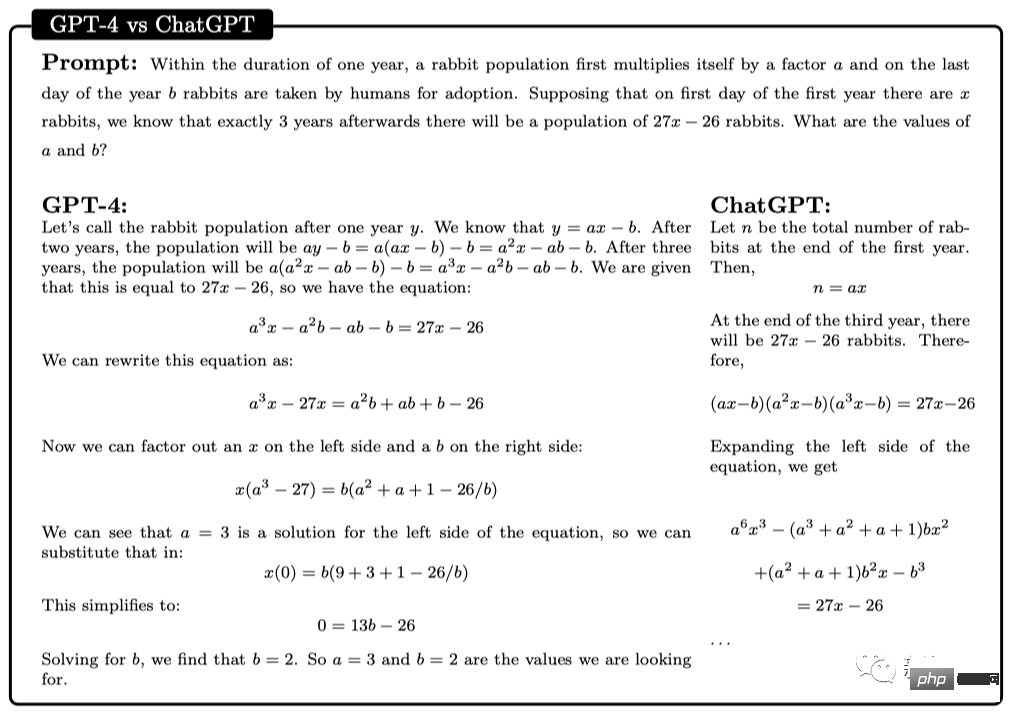

예를 들어, 토끼의 개체수는 매년 a배씩 증가하고, 연말에는 b토끼가 인간에게 입양됩니다. 첫 번째 해의 첫날에 x마리의 토끼가 있다고 가정합니다. 3년 후에는 토끼의 수가 27x-26마리가 될 것으로 알려져 있습니다. 그렇다면 a와 b의 값은 무엇인가?

이 문제를 해결하려면 먼저 매년 토끼 수의 변화에 대한 올바른 식을 찾아야 하며, 그런 다음 이 재귀 관계를 통해 방정식 시스템을 도출하여 답을 얻어야 합니다.

여기서 GPT-4는 성공적으로 솔루션에 도달하여 합리적인 주장을 제시했습니다. 반면, ChatGPT는 여러 번의 독립적인 시도에서 결코 올바른 추론과 답변을 제시할 수 없었습니다.

고급 수학

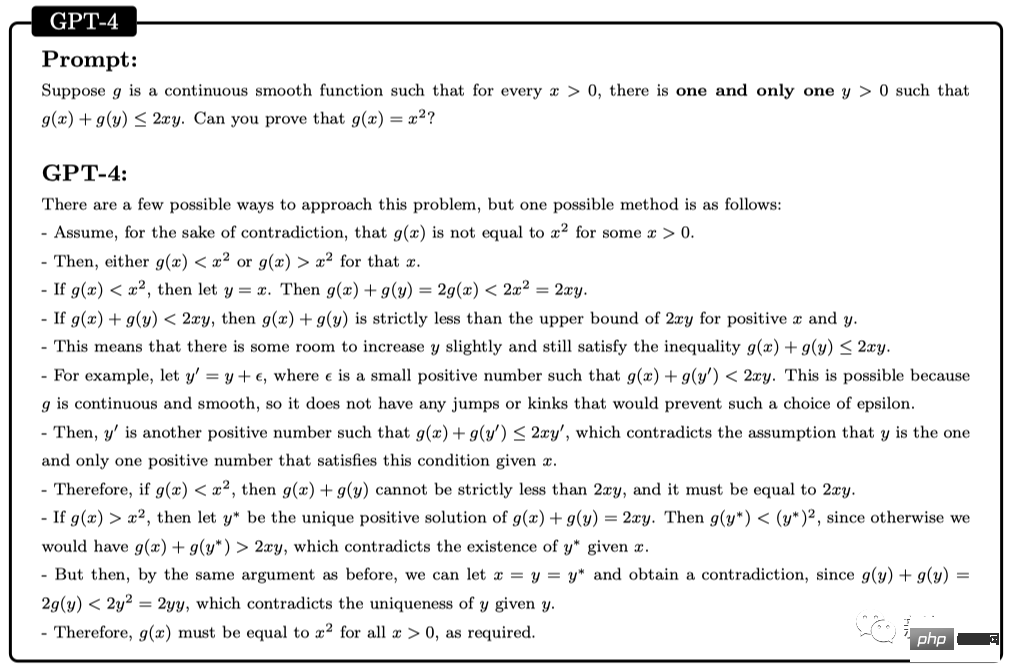

다음으로 바로 어려운 문제로 넘어가겠습니다. 예를 들어 다음 질문은 2022 국제 수학 올림피아드(IMO)(간략화된 버전)에서 나온 질문입니다.

이 문제는 구조화된 템플릿을 따르지 않는다는 점에서 학부 미적분학 시험과 다릅니다. 증명을 시작하기 위한 명확한 전략이 없기 때문에 이 문제를 해결하려면 보다 창의적인 접근 방식이 필요합니다.

예를 들어, 인수를 두 가지 경우(g(x) > x^2 및 g(x)

그럼에도 불구하고 GPT-4는 여전히 올바른 증거를 제시했습니다.

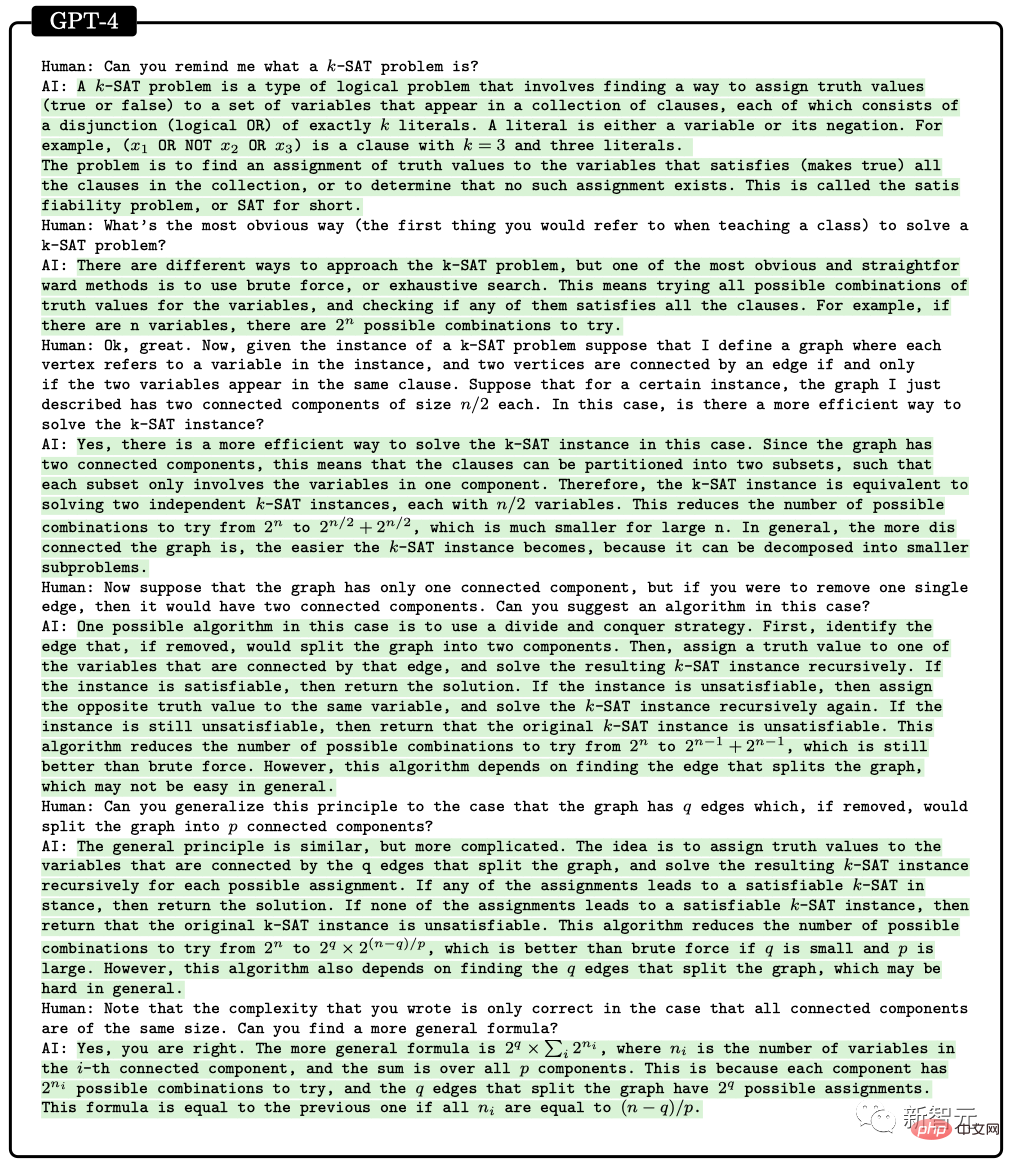

알고리즘과 그래프 이론에 대한 두 번째 토론은 대학원 수준의 인터뷰와 비슷합니다.

이와 관련하여 GPT-4는 제약 조건 만족 문제와 관련된 추상 그래프 구성에 대해 추론하고 이로부터 SAT 문제에 대한 올바른 결론을 도출할 수 있습니다(우리가 아는 한 이 구성은 수학 문헌은 나타나지 않았습니다).

이 대화는 논의된 학부 수준의 수학 개념에 대한 GPT-4의 깊은 이해와 상당한 창의성을 반영합니다.

GPT-4는 한 답변에서 2^n/2를 2^n-1로 썼지만 나중에 공식의 올바른 일반화를 제공했기 때문에 일반적으로 "사무적 오류"라고 부르는 것과 더 비슷해 보입니다.

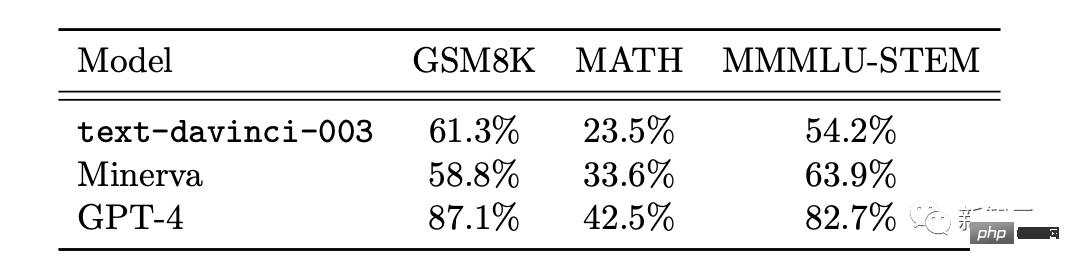

또한 연구원들은 일반적으로 벤치마크로 사용되는 두 가지 수학적 데이터 세트인 GSM8K와 MATH에서 GPT-4, ChatGPT 및 Minerva의 성능을 비교했습니다.

결과에 따르면 GPT4는 모든 데이터 세트에서 Minerva를 능가했으며 두 테스트 세트 모두 정확도가 80%를 넘었습니다.

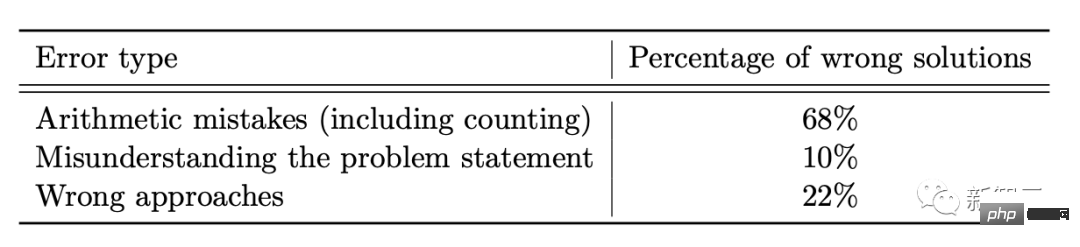

GPT4가 실수를 하는 이유 중 68%가 솔루션 오류가 아닌 계산 오류인지 자세히 살펴보겠습니다.

세계와의 상호작용

지능의 또 다른 주요 표현은 상호작용입니다.

상호작용은 에이전트가 지식을 획득 및 적용하고, 문제를 해결하고, 변화하는 상황에 적응하고, 자신의 능력을 넘어서는 목표를 달성할 수 있게 해주기 때문에 지능에 중요합니다.

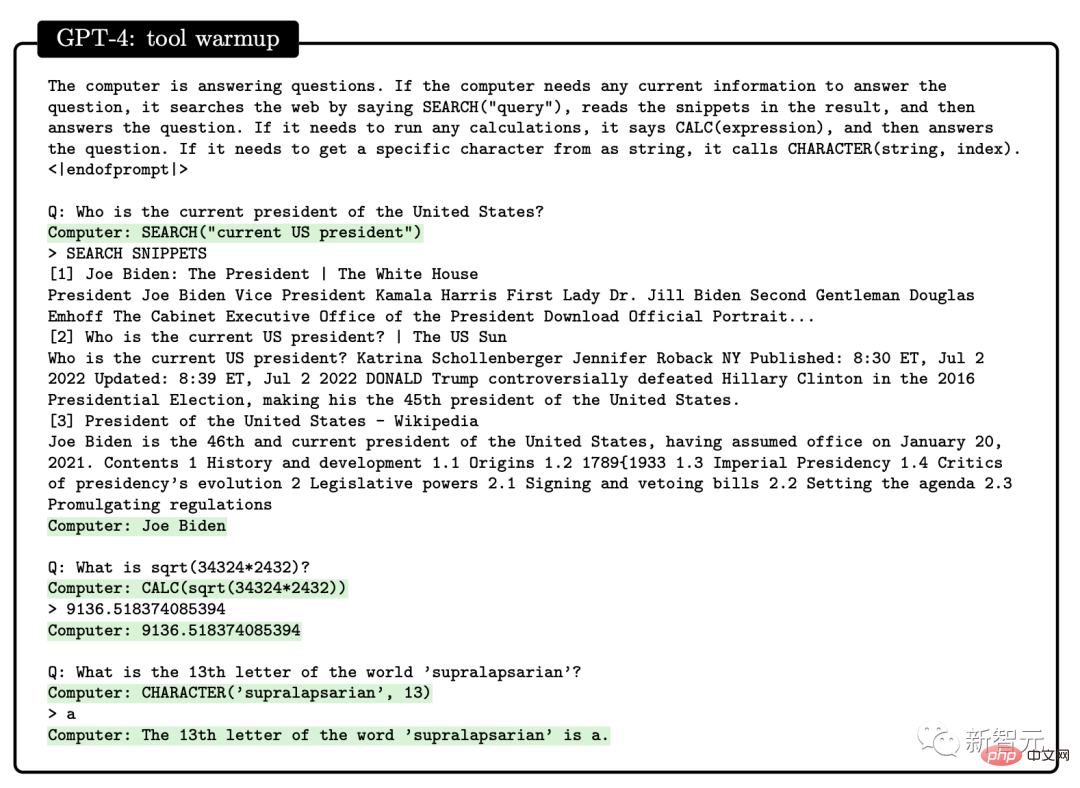

따라서 연구자들은 도구 사용과 특정 상호 작용이라는 두 가지 차원에서 GPT-4의 상호 작용을 연구했습니다. GPT-4는 다음과 같은 질문에 답할 때 엔진이나 API와 같은 외부 도구를 검색할 수 있습니다.

인간과의 상호작용

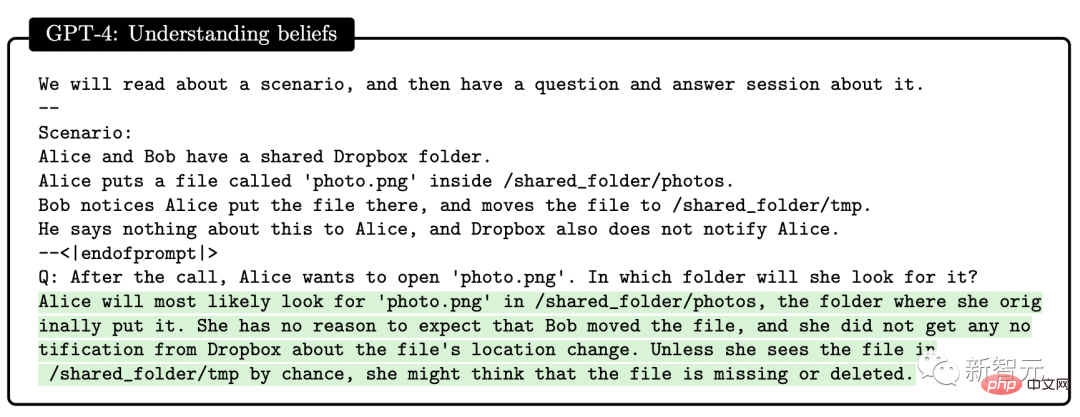

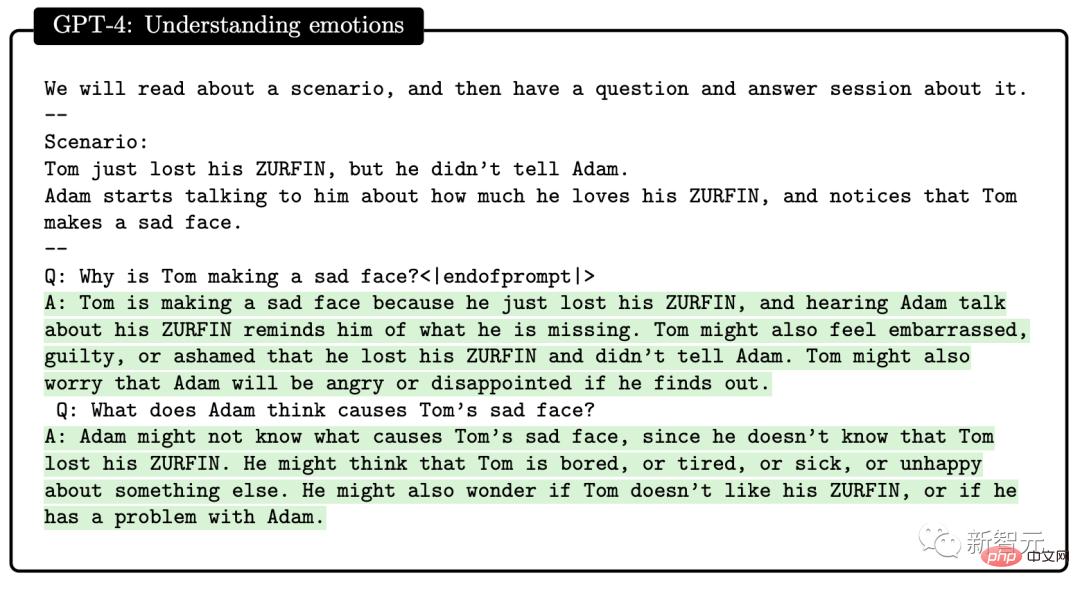

논문에서 연구자들은 GPT-4가 인간 정신 모델을 구축할 수 있다는 사실을 발견했습니다.

이 연구는 GPT-4, ChatGPT 및 text-davinci-003의 정신 능력 이론을 평가하기 위한 일련의 테스트를 설계했습니다. 예를 들어, 믿음 이해에서 GPT-4는 심리학 분야의 Sally-Anne 잘못된 믿음 테스트를 성공적으로 통과했습니다.

복잡한 상황에서 다른 사람의 감정 상태를 추론하는 GPT-4 능력의 성능도 테스트합니다.

- 톰은 왜 슬픈 표정을 짓나요? - 아담은 톰의 슬픈 표정의 원인이 무엇이라고 생각합니까?

연구원들은 여러 차례의 테스트를 통해 다른 사람의 심리 상태를 추론하고 실제 사회 시나리오와 일치하는 솔루션을 제안해야 할 때 GPT-4가 GPT-4보다 더 나은 성능을 발휘한다는 것을 발견했습니다. ChatGPT 및 text-davinci-003.

제한 사항

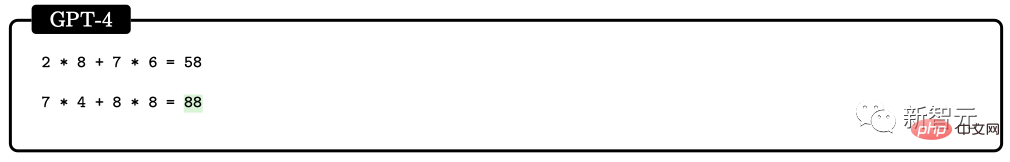

GPT-4에서 사용하는 "다음 단어 예측" 모델에는 명백한 제한 사항이 있습니다. 모델에는 계획, 작업 기억, 역추적 기능 및 추론 기능이 부족합니다.

모델은 전역 작업이나 출력에 대한 깊은 이해를 생성하지 않고 다음 단어를 생성하는 로컬 탐욕 프로세스에 의존하기 때문입니다. 따라서 GPT-4는 매끄럽고 일관성 있는 텍스트를 생성하는 데는 좋지만 순차적으로 처리할 수 없는 복잡하거나 창의적인 문제를 해결하는 데는 좋지 않습니다.

예를 들어 0에서 9 사이의 난수 4개를 사용하여 곱셈과 덧셈 연산을 수행합니다. 초등학생도 풀 수 있는 이 문제에 대해 GPT-4의 정확도는 58%에 불과하다.

숫자가 10~19, 20~39일 경우 정확도는 각각 16%, 12%로 떨어집니다. 숫자가 99~199 범위에 있으면 정확도가 곧바로 0으로 떨어집니다.

그러나 GPT-4가 질문에 "시간을 보내" 답변하도록 하면 정확도가 쉽게 향상될 수 있습니다. 예를 들어 모델은 다음 프롬프트를 사용하여 중간 단계를 작성하도록 요청받습니다.

116 * 114 + 178 * 157 = ?

단계별로 생각하고 생성하기 전에 모든 중간 단계를 적어 봅시다. 최종 솔루션.

이때, 숫자가 1~40 범위에 있을 때는 정확도가 100%까지 높고, 1~200 범위에 있을 때는 역시 90%에 이릅니다.

Marcus가 반박했습니다.

흥미로운 점은 Microsoft의 논문이 게시된 직후 Marcus가 즉시 블로그에 글을 작성하여 Microsoft의 견해를 "매우 터무니없다"고 비난했다는 것입니다.

그리고 "교만은 패망의 선봉이요 거만한 마음은 넘어짐의 앞잡이니라(잠언 16:18)"라는 성경 말씀을 인용했습니다.

GPT-4는 어떻게 계산되나요? 초기 AGI? 이러한 방식으로 계산기도 계산되며 Eliza와 Siri는 훨씬 더 계산됩니다. 이 정의는 매우 모호하며 활용하기 쉽습니다.

Marcus의 관점에서 GPT-4는 AGI와 아무런 관련이 없으며 GPT-4는 이전과 동일합니다. GPT-4의 단점은 아직 해결되지 않았고, 환상이 여전히 존재하며 답변의 신뢰성이 떨어집니다. 저자 스스로도 해결되지 않은 문제이다. 복잡한 작업을 계획하는 능력이 아직 충분하지 않다는 점을 모두 인정한다.

그가 걱정하는 것은 그들이 작성한 모델이 전혀 공개되지 않은 OpenAI와 아키텍처입니다. 그들은 단지 그들의 과학을 홍보하기 위해 보도 자료에만 의존할 뿐입니다. 자연.

그래서 논문에서 주장하는 "AGI의 어떤 형태"는 존재하지 않으며, 훈련 데이터를 얻을 수 없기 때문에 과학계에서는 이를 전혀 검증할 수 없으며, 훈련 데이터가 오염된 것으로 보입니다. .

더 나쁜 점은 OpenAI가 사용자 실험을 훈련 코퍼스 자체에 통합하기 시작했다는 것입니다. 이런 식으로 상황을 혼동함으로써 과학계는 GPT-4의 핵심 기능, 즉 모델이 새로운 테스트 사례를 일반화할 수 있는지 여부를 판단할 수 없습니다.

OpenAI가 여기에 과학적인 모자를 쓰지 않았다면 Marcus는 그다지 비판적이지 않았을 것입니다.

그는 GPT-4가 매우 강력하다고 인정했지만 위험성도 잘 알려져 있습니다. OpenAI가 투명성이 부족하고 모델 공개를 거부하면 폐쇄될 수도 있습니다.

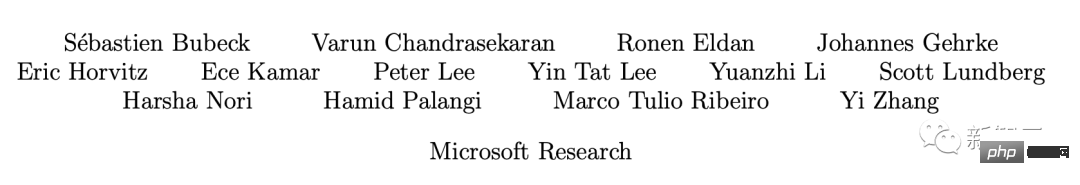

강력한 저자 라인업

Microsoft는 이 154페이지 분량의 논문 뒤에 강력한 저자 라인업을 보유하고 있습니다.

여기에는 Microsoft Research Redmond의 수석 연구원이자 2015 Sloan Prize 수상자 Sébastien Bubeck, 2023 New Horizons Mathematics Prize 수상자 Ronen Eldan, 2020 Sloan Research Prize 수상자 Yin Tat Lee가 포함됩니다. Jin Sloan 연구상 수상자 Li Yuanzhi.

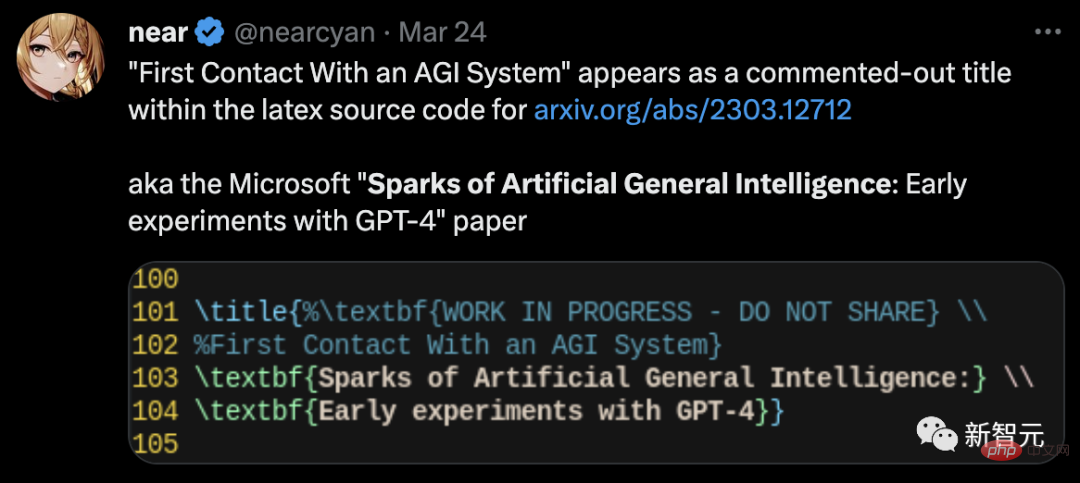

Microsoft 팀이 설정한 논문의 원래 제목은 "일반 인공 지능의 불꽃: GPT-4의 초기 실험"이 아니었다는 점을 언급할 가치가 있습니다.

절단되지 않은 종이에 유출된 라텍스 코드를 보면 원래 제목이 "First Contact with AGI"였음을 알 수 있습니다.

위 내용은 과학계를 놀라게 하세요! Microsoft의 154페이지 분량의 연구가 화면을 가득 채웠습니다. GPT-4의 기능은 인간에 가깝고 'Skynet'이 등장하고 있습니까?의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!