Jeff Dean 외의 신작: 언어 모델을 다른 각도에서 보면 규모가 충분히 크지 않아 발견할 수 없음

- 王林앞으로

- 2023-04-14 12:52:031448검색

최근 몇 년 동안 언어 모델은 자연어 처리(NLP)에 혁명적인 영향을 미쳤습니다. 매개변수와 같은 언어 모델을 확장하면 다양한 다운스트림 NLP 작업에서 더 나은 성능과 샘플 효율성을 얻을 수 있는 것으로 알려져 있습니다. 많은 경우 스케일링이 성능에 미치는 영향은 스케일링 법칙을 통해 예측할 수 있는 경우가 많으며, 대부분의 연구자들은 예측 가능한 현상을 연구해 왔습니다.

반대로 Jeff Dean, Percy Liang 등 16명의 연구자가 "Emergent Abilities of Large Language Models"라는 논문에서 공동으로 대형 모델의 예측 불가능 현상을 논의하고 이를 대형 언어 모델의 출현이라고 불렀습니다. . 응급 능력. 소위 창발(emergence)은 어떤 현상이 더 작은 모델에는 존재하지 않지만 더 큰 모델에는 존재한다는 것을 의미합니다. 그들은 모델의 이러한 능력이 창발적이라고 믿습니다.

아이디어로서의 창발은 물리학, 생물학, 컴퓨터 과학과 같은 분야에서 오랫동안 논의되어 왔습니다. 이 논문은 Steinhardt의 연구에서 채택되고 1972년에 뿌리를 둔 창발의 일반적인 정의로 시작합니다. 노벨상 수상자이자 물리학자인 필립 앤더슨(Philip Anderson)이 쓴 Is Different는 다음과 같습니다.

이 기사에서는 학습 계산 및 모델 매개변수로 측정되는 모델 크기의 출현을 살펴봅니다. 구체적으로, 본 논문에서는 대규모 언어 모델의 창발적 역량을 소규모 모델에는 없지만 대규모 모델에는 존재하는 역량으로 정의합니다. 따라서 소규모 모델의 성능 향상을 단순히 추정하는 것만으로는 대규모 모델을 예측할 수 없습니다. 축소 모델. 이 연구는 다양한 이전 작업에서 관찰된 모델의 새로운 기능을 조사하고 이를 스몰샷 큐잉 및 강화된 큐잉과 같은 설정으로 분류합니다.

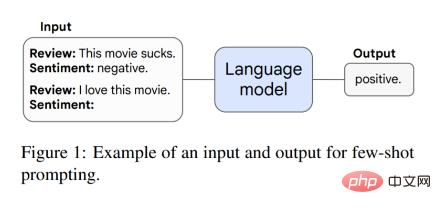

모델의 이러한 창발 기능은 이러한 기능을 획득하는 이유와 더 큰 규모가 더 창발적인 기능을 획득하는지 여부에 대한 향후 연구에 영감을 주고 이 연구의 중요성을 강조합니다. ㅋㅋㅋ 예를 들어, GPT-3 프롬프트에서 사전 훈련된 언어 모델 작업 프롬프트가 주어지면 모델은 추가 훈련이나 매개변수의 그라데이션 업데이트 없이 응답을 완료할 수 있습니다. 또한 Brown et al.은 모델 컨텍스트(입력)의 일부 입력 및 출력 예를 프롬프트(서문)로 사용한 다음 모델에 보이지 않는 추론 작업을 수행하도록 요청하는 소표본 프롬프트를 제안했습니다. 그림 1은 예시 프롬프트를 보여줍니다.

BIG-Bench: 그림 2A-D는 200개 이상의 언어 모델 평가 벤치마크 제품군인 BIG-Bench의 4가지 긴급 Few-Shot 프롬프트 작업을 보여줍니다. 그림 2A는 3자리 숫자의 덧셈과 뺄셈, 2자리 숫자의 곱셈을 테스트하는 산술 벤치마크를 보여줍니다. 표 1은 BIG-Bench의 더욱 새로운 기능을 보여줍니다.

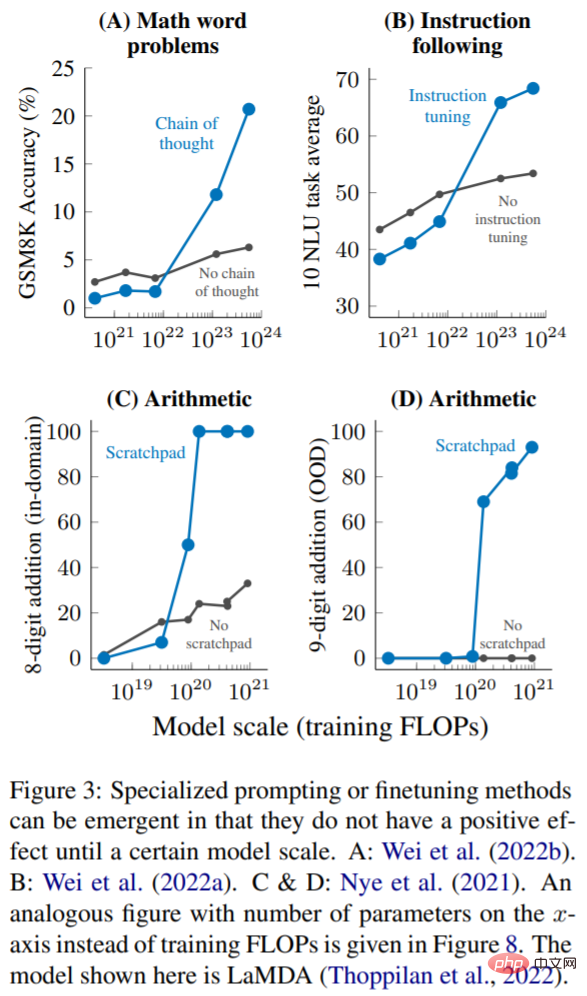

현재는 소규모 샘플 힌트가 대규모 언어 모델과 상호 작용하는 가장 일반적인 방법이지만 최근 연구에서는 언어 모델의 기능을 더욱 향상시키기 위해 몇 가지 다른 힌트와 미세 조정 전략을 제안했습니다. 또한 이 기사에서는 기술이 충분히 큰 모델에 적용되기 전에 개선되지 않거나 유해한 경우 새로운 기능으로 간주합니다.

다단계 추론: 추론 작업, 특히 다단계 추론과 관련된 작업은 항상 언어 모델과 NLP 모델에 있어 큰 도전이었습니다. 생각의 연쇄라고 불리는 최근의 프롬프트 전략을 사용하면 언어 모델이 최종 답변을 제공하기 전에 일련의 중간 단계를 생성하도록 안내하여 이러한 유형의 문제를 해결할 수 있습니다. 그림 3A에 표시된 대로 1023개의 훈련 FLOP(~100B 매개변수)로 확장할 때 사고 체인 프롬프트는 중간 단계 없이 표준 프롬프트만 능가했습니다.

명령(명령 따르기): 그림 3B에 표시된 것처럼 Wei et al.은 훈련 FLOP가 7·10^21(8B 매개변수) 이하일 때 명령 미세 조정 기술이 모델 성능에 해를 끼친다는 것을 발견했습니다. 훈련 FLOP를 10^23(~100B 매개변수)으로 확장하면 성능이 향상될 수 있습니다.

프로그램 실행: 그림 3C에 표시된 것처럼 8비트 추가의 도메인 내 평가에서 스크래치 패드를 사용하면 ~9 · 10^19 훈련 FLOP(40M 매개변수) 이상의 모델에만 도움이 됩니다. 그림 3D는 이러한 모델이 ~1.3 · 10^20 훈련 FLOP(100M 매개변수)에서 발생하는 도메인 외부 9비트 추가로 일반화될 수도 있음을 보여줍니다.

이 기사에서는 지금까지 특정 계산 규모에서만 의미 있는 성능이 관찰되었던 언어 모델의 새로운 힘에 대해 논의합니다. 모델의 이러한 새로운 기능은 다양한 언어 모델, 작업 유형 및 실험 시나리오에 걸쳐 있을 수 있습니다. 이러한 출현의 존재는 추가 확장이 언어 모델의 기능을 더욱 확장할 수 있음을 의미합니다. 이 능력은 최근 발견된 언어 모델 확장의 결과입니다. 그것이 어떻게 등장했는지, 그리고 더 많은 확장이 더 많은 창발 기능을 가져올지 여부는 NLP 분야에서 중요한 향후 연구 방향이 될 수 있습니다.

자세한 내용은 원문을 참고해주세요.

위 내용은 Jeff Dean 외의 신작: 언어 모델을 다른 각도에서 보면 규모가 충분히 크지 않아 발견할 수 없음의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!