"인공 지능: 현대적 접근 방식"의 네 번째 중국어 판이 최근 출시되었습니다. Machine Heart는 저자인 스튜어트 러셀 교수와 독점 인터뷰를 진행했습니다. AI 분야의 고전인 인공 지능: 현대적 접근 방식은 두 저자의 발전하는 이해를 반영하여 내용과 구조로 여러 번 재인쇄되었습니다. 최신 제4판은 지난 10년간 AI의 발전, 특히 딥러닝의 영향을 전체 틀에 접목한 최신 설명으로, 인공지능 동향과 주제 발전에 대한 두 거장의 통찰력을 반영한다. 체계.

이번 인터뷰 역시 "현대적인 접근"을 따르고 있으며, 기술의 발전과 시대에 걸맞는 관점에서 기술 동향, 지능 이론, 대중과 고전에 대한 러셀 교수의 생각을 보여주고자 하며, AI 연구자에게 통찰력을 제공하고 실무자에게 영감을 줍니다.

Stuart Russell은 University of California, Berkeley에서 근무하며 현재 컴퓨터 과학과 교수(전 학과장)이자 Center for Human-Compatible 소장으로 재직하고 있습니다. 인공 지능. 그는 1990년에 뛰어난 젊은 과학자를 위한 국립과학재단 대통령상을, 1995년에는 IJCAI 컴퓨팅 및 아이디어상을 받았습니다. 그는 AAAI, ACM 및 AAAS의 펠로우이며 인공 지능 분야에서 광범위한 주제를 다루는 300개 이상의 논문을 발표했습니다. 이미지 출처: kavlicenter.berkeley.edu

Russell 교수는 앞으로 10년 안에 사람들의 초점이 엔드 투 엔드 딥 러닝에 크게 의존하는 것에서 모듈식, 수학적 논리 기반 시스템으로 바뀔 것이라고 믿습니다. 의미론적으로 잘 정의된 표현으로 구성되며, 딥러닝은 원시 감각 데이터를 얻는 데 중요한 역할을 합니다. 의미론적으로 잘 정의된 모듈식 표현은 직접 설계하거나 유연하지 않아도 데이터에서 학습할 수 있다는 점을 강조하는 것이 중요합니다.

인기 있는 ChatGPT의 경우 Russell 교수는 작업 영역을 구별하고 어떤 상황에서 사용되는지 파악하는 것이 중요하다고 믿습니다. ChatGPT는 사실에 기반을 두고 다음과 결합할 수 있다면 좋은 도구가 될 수 있습니다. 기획 시스템을 통해 더 큰 가치를 선사하겠습니다. 문제는 현재 ChatGPT가 어떻게 작동하는지 알지 못하고 아마도 알아낼 수도 없을 것이라는 점입니다. 이를 위해서는 예측하기 어려운 몇 가지 개념적 혁신이 필요합니다.

그는 진정한 지능형 시스템을 구축하려면 수학적 논리와 지식 추론에 더 많은 관심을 기울여야 한다고 믿습니다. 왜냐하면 AI가 빠져나오지 않도록 우리가 이해하는 방법을 기반으로 시스템을 구축해야 하기 때문입니다. 통제의. 그는 규모 확장이 답이라고 믿지 않으며, 더 많은 데이터와 더 많은 컴퓨팅 성능이 문제를 해결할 수 있다고 믿지 않습니다. 이는 지나치게 낙관적이며 지적으로 흥미롭지 않습니다.

딥러닝 데이터의 비효율성이라는 근본적인 문제를 무시한다면, "우리가 진정한 지능을 향해 나아가고 있다고 스스로를 속이고 있는 것은 아닐까 걱정됩니다. 우리가 하는 모든 일은 실제로 전혀 지능적이지 않은 모델을 향한 것입니다. . 사물이 점점 더 많은 픽셀을 추가합니다. "

-1-

Machine Heart: ChatGPT로 대표되는 대규모 사전 학습 언어 모델(LLM)은 근본적으로 다르다고 생각하시나요? 지능을 다음 단계로? LLM은 상식 습득 및 지식 추론과 같은 딥 러닝 시스템의 몇 가지 근본적인 문제를 극복합니까?

스튜어트 러셀: 첫 번째로 떠오르는 대답은 – 우리는 모른다는 것입니다. 모델을 만든 사람을 포함하여 이 모델이 어떻게 작동하는지 아는 사람이 아무도 없기 때문입니다.

ChatGPT는 무엇을 알고 있나요? 추론할 수 있나요? 어떤 의미에서 대답을 이해합니까? 우리는 모른다.

오레곤 주립대학교에 다니는 친구가 모델에게 "코끼리와 고양이 중 어느 것이 더 크나요?"라고 물었고, 모델은 "코끼리가 더 큽니다"라고 답했지만 "어느 것이 더 크지 않습니까?"라고 또 다른 질문을 했습니다. 다른 것보다 코끼리인가요, 고양이인가요?" 모델은 "코끼리도 고양이도 둘 다 크지 않습니다."라고 답했습니다. 그러면 모델이 코끼리와 고양이 중 어느 것이 더 큰지 안다는 말씀이신가요? 다른 방식으로 질문하면 모순된 결론이 나올 것이기 때문에 모릅니다.

그럼 모델은 뭘 알까요?

또 다른 예를 들어보겠습니다. 이 예도 실제로 일어났습니다. 이러한 모델의 훈련 데이터에는 통합된 코드와 기호로 표시되는 수많은 체스 게임이 포함되어 있습니다. 게임은 시퀀스 e4 e5 Nf3 Nc6 Bb5...와 같습니다. 플레이어는 이러한 기호의 의미와 이러한 시퀀스로 묘사된 동작을 알고 있습니다. 하지만 모델은 체스판이 있다는 사실도 모르고, 움직임도 모릅니다. 모델에게 이러한 기호는 단지 기호일 뿐입니다. 따라서 블라인드 체스를 하고 "Let's play chess, g4"라고 말하면 "e6"이라고 응답할 수 있습니다. 물론 이것은 좋은 수일 수도 있지만 모델에는 체스 게임에 대한 개념이 없습니다. 훈련 데이터에서 유사한 시퀀스를 찾아 이러한 시퀀스에 대해 적절한 변환을 수행한 후 다음 동작을 생성합니다. 80% 또는 심지어 90%의 경우 좋은 수를 생성하지만 다른 경우에는 체스판에서 수를 두는 개념이 없기 때문에 어리석거나 규칙에 완전히 위배되는 수를 만듭니다.

체스를 두는 것뿐만 아니라 이것이 실제로 현재 대형 모델이 하고 있는 모든 것에 적용된다고 생각합니다. 80%의 경우 매우 똑똑한 사람처럼 보이지만 나머지 20%는 똑똑한 사람처럼 보입니다. 완전 바보.

지금까지 인간이 쓴 책과 기사를 거의 다 읽었기 때문에 똑똑해 보이지만, 그럼에도 불구하고 이렇게 엄청난 양의 유용한 정보를 받아들인 후에도 여전히 침을 뱉을 것입니다. 이름이 무엇인지 전혀 모르는 것들입니다. 그래서 이런 의미에서 대규모 언어 모델은 아마도 인공 지능의 발전이 아닐 것이라고 생각합니다.

ChatGPT에서 정말 인상적인 점은 일반화하고, 사용자와의 대화와 이전에 읽은 텍스트 사이의 유사점을 찾아 적절하게 변환하는 능력( )이므로 답변이 스마트해 보입니다. 그러나 우리는 모델이 이를 어떻게 수행하는지 모르고, 이 일반화 능력의 경계가 어디에 있는지 모르고, 이 일반화가 회로에서 어떻게 구현되는지 모릅니다.

정말 알면 인공지능의 발전이라고 할 수 있습니다. 이를 기반으로 사용할 수도 있고 ChatGPT를 기반으로 다른 시스템을 개발할 수도 있기 때문입니다. 하지만 이 단계에서는 모든 것이 미스터리로 남아있습니다. 앞으로 나아갈 수 있는 유일한 방법은 모델이 작동하지 않는 것뿐인가요? 좋아요, 더 많은 데이터를 제공하고 모델을 좀 더 크게 만들어 보겠습니다.

스케일업이 답은 아닌 것 같아요. 데이터는 결국 고갈될 것이고, 현실 세계에는 늘 새로운 상황이 일어나고 있습니다. 우리가 체스 프로그램을 작성할 때 실제로 체스를 잘 할 수 있는 프로그램은 이전에 볼 수 없었던 상황에 대처할 수 있습니다. 즉, 이러한 프로그램이 체스의 규칙을 이해하고 체스 말을 진화시킬 수 있다는 것입니다. 체스판의 위치(말이 움직일 수 있는 지점, 체스 게임에서는 볼 수 없는 움직임을 포함하여 상대방이 움직일 수 있는 지점)가 시각화됩니다.

일반적인 실제 상황에서는 아직까지 이를 수행할 수 없습니다. 동시에, 나는 언어의 큰 모델이 우리를 그 목표 달성에 더 가까이 다가가게 해준다고 생각하지 않습니다. 단, 언어의 대규모 모델을 사용하면 텍스트에 저장된 인간 지식을 사용할 수 있다고 말할 수 있습니다.

대규모 언어 모델은 알려진 사실에 고정시킬 수 있다면 더 유용할 것입니다. 5,000억 개의 사실이 있는 Google 지식 그래프를 생각해 보세요. ChatGPT가 이러한 사실에 기반을 두고 이러한 사실과 관련된 질문에 올바른 답변을 제공할 수 있다면 ChatGPT는 더욱 신뢰할 수 있을 것입니다.

추론과 계획을 올바르게 수행할 수 있는 추론 엔진에 대규모 언어 모델을 결합하는 방법을 찾을 수 있다면 인공 지능의 병목 현상을 돌파했다고 말할 수 있습니다. 현재 우리는 많은 계획 알고리즘을 보유하고 있지만 이러한 계획 알고리즘을 통해 자동차 제작과 같은 올바르고 합리적인 계획을 수행하고 필요한 지식을 제공하는 것은 어렵습니다. 그렇게 하는 것은 매우 어렵습니다. 그것들을 모두 적어서 모두 올바른지 확인하는 것은 어렵습니다. 그러나 언어 빅 모델은 자동차에 관한 모든 책을 읽었으며 필요한 지식을 구축하는 데 도움을 주거나 요청에 따라 필요한 질문에 간단히 답변하여 계획할 때 이 모든 지식을 포착할 수 있습니다.

ChatGPT를 무언가를 수행하는 데 도움이 되는 블랙박스로 보는 것과 비교하면 대규모 언어 모델을 계획 알고리즘과 결합하여 계획 시스템의 지식 입력이 되게 하면 정말 유용한 결과를 가져올 수 있습니다. 도구 . 내가 아는 한, 이미 이 방향으로 노력하는 사람들이 있고, 성공한다면 큰 진전이 될 것이다.

기계의 심장: 교사로서 ChatGPT에 대해 어떻게 생각하시나요? 학생들이 ChatGPT를 사용하여 논문을 생성하도록 허용하시겠습니까? 사용자로서 ChatGPT가 생성한 다양한 애플리케이션, 특히 상용 애플리케이션에 대해 어떻게 생각하시나요?

스튜어트 러셀: 몇 주 전 다보스에서 열린 세계경제포럼에서 사업가들과 이야기를 나누고 있었는데, 모두가 나에게 언어 빅 모델과 이를 문제 해결에 사용하는 방법에 대해 묻고 있었습니다. 회사에서는 이러한 모델을 사용합니다.

이렇게 생각하시면 될 것 같은데, 회사에서 6살짜리 아이를 같은 자리에 두시겠어요?

둘 사이에는 능력의 차이가 있지만 이렇게 비교할 수 있다고 생각합니다. 대규모 언어 모델과 ChatGPT는 신뢰할 수 없으며 상식이 없으며 심각한 방식으로 잘못된 정보를 제공합니다. 따라서 회사에서 ChatGPT 또는 유사한 모델을 사용하려면 매우 주의해야 합니다. 회사의 특정 직위나 책임을 네트워크의 노드로 생각하면 이 노드에서 언어가 입력되고 출력됩니다. 물론 언론인이나 교수 등 많은 직업에 대해서도 이렇게 생각할 수 있습니다. . 그런 것. 그러나 이것이 ChatGPT로 대체할 수 있다는 의미는 아닙니다.

우리는 교육에 있어서 매우 신중해야 합니다. ChatGPT의 출현으로 많은 사람들이 당황하게 되었습니다. 어떤 사람들은 아 학교에서 ChatGPT를 비활성화해야 한다고 말합니다. 다른 사람들은 학생들이 기계식 계산기를 사용하기 시작하면 결코 수학을 제대로 배울 수 없기 때문에 기계식 계산기를 금지해야 한다고 말한 19세기의 토론을 인용하면서 ChatGPT를 금지하는 것이 터무니없다고 말했습니다.

이 말이 설득력 있지 않나요? ChatGPT를 금지해야 할 것 같지 않나요? 그러나 이 비유는 완전히 잘못된 것입니다. 기계식 계산기는 정확히 동일한 기계적 프로세스를 자동화합니다. 26자리 숫자의 곱셈은 매우 기계적이며 일련의 지침이므로 답을 얻으려면 단계별로 단계를 따르기만 하면 됩니다. 지침을 따르는 것의 지적 가치는 제한적입니다. 특히 지침이 무엇인지 이해하지 못하는 경우에는 더욱 그렇습니다.

하지만 ChatGPT가 대체할 것은 기계적으로 지시를 따르는 것이 아니라 질문에 대답하는 능력, 읽고 이해하는 능력, 아이디어를 문서로 정리하는 능력입니다. 이런 것조차 배우지 않고 ChatGPT에 맡기면 정말 쓸모없는 사람이 될 수 있습니다.

이제 전자 계산기가 있지만 우리는 여전히 아이들에게 산수를 가르치고, 산술 규칙을 가르치고, 숫자가 무엇인지, 숫자가 물리적 세계의 사물과 어떻게 대응하는지 등을 이해하도록 노력합니다. 그들이 이러한 이해를 얻고 산술 규칙을 숙지한 후에야 우리는 그들에게 전자 계산기를 제공하여 그들이 기계적인 절차를 따를 필요가 없도록 할 것입니다.

당시에는 계산기가 없었습니다. 다양한 사인, 코사인 및 로그 함수 값이 인쇄된 표를 사용했습니다. 수학.

따라서 학생들이 ChatGPT와 같은 도구를 사용하기 시작하기에 적절한 시기가 언제인지 파악해야 합니다. 귀하의 질문에 대답하자면, 논문 작성 작업에서 두뇌 없는 부분을 찾을 수 있다면 실제로 논문 작성이 무의미하고 지루하고 지루한 프로세스를 기계적으로 반복하는 경우가 많이 있습니다. 그렇다면 아마도 ChatGPT를 사용할 수 있고 나는 그것에 아무런 문제가 없습니다.

그러나 글쓰기가 모두 지루한 과정은 아닙니다. 글쓰기는 본질적으로 일종의 사고이자 사람들이 사고하는 법을 배우는 방법입니다. 우리가 원하는 마지막 것은 질문도 대답도 이해하지 못하는 ChatGPT를 맹목적으로 사용하는 사람입니다.

그림이나 음악 생성 등 ChatGPT의 다른 애플리케이션도 상황은 비슷하다고 생각합니다. 작업 영역을 명확하게 구분하는 것이 핵심입니다. 예술을 창작하는 과정은 크게 두 부분으로 나눌 수 있다고 생각합니다. 첫째는 무엇을 만들고 싶은지에 대한 아이디어를 갖고, 둘째는 자신의 비전을 바탕으로 실제로 그것을 창작하는 비교적 기계적인 과정입니다. 어떤 사람들에게는 후자가 매우 어렵고 아무리 노력해도 보기 좋은 그림을 만들 수 없기 때문에 특별히 훈련된 예술가, 특히 상업 예술가의 작업에는 창의성이 별로 필요하지 않아 더 많은 관심을 기울이고 있습니다. 필요에 따라 사진을 제작하는 능력. 굉장히 위협받는 직업인 것 같아요.

책을 쓸 때 이런 경험을 했습니다. 『인공지능: 현대적 접근』에는 500~600개의 삽화가 있는데 거의 전부 제가 직접 그렸습니다. 좋은 일러스트레이션이나 다이어그램을 만드는 것은 많은 기술과 기술이 필요한 느리고 힘든 과정입니다. 내 책에 나오는 것과 같은 다이어그램이나 기술 일러스트레이션을 생성하는 대형 모델이나 애플리케이션이 있다면 기꺼이 사용하겠습니다.

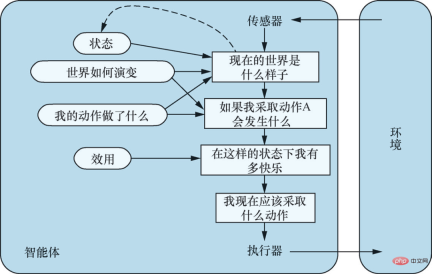

모델 기반, 유틸리티 기반 에이전트. 출처: "인공 지능: 현대적 접근 방식(4판)" 삽화 2-14

일반 학습 에이전트. 출처: "Artificial Intelligence: Modern Methods(4th Edition)" 그림 2-15

-2-

기계의 심장: ChatGPT의 원리는 모르지만 엔지니어링 구현을 통해 우리는 어떤 상황에서 유용한 도구를 얻었습니다. ChatGPT도 사람들을 루프에 참여시키는 좋은 예인 것 같습니다. ChatGPT는 엔지니어링 관점에서 개선된 것인가요?

Stuart Russell: ChatGPT를 공학이라고 부를 수 있는지 잘 모르겠습니다. 일반적으로 우리는 "공학"을 공학 과학을 적용하고 물리학, 화학 및 역학을 결합하는 학문으로 생각하기 때문입니다. . 전자공학과 기타 지식이 결합되어 복잡하고 독창적인 방식으로 인간에게 유용한 무언가를 만들어냅니다. 동시에 우리는 이러한 것들이 유용한 이유를 이해합니다. 그 유용한 특성은 특정 방법을 통해 달성되고 재현될 수 있기 때문입니다.

그런데 ChatGPT는 어떻게 개발한 걸까요? 사람의 피드백을 반영하는 것도 유용하지만, 결과로 볼 때 ChatGPT는 수많은 데이터 세트에 대해 경사하강법을 수행하여 얻은 것입니다. 이는 유전 프로그래밍에 많은 노력을 기울인 1950년대를 생각나게 하며, 생물학적 진화를 시뮬레이션하여 지능을 달성하고자 했던 포트란 프로그램은 비참하게 실패했습니다.

이론적으로 충분한 포트란 프로그램이 있고 충분한 돌연변이를 생성하게 하면 원칙적으로 인간보다 똑똑한 포트란 프로그램을 생성하는 것이 가능합니다. 그러나 원칙적으로 이러한 가능성은 실제로 실현되지 않았습니다.

이제 충분히 큰 회로와 충분한 데이터에서 경사하강법을 수행하면 갑자기 실제 지능을 만들 수 있다고요? 나는 그것이 발전하는 Fortran 프로그램보다 조금 더 가능성이 없다고 생각합니다. 그러나 Fortran 프로그램이 회로보다 더 강력한 기능을 가진 일종의 표현이라고 생각할 이유가 있기 때문에 Fortran 프로그램이 더 가능성이 있다고 말할 수는 없습니다. 그들이 1958년에 포트란 프로그램을 포기했을 때 컴퓨팅 능력은 오늘날 우리가 갖고 있는 것보다 15~16배 정도 낮았습니다.

Machine Heart: "프로젝트"라는 단어를 사용하지 않고 OpenAI가 하는 일에 대해 어떻게 생각하시나요?

Stuart Russell: OpenAI가 하는 일은 Cookery라고 부를 수 있습니다. 왜냐하면 우리는 이러한 모델이 어떻게 작동하는지 모르기 때문입니다. 내가 케이크를 만들 때 어떻게 케이크가 되었는지는 알 수 없지만, 인간은 수천 년 동안 수많은 경사하강법을 거쳐 다양한 원료와 방법을 시도해 왔습니다. , 어느 날 나는 마법 같은 것을 발견했습니다. 바로 케이크, 그것이 바로 요리였습니다. 이제 우리는 케이크의 기본 원리에 대해 조금 더 알게 되었지만 여전히 완벽하지는 않습니다. 요리를 통해 얻을 수 있는 것은 한계가 있으며 그 과정은 지적 가치가 크지 않습니다.

만약 어느 날 ChatGPT의 근본적인 문제로 인해 프롬프트나 지침을 입력해도 원하는 답변을 얻을 수 없다면 어떻게 될까요? 레시피를 다시 수정하시겠습니까? 토큰을 4000에서 5000으로 늘리고 네트워크 레이어 수를 두 배로 늘리시겠습니까? 그것은 과학도 아니고 지적으로 흥미롭지도 않다고 생각합니다.

언어 작업의 대규모 모델을 이해하려는 연구는 확실히 가치가 있습니다. 왜냐하면 ChatGPT는 엄청난 양의 일반화를 수행하고 있으며 이것이 어떻게 발생하는지 파악해야만 실제로 의미 있는 지능 시스템을 개발할 수 있기 때문입니다. 현재 이에 대해 많은 사람들이 연구하고 있으며 이에 대한 많은 논문이 출판되었습니다.

하지만 ChatGPT의 내부 메커니즘을 이해할 수 있는지 여부는 말하기 어려운 것 같습니다. 너무 복잡할 수 있으며 내부에서 무슨 일이 일어나고 있는지 리버스 엔지니어링할 방법이 없습니다.

흥미로운 비유는 3만년 전 인간과 개 사이에 일어난 일입니다. 우리는 개의 뇌가 어떻게 작동하는지 이해하지 못하고, 개가 무엇을 생각하는지 정확히 파악하기 어렵지만, 길들이는 법을 배웠고, 이제 개는 우리 삶에 통합되어 다양한 귀중한 역할을 하고 있습니다. 우리는 개가 집을 돌보고 아이들과 놀아주는 것을 포함하여 많은 일에 능숙하다는 것을 발견했지만 공학을 통해 그렇게 하는 것이 아니라 번식과 공식 조정을 통해 이러한 특성을 선택하고 향상시킵니다. 그러나 당신은 당신의 개가 당신을 위해 기사를 써줄 것이라고 기대하지 않을 것이고, 그들이 그렇게 할 수 없다는 것을 알고 있으며, 아마도 당신의 개도 그렇게 할 것이라고 기대하지 않을 것입니다.

ChatGPT 이 모든 것에서 놀라운 점은 AI 시스템이 실제로 대중의 눈에 들어온 것은 이번이 처음이라고 생각하는데, 이는 큰 변화입니다. OpenAI 자체에는 좋은 말이 있습니다. 즉, ChatGPT는 실제 지능은 아니지만 인체가 실제(인공) 지능의 실현을 맛볼 수 있게 하고, 누구나 그 지능을 사용하여 원하는 모든 종류의 작업을 수행할 수 있다는 것입니다. .

Heart of the Machine: 많은 사람들이 우려하는 또 다른 점은 LLM이 가져오는 중간 작업의 소멸입니다. 의미론적 분석, 구문 분석과 같은 중간 작업이 기술적인 반복 관점에서 현재 많은 가치를 갖고 있다고 생각하시나요? 그리고 미래에는 실제로 사라질까요? 강력한 하드웨어 자원이나 강력한 도메인 지식이 없는 중간에 있는 AI 연구자와 실무자는 일자리를 잃을 위험에 처해 있습니까?

스튜어트 러셀: 좋은 질문이군요. 사실은 현재 의미 분석에 관한 논문을 출판하는 것이 어렵고 실제로 언어의 큰 모델에 대해 이야기하거나 큰 모델로 큰 벤치마크를 새로 고치지 않는 한 NLP 커뮤니티의 사람들이 무엇이든 듣도록 하는 것이 어렵습니다. 거의 모든 논문이 언어 구조나 언어 이해나 의미 분석, 구문 분석 등 빅 벤치마크를 새로 고치는 내용이 아닌 논문을 출판하기 어렵기 때문에 대형 모델을 평가하는 데에는 빅 벤치마크가 필요합니다. 논문 작성을 위한 유일한 선택이 되었으며 이러한 큰 벤치마크는 언어와는 아무런 관련이 없습니다.

어떤 의미에서 오늘날 자연어 처리 분야에서 우리는 더 이상 언어를 공부하지 않는다는 점은 매우 불행한 일이라고 생각합니다. 오늘날 대부분의 컴퓨터 비전 연구에서는 더 이상 비전을 연구하지 않고 데이터, 훈련 및 예측 정확도만 연구합니다.

다음 AI 개발 방법은 지식과 논리적 추론에 중점을 두고 우리가 이해할 수 있는 방법에 중점을 두어야 한다고 생각합니다. 그 이유는 두 가지입니다. 첫째, 우리는 AI 시스템이 신뢰할 수 있기를 원하고, 그것이 안전하고 제어 가능하다는 것을 수학적으로 보장해야 하며, 이는 우리가 구축하고 있는 시스템을 이해해야 함을 의미합니다.

두 번째로, 인간의 두뇌가 20메가와트가 아닌 20와트에서 작동하는 일반 지능을 달성하려면 필요한 데이터 효율성 관점에서 생각해 보세요. 회로는 표현력이 뛰어난 언어가 아니며, 이러한 알고리즘의 데이터 효율성은 인간 학습보다 훨씬 낮으며, 회로 세계에 대해 우리가 알고 있는 많은 내용을 기록하는 데 어려움을 겪을 것입니다. 범용 컴퓨터와 프로그래밍 언어가 생기면 우리는 프로그램에서 원하는 것을 표현하는 것이 훨씬 더 간단하고 쉽기 때문에 회로 사용을 중단했습니다. AI 커뮤니티는 어느 시점에서 많은 사람들이 이를 거의 잊어버렸습니다. 길을 잃었다.

-3-

기계의 심장: "인공 지능: 현대적 접근 방식"의 제4판에는 더 이상 AI 시스템이나 에이전트가 고정된 목표를 가지고 있다고 가정하지 않는다는 중요한 업데이트가 있습니다. 이전에는 인공지능의 목적을 '인간이 설정한 목표를 바탕으로 기대 효용을 극대화하는 시스템을 만드는 것'으로 정의했는데, 이제는 더 이상 AI 시스템에 대한 목표를 설정하지 않습니다.

스튜어트 러셀: 여러 가지 이유가 있습니다. 첫째, 인공지능이 실험실을 벗어나 현실 세계로 이동함에 따라 우리의 목표를 완전히 정확하게 정의하는 것이 어렵다는 것을 알게 되었습니다. 예를 들어, 도로를 운전할 때 목적지에 빨리 도착하고 싶지만 시속 200마일로 운전해야 한다는 뜻은 아니며, 자율주행차에게 안전을 최우선으로 하라고 하면, 결국 차고 안에 영원히 주차될 수도 있습니다. 목적지까지 안전하고 신속하게 도착하는 것, 다른 운전자에게 친절하게 대하는 것, 승객을 불편하게 하지 않는 것, 법률 및 규정을 준수하는 것 등의 목표 사이에는 균형이 있습니다. 도로에는 항상 위험이 따르며, 피할 수 없는 사고도 발생하기 마련입니다. 운전을 할 때 목표를 모두 적어두기는 어렵고, 운전은 인생에서 작고 단순한 일일 뿐입니다. 따라서 실용적인 관점에서 볼 때 AI 시스템에 대한 목표를 설정하는 것은 불합리합니다.

두 번째는 책에서 제가 제시한 미다스 왕의 사례(미다스 왕 문제)와 관련이 있습니다. 그리스 신화에 나오는 왕은 욕심이 많아 신에게 모든 것을 금으로 바꿀 수 있는 능력을 달라고 간청했는데 신은 그가 만지는 모든 것을 금으로 바꾸었지만 나중에는 그의 목표를 이루었습니다. 그도 금으로 변했고, 그의 가족들도 그에게 닿은 후 금으로 변했습니다. 마침내 그는 금에 둘러싸여 비극적으로 죽었습니다. 이는 매우 강력한 시스템에 대한 목표를 정의할 때 정의한 목표가 절대적으로 올바른지 확인하는 것이 더 좋다는 점을 상기시켜 줍니다. 그러나 이제 우리는 그렇게 할 수 없다는 것을 알고 있으므로 AI 시스템이 더욱 강력해지면서 진정한 목표가 무엇인지 알지 못하는 것이 점점 더 중요해지고 있습니다.

목표는 실제로 매우 복잡한 것입니다. 예를 들어 점심으로 오렌지를 사고 싶다고 하면 그게 목표가 될 수도 있겠죠? 일상적인 맥락에서 목표는 달성할 수 있는 것으로 간주되며 일단 달성되면 완료됩니다. 그러나 철학과 경제학이 정의하는 합리적 선택 이론에는 그러한 목표가 없습니다. 우리가 가지고 있는 것은 다양한 가능한 미래의 선호도나 순위입니다. 각각의 가능한 미래는 우주의 모든 것을 포함합니다. 목적, 즉 인간이 진정으로 원하는 것이 무엇인지에 대한 더 복잡하고 깊은 이해라고 생각합니다.

기계의 심장: 이러한 변화가 인공 지능의 미래 발전에 어떤 영향을 미칠까요?

스튜어트 러셀: 1940년대와 1950년대 컴퓨터 과학을 통해 인공지능이 탄생한 이후, 연구자들은 이를 바탕으로 연구를 수행하기 위해 지능에 대한 개념을 가질 필요가 있었습니다. 초기 작업 중 일부는 인간의 인지를 모방하는 것에 관한 것이었지만 궁극적으로 승리한 것은 합리성의 개념이었습니다. 기계가 행동을 통해 의도한 목표를 더 많이 달성할수록 우리는 기계를 더 지능적으로 간주합니다.

인공 지능의 표준 모델에서 이는 우리가 만들려고 노력하는 기계 유형입니다. 인간이 목표를 정의하고 기계가 나머지 작업을 수행합니다. 예를 들어, 결정론적 환경의 솔루션 시스템의 경우 확률론적 환경의 강화 학습 시스템에 대한 목표 상태를 달성하기 위해 기계가 최소 비용으로 작업 시퀀스를 찾을 수 있도록 비용 함수와 목표 기준을 제공합니다. 보상 함수와 할인 요소를 제공하여 기계가 예상되는 할인 보상 합계를 최대화하는 전략을 학습하도록 합니다. 이러한 접근 방식은 인공 지능 분야 외부에서도 볼 수 있습니다. 제어 과학자는 비용 함수를 최소화하고, 운영 연구원은 보상을 극대화하고, 통계학자는 예상 손실 함수를 최소화하고, 경제학자는 개인의 효용이나 그룹의 복지를 극대화합니다.

하지만 표준 모델은 실제로 잘못되었습니다. 방금 말했듯이 목표를 완전히 정확하게 지정하는 것은 거의 불가능하며, 기계의 목표가 우리가 실제로 원하는 것과 일치하지 않으면 기계가 선제적으로 조치를 취하고 무엇이든 수행하기 때문에 기계에 대한 통제력을 잃을 수 있습니다. 가격은 명시된 목표를 달성하도록 보장합니다. 기존의 거의 모든 AI 시스템은 표준 모델의 프레임워크 내에서 개발되므로 큰 문제가 발생합니다.

"Artificial Intelligence: Modern Approach(4th Edition)"에서는 인공지능에 새로운 모델이 필요하다고 제안했는데, 새 모델은 AI 시스템의 목표가 불확실하다는 점을 강조합니다. 인간의 선호도를 배우고 행동을 취하기 전에 인간의 의견을 구합니다. AI 시스템이 작동하는 동안 인간의 목표가 일단 설정되면 무의미해지는 것이 아니라 인간의 진정한 선호를 보여주는 일부 정보가 인간에서 기계로 흘러야 합니다. 이를 위해서는 고정된 목표에서 기계를 분리하고 기계와 인간 사이의 이진 결합이 필요합니다. 표준 모델은 기계가 바둑을 두거나 퍼즐을 푸는 등 인간이 원하는 목표를 기계의 범위 내에서 완전히 정확하게 지정할 수 있는 극단적인 경우로 생각할 수 있습니다.

또한 불확실한 선호도, 스위치 끄기 문제, 지원 게임 등과 같은 새 모델의 작동 방식을 설명하기 위해 책에 몇 가지 예를 제공합니다. 그러나 이것은 단지 시작일 뿐이며 우리는 이제 막 연구를 시작했을 뿐입니다.

기계의 심장: 빠르게 발전하는 인공 지능 분야에서 맹목적으로 핫스팟을 쫓지 않고 기술 동향을 따라잡을 수 있는 방법은 무엇일까요? AI 연구자와 실무자는 무엇을 명심해야 할까요?

스튜어트 러셀: 진정한 지능형 시스템을 구축하려면 근본적인 문제는 표현 언어를 사용하여 우주에 포함된 다양한 불규칙성을 표현할 수 있어야 한다고 생각합니다. 지능과 회로의 본질적인 차이점은 우리가 아는 한 회로는 실제로 데이터의 극도의 비효율성을 나타내는 불규칙성을 잘 표현할 수 없다는 것입니다.

간단한 예를 들기 위해 사인 함수의 정의를 (수학적 공식으로) 적어볼 수도 있고, 많은 수의 픽셀을 사용하여 경험적으로 사인 함수를 설명하려고 시도할 수도 있습니다. 1000만 픽셀만 가지고 있다면 사인 함수의 일부만 커버할 수 있고, 커버한 영역을 보면 사인 함수의 꽤 좋은 모델이 있는 것 같습니다. 하지만 사실 저는 사인 함수를 잘 이해하지 못하고, 함수의 모양도 모르고, 수학적 성질도 모릅니다.

우리가 진정한 지능을 향해 나아가고 있다고 스스로를 속이고 있는 것은 아닌지 걱정됩니다. 우리가 실제로 하고 있는 일은 전혀 스마트 모델이 아닌 것에 점점 더 많은 픽셀을 추가하는 것뿐입니다.

AI 시스템을 구축할 때 기본적인 표현 능력을 갖춘 메소드에 집중해야 한다고 생각하는데, 그 핵심은 모든 객체를 선언할 수 있다는 점입니다. Go의 규칙을 적고 싶다고 가정해 보겠습니다. 그러면 이 규칙은 보드의 모든 사각형에 적용되어야 합니다. 각 x에 대해 각 y에 어떤 일이 일어날지 말할 수 있습니다. C++나 Python을 사용할 수도 있습니다. 영어로 작성되었으며 1차 논리로 작성되었습니다. 이들 언어 각각은 규칙을 표현하는 표현력을 갖고 있기 때문에 매우 간결하게 규칙을 적을 수 있게 해줍니다. 그러나 회로 기반 표현(딥 러닝 시스템 포함)은 이러한 종류의 일반화를 표현할 수 없습니다.

이 사실을 무시하고 빅 데이터를 통해 지능을 얻으려는 것은 내 생각에는 수십억 개의 훈련 샘플이 있기 때문에 바둑 조각이 무엇인지 이해할 필요가 없다고 말하는 것과 같습니다. 인간 지능이 한 일을 생각해 보면 우리는 LIGO를 구축하고 우주 반대편에서 중력파를 감지했습니다. 우리는 어떻게 했나요? 지식과 추론을 기반으로합니다. LIGO를 구축하기 전에 훈련 샘플을 어디에서 수집했습니까? 분명히 선배들은 감각적 경험을 포함해 몇 가지를 배웠고, 그것을 영어, 수학 등의 표현언어로 기록했습니다. 설계 등을 통해 우주 반대편 끝에서 블랙홀 충돌을 관찰합니다.

물론, 빅데이터를 기반으로 지능을 이루는 것도 가능합니다. 인간보다 똑똑한 포트란 프로그램을 진화시키는 것도 가능합니다. 그러나 우리는 지식과 추론을 이해하는 데 2000년이 넘는 시간을 투자해 왔으며, 지식과 추론을 기반으로 한 수많은 우수한 기술을 개발해 왔으며, 이러한 기술을 기반으로 수천 개의 유용한 응용 프로그램이 개발되었습니다. 이제 당신은 지능에 관심이 있지만 지식과 추론에는 관심이 없습니다. 나는 그것에 대해 말할 것이 없습니다.

위 내용은 스튜어트 러셀(Stuart Russell)과의 인터뷰: ChatGPT에 관해 더 많은 데이터와 더 많은 컴퓨팅 성능이 실제 지능을 가져올 수는 없습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

ai合并图层的快捷键是什么Jan 07, 2021 am 10:59 AM

ai合并图层的快捷键是什么Jan 07, 2021 am 10:59 AMai合并图层的快捷键是“Ctrl+Shift+E”,它的作用是把目前所有处在显示状态的图层合并,在隐藏状态的图层则不作变动。也可以选中要合并的图层,在菜单栏中依次点击“窗口”-“路径查找器”,点击“合并”按钮。

ai橡皮擦擦不掉东西怎么办Jan 13, 2021 am 10:23 AM

ai橡皮擦擦不掉东西怎么办Jan 13, 2021 am 10:23 AMai橡皮擦擦不掉东西是因为AI是矢量图软件,用橡皮擦不能擦位图的,其解决办法就是用蒙板工具以及钢笔勾好路径再建立蒙板即可实现擦掉东西。

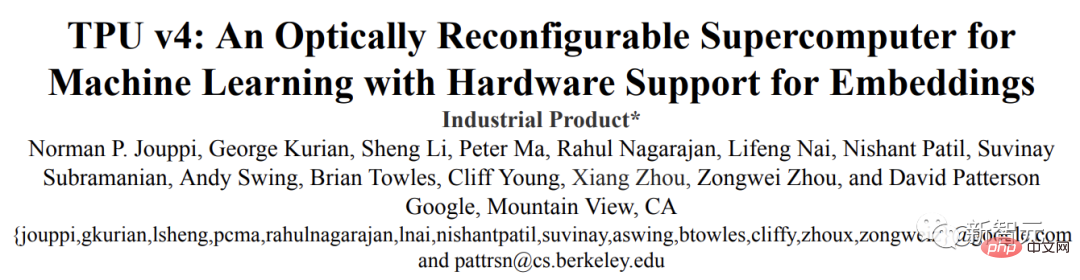

谷歌超强AI超算碾压英伟达A100!TPU v4性能提升10倍,细节首次公开Apr 07, 2023 pm 02:54 PM

谷歌超强AI超算碾压英伟达A100!TPU v4性能提升10倍,细节首次公开Apr 07, 2023 pm 02:54 PM虽然谷歌早在2020年,就在自家的数据中心上部署了当时最强的AI芯片——TPU v4。但直到今年的4月4日,谷歌才首次公布了这台AI超算的技术细节。论文地址:https://arxiv.org/abs/2304.01433相比于TPU v3,TPU v4的性能要高出2.1倍,而在整合4096个芯片之后,超算的性能更是提升了10倍。另外,谷歌还声称,自家芯片要比英伟达A100更快、更节能。与A100对打,速度快1.7倍论文中,谷歌表示,对于规模相当的系统,TPU v4可以提供比英伟达A100强1.

ai可以转成psd格式吗Feb 22, 2023 pm 05:56 PM

ai可以转成psd格式吗Feb 22, 2023 pm 05:56 PMai可以转成psd格式。转换方法:1、打开Adobe Illustrator软件,依次点击顶部菜单栏的“文件”-“打开”,选择所需的ai文件;2、点击右侧功能面板中的“图层”,点击三杠图标,在弹出的选项中选择“释放到图层(顺序)”;3、依次点击顶部菜单栏的“文件”-“导出”-“导出为”;4、在弹出的“导出”对话框中,将“保存类型”设置为“PSD格式”,点击“导出”即可;

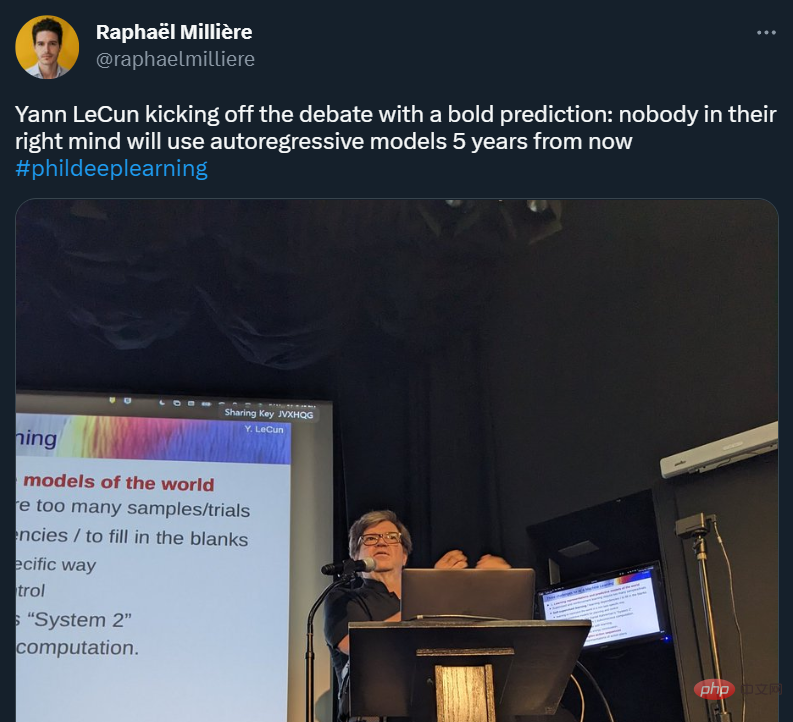

GPT-4的研究路径没有前途?Yann LeCun给自回归判了死刑Apr 04, 2023 am 11:55 AM

GPT-4的研究路径没有前途?Yann LeCun给自回归判了死刑Apr 04, 2023 am 11:55 AMYann LeCun 这个观点的确有些大胆。 「从现在起 5 年内,没有哪个头脑正常的人会使用自回归模型。」最近,图灵奖得主 Yann LeCun 给一场辩论做了个特别的开场。而他口中的自回归,正是当前爆红的 GPT 家族模型所依赖的学习范式。当然,被 Yann LeCun 指出问题的不只是自回归模型。在他看来,当前整个的机器学习领域都面临巨大挑战。这场辩论的主题为「Do large language models need sensory grounding for meaning and u

ai顶部属性栏不见了怎么办Feb 22, 2023 pm 05:27 PM

ai顶部属性栏不见了怎么办Feb 22, 2023 pm 05:27 PMai顶部属性栏不见了的解决办法:1、开启Ai新建画布,进入绘图页面;2、在Ai顶部菜单栏中点击“窗口”;3、在系统弹出的窗口菜单页面中点击“控制”,然后开启“控制”窗口即可显示出属性栏。

ai移动不了东西了怎么办Mar 07, 2023 am 10:03 AM

ai移动不了东西了怎么办Mar 07, 2023 am 10:03 AMai移动不了东西的解决办法:1、打开ai软件,打开空白文档;2、选择矩形工具,在文档中绘制矩形;3、点击选择工具,移动文档中的矩形;4、点击图层按钮,弹出图层面板对话框,解锁图层;5、点击选择工具,移动矩形即可。

强化学习再登Nature封面,自动驾驶安全验证新范式大幅减少测试里程Mar 31, 2023 pm 10:38 PM

强化学习再登Nature封面,自动驾驶安全验证新范式大幅减少测试里程Mar 31, 2023 pm 10:38 PM引入密集强化学习,用 AI 验证 AI。 自动驾驶汽车 (AV) 技术的快速发展,使得我们正处于交通革命的风口浪尖,其规模是自一个世纪前汽车问世以来从未见过的。自动驾驶技术具有显着提高交通安全性、机动性和可持续性的潜力,因此引起了工业界、政府机构、专业组织和学术机构的共同关注。过去 20 年里,自动驾驶汽车的发展取得了长足的进步,尤其是随着深度学习的出现更是如此。到 2015 年,开始有公司宣布他们将在 2020 之前量产 AV。不过到目前为止,并且没有 level 4 级别的 AV 可以在市场

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

Eclipse용 SAP NetWeaver 서버 어댑터

Eclipse를 SAP NetWeaver 애플리케이션 서버와 통합합니다.

에디트플러스 중국어 크랙 버전

작은 크기, 구문 강조, 코드 프롬프트 기능을 지원하지 않음

Dreamweaver Mac版

시각적 웹 개발 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

VSCode Windows 64비트 다운로드

Microsoft에서 출시한 강력한 무료 IDE 편집기