추론 속도는 Stable Diffusion보다 2배 빠릅니다. Visual Transformer는 이미지 텍스트를 통합합니다.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB앞으로

- 2023-04-13 23:55:011595검색

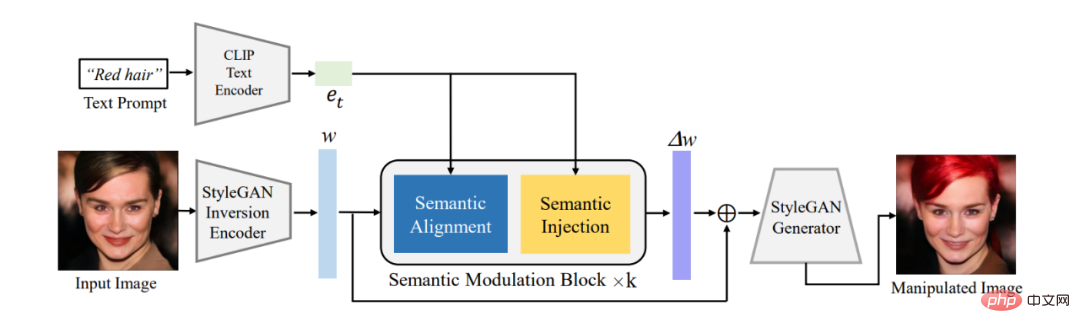

논문 1: 모두 편집할 수 있는 단일 모델: 의미론적 변조를 사용한 자유 형식 텍스트 기반 이미지 조작

- 저자: Yiming Zhu, Hongyu Liu 등

- 논문 주소: https: //arxiv.org/pdf/2210.07883.pdf

요약: 이 기사에서는 먼저 기존 인코더를 사용하여 편집해야 하는 이미지를 W^+ 의미 체계의 잠재 인코딩 w로 변환합니다. StyleGAN의 공간을 이용하여 제안된 의미 변조 모듈을 통해 잠재 코딩을 적응적으로 변조한다. 의미론적 변조 모듈은 의미론적 정렬과 의미론적 주입 모듈을 포함합니다. 먼저 어텐션 메커니즘을 통해 GAN의 텍스트 인코딩과 잠재 인코딩 간의 의미론을 정렬한 다음 텍스트 정보를 정렬된 잠재 인코딩에 주입하여 Cain 인코딩이 소유하는지 확인합니다. 텍스트를 사용하여 이미지를 편집할 수 있는 기능을 제공합니다.

클래식 StyleCLIP 모델과 달리 우리 모델은 각 텍스트에 대해 별도의 모델을 훈련할 필요가 없습니다. 하나의 모델이 여러 텍스트에 응답하여 이미지를 효과적으로 편집할 수 있으므로 모델은 FFCLIP-Free Form Text-Driven Image Manipulation이 됩니다. . 동시에 우리 모델은 고전적인 교회, 얼굴 및 자동차 데이터 세트에서 매우 좋은 결과를 얻었습니다.

그림 1: 전체 프레임워크 다이어그램

권장 사항: 텍스트 및 그림 편집의 새로운 패러다임, 단일 모델은 다중 텍스트 안내 이미지 편집을 실현합니다.

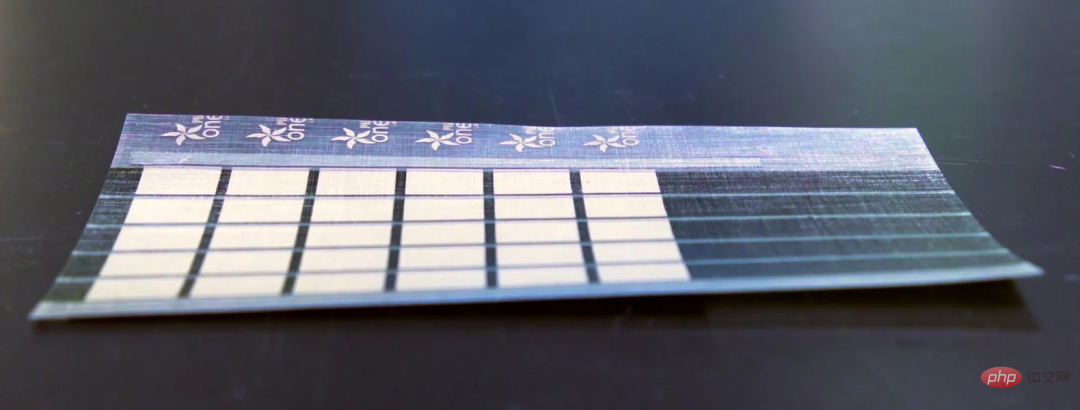

논문 2: 추가 전원으로 전사 가능한 초박형 기판에 인쇄된 유기 광전지 모듈

- 저자: Mayuran Saravanapavanantham, Jeremiah Mwaura 등

- 문서 주소: https: // onlinelibrary.wiley.com/doi/10.1002/smtd.202200940

요약: MIT 연구원들은 초박형, 경량 태양전지를 생산할 수 있는 확장 가능한 제조 기술을 개발했습니다. 어떤 표면에서도.

MIT 연구원들은 사람의 머리카락보다 얇고 현재 유리 및 실리콘 기반 태양광 패널보다 킬로그램당 18배 더 많은 에너지를 제공하는 태양광 패널을 만들었습니다. 이 태양광 패널의 무게는 기존 광전지의 1%에 불과합니다.

이 초박형 태양광 패널은 돛, 드론 날개, 텐트에도 설치할 수 있습니다. 특히 외딴 지역과 재난 구호 활동에 유용합니다.

추천: MIT는 종이처럼 얇은 태양전지판을 만듭니다.

논문 3: 수학적 추론을 위한 딥 러닝 조사

- 저자: Pan Lu, Liang Qiu 등

- 논문 주소: https://arxiv.org/ pdf/ 2212.10535.pdf

요약:최근 발표된 보고서에서 UCLA 및 기타 기관의 연구자들은 수학적 추론에서 딥 러닝의 진행 상황을 체계적으로 검토했습니다.

특히 이 문서에서는 다양한 작업과 데이터 세트(섹션 2)에 대해 논의하고 수학 분야의 신경망(섹션 3) 및 사전 훈련된 언어 모델(섹션 4)의 발전을 검토합니다. 수학적 추론에서 대규모 언어 모델의 상황별 학습의 급속한 발전도 탐구됩니다(섹션 5). 이 기사에서는 기존 벤치마크를 추가로 분석하고 다중 모드 및 저자원 환경에 대한 관심이 덜하다는 사실을 발견했습니다(섹션 6.1). 증거 기반 연구에 따르면 현재의 컴퓨팅 기능 표현은 부적절하고 딥러닝 방법은 수학적 추론과 일치하지 않는 것으로 나타났습니다(6.2절). 그런 다음 저자는 일반화 및 견고성, 신뢰할 수 있는 추론, 피드백을 통한 학습 및 다중 모드 수학적 추론 측면에서 현재 작업의 개선 사항을 제안합니다(섹션 7).

추천: 딥 러닝이 수학적 추론의 문을 천천히 여는 방법.

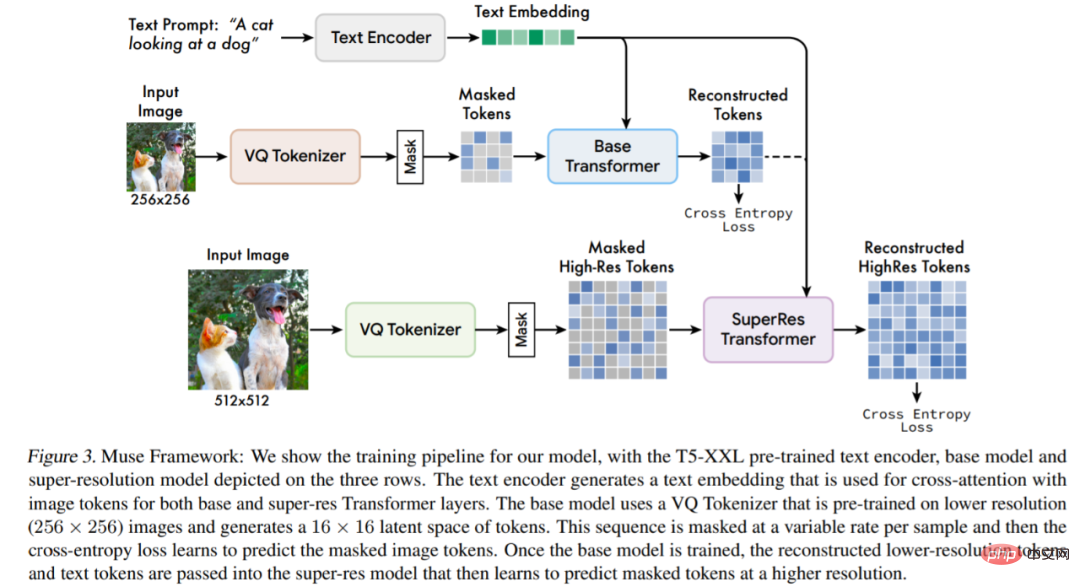

논문 4: Muse: Masked Generative Transformers를 통한 텍스트-이미지 생성

- 저자: Huiwen Chang, Han Zhang 등

- 논문 주소: https:// arxiv.org/pdf/2301.00704v1.pdf

요약: 이 연구는 마스크된 이미지 모델링 접근 방식을 사용하여 텍스트-이미지 합성을 위한 새로운 모델을 제안합니다. 고정된 T5-XXL LLM(대형 언어 모델) 인코더 임베딩.

캐스케이드 픽셀 공간 확산 모델을 기반으로 하는 Imagen(Saharia et al., 2022) 또는 Dall-E2(Ramesh et al., 2022)와 비교하여 Muse는 개별 토큰을 사용하므로 효율성이 크게 향상됩니다. SOTA 자동 회귀 모델 Parti(Yu et al., 2022)와 비교할 때 Muse는 병렬 디코딩을 사용하므로 더 효율적입니다.

TPU-v4의 실험 결과를 바탕으로 연구원들은 Muse가 Imagen-3B 또는 Parti-3B 모델보다 추론 속도가 10배 이상 빠르고 Stable Diffusion v1.4보다 빠르다고 추정합니다(Rombach et al., 2022) 2배 더 빨라졌습니다. 연구원들은 추론 중에 더 많은 반복이 필요한 Stable Diffusion v1.4에서 확산 모델이 사용되기 때문에 Muse가 Stable Diffusion보다 빠르다고 믿습니다.

모델 아키텍처 개요.

추천: 추론 속도는 Stable Diffusion보다 2배 빠르며, 하나의 Google 모델로 이미지 생성 및 복구가 가능합니다.

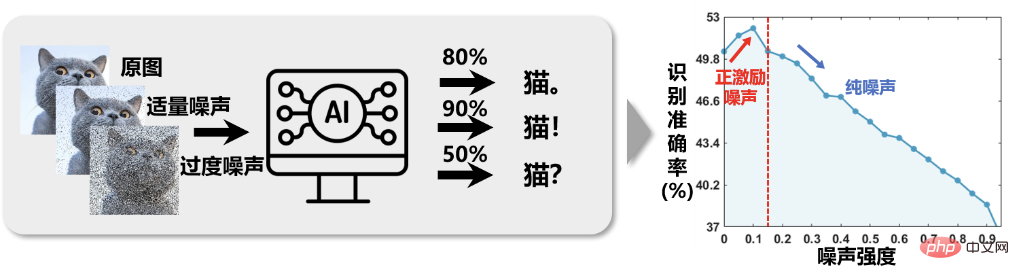

논문 5: 긍정적 인센티브 소음

- 저자: Li Xuelong

- 논문 주소: https://ieeexplore.ieee.org/document/10003114

요약:과학 연구의 모든 측면에는 부족한 기기 정밀도로 인한 기기 오류, 조작 중 사람의 오류로 인한 편차, 극한 환경과 같은 외부 간섭으로 인한 정보 왜곡 등 많은 양의 노이즈가 있습니다. . 소음이 수행되는 작업에 종종 부정적인 영향을 미친다는 것은 연구자들 사이에서 일반적인 가정이 되었습니다. 따라서 "소음 감소"라는 핵심 과제를 중심으로 많은 양의 연구 작업이 이루어졌습니다. 그러나 Northwestern Polytechnical University의 Li Xuelong 교수 팀은 신호 감지 및 처리 작업을 수행할 때 실험적 관찰을 통해 이러한 가정에 의문을 제기했습니다. 과학 연구에서 잡음이 실제로 항상 해로운가요?

그림 1과 같이 이미지 지능형 분류 시스템에서는 이미지에 적절한 양의 노이즈를 추가한 후 훈련한 후 인식 정확도가 높아졌습니다. 이는 우리에게 영감을 줍니다. 이미지를 제거하는 대신 이미지에 약간의 노이즈를 추가한 다음 이미지 분류 작업을 수행하면 더 나은 결과를 얻을 수 있습니다. 소음이 대상에 미치는 영향이 배경에 미치는 소음의 영향보다 훨씬 작은 한, "적(배경 소음)에게 1000 피해를 주고 자신(대상 신호)에 800 피해를 준다"는 효과는 의미가 있으며, 임무는 높은 신호 대 잡음비를 추구하기 때문입니다. 본질적으로 전통적인 분류 문제에 직면했을 때 특징 뒤에 적당한 노이즈를 무작위로 추가하는 것은 어떤 의미에서 특징에 커널 함수를 추가하는 것과 유사하며 실제로 낮은 수준의 매핑을 완료합니다. -차원 공간에서 고차원 공간으로 데이터의 분리성을 높여 분류 효과를 향상시킵니다.

그림 1 이미지 인식 정확도는 이미지 노이즈 강도가 증가함에 따라 "처음에는 증가했다가 감소하는" "반직관적인" 관계를 보여줍니다.

추천: Western Polytechnic University의 Li Xuelong 교수는 작업 엔트로피를 기반으로 한 수학적 분석 프레임워크를 제안했습니다.

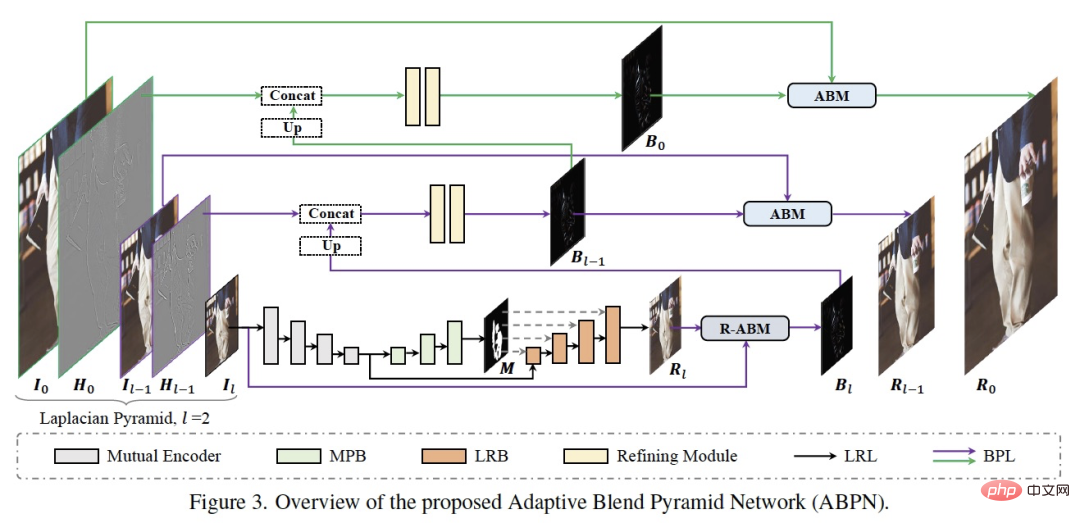

논문 6: ABPN: 초고해상도 사진의 실시간 로컬 리터칭을 위한 적응형 혼합 피라미드 네트워크

- 저자: Biwen Lei, Xiefan Guo 등

- Paper 주소: https://openaccess.thecvf.com/content/CVPR2022/papers/Lei_ABPN_Adaptive_Blend_Pyramid_Network_for_Real-Time_Local_Retouching_of_CVPR_2022_paper.pdf

요약: DAMO 아카데미의 연구원들은 전문가 수준의 스마트 스킨케어 포인트, 연구 및 개발 고화질 이미지를 위한 일련의 초미세 로컬 리터칭 알고리즘 ABPN이 개발되었으며, 이는 초고화질 이미지의 피부 미화 및 의류 주름 제거 작업에서 좋은 결과와 적용을 달성했습니다.

위 그림에서 볼 수 있듯이 네트워크 구조는 주로 상황 인식 로컬 수정 계층(LRL)과 적응형 혼합 피라미드 계층(BPL)의 두 부분으로 구성됩니다. LRL의 목적은 다운샘플링된 저해상도 영상을 국부적으로 수정하고 전역 컨텍스트 정보와 국부적 텍스처 정보를 충분히 고려하여 저해상도 수정 결과 영상을 생성하는 것입니다. 또한 BPL은 LRL에서 생성된 저해상도 결과를 점차적으로 고해상도 결과로 확대하는 데 사용됩니다. 그 중 적응형 블렌딩 모듈(ABM)과 그 역모듈(R-ABM)을 중간 블렌딩 레이어 Bi를 사용하여 원본 이미지와 결과 이미지 간의 적응형 변환 및 상향 확장을 구현하여 강력한 확장성을 보여줍니다. 그리고 세부 충실도 기능. 우리는 얼굴 수정과 의복 수정이라는 두 가지 데이터 세트에 대해 많은 실험을 수행했으며 그 결과 우리의 방법이 효과성과 효율성 측면에서 기존 방법보다 훨씬 앞서 있음을 보여주었습니다. 우리 모델이 단일 카드 P100에서 4K 초고해상도 이미지의 실시간 추론을 달성한다는 점은 언급할 가치가 있습니다.

추천: 한 번의 클릭으로 잡티와 주름을 지워보세요.

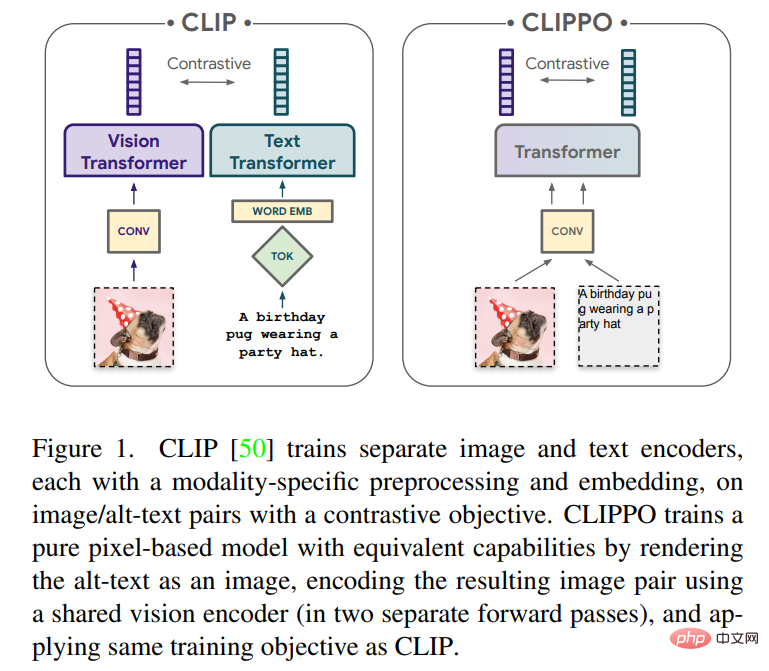

논문 7: 픽셀만으로 이미지 및 언어 이해

- 저자: Michael Tschannen, Basil Mustafa 등

- 논문 주소: https://arxiv.org /pdf /2212.08045.pdf

요약: 모든 양식 또는 양식의 조합을 처리할 수 있는 단일 엔드 투 엔드 모델을 개발하는 것은 다중 모드 학습을 향한 중요한 단계가 될 것입니다. 이번 글에서는 구글리서치(구글브레인팀)와 취리히 연구진이 주로 이미지와 텍스트에 집중할 예정이다.

이 기사에서는 순수 픽셀 기반 모델을 사용하여 텍스트와 이미지의 다중 모드 학습을 살펴봅니다. 모델은 시각적 입력이나 텍스트 또는 둘 다를 모두 RGB 이미지로 렌더링하는 별도의 시각적 변환기입니다. 모든 양식은 하위 수준 기능 처리를 포함하여 동일한 모델 매개변수를 사용합니다. 즉, 양식별 초기 컨볼루션, 토큰화 알고리즘 또는 입력 임베딩 테이블이 없습니다. 모델은 CLIP 및 ALIGN으로 대중화된 대조 학습이라는 단 하나의 작업으로만 학습됩니다. 따라서 모델을 CLIP-Pixels Only(CLIPPO)라고 합니다.

추천: 매개변수가 절반으로 줄어들어 CLIP 못지않게 Visual Transformer는 픽셀부터 시작하는 이미지와 텍스트의 통일을 실현합니다.

ArXiv Weekly Radiostation

Heart of Machine은 Chu Hang과 Luo Ruotian이 시작한 ArXiv Weekly Radiostation과 협력하여 NLP, CV, ML 분야에서 각각 10편의 선정 논문을 포함한 7편의 논문을 바탕으로 이번 주에 더 중요한 논문을 선정합니다. , 논문의 오디오 요약을 제공합니다. 세부 사항은 다음과 같습니다:

10 NLP PapersAudio:00:0020:02

이번 주 선정된 NLP 논문 10개는 다음과 같습니다.

1. 검색을 통한 재고: 충실한 대형 언어 모델 추론(홍밍 장, 댄 로스)

2. 데이터 세트 및 방법(Bhiksha Raj)

3. 사전 학습된 언어 모델을 사용한 테이블-텍스트 생성을 향하여: 테이블 구조 이해 및 텍스트 심의 접근법(Hui Xiong)

4. 인식론적 입장 탐지를 통한 수사학(Brendan O'Connor)

5. 형식적 지식을 사용한 지식 집약적 텍스트-SQL 의미 분석을 향하여(Kan Min-Yen)

6. 암시적 증오심 표현 탐지

7. 신경 코덱 언어 모델은 제로샷 텍스트 음성 합성기입니다(Furu Wei)

8. 인터뷰 생성기(Tao Zhang에서)

9. 자동 음성 인식을 위한 메모리 증강 조회 사전 기반 언어 모델링(Yuxuan Wang에서)

10. Diyi Yang에서. )

10개의 이력서 서류오디오:00:0021:06

이번 주 CV 선정 논문 10개는 다음과 같습니다.

1. CA$^2$T-Net: 단일 이미지에서 카테고리에 구애받지 않는 3D 관절 전송(Jitendra Malik에서)

2. 베냉의 지속 가능한 나무 작물 확장을 알리기 위한 매핑. Malik) Vipin Kumar)

3. Scale-MAE: 다중 규모 지리공간 표현 학습을 위한 규모 인식 마스크 자동 인코더(Trevor Darrell 작성)

4. .(Rama Chellappa에서)

5. Muse: Masked Generative Transformers를 통한 텍스트-이미지 생성(Ming-Hsuan Yang, Kevin Murphy, William T. Freeman에서)

6. 신경 붕괴를 통해(Xiangyu Zhang, Jiaya Jia)

7. 3D 객체 감지를 위한 좌표 인코딩을 통한 교차 모달 변환기(Xiangyu Zhang에서)

8. . (Alan Yuille에서)

9. 정렬을 통한 학습: 그룹 순서 제약 조건을 사용한 자기 지도 학습(Bernt Schiele에서)

10. AttEntropy: 의미론적 분할 변환기의 공간 주의 엔트로피를 사용하여 복잡한 장면에서 알 수 없는 객체를 분할합니다. (Pascal Fua에서)

10 ML 논문소리频:00:0023:15

本周 10 篇 ML 精选论文是:

1. 관련 정보의 원리를 이용한 자기 조직 보존 그래프 구조 학습. (필립 S. 유 중에서)

2. 전자상거래에서 정보 추출을 위한 생성적 적대 네트워크를 통한 수정된 쿼리 확장. (Altan Cakir에서)

3. 관련 부분공간을 찾아 신경망 예측에 대한 풀린 설명. (클라우스-로베르트 뮐러 중에서)

4. L-HYDRA: 다중 헤드 물리학 기반 신경망. (George Em Karniadakis에서)

5. Transformer를 통한 강화 학습 변환: 개발 궤적. (다청 타오에서)

6. 최적화된 바이너리를 디컴파일하기 위해 신경망을 강화합니다. (첸 카이에게서)

7. NeuroExplainer: 미숙아의 피질 발달 패턴을 밝혀내기 위한 세밀한 주의 디코딩. (Dinggang Shen에서)

8. 인간과 유사한 Few-Shot 학습 이론. (밍 리에서)

9. 압축 업데이트를 통한 시간차 학습: 오류 피드백이 강화 학습을 충족합니다. (George J. Pappas에서)

10. 다중 한계 최적 전송 역전을 통해 집계된 데이터에서 잠재 인구 흐름을 추정합니다. (자홍원에서)

위 내용은 추론 속도는 Stable Diffusion보다 2배 빠릅니다. Visual Transformer는 이미지 텍스트를 통합합니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!