그라디언트 부스팅 알고리즘은 가장 일반적으로 사용되는 앙상블 기계 학습 기술 중 하나입니다. 이 모델은 일련의 약한 결정 트리를 사용하여 강력한 학습자를 구축합니다. 이는 XGBoost 및 LightGBM 모델의 이론적 기반이기도 하므로 이 기사에서는 처음부터 그래디언트 부스팅 모델을 구축하고 이를 시각화하겠습니다.

그라디언트 부스팅 알고리즘 소개

그라디언트 부스팅 알고리즘은 여러 개의 약한 분류기를 구축한 다음 이를 강력한 분류기로 결합하여 모델의 예측 정확도를 향상시키는 앙상블 학습 알고리즘입니다.

그라디언트 부스팅 알고리즘의 원리는 다음 단계로 나눌 수 있습니다.

- 모델 초기화: 일반적으로 초기 분류자로 간단한 모델(예: 의사결정 트리)을 사용할 수 있습니다.

- 손실 함수의 음의 기울기 계산: 각 샘플 포인트에 대해 현재 모델에서 손실 함수의 음의 기울기를 계산합니다. 이는 새 분류기에 현재 모델의 오류를 맞추도록 요청하는 것과 같습니다.

- 새 분류기 학습: 이러한 음의 기울기를 대상 변수로 사용하여 새로운 약한 분류기를 학습합니다. 이 약한 분류기는 의사결정 트리, 선형 모델 등과 같은 모든 분류기가 될 수 있습니다.

- 모델 업데이트: 원래 모델에 새 분류자를 추가하고 가중 평균 또는 기타 방법을 사용하여 결합합니다.

- 반복 반복: 미리 설정된 반복 횟수에 도달하거나 미리 설정된 정확도에 도달할 때까지 위 단계를 반복합니다.

그라디언트 부스팅 알고리즘은 직렬 알고리즘이므로 훈련 속도가 느릴 수 있습니다. 실제 예를 들어 소개하겠습니다.

특성 세트 Xi와 값 Yi가 있고 y를 계산하려고 한다고 가정합니다.

우리는 y

F_m(x)가 y|x에 더 가까워지기를 원하는 모든 단계에서 y의 평균부터 시작합니다.

각 단계에서 우리는 F_m(x)가 주어진 x에 대해 더 나은 근사치가 되기를 원합니다.

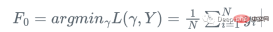

먼저 손실 함수를 정의합니다.

그런 다음 학습자에 대해 손실 함수가 가장 빠르게 감소하는 방향으로 이동합니다. Fm:

y를 계산할 수 없기 때문입니다. 모든 x에 대해 이 기울기의 정확한 값은 알 수 없지만 훈련 데이터의 각 x_i에 대해 기울기는 단계 m의 잔차와 정확히 같습니다: r_i!

그래서 우리는 약한 회귀 트리 h_m을 사용하여 다음을 수행할 수 있습니다. 잔여 수행 훈련에 대해 그래디언트 함수 g_m을 근사화합니다.

그런 다음 학습자를 업데이트합니다.

이것은 손실 함수의 실제 그래디언트 g_m을 사용하는 대신에 관련됩니다. 현재 학습자는 현재 학습자 F_{m }을 업데이트하는 대신 약한 회귀 트리 h_m을 사용하여 업데이트합니다.

즉, 다음 단계를 반복합니다.

1. 잔차를 계산합니다.

2 회귀 트리 h_m을 훈련 표본과 잔차(x_i, r_i)에 맞춥니다. 단계 크기 알파 업데이트 모델

복잡해 보이죠? 프로세스를 시각화하면 매우 명확해집니다. 고전적인 비선형 범주형 데이터

복잡해 보이죠? 프로세스를 시각화하면 매우 명확해집니다. 고전적인 비선형 범주형 데이터

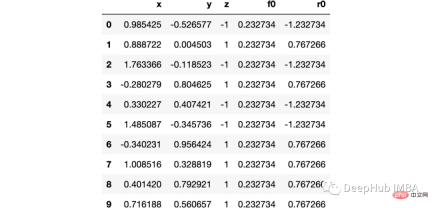

import numpy as np import sklearn.datasets as ds import pandas as pd import matplotlib.pyplot as plt import matplotlib as mpl from sklearn import tree from itertools import product,islice import seaborn as snsmoonDS = ds.make_moons(200, noise = 0.15, random_state=16) moon = moonDS[0] color = -1*(moonDS[1]*2-1) df =pd.DataFrame(moon, columns = ['x','y']) df['z'] = color df['f0'] =df.y.mean() df['r0'] = df['z'] - df['f0'] df.head(10)

데이터를 시각화해 보겠습니다.

下图可以看到,该数据集是可以明显的区分出分类的边界的,但是因为他是非线性的,所以使用线性算法进行分类时会遇到很大的困难。

那么我们先编写一个简单的梯度增强模型:

def makeiteration(i:int):

"""Takes the dataframe ith f_i and r_i and approximated r_i from the features, then computes f_i+1 and r_i+1"""

clf = tree.DecisionTreeRegressor(max_depth=1)

clf.fit(X=df[['x','y']].values, y = df[f'r{i-1}'])

df[f'r{i-1}hat'] = clf.predict(df[['x','y']].values)

eta = 0.9

df[f'f{i}'] = df[f'f{i-1}'] + eta*df[f'r{i-1}hat']

df[f'r{i}'] = df['z'] - df[f'f{i}']

rmse = (df[f'r{i}']**2).sum()

clfs.append(clf)

rmses.append(rmse)上面代码执行3个简单步骤:

将决策树与残差进行拟合:

clf.fit(X=df[['x','y']].values, y = df[f'r{i-1}'])

df[f'r{i-1}hat'] = clf.predict(df[['x','y']].values)然后,我们将这个近似的梯度与之前的学习器相加:

df[f'f{i}'] = df[f'f{i-1}'] + eta*df[f'r{i-1}hat']最后重新计算残差:

df[f'r{i}'] = df['z'] - df[f'f{i}']步骤就是这样简单,下面我们来一步一步执行这个过程。

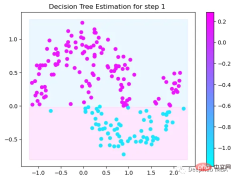

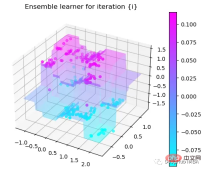

第1次决策

Tree Split for 0 and level 1.563690960407257

第2次决策

Tree Split for 1 and level 0.5143677890300751

第3次决策

Tree Split for 0 and level -0.6523728966712952

第4次决策

Tree Split for 0 and level 0.3370491564273834

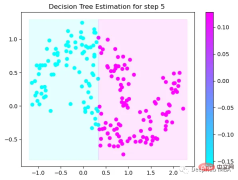

第5次决策

Tree Split for 0 and level 0.3370491564273834

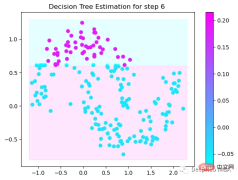

第6次决策

Tree Split for 1 and level 0.022058885544538498

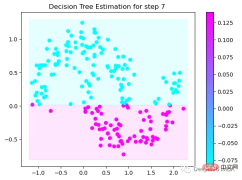

第7次决策

Tree Split for 0 and level -0.3030575215816498

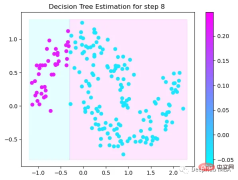

第8次决策

Tree Split for 0 and level 0.6119407713413239

第9次决策

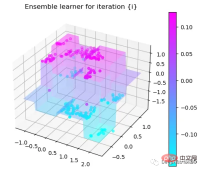

可以看到通过9次的计算,基本上已经把上面的分类进行了区分

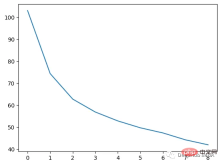

我们这里的学习器都是非常简单的决策树,只沿着一个特征分裂!但整体模型在每次决策后边的越来越复杂,并且整体误差逐渐减小。

plt.plot(rmses)

这也就是上图中我们看到的能够正确区分出了大部分的分类

如果你感兴趣可以使用下面代码自行实验:

https://www.php.cn/link/bfc89c3ee67d881255f8b097c4ed2d67

위 내용은 그래디언트 부스팅 알고리즘의 의사결정 과정을 단계별로 시각화의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

Gemma Scope : AI의 사고 과정으로 들여다 보는 Google의 현미경Apr 17, 2025 am 11:55 AM

Gemma Scope : AI의 사고 과정으로 들여다 보는 Google의 현미경Apr 17, 2025 am 11:55 AM젬마 범위로 언어 모델의 내부 작업 탐색 AI 언어 모델의 복잡성을 이해하는 것은 중요한 도전입니다. 포괄적 인 툴킷 인 Gemma Scope의 Google 릴리스는 연구원에게 강력한 강력한 방법을 제공합니다.

비즈니스 인텔리전스 분석가는 누구이며 하나가되는 방법은 무엇입니까?Apr 17, 2025 am 11:44 AM

비즈니스 인텔리전스 분석가는 누구이며 하나가되는 방법은 무엇입니까?Apr 17, 2025 am 11:44 AM비즈니스 성공 잠금 해제 : 비즈니스 인텔리전스 분석가가되는 가이드 원시 데이터를 조직의 성장을 이끌어내는 실행 가능한 통찰력으로 바꾸는 것을 상상해보십시오. 이것은 비즈니스 인텔리전스 (BI) 분석가의 힘 - GU에서 중요한 역할입니다.

SQL에서 열을 추가하는 방법? - 분석 VidhyaApr 17, 2025 am 11:43 AM

SQL에서 열을 추가하는 방법? - 분석 VidhyaApr 17, 2025 am 11:43 AMSQL의 Alter Table 문 : 데이터베이스에 열을 동적으로 추가 데이터 관리에서 SQL의 적응성이 중요합니다. 데이터베이스 구조를 즉시 조정해야합니까? Alter Table 문은 솔루션입니다. 이 안내서는 Colu를 추가합니다

비즈니스 분석가 대 데이터 분석가Apr 17, 2025 am 11:38 AM

비즈니스 분석가 대 데이터 분석가Apr 17, 2025 am 11:38 AM소개 두 전문가가 중요한 프로젝트에 대해 협력하는 번화 한 사무실을 상상해보십시오. 비즈니스 분석가는 회사의 목표, 개선 영역을 식별하며 시장 동향과의 전략적 조정을 보장합니다. 시무

Excel의 Count와 Counta는 무엇입니까? - 분석 VidhyaApr 17, 2025 am 11:34 AM

Excel의 Count와 Counta는 무엇입니까? - 분석 VidhyaApr 17, 2025 am 11:34 AMExcel 데이터 계산 및 분석 : 카운트 및 카운트 기능에 대한 자세한 설명 정확한 데이터 계산 및 분석은 특히 큰 데이터 세트로 작업 할 때 Excel에서 중요합니다. Excel은이를 달성하기위한 다양한 기능을 제공하며, 카운트 및 카운타 기능은 다른 조건에서 셀 수를 계산하기위한 핵심 도구입니다. 두 기능 모두 셀을 계산하는 데 사용되지만 설계 목표는 다른 데이터 유형을 대상으로합니다. Count 및 Counta 기능의 특정 세부 사항을 파고 고유 한 기능과 차이점을 강조하고 데이터 분석에 적용하는 방법을 배우겠습니다. 핵심 포인트 개요 수를 이해하고 쿠션하십시오

Chrome은 AI와 함께 여기에 있습니다 : 매일 새로운 것을 경험하고 있습니다 !!Apr 17, 2025 am 11:29 AM

Chrome은 AI와 함께 여기에 있습니다 : 매일 새로운 것을 경험하고 있습니다 !!Apr 17, 2025 am 11:29 AMChrome 's AI Revolution : 개인화되고 효율적인 탐색 경험 인공 지능 (AI)은 우리의 일상 생활을 빠르게 변화시키고 있으며 Chrome은 웹 브라우징 경기장에서 요금을 주도하고 있습니다. 이 기사는 흥분을 탐구합니다

AI '의 인간 측면 : 웰빙과 4 배의 결론Apr 17, 2025 am 11:28 AM

AI '의 인간 측면 : 웰빙과 4 배의 결론Apr 17, 2025 am 11:28 AM재구성 영향 : 4 배의 결론 너무 오랫동안 대화는 AI의 영향에 대한 좁은 견해로 인해 주로 이익의 결론에 중점을 두었습니다. 그러나보다 전체적인 접근 방식은 BU의 상호 연결성을 인식합니다.

5 게임 변화 양자 컴퓨팅 사용 사례에 대해 알아야합니다.Apr 17, 2025 am 11:24 AM

5 게임 변화 양자 컴퓨팅 사용 사례에 대해 알아야합니다.Apr 17, 2025 am 11:24 AM상황이 그 시점을 꾸준히 움직이고 있습니다. 양자 서비스 제공 업체와 신생 기업에 쏟아지는 투자는 업계의 중요성을 이해하고 있음을 보여줍니다. 그리고 점점 더 많은 실제 사용 사례가 그 가치를 보여주기 위해 떠오르고 있습니다.

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

드림위버 CS6

시각적 웹 개발 도구

Atom Editor Mac 버전 다운로드

가장 인기 있는 오픈 소스 편집기

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

DVWA

DVWA(Damn Vulnerable Web App)는 매우 취약한 PHP/MySQL 웹 애플리케이션입니다. 주요 목표는 보안 전문가가 법적 환경에서 자신의 기술과 도구를 테스트하고, 웹 개발자가 웹 응용 프로그램 보안 프로세스를 더 잘 이해할 수 있도록 돕고, 교사/학생이 교실 환경 웹 응용 프로그램에서 가르치고 배울 수 있도록 돕는 것입니다. 보안. DVWA의 목표는 다양한 난이도의 간단하고 간단한 인터페이스를 통해 가장 일반적인 웹 취약점 중 일부를 연습하는 것입니다. 이 소프트웨어는