Meta 'Divide Everything'의 초진화 버전이 출시되었습니다! IDEA는 국내 최고의 팀을 이끌고 모든 것을 감지, 분할, 생성하고 별 2,000개를 획득합니다.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB앞으로

- 2023-04-13 14:40:031918검색

메타의 '모든 것을 나누는' 모델이 나온 후 업계에서는 이미 이력서가 존재하지 않는다고 외쳤습니다.

SAM이 출시된 지 하루 만에 국내팀은 이를 기반으로 한 진화형 'Grounded-SAM'을 내놓았습니다.

참고: 프로젝트 로고는 Midjourney

Grounded-SAM을 사용하여 팀에서 한 시간 만에 만들었습니다. SAM을 BLIP 및 Stable Diffusion과 통합하여 "세그먼트" 및 "이미지 감지" " 생성'이라는 세 가지 능력이 하나로 결합되어 가장 강력한 Zero-Shot 시각적 응용 프로그램이 됩니다.

네티즌들은 너무 곱슬스럽다고 표현했어요!

Google Brain의 연구 과학자이자 워털루 대학교 컴퓨터 공학과 조교수인 Wenhu Chen은 "이건 너무 빠르다"고 말했습니다.

AI 보스 Shun Xiangyang도 모든 사람에게 이 최신 프로젝트를 추천했습니다.

Grounded-Segment-Anything: 이미지 및 텍스트 입력을 통해 모든 것을 자동으로 감지, 분할 및 생성합니다. Edge 분할이 더욱 향상될 수 있습니다.

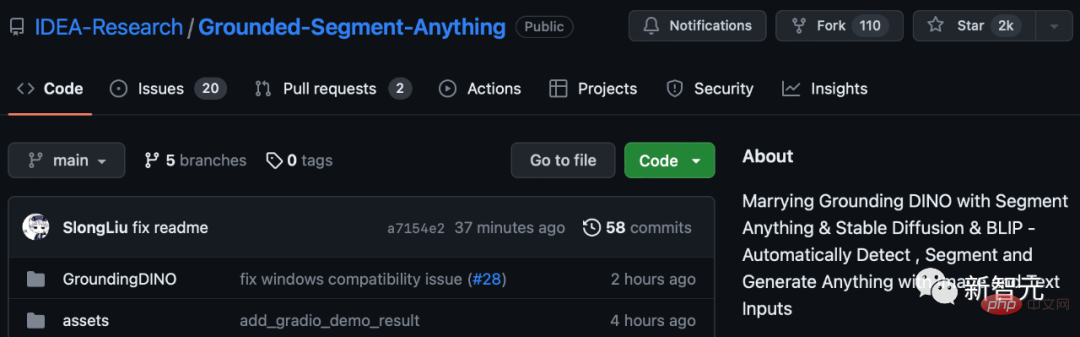

지금까지 이 프로젝트는 GitHub에서 별 2,000개를 받았습니다.

모든 것을 감지하고, 모든 것을 분할하고, 모든 것을 생성합니다.

지난주 SAM의 출시로 CV는 GPT-3 순간을 맞이했습니다. 심지어 Meta AI는 이것이 역사상 최초의 기본 이미지 분할 모델이라고 주장합니다.

이 모델은 통합 프레임워크 프롬프트 인코더에서 점, 경계 상자 및 문장을 지정하여 한 번의 클릭으로 모든 개체를 직접 분할할 수 있습니다.

SAM은 다양한 용도로 사용할 수 있습니다. 즉, 다양한 사용 사례를 포괄하는 데 충분한 제로 샘플 전송 기능이 있으며 추가 교육이 필요하지 않고 바로 사용할 수 있습니다. 수중 사진인지, 세포현미경인지에 관계없이 새로운 이미지 영역에서.

SAM은 매우 강력하다고 할 수 있습니다.

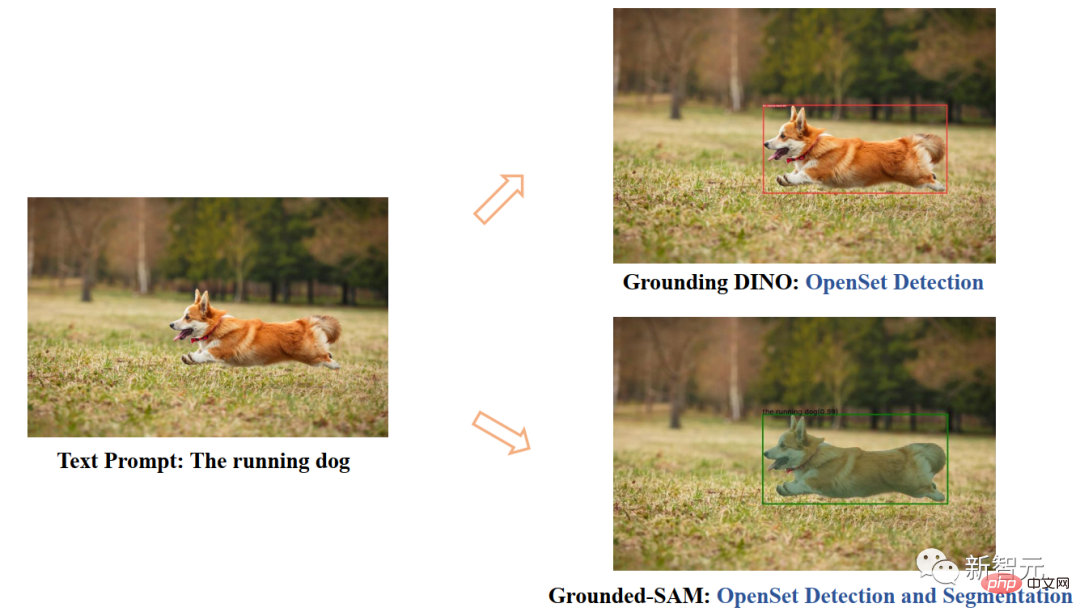

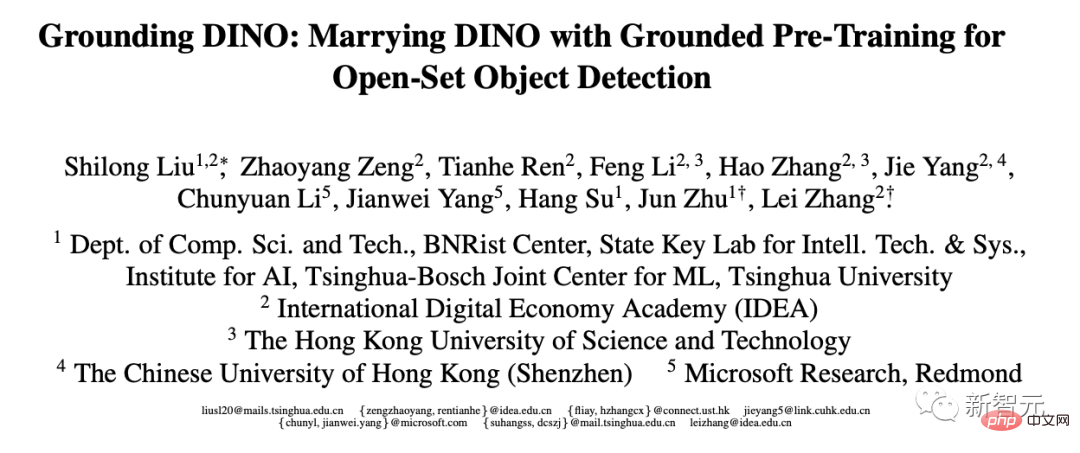

이제 국내 연구진은 이 모델을 기반으로 새로운 아이디어를 내놓았습니다. 여기에 강력한 제로 샘플 대상 탐지기 Grounding DINO를 결합하면 텍스트 입력을 통해 모든 것을 탐지하고 분할할 수 있습니다.

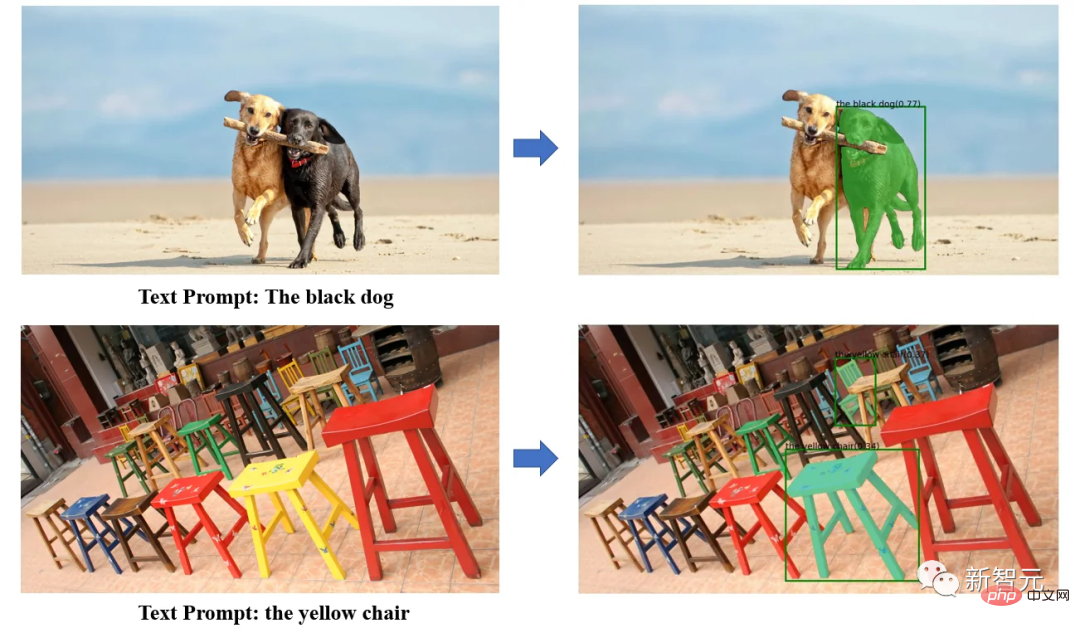

Grounding DINO의 강력한 제로 샘플 감지 기능을 통해 Grounded SAM은 텍스트 설명을 통해 그림에서 모든 개체를 찾은 다음 SAM의 강력한 분할 기능을 사용하여 mas를 세밀하게 분할할 수 있습니다.

마지막으로 Stable Diffusion을 사용하여 분할된 영역에 제어 가능한 텍스트와 그래픽을 생성할 수도 있습니다.

Grounded-SAM의 특정 실행에서 연구원들은 Segment-Anything을 3개의 강력한 제로샷 모델과 결합하여 자동 라벨링 시스템 프로세스를 구축하고 매우 인상적인 결과를 보여주었습니다!

이 프로젝트는 다음 모델을 결합합니다.

· BLIP: 강력한 이미지 주석 모델

· Grounding DINO: 최첨단 제로 샷 감지기

· Segment -Anything: 강력한 제로샷 분할 모델

· Stable-Diffusion: 우수한 생성 모델

모든 모델은 조합하여 또는 독립적으로 사용할 수 있습니다. 강력한 시각적 워크플로 모델을 구축하세요. 전체 워크플로우에는 모든 것을 감지하고, 분류하고, 생성하는 기능이 있습니다.

이 시스템의 기능은 다음과 같습니다:

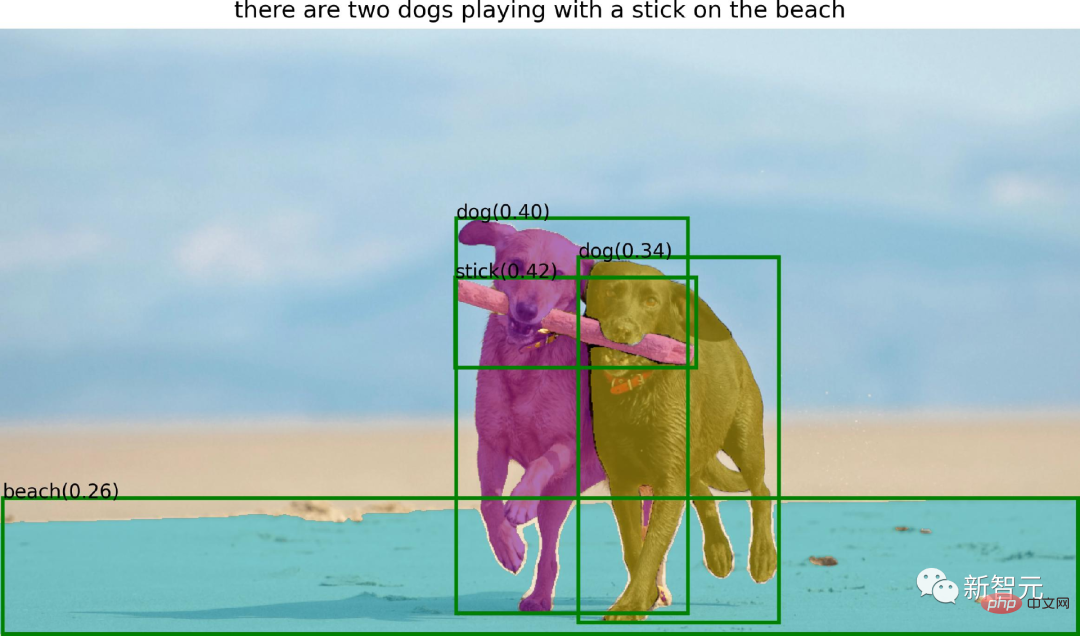

BLIP+Grounded-SAM = 자동 라벨러

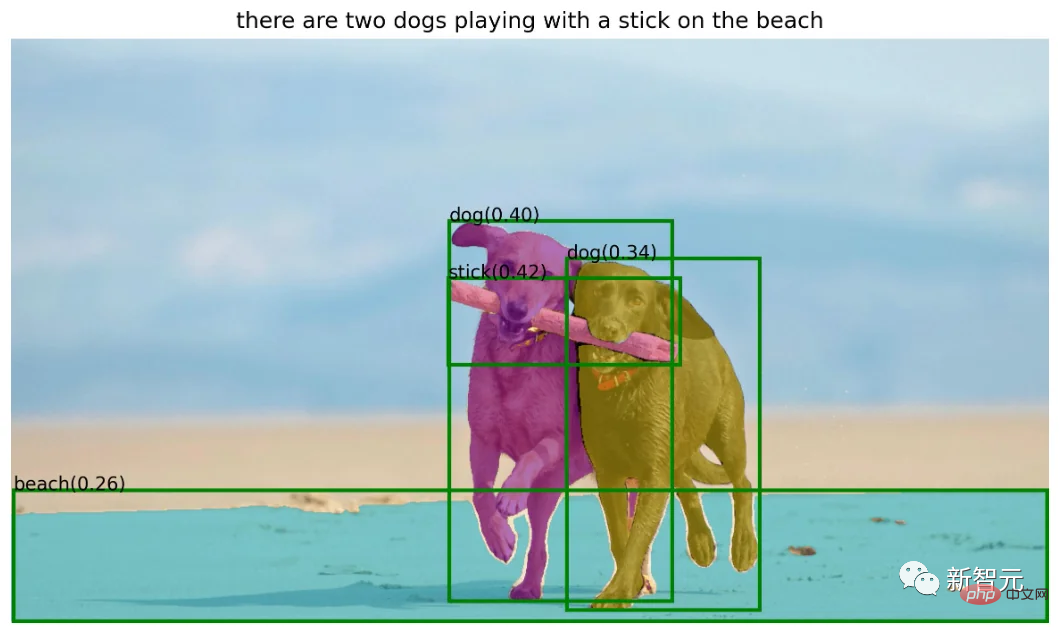

BLIP 모델을 사용하여 제목을 생성하고, 라벨을 추출하고, Ground-SAM을 사용하여 상자와 마스크를 생성합니다.

· 반자동 주석 시스템: 입력된 텍스트를 감지하고 정확한 상자 주석 및 마스크 주석을 제공합니다.

· 완전 자동 주석 시스템:

먼저 BLIP 모델을 사용하여 입력 이미지에 대한 신뢰할 수 있는 주석을 생성한 다음 Grounding DINO가 주석에서 엔터티를 감지하도록 한 다음 SAM을 사용합니다. 해당 상자 팁 인스턴스 분할을 수행합니다.

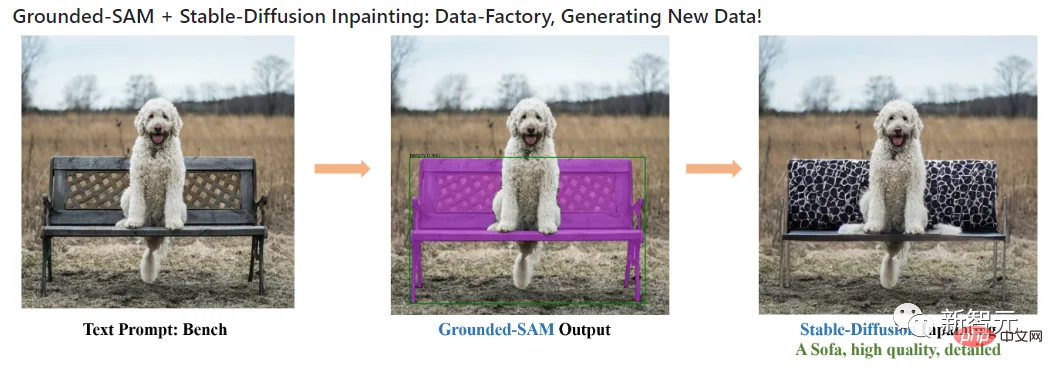

Stable Diffusion+Grounded-SAM=Data Factory

· 새로운 데이터를 생성하기 위한 데이터 팩토리로 사용: 확산 복구 모델을 사용하여 다음을 기반으로 새로운 데이터를 생성할 수 있습니다. 마스크.

Segment Anything+HumanEditing

이 분기에서 저자는 Segment Anything을 사용하여 사람의 머리카락/얼굴을 편집합니다.

·SAM+Hair Editor

·SAM+Fashion Editor

저자는 Grounded-S에 대한 몇 가지 제안을 했습니다. AM 모델 향후 연구 가능성 지침:

자동으로 이미지를 생성하여 새로운 데이터 세트 구축 새로운 이미지를 생성합니다.

저자 소개

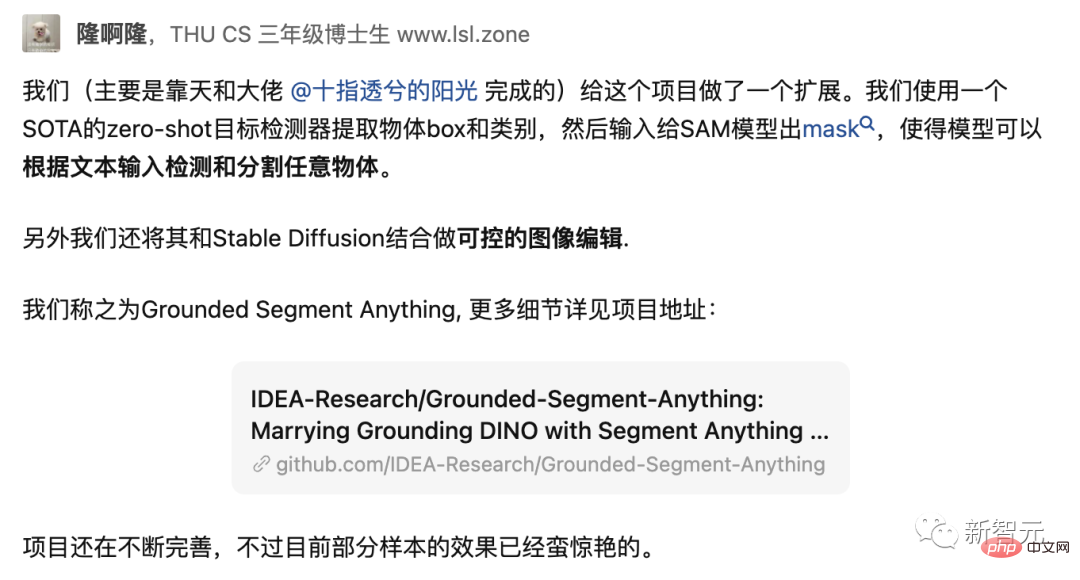

Grounded-SAM 프로젝트의 연구원 중 한 명인 Liu Shilong은 칭화대학교 컴퓨터과학과 박사과정 3년차입니다.

그는 최근 자신과 그의 팀이 만든 최신 프로젝트를 GitHub에 소개하며 아직 개선 중이라고 말했습니다.

현재 Liu Shilong은 광둥-홍콩-마카오 대만 지역 디지털 경제 연구소(IDEA 연구소)의 컴퓨터 비전 및 로봇 공학 연구 센터에서 인턴으로 근무하고 있습니다. 주요 연구 방향은 표적 탐지와 다중 모드 학습입니다.

이전에 그는 2020년 칭화대학교에서 산업공학 학사학위를 취득했고, 2019년에는 한동안 메그비(Megvii)에서 인턴으로 일했습니다.

개인 홈페이지 : http://www.lsl.zone/

참고로 Liu Shilong은 올해 3월에 출시된 표적 탐지 모델 Grounding DINO의 작품이기도 합니다.

또한 그의 논문 중 4편이 CVPR 2023에 승인되었고, 2편의 논문이 ICLR 2023에 승인되었으며, 1편의 논문이 AAAI 2023에 승인되었습니다.

문서 주소: https://arxiv.org/pdf/2303.05499.pdf

그리고 Liu Shilong이 언급한 빅 보스인 Ren Tianhe는 현재 IDEA 연구소에서 연구원으로 재직하고 있습니다. 컴퓨터 비전 알고리즘 엔지니어이자 Zhang Lei 교수가 지도하고 있으며 주요 연구 방향은 표적 탐지 및 다중 양식입니다. ㅋㅋㅋ 주요 연구 방향이 생성 모델인 IDEA 연구소의 컴퓨터 비전 및 로봇공학 연구 센터와 Alibaba Cloud의 수석 알고리즘 엔지니어인 Chen Jiayu입니다.

Ren Tianhe 및 Liu Shilong

설치 및 운영 이 프로젝트에는 Python 3.8 이상, pytorch 1.7 이상 및 torchvision 0.8 이상이 설치되어 있어야 합니다. 또한 저자는 CUDA를 지원하는 PyTorch와 TorchVision을 설치할 것을 강력히 권장합니다.

무엇이든 세그먼트 설치:

python -m pip install -e segment_anythingGroundingDINO 설치:

python -m pip install -e GroundingDINO디퓨저 설치:

pip install --upgrade diffusers[torch]마스크 후처리 설치, 마스크를 COCO 형식으로 저장, 예제 노트북 및 ONNX 형식으로 모델 내보내기 필수 선택적 종속성. 동시에 프로젝트에서는 예제 노트북을 실행하기 위해 jupyter도 필요합니다.

pip install opencv-python pycocotools matplotlib onnxruntime onnx ipykernelGrounding DINO DEMO

groundingdino 체크포인트 다운로드:

cd Grounded-Segment-Anything

wget https://github.com/IDEA-Research/GroundingDINO/releases/download/v0.1.0-alpha/groundingdino_swint_ogc.pth

데모 실행:

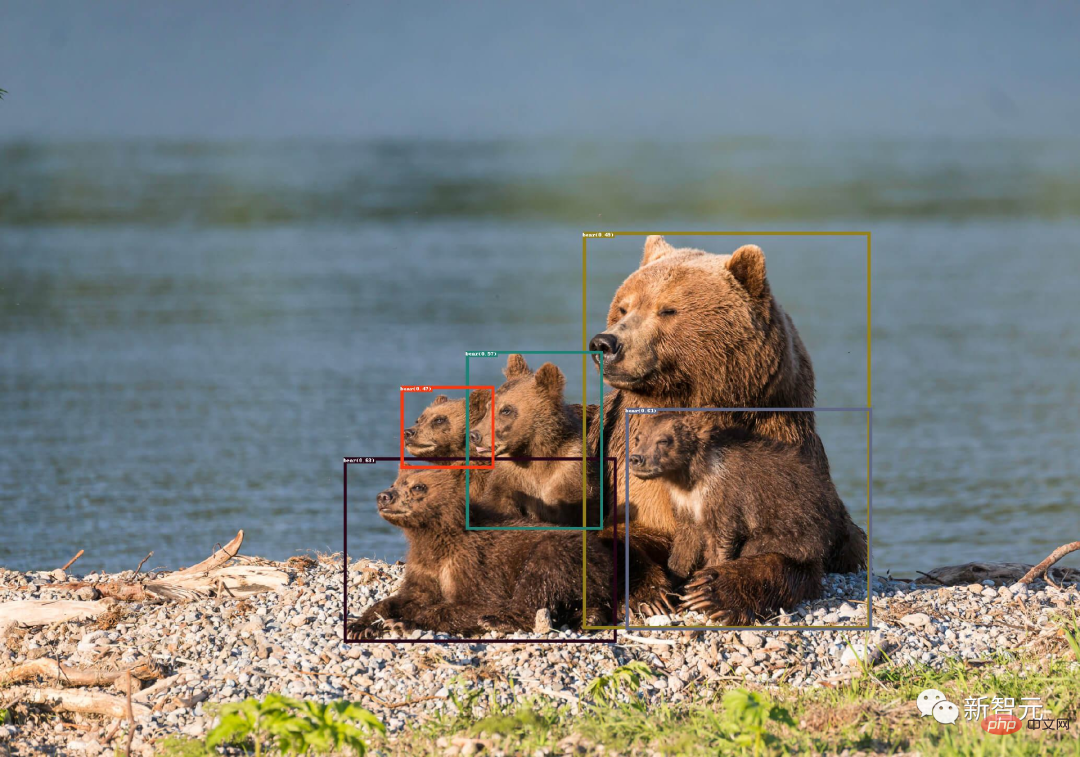

export CUDA_VISIBLE_DEVICES=0 python grounding_dino_demo.py --config GroundingDINO/groundingdino/config/GroundingDINO_SwinT_OGC.py --grounded_checkpoint groundingdino_swint_ogc.pth --input_image assets/demo1.jpg --output_dir "outputs" --box_threshold 0.3 --text_threshold 0.25 --text_prompt "bear" --device "cuda"모델 예측 시각화는 아래와 같이 output_dir에 저장됩니다.

접지됨 -Segment-Anything+BLIP 데모

의사 라벨을 자동으로 생성하는 것은 간단합니다.

의사 라벨을 자동으로 생성하는 것은 간단합니다.

1 BLIP(또는 다른 주석 모델)을 사용하여 주석을 생성합니다.

2. 주석에서 태그를 추출하고 ChatGPT를 사용하여 잠재적으로 복잡한 문장을 처리합니다.

3. Grounded-Segment-Anything을 사용하여 상자와 마스크를 생성합니다.

export CUDA_VISIBLE_DEVICES=0 python automatic_label_demo.py --config GroundingDINO/groundingdino/config/GroundingDINO_SwinT_OGC.py --grounded_checkpoint groundingdino_swint_ogc.pth --sam_checkpoint sam_vit_h_4b8939.pth --input_image assets/demo3.jpg --output_dir "outputs" --openai_key your_openai_key --box_threshold 0.25 --text_threshold 0.2 --iou_threshold 0.5 --device "cuda"

伪标签和模型预测可视化将保存在output_dir中,如下所示:

Grounded-Segment-Anything+Inpainting演示

CUDA_VISIBLE_DEVICES=0 python grounded_sam_inpainting_demo.py --config GroundingDINO/groundingdino/config/GroundingDINO_SwinT_OGC.py --grounded_checkpoint groundingdino_swint_ogc.pth --sam_checkpoint sam_vit_h_4b8939.pth --input_image assets/inpaint_demo.jpg --output_dir "outputs" --box_threshold 0.3 --text_threshold 0.25 --det_prompt "bench" --inpaint_prompt "A sofa, high quality, detailed" --device "cuda"

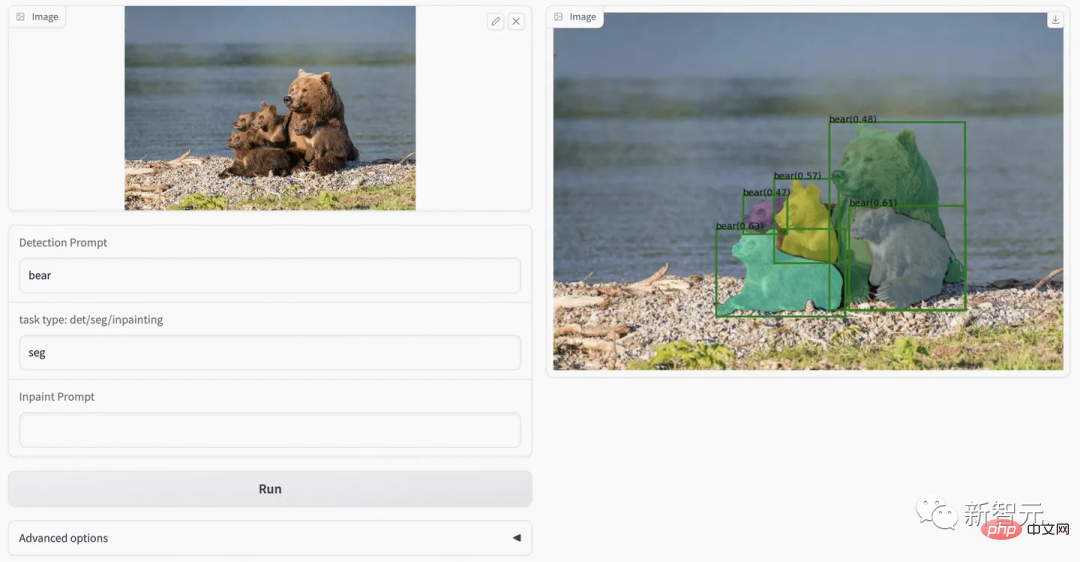

Grounded-Segment-Anything+Inpainting Gradio APP

python gradio_app.py

作者在此提供了可视化网页,可以更方便的尝试各种例子。

网友评论

对于这个项目logo,还有个深层的含义:

一只坐在地上的马赛克风格的熊。坐在地面上是因为ground有地面的含义,然后分割后的Meta Divide Everything의 초진화 버전이 출시되었습니다! IDEA는 국내 최고의 팀을 이끌고 모든 것을 감지, 분할, 생성하고 별 2,000개를 획득합니다.可以认为是一种马赛克风格,而且马塞克谐音mask,之所以用熊作为logo主体,是因为作者主要示例的Meta Divide Everything의 초진화 버전이 출시되었습니다! IDEA는 국내 최고의 팀을 이끌고 모든 것을 감지, 분할, 생성하고 별 2,000개를 획득합니다.是熊。

看到Grounded-SAM后,网友表示,知道要来,但没想到来的这么快。

项目作者任天和称,「我们用的Zero-Shot检测器是目前来说最好的。」

未来,还会有web demo上线。

最后,作者表示,这个项目未来还可以基于生成模型做更多的拓展应用,例如多领域精细化编辑、高质量可信的数据工厂的构建等等。欢迎各个领域的人多多参与。

위 내용은 Meta 'Divide Everything'의 초진화 버전이 출시되었습니다! IDEA는 국내 최고의 팀을 이끌고 모든 것을 감지, 분할, 생성하고 별 2,000개를 획득합니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!