컴퓨팅 성능이 너무 높으면 언어 모델 성능을 어떻게 향상시킬 수 있습니까? 구글이 새로운 아이디어를 가지고 있다

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB앞으로

- 2023-04-13 14:01:091507검색

최근 몇 년 동안 언어 모델(LM)이 자연어 처리(NLP) 연구에서 더욱 두드러지고 실제로 영향력이 커지고 있습니다. 일반적으로 모델 크기를 늘리면 다양한 NLP 작업의 성능이 향상되는 것으로 나타났습니다.

그러나 모델을 확장하는 과제도 분명합니다. 새롭고 더 큰 모델을 훈련하려면 많은 컴퓨팅 리소스가 필요합니다. 또한 새 모델은 처음부터 훈련되는 경우가 많아 이전 모델의 훈련 가중치를 활용할 수 없습니다.

이 문제에 대해 Google 연구원들은 추가 컴퓨팅 리소스를 많이 소비하지 않고도 기존 언어 모델의 성능을 크게 향상시킬 수 있는 두 가지 보완적인 방법을 모색했습니다.

먼저, "0.1% 추가 컴퓨팅으로 스케일링 법칙 초월"이라는 기사에서 연구원들은 하이브리드 에노이저 목표를 사용하는 경량의 2단계 사전 훈련 모델인 UL2R을 소개했습니다. UL2R은 다양한 작업의 성능을 향상하여 이전에 거의 무작위 성능을 보였던 작업에서도 성능을 대폭 향상합니다.

논문 링크: https://arxiv.org/pdf/2210.11399.pdf

또한 "Scaling Instruction-Finetuned Language Models"에서는 명령어 기반 언어 모델을 논의합니다. 데이터 세트에서 언어 모델을 미세 조정하는 문제는 우리가 "Flan"이라고 부르는 프로세스입니다. 이 접근 방식은 성능을 향상시킬 뿐만 아니라 사용자 입력에 대한 언어 모델의 유용성도 향상시킵니다.

문서 링크: https://arxiv.org/abs/2210.11416

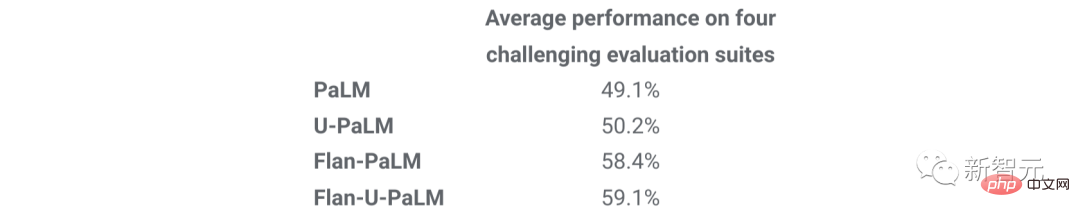

마지막으로 Flan과 UL2R은 Flan-U-PaLM 540B라는 하나의 보완 기술로 결합될 수 있습니다. 모델은 다양한 까다로운 평가 벤치마크에서 조정되지 않은 PaLM 540B 모델보다 10% 더 나은 성능을 발휘합니다.

UL2R 훈련

전통적으로 대부분의 언어 모델은 인과 언어 모델링 목표에 대해 사전 훈련되어 모델이 시퀀스의 다음 단어(예: GPT-3 또는 PaLM)를 예측하거나 잡음 제거 목표를 예측할 수 있습니다. 모델은 손상된 단어 시퀀스(예: T5)에서 원래 문장을 복구하는 방법을 학습합니다.

언어 모델링 목표에는 몇 가지 트레이드오프가 있지만, 즉 인과 언어 모델은 긴 문장 생성에서 더 나은 성능을 발휘하는 반면, 노이즈 제거 목표에 대해 훈련된 언어 모델은 미세 조정에서 더 나은 성능을 발휘하지만 작업에서는 연구자들은 두 가지 목표를 모두 포함하는 하이브리드 음향 장치가 두 경우 모두에서 더 나은 성능을 달성한다는 것을 보여주었습니다.

그러나 다양한 대상에 대해 대규모 언어 모델을 처음부터 사전 훈련하는 것은 계산적으로 어렵습니다. 따라서 우리는 UL2 목표로 사전 훈련을 계속하고 상대적으로 적은 양의 계산만 필요로 하는 추가 단계인 UL2 복구(UL2R)를 제안합니다.

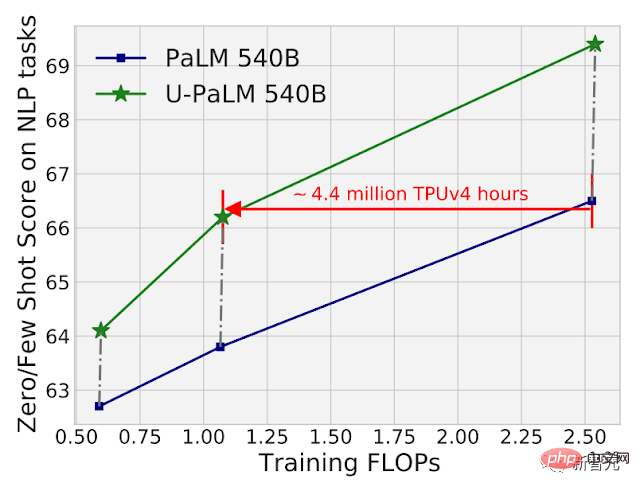

PaLM에 UL2R을 적용하고 그 결과 생성된 새로운 언어 모델을 U-PaLM이라고 부릅니다.

실증적 평가에서 우리는 적은 양의 UL2 교육만으로도 모델이 크게 향상된다는 것을 발견했습니다.

예를 들어 PaLM 540B의 중간 체크포인트에서 UL2R을 사용하면 2배의 계산을 사용하면서 최종 체크포인트에서 PaLM 540B의 성능을 달성하는 것이 가능합니다. 물론, 최종 PaLM 540B 체크포인트에 UL2R을 적용한다면 엄청난 개선을 가져올 것입니다.

26개 NLP 벤치마크에서 PaLM 540B와 U-PaLM 540B의 계산 및 모델 성능을 비교합니다. U-PaLM 540B는 매우 적은 양의 계산으로 PaLM을 계속 훈련하지만 성능은 크게 향상됩니다.

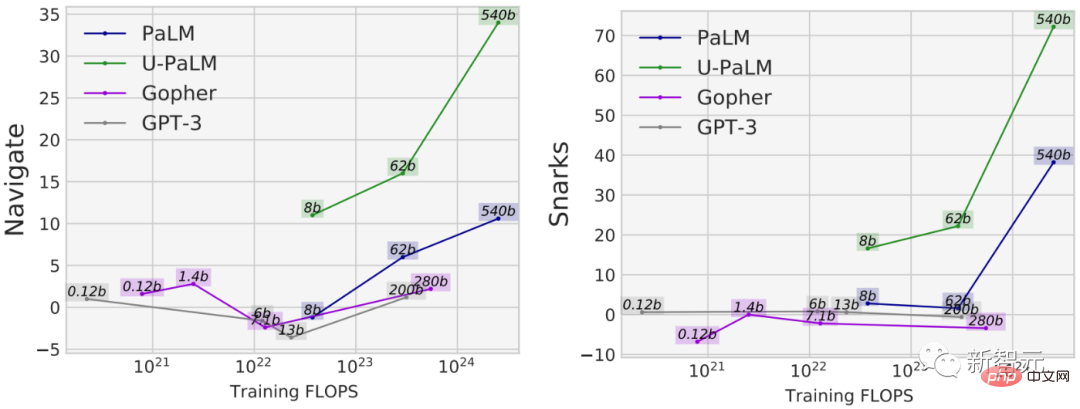

UL2R 사용의 또 다른 이점은 인과 언어 모델링 목표로만 훈련된 모델보다 일부 작업에서 훨씬 더 나은 성능을 발휘한다는 것입니다. 예를 들어, 충분히 큰 언어 모델에서만 사용할 수 있는 기능인 소위 "긴급 기능"을 갖춘 BIG-Bench 작업이 많이 있습니다.

새로운 기능을 발견하는 가장 일반적인 방법은 모델을 확장하는 것이지만, UL2R은 실제로 모델을 확장하지 않고도 새로운 기능에 영감을 줄 수 있습니다.

예를 들어 BIG-Bench의 탐색 작업에서는 U-PaLM을 제외하고 모든 모델의 훈련 FLOP가 10^23 미만입니다. 또 다른 예는 냉소적인 언어를 감지하는 모델의 능력을 측정하는 BIG-Bench의 Snarks 작업입니다.

새로운 작업 성능을 보여주는 BIG-Bench의 두 기능 모두 U-PaLM은 UL2R 타겟을 사용하여 더 작은 모델 크기에서 새로운 성능을 달성합니다.

명령어 미세 조정

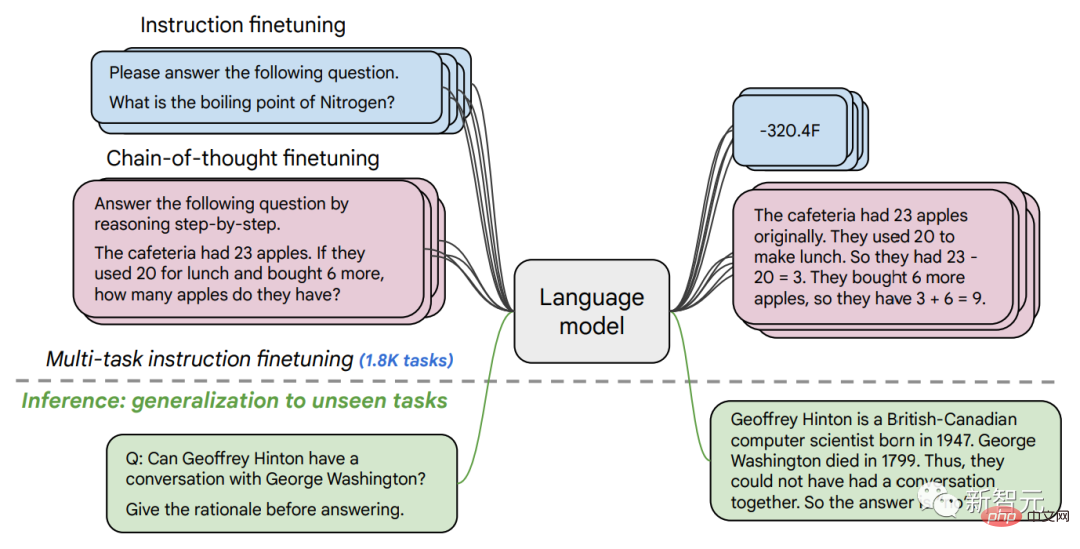

두 번째 문서에서는 명령어가 포함된 NLP 데이터 세트 세트에서 LM을 미세 조정하는 명령어 미세 조정을 살펴봅니다.

이전 작업에서는 짧은 질문에 답하기, 영화에서 표현된 감정 분류하기, 문장을 스페인어로 번역하기 등 62개의 NLP 작업에 대해 137B 매개변수 모델에 지시 미세 조정을 적용했습니다.

이 작업에서 우리는 1.8K개 이상의 작업에 대해 540B 매개변수 언어 모델을 미세 조정했습니다. 또한 이전 작업에서는 예제가 거의 없는 미세 조정된 언어 모델(예: MetaICL) 또는 예제가 없는 제로 인스턴스 언어 모델(예: FLAN, T0)만 미세 조정된 반면, 우리는 두 가지의 조합을 미세 조정했습니다.

모델이 다단계 추론을 수행할 수 있도록 하는 사고 체인 미세 조정 데이터도 포함됩니다. 우리는 언어 모델을 미세 조정하기 위해 개선된 방법을 "Flan"이라고 부릅니다.

1.8K 작업을 미세 조정하더라도 Flan은 사전 훈련에 비해 계산의 일부만 사용한다는 점에 주목할 가치가 있습니다(PaLM 540B의 경우 Flan은 사전 훈련 계산의 0.2%만 필요) .

명령어 형식으로 공식화된 1.8K 작업에 대해 언어 모델을 미세 조정하고, 미세 조정에 포함되지 않은 새로운 작업에 대해 모델을 평가합니다. 예제(예: 0샷 및 퓨샷) 유무와 사고 체인 유무에 관계없이 미세 조정이 수행되므로 모델이 다양한 평가 시나리오에 걸쳐 일반화될 수 있습니다.

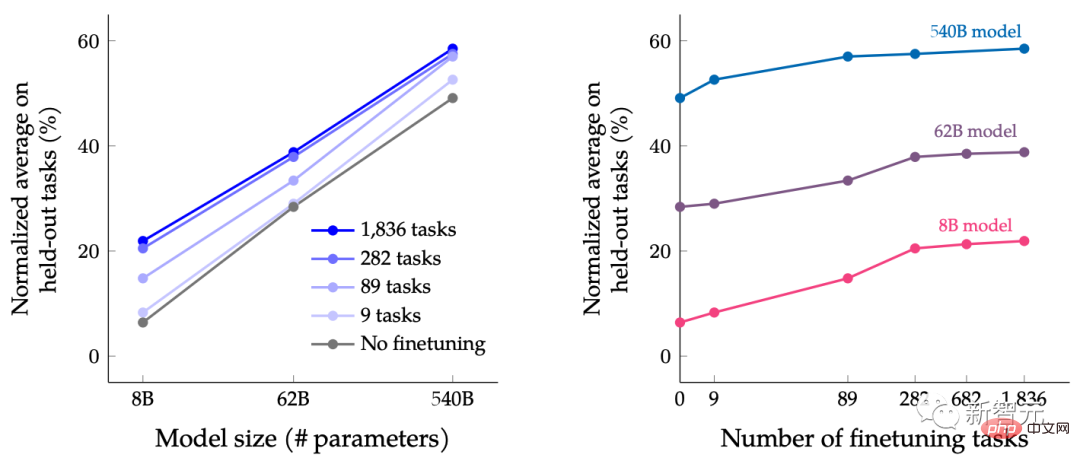

본 논문에서는 언어 모델의 크기를 확장하는 동시에 미세 조정 작업 수를 늘리는 공동 효과를 연구하는 목적으로 다양한 크기의 LM을 명령어 미세 조정합니다.

예를 들어 PaLM 클래스 언어 모델의 경우 8B, 62B 및 540B 매개변수 사양을 포함합니다. 우리 모델은 네 가지 까다로운 벤치마크 평가 기준(MMLU, BBH, TyDiQA 및 MGSM)에 따라 평가되었으며 매개변수 수를 확장하고 작업 수를 미세 조정하면 새로운 작업과 이전에 볼 수 없었던 작업의 성능을 향상시킬 수 있음을 발견했습니다.

매개변수 모델을 540B로 확장하고 1.8K 미세 조정 작업을 사용하면 성능을 향상시킬 수 있습니다. 위 그림의 y축은 4가지 평가 제품군(MMLU, BBH, TyDiQA 및 MGSM)의 정규화된 평균입니다.

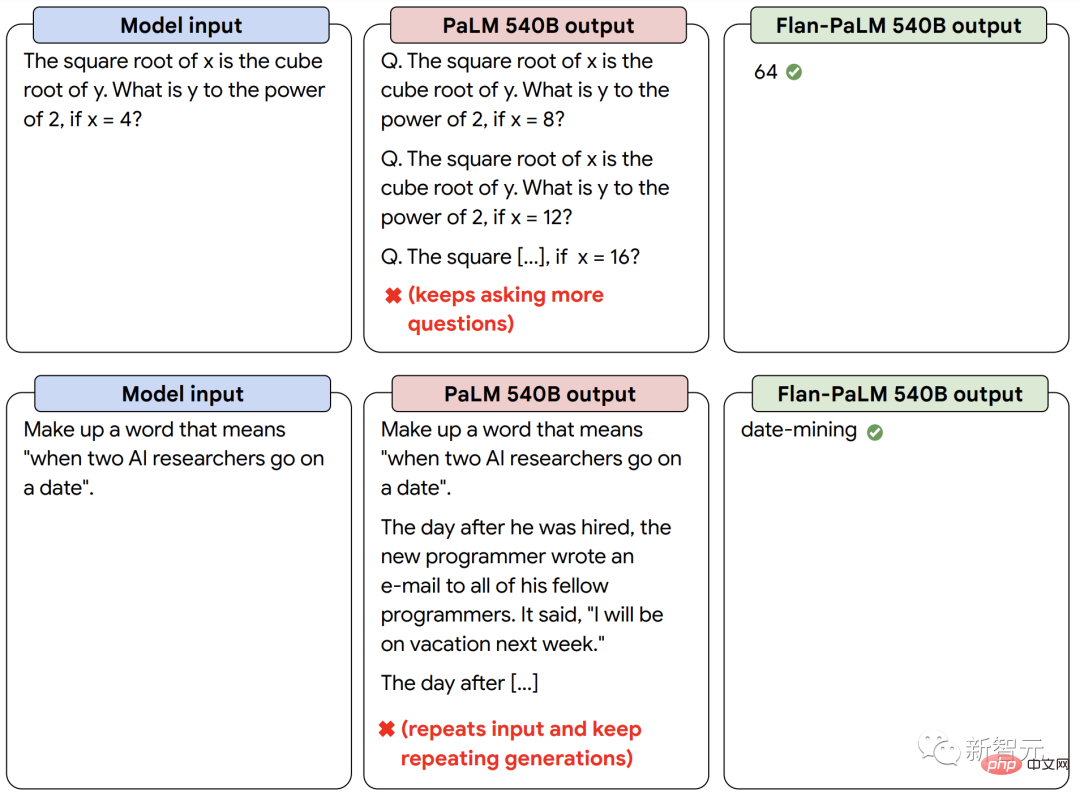

더 나은 성능 외에도 명령어 미세 조정 LM은 소수의 예제나 힌트 엔지니어링 없이도 추론 시 사용자 명령어에 반응할 수 있습니다. 이는 다양한 입력에 걸쳐 LM을 더욱 사용자 친화적으로 만듭니다. 예를 들어 명령어 미세 조정이 없는 LM은 입력을 반복하거나 지시를 따르지 않는 경우가 있지만 명령어 미세 조정을 통해 이러한 오류를 완화할 수 있습니다.

명령어 미세 조정 언어 모델 Flan-PaLM은 명령어 미세 조정이 없는 PaLM 모델에 비해 명령어에 더 잘 반응합니다.

강력한 힘을 결합하여 "1+1>2" 달성

마지막으로 UL2R과 Flan을 결합하여 Flan-U-PaLM 모델을 훈련할 수 있음을 보여줍니다.

Flan은 NLP 작업의 새로운 데이터를 사용하고 영점 명령 추적을 구현할 수 있으므로 Flan을 UL2R 다음으로 두 번째 선택 방법으로 사용합니다.

4개의 벤치마크 제품군을 다시 평가한 결과 Flan-U-PaLM 모델이 UL2R(U-PaLM)만 사용하거나 Flan(Flan-PaLM)만 사용하는 PaLM 모델보다 성능이 뛰어난 것으로 나타났습니다. 또한 Flan-U-PaLM은 사고 연결 및 자체 일관성과 결합하여 MMLU 벤치마크에서 75.4%의 점수로 새로운 SOTA에 도달했습니다.

UL2R과 Flan(Flan-U-PaLM)을 결합하면 UL2R(U-PaLM)만 사용하거나 Flan(Flan-U-PaLM)만 사용하는 것에 비해 최고의 성능을 나타냅니다. 4개 평가의 정규화 평균 제품군(MMLU, BBH, TyDiQA 및 MGSM).

요약하자면, UL2R과 Flan은 사전 훈련된 언어 모델을 개선하기 위한 두 가지 보완적인 방법입니다. UL2R은 동일한 데이터를 사용하여 LM을 잡음 제거기의 혼합 목표에 맞게 조정하는 반면, Flan은 1.8K가 넘는 NLP 작업의 교육 데이터를 활용하여 모델이 지침을 따르도록 가르칩니다.

언어 모델이 커짐에 따라 많은 양의 계산을 요구하지 않고 일반적인 성능을 향상시킬 수 있는 UL2R 및 Flan과 같은 기술이 점점 더 매력적일 수 있습니다.

위 내용은 컴퓨팅 성능이 너무 높으면 언어 모델 성능을 어떻게 향상시킬 수 있습니까? 구글이 새로운 아이디어를 가지고 있다의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!