안녕하세요 여러분.

오늘 저는 오픈 소스 대형 언어 모델 ChatGLM-6B를 여러분과 공유하고 싶습니다.

열흘만에 거의 10,000개의 별을 얻었습니다.

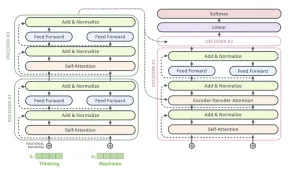

ChatGLM-6B는 중국어 및 영어 이중 언어를 지원하는 오픈 소스 대화형 언어 모델입니다. GLM(일반 언어 모델) 아키텍처를 기반으로 하며 62억 개의 매개변수를 가지고 있습니다. 모델 양자화 기술과 결합하여 사용자는 이를 소비자급 그래픽 카드에 로컬로 배포할 수 있습니다(INT4 양자화 수준에서는 최소 6GB의 비디오 메모리가 필요함). ChatGLM-6B는 ChatGPT와 유사한 기술을 사용하며 중국어 질문과 답변 및 대화에 최적화되어 있습니다. 감독된 미세 조정, 피드백 셀프 서비스, 인간 피드백 강화 학습 및 기타 기술로 보완된 약 1T 식별자를 사용하여 중국어와 영어로 된 이중 언어 교육을 마친 후 62억 개의 매개변수 ChatGLM-6B는 다음과 상당히 일치하는 답변을 생성할 수 있었습니다. 인간의 선호.

누구나 자신의 컴퓨터에 설치하여 사용해 볼 수 있습니다. 독립 그래픽의 최소 비디오 메모리는 6G이며 CPU 컴퓨터에서도 실행할 수 있지만 속도가 매우 느립니다.

이 프로젝트는 현재 모델과 추론 코드만 오픈소스로 제공하고 모델 교육은 오픈소스로 제공하지 않습니다.

프로젝트를 실행하려면 두 단계만 필요합니다.

첫 번째 단계는 소스 코드를 다운로드하는 것입니다

git clone https://github.com/THUDM/ChatGLM-6B.git

pip install -r 요구사항.txt를 실행하여 종속성을 설치합니다

두 번째 단계는 프로젝트를 실행하는 것입니다

python web_demo.py

실행 후에는 아마도 4G 정도에서 모델 파일이 자동으로 다운로드될 것입니다.

GPU에서 실행 중인 경우 기본적으로 실행 중인 모델의 비디오 메모리는 13G 이상입니다. 비디오 메모리가 충분하지 않은 경우 web_demo.py

tokenizer = AutoTokenizer.from_pretrained("THUDM/chatglm-6b", trust_remote_code=True)

model = AutoModel.from_pretrained("THUDM/chatglm-6b", trust_remote_code=True).half().cuda()위 코드에서 THUDM/chatglm-6b를 수정하세요. THUDM/chatglm-6b-int4 , 즉 int4 양자화 모델로 전환하면 비디오 메모리가 6g보다 큰 한 원활하게 실행될 수 있습니다.

CPU 메모리가 부족하다고 보고되면 다른 소프트웨어, 특히 브라우저를 닫으세요.

성공적으로 실행되면 자동으로 브라우저 페이지로 이동하며, ChatGPT처럼 사용할 수 있습니다.

다음은 내 로컬 작업 결과입니다. ChatGPT

자기 인식

개요 쓰기

이메일 쓰기

W 의식 코드

롤플레잉

이 프로젝트는 실행이 매우 간단하므로 시도해 볼 수 있습니다.

이 글이 도움이 되셨다면 "읽기"를 눌러 저를 격려해주세요. 앞으로도 훌륭한 Python+AI 프로젝트를 공유하겠습니다.

위 내용은 컴퓨터에 ChatGPT를 설치하시겠습니까? 국내 오픈소스 대형언어모델 ChatGLM이 이를 실현시켜드립니다!의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

H20 Chip Ban Jolts China AI 회사이지만 오랫동안 충격을 받기 위해 자랑했습니다.Apr 25, 2025 am 11:12 AM

H20 Chip Ban Jolts China AI 회사이지만 오랫동안 충격을 받기 위해 자랑했습니다.Apr 25, 2025 am 11:12 AMAdvanced AI 하드웨어에 대한 최근 제한은 AI 지배에 대한 확대 된 지정 학적 경쟁을 강조하여 중국의 외국 반도체 기술에 대한 의존도를 드러냅니다. 2024 년에 중국은 3,800 억 달러 상당의 반도체를 수입했습니다.

OpenAi가 Chrome을 구매하면 AI는 브라우저 전쟁을 지배 할 수 있습니다.Apr 25, 2025 am 11:11 AM

OpenAi가 Chrome을 구매하면 AI는 브라우저 전쟁을 지배 할 수 있습니다.Apr 25, 2025 am 11:11 AMGoogle의 Chrome의 잠재적 인 강제 매각은 기술 산업 내에서 강력한 논쟁을 불러 일으켰습니다. OpenAi가 65%의 글로벌 시장 점유율을 자랑하는 주요 브라우저를 인수 할 가능성은 TH의 미래에 대한 중요한 의문을 제기합니다.

AI가 소매 미디어의 고통을 해결할 수있는 방법Apr 25, 2025 am 11:10 AM

AI가 소매 미디어의 고통을 해결할 수있는 방법Apr 25, 2025 am 11:10 AM전반적인 광고 성장을 능가 함에도 불구하고 소매 미디어의 성장은 느려지고 있습니다. 이 성숙 단계는 생태계 조각화, 비용 상승, 측정 문제 및 통합 복잡성을 포함한 과제를 제시합니다. 그러나 인공 지능

'AI는 우리이고 우리보다 더 많아요'Apr 25, 2025 am 11:09 AM

'AI는 우리이고 우리보다 더 많아요'Apr 25, 2025 am 11:09 AM깜박 거리는 스크린 모음 속에서 정적으로 오래된 라디오가 딱딱합니다. 이 불안정한 전자 제품 더미, 쉽게 불안정하게, 몰입 형 전시회에서 6 개의 설치 중 하나 인 "The-Waste Land"의 핵심을 형성합니다.

Google Cloud는 다음 2025 년 인프라에 대해 더 진지하게 생각합니다.Apr 25, 2025 am 11:08 AM

Google Cloud는 다음 2025 년 인프라에 대해 더 진지하게 생각합니다.Apr 25, 2025 am 11:08 AMGoogle Cloud의 다음 2025 : 인프라, 연결 및 AI에 대한 초점 Google Cloud의 다음 2025 회의는 수많은 발전을 선보였으며 여기에서 자세히 설명하기에는 너무 많았습니다. 특정 공지 사항에 대한 심도있는 분석은 My의 기사를 참조하십시오.

Talking Baby ai Meme, Arcana의 550 만 달러 AI 영화 파이프 라인, IR의 비밀 후원자 공개Apr 25, 2025 am 11:07 AM

Talking Baby ai Meme, Arcana의 550 만 달러 AI 영화 파이프 라인, IR의 비밀 후원자 공개Apr 25, 2025 am 11:07 AM이번 주 AI 및 XR : AI 구동 창의성의 물결은 음악 세대에서 영화 제작에 이르기까지 미디어와 엔터테인먼트를 통해 휩쓸고 있습니다. 헤드 라인으로 뛰어 들자. AI 생성 콘텐츠의 영향력 증가 : 기술 컨설턴트 인 Shelly Palme

신뢰할 수있는 Q & A, Rag 및 Info Extraction을 위해 Teapotllm을 사용해보십시오Apr 25, 2025 am 10:45 AM

신뢰할 수있는 Q & A, Rag 및 Info Extraction을 위해 Teapotllm을 사용해보십시오Apr 25, 2025 am 10:45 AMTeapotllm : 가벼운 환각 방지 언어 모델 텍스트 생성 모델은 연구 및 응용 프로그램을위한 강력한 도구, 아키텍처, 교육 및 광범위한 데이터 세트를 활용하여 놀라운 기능을 달성합니다. Teapotai의 Open-S

Devin 2.0의 새로운 기능은 무엇입니까? 내부의 전체 고장Apr 25, 2025 am 10:43 AM

Devin 2.0의 새로운 기능은 무엇입니까? 내부의 전체 고장Apr 25, 2025 am 10:43 AMDevin 2.0 : AI를 통한 소프트웨어 개발 혁신 인지 AI의 Devin 2.0은 개발자의 작동 방식을 변화시키고 있습니다. 전임자 인 Devin 2.0의 상당한 업그레이드는 향상된 속도, 효율성 및 사용 편의성을 자랑합니다. 이 AI 기반 도구 Str

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

Video Face Swap

완전히 무료인 AI 얼굴 교환 도구를 사용하여 모든 비디오의 얼굴을 쉽게 바꾸세요!

인기 기사

뜨거운 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

SecList

SecLists는 최고의 보안 테스터의 동반자입니다. 보안 평가 시 자주 사용되는 다양한 유형의 목록을 한 곳에 모아 놓은 것입니다. SecLists는 보안 테스터에게 필요할 수 있는 모든 목록을 편리하게 제공하여 보안 테스트를 더욱 효율적이고 생산적으로 만드는 데 도움이 됩니다. 목록 유형에는 사용자 이름, 비밀번호, URL, 퍼징 페이로드, 민감한 데이터 패턴, 웹 셸 등이 포함됩니다. 테스터는 이 저장소를 새로운 테스트 시스템으로 간단히 가져올 수 있으며 필요한 모든 유형의 목록에 액세스할 수 있습니다.

SublimeText3 영어 버전

권장 사항: Win 버전, 코드 프롬프트 지원!

Atom Editor Mac 버전 다운로드

가장 인기 있는 오픈 소스 편집기

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경