ControlNet 별 수가 10,000개를 초과했습니다! 2023년에는 AI 그림이 미쳐버릴까?

- 王林앞으로

- 2023-04-13 11:25:021202검색

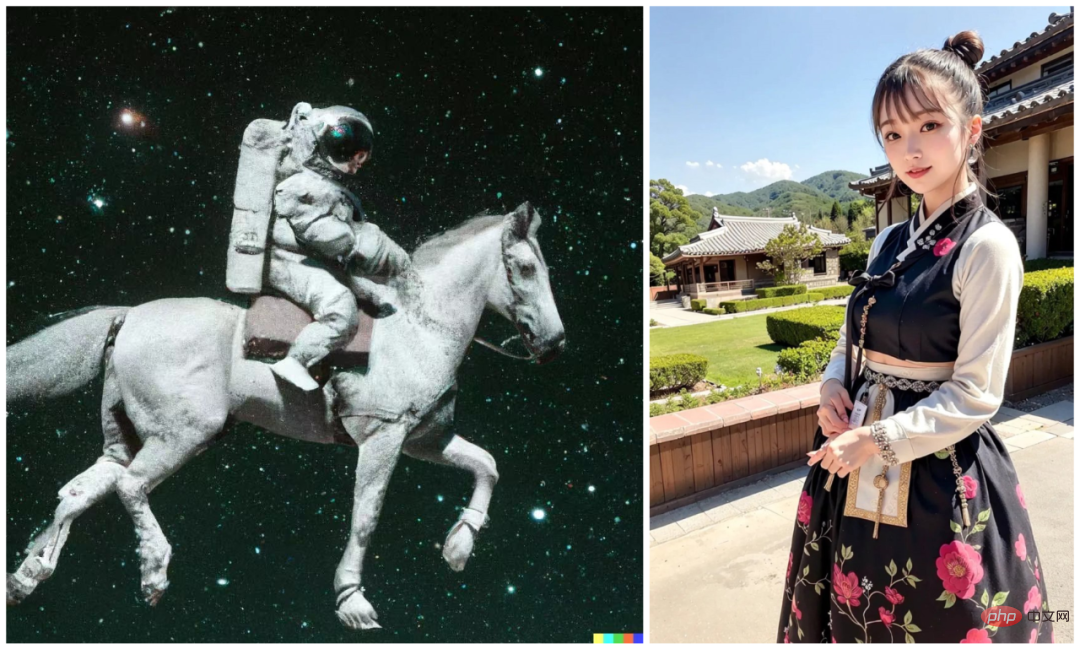

말을 타는 우주 비행사에서 입체적인 여성으로, AI 페인팅은 1년도 안 되어 혁명적인 발전을 이룬 것 같습니다.

이 "말을 타는 우주비행사"는 OpenAI가 2022년 4월 출시한 빈첸시안 그래프 모델 DALL・E 2가 그린 작품입니다. 이전 버전인 DALL・E는 2021년에 텍스트에서 직접 이미지를 생성하는 기능을 사람들에게 시연하여 자연 언어와 시각 사이의 차원 벽을 허물었습니다. 이를 바탕으로 DALL・2는 한 단계 더 발전하여 사진에 코기를 추가하는 등 원본 이미지를 편집할 수 있습니다. 간단해 보이는 이 조작은 실제로 AI 페인팅 모델의 제어 가능성이 향상되었음을 반영합니다.

그러나 영향력 측면에서 2022년 가장 인기 있는 Vincent 다이어그램 모델은 DALL・E 2가 아니라 이와 유사한 기능을 가진 또 다른 모델인 Stable Diffusion입니다. DALL・E 2와 마찬가지로 Stable Diffusion을 사용하면 제작자가 생성된 이미지를 편집할 수 있지만 모델이 오픈 소스이고 소비자급 GPU에서 실행될 수 있다는 장점이 있습니다. 따라서 Stable Diffusion은 2022년 8월 출시 이후 빠르게 인기를 얻었으며 불과 몇 달 만에 가장 인기 있는 Vincent 다이어그램 모델이 되었습니다.

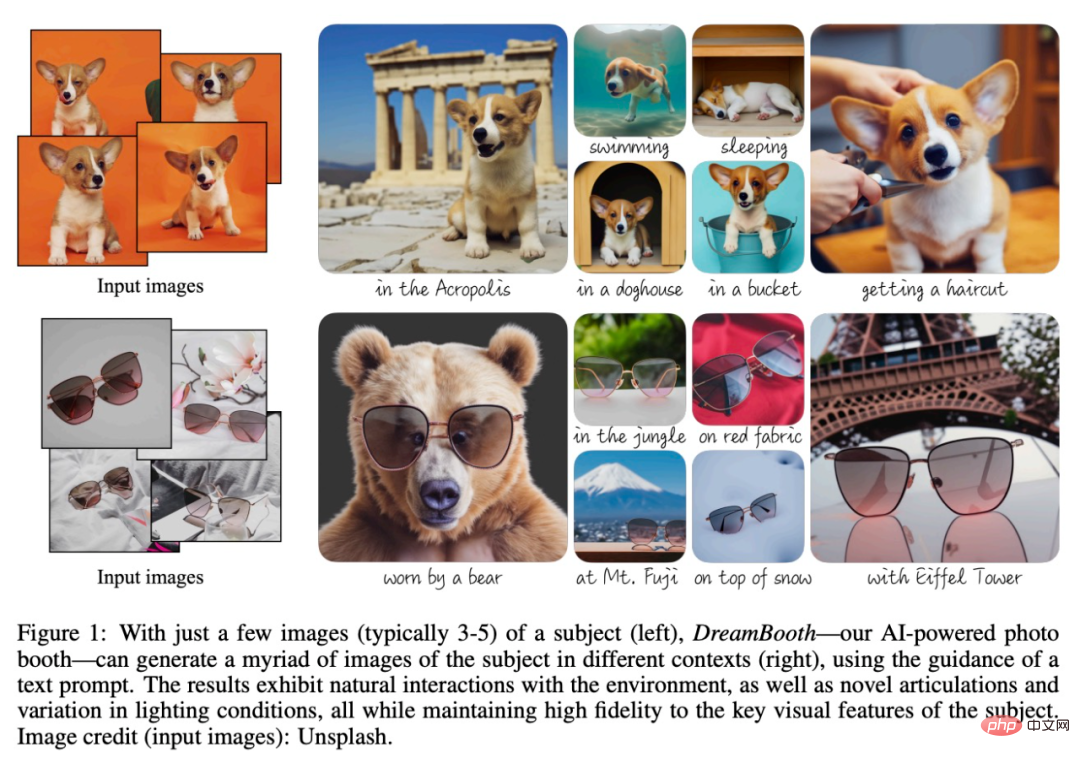

Google과 Boston University의 연구원들이 "개인화된" 텍스트-이미지 확산 모델을 제안했습니다. DreamBooth, 사용자는 3~5개의 샘플과 한 문장만 제공하면 됩니다. 그런 다음, AI는 사실적인 이미지를 맞춤화할 수 있습니다.

또한 UC Berkeley 연구팀은 인간의 지시에 따라 이미지를 편집하는 새로운 방법도 제안했습니다. InstructPix2Pix, 이 모델은 GPT-3과 안정적인 확산. 입력 이미지와 모델에 수행할 작업을 알려주는 텍스트 설명이 주어지면 모델은 설명 지침에 따라 이미지를 편집할 수 있습니다. 예를 들어, 그림 속 해바라기를 장미로 교체하려면 모델에게 직접 "해바라기를 장미로 교체하세요"라고 말하면 됩니다.

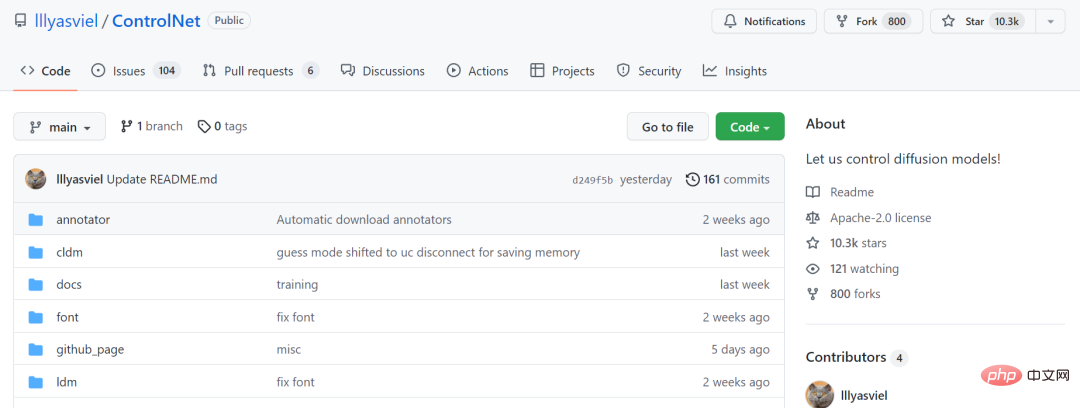

2023년에 접어들면서 ControlNet이라는 모델이 이러한 유형의 제어 유연성을 최고조로 끌어올렸습니다.

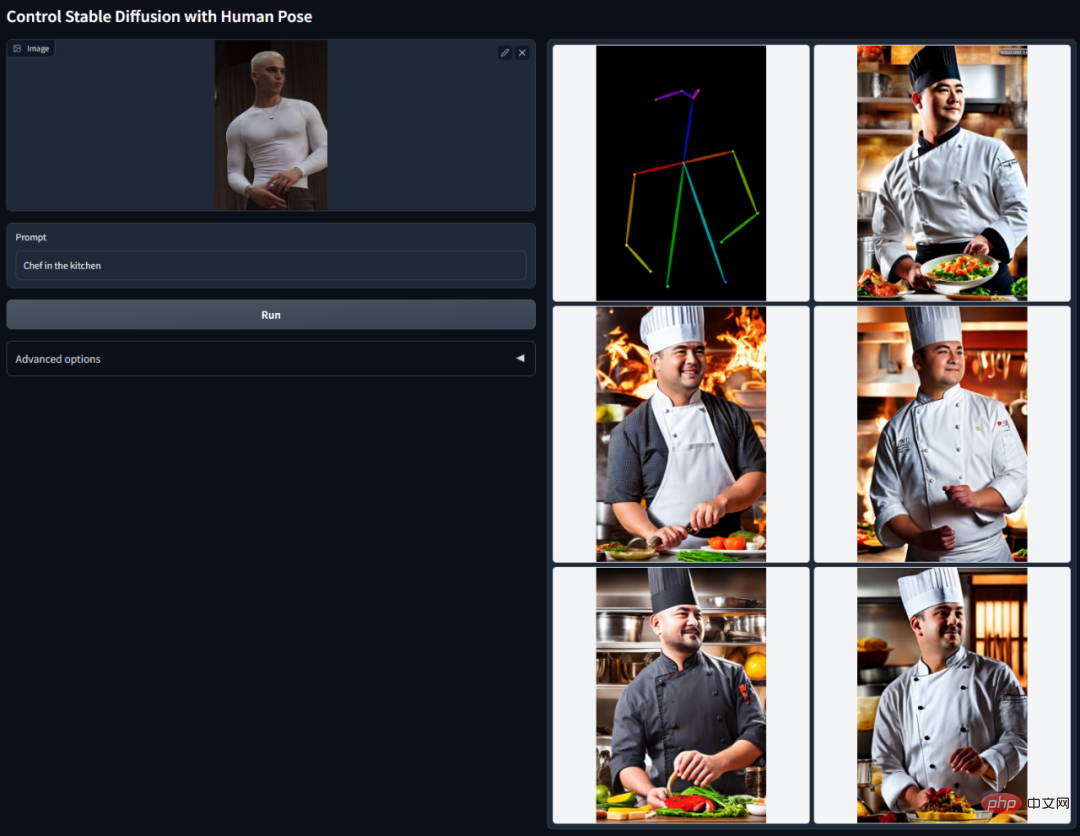

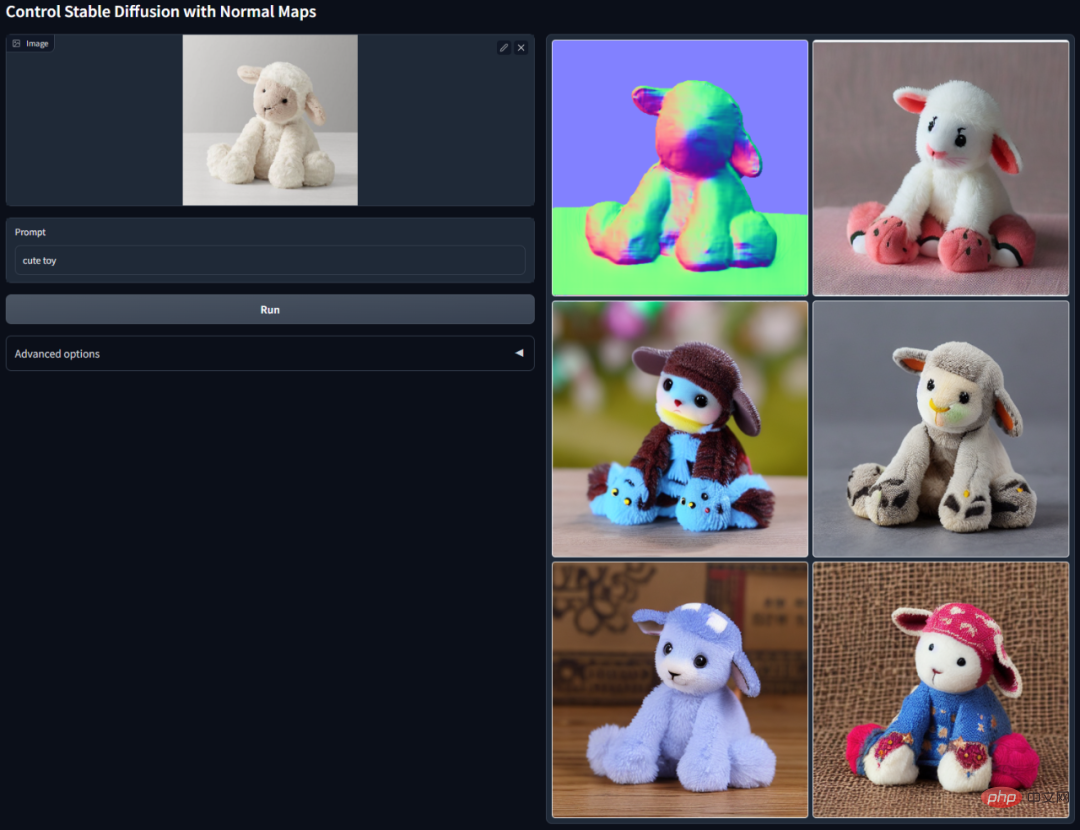

ControlNet의 핵심 아이디어는 텍스트 설명에 몇 가지 추가 조건을 추가하여 확산 모델(예: Stable Diffusion)을 제어함으로써 생성된 캐릭터 포즈, 깊이, 그림 구조 및 기타 정보를 더 잘 제어하는 것입니다. 영상.

여기서 추가 조건은 이미지 형식으로 입력됩니다. 모델은 이를 기반으로 Canny Edge 감지, 깊이 감지, 의미론적 분할, Hough 변환 선 감지, 전체 중첩 모서리 감지(HED) 및 인간 자세를 수행할 수 있습니다. 입력 이미지 인식 등을 수행한 다음 생성된 이미지에 이 정보를 유지합니다. 이 모델을 사용하면 선화나 그래피티를 풀컬러 이미지로 직접 변환하고, 동일한 깊이 구조의 이미지를 생성할 수 있으며, 손 키 포인트를 통해 캐릭터 손 생성을 최적화할 수 있습니다.

이 모델은 AI 페인팅 분야에 큰 파장을 일으켰고, 관련 프로젝트의 GitHub 스타 수가 10,000명을 넘었습니다.

프로젝트 링크: https://github.com/lllyasviel/ControlNet

현재 많은 사람들이 2차원 및 3차원 여성을 생성하는 데에만 사용하지만, 그 이상입니다. 널리 사용되는 그 용도는 주택 디자인, 사진, 영화 및 TV 제작, 광고 디자인 등과 같이 점차적으로 발견되었습니다. 이러한 시나리오에서 ControlNet은 대규모 모델 미세 조정 문제를 처리하기 위한 LoRA, 비디오-애니메이션 변환 도구 EbSynth 등과 같은 일부 이전 도구와 함께 사용됩니다. 이러한 도구를 결합하면 AI 페인팅 모델을 생산 프로세스에 통합하는 속도가 빨라집니다.

ControlNet 및 EbSynth와 같은 도구를 사용하여 인테리어를 재설계하세요. 이미지 출처: https://creativetechnologydigest.substack.com/p/controlling-artistic-chaos-with-controlnet (전체 튜토리얼 포함)

ControlNet 및 Houdini 도구 사용 3D 모델을 생성합니다. 이미지 출처: https://www.reddit.com/r/StableDiffusion/comments/115eax6/im_working_on_api_for_the_a1111_controlnet/

Dreambooth 및 Con 사용 Net은 2D 이미지 조명을 변경할 수 있습니다. 사진 및 비디오의 후반 작업에 사용됩니다. 이미지 출처: https://www.reddit.com/r/StableDiffusion/comments/1175id9/when_i_say_mindbloing_i_mean_it_new_experiments/

ControlNet 및 E 사용 bSynth는 애니메이션을 실제 인물로 변환합니다. . 아직 결과가 좋지는 않지만, 배우가 출연하지 않고도 애니메이션을 실사화할 수 있는 가능성을 보여주었다. 이미지 출처 https://www.reddit.com/r/StableDiffusion/comments/117ewr9/anime_to_live_action_with_controlnet_ebsynth_not/

디자이너가 ControlNet을 사용하여 생성한 유명 브랜드 "새로운 로고". 이미지 출처: https://twitter.com/fofrAI/status/1628882166900744194

놀랍게도 이러한 기술의 발전은 회화 및 기타 분야의 실무자들을 불안과 분노에 빠뜨렸습니다. 걱정되는 점은 AI가 당신의 직업을 빼앗아 갈 수 있다는 것입니다. 안타깝지만 AI가 생성한 이미지 중 상당수는 현직 화가들의 표절과 모방으로, 화가들의 지적재산권이 침해됐다.

이러한 문제가 아직 해결되지 않은 가운데 AI 페인팅은 화가들 사이에서 날카로운 문제가 되었습니다. 많은 사람들은 모든 사람이 AI 그림을 보이콧하고 공동으로 자신의 권리를 지켜야 한다고 믿습니다. 그래서 유명 아티스트가 AI 페인팅을 이용해 게임 스튜디오에 기여했다는 의혹이 제기됐다는 소식이 퍼지자 다른 아티스트들은 완전히 분노했다.

동시에 게이머들도 분노했습니다. 현재 AI 페인팅에는 손 세부 사항을 잘 처리할 수 없는 등 일부 제한 사항이 있기 때문에(이 기사의 첫 번째 사진에 있는 소녀를 자세히 보면 알 수 있음) 플레이어의 요구 사항을 충족할 수 없습니다. 절묘한 시각 효과, 개성과 창의력을 갖춘 캐릭터 등으로 인해 많은 플레이어들이 "속았다"고 느꼈습니다. 따라서 위 게임 스튜디오는 “자사 제품에 AI 페인팅을 사용하지 않겠다”는 긴급 성명을 낼 수밖에 없다.

그런데 이 상황이 언제까지 갈까요? AI 그림의 수준이 육안으로 구별하기 어려운 수준에 이르렀을 때, 지금 하고 있는 게임이 작가의 게임인지, AI의 게임인지, 아니면 둘로 구성된 '팀'인지 어떻게 알 수 있을까요?

출처: https://m.weibo.cn/2268335814/4870844515358190

아마도 몇 달 안에 , AI 페인팅 도구는 Copilot과 같은 프로그래머와 같을 것입니다. 그것은 일상 작업에서 화가들에게 없어서는 안 될 도구가 되었습니다. 물론 이는 AI의 '침략'을 받은 다른 산업과 마찬가지로 사실상 이 산업의 기준을 높였습니다. 이러한 흐름 속에서 어떻게 경쟁력을 유지할 수 있는가는 모두가 고민해야 할 문제일 것이다.

위 내용은 ControlNet 별 수가 10,000개를 초과했습니다! 2023년에는 AI 그림이 미쳐버릴까?의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!