압축된 음성 표현으로 고성능 음성 합성 시스템을 구축하는 방법

- WBOY앞으로

- 2023-04-13 11:10:021640검색

Xiaohongshu 멀티미디어 지능형 알고리즘 팀과 홍콩 중문 대학교는 처음으로 다단계 다중 코드북 컴팩트 음성 표현을 기반으로 하는 고성능 음성 합성 방식 MSMC-TTS를 공동으로 제안했습니다. VQ-VAE(벡터 양자화된 변형 자동 인코더)를 기반으로 하는 특징 분석기는 여러 코드북을 사용하여 음향 특징을 단계적으로 인코딩하여 서로 다른 시간 해상도를 가진 잠재 시퀀스 세트를 형성합니다. 이러한 잠재 시퀀스는 다단계 예측기를 통해 텍스트에서 예측할 수 있으며 신경 보코더를 통해 대상 오디오로 변환될 수 있습니다. Mel-Spectrogram 기반 Fastspeech 기준 시스템과 비교하여 이 솔루션은 음질과 자연스러움이 크게 향상되었습니다. 이 작업은 이제 "고성능 신경 TTS에 대한 다단계 다중 코드북 VQ-VAE 접근 방식"이라는 논문으로 요약되었으며 음성 도메인 컨퍼런스 INTERSPEECH 2022에서 승인되었습니다.

1. 배경 소개

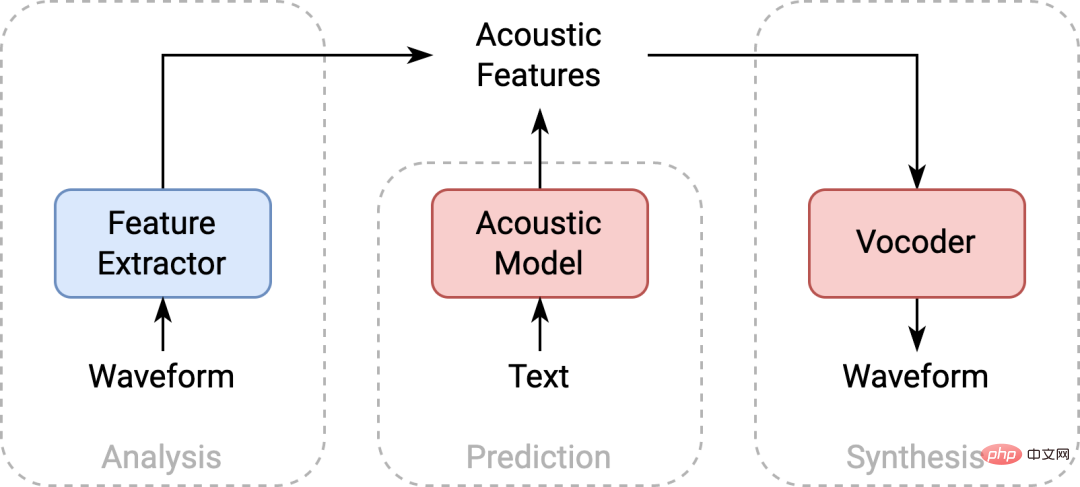

텍스트 음성 변환(TTS)은 텍스트를 음성으로 변환하는 기술로, 비디오 더빙, 오디오 및 비디오 콘텐츠 제작, 지능형 인간-컴퓨터 상호 작용 및 기타 제품에 널리 사용됩니다. 주류 음성 합성 시스템의 백엔드 음향 모델링 기술은 일반적으로 특징 추출기, 음향 모델 및 보코더의 세 부분으로 구성됩니다. TTS는 일반적으로 신호 처리(예: Mel Spectrogram)를 기반으로 얻은 음향 특징에 대해 음향 모델링을 수행합니다. 그러나 모델의 피팅 능력에 따라 예측된 음향 특징과 실제 데이터 간의 분포에 일정한 차이가 있습니다. 실제 데이터로 훈련된 보코더가 예측된 특징으로부터 고품질 오디오를 생성하기 어렵게 만듭니다.

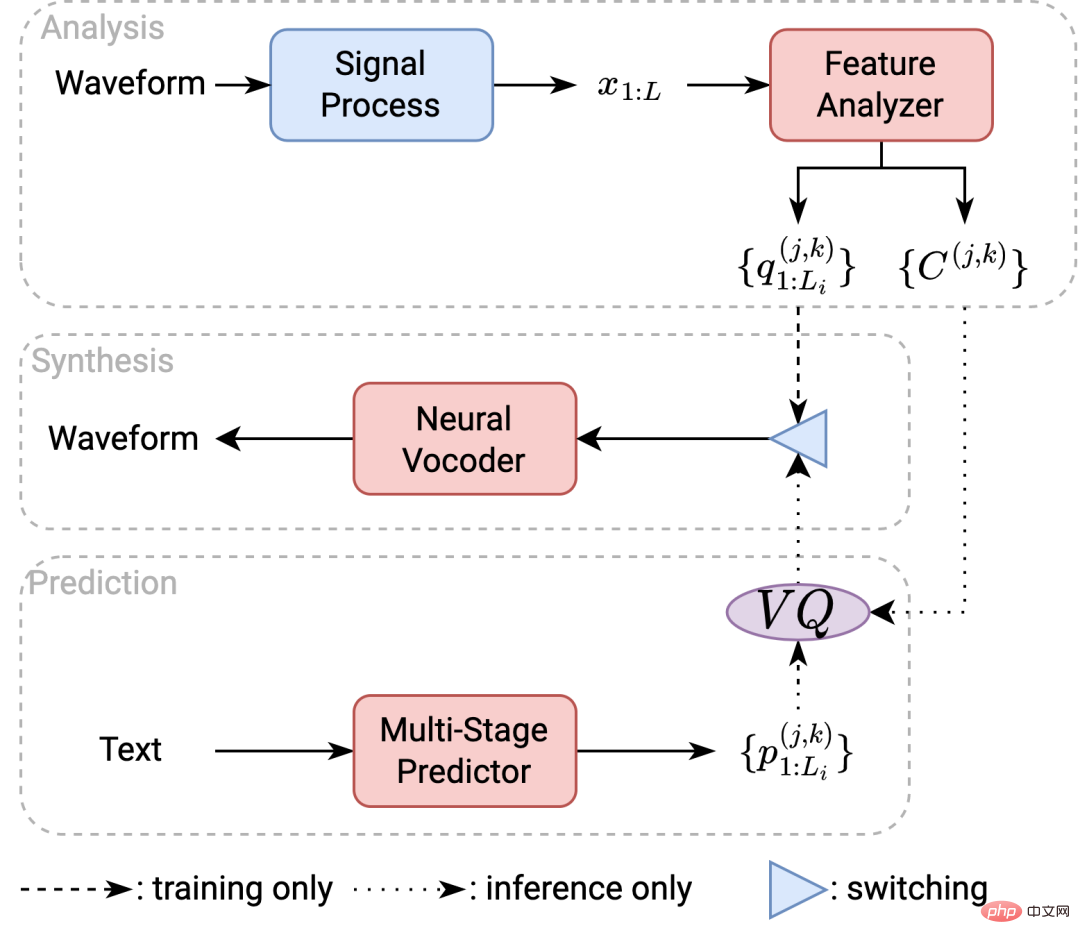

TTS 시스템 프레임워크 다이어그램

이 문제를 해결하기 위해 학계에서는 예측 오류와 분포 차이를 줄이기 위해 더 복잡한 모델 구조와 더 새로운 생성 알고리즘을 사용했습니다. 이 작업은 문제를 고려하기 위한 출발점으로 간결한 음성 표현을 취하는 다른 접근 방식을 취합니다. 음성 합성의 경우 1) 음향 특징의 우수한 압축성은 보다 정확한 모델 예측 결과와 보다 강력한 파형 생성을 보장할 수 있습니다. 2) 음향 특징의 우수한 완전성은 음성 신호의 더 나은 재구성을 보장할 수 있습니다. 이러한 두 가지 고려 사항을 기반으로 이 논문에서는 벡터 양자화 변형 자동 인코더(VQ-VAE)를 사용하여 대상 데이터에서 더 컴팩트한 표현을 마이닝하는 것을 제안합니다.

2. MSMC VQ-VAE

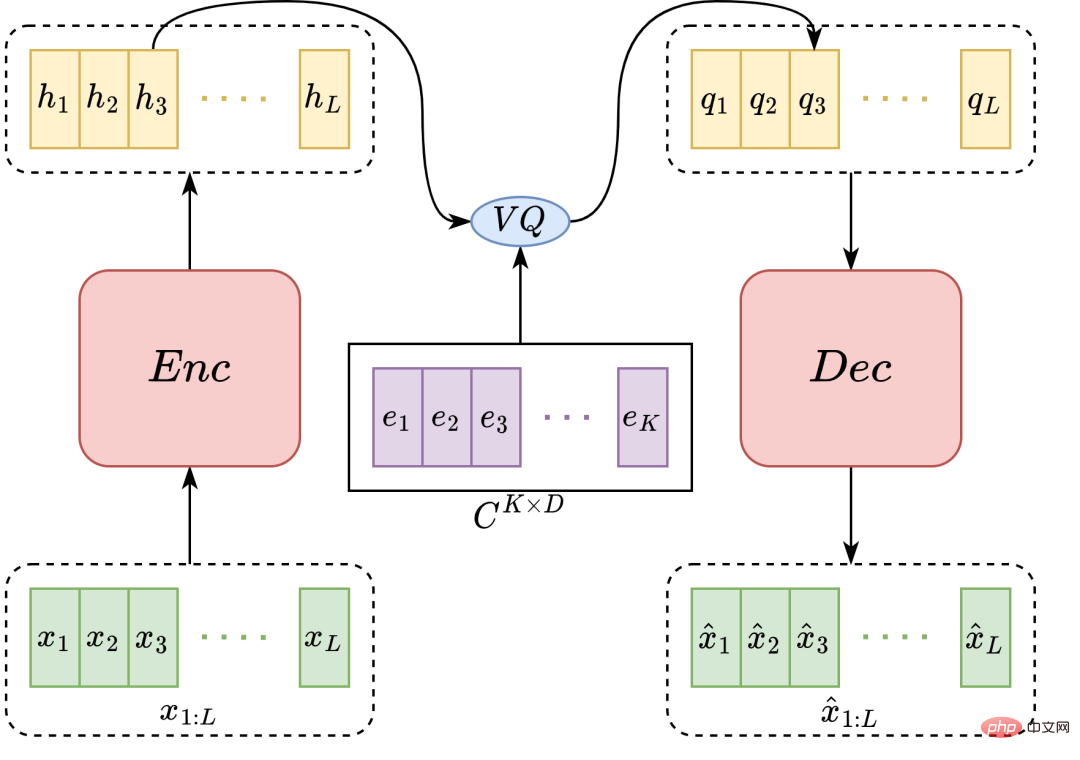

VQ-VAE에는 인코더와 디코더가 포함된 표현 학습. 인코더는 입력된 음향 특징 시퀀스를 잠재 시퀀스로 처리하고 해당 코드북을 사용하여 이를 양자화합니다. 디코더는 양자화된 시퀀스를 원래의 음향 특징 시퀀스로 복원합니다. 이 양자화된 시퀀스는 이산화된 표현으로서 더 나은 압축성(특성 매개변수의 수가 적음)을 갖습니다. 양자화 정도가 높을수록, 즉 코드북 용량이 작을수록 특징의 컴팩트성은 높아집니다. 그러나 이로 인해 정보가 압축되고 기능 완성도가 저하됩니다. 충분한 완성도를 보장하기 위해 일반적으로 더 많은 코드워드가 사용됩니다. 그러나 코드북 용량이 증가함에 따라 코드북 업데이트에 필요한 데이터의 양과 훈련 횟수가 기하급수적으로 증가하므로 VQ-VAE가 코드북을 늘려 표현 완성도를 효과적으로 높이기가 어렵습니다. 이러한 문제를 해결하기 위해 본 논문에서는 MHVQ(Multi-Head Vector Quantization) 방법을 제안한다.

VQ-VAE 모델 구조 다이어그램

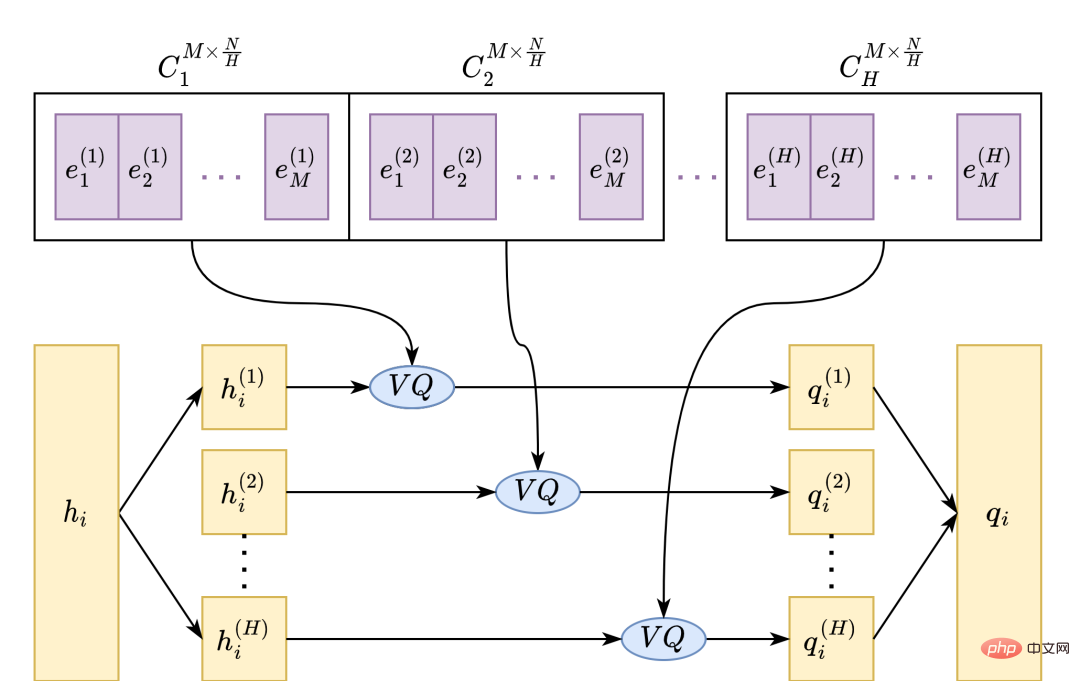

MHVQ는 특징 차원 방향에 따라 단일 코드북을 여러 하위 코드북으로 나눕니다. 양자화 중에 각 입력 벡터는 여러 하위 벡터로 동일하게 절단되고 각각 해당 하위 코드북으로 양자화되며 최종적으로 출력 벡터로 연결됩니다. 이러한 방식으로 코드북 매개변수의 양을 늘리지 않고도 코드북 활용도와 표현 용량을 보다 효과적으로 향상시킬 수 있습니다. 예를 들어 압축률을 1배로 줄이려면 코드워드를 원래 코드북 번호의 제곱으로 늘려야 합니다. MHVQ를 사용한 후 코드북을 두 부분으로 나누기만 하면 동일한 압축률을 얻을 수 있습니다. 따라서 이 방법은 정량적 표현의 완전성을 보다 효과적으로 규제할 수 있습니다.

MHVQ 예시 사진

또한, 음성 시퀀스를 양자화할 때 음성 특징에 포함된 다양한 유형의 정보가 다양한 정도로 손실됩니다. 이 정보는 거친 음색, 발음 스타일 등의 시간 단위와 세밀한 음조, 발음 세부 사항 등이 다릅니다. 모든 시간 규모에서 정보를 과도하게 압축하면 음성 품질이 어느 정도 저하될 수 있습니다. 이러한 문제를 완화하기 위해 본 연구에서는 다중 시간 규모 음성 모델링 방법을 제안합니다. 그림에 도시된 바와 같이, 음향 특징 시퀀스는 여러 인코더를 통해 단계적으로 서로 다른 시간 스케일로 인코딩된 후 디코더를 통해 계층별로 양자화되고, 디코딩되어 서로 다른 시간 해상도를 갖는 여러 양자화된 시퀀스를 얻습니다. 이러한 유형의 시퀀스 집합으로 구성된 표현은 본 연구에서 제안하는 다단계 다중 코드북 표현이다.

다단계 모델링 예제 다이어그램

3. 음향 모델링 MSMC-TTS

다단계 다중 코드북 특성화 MSMCR을 고려하여 본 논문에서는 이에 상응하는 TTS 시스템, 즉 MSMC-TTS 시스템을 제안합니다. . 시스템은 분석, 합성, 예측의 세 부분으로 구성됩니다. 시스템 교육에서 시스템은 먼저 분석 모듈을 교육합니다. 훈련 세트의 오디오는 신호 처리 후 완성도가 높은 음향 기능(예: 이 작업에 사용된 Mel-Spectrogram 기능)으로 변환됩니다. 이러한 음향 특징은 MSMC-VQ-VAE 기반의 특징 분석기를 훈련하는 데 사용되며 훈련이 끝나면 해당 MSMCR로 변환된 다음 음향 모델과 신경 보코더가 훈련됩니다. 디코딩하는 동안 시스템은 음향 모델을 사용하여 텍스트에서 MSMCR을 예측한 다음 신경 보코더를 사용하여 대상 오디오를 생성합니다.

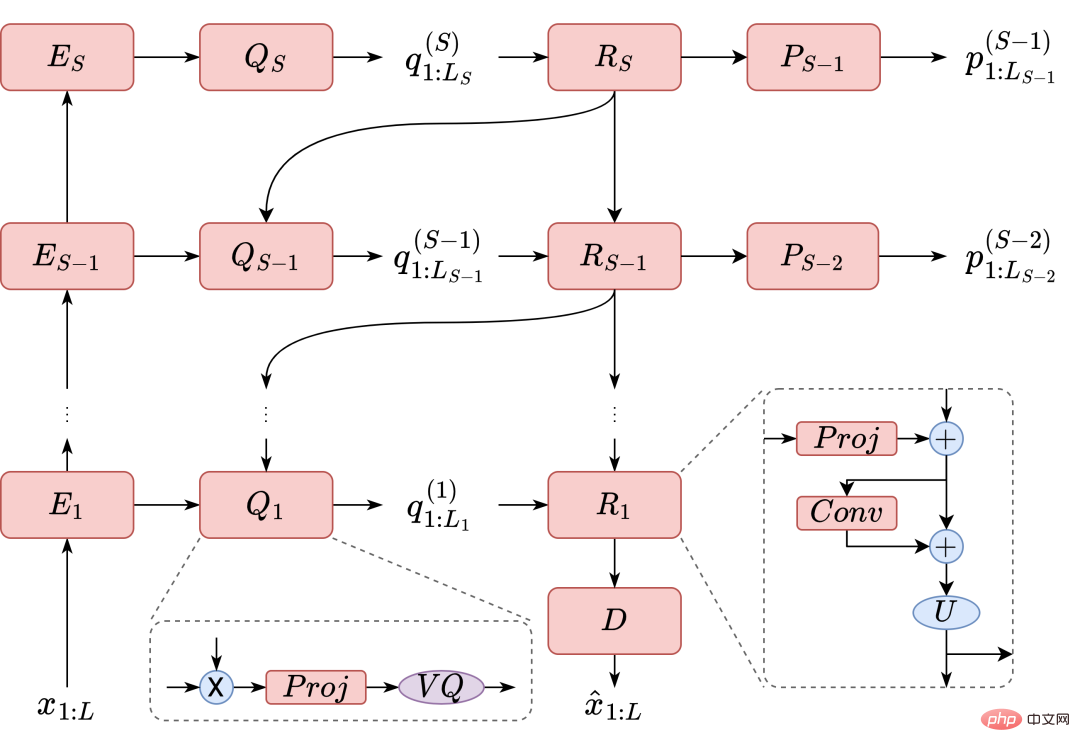

MSMC-TTS 시스템 프레임워크 다이어그램

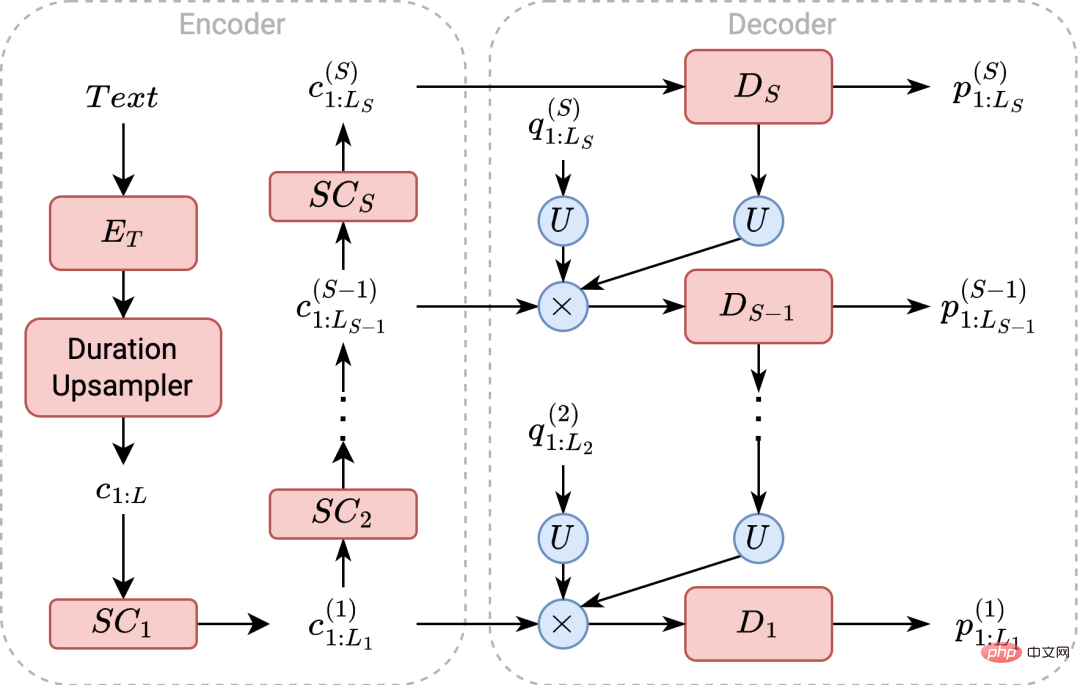

이 작업은 또한 MSMCR 모델링을 적용하기 위한 다단계 예측기를 제안합니다. 이 모델은 FastSpeech를 기반으로 구현되지만 디코더 측에서는 다릅니다. 모델은 먼저 텍스트를 인코딩하고 예측 기간 정보를 기반으로 텍스트를 업샘플링합니다. 그런 다음 시퀀스는 MSMCR에 해당하는 각 시간 해상도로 다운샘플링됩니다. 이러한 시퀀스는 다양한 디코더에 의해 저해상도에서 고해상도까지 단계별로 디코딩 및 양자화됩니다. 동시에 저해상도 양자화 시퀀스는 예측을 돕기 위해 다음 단계 디코더로 전송됩니다. 마지막으로 예측된 MSMCR은 신경 보코더에 입력되어 대상 오디오를 생성합니다.

다단계 예측기 구조 다이어그램

다단계 예측기를 훈련하고 추론할 때 이 작업은 연속 공간에서 목표 표현을 직접 예측하도록 선택합니다. 이 방법은 선형 연속 공간에서 벡터와 코드워드 간의 거리 관계를 더 잘 고려할 수 있습니다. TTS 모델링에 일반적으로 사용되는 MSE 손실 함수 외에도 훈련 기준은 "삼중 손실"을 사용하여 예측 벡터를 비목표 코드워드에서 멀어지고 목표 코드워드에 더 가깝게 만듭니다. 두 개의 손실 함수 항을 결합함으로써 모델은 대상 코드워드를 더 잘 예측할 수 있습니다.

4. 실험 결과

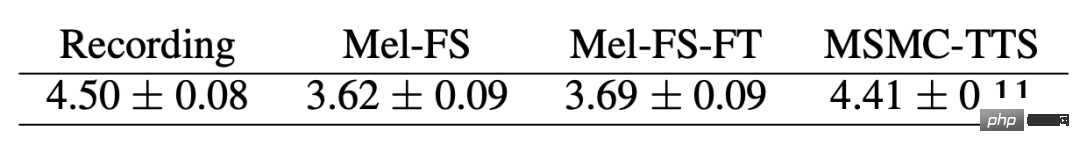

이 작업은 공개 영어 단일 화자 데이터 세트 Nancy(Blizzard Challenge 2011)를 대상으로 수행되었습니다. MSMC-TTS 합성 효과를 평가하기 위해 주관적 의견 점수 테스트(MOS)를 구성했습니다. 실험 결과, 원본 녹음이 4.50점일 때 MSMC-TTS 점수는 4.41점, 기준 시스템 Mel-FS(Mel-Spectrogram based FastSpeech)는 3.62점인 것으로 나타났다. Mel-FS 출력 특성에 맞게 베이스라인 시스템의 보코더를 튜닝한 결과 3.69점을 얻었습니다. 이 비교 결과는 본 논문에서 제안한 방법에 의해 TTS 시스템이 크게 향상되었음을 입증한다.

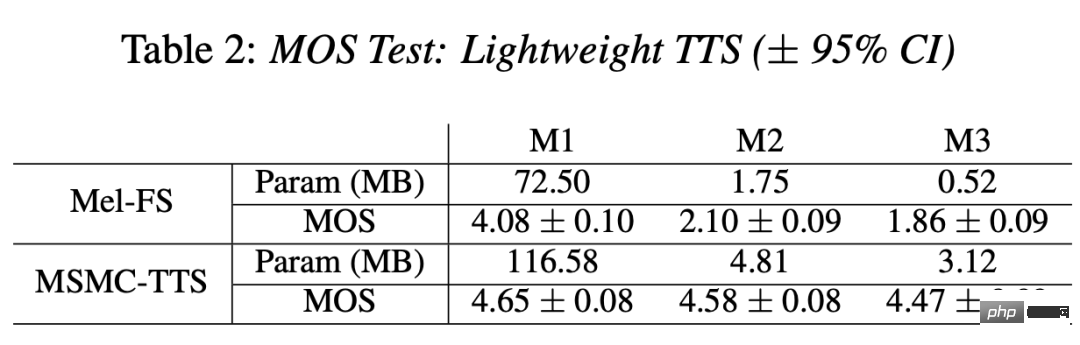

또한 모델링 복잡성이 TTS 성능에 미치는 영향에 대해 추가로 논의했습니다. 모델 매개변수의 수는 M1에서 M3으로 기하급수적으로 감소하고 Mel-FS 합성 효과는 1.86포인트로 떨어집니다. 대조적으로, MSMC-TTS의 경우 매개변수 수의 감소는 합성 품질에 큰 영향을 미치지 않았습니다. 음향 모델 매개변수 크기가 3.12MB인 경우 MOS는 여전히 4.47포인트를 유지할 수 있습니다. 이는 컴팩트한 기능을 기반으로 한 MSMC-TTS 모델링의 낮은 복잡성 요구 사항을 보여줄 뿐만 아니라 이 방법이 경량 TTS 시스템에 적용될 가능성도 보여줍니다.

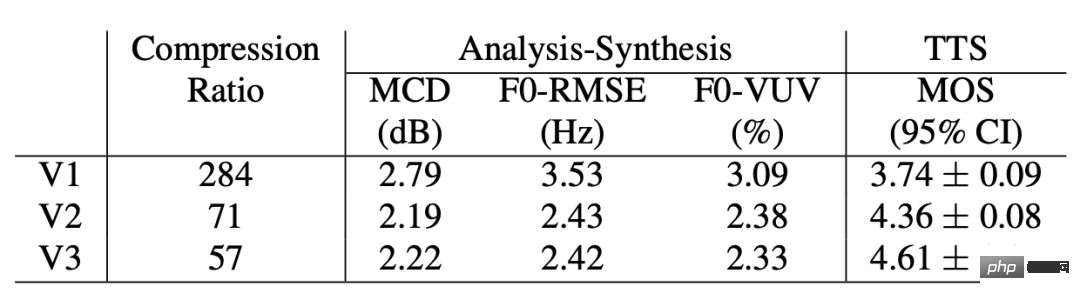

마지막으로 MHVQ 및 다단계 모델링이 TTS에 미치는 영향을 탐색하기 위해 다양한 MSMCR을 기반으로 MSMC-TTS 비교를 수행했습니다. 그 중 V1 시스템은 단일 단계 단일 코드북 표현을 사용하고, V2 시스템은 V1 기반의 4-헤드 벡터 양자화를 사용하며, V3 시스템은 V2 기반의 2단계 모델링을 사용합니다. 첫째, V1 시스템에서 사용하는 표현은 가장 높은 특징 압축률을 가지지만, 분석 합성 실험에서는 가장 낮은 완성도를 보이고, TTS 실험에서는 가장 나쁜 합성 품질을 보인다. MHVQ가 완성도를 높인 데 이어 V2 시스템 역시 TTS 효과가 대폭 향상됐다. V3에서 사용한 다단계 표현은 완성도가 더 이상 향상되지는 않았지만 TTS에서는 리듬의 자연스러움과 오디오 품질 모두 크게 향상되는 등 최고의 결과를 보여주었습니다. 이는 MSMC-TTS에서 다단계 모델링과 다중 규모 정보 보존이 매우 중요하다는 것을 보여줍니다.

5. 요약

본 연구에서는 압축 음성 표현 연구 관점에서 새로운 고성능 TTS(MSMC-TTS) 모델링 방법을 제안합니다. 이 시스템은 기존 음향 특징 대신 오디오에서 다단계 다중 코드북 표현을 추출합니다. 입력 텍스트는 다단계 예측기에 의해 서로 다른 시간 해상도를 갖는 여러 시퀀스로 구성된 음성 표현으로 변환될 수 있으며 신경 보코더에 의해 대상 음성 신호로 변환될 수 있습니다. 실험 결과에 따르면 Mel-Spectrogram을 기반으로 하는 주류 FastSpeech 시스템과 비교하여 이 시스템은 더 나은 합성 품질과 모델링 복잡성에 대한 더 낮은 요구 사항을 나타냅니다.

6. 작성자 정보

Guo Haohan: Xiaohongshu 멀티미디어 지능형 알고리즘 팀 인턴. 그는 Northwestern Polytechnical University에서 학사 학위를 취득하고 Xie Lei 교수 밑에서 ASLP 연구실에서 공부했습니다. 현재 그는 홍콩중문대학교 HCCL 연구실에서 Meng Meiling 교수 밑에서 박사과정을 밟고 있습니다. 현재까지 제1저자로 ICASSP, INTERSPEECH, SLT 국제스피치컨퍼런스에서 6편의 논문이 게재됐다.

Xie Fenglong: Xiaohongshu 멀티미디어 지능형 알고리즘 팀 음성 기술 책임자. ICASSP, INTERSPEECH, SPEECHCOM 등 음성 분야의 학회와 저널에 10편 이상의 논문을 발표했습니다. 오랫동안 ICASSP, INTERSPEECH 등 주요 연설 학회의 평론가로 활동해 왔으며, 주요 연구 방향은 음성 신호입니다. 처리 및 모델링.

위 내용은 압축된 음성 표현으로 고성능 음성 합성 시스템을 구축하는 방법의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!