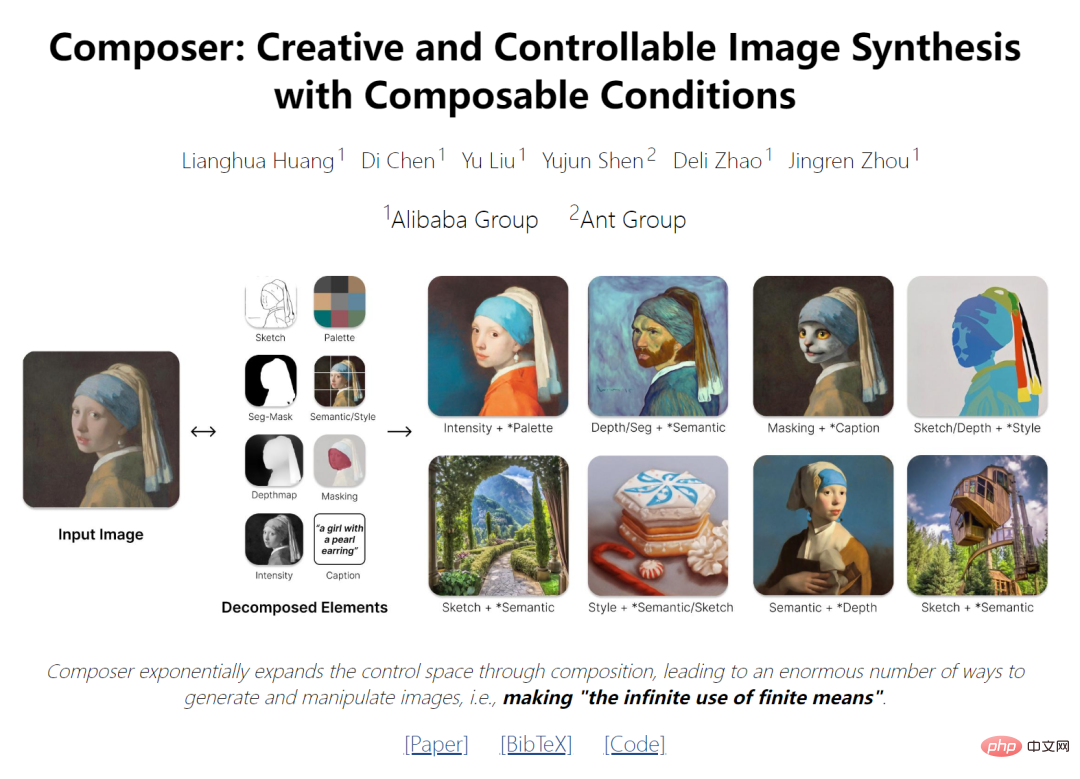

AI 페인팅을 위한 새로운 아이디어: 50억 개의 매개변수를 갖춘 국내 오픈소스 신모델, 합성 제어성 및 품질의 도약 달성

- PHPz앞으로

- 2023-04-13 10:37:021431검색

- 논문 주소: https://arxiv.org/pdf/2302.09778v2.pdf

- 프로젝트 주소: https://github.com/damo-vilab/composer

최근 빅데이터로 학습된 대규모 생성 모델은 이미지를 훌륭하게 합성할 수 있었지만 제어성에 한계가 있었습니다. 제어 가능한 이미지 생성의 핵심은 조건뿐만 아니라 더 중요한 것은 구성성에 달려 있습니다. 후자는 엄청난 수의 잠재적인 조합을 도입하여 제어 공간을 기하급수적으로 확장할 수 있습니다(예: 각각 8개의 표현이 있는 100개의 이미지, 약 100^8개의 조합 생성). 유사한 개념이 언어 및 장면 이해 분야에서 탐구되었습니다. 여기서 구성성은 제한된 알려진 구성 요소 집합에서 잠재적으로 무한한 수의 새로운 조합을 식별하거나 생성하는 기술인 조합 일반화로 알려져 있습니다.

최신 연구는 합성 품질과 모델 창의성을 유지하면서 출력 이미지(예: 공간 레이아웃 및 색상 팔레트)를 유연하게 제어할 수 있는 새로운 생성 패러다임을 제공합니다.

이 연구는 구성성을 핵심 아이디어로 삼아 먼저 이미지를 대표 요소로 분해한 다음 이러한 요소를 조건으로 한 확산 모델을 훈련하여 입력을 재구성합니다. 추론 단계에서 풍부한 중간 표현은 구성 가능한 요소 역할을 하여 사용자 정의 가능한 콘텐츠 생성을 위한 거대한 디자인 공간을 제공합니다(즉, 분해 요소 수에 기하급수적으로 비례). Composer라는 메서드는 전역 정보인 텍스트 설명, 로컬 안내인 깊이 지도 및 스케치, 하위 수준 세부 정보인 색상 히스토그램 등과 같은 다양한 수준의 조건을 지원한다는 점은 주목할 가치가 있습니다.

이 연구는 제어 가능성을 향상시키는 것 외에도 Composer가 재교육 없이도 광범위한 클래식 생성 작업을 용이하게 하는 일반적인 프레임워크 역할을 할 수 있음을 확인합니다.

Method

이 글에서 소개하는 프레임워크는 분해 단계(이미지를 독립된 구성 요소의 집합으로 나눔)와 합성 단계(조건부 확산 모델을 사용하여 구성 요소를 재결합)로 구성됩니다. 여기에서는 먼저 Composer를 사용하여 구현한 확산 모델과 안내 방향을 간략하게 소개한 다음, 이미지 분해 및 합성 구현을 자세히 설명합니다.

2.1. 확산 모델

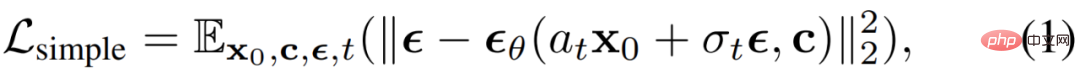

확산 모델은 반복적인 노이즈 제거 프로세스를 통해 가우스 노이즈로부터 데이터를 생성하는 생성 모델입니다. 단순 평균 제곱 오차는 일반적으로 잡음 제거 목표로 사용됩니다.

여기서 x_0은 선택적 조건 c가 있는 훈련 데이터이고,  는 가산 가우스 잡음, a_t, σ_t는 t입니다. 스칼라 함수

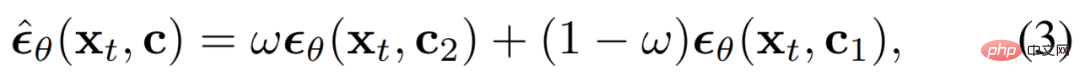

는 가산 가우스 잡음, a_t, σ_t는 t입니다. 스칼라 함수  는 학습 가능한 매개변수 θ가 있는 확산 모델입니다. 분류기가 없는 부트스트래핑은 확산 모델의 조건부 데이터 샘플링을 위한 최근 작업에서 가장 널리 사용되었으며, 여기서 예상 노이즈는 다음과 같이 조정됩니다. DDIM 및 DPM-Solver는 확산 모델의 샘플링 프로세스 속도를 높이는 데 자주 사용됩니다. DDIM을 사용하면 샘플 x_0을 순수 노이즈 잠재력 x_T로 반전하여 다양한 이미지 편집 작업을 수행할 수도 있습니다.

는 학습 가능한 매개변수 θ가 있는 확산 모델입니다. 분류기가 없는 부트스트래핑은 확산 모델의 조건부 데이터 샘플링을 위한 최근 작업에서 가장 널리 사용되었으며, 여기서 예상 노이즈는 다음과 같이 조정됩니다. DDIM 및 DPM-Solver는 확산 모델의 샘플링 프로세스 속도를 높이는 데 자주 사용됩니다. DDIM을 사용하면 샘플 x_0을 순수 노이즈 잠재력 x_T로 반전하여 다양한 이미지 편집 작업을 수행할 수도 있습니다.

안내 방향: Composer는 여러 조건을 수용할 수 있고 분류자 안내 없이 다양한 방향을 달성할 수 있는 확산 모델입니다.

c_1과 c_2는 두 가지 조건 세트입니다. c_1과 c_2의 다른 선택은 조건에 대한 다른 강조를 나타냅니다.

(c_2 c_1) 내의 조건은 Ω으로 강조되고, (c_1 c_2) 내의 조건은 (1−Ω)으로 억제되며, c1∩c2 내의 조건은 1.0의 안내 가중치를 갖습니다. 양방향 안내: 조건 c_1을 사용하여 이미지 x_0을 기본 x_T로 반전한 다음 다른 조건 c_2를 사용하여 x_T에서 샘플링함으로써 Composer를 사용하여 조작 방향이 두 방향 사이에 있는 엉킴이 없는 방식으로 이미지를 조작할 수 있습니다. c_2와 c_1은 차이점으로 정의됩니다.

Decomposition

이미지를 이미지의 다양한 측면을 포착하는 분리된 표현으로 분해하는 방법을 연구하고 이 작업에 사용되는 8가지 표현을 설명합니다. 이 표현은 훈련 과정에서 실시간으로 추출됩니다.

캡션 : 연구에서는 이미지-텍스트 교육 데이터(예: LAION-5B(Schuhmann et al., 2022))의 제목 또는 설명 정보를 이미지 캡션으로 직접 사용합니다. 주석을 사용할 수 없는 경우 사전 훈련된 이미지를 활용하여 모델을 설명할 수도 있습니다. 사전 훈련된 CLIP ViT-L /14@336px(Radford et al., 2021) 모델에서 추출된 문장 및 단어 임베딩을 사용하여 이러한 제목의 특성을 파악합니다.

의미론 및 스타일 : 사전 훈련된 CLIP ViT-L/14@336px 모델에서 추출한 이미지 임베딩을 사용하여 unCLIP과 유사하게 이미지의 의미 및 스타일을 특성화하는 연구입니다.

Color: 매끄러운 CIELab 히스토그램을 사용하여 이미지의 색상 통계를 연구합니다. 평활화 시그마 10을 사용하여 CIELab 색상 공간을 11개의 색상 값, 5개의 채도 및 5개의 조명 값으로 양자화합니다. 경험상 이 설정이 더 잘 작동합니다.

Sketch: 가장자리 감지 모델을 적용한 후 스케치 축소 알고리즘을 사용하여 이미지의 스케치를 추출하는 연구입니다. Sketch는 의미가 적은 이미지의 로컬 세부 정보를 캡처합니다.

Instances: 사전 훈련된 YOLOv5 모델을 사용하여 이미지에 인스턴스 분할을 적용하여 인스턴스 마스크를 추출하는 방법을 연구합니다. 인스턴스 분할 마스크는 시각적 개체의 범주 및 모양 정보를 반영합니다.

Depthmap: 사전 훈련된 단안 깊이 추정 모델을 사용하여 이미지의 깊이 맵을 추출하고 이미지의 레이아웃을 대략적으로 캡처하는 방법을 연구합니다.

Intensity: 이 연구에서는 원본 회색조 이미지를 표현으로 도입하여 모델이 얽혀 있지 않은 색상의 자유도를 다루는 방법을 배우도록 합니다. 임의성을 도입하기 위해 사전 정의된 RGB 채널 가중치 세트에서 균일하게 샘플링하여 회색조 이미지를 생성합니다.

Masking: Composer가 이미지 생성 또는 작업을 편집 가능한 영역으로 제한할 수 있도록 이미지 마스킹 도입을 연구합니다. 4채널 표현이 사용됩니다. 여기서 처음 3개 채널은 마스크된 RGB 이미지에 해당하고 마지막 채널은 바이너리 마스크에 해당합니다.

본 글에서는 위 8가지 조건을 사용해 실험을 진행했지만, Composer를 이용하면 사용자가 자유롭게 조건을 커스터마이징할 수 있다는 점을 참고하세요.

Composition

확산 모델을 사용하여 일련의 표현에서 이미지를 재결합하는 방법을 연구합니다. 특히, 이 연구에서는 GLIDE 아키텍처를 활용하고 튜닝 모듈을 수정합니다. 이 연구에서는 표현을 기반으로 모델을 조정하는 두 가지 메커니즘을 탐구합니다.

전역 조건화: CLIP 문장 임베딩, 이미지 임베딩, 색상 팔레트를 포함한 전역 표현의 경우 이를 투영하고 시간 단계 임베딩에 추가합니다. 또한 이미지 임베딩과 색상 팔레트를 8개의 추가 토큰에 투영하고 이를 CLIP 단어 임베딩과 연결합니다. 그런 다음 unCLIP과 유사하게 GLIDE에서 교차 주의를 위한 컨텍스트로 사용됩니다. 조건은 추가적이거나 교차 어텐션에서 선택적으로 마스킹될 수 있으므로 훈련 및 추론 중에 조건을 직접 삭제하거나 새로운 전역 조건을 도입할 수 있습니다.

지역화 조건화: 스케치, 분할 마스크, 깊이 맵, 강도 이미지 및 마스크 이미지를 포함한 지역화된 표현의 경우 쌓인 컨볼루셔널 레이어를 사용하여 x_t 차원에 포함된 노이즈 잠재력과 동일한 공간 크기를 가진 평균으로 투영합니다. . 그런 다음 이러한 임베딩의 합계가 계산되고 결과가 x_t에 연결된 다음 UNet에 공급됩니다. 임베딩은 추가적이므로 누락된 조건을 조정하거나 새로운 지역화된 조건을 통합하는 것이 쉽습니다.

공동 훈련 전략: 모델이 다양한 조건 조합에서 이미지를 디코딩하는 방법을 학습할 수 있도록 하는 공동 훈련 전략을 설계하는 것이 중요합니다. 본 연구에서는 여러 가지 구성을 실험하여 각 조건에 대해 독립적인 종료 확률 0.5, 모든 조건을 제거하는 확률 0.1, 모든 조건을 유지하는 확률 0.1을 사용하는 간단하면서도 효과적인 구성을 식별했습니다. 강도 이미지에는 이미지에 대한 대부분의 정보가 포함되어 있고 훈련 중에 다른 조건을 약화시킬 수 있으므로 특수 드롭아웃 확률 0.7이 사용됩니다.

기본 확산 모델은 64 × 64 해상도 이미지를 생성합니다. 고해상도 이미지를 생성하기 위해 연구에서는 업샘플링을 위한 두 가지 무조건 확산 모델을 훈련했습니다. 각각 이미지를 64×64에서 256×256으로, 256×256에서 1024×1024 해상도로 업샘플링했습니다. 업샘플링 모델의 아키텍처는 저해상도 레이어에서 더 많은 채널 사용을 연구하고 용량 확장을 위해 self-attention 블록을 도입하는 unCLIP에서 수정되었습니다. 자막에서 이미지 임베딩을 생성하는 선택적 이전 모델도 도입되었습니다. 경험적으로 이전 모델은 특정 조건 조합에서 생성된 이미지의 다양성을 향상시킬 수 있습니다.

Experimentation

Variation: Composer를 사용하면 주어진 이미지와 유사하지만 표현의 특정 하위 집합에 대한 조건을 통해 어떤 면에서 다소 다른 새로운 이미지를 생성할 수 있습니다. 다양한 표현의 조합을 신중하게 선택하면 이미지 변경 범위를 유연하게 제어할 수 있습니다(그림 2a). 연구에서 제시된 방법은 더 많은 조건을 통합한 후 이미지 임베딩에 대해서만 조건을 지정하는 unCLIP의 변형을 생성합니다. Composer를 사용하면 주어진 이미지와 유사한 새로운 이미지를 생성할 수 있지만 해당 이미지의 특정 하위 집합을 조건으로 하여 생성할 수 있습니다. 반영은 어떤 면에서는 다릅니다. 다양한 표현의 조합을 신중하게 선택하면 이미지 변경 범위를 유연하게 제어할 수 있습니다(그림 2a). 제안된 방법은 더 많은 조건을 통합한 후 이미지 임베딩에만 조건을 적용한 unCLIP보다 더 높은 재구성 정확도를 달성합니다. ㅋㅋㅋㅋㅋㅋㅋㅋㅋㅋㅋㅋㅋㅋㅋㅋㅋㅋㅋㅋㅋㅋㅋㅋㅋㅋㅋㅋㅋㅋ

위 내용은 AI 페인팅을 위한 새로운 아이디어: 50억 개의 매개변수를 갖춘 국내 오픈소스 신모델, 합성 제어성 및 품질의 도약 달성의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!