Jimmy Lin 얼굴의 3D 재구성은 두 대의 A100과 2D CNN을 사용하여 달성할 수 있습니다!

- 王林앞으로

- 2023-04-13 08:19:061264검색

3D 재구성 기술은 항상 컴퓨터 그래픽 및 컴퓨터 비전 분야의 핵심 연구 분야였습니다.

간단히 말하면 3D 재구성은 2D 이미지를 기반으로 3D 장면 구조를 복원하는 것입니다.

지미 린이 교통사고를 당한 후 그의 얼굴 재건 계획은 3차원 재건을 사용했다고 합니다.

3D 재구성을 위한 다양한 기술 루트가 통합될 것으로 예상됩니다

실제 3D 재구성 기술은 게임, 영화, 측량 및 매핑, 측위, 내비게이션, 자율주행, VR/AR, 산업 분야에서 널리 사용되었습니다. 제조 및 소비재에 적용 범위가 넓습니다.

GPU 및 분산 컴퓨팅의 발전과 Microsoft의 Kinect, ASUS의 XTion 및 Intel의 RealSense와 같은 심도 카메라의 하드웨어 성숙도가 높아짐에 따라 3D 재구성 비용이 감소하는 추세를 보였습니다.

작동 측면에서 3D 재구성 과정은 대략 5단계로 나눌 수 있습니다.

첫 번째 단계는 이미지 획득입니다.

3D 재구성은 카메라의 역동작이므로 3D 물체의 2D 이미지를 얻으려면 먼저 카메라를 사용해야 합니다.

조명 조건, 카메라 기하학적 특성 등이 후속 이미지 처리에 큰 영향을 미치기 때문에 이 단계는 무시할 수 없습니다.

두 번째 단계는 카메라 보정입니다.

이 단계는 카메라에 포착된 이미지를 활용하여 공간 속 사물을 복원하는 단계입니다.

일반적으로 카메라에 포착된 이미지와 3차원 공간의 물체 사이에 선형 관계가 있다고 가정합니다. 선형 관계의 매개변수를 해결하는 과정을 카메라 보정이라고 합니다.

세 번째 단계는 특징 추출입니다.

특징에는 주로 특징점, 특징선 및 영역이 포함됩니다.

대부분의 경우 특징점은 매칭 프리미티브로 사용됩니다. 특징점이 추출되는 형태는 사용되는 매칭 전략과 밀접한 관련이 있습니다.

따라서 특징점을 추출할 때는 먼저 어떤 매칭 방법을 사용할지 결정해야 합니다.

네 번째 단계는 스테레오 매칭입니다.

스테레오 매칭이란 추출된 특징을 기반으로 이미지 쌍 간의 대응 관계를 설정하는 것을 의미합니다. 즉, 서로 다른 두 이미지의 동일한 물리적 공간 지점의 이미징 지점을 일대일로 매칭하는 것입니다.

다섯 번째 단계, 3차원 재구성입니다.

카메라 보정의 내부 및 외부 매개변수와 결합하여 비교적 정확한 매칭 결과를 통해 3차원 장면 정보를 복원할 수 있습니다.

이 다섯 단계가 서로 맞물려 각 링크가 높은 정밀도와 작은 오차로 이루어져야 비교적 정확한 입체 비전 시스템을 설계할 수 있습니다.

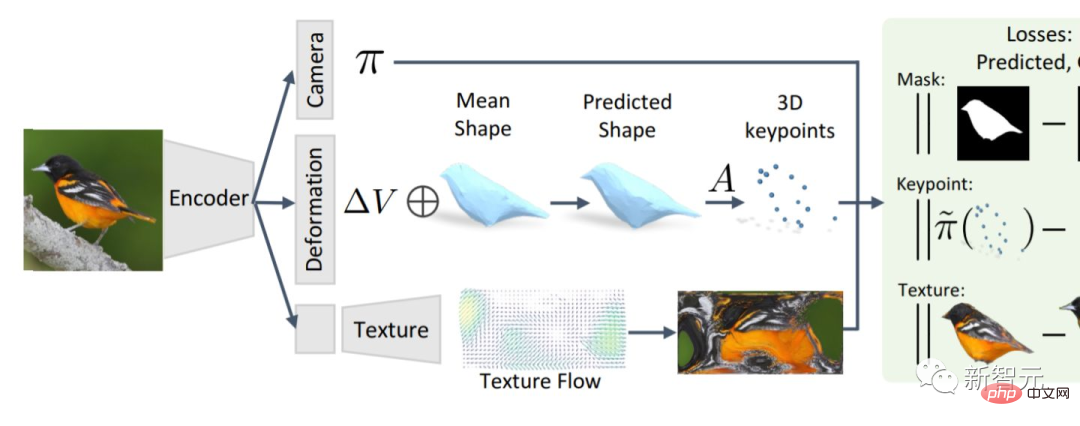

알고리즘 측면에서 3D 재구성은 크게 두 가지 범주로 나눌 수 있습니다. 하나는 전통적인 다중 뷰 기하학을 기반으로 하는 3D 재구성 알고리즘입니다.

다른 하나는 딥러닝 기반의 3차원 재구성 알고리즘입니다.

현재 이미지 특징 매칭에서 CNN의 엄청난 장점으로 인해 점점 더 많은 연구자들이 딥러닝을 기반으로 한 3차원 재구성에 관심을 돌리기 시작했습니다.

그러나 이 방법은 대부분 지도 학습 방법이며 데이터 세트에 대한 의존도가 높습니다.

데이터 세트의 수집과 라벨링은 항상 지도 학습의 문제 원인이었습니다. 따라서 딥러닝을 기반으로 한 3차원 재구성은 대부분 작은 객체를 재구성하는 방향으로 연구됩니다.

또한 딥러닝을 기반으로 한 3D 재구성은 충실도가 높고 정확도 측면에서 더 나은 성능을 제공합니다.

하지만 모델을 훈련시키는 데는 시간이 많이 걸리고 3D 재구성을 위한 3D 컨벌루션 레이어는 비용이 매우 많이 듭니다.

따라서 일부 연구자들은 전통적인 3차원 재구성 방법을 재검토하기 시작했습니다.

기존의 3차원 재구성 방식은 성능면에서는 단점이 있지만 기술은 상대적으로 성숙해졌습니다.

그러면 두 가지 방법을 어느 정도 통합하면 더 나은 결과를 얻을 수 있습니다.

3D 컨볼루셔널 레이어 없이도 3D 재구성이 가능합니다

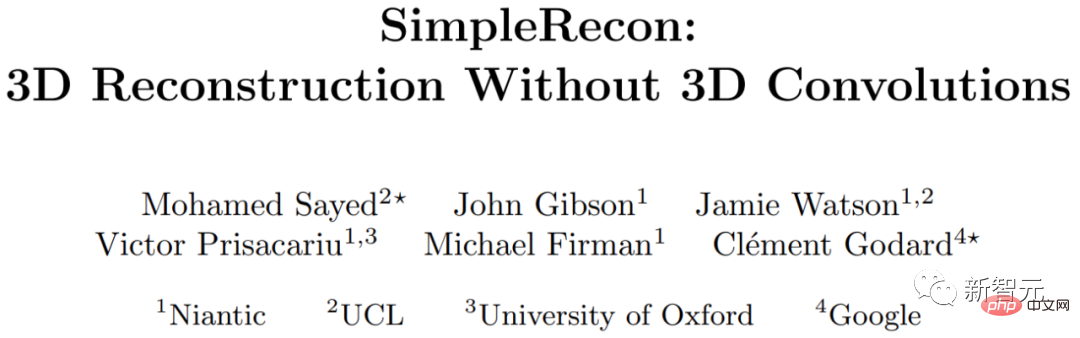

런던대학교, 옥스퍼드대학교, 구글, Niantic(구글에서 분사해 AR을 연구하는 유니콘 기업) 등 연구기관 연구진이 탐색 3차원 컨볼루션이 없는 3차원 재구성 방법.

그들은 간단한 최첨단 다중 시점 깊이 추정기를 제안합니다.

이 다중 뷰 깊이 추정기에는 두 가지 획기적인 기능이 있습니다.

첫째, 잘 설계된 2D CNN은 강력한 이미지 사전 정보를 활용하고 평면 스캔 기능 수량 및 기하학적 손실을 얻을 수 있습니다.

두 번째, 키 프레임과 기하학적 메타데이터를 비용 볼륨에 통합하여 정보를 얻을 수 있습니다. 깊이 평면 점수.

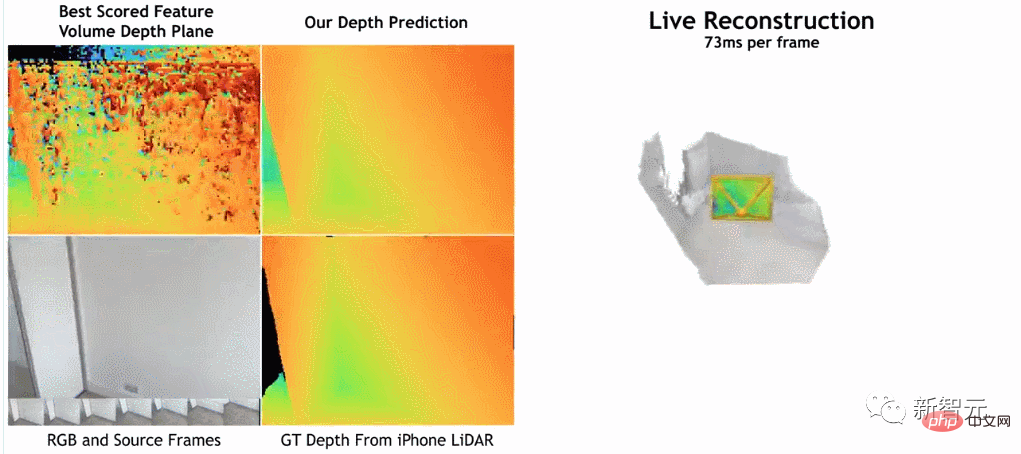

연구자들에 따르면, 그들의 방법은 심층 추정에서 현재의 최첨단 방법보다 분명히 앞서 있습니다.

ScanNet 및 7-Scenes의 3D 재구성에 가깝거나 더 좋지만 여전히 온라인 실시간 저메모리 재구성이 가능합니다.

더욱이 재구성 속도는 프레임당 약 73ms에 불과할 정도로 매우 빠릅니다.

연구원들은 이것이 빠른 심층 융합을 통해 정확한 재구성이 가능하다고 믿습니다.

연구자들에 따르면, 그들의 방법은 이미지 인코더를 사용하여 참조 이미지와 원본 이미지에서 일치하는 특징을 추출한 후 이를 비용 볼륨에 입력한 후 2D 컨볼루셔널을 사용하는 것입니다. 인코더/디코더 네트워크 비용량의 출력 결과를 처리합니다.

이 연구는 PyTorch를 사용하여 구현되었으며, 매칭 기능 추출에는 ResNet18도 사용되었으며 전체 작업을 완료하는 데 36시간이 걸렸습니다.

또한 모델은 3D 컨볼루션 레이어를 사용하지 않지만 깊이 예측 지표에서 기본 모델보다 성능이 뛰어납니다.

이는 잘 설계되고 훈련된 2D 네트워크가 고품질 깊이 추정에 충분하다는 것을 보여줍니다.

관심 있는 독자는 논문의 원문을 읽어보세요:

https://nianticlabs.github.io/simplerecon/resources/SimpleRecon.pdf

그러나 이 문서를 읽는 데에는 전문적인 기준이 있으며 일부 세부 사항은 쉽게 알아차리지 못할 수도 있다는 점을 상기시켜 드립니다.

해외 네티즌들이 이 논문에서 발견한 내용을 살펴보는 것도 좋을 것 같습니다.

'stickshiftplease'라는 네티즌은 "A100의 추론 시간은 70밀리초 정도지만 다양한 기법을 통해 이를 단축할 수 있고, 메모리 요구 사항이 꼭 40GB일 필요는 없지만 가장 작은 모델은 2.6GB를 쓴다"고 말했다. 메모리".

"IrreverentHippie"라는 또 다른 네티즌은 "이 연구는 여전히 LiDAR 깊이 센서 샘플링을 기반으로 하고 있다는 점에 유의하세요. 이것이 바로 이 방법이 이렇게 좋은 품질과 정확도를 달성하는 이유입니다."라고 지적했습니다.

"nickthorpie"라는 네티즌의 비교적 긴 댓글도 있습니다. "ToF 카메라의 장점과 단점은 잘 문서화되어 있습니다. ToF는 Raw 이미지 처리를 괴롭히는 다양한 문제를 해결합니다. 그 중 두 가지 주요 문제는 다음과 같습니다. 확장성 및 세부 사항. 테이블 가장자리나 얇은 기둥과 같은 작은 세부 사항은 항상 ToF로 감지하기 어렵습니다. 이는 자율 또는 반자율 애플리케이션에 중요합니다.

또한 ToF는 활성 센서이므로 여러 센서가 있는 경우 혼잡한 교차로나 자체 제작 창고 등에서 함께 사용하면 화질이 빨리 저하됩니다.

분명히 한 장면에서 데이터를 많이 수집할수록 더 정확한 설명을 선호하는 연구자가 많습니다. 더 유연하기 때문에 원시 이미지 데이터를 연구하는 것입니다."

위 내용은 Jimmy Lin 얼굴의 3D 재구성은 두 대의 A100과 2D CNN을 사용하여 달성할 수 있습니다!의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!