단계별로 생각하지 마세요! 구글의 최신 자연어 추론 알고리즘 LAMBADA: '역연쇄추론'이 답이다

- 王林앞으로

- 2023-04-12 21:16:201734검색

자연어 처리 분야에서 자동 추론은 확실히 큰 문제입니다. 모델은 주어진 전제와 지식을 바탕으로 효과적이고 정확한 결론을 도출해야 합니다.

NLP 분야는 최근 대규모 사전 훈련된 언어 모델을 통해 독해, 질문 답변 등 다양한 "자연어 이해" 작업에서 매우 높은 성능을 달성했지만, 논리적 추론에서는 이러한 모델의 성능이 아직은 많이 늦어요.

CoT(Chain of Thought)는 작년 5월에 나왔습니다. 일부 연구자들은 프롬프트에 "단계적으로 생각해보자"를 추가하는 것만으로도 GPT-3의 추론 성능을 크게 향상시킬 수 있다는 사실을 발견했습니다. MultiArith, 추론 정확도가 기존 17.7%에서 78.7%로 증가했습니다

그러나 CoT 및 Selection Inference와 같은 방법은 모두 순방향 공리에서 검색하여 최종 결론(결론)을 도출하는 증명 프로세스(증명)를 갖습니다. 검색 공간의 조합 폭발 문제가 발생하므로 추론 체인이 길수록 실패율이 더 높아집니다.

최근 Google Research는 고전 추론 문헌에서 파생된 "역방향 추론 효율성이 순방향 추론보다 훨씬 높다"는 결론을 언어 모델에 적용한 역방향 연결 알고리즘 LAMBADA(LAnguage Model Augmented BAckwarD Chaining)를 개발했습니다. (LM).

논문 링크: https://arxiv.org/abs/2212.13894

LAMBADA는 추론 프로세스를 4개의 하위 모듈로 분해하며, 각 모듈은 몇 번의 프롬프트 언어 모델 추론으로 구현됩니다.

결국, LAMBADA는 현재의 sota의 순방향 추론 방법과 비교하여 두 가지 논리적 추론 데이터 세트에서 상당한 성능 향상을 달성했습니다. 특히 문제에 깊고 정확한 증명 체인이 필요한 경우 LAMBADA의 성능 향상은 더욱 분명합니다. .

"역추론"이 답이 된다?

논리적 추론, 특히 구조화되지 않은 자연 텍스트에 대한 논리적 추론은 자동 지식 발견을 위한 기본 구성 요소이자 다양한 과학 분야의 향후 발전을 위한 열쇠입니다.

많은 NLP 작업의 개발이 사전 훈련된 언어 모델의 규모 증가로 인해 이익을 얻었음에도 불구하고 모델의 크기를 늘리면 복잡한 추론 문제를 해결하는 데 있어 개선이 매우 제한되는 것으로 관찰되었습니다.

고전 문학에는 크게 두 가지 논리적 추론 방법이 있습니다.

1. 순방향 연결(FC), 즉 사실과 규칙에서 시작하여 새로운 추론을 하고, 이론 사이에 이를 추가하여 목표까지 반복합니다.

2. 역방향 연결(BC), 즉 목표에서 시작하여 하위 목표가 사실을 기반으로 입증되거나 반증될 수 있을 때까지 하위 목표로 재귀적으로 분해합니다.

언어 모델을 사용한 이전 추론 방법은 전체 집합에서 사실과 규칙의 하위 집합을 선택해야 하는 순방향 연쇄 추론 아이디어를 대부분 채택했습니다. 이는 조합 검색이 필요하기 때문에 LM에게는 어려울 수 있습니다. 넓은 공간.

또한 검색을 중지하고 증명 실패를 선언할 시점을 결정하는 것도 FC에서는 매우 어려우며 때로는 중간 라벨에 대해 특별히 훈련된 모듈이 필요한 경우도 있습니다.

실제로 고전적인 자동 추론 문헌은 주로 역방향 연쇄 추론이나 목표 지향 검증 전략에 중점을 둡니다.

LAMBADA

LAMBADA는 "역연쇄 기술로 강화된 언어 모델"을 의미합니다. 연구원들은 BC가 텍스트 기반 연역적 논리 추론에 더 적합하다는 것을 실험적으로 입증했습니다.

BC에서는 하위 집합을 선택하기 위해 많은 수의 조합 검색이 필요하지 않으며 보다 자연스러운 중지 기준이 있습니다.

LAMBADA는 주로 사실에 대한 자동 추론, 즉 "좋은 사람은 빨간색이다"와 같은 자연어 주장에 중점을 둡니다. 이러한 주장은 일관성이 있지만 반드시 실제 상황에 기반한 것은 아닙니다.

규칙은 자연어 문장으로 작성되며 "if P then Q" 형식으로 다시 작성할 수 있습니다. 예를 들어 "거칠고 좋은 사람은 빨간색입니다"는 "사람이 거칠면"으로 다시 작성할 수 있습니다. "사람이 거칠고 착하면 빨간색이다.

여기서 P를 규칙의 전건이라고 하고 Q를 규칙의 후건이라고 합니다.

이론 이론 C는 사실 F={f1, f2, . , fn}과 규칙 R={r1, r2, . , rm}으로 구성됩니다. 사실과 규칙 목표.

예시 1, 허구의 인물과 규칙을 적용한 이론적인 예 C

F={"피오나는 좋은 사람이다", "피오나는 거친 사람이다"}

R={"만약 누군가가 만약 사람이라면 똑똑하면 좋은 사람이다", "거친 좋은 사람은 빨간색이다", "좋은 사람이고 빨간색은 둥글다는 뜻이다"}.

위의 이론을 바탕으로 "피오나가 빨개요?"와 같은 목표를 증명하거나 반증하고 싶을 수도 있습니다.

역방향 연결 추론

규칙이 목표에 적용되는지 여부는 논리의 통일이라는 연산을 통해 결정됩니다.

예를 들어 예시 1의 "Fiona is red?"라는 목표의 경우 두 번째 규칙은 목표와 동일한 결과를 가지므로 적용할 수 있지만 다른 두 규칙은 다른 결과를 가지므로 적용되지 않습니다. 신청하지 마세요.

예제 1의 이론과 목표를 고려하여 BC는 "피오나는 빨간색인가?"라는 목표에서 추론을 시작합니다.

먼저 BC는 목표가 어떤 사실로도 입증될 수 있는지, 반증될 수 있는지 검증합니다. 이 목표를 입증하거나 반증할 사실이 없기 때문에 다음으로 이 목표가 어떤 규칙의 결과와 일치하는지 확인하여 두 번째 규칙인 "거칠고 좋은 사람은 빨간색"과 일치하는 것으로 확인됩니다.

이 목표는 두 가지 하위 목표로 나눌 수 있습니다. 1) Fiona는 거친가요? 2) 피오나는 좋은 사람인가요? .

두 하위 목표 모두 사실로 증명할 수 있으므로 BC는 원래의 목표도 증명할 수 있다고 결론 내립니다.

목표의 경우 BC의 결과는 증명, 부정 또는 알 수 없음입니다(예: 목표 "피오나는 똑똑해요?").

LAMBADA의 언어 모델

텍스트 기반 추론에 BC를 사용하기 위해 연구원들은 4가지 LM 기반 모듈(사실 확인, 규칙 선택, 목표 분해) 및 서명 동의를 도입했습니다.

사실 확인

이론에서 일련의 사실 F와 목표 G가 주어지면 사실 확인 모듈은 f에 G가 포함되는 사실 f∈F가 있는지 확인합니다( 여기서 이 경우 골이 증명됨) 또는 f에 G의 부정이 포함됩니다(이 경우 골이 거부됨).

그런 사실을 찾을 수 없다면 G의 진실은 아직 알려지지 않았습니다.

사실 확인 구현에는 두 개의 하위 모듈이 포함됩니다. 첫 번째 하위 모듈은 목표와 가장 관련성이 높은 사실 집합에서 사실을 선택하고, 두 번째 하위 모듈은 목표를 기반으로 입증 또는 반증할 수 있는지 여부를 확인합니다. 이 사실에 대해.

사실 선택 하위 모듈은 첫 번째 시도에서 가장 좋은 사실을 결정하지 못할 수 있으므로 하위 모듈을 한 번 호출한 후에도 대상의 진실을 여전히 알 수 없는 경우 선택한 사실을 삭제하고 하위 -모듈이 다시 호출됩니다. 이 프로세스는 여러 번 반복될 수 있습니다.

규칙 선택

이론에서 일련의 규칙 R과 목표 G가 주어지면 규칙 선택 모듈은 r의 결과가 G와 일치하도록 규칙 r∈R을 결정한 후 다음을 사용합니다. 목표를 설정하는 규칙을 하위 목표로 세분화합니다.

이러한 규칙을 결정할 수 없다면 G의 진실은 알 수 없습니다.

규칙 선택에는 두 개의 하위 모듈도 포함되어 있습니다. 첫 번째 하위 모듈은 각 규칙의 결과(목표와 무관)를 결정하고, 두 번째 하위 모듈은 규칙의 결과와 목표를 입력으로 받아 어떤 규칙을 결정하는지 결정합니다. 하나는 목표와 일치합니다.

BC의 재귀적 특성으로 인해 목표를 증명하는 과정에서 규칙 선택 모듈이 여러 번 호출될 수 있다는 점에 유의해야 합니다. 각 규칙을 식별한 결과는 대상과 독립적이므로 이 하위 모듈은 한 번만 호출하면 됩니다.

골 분해

r의 결과가 G와 통합되는 규칙 r과 골 G가 주어지면 골 분해 모듈은 G가 증명되도록 증명해야 하는 하위 목표를 결정합니다. 또는 반증되었습니다.

r의 전건을 성공적으로 증명한 경우, 목표의 증명 여부는 목표의 부호가 r의 결과의 부호와 일치하는지 여부에 따라 달라집니다.

예를 들어 "Fiona is red?"라는 골의 경우 골의 부호가 두 번째 규칙의 결과 부호와 일치하고 규칙의 선행이 증명되므로 골이 증명되었습니다.

Symbolic Consistency

규칙 r과 목표 G가 주어지면 기호 일관성 모듈은 r의 결과 기호가 목표 기호와 일치하는지 또는 불일치하는지 확인합니다.

실험 부분

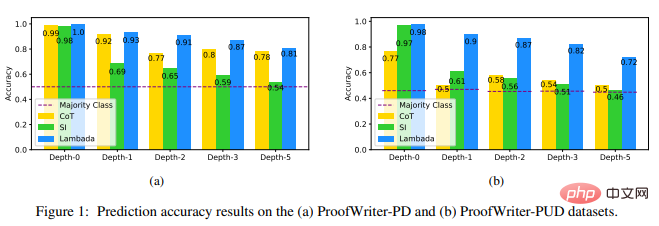

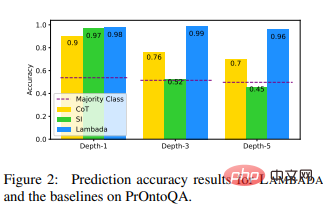

연구진은 비교를 위한 기준 모델로 명시적 추론 기반의 소타 신경 추론 방법인 CoT(Chain of Thought)와 소타 모듈 추론 방법인 SI(Selection Inference)를 선택했습니다.

실험 데이터 세트는 ProofWriter 및 PrOntoQA를 사용합니다. 이러한 데이터 세트는 LM 추론에 까다로우며 최대 5홉의 체인 길이를 증명해야 하는 예와 대상을 증명하거나 반박할 수 없는 예를 포함합니다. 제공된 이론.

실험 결과에 따르면 LAMBADA는 특히 UNKNOWN 레이블이 포함된 ProofWriter-PUD 데이터 세트에서 다른 두 기준보다 훨씬 뛰어난 성능을 보였습니다(심도-5% 개선에서 CoT에 비해 44%, SI에 비해 56% 개선). PrOntoQA(CoT에 비해 37% 상대적 개선, 깊이 -5에서 SI에 비해 113% 상대적 개선).

이러한 결과는 논리적 추론에서 LAMBADA의 장점을 보여주며, SI의 중추인 순방향 연결에 비해 LAMBADA 추론의 중추인 역방향 연결이 가능함을 보여줍니다. 더 나은 선택.

이러한 결과는 UNKNOWN 라벨을 처리할 때 CoT 방법의 결함도 드러냅니다. PROVED 또는 DISPROVED 라벨이 붙은 예시와는 달리 UNKNOWN 라벨이 붙은 예시에는 자연스러운 사고 연쇄가 없습니다.

심층(3+) 증명 체인 문제의 경우 SI는 세 가지 데이터 세트에 대해 다수 클래스 예측에 가까운 예측을 생성합니다.

이진 사례에서는 DISPROVED를 과대 예측하는 경향이 있고, 삼항 분류 사례에서는 UNKNOWN을 과대 예측하는 경향이 있으며 이는 PrOntoQA Bad의 깊이 5에서 다수 클래스보다 훨씬 더 나은 성능을 발휘한다는 것을 알 수 있습니다. 해당 깊이에는 DISPROVED 태그보다 PROVED 태그가 더 많습니다.

그러나 ProofWriterPD 데이터 세트에 대한 CoT의 성능은 여전히 상대적으로 높았으며 정확도도 떨어지지 않았다는 사실에 연구원들도 놀랐습니다.

요약하자면, 이러한 데이터세트에서 LAMBADA는 잘못된 증명 추적으로 올바른 결론을 찾는 다른 기술에 비해 더 높은 추론 정확도를 가지고 있으며, LM을 기반으로 한 모듈식 추론 방법보다 유효한 추론 체인을 생성할 가능성이 더 높습니다. 쿼리에 더 효율적입니다.

이 실험의 결과는 LM을 이용한 추론에 대한 향후 작업에 역방향 연결 또는 목표 지향 전략이 포함되어야 함을 강력히 시사한다고 연구원들은 말했습니다.

참고자료:

https://arxiv.org/abs/2212.13894

위 내용은 단계별로 생각하지 마세요! 구글의 최신 자연어 추론 알고리즘 LAMBADA: '역연쇄추론'이 답이다의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!