Meta, MoDem 세계 모델 출시: LeCun이 제시한 시각적 분야의 세 가지 주요 과제 해결

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB앞으로

- 2023-04-12 20:22:011597검색

12월 27일 MetaAI의 A

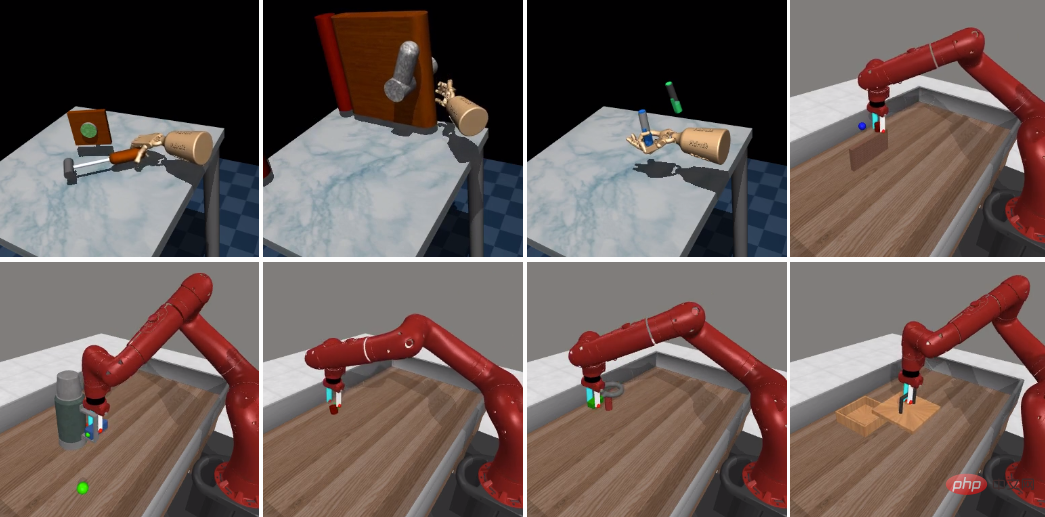

이 트윗의 조회수는 27일 저녁 현재 73.9만명에 이르렀습니다.

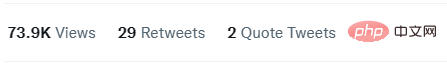

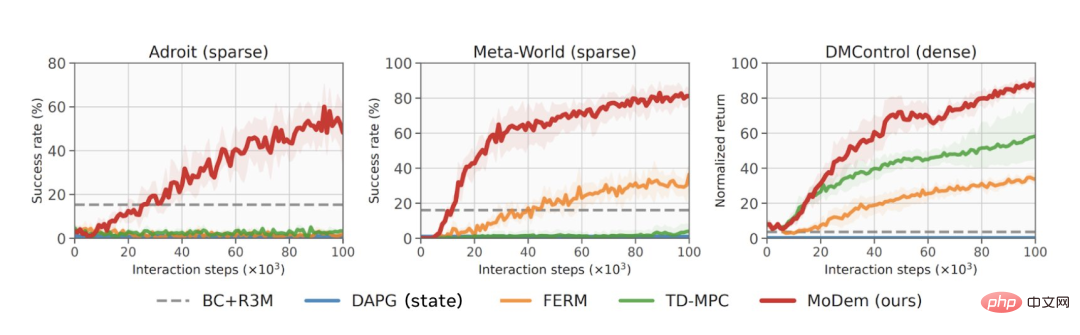

그는 단지 5번의 시연을 통해 MoDem이 100K 상호 작용 단계에서 희박한 보상과 고차원 작업 공간을 통해 까다로운 시각적 동작 제어 작업을 해결할 수 있었으며 기존 수준보다 훨씬 뛰어난 성능을 발휘했다고 말했습니다. 예술 방법.

얼마나 좋은가요?

MoDem의 희소 보상 작업 완료 성공률은 데이터가 적은 체제의 이전 방법보다 150%-250% 더 높았습니다.

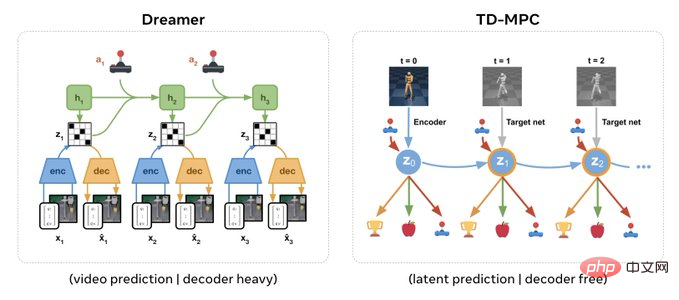

Lecun도 이 연구를 전달하면서 MoDem의 모델 아키텍처는 JEPA와 유사하며 디코더 없이도 표현 공간에서 예측을 할 수 있다고 말했습니다.

편집자가 아래에 링크를 걸어두었으니 관심있는 친구들은 구경해보세요~

논문 링크: https://arxiv.org/abs/2212.05698

Github 링크: https://github.com/facebookresearch/modem

연구 혁신 및 모델 아키텍처

비효율적인 샘플은 실제 응용 프로그램, 특히 비전 스포츠 제어에 심층 강화 학습(RL) 알고리즘을 배포하는 데 있어 주요 과제입니다.

모델 기반 RL은 세계 모델을 학습하는 동시에 계획 및 정책 개선을 위해 합성 배포를 사용하여 높은 샘플 효율성을 달성할 수 있는 잠재력을 가지고 있습니다.

그러나 실제로 모델 기반 RL의 효율적인 샘플 학습은 탐색 문제로 인해 병목 현상이 발생합니다. 이 연구는 이러한 주요 문제를 정확하게 해결합니다.

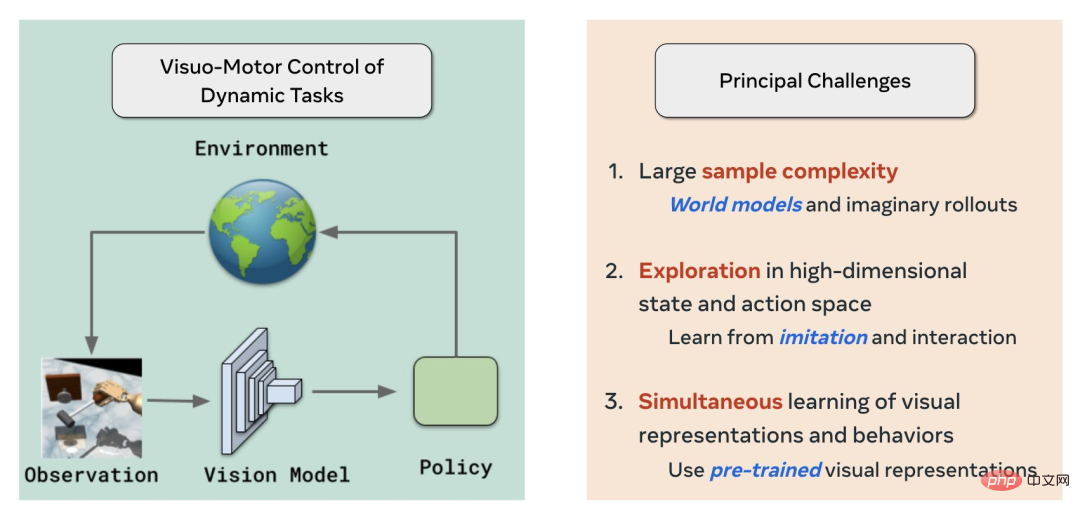

우선, MoDem은 월드 모델, 모방 + RL 및 자기 지도 시각적 사전 훈련을 각각 사용하여 시각적 강화 학습/제어 분야의 세 가지 주요 문제를 해결합니다.

- 대형 샘플 복잡성 )

- 고차원 상태 및 행동 공간 탐색

- 시각적 표현과 행동 동시 학습

이번에 모델 아키텍처는 Yann LeCun의 JEPA와 유사하며 디코더가 필요하지 않습니다.

저자인 Aravind Rajeswaran은 픽셀 수준 예측을 위해 디코더가 필요하고 아키텍처가 무거운 Dreamer에 비해 디코더 없는 아키텍처는 SSL을 사용하여 사전 훈련된 시각적 표현의 직접 삽입을 지원할 수 있다고 말했습니다.

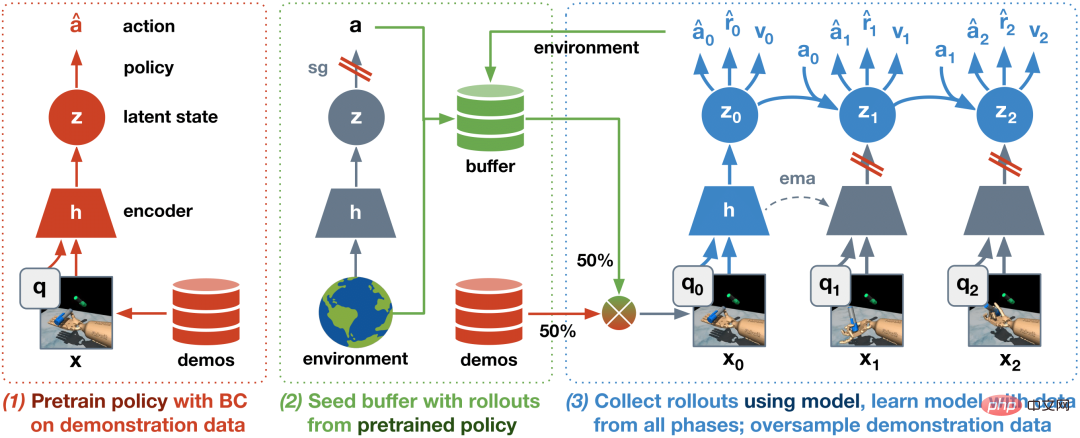

또한 IL+RL을 기반으로 3단계 알고리즘을 제안했습니다.

- BC 사전 훈련 전략

- 시연 및 탐색이 포함된 시드 데이터세트를 사용하여 세계 모델을 사전 훈련합니다. 이 단계는 전반적인 안정성과 효율성에 중요합니다.

- 온라인 상호 작용을 통해 세계 모델을 미세 조정합니다.

결과는 생성된 알고리즘이 Adroit dexterous Operation, MetaWorld 및 DeepMind 제어 제품군을 포함한 21개의 하드 시각적 모션 제어 작업에서 SOTA 결과(최첨단 결과)를 달성했음을 보여줍니다.

데이터 관점에서 볼 때 MoDem은 다양한 작업에서 다른 모델보다 훨씬 더 나은 성능을 발휘하며 결과는 이전 SOTA 방법보다 150%~250% 더 높습니다.

빨간색 선은 다양한 작업에서 MoDem의 성능을 나타냅니다.

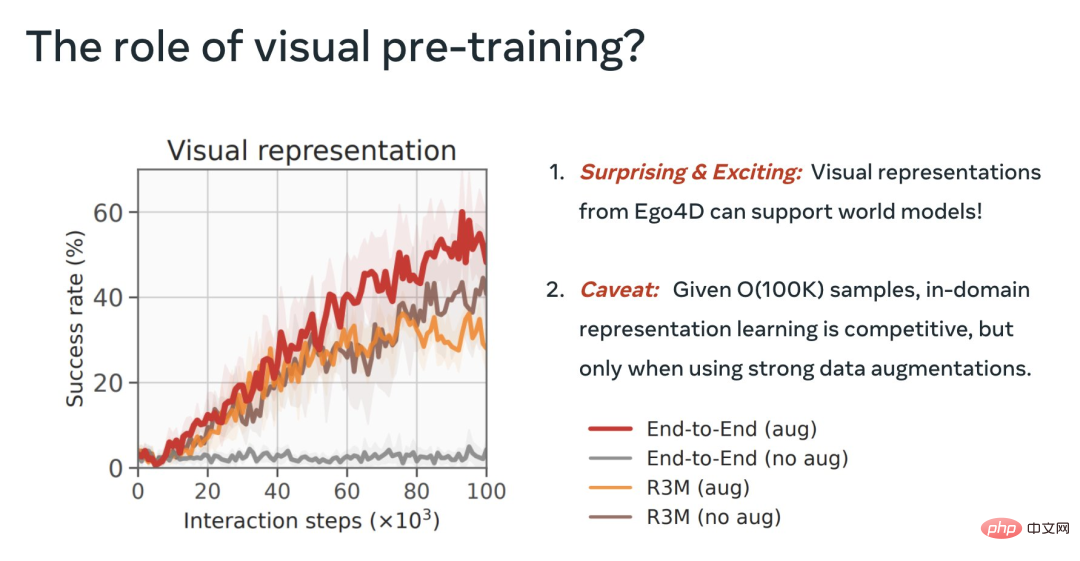

이 과정에서 그들은 또한 MoDem의 다양한 단계의 중요성, 시각적 MBRL에 대한 데이터 확대의 중요성 및 사전 훈련된 시각적 표현의 유용성

마지막으로, 고정된 R3M 기능을 사용하는 것이 직접적인 E2E 접근 방식보다 훨씬 우수합니다. 이는 매우 흥미롭고 비디오의 시각적 사전 훈련이 세계 모델을 지원할 수 있음을 보여줍니다.

하지만 8월에 강력한 데이터를 보유한 E2E는 동결된 R3M과 경쟁하므로 사전 훈련을 통해 더 잘할 수 있습니다.

위 내용은 Meta, MoDem 세계 모델 출시: LeCun이 제시한 시각적 분야의 세 가지 주요 과제 해결의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!