Yann LeCun이 Google 연구에 대해 이야기합니다. 타겟 커뮤니케이션은 오랫동안 존재해 왔는데, 귀하의 혁신은 어디에 있습니까?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB앞으로

- 2023-04-12 18:52:131482검색

며칠 전, 학술 Turing Award 수상자 Yann LeCun이 Google 연구에 의문을 제기했습니다.

얼마 전 Google AI는 새로운 연구 "LocoProp: Enhancing BackProp via Local Loss Optimization"에서 다층 신경망을 위한 일반적인 계층적 손실 구성 프레임워크 LocoProp을 제안했습니다. 이 프레임워크는 성능을 달성하면서 1차 최적화 프로그램만 사용합니다. 2차 방법에 가깝습니다.

더 구체적으로, 프레임워크는 신경망을 다중 레이어의 모듈식 구성으로 재구성합니다. 여기서 각 레이어는 자체 가중치 정규화기, 목표 출력 및 손실 함수를 사용하여 궁극적으로 성능과 효율성을 모두 달성합니다.

Google은 벤치마크 모델 및 데이터 세트에서 해당 방법의 효율성을 실험적으로 검증하여 1차 최적화 도구와 2차 최적화 도구 간의 격차를 줄였습니다. 또한, 구글 연구진은 지역 손실 구성 방법이 지역 손실로 제곱 손실을 사용한 최초의 방법이라고 밝혔습니다.

이미지 출처: @Google AI

Google의 이번 연구에 대해 어떤 사람들은 그것이 멋지고 흥미롭다고 말했습니다. 그러나 Turing Award 수상자 Yann LeCun을 포함하여 일부 사람들은 다른 견해를 표명했습니다.

그는 현재 우리가 타겟 소품이라고 부르는 것에는 여러 가지 버전이 있으며 그 중 일부는 1986년으로 거슬러 올라간다고 믿습니다. 그렇다면 Google의 LocoProp과 이들의 차이점은 무엇입니까?

사진 출처 : @Yann LeCun

UIUC 조교수를 앞둔 왕하오한 씨도 르쿤의 질문에 동의했습니다. 그는 일부 작가들이 왜 그렇게 단순한 아이디어가 최초라고 생각했는지 가끔 놀랍다고 말했습니다. 뭔가 다른 일을 했을지도 모르지만, 홍보팀은 빨리 나와서 모든 것을 주장하고 싶었습니다...

사진 출처: @HaohanWang

그러나 일부 사람들은 LeCun에게 "차갑지 않다"고 생각했습니다. 경쟁을 고려하지 않고 의문을 제기하고 심지어 "전쟁을 유발"하기도 합니다. LeCun은 자신의 질문이 경쟁과 아무 관련이 없다고 주장하며 Marc'Aurelio Ranzato, Karol Gregor, Koray kavukcuoglu 등과 같은 이전 실험실 구성원의 예를 들었습니다. 그들은 모두 일부 버전의 표적 전파를 사용했습니다. , 이제 그들은 모두 Google DeepMind에서 작동합니다.

사진출처 : @Gabriel Jimenez @Yann LeCun

어떤 분들은 얀 르쿤을 놀리기도 했습니다. "위르겐 슈미트후버를 이길 수 없으면 그냥 그 사람이 되세요."

얀 르쿤 맞나요? 먼저 이번 구글 연구가 어떤 내용인지 살펴보겠습니다. 눈에 띄는 혁신이 있나요?

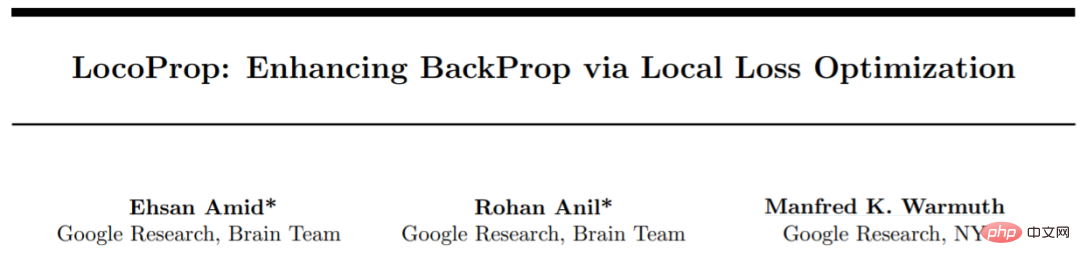

Google LocoProp: 로컬 손실 최적화를 통한 향상된 역전파

이 연구는 Google의 세 연구원인 Ehsan Amid, Rohan Anil 및 Manfred K. Warmuth에 의해 완료되었습니다.

논문 주소: https://proceedings.mlr.press/v151/amid22a/amid22a.pdf

이 기사에서는 심층 신경망(DNN)의 성공을 위한 두 가지 핵심 요소가 있다고 믿습니다. 바로 모델 설계와 그러나 모델 매개변수 업데이트를 위한 최적화 방법을 논의하는 연구자는 거의 없습니다. DNN 교육에는 실제 값과 모델 예측 값 간의 차이를 예측하는 데 사용되는 손실 함수를 최소화하고 역전파를 사용하여 매개변수를 업데이트하는 작업이 포함됩니다.

가장 간단한 가중치 업데이트 방법은 확률적 경사 하강법입니다. 즉, 각 단계에서 가중치는 경사에 대해 음의 방향으로 이동합니다. 또한 Momentum Optimizer, AdaGrad 등과 같은 고급 최적화 방법이 있습니다. 이러한 최적화 프로그램은 일반적으로 업데이트 방향을 수정하기 위해 1차 파생 항목의 정보만 사용하기 때문에 1차 방법이라고도 합니다.

수렴을 개선하고 반복 횟수를 줄이는 것으로 입증된 샴푸, K-FAC 등과 같은 고급 최적화 방법도 있습니다. 이러한 방법은 그라데이션의 변화를 포착할 수 있습니다. 이 추가 정보를 사용하여 고차 최적화 프로그램은 다양한 매개변수 그룹 간의 상관 관계를 고려하여 훈련된 모델에 대한 보다 효율적인 업데이트 방향을 찾을 수 있습니다. 단점은 고차 업데이트 방향을 계산하는 것이 1차 업데이트보다 계산 비용이 더 많이 든다는 것입니다.

Google은 논문에서 DNN 모델 훈련을 위한 프레임워크인 LocoProp을 소개했습니다. LocoProp은 신경망을 레이어의 모듈식 조합으로 간주합니다. 일반적으로 신경망의 각 계층은 입력에 대해 선형 변환을 수행한 후 비선형 활성화 함수를 수행합니다. 본 연구에서는 네트워크의 각 계층에 자체 가중치 정규화기, 출력 목표 및 손실 함수가 할당되었습니다. 각 레이어의 손실 함수는 해당 레이어의 활성화 함수와 일치하도록 설계되었습니다. 이 형식을 사용하면 주어진 작은 배치의 로컬 손실을 훈련하여 레이어 간을 병렬로 반복하여 최소화할 수 있습니다.

Google은 매개변수 업데이트에 이 1차 최적화 프로그램을 사용하므로 고차 최적화 프로그램에 필요한 계산 비용을 피할 수 있습니다.

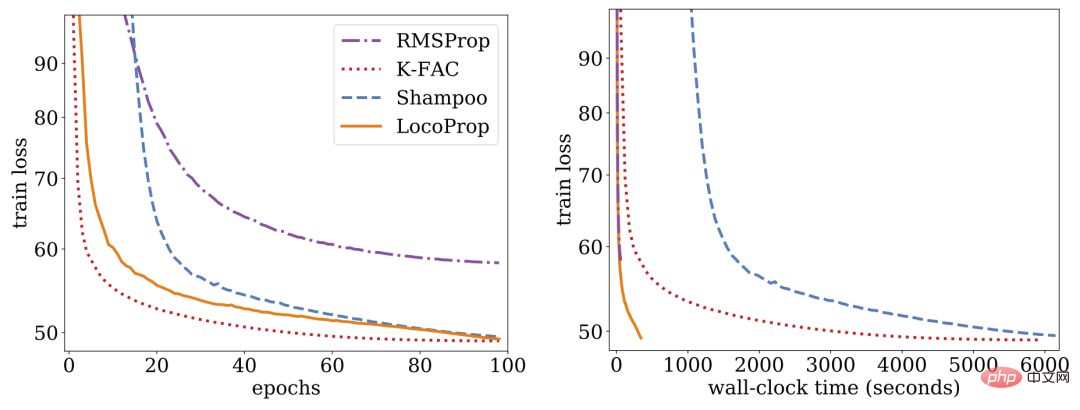

연구에 따르면 LocoProp은 딥 오토인코더 벤치마크에서 1차 방법보다 성능이 뛰어나고 높은 메모리 및 계산 요구 사항 없이 샴푸 및 K-FAC와 같은 고차 최적화 프로그램과 비슷한 성능을 발휘하는 것으로 나타났습니다.

LocoProp: 국소 손실 최적화를 통한 향상된 역전파

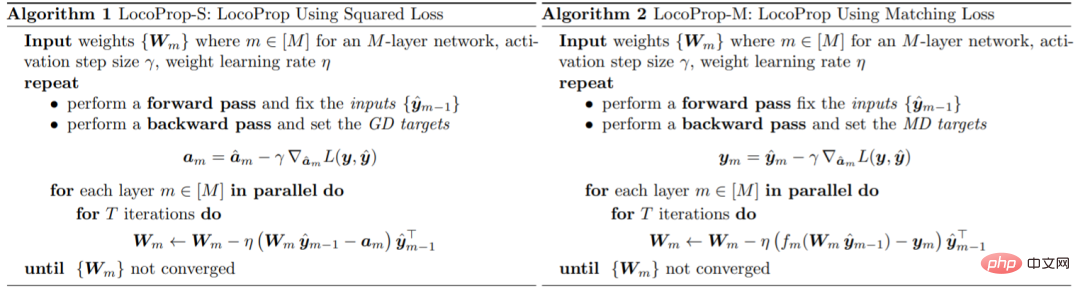

일반적으로 신경망은 각 레이어의 입력을 출력 표현으로 변환하는 복합 함수로 간주됩니다. LocoProp은 네트워크를 레이어로 분해할 때 이러한 관점을 채택합니다. 특히, LocoProp은 출력의 손실 함수를 최소화하기 위해 레이어의 가중치를 업데이트하는 대신 각 레이어에 특정한 사전 정의된 로컬 손실 함수를 적용합니다. 주어진 레이어에 대해 손실 함수는 활성화 함수와 일치하도록 선택됩니다. 예를 들어 tanh 활성화가 있는 레이어에 대해 tanh 손실이 선택됩니다. 또한 정규화 용어는 업데이트된 가중치가 현재 값에서 너무 멀리 벗어나지 않도록 보장합니다.

역전파와 유사하게 LocoProp은 활성화 계산에 순방향 전달을 적용합니다. 역방향 전달에서 LocoProp은 각 계층의 뉴런에 대한 목표를 설정합니다. 마지막으로 LocoProp은 모델 훈련을 여러 레이어에 걸쳐 독립적인 문제로 분해합니다. 여기서 여러 로컬 업데이트가 각 레이어의 가중치에 병렬로 적용될 수 있습니다.

Google은 최적화 알고리즘의 성능을 평가하기 위한 일반적인 벤치마크인 딥 오토인코더 모델에 대한 실험을 수행했습니다. 그들은 SGD, 모멘텀이 있는 SGD, AdaGrad, RMSProp, Adam 및 Shampoo, K-FAC를 포함한 고차 최적화 프로그램을 포함하여 일반적으로 사용되는 여러 1차 최적화 프로그램에 대해 광범위한 최적화를 수행하고 결과를 LocoProp과 비교했습니다. 결과는 LocoProp 방법이 1차 최적화 프로그램보다 훨씬 더 나은 성능을 발휘하고 고차 최적화 프로그램과 비슷하면서도 단일 GPU에서 실행할 때 훨씬 더 빠르다는 것을 보여줍니다.

위 내용은 Yann LeCun이 Google 연구에 대해 이야기합니다. 타겟 커뮤니케이션은 오랫동안 존재해 왔는데, 귀하의 혁신은 어디에 있습니까?의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!