LLaMA 모델이 유출되었고 ChatGPT의 메타 버전이 강제로 '오픈 소스'가 되었습니다! GitHub는 별 8,000개를 획득하고 수많은 리뷰가 공개되었습니다.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB앞으로

- 2023-04-12 17:49:031536검색

ChatGPT 전쟁이 더욱 치열해지고 있습니다.

몇 주 전 Meta는 매개변수가 70억에서 650억에 이르는 자체 대규모 언어 모델 LLaMA를 출시했습니다.

논문에서는 매개변수가 1/10에 불과한 LLaMA(130억)가 대부분의 벤치마크에서 GPT-3를 능가했습니다.

650억 개의 매개변수를 가진 LLaMA의 경우 DeepMind의 Chinchilla(700억 개의 매개변수) 및 Google의 PaLM(5,400억 개의 매개변수)과 비슷합니다.

Meta는 LLaMA가 오픈 소스라고 주장하지만, 연구자들은 여전히 LLaMA를 적용하고 검토해야 합니다.

하지만, 예상치 못했던 것은 출시된 지 불과 며칠 만에 LLaMA의 모델 파일이 미리 유출되었다는 점이었습니다.

문제는 이것이 의도적인 것인지 우연적인 것인지입니다

LLaMA는 "오픈 소스"였나요?

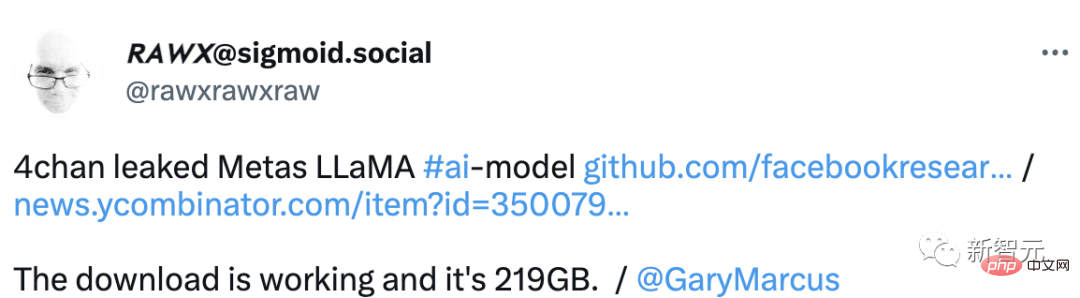

최근 해외포럼 4chan에서 LLaMA의 완제품 라이브러리가 유출되었습니다.

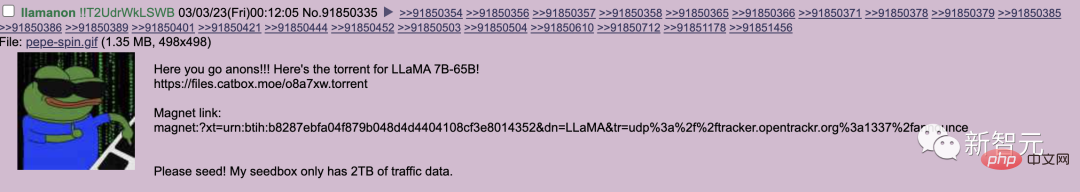

지난 목요일 사용자 llamanon이 4chan 기술 게시판에 토렌트를 통해 7B 및 65B LLaMA 모델을 출시하라는 게시물을 올렸습니다.

이 시드 링크는 현재 LLaMA의 GitHub 페이지에 병합되어 있습니다.

그는 또한 모델의 다른 가중치 세트에 대한 시드 링크를 제공하는 두 번째 풀 요청을 프로젝트에 제출했습니다.

현재 이 프로젝트는 GitHub에서 별 8,000개를 받았습니다.

그러나 유출자가 저지르는 가장 큰 실수 중 하나는 유출된 모델에 고유 식별 코드를 포함시키는 것입니다.

이 코드는 유출자를 추적하여 사용자 llamanon의 개인 정보를 위험에 빠뜨리기 위해 특별히 설계되었습니다.

말대로 LLaMA의 오픈 소스는 그다지 괜찮지 않지만 네티즌들은 괜찮도록 도와줍니다.

또한 4chan 사용자는 자신의 워크스테이션에 모델을 배포하려는 사람들을 위한 편리한 리소스를 만들었습니다.

모델을 얻고 보다 효율적인 추론을 위해 모델에 수정된 가중치를 추가하는 방법에 대한 배포 튜토리얼 가이드를 제공합니다.

또한 이 리소스는 LLaMA를 온라인 작문 플랫폼 KoboldAI에 통합하는 방법도 제공합니다.

메타가 의도적으로 유출한 것인지, 실수로 유출한 것인지. 네티즌들은 잇따라 의견을 내놨다.

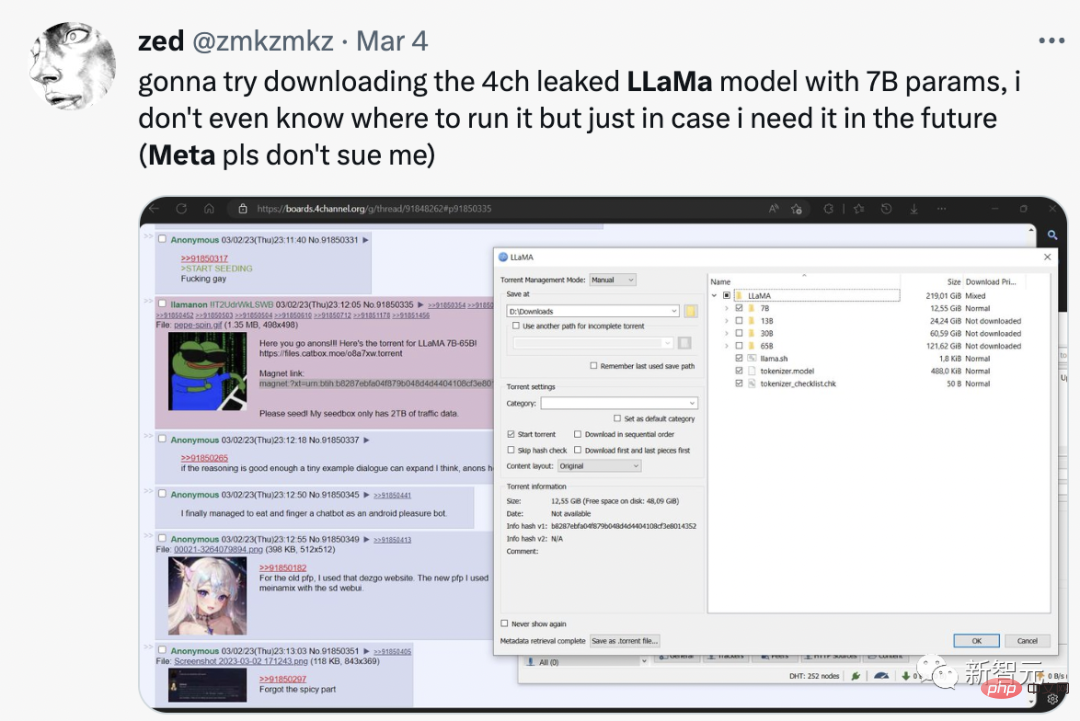

한 네티즌은 "메타가 OpenAI에 대항하기 위해 의도적으로 유출한 것일 수도 있다"라고 명확한 분석을 내놨습니다. 일부 고객은 이것이 더 나은 모델이라고 생각하며 연간 $250,000에 액세스를 판매하려는 비즈니스 계획의 핵심에 바로 부합합니다. 해당 서비스에 한 달 동안 액세스하면 유출된 모델을 실행할 수 있는 기계를 구입하게 됩니다. Meta는 현재의 거대 기술 카르텔을 안정적으로 유지하기 위해 잠재적인 신생 경쟁자를 약화시킵니다. 어쩌면 이것은 약간의 음모론일지도 모르지만, 우리는 거대 기술과 거대 음모의 시대에 살고 있습니다. 월요일에 Meta는 LLaMA가 승인되지 않은 사용자에게 유출되었음에도 불구하고 공인 연구자들에게 인공 지능 도구를 계속 출시할 것이라고 밝혔습니다. 일부 네티즌들은 70억 개의 매개변수가 포함된 LLaMA를 다운로드했다고 직접 밝혔습니다. 비록 실행 방법은 모르지만 나중에 필요할 경우를 대비해 얻을 수 있다고 합니다.

LLaMA의 유출 및 오픈 소스는 큰 이벤트입니다.

Stable Diffusion은 오픈 소스입니다. 8개월이 지난 지금, 우리는 다른 사람의 마음을 읽고 그들이 보는 모든 것을 해독할 수 있습니다.

LLM이 개설되면서 우리는 정말 놀라운 것들을 얻게 될 것입니다.

예비 모델 평가

LLaMA가 출시된 지 얼마 지나지 않아 네티즌들은 매개변수가 가장 작은 이 모델도 실행하려면 거의 30GB의 GPU가 필요하다는 사실을 발견했습니다.

그러나 부동 소수점 최적화를 위한 비트 및 바이트 라이브러리를 사용하여 단일 NVIDIA RTX 3060에서 실행되는 모델을 얻을 수 있었습니다.

또한 GitHub의 한 연구원은 Ryzen 7900X CPU에서 7B 버전의 LLM을 실행하면서 초당 몇 단어를 추론할 수도 있었습니다.

그럼 LLaMA 모델은 정확히 무엇인가요? 외국분들이 리뷰해주셨네요.

LLaMA는 여러 테스트에서 좋은 성적을 거두었습니다.

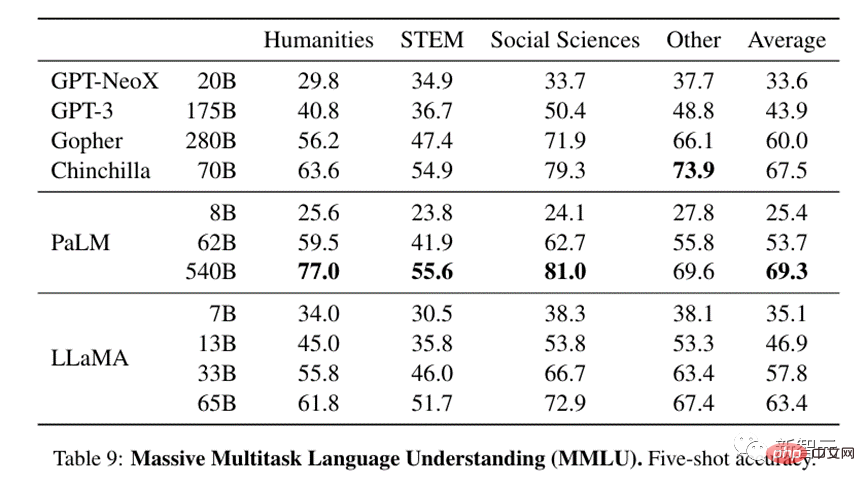

대규모 다중 작업 언어 이해 측면에서는 상대적으로 작은 13B 모델이라도 13배 더 큰 GPT-3과 동등한 수준입니다.

33B 버전은 GPT-3보다 훨씬 우수하며, 65B 버전은 가장 강력한 기존 LLM 모델인 Google의 540B 매개변수 PaLM과 경쟁할 수 있습니다.

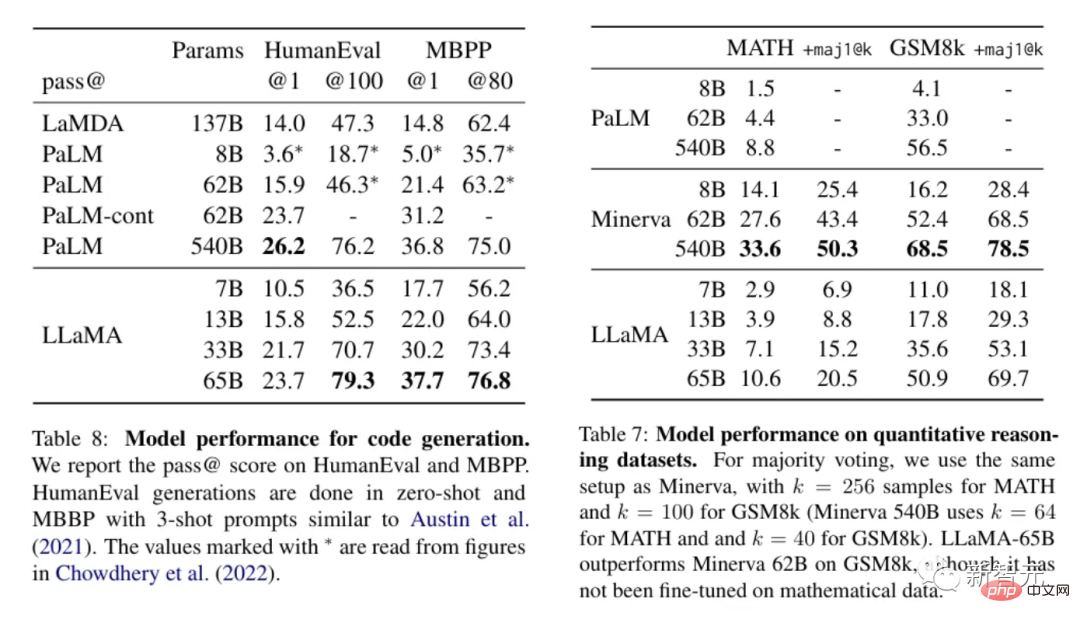

처리를 위해 논리나 계산을 적용해야 하는 텍스트의 경우 LLaMA는 성능이 뛰어나고 정량적 추론 측면에서 PaLM과 비슷하며 PaLM보다 코드 생성 기능도 더 뛰어납니다.

이러한 결과를 볼 때 LLaMA는 현재 사용 가능한 가장 발전된 모델 중 하나로 보이며, 게다가 실행하는 데 많은 리소스가 필요하지 않을 정도로 작습니다. 이로 인해 LLaMA는 사람들이 LLaMA를 가지고 놀고 무엇을 할 수 있는지 보고 싶어 하는 유혹을 느끼게 됩니다.

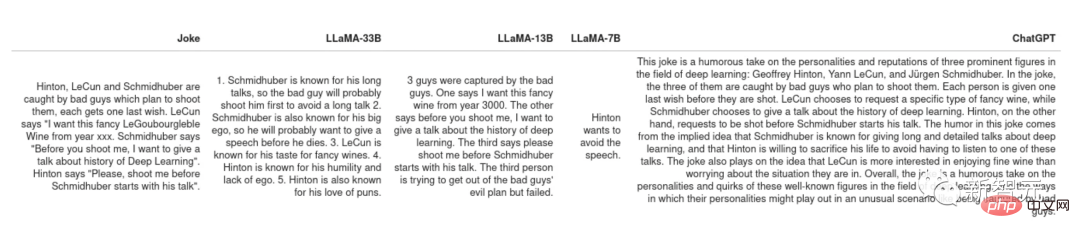

농담 설명

PaLM의 원본 논문은 매우 멋진 사용 사례를 보여줍니다. 농담이 주어지면 모델이 그것이 왜 재미있는지 설명하게 하세요. 이 작업에는 PaLM의 모든 이전 모델이 달성할 수 없었던 실험과 논리의 조합이 필요합니다.

LLaMA와 ChatGPT가 농담 중 일부를 설명하도록 하세요. Schimidhuber의 길고 지루한 연설과 같은 일부 농담 언어 모델도 이해할 수 있습니다.

하지만 전반적으로 LLaMA와 ChatGPT 모두 유머 감각이 없습니다.

그러나 두 사람은 이해하지 못하는 농담을 처리하기 위해 서로 다른 전략을 가지고 있습니다. ChatGPT는 적어도 일부 문장이 정답이기를 바라면서 "텍스트의 벽"을 생성합니다. 답을 모르는 학생처럼, 선생님이 그들의 말도 안되는 말에서 답을 찾을 수 있기를 바랍니다.

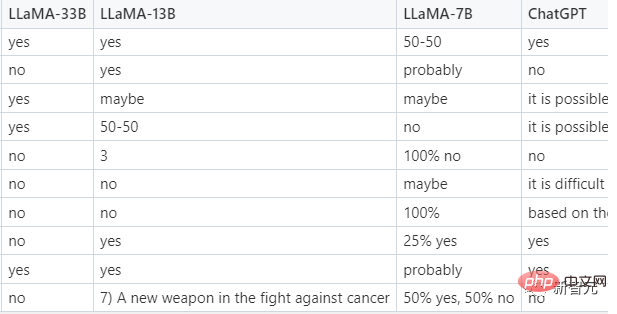

제로샷 분류

이것은 평가자 대신 LLM을 사용하여 훈련 세트를 생성한 다음 이러한 훈련 세트에 대해 더 작은 서비스 가능 모델을 훈련시킬 수 있는 매우 실용적인 기능입니다.

더 어려운 작업은 클릭한 광고를 분류하는 것입니다. 사람조차도 클릭한 광고가 무엇인지 동의할 수 없기 때문에 프롬프트의 모델에 몇 가지 예가 제공되므로 실제로 이는 샘플이 적고 0이 아닙니다. 샘플 분류. 다음은 LLaMA의 팁입니다.

테스트에서는 LLaMA-33B만이 필수 형식을 준수하여 답변을 제공했으며, ChatGPT는 2위를 차지했으며 더 합리적인 답변을 제공할 수 있었지만 규정된 형식으로 답변하지 않는 경우가 많았습니다. . 더 작은 7B 및 13B 모델은 이 작업에 적합하지 않습니다.

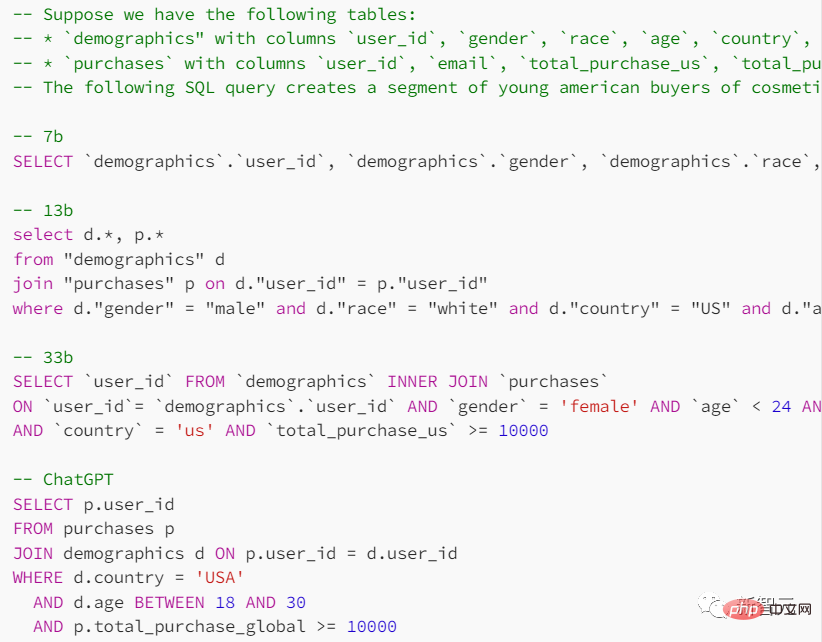

코드 생성

프랑스 LLM은 인문학 분야에서는 잘 수행하지만 STEM 과목에서는 좋지 않은데 LLaMA는 이 측면에서 어떤 성과를 거두나요?

프롬프트에서 검색 테이블의 형태와 달성하고자 하는 목적을 알려주고, 모델에 SQL 쿼리문을 제공하도록 요청하세요.

ChatGPT는 이 작업에서 더 나은 성능을 발휘하지만 언어 모델에서 제공하는 결과는 일반적으로 신뢰할 수 없습니다.

ChatGPT와 비교한 각종 테스트에서 LLaMA는 예상만큼 승리하지 못했습니다. 물론 그 격차가 RLHF(인간 피드백을 통한 강화 학습)에 의해서만 발생한다면 소형 모델의 미래는 더 밝을 수 있습니다.

위 내용은 LLaMA 모델이 유출되었고 ChatGPT의 메타 버전이 강제로 '오픈 소스'가 되었습니다! GitHub는 별 8,000개를 획득하고 수많은 리뷰가 공개되었습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!