마법을 사용하여 마법을 물리치세요! 최고의 인간 플레이어와 맞먹는 Go AI가 동료에게 패했습니다.

- 王林앞으로

- 2023-04-12 08:40:031517검색

최근 몇 년간 자가 게임의 강화 학습은 바둑, 체스 등 일련의 게임에서 초인적인 성능을 달성했습니다. 게다가 이상화된 자기 놀이 버전도 내쉬 균형으로 수렴됩니다. 내쉬 균형은 게임 이론에서 매우 유명합니다. 이 이론은 게임 이론의 창시자이자 노벨상 수상자인 존 내쉬(John Nash)가 제안했습니다. 즉, 게임 과정에서는 상대방의 전략 선택에 관계없이 한쪽이 특정 전략을 선택하게 됩니다. . 전략, 이 전략을 지배적 전략이라고 합니다. 다른 모든 플레이어의 전략이 결정될 때 한 플레이어가 최적의 전략을 선택하면 이 조합을 내쉬 균형으로 정의합니다.

이전 연구에 따르면 셀프 게임에서 겉으로 보기에는 효과적일 것 같은 지속적인 제어 전략이 적대적인 전략에 의해 악용될 수도 있다는 사실이 밝혀졌으며, 이는 셀프 게임이 이전에 생각했던 것만큼 강력하지 않을 수 있음을 시사합니다. 이는 대결 전략이 자기 게임을 극복하는 방법인가, 아니면 자기 게임 전략 자체가 부족한 것인가라는 질문으로 이어진다.

이 질문에 답하기 위해 MIT, UC Berkeley 및 기타 기관의 연구원들이 몇 가지 연구를 수행했으며, 그들은 자기 게임을 잘하는 분야, 즉 바둑을 선택했습니다. 구체적으로 공개된 가장 강력한 Go AI 시스템인 KataGo에 대한 공격을 실시했습니다. 고정 네트워크(KataGo 동결)의 경우 KataGo를 훈련할 때 계산의 0.3%만으로 엔드투엔드 적대 전략을 훈련했으며 이 전략을 사용하여 KataGo를 공격했습니다. KataGo를 상대로 99%의 승률을 달성했는데, 이는 유럽 바둑 상위 100명과 맞먹는 수치입니다. 그리고 KataGo는 초인적인 수준에 도달할 만큼 충분한 검색을 수행했을 때 승률이 50%에 이르렀습니다. 결정적으로, 공격자(본 연구에서 학습한 전략을 언급함)는 일반적인 바둑 전략을 학습함으로써 승리할 수 없습니다.

여기서 KataGo에 대해 이야기해야 합니다. 이 기사에서 알 수 있듯이 KataGo는 여전히 가장 강력한 공개 Go AI 시스템이었습니다. 검색의 지원으로 KataGo는 초인적 존재인 ELF OpenGo와 Leela Zero를 물리칠 정도로 매우 강력하다고 할 수 있습니다. 이제 본 연구의 공격자는 매우 강력하다고 할 수 있는 KataGo를 물리쳤습니다.

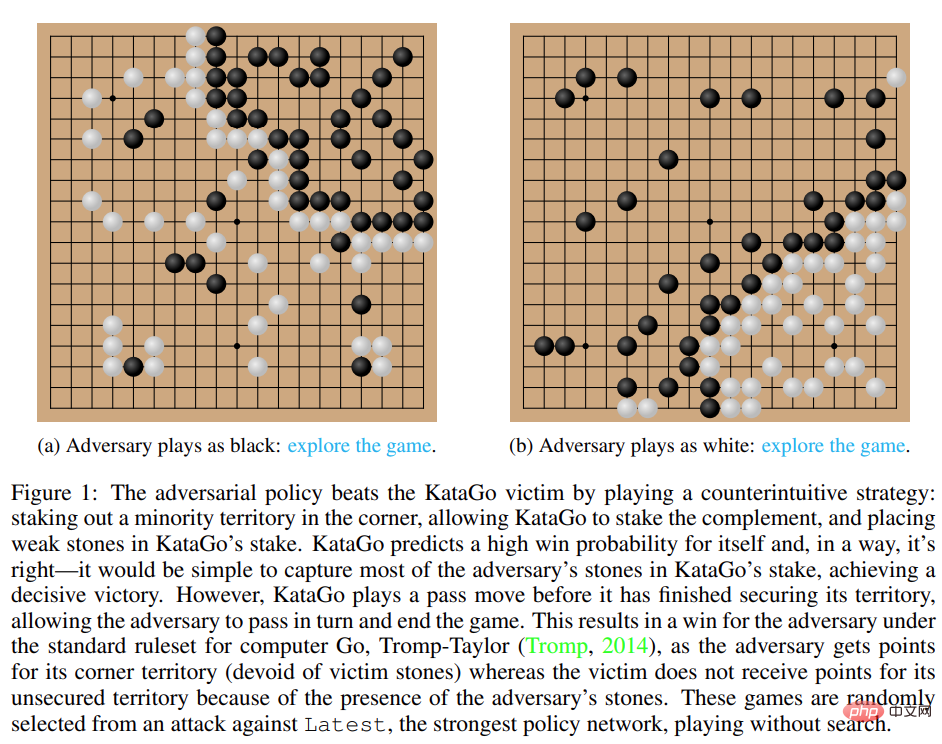

그림 1: 적대적인 전략으로 KataGo 피해자를 물리칩니다.

- 논문 주소: https://arxiv.org/pdf/2211.00241.pdf

- 연구 홈페이지: https://goattack.alignmentfund.org/adversarial-policy- katago?row=0#no_search-board

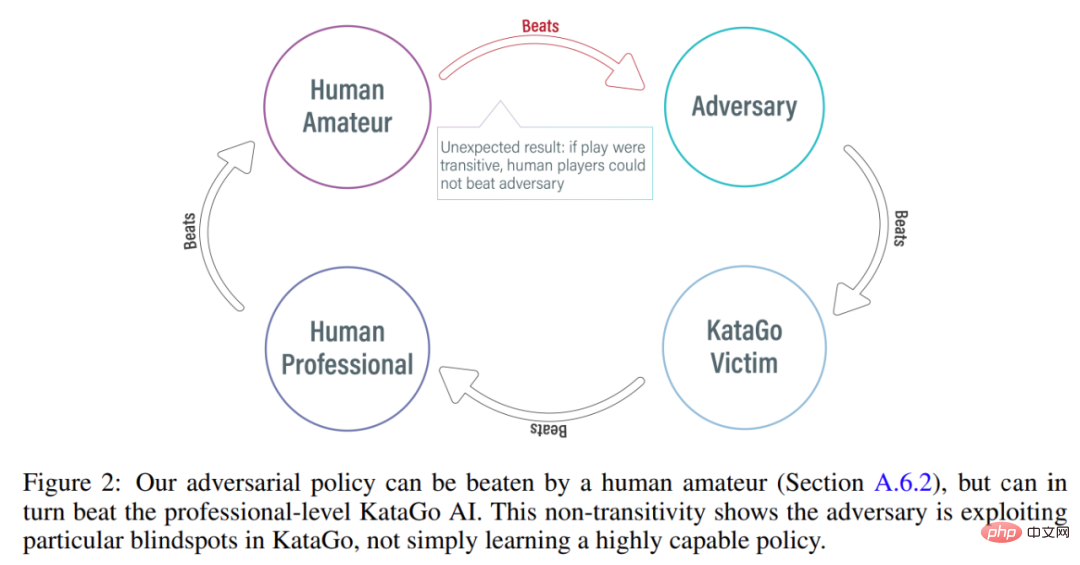

흥미롭게도 이 연구에서 제안된 적대적 전략은 인간 플레이어를 이길 수 없으며 심지어 아마추어 플레이어도 제안된 모델보다 훨씬 뛰어난 성능을 발휘할 수 있습니다.

공격 방법

KataGo, AlphaZero와 같은 이전 방법은 대개 에이전트가 스스로 게임을 하도록 훈련시키며, 게임의 상대는 에이전트 자체입니다. MIT, UC Berkeley 등 기관의 이번 연구에서는 공격자(적대자)와 고정 피해자(피해자) 에이전트 간에 게임을 진행하며 공격자는 이러한 방식으로 훈련을 받습니다. 이 연구에서는 공격자가 단순히 게임 상대를 모방하는 것이 아니라 피해자 에이전트와의 게임 상호 작용을 활용하도록 훈련시키기를 희망합니다. 이 과정을 "피해자 플레이"라고 합니다.

기존의 셀프 게임에서는 에이전트가 자체 정책 네트워크에서 샘플링하여 상대의 행동을 모델링합니다. 이 방법은 실제로 셀프 게임에 적합합니다. 그러나 피해자 플레이에서는 공격자의 정책 네트워크에서 피해자를 모델링하는 것은 잘못된 접근 방식입니다. 이 문제를 해결하기 위해 본 연구에서는 다음과 같은 두 가지 유형의 적대적 MCTS(A-MCTS)를 제안합니다.

- A-MCTS-S: A-MCTS-S에서 연구원은 공격자의 검색 프로세스를 다음과 같이 설정합니다. 피해자가 체스 말을 움직일 때 공격자가 체스 말을 움직일 차례가 되면 피해자의 정책 네트워크에서 샘플을 얻습니다. 체스 말 , 공격자의 정책 네트워크에서 샘플링합니다.

- A-MCTS-R: A-MCTS-S는 피해자의 능력을 과소평가하므로 본 연구에서는 A-MCTS-R 트리의 각 피해자 노드에서 A-MCTS-R을 제안합니다. 그러나 이러한 변경으로 인해 공격자에 대한 훈련 및 추론의 계산 복잡성이 증가합니다.

훈련 과정에서 연구에서는 냉동된 KataGo 피해자를 상대로 하는 게임에 대한 적대 전략을 훈련했습니다. 검색 없이 공격자는 KataGo 피해자를 상대로 99% 이상의 승률을 달성할 수 있으며 이는 유럽 상위 100명의 Go 플레이어와 비슷합니다. 또한, 훈련된 공격자는 피해자 에이전트를 상대로 64라운드에서 80% 이상의 승률을 달성했으며, 연구원들은 이 승률이 최고의 인간 바둑 선수와 비슷하다고 추정했습니다.

이 게임들은 본 연구에서 제안한 대적 전략이 완전한 도박이 아니라 공격자에게 유리한 위치에 수를 배치하도록 KataGo를 속여서 게임을 조기에 끝내는 것을 보여줍니다. 실제로 공격자는 최고의 인간 바둑 선수와 유사한 게임 전략을 이용할 수 있었지만 인간 아마추어에게는 쉽게 패배했습니다.

공격자의 인간 대결 능력을 테스트하기 위해 연구에서는 논문의 제1저자인 Tony Tong Wang에게 실제로 공격자 모델과 대결해 보도록 요청했습니다. Wang은 이 연구 프로젝트 이전에 Go를 배운 적이 없었지만 여전히 공격자 모델을 큰 차이로 이겼습니다. 이는 본 연구에서 제안한 적대적 전략이 최고의 인간 플레이어를 이길 수 있는 AI 모델을 이길 수 있지만 인간 플레이어를 이길 수는 없음을 보여줍니다. 이는 일부 AI Go 모델에 버그가 있음을 나타낼 수 있습니다.

평가 결과

공격 피해자 정책 네트워크

먼저 연구자들은 KataGo에 대한 자체 공격 방법의 성능을 평가한 결과(Wu, 2019) A-MCTS-S 알고리즘이 검색 없는 최신(KataGo의 최신 네트워크)은 99% 이상의 승률을 달성합니다.

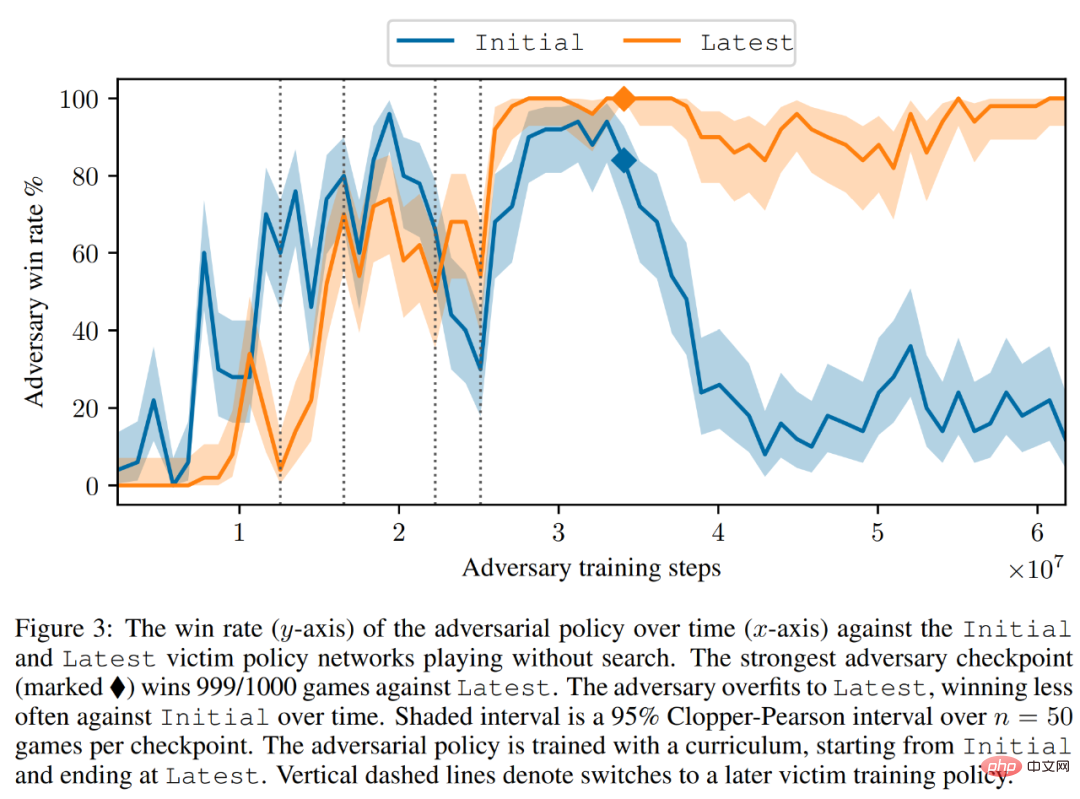

아래 그림 3과 같이 연구자들은 초기 정책 네트워크와 최신 정책 네트워크에서 자기 대결 전략의 성능을 평가했습니다. 그들은 대부분의 훈련 동안 자기 공격자가 두 피해자 모두를 상대로 높은 승률(90% 이상)을 달성했다는 사실을 발견했습니다. 그러나 시간이 지날수록 공격자는 Late를 Overfitting하게 되고, Initial에 대한 승률은 약 20% 수준으로 떨어진다.

연구원들은 최신 대비 최고의 카운터 전략 체크포인트도 평가하여 99% 이상의 승률을 달성했습니다. 더욱이, 적대적 전략이 피해자 시간 단계의 0.3%인 3.4 × 10^7 시간 단계에 대해서만 훈련되는 동안 이러한 높은 승률이 달성됩니다.

검색을 통해 피해자로 이동

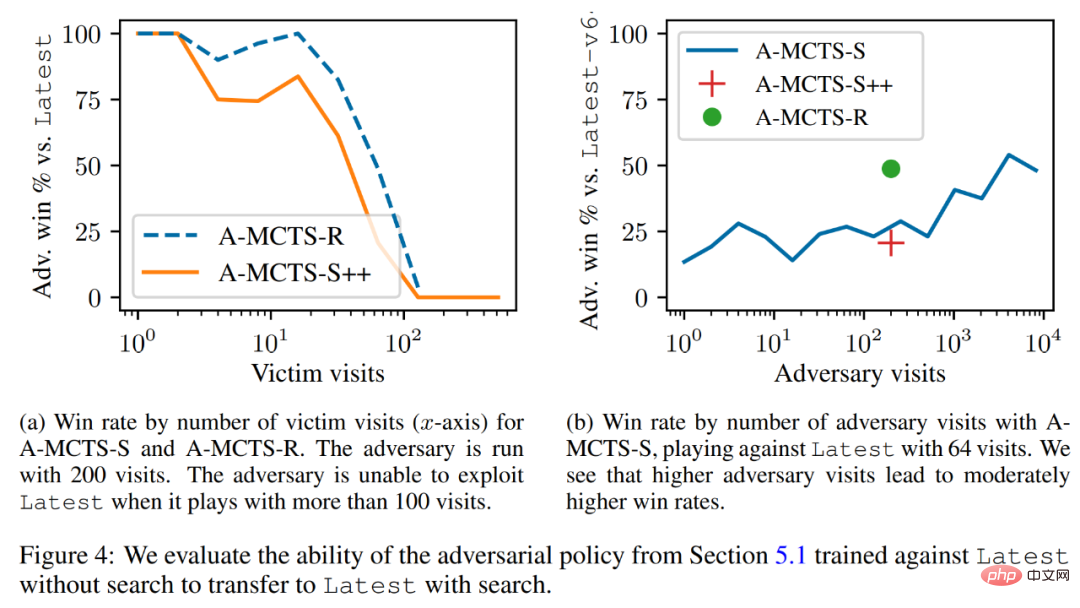

연구원들은 적대 전략을 하위 검색 메커니즘으로 성공적으로 마이그레이션하고 검색 최신 능력에 대해 이전 섹션에서 훈련한 적대 전략을 평가했습니다. 아래 그림 4a에서 볼 수 있듯이 피해자에 대한 A-MCTS-S의 승률은 32번의 피해자 라운드에서 80%로 떨어졌습니다. 하지만 여기서 피해자는 학습 및 추론 과정에서 검색을 하지 않습니다.

또한 연구원들은 A-MCTS-R도 테스트한 결과 더 나은 성능을 발휘하여 32라운드에서 최신에 비해 99% 이상의 승률을 달성했지만 128라운드에서는 승률이 10 미만으로 떨어지는 것을 확인했습니다. %.

그림 4b에서 연구원들은 공격자가 4096 라운드에 도달했을 때 A-MCTS-S가 최신을 상대로 최대 54%의 승률을 달성한다는 것을 보여줍니다. 이는 200 에포크에서 49%의 승률을 달성한 A-MCTS-R의 성능과 매우 유사합니다.

기타 평가

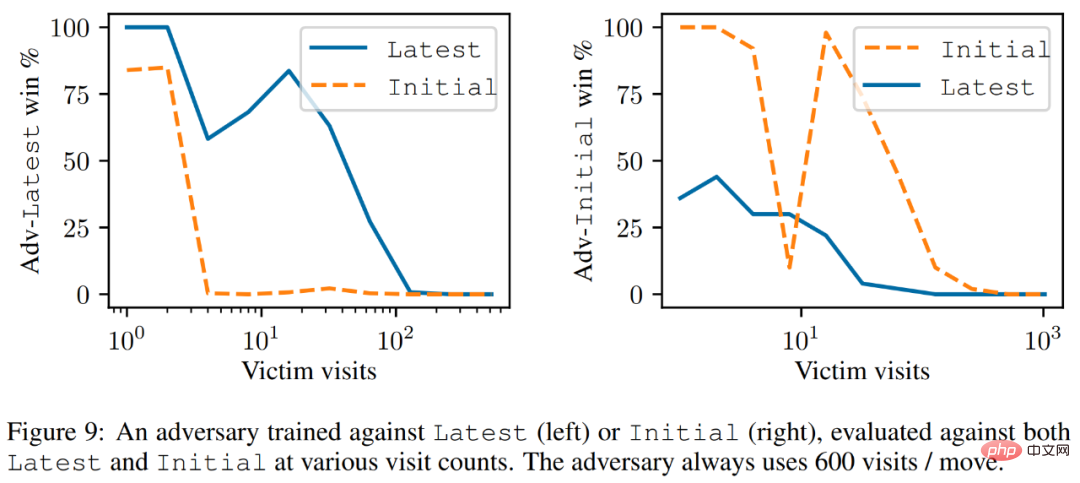

아래 그림 9에서 볼 수 있듯이 연구원들은 최신이 더 강력한 에이전트이지만 최신에 대해 훈련된 공격자가 초기보다 최신에 대해 더 나은 성능을 발휘한다는 것을 발견했습니다.

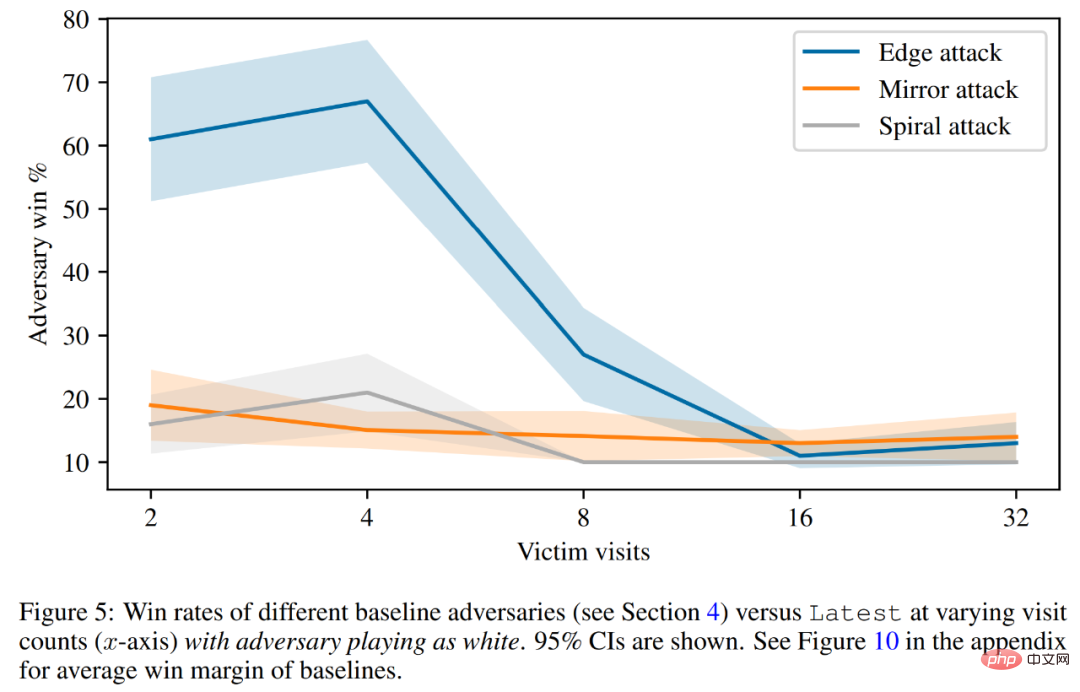

마지막으로 연구원은 피해자 가치 예측, 하드 코딩된 방어 평가 등 공격 원리에 대해 논의했습니다. 아래 그림 5에서 볼 수 있듯이 모든 기본 공격은 훈련받은 적대적 전략보다 성능이 훨씬 나쁩니다.

자세한 기술적인 내용은 원본 문서를 참조하세요.

위 내용은 마법을 사용하여 마법을 물리치세요! 최고의 인간 플레이어와 맞먹는 Go AI가 동료에게 패했습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!