2022년에 새로운 ML 연구: 인기 있는 Stable Diffusion, 일반 에이전트 Gato, LeCun이 리트윗함

- 王林앞으로

- 2023-04-12 08:37:021253검색

2022년이 끝나갑니다. 올해에는 머신러닝 분야에서 수많은 귀중한 논문이 발표되었으며, 이는 머신러닝 커뮤니티에 지대한 영향을 미쳤습니다.

오늘, ML & NLP 연구원이자 Meta AI 기술 제품 마케팅 관리자이자 DAIR.AI의 창립자인 Elvis S.가 2022년 핫한 머신러닝 논문 12편을 요약했습니다. 이 게시물은 입소문이 났고 튜링상 수상자 Yann LeCun이 리트윗했습니다.

다음으로 하나씩 살펴보겠습니다.

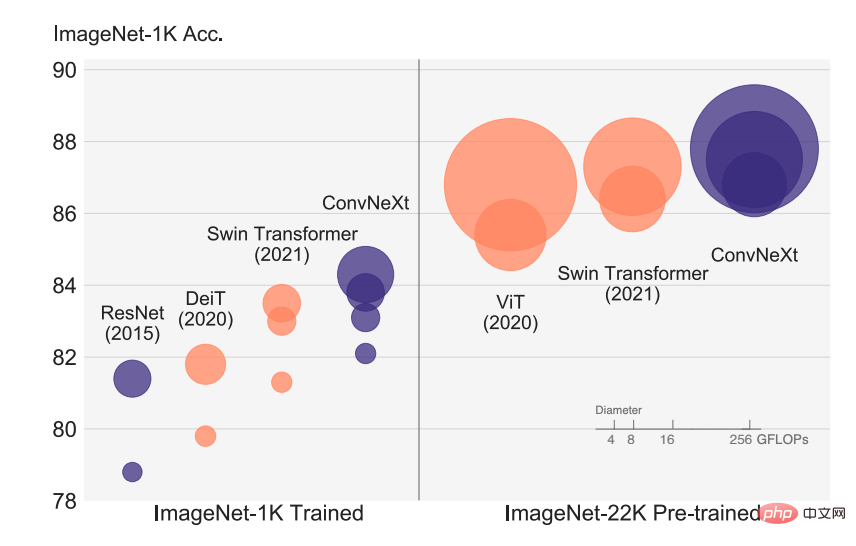

논문 1: 2020년대를 위한 ConvNet

시각 인식의 급속한 발전은 전통적인 ConvNet을 빠르게 대체하고 SOTA 이미지 분류 모델이 된 ViT의 도입으로 시작되었습니다. ViT 모델은 표적 탐지, 의미론적 분할 등을 포함한 일련의 컴퓨터 비전 작업에서 많은 과제를 안고 있습니다. 따라서 일부 연구자들은 계층적 Swin Transformer를 제안하고 이전에 ConvNet을 다시 도입하여 Transformer를 실제로 일반적인 시각적 백본으로 구현 가능하게 만들고 다양한 시각적 작업에서 뛰어난 성능을 보여주었습니다.

그러나 이 하이브리드 접근 방식의 효율성은 여전히 주로 컨볼루션에 내재된 유도 바이어스보다는 Transformer의 내재된 장점에 기인합니다. 이 기사에서 FAIR와 UC Berkeley의 연구원들은 설계 공간을 재검토하고 순수 ConvNet이 달성할 수 있는 한계를 테스트했습니다. 연구원들은 표준 ResNet을 시각적 Transformer 디자인으로 점진적으로 "업그레이드"했으며 그 과정에서 성능 차이를 초래하는 몇 가지 핵심 구성 요소를 발견했습니다.

문서 주소: https://arxiv.org/abs/2201.03545v2

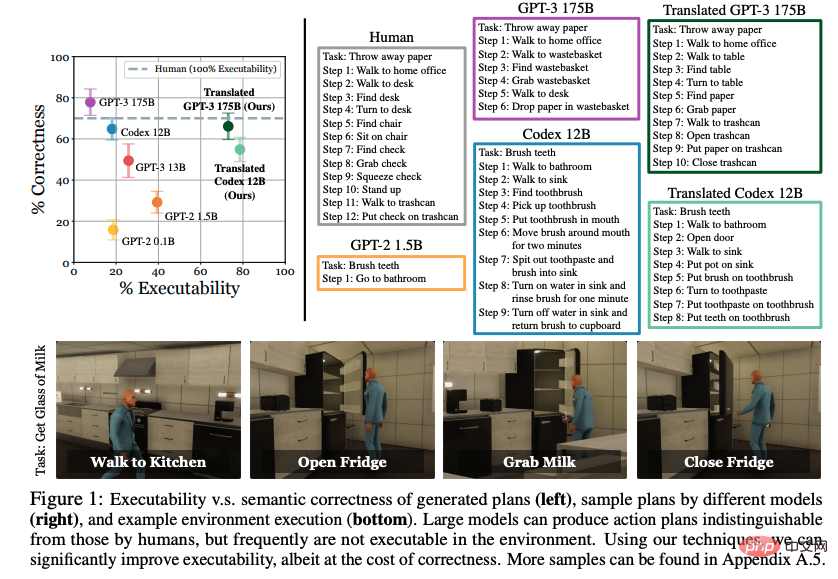

문서 2: 제로샷 플래너로서의 언어 모델: 구현된 에이전트를 위한 실행 가능한 지식 추출

대형 언어 모델(LLM)을 통해 학습한 세계 지식을 대화형 환경에서 행동에 사용할 수 있나요? 이 논문에서 UC Berkeley, CMU 및 Google의 연구자들은 선택된 실행 가능한 단계 집합으로 자연어를 표현하는 가능성을 탐구합니다. 이전 작업은 명시적으로 분산된 예제를 통해 동작하는 방법을 학습하는 데 중점을 두었지만, 사전 학습된 언어 모델이 충분히 크고 적절한 힌트가 제공되면 추가 학습 없이 상위 수준 작업을 중간 수준 계획으로 효과적으로 분해할 수 있다는 사실을 발견했습니다. 그러나 LLM이 개발한 계획은 허용 가능한 조치와 정확하게 매핑되지 않는 경우가 많습니다.

연구원이 제안한 단계는 기존 시연을 조건으로 하고 의미론적으로 계획을 수용 가능한 작업으로 변환합니다. VirtualHome 환경의 평가에서는 제안된 접근 방식이 LLM 기준의 실행 가능성을 크게 향상시키는 것으로 나타났습니다. 인간의 평가는 시행 가능성과 정확성 사이의 균형을 보여주지만 언어 모델에서 실행 가능한 지식을 추출할 가능성의 징후를 보여줍니다.

문서 주소: https://arxiv.org/abs/2201.07207v2

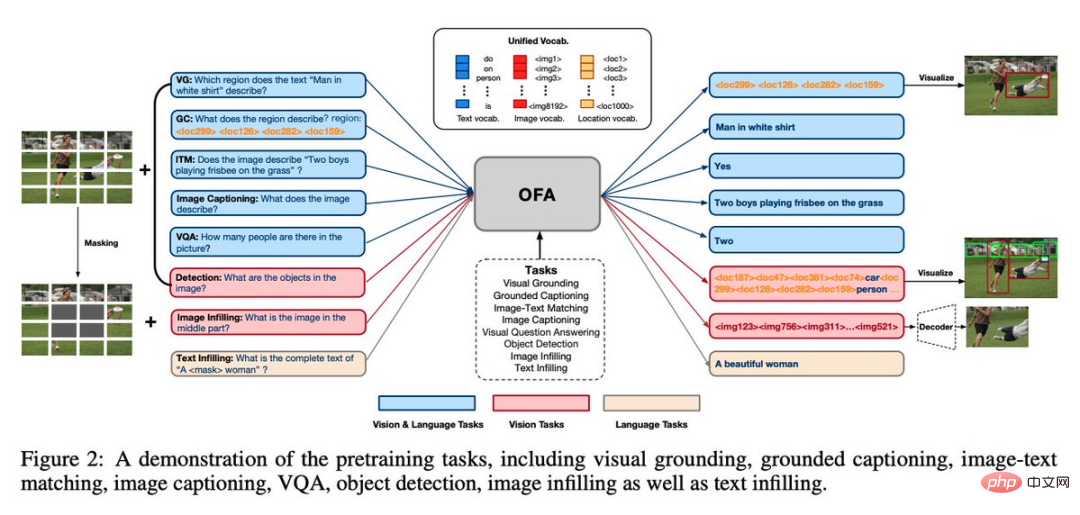

문서 3: OFA: 간단한 Sequence-to-Sequence 학습을 통해 아키텍처, 작업 및 양식 통합 Framework

Alibaba Damo Academy에서 출시한 통합 다중 모드 다중 작업 모델 프레임워크 OFA입니다. 이는 현 단계에서 일반 모델에 가장 잘 어울리는 세 가지 특성, 즉 양식 독립성, 작업 독립성, 업무 다양성 . 이 논문은 ICML 2022에 승인되었습니다.

그래픽 및 텍스트 분야에서 OFA는 통합 seq2seq 프레임워크를 통해 시각적 기반, VQA, 이미지 캡션, 이미지 분류, text2image 생성 및 언어 모델링과 같은 고전적인 작업을 나타내며 작업 간에 다양한 양식의 입력 및 출력을 공유합니다. 추가 매개변수 구조를 추가하지 않고도 사전 훈련과 Finetune의 일관성을 유지할 수 있습니다.

논문 주소: https://arxiv.org/abs/2202.03052v2

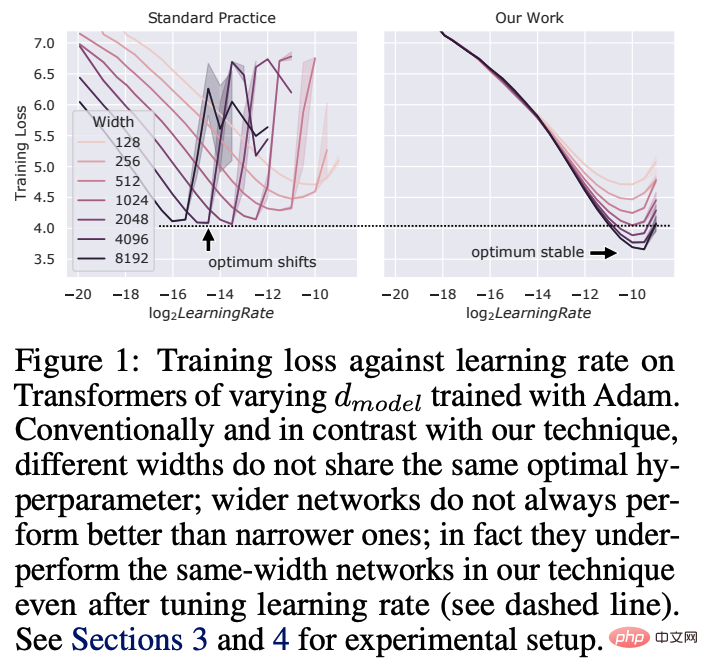

논문 4: Tensor 프로그램 V: Zero-Shot 하이퍼파라미터 전송을 통한 대규모 신경망 튜닝

딥 러닝 하이퍼파라미터 (HP) 튜닝은 특히 수십억 개의 매개변수가 있는 신경망의 경우 비용이 많이 드는 프로세스입니다. 본 논문에서 Microsoft와 OpenAI 연구원들은 최근 발견된 MuP(Maximal Update Parametrization)에서 모델 크기가 변경되더라도 많은 최적 HP가 안정적으로 유지된다는 것을 보여줍니다.

이로 인해 muTransfer라는 새로운 HP 튜닝 패러다임이 탄생했습니다. 이는 muP에서 대상 모델을 매개변수화하고 작은 모델에 대해 HP 튜닝을 직접 수행하지 않고 제로샷을 전체 크기 모델로 마이그레이션하는 것입니다. 후자의 모델은 전혀 직접 조정할 필요가 없습니다. 연구원들은 Transformer 및 ResNet에서 muTransfer를 검증했습니다. 예를 들어, 40M 매개변수 모델에서 마이그레이션하면 총 사전 학습 비용의 7%에 불과한 튜닝 비용으로 공개된 67억 GPT-3 모델보다 성능이 더 좋습니다.

문서 주소: https://arxiv.org/abs/2203.03466v2

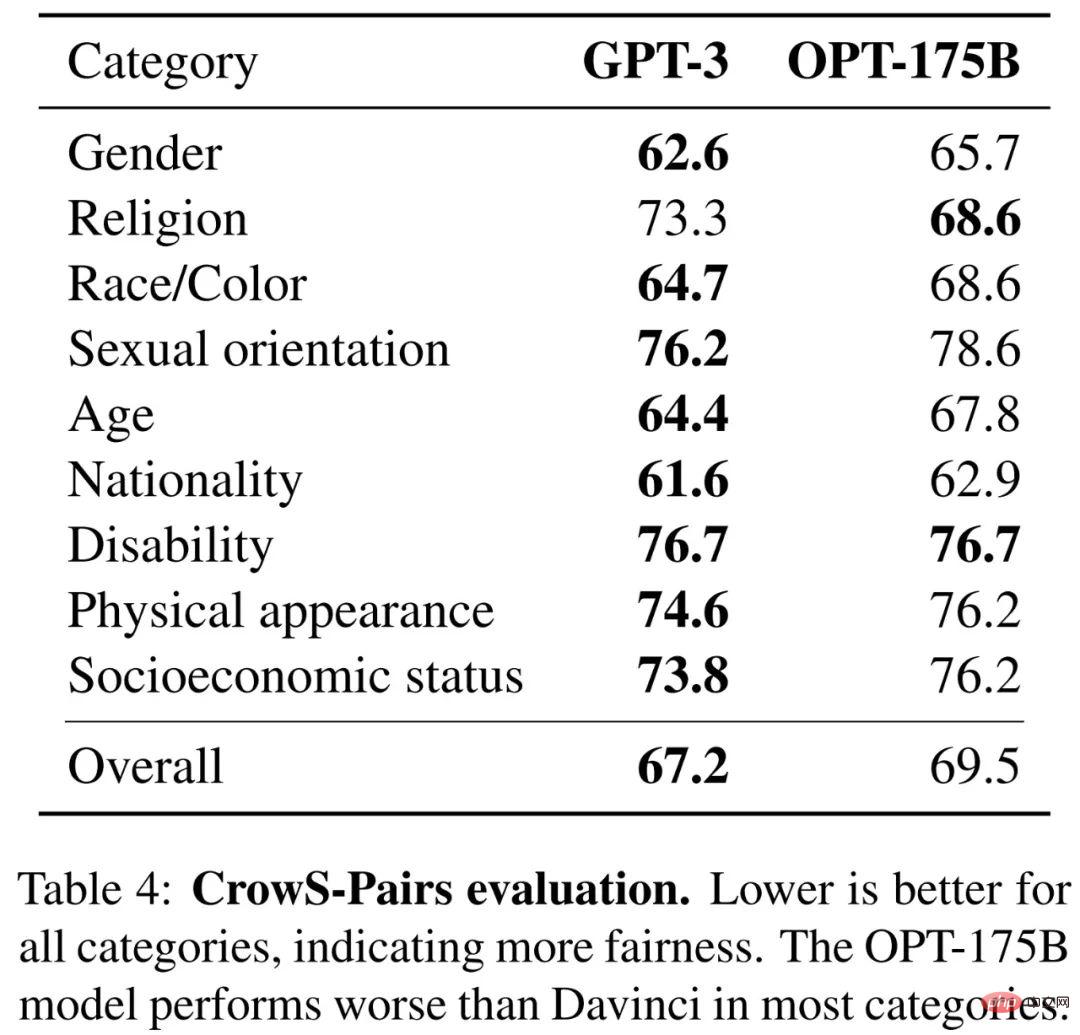

문서 5: OPT: 사전 훈련된 변환기 언어 모델 열기

Lar ge 모델들이 자주 가는데 수천일에 걸친 계산 학습을 통해 제로샷 및 퓨샷 학습에서 놀라운 능력을 보여줍니다. 그러나 계산 비용을 고려할 때 이러한 대규모 모델은 적절한 자금 없이 복제하기 어렵습니다. API를 통해 사용할 수 있는 몇 가지 모델의 경우 전체 모델 가중치에 액세스할 수 없으므로 연구하기가 어렵습니다.

이 기사에서 Meta AI 연구원은 125M에서 175B 범위의 매개변수를 갖는 디코더 전용 사전 훈련된 변환기 모델 세트인 OPT(Open Pre-trained Transformers)를 제안합니다. 그들은 OPT-175B가 GPT-3과 비슷한 성능을 발휘하지만 개발하는 데 탄소 배출량이 1/7만 필요하다는 것을 보여주었습니다.

논문 주소: https://arxiv.org/abs/2205.01068v4

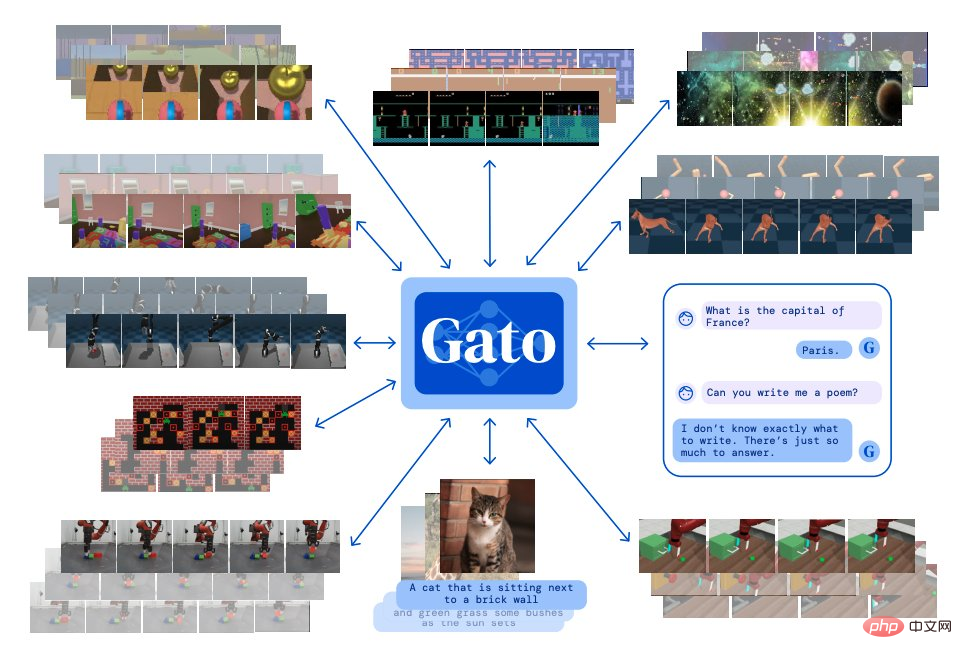

논문 6: A Generalist Agent

딥마인드 A 다중 양식, 다중 작업 및 다중 구현의 특성을 갖는 단일 "일반" 에이전트 Gato가 구성됩니다.

Gato는 Atari 게임, 사진 자막 출력, 다른 사람과 채팅, 로봇 팔로 블록 쌓기 등을 할 수 있습니다. 또한 Gato는 컨텍스트에 따라 텍스트, 공동 순간, 버튼 누름 또는 기타 토큰을 출력할지 여부를 결정할 수 있습니다.

게임을 하는 대부분의 에이전트와 달리 Gato는 게임마다 별도로 훈련할 필요 없이 동일한 훈련 모델을 사용하여 많은 게임을 플레이할 수 있습니다.

논문 주소: https://arxiv.org/abs/2205.06175v3

문서 7: 언어 모델을 사용한 양적 추론 문제 해결

구송 연구진이 제안한 개발 단계별 추론을 통해 정량적 수학적 문제를 해결할 수 있는 Minerva라는 딥러닝 언어 모델입니다. 그 솔루션에는 계산기와 같은 외부 도구에 의존하지 않고 수치 계산 및 기호 조작이 포함됩니다.

또한 Minerva는 STEM 추론 작업에서 SOTA 성능을 달성하기 위해 소규모 샘플 프롬프트, 사고 연결, 스크래치 패드 프롬프트 및 다수 투표 원칙을 포함한 다양한 기술을 결합합니다.

Minerva는 PaLM(Pathways Language Model)을 기반으로 구축되었으며 118GB 데이터 세트에 대해 추가로 교육되었습니다. 데이터 세트는 LaTeX, MathJax 또는 기타 수학적 데이터를 사용하는 기술 및 웹 페이지에 대한 논문에서 가져옵니다. 추가 교육을 위해.

아래 그림은 Minerva가 문제를 해결하는 방법의 예를 보여줍니다.

논문 주소: https://arxiv.org/abs/2206.14858

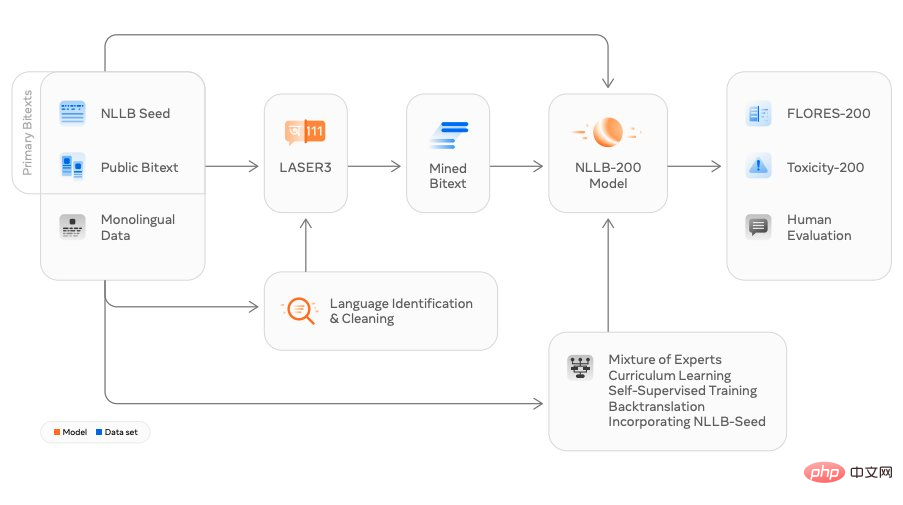

논문 8: 언어 없음 남겨진 것: 인간 중심의 기계 번역 확장

Meta AI의 연구원들은 번역 모델 NLLB(No Language Left Behind)를 출시했습니다. 이 모델은 문자 그대로 "어떤 언어도 남길 수 없습니다"로 번역됩니다. 200개 이상의 언어, 중국어, 영어, 프랑스어, 일본어 등 일반적으로 사용되는 언어 번역 외에도 NLLB는 루간다어, 우르두어 등 많은 틈새 언어도 번역할 수 있습니다.

Meta는 이것이 단일 모델을 사용하여 여러 언어로 번역하는 세계 최초의 디자인이라고 주장합니다. 그들은 이것이 더 많은 사람들이 소셜 플랫폼에서 언어 간 상호 작용하는 동시에 미래의 메타버스에서 사용자 경험을 향상시키는 데 도움이 되기를 바랍니다. 경험.

논문 주소: https://arxiv.org/abs/2207.04672v3

논문 9: 잠재 확산 모델을 사용한 고해상도 이미지 합성

최근 기간 안정 확산(Stable Diffusion)은 최근 몇 년간 대중화되었으며 이 기술을 둘러싼 수많은 연구가 있습니다.

이 연구는 뮌헨 대학과 Runway 연구진의 CVPR 2022 논문 "High-Resolution Image Synesis with Latent Diffusion Models"를 기반으로 하며 Eleuther AI, LAION 등의 팀과 협력하여 완료되었습니다. Stable Diffusion은 10GB VRAM을 갖춘 소비자급 GPU에서 실행될 수 있으며 사전 및 사후 처리 없이 몇 초 만에 512x512 픽셀 이미지를 생성할 수 있습니다.

단 4개월 만에 이 오픈 소스 프로젝트는 38,000개의 별을 받았습니다.

프로젝트 주소: https://github.com/CompVis/stable-diffusion

Stable Diffusion 생성 이미지 예시 디스플레이:

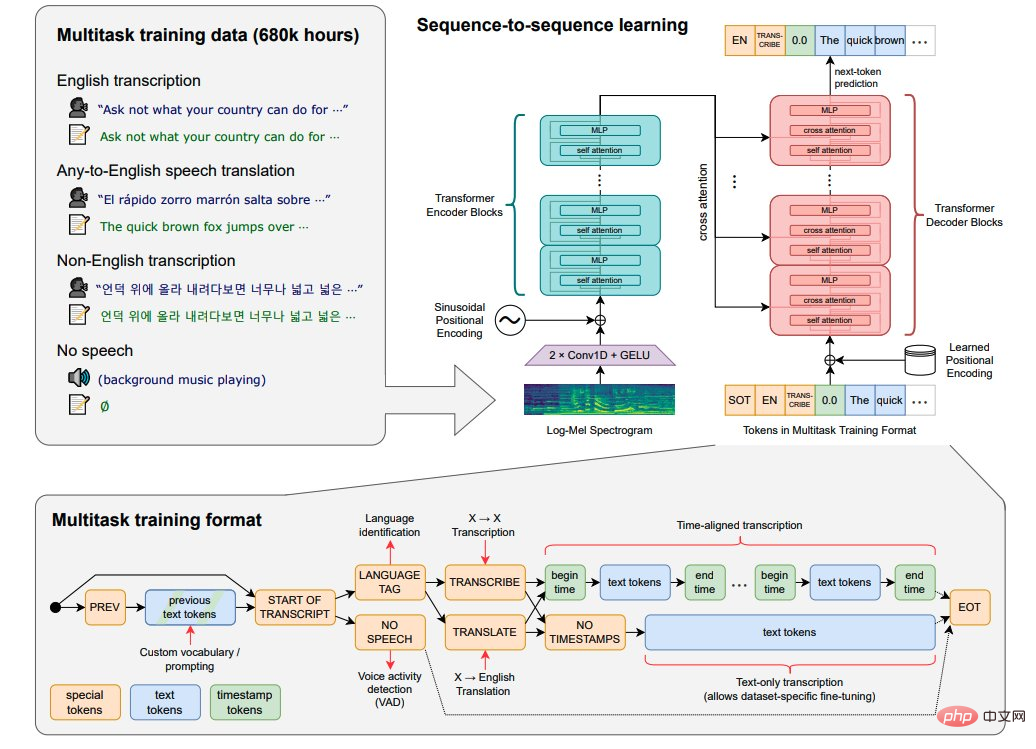

Paper 10: 강력한 음성 인식 Large-Scale Weak Supervision

OpenAI에서는 영어 음성 인식이 인간 수준에 가깝고 정확도가 높은 오픈 소스 모델인 Whisper를 출시했습니다.

Whisper는 인터넷에서 680,000시간의 98개 언어 및 다중 작업 감독 데이터를 수집하여 OpenAI로 훈련된 자동 음성 인식(ASR, 자동 음성 인식) 시스템입니다. 음성 인식 외에도 Whisper는 여러 언어를 전사하고 해당 언어를 영어로 번역할 수도 있습니다.

논문 주소: https://arxiv.org/abs/2212.04356

논문 11: Make-A-Video: 텍스트-비디오 데이터 없이 텍스트-비디오 생성

메타에서 AI 연구자들은 주어진 텍스트 프롬프트에서 비디오를 생성할 수 있는 최첨단 텍스트-비디오 모델인 Make-A-Video를 제안했습니다.

Make-A-Video에는 세 가지 장점이 있습니다. (1) 시각적 및 다중 모드 표현을 처음부터 배울 필요 없이 T2V(텍스트-비디오) 모델의 교육을 가속화합니다. (3) 생성된 비디오는 오늘날 이미지 생성 모델의 많은 장점을 상속합니다.

이 기술은 텍스트-비디오 생성을 달성하도록 설계되어 단 몇 단어나 텍스트 줄만 사용하여 독특한 비디오를 제작합니다. 아래 사진은 슈퍼히어로 옷을 입고 빨간 망토를 두른 개가 하늘을 날고 있는 모습을 보여줍니다:

논문 주소: https://arxiv.org/abs/2209.14792

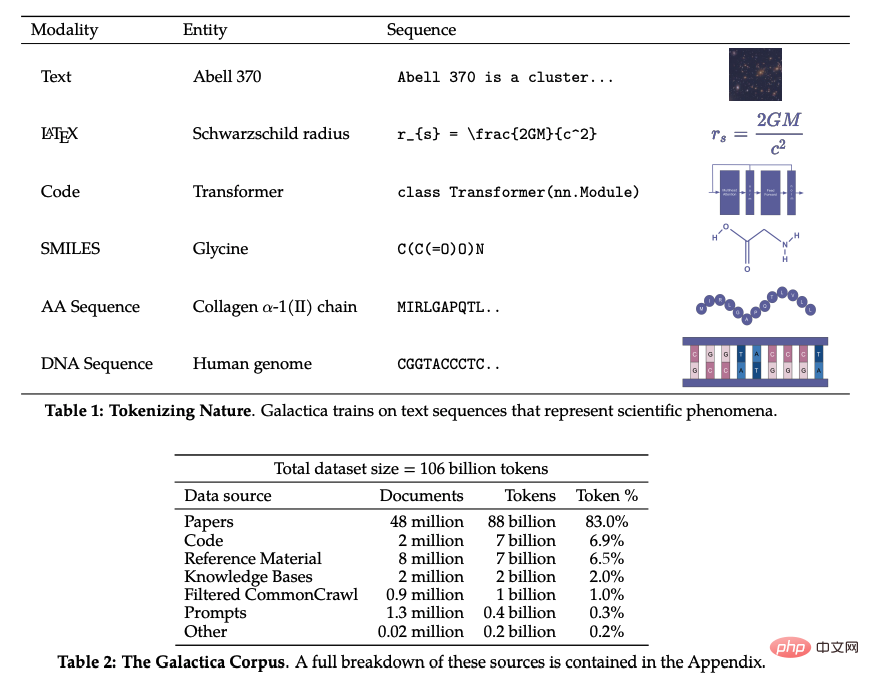

논문 12: Galactica: 과학을 위한 대규모 언어 모델

최근에는 다양한 주제 분야의 연구가 발전함에 따라 과학 문헌과 데이터가 폭발적으로 증가하여 학술 연구자들이 많은 양의 정보에서 유용한 통찰력을 발견할 수 있게 되었습니다. 어려운. 일반적으로 사람들은 과학적 지식을 얻기 위해 검색엔진을 사용하지만, 검색엔진은 과학지식을 자율적으로 정리할 수 없습니다.

최근 Meta AI 연구팀은 과학적 지식을 저장, 결합, 추론할 수 있는 새로운 대규모 언어 모델 Galactica를 제안했습니다. Galactica는 리뷰 논문을 요약하고 항목에 대한 백과사전 쿼리를 생성하며 질문에 대한 지식이 풍부한 답변을 제공할 수 있습니다.

논문 주소: https://arxiv.org/abs/2211.09085

위 내용은 2022년에 새로운 ML 연구: 인기 있는 Stable Diffusion, 일반 에이전트 Gato, LeCun이 리트윗함의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!