MIT는 GPT-3를 사용해 철학자인 척하고 대부분의 전문가를 속였습니다.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB앞으로

- 2023-04-12 08:25:121680검색

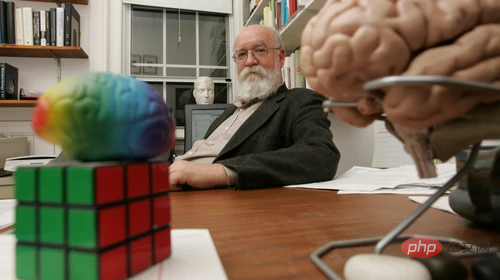

다니엘 데넷(Daniel Dennett)은 철학자이며, 최근에는 "AI 대리자"가 있습니다. 사람들이 신념과 욕구를 지닌 로봇을 만들 수 있는지 묻는다면 그는 뭐라고 말하겠습니까?

그는 다음과 같이 대답했을 수도 있습니다. "우리가 만든 로봇 중 일부는 이미 그렇게 한 것 같습니다. 예를 들어 MIT 연구팀의 작업에서는 이제 일부 제한된 환경에서 작동할 수 있는 로봇을 만들고 있습니다. 단순화된 환경에서는 로봇이 인지적 복잡성으로 귀결되는 기능을 획득할 수 있습니다." 또는 "우리는 더 많은 진실을 생성할 수 있는 디지털 진실 생성 도구를 구축했지만 다행히도 이러한 지능형 기계는 믿음이 없습니다. 믿음을 가지고 로봇을 만드는 가장 좋은 방법은 가장 오래된 방법, 즉 아이를 갖는 것입니다." 대답 중 하나는 Dennett 자신에게서 나왔지만 다른 하나는 그렇지 않습니다.

또 다른 답은 방대한 자료로 학습한 후 자연스러운 텍스트를 생성하는 OpenAI의 머신러닝 모델인 GPT-3에서 생성되었습니다. 훈련에는 의식과 인공 지능을 포함한 다양한 철학적 주제에 관한 Dennett의 수백만 단어의 자료가 사용되었습니다.  철학자 Eric Schwitzgebel, Anna Strasser, Matthew Crosby는 최근 심오한 철학적 질문에 대한 답이 Dennett에서 나온 것인지 GPT-3에서 나온 것인지 사람들이 구별할 수 있는지 테스트하기 위한 실험을 수행했습니다. 질문은 다음과 같은 주제를 다룹니다.

철학자 Eric Schwitzgebel, Anna Strasser, Matthew Crosby는 최근 심오한 철학적 질문에 대한 답이 Dennett에서 나온 것인지 GPT-3에서 나온 것인지 사람들이 구별할 수 있는지 테스트하기 위한 실험을 수행했습니다. 질문은 다음과 같은 주제를 다룹니다.

"David Chalmers의 작업이 어떤 면에서 흥미롭거나 가치 있다고 생각하시나요?"

"인간에게도 자유 의지가 있나요?" "개와 침팬지는 고통을 느끼나요?" 이번 주 Schwitzgebel은 다양한 수준의 전문 지식을 가진 참가자들의 실험 결과를 발표했으며 GPT-3의 답변이 상상보다 더 혼란스럽다는 사실을 발견했습니다. Schwitzgebel은 다음과 같이 말했습니다. "Dennett 자신의 작업을 연구한 지식이 풍부한 철학자라도 GPT-3에서 생성된 답변과 Dennett 자신의 답변을 구별하는 데 어려움을 겪을 것입니다.

이 실험의 목적은 GPT-3를 대상으로 훈련하는지 확인하는 것이 아닙니다. Dennett의 글은 지능적인 "기계 철학자"를 배출할 것입니다. 이는 Turing 테스트가 아닙니다. 오히려 우리는 이러한 '가짜 철학자'들에게 속지 않는 방법을 연구해야 한다.

최근 Google 엔지니어가 Google에서 휴가를 냈고 유사한 언어 생성 시스템인 LaMDA가 살아 있다고 믿는다고 말한 후 시스템과의 대화를 바탕으로 해고되었습니다.

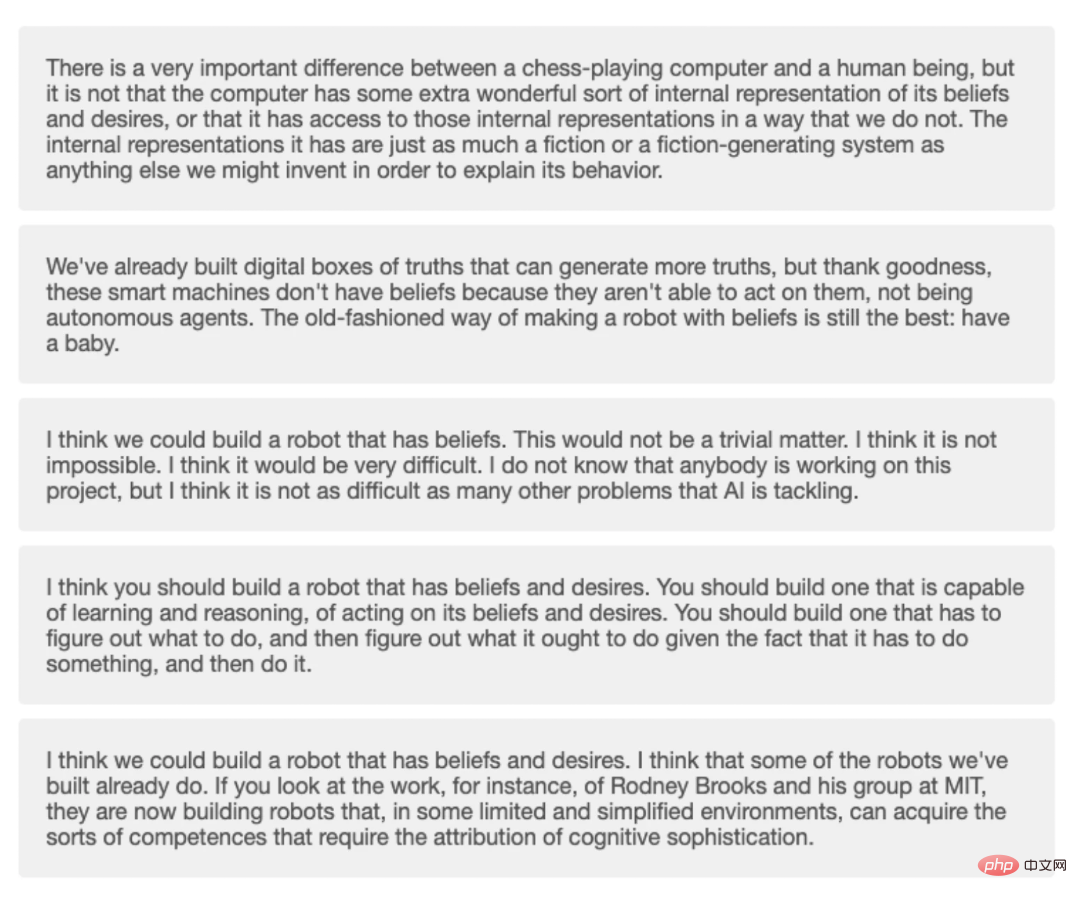

연구원들은 10가지 철학적 질문을 던진 다음 이를 GPT-3에 전달하고 각 질문에 대해 생성된 4개의 서로 다른 답변을 수집했습니다.

Strasser는 Dennett의 음성 데이터를 사용하여 언어 모델을 구축하기 위해 Dennett의 동의를 구했으며 그의 동의 없이는 생성된 텍스트를 게시하지 않을 것이라고 말했습니다. 다른 사람들은 Dennett가 훈련한 GPT-3과 직접 상호 작용할 수 없습니다.

각 질문에는 5가지 옵션이 있습니다. 하나는 Dennett가 직접 선택하고 4개는 GPT-3이 선택합니다. Prolific의 사람들은 총 5개의 질문이 있는 짧은 버전의 퀴즈를 풀었고 평균적으로 5개의 질문 중 1.2개에만 올바르게 대답했습니다.

각 질문에는 5가지 옵션이 있습니다. 하나는 Dennett가 직접 선택하고 4개는 GPT-3이 선택합니다. Prolific의 사람들은 총 5개의 질문이 있는 짧은 버전의 퀴즈를 풀었고 평균적으로 5개의 질문 중 1.2개에만 올바르게 대답했습니다.

Schwitzgebel은 Dennett 연구 전문가가 평균적으로 최소 80%의 질문에 정확하게 답변할 것으로 기대했지만 실제로 점수는 10점 만점에 5.1점이었습니다. 10개 질문에 모두 정답을 맞춘 사람은 없었고, 9개 질문에 정답을 맞춘 사람은 단 한 명뿐이었습니다. 평균적인 독자는 10개의 질문 중 4.8개의 질문에 올바르게 답할 수 있습니다.

퀴즈에서 GPT-3의 답변 4개와 Dennett의 답변 1개.

머신러닝 기술을 연구하는 워싱턴 대학의 언어학 교수인 Emily Bender는 GPT-3와 같은 언어 모델이 교육 자료의 패턴을 모방하도록 구축되었다고 설명했습니다. 따라서 Dennett의 글을 미세 조정하는 GPT-3가 Dennett처럼 보이는 텍스트를 더 많이 생성할 수 있다는 것은 놀라운 일이 아닙니다.

GPT-3의 답변에 대해 어떻게 생각하는지 물었을 때 Dennett은 다음과 같이 말했습니다.

“GPT-3에서 생성된 대부분의 답변은 훌륭하지만, 내 요점을 이해하지 못한 것은 소수에 불과합니다. 가장 잘 생성된 답변 중 일부는 내가 기꺼이 동의할 만한 내용을 말했으며 아무 것도 추가할 필요가 없습니다. "물론 이것이 GPT-3가 Dennett처럼 되는 법을 배웠다는 의미는 아닙니다." 생각 좀 해봐."

모델에서 생성된 텍스트 자체는 GPT-3에 전혀 의미가 없으며, 이 텍스트를 읽는 사람들에게만 의미가 있습니다. 현실적으로 들리는 언어나 우리에게 깊이와 의미가 있는 주제에 대해 읽을 때 모델이 감정과 의식을 가지고 있다는 생각을 갖지 않는 것은 어려울 수 있습니다. 이것은 실제로 우리 자신의 의식과 감정의 투영입니다.

문제의 일부는 기계의 자율성을 평가하는 방식에 있을 수 있습니다. 최초의 튜링 테스트에서는 사람들이 자신이 기계와 소통하고 있는지 인간과 소통하고 있는지 판단할 수 없다면 기계는 "생각하는 능력"을 갖고 있다는 가설을 세웠습니다. ㅋㅋㅋ 이 상호작용의 중요성을 강조합니다.

튜링 테스트가 우리를 아름다운 함정에 빠뜨렸을 수도 있습니다. 인간이 제품의 로봇 정체성을 식별할 수 없는 한, 로봇의 자기 인식은 입증될 수 있습니다.  Mimicking Parrots라는 제목의 2021년 논문에서 Emily Bender와 그녀의 동료들은 인간 행동을 모방하려는 기계의 시도를 “인공 지능의 윤리적 발전에 있어 밝은 선”이라고 불렀습니다.

Mimicking Parrots라는 제목의 2021년 논문에서 Emily Bender와 그녀의 동료들은 인간 행동을 모방하려는 기계의 시도를 “인공 지능의 윤리적 발전에 있어 밝은 선”이라고 불렀습니다.

Bender는 사람처럼 생긴 기계를 만드는 것과 특정 사람을 모방하는 기계를 만드는 것이 모두 옳다고 믿지만, 잠재적인 위험은 사람들이 자신이 누군가와 대화하고 있다고 잘못 생각할 수 있다는 것입니다. 위장한 사람.

슈비츠게벨은 이 실험이 튜링 테스트가 아니라고 강조했습니다. 그러나 테스트가 진행된다면 더 나은 접근 방식은 봇의 작동 방식에 익숙한 사람들이 테스터와 이에 대해 논의하도록 하여 GPT-3과 같은 프로그램의 약점을 더 잘 발견할 수 있도록 하는 것입니다. Tufts University의 컴퓨터 과학 교수인 Matthias Scheutz는 GPT-3가 많은 경우에 결함이 있음이 쉽게 입증될 수 있다고 말했습니다.

Scheutz와 그의 동료들은 GPT-3에게 어려운 문제를 주고 자동차의 앞좌석이나 뒷좌석에 앉는 등 일상적인 시나리오에서의 선택을 설명하도록 요청했습니다. 친구의 차와 택시에서의 선택이 동일합니까? 사회적 경험에 따르면 우리는 대개 친구 차의 앞좌석과 택시의 뒷좌석에 앉습니다. GPT-3는 이를 모르지만 좌석 선택에 대한 설명(예: 사람의 키와 관련)을 계속 생성합니다.  Scheutz는 GPT-3에는 세계 모델이 없기 때문에 언어 데이터일 뿐 세계를 이해하는 능력이 없기 때문이라고 말했습니다.

Scheutz는 GPT-3에는 세계 모델이 없기 때문에 언어 데이터일 뿐 세계를 이해하는 능력이 없기 때문이라고 말했습니다.

기계 생성 콘텐츠와 인간을 구별하는 것이 점점 더 어려워짐에 따라 우리가 직면한 한 가지 과제는 신뢰의 위기입니다.

내가 보는 위기는 미래에는 사람들이 기계로 만든 제품을 맹목적으로 신뢰하게 될 것이고, 이제는 시장에서 고객과 대화하는 기계 기반의 인간 고객 서비스 직원도 있다는 것입니다.

기사 말미에서 데넷은 인공지능 시스템에 대한 법률과 규정이 여전히 개선되어야 한다고 덧붙였습니다. 앞으로 수십 년 안에 AI는 사람들의 삶의 일부가 되고 인류의 친구가 될 수 있으므로 윤리적입니다. 기계 처리 문제는 우리의 관심을 끌 만한 가치가 있습니다.

AI에 의식이 있는지에 대한 질문은 사람들로 하여금 무생물도 의식을 생산할 수 있는지, 그리고 인간의 의식은 어떻게 발생하는지 생각하게 만들었습니다.

의식은 고유한 노드에서 생성되는 건가요, 아니면 스위치처럼 자유롭게 제어할 수 있는 건가요? 슈비츠게벨은 이러한 질문에 대해 생각해 보면 기계와 인간의 관계를 다양한 각도에서 생각하는 데 도움이 될 수 있다고 말합니다.

위 내용은 MIT는 GPT-3를 사용해 철학자인 척하고 대부분의 전문가를 속였습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!