수천억 개의 매개변수를 가진 Meta의 대형 모델인 OPT-IML의 '업그레이드 버전'이 출시되었으며, 완전한 모델과 코드가 공개되었습니다!

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB앞으로

- 2023-04-11 22:31:091671검색

올해 5월 MetaAI는 1,750억 개의 매개변수를 기반으로 한 초대형 모델 OPT-175B의 출시를 공식 발표했으며, 이는 모든 커뮤니티에도 무료로 공개됩니다.

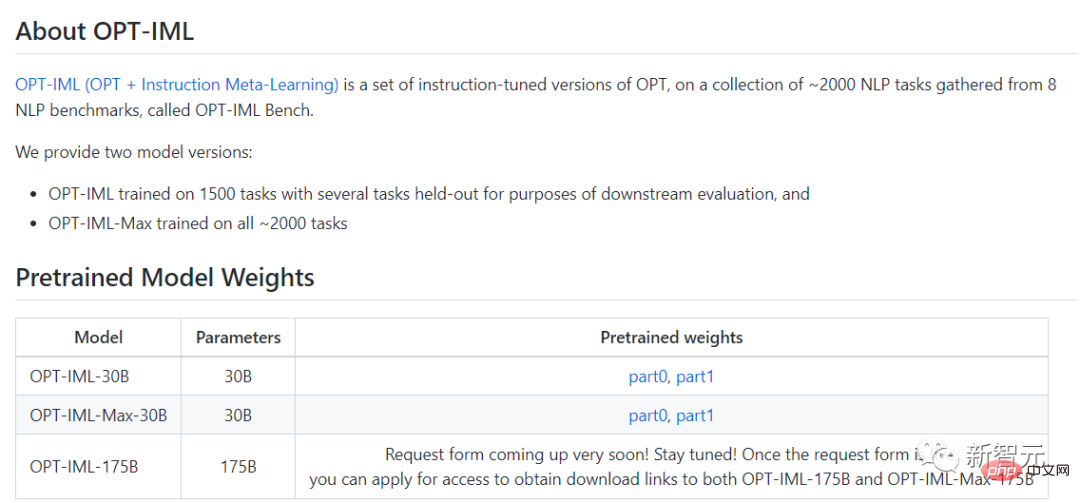

12월 22일, 모델의 업데이트 버전인 OPT-IML(Open Pre-trained Transformer)이 공식 출시되었습니다. Meta는 "2,000개의 언어 작업에 맞게 미세 조정되었으며 1,750억 개의 매개변수를 포함하고 있습니다." 비상업적 연구 용도로도 무료로 사용됩니다.

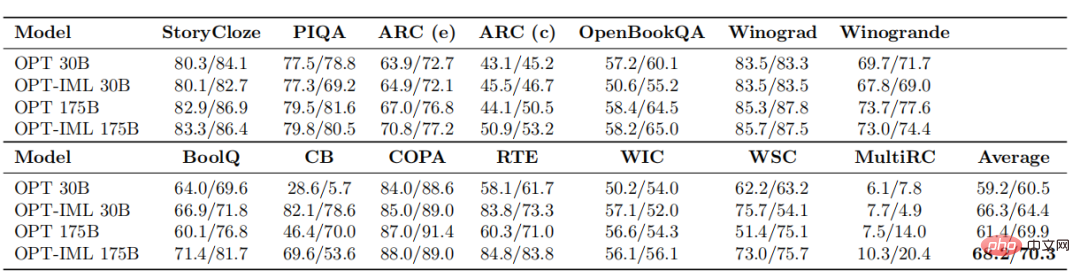

업데이트된 OPT-IML의 성능은 어떤가요? 두 사진을 함께 보시죠.

이번 OPT-IML은 30B와 175B 두 가지 모델 사이즈를 만들었습니다.

기존 OPT 모델과 비교하여 OPT-IML은 14가지 표준 NLP 평가 작업에서 평균적으로 OPT보다 성능이 뛰어납니다.

두 모델 크기는 제로샷 학습 작업에서 각각 7%~, 32샷 작업에서 각각 4%~ 및 0.4%~ 더 좋습니다.

이 연구에서 연구원들은 모델 및 벤치마크 크기의 증가가 지침 조정 결정이 다운스트림 작업 성능에 미치는 영향에 어떻게 영향을 미치는지 설명합니다.

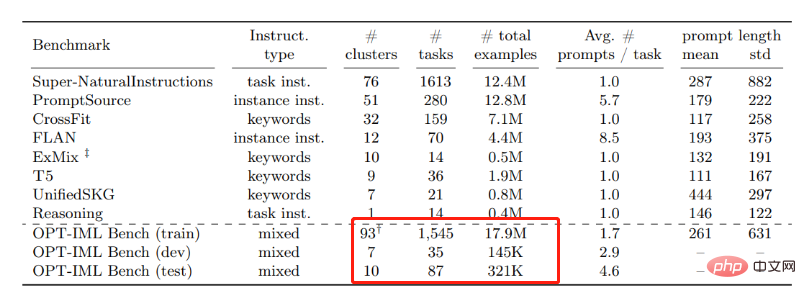

이를 위해 그들은 8개의 기존 벤치마크를 기반으로 작업 범주로 분류된 2000개의 NLP 작업을 포함하는 상당히 큰 교육용 메타 학습(IML) 벤치마크인 OPT-IML Bench를 개발했습니다.

OPT-IML 30B 및 175B를 교육하기 위해 연구원들은 먼저 이 프레임워크의 관점에서 OPT-30B에 적용되는 명령 조정 결정에 대한 통찰력을 제공했습니다.

다양한 대상과 입력 형식을 사용하는 4가지 평가 벤치마크(PromptSource, FLAN, Super-NaturalInstructions 및 UnifiedSKG)에서 OPT-IML은 두 가지 규모로 세 가지 일반화 기술을 모두 보여줍니다.

모든 벤치마크에서 OPT를 크게 능가할 뿐만 아니라 매우 경쟁력 있는 방식으로 이 특정 벤치마크에 최적화된 기존 모델보다 성능이 뛰어납니다.

이외에 OPT-IML은 오픈소스로 되어 있고 Github 링크도 아래에 올려두었어요~

Github 링크: https://github.com/facebookresearch/metaseq/tree/main /projects/ OPT-IML

다음으로, 논문을 통해 OPT-IML에 대해 알아보겠습니다.

문서 링크: https://github.com/facebookresearch/metaseq/blob/main/projects/OPT-IML/optimal_paper_v1.pdf

연구 방법

대규모 언어 모델에 대한 지침 미세 조정은 제로 샷 및 소수 샷 일반화 기능을 향상시키는 효과적인 방법이 되었습니다. 이 연구에서 Meta 연구자들은 교육 미세 조정에 세 가지 중요한 추가 사항을 추가했습니다.

먼저 작업 유형별로 분류된 8개 데이터 세트 컬렉션에서 2,000개의 NLP 작업이 포함된 대규모 명령 미세 조정 벤치마크를 컴파일했습니다.

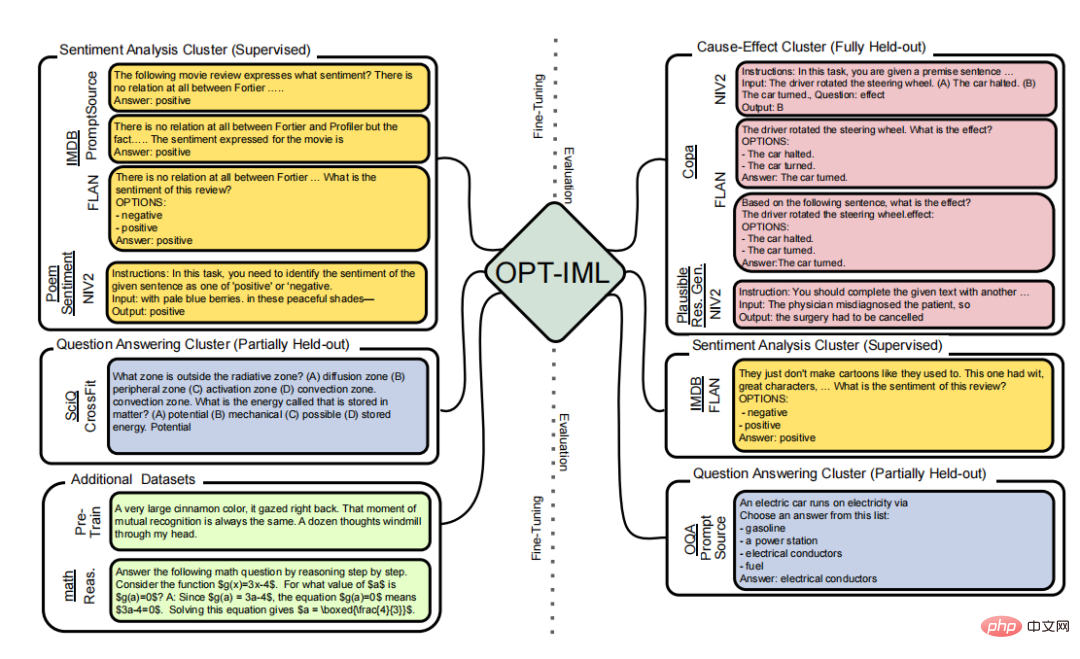

연구원들은 이 벤치마크에서 선택적으로 평가 분할을 구축하여 세 가지 유형의 모델 일반화 기능을 테스트합니다.

완전히 보류된 카테고리의 작업, 표시된 유형의 보류된 작업 및 표시된 작업의 보류된 인스턴스가 포함됩니다.

명령 미세 조정

모델을 준수 지침과 일치하도록 미세 조정하는 것은 기계 학습의 현재 연구 방향 중 하나입니다.

명령어 미세 조정에는 두 가지 방법이 있습니다. 하나는 사람이 주석을 추가한 지침과 피드백을 사용하여 다양한 작업에 대한 모델을 미세 조정하는 데 중점을 두고, 다른 하나는 주석을 통해 또는 공개적으로 액세스할 수 있는 벤치마크 및 데이터 세트에 자동으로 지침을 추가하는 데 중점을 둡니다.

이 연구에서 Meta AI 구성원은 두 번째 기술에 중점을 두고 OPT 개선 방법이 포함된 공개적으로 액세스 가능한 여러 데이터 세트를 편집했습니다.

연구 중에 Meta 회원들은 4개의 벤치마크에서 1836개의 작업을 사용하여 유사한 스케일링 방법을 제안했습니다. 마지막으로, 연구원들은 MMLU 및 BBH(Big-Bench Hard)와 같은 까다로운 외부 벤치마크의 성능 한계를 뛰어넘기 위해 전체 테스트를 조정하면서 다운스트림 성능에 영향을 미칠 수 있는 다양한 명령 조정 전략의 가중치를 설명합니다.

다중 작업 학습

다중 작업 학습은 MTL(교수 기반 미세 조정)의 표현입니다.

MTL은 비교 가능한 매개변수 또는 표현을 공유하는 유사한 기능과 결합될 때 작업의 일반화 성능을 향상시킬 수 있는 인기 있는 패러다임입니다.

최근 몇 년 동안 MTL은 관련 활동의 신호를 활용하여 교육 작업 또는 새로운 도메인의 성능을 향상시키는 데 주로 초점을 맞춘 수많은 NLP 시나리오에 적용되었습니다.

반대로, 명령 기반 미세 조정은 이전에 볼 수 없었던 문제에 대한 일반화 성능을 향상시키는 데 도움이 됩니다. 모든 작업을 하나의 개념으로 결합하고 모든 작업에 모델의 가중치를 할당하여 함께 훈련하도록 지시함으로써 이를 수행합니다.

OPT란 무엇인가요?

대규모 언어 모델, 1000억 개가 넘는 매개변수를 갖춘 자연어 처리 시스템은 지난 몇 년 동안 NLP 및 AI 연구를 변화시켰습니다.

다양한 텍스트를 학습한 이 모델은 창의적인 텍스트를 생성하고, 기본 수학 문제를 해결하고, 독해 문제에 답하는 등의 놀라운 새로운 능력을 보여주었습니다.

어떤 경우에는 대중이 유료 API를 통해 이러한 모델과 상호 작용할 수 있지만, 전체 연구 액세스는 여전히 리소스가 풍부한 소수의 실험실로 제한됩니다.

이러한 제한된 액세스로 인해 이러한 대규모 언어 모델이 작동하는 방식과 이유를 이해하는 연구자의 능력이 제한되어 견고성을 개선하고 편견과 같은 알려진 문제를 완화하기 위한 진행이 방해됩니다.

Meta AI는 개방형 과학에 대한 헌신의 일환으로 올해 5월 공개 데이터세트에서 훈련된 1,750억 개의 매개변수를 갖춘 모델인 Open Pretrained Transformer(OPT-175B)를 출시했습니다. 대형 모델에 대한 기본 기술을 이해하는 더 넓은 커뮤니티.

간단히 말하면 Meta는 인공지능 연구에 사용되는 대규모 언어 모델에 대한 접근권을 대중에게 공개함으로써 대규모 모델 연구를 위한 인공지능을 민주화합니다.

이전 버전과의 비교

현재 Meta에서 출시한 IML 버전에 따르면 이전 버전의 OPT보다 미세 조정되었으며 자연어 작업에서 더 나은 성능을 발휘합니다.

일반적인 언어 작업에는 질문에 답하기, 텍스트 요약하기, 번역하기 등이 있습니다.

미세 조정을 위해 연구원들은 약 2,000개의 자연어 작업을 사용했습니다. 작업은 8개의 NLP 벤치마크(OPT-IML Bench)로 나누어져 있으며, 이 벤치마크도 연구원이 제공합니다.

평균적으로 30B와 175B 모델을 예로 들면 OPT-IML은 OPT에 비해 제로샷 학습 정확도를 약 6~7% 향상시킵니다. 32 epoch에서는 300억 개의 매개변수를 가진 모델은 정확도가 크게 향상되었으며, 1,750억 개의 매개변수를 가진 모델은 약간의 개선을 보였습니다.

Meta 팀은 비교 결과 모든 벤치마크에서 OPT-IML의 성능이 OPT보다 우수하고, 제로샷 및 퓨샷 측면에서 다른 명령어 미세 조정 기반 모델보다 경쟁력이 있다는 것을 확인했습니다. 학습 정확도.

위 내용은 수천억 개의 매개변수를 가진 Meta의 대형 모델인 OPT-IML의 '업그레이드 버전'이 출시되었으며, 완전한 모델과 코드가 공개되었습니다!의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!