ChatGPT가 갑자기 왜 그렇게 강력해졌나요? 중국 의사의 10,000 단어에 달하는 긴 기사는 GPT-3.5 기능의 기원을 깊이 분석합니다.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB앞으로

- 2023-04-11 21:37:041737검색

OpenAI가 최근 출시한 ChatGPT는 인공지능 분야에 한 발 더 다가섰습니다. 그 강력한 기능은 언어 처리 연구자들의 기대를 훨씬 뛰어넘습니다.

ChatGPT를 경험한 사용자라면 자연스럽게 다음과 같은 질문을 하게 될 것입니다. 원래 GPT 3가 어떻게 ChatGPT로 발전했나요? GPT 3.5의 놀라운 언어 기능은 어디서 오는 걸까요?

최근 Allen Institute for Artificial Intelligence의 연구원들은 ChatGPT의 Emergent Ability를 분석하고 이러한 기능의 출처를 추적하여 포괄적인 기술을 제공하려는 기사를 작성했습니다. 로드맵은 GPT-3.5 모델이 어떻게 작동하는지 보여줍니다. 시리즈 및 관련 대규모 언어 모델은 현재의 강력한 형태로 단계적으로 발전했습니다.

원본 링크: https://yaofu.notion.site/GPT-3-5-360081d91ec245f29029d37b54573756

저자 FU尧 에딘버러 대학교 박사과정 합격자인가요? 그는 2020년에 컬럼비아 대학교에서 석사 학위를, 베이징 대학교에서 학사 학위를 취득했으며 현재 Allen Institute for Artificial Intelligence에서 연구 인턴으로 일하고 있습니다. 그의 주요 연구 방향은 인간 언어의 대규모 확률 생성 모델입니다.

저자 Peng Hao는 워싱턴 대학교에서 학사 및 박사 학위를 취득했으며 현재 Allen Institute for Artificial Intelligence에서 젊은 연구원으로 재직하고 있으며 컴퓨터학과에 합류할 예정입니다. 2023년 8월 일리노이대학교 어바나-샴페인 캠퍼스 과학과 조교수로 재직. 그의 주요 연구 관심분야는 언어 AI를 더욱 효율적이고 이해하기 쉽게 만드는 것과 대규모 언어 모델을 구축하는 것입니다.

저자 Tushar KhotPh.D.는 University of Wisconsin-Madison을 졸업하고 현재 Allen Institute for Artificial Intelligence의 연구 과학자입니다. 그의 주요 연구 방향은 구조화된 기계 추론이다.

1. 1세대 GPT-3의 2020 버전 및 대규모 사전 훈련

1세대 GPT-3은 세 가지 중요한 기능을 시연했습니다.

- 언어 생성: 프롬프트 단어( 프롬프트), 모든 프롬프트 단어로 보완 문장을 생성합니다. 이는 오늘날 인간이 언어 모델과 상호 작용하는 가장 일반적인 방식이기도 합니다.

- 상황에 맞는 학습: 주어진 작업의 몇 가지 예를 따른 다음 새로운 테스트 사례에 대한 솔루션을 생성하세요. 매우 중요한 점은 GPT-3가 언어 모델이지만 해당 논문에서는 "언어 모델링"에 대해 거의 언급하지 않는다는 것입니다. 저자는 상황별 학습 비전에 모든 글쓰기 에너지를 쏟았습니다. 이것이 GPT-3의 진정한 초점입니다.

- 세계지식: 사실적 지식(사실적 지식)과 상식(상식)을 포함합니다.

그럼 이러한 능력은 어디서 나오는 걸까요?

기본적으로 위의 세 가지 기능은 대규모 사전 학습에서 나옵니다. 즉, 3,000억 단어의 모음에서 1,750억 개의 매개변수가 있는 모델을 사전 학습합니다(훈련 모음의 60%는 2016년부터 C4+22에서 나옵니다. 2019년 WebText2의 % + 도서의 16% + Wikipedia의 3%). 그중에는:

- 언어 생성 능력은 언어 모델링(Language Modeling)이라는 훈련 목표에서 비롯됩니다.

- 세계 지식은 3천억 단어로 구성된 훈련 자료에서 나옵니다(다른 곳에서는 가능).

- 모델의 1,750억 매개변수는 지식을 저장하기 위한 것이며, 이는 Liang et al.(2022)의 기사에서 더욱 입증되었습니다. 그들은 지식 집약적 작업의 성능이 모델 크기와 밀접한 관련이 있다는 결론을 내렸습니다.

- 상황별 학습 기능의 출처와 상황별 학습이 일반화될 수 있는 이유는 여전히 추적하기 어렵습니다. 직관적으로 이 기능은 훈련 중에 동일한 배치에 순차적으로 배열된 동일한 작업의 데이터 포인트에서 나올 수 있습니다. 그러나 언어 모델 사전 훈련이 상황별 학습을 촉진하는 이유와 상황별 학습이 미세 조정과 다르게 동작하는 이유에 대한 연구는 거의 이루어지지 않았습니다.

궁금한 것은 1세대 GPT-3가 얼마나 강력한지입니다.

사실 원본 GPT-3(OpenAI API에서는 davinci라고 함)가 "강함"인지 "약함"인지 판단하기 어렵습니다.

일부 특정 쿼리에 합리적으로 응답하고 많은 데이터 세트에서 적절한 성능을 달성합니다.

다른 한편으로는 많은 작업에서 T5만큼 성능이 좋지 않습니다. 작은 모델(원본 참조) 종이).

현재(2022년 12월) ChatGPT 표준에서는 원본 GPT-3가 "스마트"하다고 말하기 어렵습니다. Meta의 오픈 소스 OPT 모델은 원래 GPT-3를 복제하려고 시도하지만 그 기능은 오늘날의 표준과 뚜렷한 대조를 이룹니다. OPT를 테스트한 많은 사람들은 현재 text-davinci-002와 비교하여 모델이 실제로 "그렇게 좋지 않다"고 믿습니다.

그럼에도 불구하고 OPT는 원본 GPT-3에 대한 충분히 좋은 오픈 소스 근사치일 수 있습니다(OPT 논문 및 스탠포드 대학의 HELM 평가에 따르면).

1세대 GPT-3는 표면적으로 약해 보일 수 있지만 후속 실험에서는 1세대 GPT-3가 매우 강력한 잠재력을 가지고 있음이 입증되었습니다. 이러한 잠재력은 나중에 코드 훈련, 명령 조정 및 인간 피드백을 통한 강화 학습(RLHF)을 통해 잠금 해제되었으며 최종 본체는 매우 강력한 창발 기능을 보여주었습니다.

2 2020년 버전의 GPT-3부터 2022년 버전의 ChatGPT까지

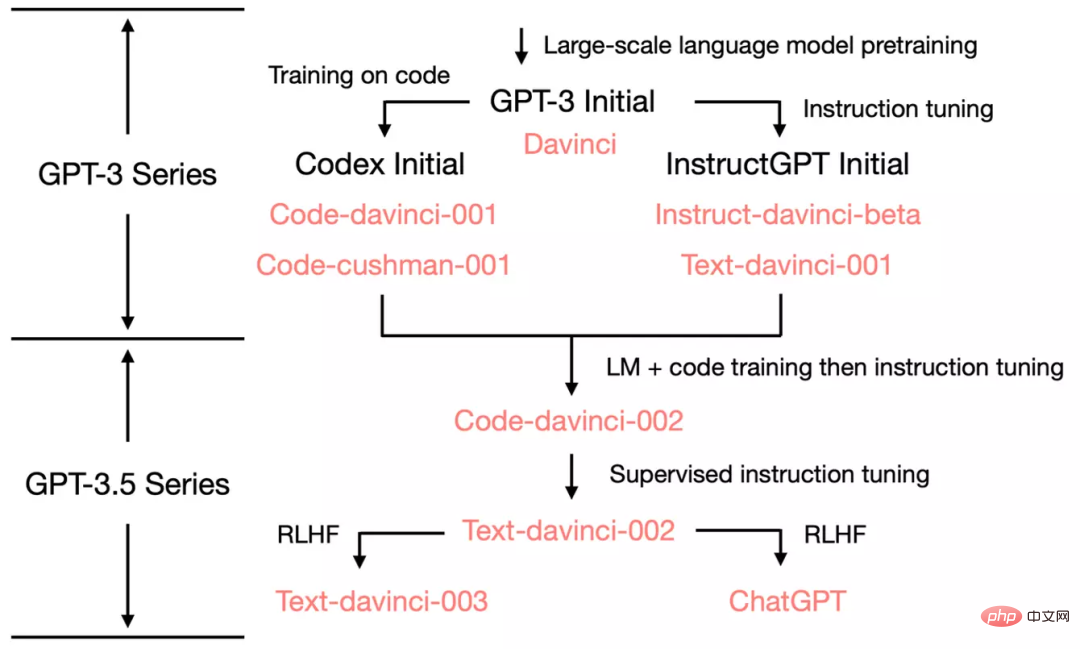

원본 GPT-3을 시작으로 OpenAI가 ChatGPT로 어떻게 발전했는지 보여드리기 위해 GPT의 진화계통을 살펴보겠습니다. -3.5:

2020년 7월 OpenAI는 모델 인덱스가 포함된 davinci의 원본 GPT-3 논문을 출시했으며 이후 계속해서 발전해 왔습니다.

2021년 7월 Codex 논문이 공개되었습니다. 여기서 초기 Codex는 (아마도 내부) 120억 매개변수 GPT-3 변형을 기반으로 미세 조정되었습니다. 이 120억 개의 매개변수 모델은 나중에 OpenAI API에서 code-cushman-001로 발전했습니다.

2022년 3월 OpenAI는 명령어 튜닝에 관한 논문을 발표했는데, 감독 명령어 튜닝 부분은 davinci-instruct-beta 및 text-davinci-001에 해당합니다.

2022년 4월부터 7월까지 OpenAI는 Codex라고도 불리는 code-davinci-002 모델의 베타 테스트를 시작했습니다. 그런 다음 code-davinci-002, text-davinci-003 및 ChatGPT는 모두 code-davinci-002의 지침을 미세 조정하여 얻습니다. 자세한 내용은 OpenAI의 모델 인덱스 문서를 참조하세요.

Codex가 코드 전용 모델처럼 들리지만 code-davinci-002는 아마도 자연어에 대한 가장 강력한 GPT-3.5 변형일 것입니다(text-davinci-002 및 -003보다 우수함). code-davinci-002는 텍스트와 코드 모두에 대해 교육을 받은 다음 지침(아래 설명)에 따라 조정되었을 가능성이 높습니다.

그러면 2022년 5월~6월에 출시되는 text-davinci-002는 code-davinci-002를 기반으로 한 지도 학습 튜닝 모델입니다. text-davinci-002에 대한 지침을 미세 조정하면 모델의 상황별 학습 능력이 감소할 수 있지만 모델의 제로샷 능력은 향상됩니다(아래에 설명됨).

그리고 2022년 11월에 출시된 text-davinci-003과 ChatGPT가 있는데, 이는 인간의 신체 피드백을 통해 강화 학습을 통해 지침 조정을 사용하는 모델의 두 가지 변형입니다.

text-davinci-003은 text-davinci-002에서 손실된 상황별 학습 기능 중 일부를 복원합니다(그러나 code-davinci-002보다 여전히 나쁩니다)(아마도 미세 조정 중에 언어 모델링에 혼합되었기 때문일 것입니다). 향상된 제로 샘플 기능(RLHF 덕분에) 반면 ChatGPT는 대화 기록을 모델링하는 기능을 위해 거의 모든 상황 학습 기능을 희생하는 것으로 보입니다.

일반적으로 code-davinci-002 이전인 2020~2021년 동안 OpenAI는 코드 교육 및 명령어 미세 조정을 통해 GPT-3을 향상시키는 데 많은 노력을 기울였습니다. code-davinci-002를 완성할 때쯤에는 이미 모든 기능이 갖춰져 있었습니다. 지도 버전이든 강화 학습 버전이든 후속 명령 미세 조정은 다음을 수행할 가능성이 높습니다(나중에 자세히 설명).

- 명령 미세 조정은 모델에 새로운 기능을 주입하지 않습니다. 모든 기능이 이미 존재합니다. 명령 넛지의 역할은 이러한 능력을 잠금 해제/활성화하는 것입니다. 이는 주로 명령 미세 조정을 위한 데이터 양이 사전 훈련 데이터 양보다 몇 배 더 작기 때문입니다(기본 기능은 사전 훈련을 통해 주입됨).

- 명령 미세 조정을 통해 GPT-3.5를 다양한 스킬 트리로 차별화합니다. text-davinci-003과 같은 일부는 상황별 학습에 더 뛰어나고 일부는 ChatGPT와 같은 대화에 더 좋습니다.

-

명령을 미세 조정하면 인간과의 정렬을 위해 성능이 희생됩니다. OpenAI의 저자는 지침 미세 조정 논문에서 이를 "정렬 세금"이라고 부릅니다.

많은 논문에서는 code-davinci-002가 벤치마크에서 최고의 성능을 달성했다고 보고합니다(그러나 모델이 반드시 인간의 기대와 일치하지는 않습니다). code-davinci-002에 대한 지침을 미세 조정한 후 모델은 제로 샘플 질문 및 답변, 안전하고 공정한 대화 생성과 같이 인간의 기대에 더 부합하는(또는 모델이 인간과 일치하는) 피드백을 생성할 수 있습니다. 모델의 지식 범위를 넘어서는 응답 및 거부 문제입니다.

3개, Code-Davinci-002와 Text-Davinci-002, 코드에 대해 훈련을 받고 지침에 따라 미세 조정

code-davinci-002와 text-davinci-002 이전에는 두 가지 중간 모델이 있었습니다. , 각각 davinci-instruct-beta 및 text-davinci-001입니다. 둘 다 여러 측면에서 위에서 언급한 two-002 모델보다 나쁩니다(예를 들어 text-davinci-001의 연쇄 사고 추론 능력이 강하지 않습니다).

그래서 이 섹션에서는 -002 모델에 중점을 둡니다.

3.1 복잡한 추론 능력의 원천이자 새로운 작업으로 일반화하는 능력

우리는 code-davinci-002와 text-davinci-002에 중점을 두고 있는데, 이 두 형제는 GPT3.5 모델의 첫 번째 버전이며, 하나는 코드용이고 다른 하나는 텍스트용입니다. 원본 GPT-3과 다른 세 가지 중요한 기능을 보여줍니다.

- 인간 지시에 응답: 이전에는 GPT-3의 출력이 주로 훈련 세트의 일반적인 문장에 중점을 두었습니다. 이제 모델은 지침/단서에 대해 (관련이 있지만 쓸모없는 문장이 아닌) 더 합리적인 답변을 생성합니다.

- 보이지 않는 작업에 대한 일반화: 모델을 조정하는 데 사용되는 지침의 수가 특정 규모를 초과하면 모델은 이전에 본 적이 없는 새로운 지침에 대해 자동으로 효과적인 답변을 생성할 수 있습니다. 사용자는 항상 새로운 질문을 하고 모델은 이에 답할 수 있어야 하기 때문에 이 기능은 온라인 배포에 매우 중요합니다.

- 코드 생성 및 코드 이해: 모델이 코드로 훈련되었기 때문에 이 능력은 분명합니다.

- 복잡한 추론을 위해 사고 사슬 사용: 원래 GPT3 모델의 사고 사슬 추론 기능은 약하거나 심지어 존재하지도 않았습니다. code-davinci-002 및 text-davinci-002는 충분히 강력한 사고 연쇄 추론 기능을 갖춘 두 가지 모델입니다.

- 사고 사슬이 창발적 역량을 발휘하고 확장 법칙을 초월하는 열쇠가 될 수 있기 때문에 사고 사슬 추론이 중요합니다.

이러한 능력은 어디서 오는 걸까요?

이전 모델과 비교했을 때, 두 가지 주요 차이점은 지침 미세 조정과 코드 교육입니다. 구체적으로:

- 인간의 명령에 응답하는 능력은 명령 미세 조정의 직접적인 산물입니다.

- 눈에 보이지 않는 지시에 응답하는 일반화 능력은 지시의 수가 일정 수준을 초과하면 자동으로 나타나며, T0, Flan 및 FlanPaLM 논문이 이를 더욱 증명합니다.

- 복잡한 추론을 위해 사고 사슬을 사용하는 능력은 코딩 교육의 마법 같은 부산물일 수도 있습니다. 이를 위해 다음과 같은 사실을 지원합니다.

- 원본 GPT-3은 코딩 교육을 받지 않았으며 사고 연결을 수행할 수 없었습니다.

- text-davinci-001 모델은 지침에 따라 미세 조정되었지만 사고 체인의 첫 번째 버전에서는 다른 사고 체인에 대해 추론하는 능력이 매우 약하다고 보고하므로 지침 미세 조정이 되지 않을 수 있습니다. 모델이 사고 사슬 추론을 수행할 수 있는 가장 가능성 있는 이유는 코드 훈련입니다.

- PaLM은 5%의 코드 훈련 데이터를 보유하고 있으며 사고 연결이 가능합니다.

- Codex 논문의 코드 데이터 양은 159G로, 원본 GPT-3의 훈련 데이터 5,700억 개 중 약 28%에 해당합니다. code-davinci-002와 그 후속 변종은 일련의 사고 추론을 수행할 수 있습니다.

- HELM 테스트에서 Liang et al.(2022)은 다양한 모델에 대한 대규모 평가를 수행했습니다. 그들은 코드에 대해 훈련된 모델이 120억 개의 매개변수 code-cushman-001을 포함하여 강력한 언어 추론 기능을 가지고 있음을 발견했습니다.

- AI2에 대한 우리의 작업은 또한 복잡한 사고 체인을 갖춘 경우 code-davinci-002가 현재 GSM8K와 같은 중요한 수학적 벤치마크에서 가장 성능이 좋은 모델임을 보여줍니다.

- 직관적으로 절차지향 프로그래밍은 인간이 작업을 단계별로 해결하는 과정과 매우 유사하며, 객체지향 프로그래밍은 인간이 복잡한 작업을 여러 개의 간단한 작업으로 분해하는 과정과 매우 유사합니다.

- 위의 모든 관찰은 코드와 추론 능력/사고 사슬 간의 상관 관계이지만 반드시 인과 관계는 아닙니다. 이 상관 관계는 흥미롭지만 현재 연구해야 할 공개 질문입니다. 현재로서는 코드가 사고 사슬과 복잡한 추론의 원인이라는 결정적인 증거가 없습니다.

- 또한 Peter Liu가 지적한 것처럼 코드 훈련의 또 다른 가능한 부산물은 장거리 종속성입니다. "언어의 다음 단어 예측은 일반적으로 매우 지역적이며 코드는 일반적으로 다음과 같은 작업을 수행하기 위해 더 긴 종속성이 필요합니다. 전면 및 후면 브래킷을 일치시키거나 원격 기능 정의를 참조합니다." 여기에 더 추가하고 싶은 점은 객체 지향 프로그래밍의 클래스 상속으로 인해 코드가 코딩 계층 구조를 설정하는 모델의 기능에도 기여할 수 있다는 것입니다. 이 가설에 대한 테스트는 향후 작업에 맡깁니다.

또한 세부 사항의 일부 차이점에 주의하세요:

- text-davinci-002 및 code-davinci-002

- Code-davinci-002는 기본 모델이고, text-davinci-002는 미세 조정 명령 코드-davinci-002의 제품입니다. (OpenAI 문서 참조) 이는 다음 데이터에 따라 미세 조정됩니다. (1) 사람이 주석을 추가한 지침 및 예상 출력, (2) 사람이 주석을 추가한 모델 출력.

- 컨텍스트 내 예제가 있는 경우 Code-davinci-002가 컨텍스트 학습에 더 좋고, 컨텍스트 예제/제로 샘플이 없으면 text-davinci-002가 제로 샘플 작업 완료에서 더 잘 수행됩니다. 이러한 의미에서 text-davinci-002는 인간의 기대에 더 부합합니다(작업에 대한 상황별 예제를 작성하는 것이 번거로울 수 있기 때문).

- OpenAI가 제로 샘플 기능 대신 상황별 학습 능력을 의도적으로 희생했을 가능성은 없습니다. 상황별 학습 능력의 감소는 OpenAI가 이를 정렬 세금이라고 부릅니다.

- 001 모델(code-cushman-001 및 text-davinci-001) v.s. 002 모델(code-davinci-002 및 text-davinci-002)

- 001 모델은 주로 순수 코드/순수 텍스트 작업을 수행합니다. 002 모델은 코드 교육 및 명령 미세 조정을 깊이 통합하며 코드와 텍스트를 모두 사용할 수 있습니다.

- Code-davinci-002는 코드 교육과 명령어 미세 조정을 깊이 통합한 최초의 모델일 수 있습니다. 증거는 다음과 같습니다: code-cushman-001은 추론을 수행할 수 있지만 일반 텍스트에서는 잘 수행되지 않습니다. text-davinci-001은 일반 텍스트에서는 잘 수행되지만 추론에서는 좋지 않습니다. code-davinci-002는 두 가지를 동시에 수행할 수 있습니다.

3.2 이러한 기능은 사전 훈련 후에 이미 존재합니까, 아니면 나중에 미세 조정을 통해 주입됩니까?

이 단계에서 우리는 교육 미세 조정 및 코드 교육의 핵심 역할을 확인했습니다. 중요한 질문은 코드 훈련 및 지침 미세 조정의 영향을 추가로 분석하는 방법입니다.

구체적으로: 위의 세 가지 능력은 이미 원래 GPT-3에 존재하며 지침과 코드 훈련을 통해서만 트리거/잠금 해제됩니까? 아니면 원래 GPT-3에는 이러한 기능이 없지만 지침과 코드 교육을 통해 주입되었습니까?

답변이 이미 원본 GPT-3에 있는 경우 이러한 기능도 OPT에 있어야 합니다. 따라서 이러한 기능을 재현하려면 지침과 코드를 통해 OPT를 직접 조정하는 것이 가능할 수도 있습니다.

단, code-davinci-002는 원본 GPT-3 다빈치를 기반으로 한 것이 아니라 원본 GPT-3보다 더 큰 모델에 기반했을 수 있습니다. 이런 경우 OPT를 조정해서 재현할 수 있는 방법이 없을 수도 있습니다.

연구 커뮤니티는 code-davinci-002의 기본 모델로 훈련된 OpenAI가 어떤 모델인지 더 명확히 해야 합니다.

다음과 같은 가설과 증거가 있습니다.

- code-davinci-002의 기본 모델은 1세대 GPT-3 다빈치 모델이 아닐 수도 있습니다.

- 1세대 GPT-3은 데이터 세트 C4 2016~2019에서 훈련되었으며, code-davinci-002 훈련 세트는 2021년까지 확장되었습니다. 따라서 code-davinci-002가 C4 2019-2021 버전에서 학습되었을 가능성이 있습니다.

- 원래 GPT-3에는 2048 단어의 컨텍스트 창이 있었습니다. code-davinci-002의 컨텍스트 창은 8192입니다. GPT 시리즈는 절대 위치 임베딩을 사용합니다. 훈련 없이 절대 위치 임베딩을 직접 외삽하는 것은 어렵고 모델 성능을 심각하게 손상시킵니다(Press et al., 2022 참조). code-davinci-002가 원본 GPT-3을 기반으로 하는 경우 OpenAI는 어떻게 컨텍스트 창을 확장합니까?

- 반면에 기본 모델이 원본 GPT-3이든 나중에 훈련된 모델이든 지침을 따르고 제로 샷 일반화하는 기능이 기본 모델에 이미 존재하고 미세 조정될 수 있습니다. 나중에 지침을 통해 잠금을 해제합니다(주입하지 않음).

- 이는 주로 OpenAI 논문에 보고된 명령 데이터의 크기가 77K에 불과하기 때문입니다. 이는 사전 훈련 데이터보다 몇 배 작은 크기입니다.

- 다른 지침 미세 조정 논문에서는 모델 성능에 대한 데이터 세트 크기의 대조를 추가로 보여줍니다. 예를 들어 Chung et al.(2022)의 연구에서 Flan-PaLM의 명령 미세 조정은 0.4%에 불과합니다. 사전 훈련 계산. 일반적으로 말하면 명령 데이터는 사전 훈련 데이터보다 훨씬 적습니다.

- 그러나 모델의 복잡한 추론 기능은 사전 학습 단계에서 코드 데이터 주입을 통해 이루어질 수 있습니다.

- 코드 데이터 세트의 크기는 위의 명령어 미세 조정 사례와 다릅니다. 여기서 코드 데이터의 양은 훈련 데이터의 상당 부분을 차지할 만큼 큽니다(예를 들어 PaLM은 코드 훈련 데이터의 8%를 차지합니다)

- 위에서 언급했듯이 코드 이전의 모델 text-davinci-001- davinci-002는 코드 데이터에 대한 미세 조정이 이루어지지 않아 추론/사고 체인 능력이 매우 열악합니다. Think Chain 논문의 첫 번째 버전에서 보고된 것처럼 때로는 code-cushman보다 더 나쁩니다. 001보다 적은 수의 매개변수를 사용합니다.

- 아마도 코드 훈련과 명령 미세 조정의 효과를 구별하는 가장 좋은 방법은 code-cushman-001, T5 및 FlanT5를 비교하는 것입니다.

- 모델 크기(110억과 120억)가 비슷하고 훈련 데이터 세트(C4)가 비슷하기 때문에 이들 사이의 가장 큰 차이점은 코드에 대한 훈련을 받았는지 여부/지침을 잘 수행했는지 여부입니다. -튜닝.

- 아직 그런 비교는 없습니다. 우리는 이것을 향후 연구에 맡깁니다.

4. text-davinci-003과 ChatGPT, RLHF(Reinforcement Learning from Human Feedback)의 힘

현재 단계(2022년 12월)에서는 text-davinci-002 사이에 엄격한 통계적 비교가 거의 없습니다. text-davinci-003 및 ChatGPT, 주로 그 이유:

- text-davinci-003 및 ChatGPT는 이 글을 쓰는 시점에서 한 달도 채 되지 않아 출시되었습니다.

- ChatGPT는 OpenAI API를 통해 호출할 수 없으므로 표준 벤치마크에서 테스트하는 것은 번거롭습니다.

따라서 이러한 모델 간의 비교는 연구 커뮤니티의 집단적 경험을 기반으로 합니다(통계적으로 그다지 엄격하지는 않음). 그러나 우리는 예비적인 설명적 비교가 여전히 모델의 메커니즘을 밝힐 수 있다고 믿습니다.

먼저 text-davinci-002, text-davinci-003 및 ChatGPT를 비교하면 다음과 같습니다.

- 세 모델 모두 지침에 따라 미세 조정되었습니다.

- text-davinci-002는 Supervised Instruction Tuning으로 미세조정된 모델입니다.

- text-davinci-003 및 ChatGPT는 인간 피드백 RLHF의 강화 학습을 사용한 지침 조정입니다. 이것이 그들 사이의 가장 중요한 차이점입니다.

이는 대부분의 새 모델의 동작이 RLHF의 인공물이라는 것을 의미합니다.

그러면 RLHF 트리거의 기능을 살펴보겠습니다.

- 정보 제공 응답: text-davinci-003은 일반적으로 text-davinci-002보다 생성하는 데 시간이 더 오래 걸립니다. ChatGPT의 응답은 더 길기 때문에 사용자는 보다 간결한 답변을 얻으려면 "한 문장으로 답변해 주세요"라고 명시적으로 질문해야 합니다. 이는 RLHF의 직접적인 파생물입니다.

- 공정한 응답: ChatGPT는 일반적으로 정치 행사와 같이 여러 주체의 이익이 관련된 이벤트에 대해 매우 균형 잡힌 답변을 제공합니다. 이것도 RLHF의 제품입니다.

- 부적절한 문제 거부: 이것은 RLHF에 의해 촉발된 콘텐츠 필터와 모델 자체 기능의 조합으로, 필터가 일부를 필터링한 다음 모델이 일부를 거부합니다.

- 알 수 없는 질문 거부: 예를 들어 2021년 6월 이후에 발생한 새로운 이벤트를 거부합니다(그 이후에는 데이터에 대한 교육을 받지 않았기 때문입니다). 이는 모델이 지식 내에 있는 문제와 그렇지 않은 문제를 암묵적으로 구별할 수 있게 해주기 때문에 RLHF의 가장 놀라운 부분입니다.

주목할 만한 두 가지 사항이 있습니다.

- 모든 기능은 RLHF를 통해 주입되는 것이 아니라 모델에 내재되어 있습니다. RLHF가 하는 일은 응급 능력을 발동/잠금 해제하는 것입니다. 이 주장은 주로 데이터 크기의 비교에서 비롯됩니다. 사전 훈련된 데이터의 양에 비해 RLHF는 훨씬 적은 컴퓨팅 성능/데이터를 차지합니다.

- 모델은 규칙을 작성하는 것이 아니라 RLHF를 통해 잠금을 해제하여 자신이 모르는 것을 알고 있습니다. RLHF의 원래 목표는 모델이 인간의 기대를 혼합하는 반응을 생성하도록 하는 것이었기 때문에 이는 매우 놀라운 발견입니다. 이는 모델이 알지 못했던 것을 알려주는 것보다 모델이 안전한 문장을 생성하도록 하는 것에 더 가깝습니다.

뒤에서 벌어지고 있는 일은 다음과 같습니다:

- ChatGPT: 대화 기록을 모델링하는 능력을 대신하여 맥락을 학습하는 능력을 희생합니다. 이는 경험적 관찰입니다. ChatGPT는 text-davinci-003만큼 문맥 표시에 크게 영향을 받지 않는 것으로 보입니다.

- text-davinci-003: text-davinci-002에 의해 희생된 컨텍스트 학습 능력을 복원하고 제로 샘플 능력을 향상시킵니다. instructGPT 논문에 따르면 이는 (RLHF 자체가 아닌) 언어 모델링의 목표와 혼합된 강화 학습 조정 단계에서 비롯됩니다.

5. 현재 단계의 GPT-3.5 진화 과정 요약

지금까지 진화 트리를 따라 나타난 모든 기능을 주의 깊게 살펴보았습니다.

결론:

- 언어 생성 능력 + 기본 세계 지식 + 상황 학습은 모두 사전 훈련(다빈치)에서 나옵니다.

- 대량의 지식을 저장할 수 있는 능력은 1,750억 개의 매개변수에서 나옵니다.

- 지시를 따르고 새로운 과제에 일반화하는 능력은 교수 학습(Davinci-instruct-beta)의 지시 수를 확장하는 데서 비롯됩니다.

- 복잡한 추론을 수행하는 능력은 코드 교육(code-davinci-002)에서 나올 가능성이 높습니다.

- 중립적이고 객관적이며 안전하고 유익한 답변을 생성하는 능력은 인간과의 일치에서 비롯됩니다. 구체적으로:

- 지도 학습 버전인 경우 결과 모델은 text-davinci-002입니다.

- 강화학습 버전(RLHF)이라면 획득한 모델은 text-davinci-003 입니다.

- Supervised든 RLHF든 모델의 성능은 많은 작업에서 code-davinci-002를 초과할 수 없습니다. 이러한 정렬로 인한 성능 저하 현상을 정렬 세금이라고 합니다.

- 대화 기능은 RLHF(ChatGPT)에서도 제공됩니다. 특히 다음과 같은 대가로 상황 학습 기능을 희생합니다.

- 대화 기록 모델링.

- 대화 정보량을 늘려보세요.

- 모델 지식 범위를 벗어나는 질문은 거부하세요.

6. 현재 GPT-3.5가 할 수 없는 것

GPT-3.5는 자연어 처리 연구의 중요한 단계이지만 AI2를 포함한 많은 연구자들이 구상하는 이상적인 속성을 모두 완전히 포함하지는 않습니다. GPT-3.5에는 없는 몇 가지 중요한 속성은 다음과 같습니다.

- 모델의 신념을 실시간으로 다시 작성: 모델이 어떤 것에 대한 신념을 표현할 때 그 신념이 잘못된 경우 이를 수정하는 데 어려움을 겪을 수 있습니다.

- 최근에 제가 접한 예는 다음과 같습니다. : ChatGPT는 3599 = 59 * 61임을 인정하지만 3599가 소수라고 주장합니다. 또한 가장 빠르게 수영하는 해양 포유류에 대한 Reddit의 예를 참조하세요.

- 그러나 모델적 신념의 강도에는 다양한 수준이 있는 것으로 보입니다. 한 가지 예는 다스베이더(스타워즈 영화 속 캐릭터)가 2020년 선거에서 승리했다고 말해도 모델은 여전히 현 미국 대통령이 바이든이라고 생각할 것이라는 점이다. 그런데 선거 연도를 2024년으로 바꾸면 대통령은 다스베이더이고 2026년 대통령은 되는 것 같아요.

- 형식 추론: GPT-3.5 시리즈는 수학이나 1차 논리와 같은 형식적으로 엄격한 시스템에서는 추론할 수 없습니다.

- 자연어 처리 문헌에서 "추론"이라는 단어는 정의가 불분명한 경우가 많습니다. 그러나 예를 들어 모호성의 관점에서 보면 일부 질문은 (a) 매우 모호하고 추론이 없습니다. (b) 약간의 논리가 있지만 일부에서는 모호할 수도 있습니다. c) 매우 엄격하며 어떤 모호함도 있어서는 안 됩니다.

- 그러면 모델은 모호하게 유형 (b) 추론을 잘 수행할 수 있습니다. 예는 다음과 같습니다.

- 두부 나오 만드는 방법을 생성합니다. 두부 퍼프를 만들 때 짠맛으로 할지 달게 할지 등 여러 단계에서 조금 모호해도 괜찮습니다. 전체적인 단계가 대략적으로 정확하면 두부 커드는 먹을 수 있습니다.

- 수학 정리 증명을 위한 아이디어. 증명 아이디어는 언어로 표현된 비공식적인 단계별 솔루션이며, 각 단계의 엄격한 파생은 너무 구체적일 필요가 없습니다. 증명 아이디어는 수학 교육에 자주 사용됩니다. 교사가 대략적으로 올바른 전체 단계를 제공하는 한 학생들은 대략적으로 이해할 수 있습니다. 그런 다음 교사는 학생들에게 구체적인 증명 세부 사항을 숙제로 할당하고 답은 생략합니다.

- GPT-3.5는 (c) 유형의 추론을 수행할 수 없습니다(추론은 모호함을 허용할 수 없음).

- 예를 들어 엄격한 수학적 증명을 사용하면 중간 단계를 건너뛰거나 흐리게 하거나 틀릴 수 없음을 요구합니다.

- 그러나 이러한 엄격한 추론을 언어 모델로 수행해야 하는지 아니면 기호 시스템으로 수행해야 하는지는 여전히 논의되어야 합니다. 한 가지 예는 GPT가 세 자리 덧셈을 수행하도록 하는 대신 Python을 호출하는 것입니다.

- 인터넷에서 검색: GPT-3.5 시리즈(일시적으로)는 인터넷에서 직접 검색할 수 없습니다.

- 하지만 GPT가 검색 엔진을 호출할 수 있도록 하는 WebGPT 논문이 2021년 12월에 출판되었습니다. 따라서 검색 기능은 OpenAI 내에서 테스트되었습니다.

- 여기서 구별해야 할 점은 GPT-3.5의 중요하지만 다른 두 가지 기능은 지식과 추론이라는 것입니다. 일반적으로 말하면, 지식 부분을 외부 검색 시스템으로 오프로드하고 언어 모델이 추론에만 집중할 수 있다면 좋을 것입니다. 왜냐하면:

- 모델의 내부 지식은 항상 어느 시점에서 끊어집니다. 모델에는 최신 질문에 답하기 위해 항상 최신 지식이 필요합니다.

- 1,750억 개의 매개변수가 지식을 저장하는 데 많이 사용된다는 점을 논의한 것을 기억하세요. 모델 외부로 지식을 오프로드할 수 있다면 모델 매개변수가 너무 많이 줄어들어 결국 휴대폰에서도 실행될 수 있습니다(미친 생각이지만 ChatGPT는 공상 과학에 가깝기 때문에 미래가 어떻게 될지는 누가 알겠습니까).

7. 결론

이 블로그 게시물에서 우리는 GPT-3.5 시리즈의 다양한 기능을 주의 깊게 조사하고 모든 새로운 기능의 소스를 추적했습니다.

1세대 GPT-3 모델은 사전 훈련을 통해 생성 능력, 세계 지식 및 상황 내 학습을 획득합니다. 그런 다음 명령 튜닝의 모델 분기를 통해 지침을 따르고 보이지 않는 작업으로 일반화하는 능력을 얻었습니다. 코드로 훈련된 분기 모델은 코드 훈련의 부산물로서 코드를 이해하는 능력을 얻습니다. 모델은 잠재적으로 복잡한 추론을 수행하는 능력도 얻습니다.

이 두 가지를 결합한 code-davinci-002는 모든 훌륭한 기능을 갖춘 가장 강력한 GPT-3.5 모델인 것 같습니다. 다음으로 지도 학습 튜닝과 RLHF를 통해 인간 정렬, 즉 정렬 세금을 대신하여 모델 기능이 희생됩니다. RLHF를 사용하면 모델이 지식 범위를 벗어나는 질문을 거부하면서 더 유익하고 편견 없는 답변을 생성할 수 있습니다.

이 기사가 GPT 평가에 대한 명확한 그림을 제공하고 언어 모델, 명령 조정 및 코드 조정에 대한 토론을 촉발하는 데 도움이 되기를 바랍니다. 가장 중요한 것은 이 기사가 오픈 소스 커뮤니티 내에서 GPT-3.5를 재현하기 위한 로드맵 역할을 할 수 있기를 바랍니다.

FAQ

- 이 글의 진술은 가설에 가깝나요 아니면 결론에 가깝나요?

- 복잡한 추론 능력은 코드 훈련에서 나온다는 것은 우리가 믿는 경향이 있는 가정입니다.

- 눈에 보이지 않는 작업으로 일반화하는 능력은 대규모 교육 학습에서 비롯된다는 것이 최소 4편의 논문의 결론입니다.

- GPT-3.5가 1,750억 매개변수의 GPT-3이 아닌 다른 대형 기본 모델에서 나온 것이라는 것은 교육받은 추측입니다.

- 이러한 모든 기능은 지도 학습이든 강화 학습이든 주입하는 것이 아니라 명령 조정을 통해 이미 존재합니다. 이는 감히 믿을 수 없을 만큼 강력한 가정입니다. 주로 명령 조정 데이터의 양이 사전 훈련 데이터의 양보다 몇 배나 적기 때문입니다.

- 결론 = 이러한 주장의 타당성을 뒷받침하는 많은 증거; 가설 = 긍정적인 증거이지만 충분히 강력하지 않음 = 확실한 증거는 없지만 일부 요인이 이 방향을 지적할 수 있음

- 모델이 다른 이유 (OPT 및 BLOOM과 같은) 그다지 강력하지 않습니까?

- OPT는 아마도 훈련 과정이 너무 불안정해서 그런 것 같아요.

- BLOOM의 상황은 알려지지 않았습니다.

위 내용은 ChatGPT가 갑자기 왜 그렇게 강력해졌나요? 중국 의사의 10,000 단어에 달하는 긴 기사는 GPT-3.5 기능의 기원을 깊이 분석합니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!