구글 AI 가수가 온다! AudioLM은 몇 초만 들으면서 음악과 노래를 작곡할 수 있습니다.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB앞으로

- 2023-04-11 21:10:061109검색

이미지 생성 모델이 등장했습니다! 비디오 생성 모델이 출시되었습니다!

다음은 오디오 생성 모델입니다.

최근 Google 연구팀은 음성 생성을 위한 AI 모델인 AudioLM을 출시했습니다.

단 몇 초의 오디오 프롬프트만으로 고품질의 일관된 음성뿐만 아니라 피아노 음악도 생성할 수 있습니다.

문서 주소: https://www.php.cn/link/b6b3598b407b7f328e3129c74ca8ca94

AudioLM은 입력 오디오를 개별 토큰 문자열로 매핑하는 장기적인 일관성을 갖춘 고품질 오디오 생성 프레임워크입니다. 오디오 생성 작업을 언어 모델링 작업으로 변환합니다.

기존 오디오 태거는 오디오 생성 품질과 안정적인 장기 구조 사이에서 균형을 맞춰야 합니다.

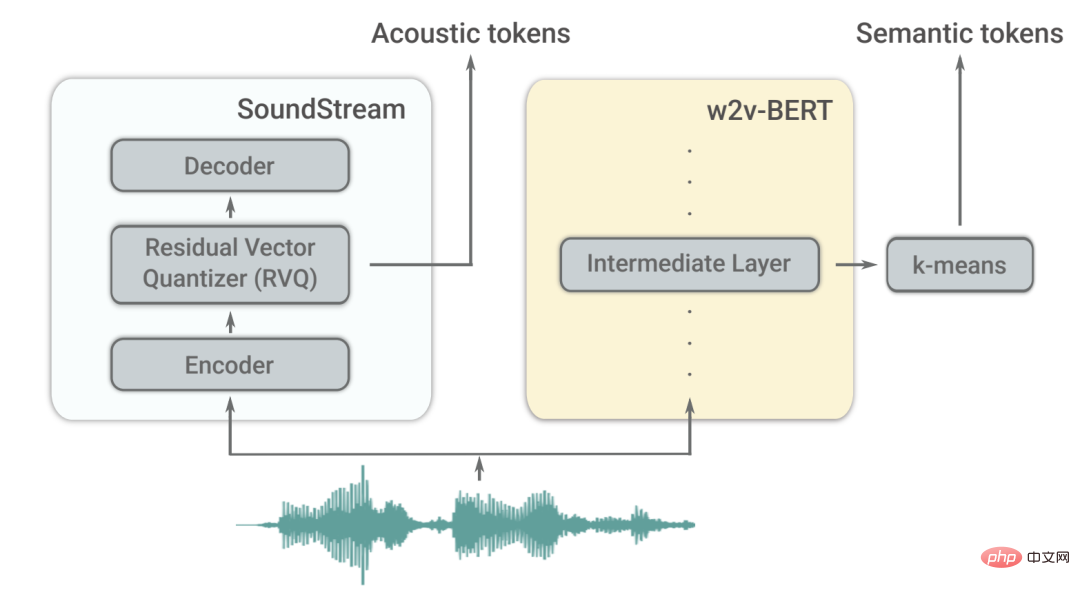

이 모순을 해결하기 위해 Google은 사전 훈련된 마스크 언어 모델의 이산화된 활성화를 사용하고 신경 오디오 코덱에서 생성된 이산 코드를 사용하여 고품질 합성을 달성하는 "하이브리드 토큰화" 솔루션을 채택합니다.

AudioLM 모델은 음성 훈련 시 정체성과 억양을 유지하면서 구문적으로 유창하고 의미적으로 합리적인 연속 단어를 생성하는 방법을 학습할 수 있습니다. 스피커의.

음성 외에도 AudioLM은 악보를 훈련할 필요 없이 일관된 피아노 음악을 생성할 수도 있습니다.

텍스트에서 피아노 음악까지: 두 가지 주요 문제

최근 몇 년 동안 대규모 텍스트 말뭉치를 훈련한 언어 모델은 뛰어난 생성 능력을 보여 개방형 대화, 기계 번역, 심지어 상식 추론까지 달성했으며, 자연 이미지 등 텍스트 이외의 신호.

AudioLM의 아이디어는 주석이 달린 데이터에 대한 교육 없이 오디오를 생성하기 위해 언어 모델링의 이러한 발전을 활용하는 것입니다.

하지만 이는 두 가지 문제에 직면해야 합니다.

첫째, 오디오의 데이터 속도가 훨씬 높고 단위 시퀀스가 더 깁니다. 예를 들어 문장에는 수십 개의 문자 표현이 포함되어 있지만 오디오 파형으로 변환된 후에는 일반적으로 수십만 개의 값이 포함됩니다.

또한 텍스트와 오디오 사이에는 일대다 관계가 있습니다. 동일한 문장이 다른 화자에 의해 다른 스타일, 감정적 내용, 맥락으로 제시될 수 있습니다.

이 두 가지 과제를 극복하기 위해 AudioLM은 두 가지 유형의 오디오 태그를 활용합니다.

먼저, 자기 감독 오디오 모델인 w2v-BERT에서 시맨틱 태그를 추출합니다.

이러한 태그는 로컬 종속성(예: 음성 속 음성, 피아노 음악의 로컬 멜로디)과 글로벌 장기 구조(예: 음성, 피아노 음악의 언어 구문 및 의미 콘텐츠) 조화 및 리듬)를 모두 캡처할 수 있으며 동시에 크게 다운샘플링합니다. 긴 시퀀스를 모델링하기 위한 오디오 신호.

그러나 이러한 토큰으로 재구성된 오디오의 충실도는 높지 않습니다.

음질을 향상시키기 위해 의미론적 태그 지정 외에도 AudioLM은 SoundStream 신경 코덱에서 생성된 음향 태그를 활용하여 고품질 합성을 위한 오디오 파형의 세부 사항(예: 스피커 특성 또는 녹음 조건)을 캡처합니다.

훈련 방법은?

AudioLM은 텍스트나 음악을 상징적으로 표현하지 않고 훈련된 오디오 전용 모델입니다.

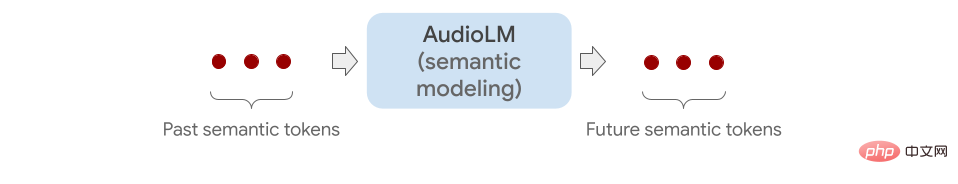

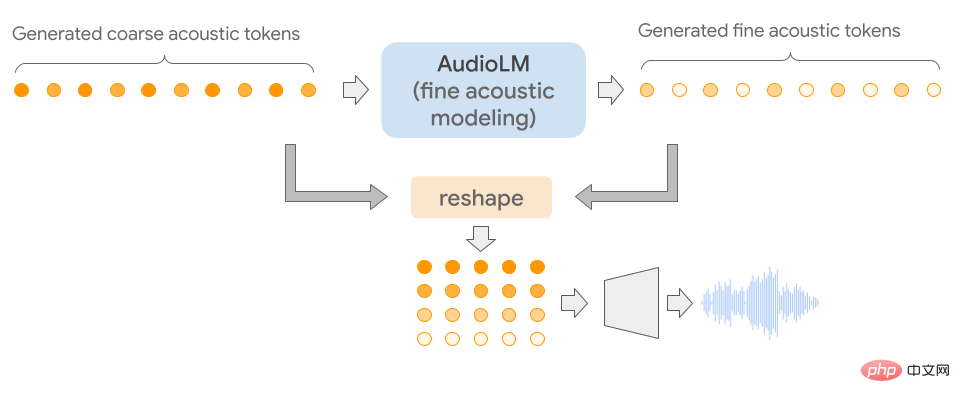

의미론적 태깅부터 미세한 음향 태깅까지 여러 Transformer 모델(각 단계마다 하나씩)을 연결하여 오디오 시퀀스를 계층적으로 모델링합니다.

각 단계는 언어 모델을 훈련하는 것처럼 마지막 토큰을 기반으로 다음 토큰을 예측하도록 훈련됩니다.

첫 번째 단계에서는 의미론적 태그에 대해 이 작업을 수행하여 오디오 시퀀스의 상위 수준 구조를 모델링합니다.

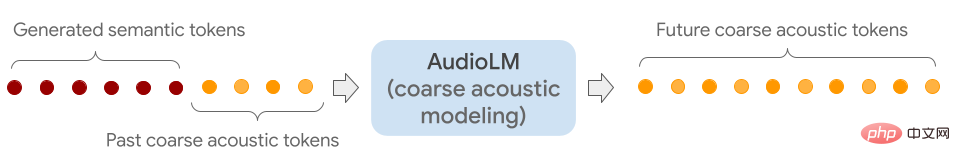

두 번째 단계에서는 전체 의미 토큰 시퀀스를 과거의 거친 토큰과 연결하고 두 가지를 거친 모델에 조건으로 제공함으로써 미래의 토큰을 예측합니다.

이 단계에서는 스피커 특성이나 음악의 음색과 같은 음향 특성을 시뮬레이션합니다.

세 번째 단계에서는 미세한 음향 모델을 사용하여 거친 음향 신호를 처리하고 최종 오디오에 더 많은 세부 정보를 추가합니다.

마지막으로 음향 마커가 SoundStream 디코더에 공급되어 파형을 재구성합니다.

교육이 완료된 후 AudioLM은 몇 초의 오디오를 조정하여 지속적인 오디오를 생성할 수 있습니다.

AudioLM의 일반적인 적용 가능성을 입증하기 위해 연구원들은 다양한 오디오 분야에서 2가지 작업을 통해 이를 테스트했습니다.

첫 번째는 음성 연속입니다. 이 모델은 제안된 화자 특성과 운율을 유지하면서 문법적으로 정확하고 의미적으로 일관된 새로운 콘텐츠를 출력합니다.

두 번째는 피아노 연속입니다. 이 모델은 멜로디, 하모니, 리듬 측면에서 프롬프트와 일치하는 피아노 음악을 생성합니다.

아래와 같이 회색 수직선 이후 들리는 모든 소리는 AudioLM에 의해 생성됩니다.

효과를 확인하기 위해 연구원들은 인간 평가자에게 짧은 오디오 클립을 듣고 그것이 인간의 음성을 원본으로 녹음한 것인지 AudioLM에서 생성한 녹음인지 확인하도록 요청했습니다.

수집된 평점에 따르면 AudioLM의 성공률은 51.2%로, 이 AI 모델이 생성한 음성은 일반 청취자가 실제 음성과 구별하기 어렵다는 것을 의미합니다.

노스이스턴 대학에서 정보 및 언어 과학을 연구하는 루팔 파텔(Rupal Patel)은 인공 지능을 사용하여 오디오를 생성하는 이전 작업에서는 훈련 데이터에 명시적으로 주석이 달린 경우에만 이러한 뉘앙스를 포착할 수 있었다고 말했습니다.

반면 AudioLM은 입력 데이터에서 이러한 기능을 자동으로 학습하고 충실도가 높은 결과를 얻습니다.

GPT3 및 Bloom(텍스트 생성), DALLE 및 Stable Diffusion(이미지 생성), RunwayML 및 Make-A-Video(비디오 생성) 등 멀티모달 ML 모델의 등장으로 콘텐츠 제작 및 창작 작업이 변화하고 있습니다.

미래세계는 인공지능이 만들어내는 세계입니다.

참고자료:

https://www.php.cn/link/c11cb55c3d8dcc03a7ab722703e0a

https://www.php.cn/link/b6b3598b407b7f328e3129c7 4ca 8ca94

https://www.php.cn/link/c5f7756d9f92a8954884ec415f79d120

https://www.php.cn/link/9b644ca9f37e3699ddf2055800130aa9

위 내용은 구글 AI 가수가 온다! AudioLM은 몇 초만 들으면서 음악과 노래를 작곡할 수 있습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!