오프라인 강화학습의 새로운 패러다임! JD.com과 Tsinghua University는 분리된 학습 알고리즘을 제안합니다.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB앞으로

- 2023-04-11 16:22:031114검색

오프라인 강화 학습 알고리즘(오프라인 RL)은 강화 학습의 가장 인기 있는 하위 방향 중 하나입니다. 오프라인 강화학습은 환경과 상호작용하지 않으며, 이전에 기록된 데이터로부터 목표 정책을 학습하는 것을 목표로 합니다. 오프라인 강화 학습은 데이터 수집 비용이 비싸거나 위험하지만 데이터 양이 많은 영역(예: 로봇 공학, 산업 제어, 자율 주행)에서 온라인 강화 학습(온라인 RL)에 비해 특히 매력적입니다.

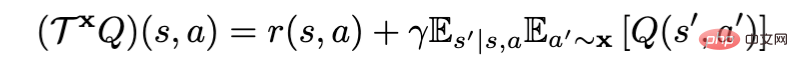

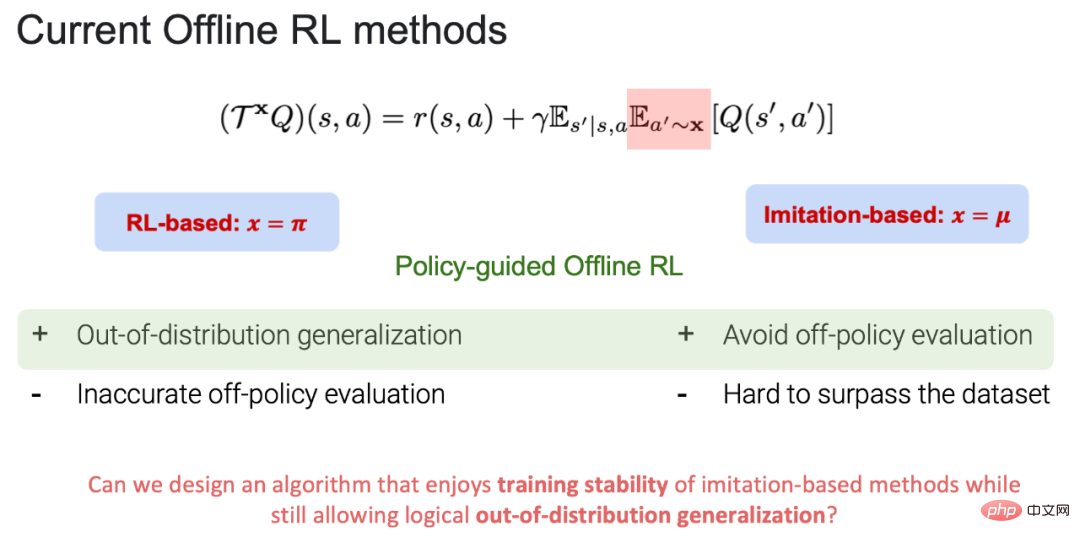

정책 평가를 위해 Bellman 정책 평가 연산자를 사용하는 경우 현재 오프라인 강화학습 알고리즘은 RL 기반(x=π)과 모방 기반(x=μ)으로 나눌 수 있습니다. 목표 전략이고 μ는 행동 전략입니다(참고: 목표 전략: 학습 및 업데이트 전략, 행동 전략: 오프라인 데이터의 전략). 현재 RL 기반과 모방 기반은 각각 장단점이 있습니다.

1. RL 기반 장점: 데이터를 넘어 일반화할 수 있으며, 최종적으로 행동 전략을 넘어 목표 전략 학습 목표를 달성할 수 있습니다. 단점: 정책 평가에서 정확한 가치 추정(행동 정규화 증가)과 정책 개선(행동 정규화 감소) 사이에는 상충 관계가 있습니다. 정책 평가 과정에서 데이터 분포 밖의 행위를 선택하게 되면 행위값함수(action-state value)를 정확하게 추정할 수 없어 궁극적으로 목표 정책 학습에 실패하게 된다.

2.모방 기반의 장점: 정책 평가 과정에서 모든 조치가 데이터 배포 내에 있기 때문에 훈련에 안정성을 가져올 수 있을 뿐만 아니라 데이터 배포 외부의 정책 평가를 피하고 학습할 수 있습니다. 닫기 행동 전략 라이브러리에 있는 최고의 전략입니다. 단점: 모든 조치가 데이터 분포 내에서 이루어지기 때문에 원본 데이터에 존재하는 행동 전략을 뛰어넘기가 어렵습니다.

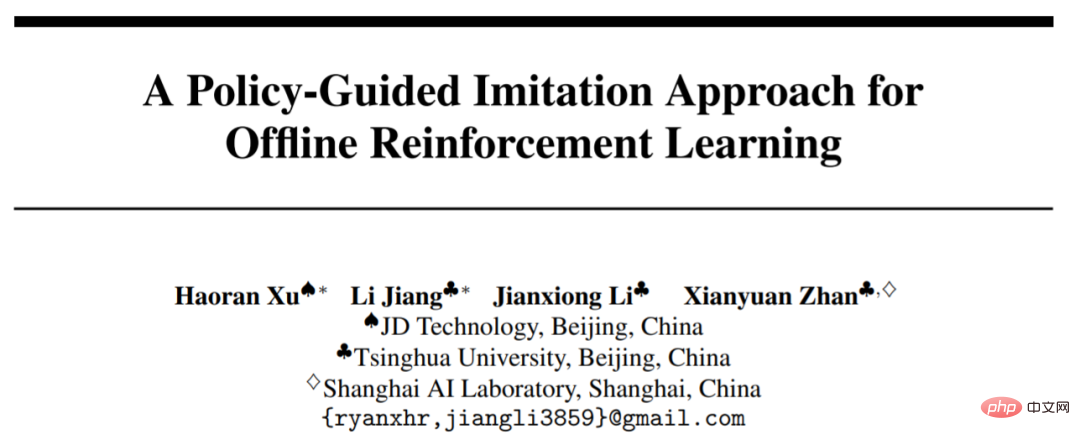

POR 이를 바탕으로 전략 평가 과정에서 trade-off를 피할 수 있을 뿐만 아니라 데이터 외부를 일반화하는 능력도 갖췄다. 이 작업은 NeurIPS 2022에 승인되었으며 구두 프레젠테이션에 초대되었습니다. 논문과 코드는 오픈 소스입니다.

- 문서: https://arxiv.org/abs/2210.08323

- 코드: https://github.com/ryanxhr/POR

상태- 스티칭 대 액션 스티칭

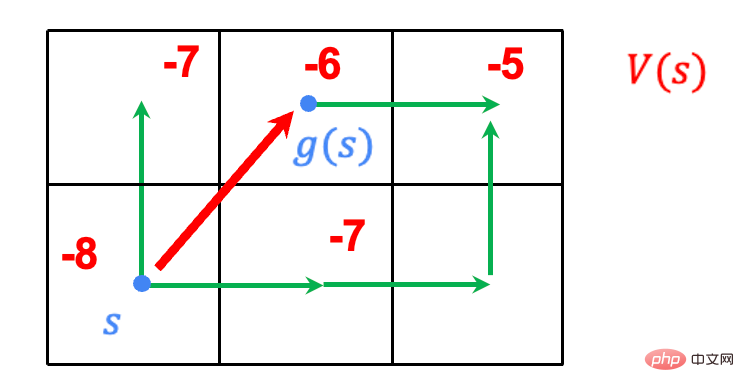

- 작업: 그리드를 걷고, 끝점은 오른쪽 상단에 있고, 시작점은 오른쪽 하단에 있습니다. 시작점에서 끝점까지의 최단 경로를 찾습니다.

- 규칙: 에이전트는 어떤 그리드에서든 주변의 8개 그리드를 선택할 수 있으며 끝에 도달하면 1의 보상을 받고 다른 모든 행동 보상은 0이 됩니다.

- 데이터: 녹색 걷기 경로는 기존 경로 데이터입니다.

이전의 모방 기반 알고리즘은 모두 액션 스티칭을 사용했습니다. 즉, 데이터에서 사용 가능한 궤적을 연결하여 목표 정책 학습을 달성했습니다. 예를 들어 영상 속 파란색 궤적은 액션 스티칭으로 학습할 수 있는 최고의 궤적이지만, 데이터 외부에서는 효과적으로 일반화할 수 없어 데이터 속 행동 전략을 넘어서는 타겟 전략을 학습할 수 있다. 그러나 POR은 분리된 학습 패러다임을 통해 목표 전략을 효과적으로 일반화하여 행동 전략의 성능을 능가할 수 있습니다.

상태 연결을 구현하는 방법은 무엇입니까?

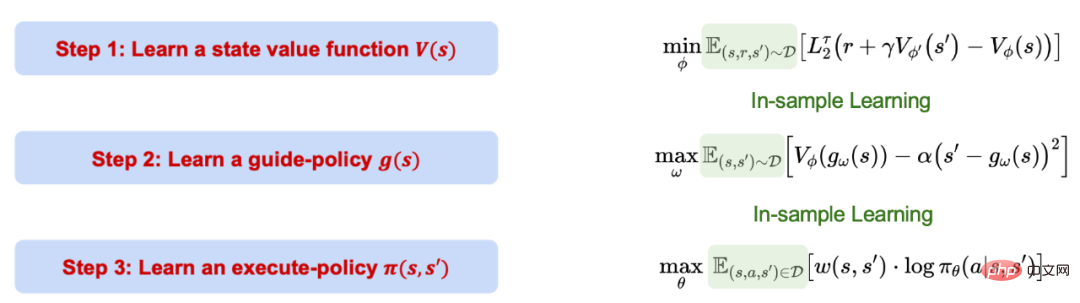

정책 기반 오프라인 RL(POR) 학습 프로세스는 세 단계로 나누어져 있으며 서로 영향을 미치지 않습니다. POR의 전 과정은 모방 기반 학습, 즉 표본 내 학습을 기반으로 하며, 데이터 분포 외부의 행동 가치를 평가하지 않는다는 점에 주목할 필요가 있습니다.

1. 분위수 회귀를 사용하여 가치 함수의 신뢰도 상한을 알아보세요.

2. 학습된 가치 함수를 사용하여 현재 상태가 주어진 샘플 내에서 다음 최적의 상태 위치를 생성할 수 있는 안내 전략을 학습합니다. 후자 항목은 생성된 상태가 MDP 조건을 충족하는지 확인하는 제약 조건 역할을 합니다.

3. 데이터의 모든 샘플을 사용하여 현재 상태(들)와 다음 상태(들')를 고려하여 현재 상태에서 올바른 조치를 취할 수 있는 실행 전략을 학습합니다. 상태(들).

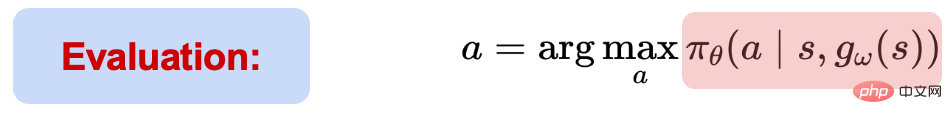

테스트 과정에서 현재 상태 정보를 기반으로 지침 전략을 통해 다음 최적의 상태를 먼저 제공합니다.

(s,s')가 주어지면 실행 전략에 따라 작업을 선택하고 실행할 수 있습니다. POR의 전체 학습 과정은 샘플 내 학습이지만 신경망의 일반화 성능을 사용하여 데이터 외부에서 일반화 학습을 수행하고 최종적으로 상태 연결을 달성할 수 있습니다.

Experiment

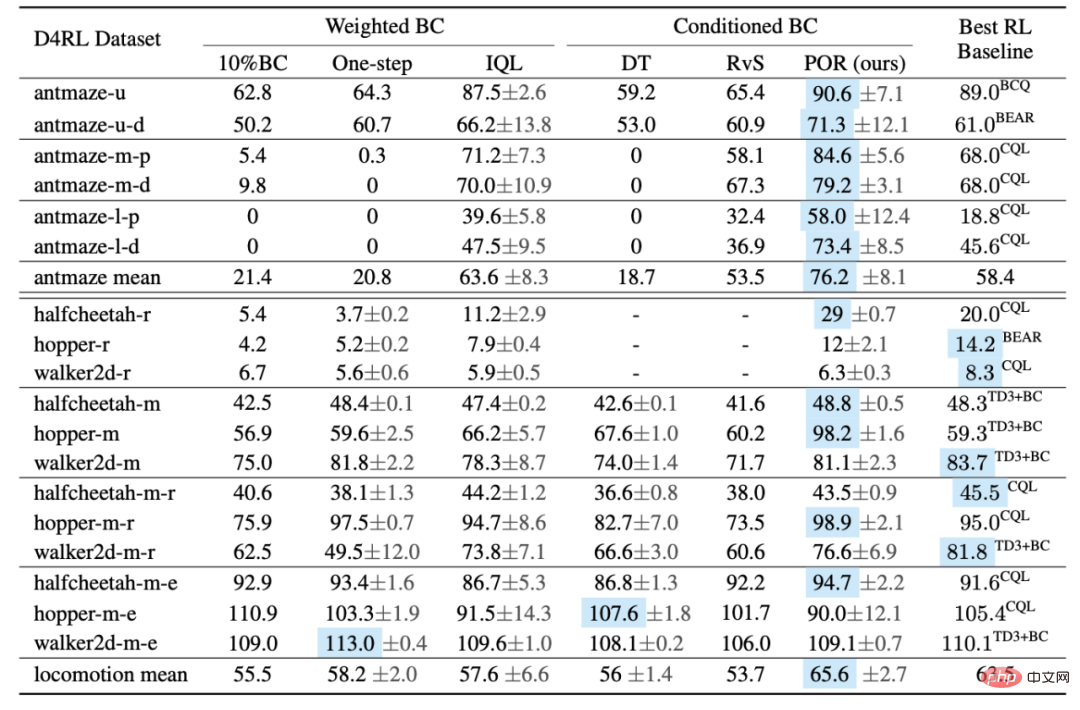

저자는 D4RL 벤치마크에서 POR과 다른 알고리즘의 성능을 비교했습니다. 표에 따르면 POR은 최적이 아닌 데이터에서 매우 잘 수행되며 더 어려운 Antmaze 작업에서 최적의 알고리즘 성능을 달성합니다.

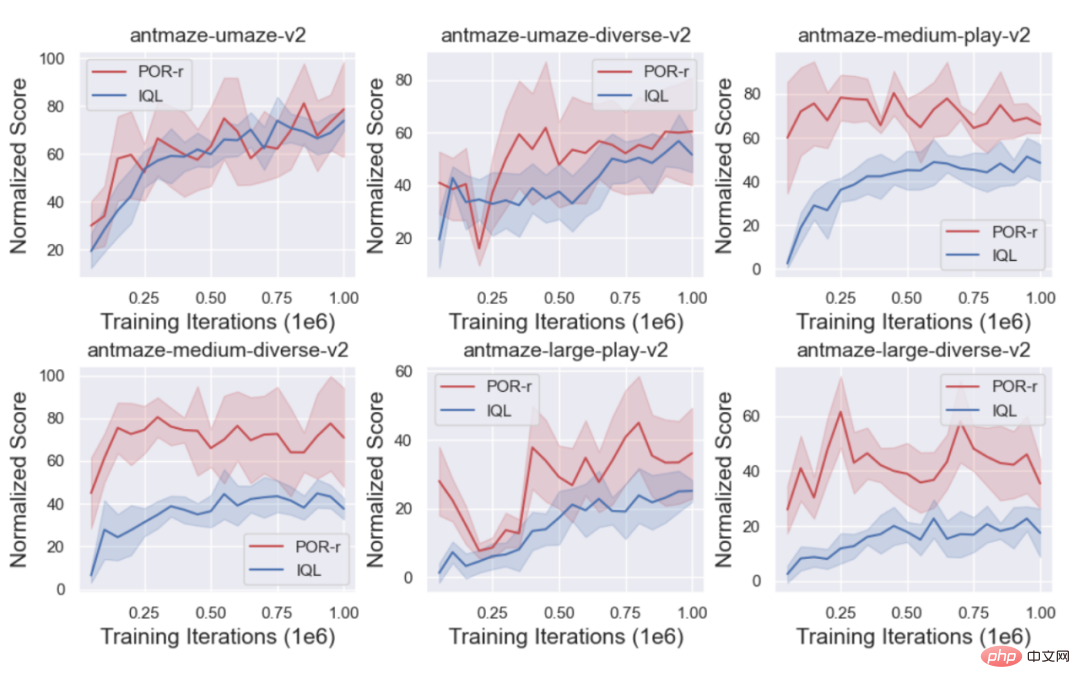

이와 동시에 저자는 상태 스티칭의 장점을 보여주기 위해 POR(상태 스티칭)과 IQL(액션 스티칭)의 훈련 곡선을 비교했습니다.

디커플링의 추가 이점은 무엇입니까

1. 알고리즘 성능 향상을 위한 지침 전략을 다시 학습하세요.

실제에는 차선책이거나 심지어 무작위 데이터 세트(D_o)가 학습 중인 원본 데이터 세트(D_e)에 직접 도입되는 경우 잘못된 전략 학습으로 이어질 수 있는 경우가 많습니다. 그러나 분리된 학습 알고리즘의 경우 성능을 향상시키기 위해 다양한 구성 요소를 목표로 하고 다양한 데이터 세트를 학습합니다. 가치함수를 학습할 때, 데이터 세트가 많을수록 더 좋습니다. 반대로 가치함수를 더 정확하게 학습할 수 있기 때문에 전략의 학습은 도입하고 싶지 않습니다(D_o).

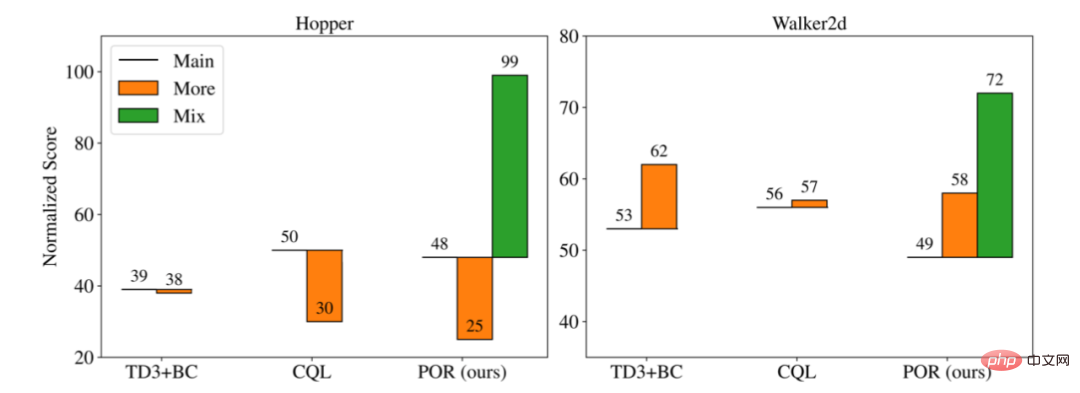

저자는 다양한 교육 시나리오에서 세 가지 알고리즘의 성능을 비교했습니다.

1. 기본: 최적이 아닌 추가 데이터 세트를 도입하지 않고 원래 데이터 세트(D_e)에서 학습합니다.

2. 더 보기: 원본 데이터 세트(D_e)와 새로운 데이터 세트(D_o)를 혼합하여 새로운 데이터 세트로 학습합니다.

3. Mix: 분리된 알고리즘의 경우 학습 부분에 따라 서로 다른 데이터 세트를 학습에 사용할 수 있으므로 POR만이 Mix 학습 패러다임을 가질 수 있습니다.

위 그림에서 볼 수 있듯이 함께 훈련하기 위해 새로운 차선 데이터를 추가(More)하면 원래 데이터 세트(Main) 단독보다 성능이 좋거나 나쁠 수 있지만, 지도 전략(D_o+D_e)을 다시 학습하기 위한 분리된 훈련 형식을 목표로 하는 저자의 실험은 더 많은 데이터가 행동 전략을 변경하지 않고 유지하면서 지도 전략의 선택성과 일반화 능력을 향상시켜 실행 전략 개선을 달성할 수 있음을 보여줍니다.

4. 새로운 과제에 직면했을 때, 실행 전략은 과제와 아무런 관련이 없기 때문에 지도 전략만 다시 배우면 됩니다.

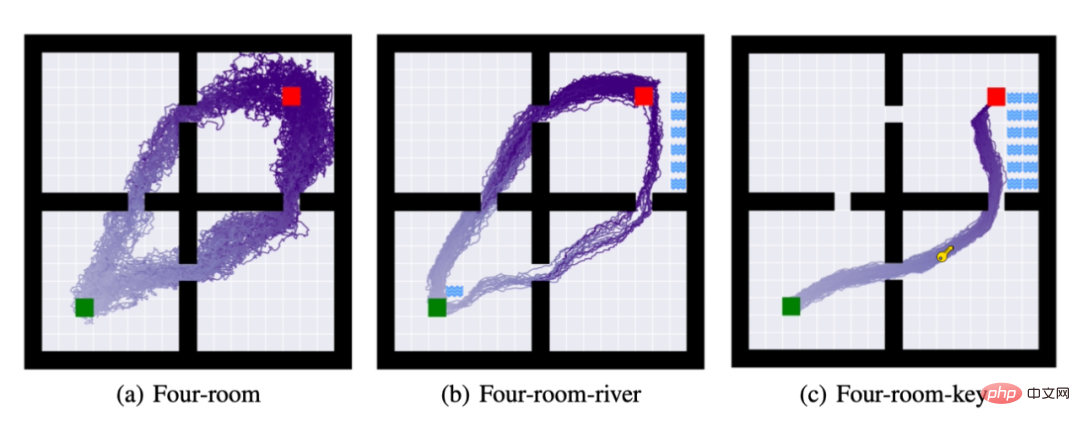

이를 위해 저자는 세 가지 작업을 제안했습니다. (a): 4개 방: 에이전트가 녹색 사각형에서 빨간색 사각형으로 이동하도록 요구합니다. (b) 작업 (a)를 완료하는 것 외에도 에이전트는 강에 닿아서는 안 됩니다. (c) 작업 (a)와 (b)를 완료하는 것 외에도 에이전트는 작업을 완료하기 위해 키를 획득해야 합니다.

위 그림은 전략 학습을 마친 후 50번의 전략 롤아웃 궤적입니다. 과제 (b)와 과제 (c)에서는 저자가 계속해서 과제 (a)와 과제의 실행 전략을 사용했습니다. 지도 전략만 다시 배웠습니다. 위 그림에서 볼 수 있듯이 분리된 학습 방법은 가능한 적은 컴퓨팅 자원을 사용하여 작업 마이그레이션을 완료할 수 있습니다.

위 내용은 오프라인 강화학습의 새로운 패러다임! JD.com과 Tsinghua University는 분리된 학습 알고리즘을 제안합니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!