2022년 'AI 100대 논문' 발표: 칭화는 구글에 이어 2위, 닝보공업대학은 최대 다크호스 등극

- 王林앞으로

- 2023-04-11 14:07:032007검색

인공지능 분야의 혁신 속도는 점점 빨라지고 있고, 논문 수도 폭발적으로 늘어나 인간이 읽을 수 없는 수준까지 이르렀습니다.

2022년에 발표된 대규모 논문 중 가장 영향력이 큰 기관은 어디인가요? 어떤 논문이 더 읽을 가치가 있나요?

최근 외신 제타알파는 고전적인 인용수를 평가 지표로 활용해 2022년 가장 많이 인용된 논문 100선을 모아 정리하고, 지난 3년간 각국과 기관에서 발표한 논문을 분석했다. 년 동안 많이 인용된 논문의 수입니다.

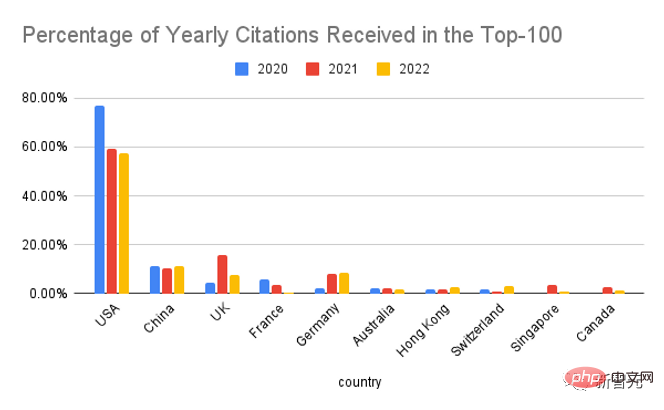

미국은 여전히 1위, 중국은 2위국가별로 나누면 미국이 여전히 1위를 차지하고 있지만, 상위 100대 논문에서 미국이 차지하는 비중은 2020년에 비해 크게 떨어졌습니다.

중국은 작년보다 약간 높은 데이터로 2위를 차지했습니다. 3위는 영국입니다. DeepMind의 생산량은 작년 영국 전체의 69%를 차지했으며 전년도에는 60%를 초과했습니다. AI 분야에서의 영향력도 분석가들의 기대를 뛰어넘었습니다.

조직별로 나누어 보면 Google이 AI 분야에서 항상 가장 강력한 플레이어였으며 그 뒤를 Meta, Microsoft, University of California, Berkeley, DeepMind 및 Stanford University가 전국 1위를 차지하고 있음을 알 수 있습니다. 대학교.

Meta AI의 리더인 Yann LeCun도 업계에서 Meta의 영향력을 자랑스럽게 알리며 Meta AI는 출판의 양보다 출판의 질에 더 많은 관심을 기울이고 있다고 말했습니다.

알파벳에 속한 Google과 DeepMind가 목록에 별도로 포함되는 문제에 대해 LeCun은 DeepMind가 항상 Google과 독립적으로 운영된다고 주장해 왔는데 이상하다고 말했습니다. Google 직원은 DeepMind의 코드에 액세스할 수 없습니다.

오늘날의 인공지능 연구는 대부분 업계가 주도하고 단일 학술 기관의 영향력이 거의 없지만, 조직 유형에 따라 데이터를 집계하면 롱테일 효과로 인해 학계 전체가 여전히 업계와 동등한 수준입니다. 의 경우, 둘의 영향력이 거의 동일함을 알 수 있다.

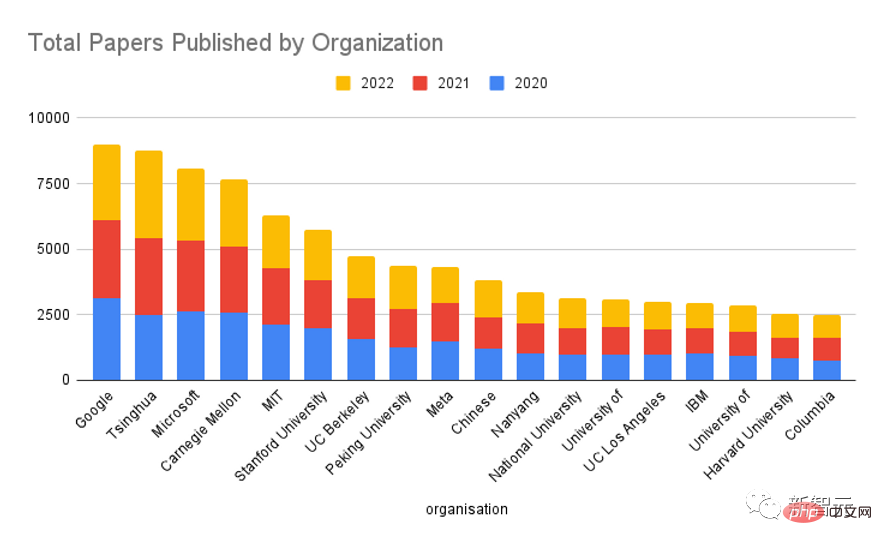

지난 3년간을 돌아보면 여러 기관의 전체 연구 결과 수를 따져보면 여전히 구글이 선두에 있지만 다른 기관에 비해 그 격차가 훨씬 적다는 것을 알 수 있습니다. Tsinghua University가 Google 뒤를 바짝 뒤쫓고 2위를 차지했다고 언급했습니다.

OpenAI와 DeepMind는 상위 20위에도 들지 않습니다. 물론 이들 기관에서 발행하는 논문의 수는 적지만 각 논문의 영향력은 매우 높습니다.

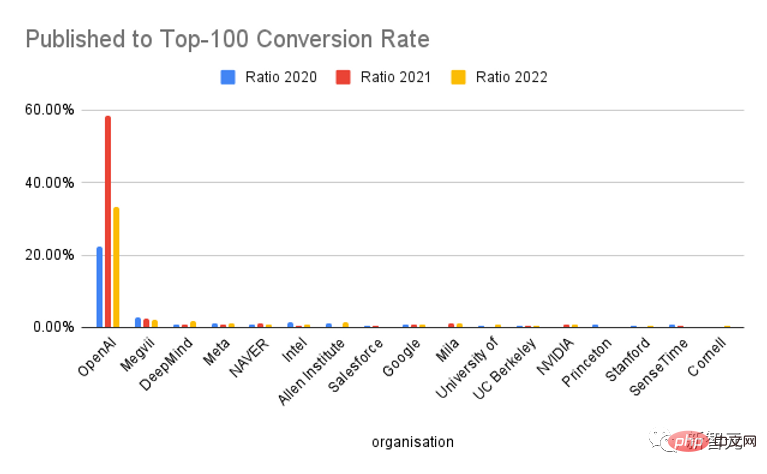

톱 100에 진입하는 출판물 비율을 보면 OpenAI는 독특하고 전환율이 다른 기관보다 훨씬 높습니다. 기본적으로 두 논문 중 하나가 "올해의 상위 100개 논문"이 되었습니다. .

물론, ChatGPT의 인기로 볼 때 OpenAI는 실제로 마케팅에 매우 능숙하며, 이는 어느 정도 인용 증가를 촉진했으며 연구 결과의 품질이 매우 높다는 것은 부인할 수 없습니다.

논문 수집 방법

먼저 Zeta Alpha 플랫폼에서 매년 가장 많이 인용되는 논문을 수집한 후, 첫 번째 출판 날짜를 수동으로 확인합니다(보통 arXiv preprint). 년도.

Semantic Scholar에서 많이 인용된 AI 논문을 마이닝하여 이 목록을 보완하세요. 이 논문은 추가 논문을 위해 주로 영향력 있는 비공개 소스 출판사(예: Nature, Elsevier, Springer 및 기타 저널)에서 인용 횟수를 기준으로 정렬할 수 있으며 더 넓은 범위를 다루고 있습니다.

그러면 각 논문의 구글 학술검색 인용 횟수를 대표 지표로 삼아 이 숫자에 따라 논문을 분류해 1년 내 상위 100위 논문을 획득하게 됩니다.

이 논문의 경우 GPT-3를 사용하여 저자, 소속, 국가를 추출하고 결과를 수동으로 확인합니다. (국가가 출판물에 반영되지 않은 경우 해당 기관의 본사가 있는 국가가 사용됩니다.)

여러 기관의 저자가 참여한 논문은 각 소속에 대해 한 번씩 계산됩니다.

2022년 상위 5개 논문

1. AlphaFold 단백질 구조 데이터베이스: 고정확도 모델로 단백질 서열 공간의 구조적 적용 범위를 대폭 확장

논문 링크: https://academic .oup.com/nar/article/50/D1/D439/6430488

출판 기관: 유럽 분자 생물학 연구소, DeepMind

AlphaFold DB: https://alphafold.ebi ac. uk

인용 횟수: 1331

AlphaFold 단백질 구조 데이터베이스 AlphaFold DB는 단백질 구조 예측을 위해 공개적으로 접근 가능하고 광범위하며 매우 정확한 데이터베이스입니다.

DeepMind의 AlphaFold v2.0을 기반으로 하는 이 데이터베이스는 알려진 단백질 서열 공간의 구조적 적용 범위를 전례 없이 확장할 수 있습니다.

AlphaFold DB는 예측 원자 좌표, 각 잔기 및 쌍에 대한 모델 신뢰도 추정, 예측 정렬 오류에 대한 프로그래밍 방식 액세스 및 대화형 시각화를 제공합니다.

AlphaFold DB의 초기 버전에는 21개 모델 유기체의 프로테옴을 포괄하는 360,000개 이상의 예측 구조가 포함되어 있으며 향후 UniRef90 데이터 세트의 대부분(1억 개 이상)의 대표 시퀀스를 포괄하도록 확장될 예정입니다.

2. ColabFold: 누구나 접근 가능한 단백질 접힘 만들기

논문 링크: https://www.nature.com/articles/s41592-022-01488-1

코드 링크: https://github.com/sokrypton/colabfold

환경 링크: https://colabfold.mmseqs.com

인용 수: 1138

ColabFold는 MMSEQS2의 빠른 상동성 검색을 AlphaFold2 또는 Rosettafold와 결합하여 단백질 구조 및 복합체 예측을 가속화합니다.

ColabFold는 모델 활용에서 40~60배 빠른 검색 및 최적화를 달성할 수 있으며, 하나의 그래픽 처리 장치만으로 서버에서 거의 1,000개에 가까운 구조를 예측할 수 있습니다.

ColabFold는 Google Colaboratory를 기반으로 하는 무료 접근 가능한 단백질 접힘 플랫폼이자 오픈 소스 소프트웨어이기도 합니다.

3. 2020년대를 위한 ConvNet

논문 링크: https://arxiv.org/pdf/2201.03545.pdf

인용 수: 835

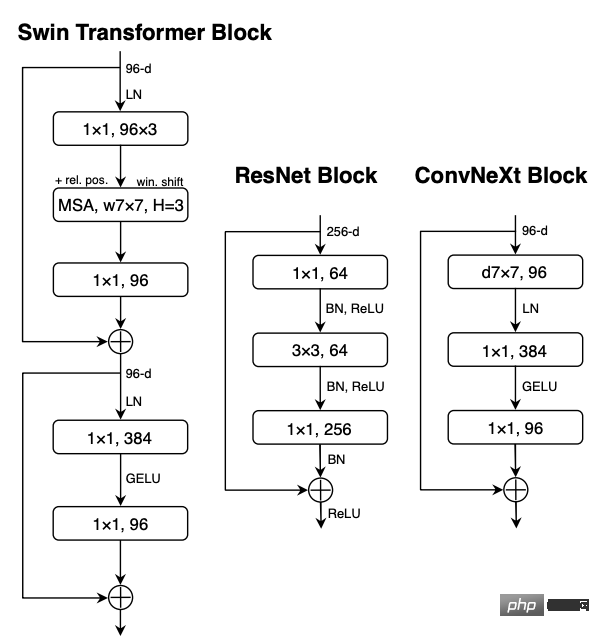

시각적으로 식별 가능한 " Roaring 20s'는 ViTs(Visual Transformers)의 도입으로 시작되었으며, ViTs는 가장 진보된 이미지 분류 모델로서 ConvNets를 빠르게 대체했습니다.

반면에, 가장 간단한 ViT는 객체 감지 및 의미론적 분할과 같은 일반적인 컴퓨터 비전 작업에 적용할 때 여전히 몇 가지 어려움에 직면합니다.

Hierarchical Transformers(예: Swin Transformers)는 여러 ConvNet 이전 버전을 다시 도입하여 Transformer를 실제로 일반 비전 모델 백본으로 사용할 수 있게 만들고 다양한 비전 작업에서 상당한 성능을 보여줍니다.

그러나 이 하이브리드 접근 방식의 효율성은 여전히 주로 컨볼루션의 고유한 유도성 바이어스보다는 Transformer의 고유한 장점에 기인합니다.

이 작업에서 연구원들은 설계 공간을 다시 방문하고 순수 ConvNet이 달성할 수 있는 한계를 테스트했습니다.

표준 ResNet을 ViT의 디자인으로 점차적으로 "현대화"했으며 그 과정에서 성능 차이에 기여하는 몇 가지 핵심 구성 요소를 발견한 후 ConvNeXt라는 순수 ConvNet 모델이 발견되었습니다.

ConvNeXt는 완전히 표준 ConvNet 모듈로 구성되어 있으며 정확도와 확장성 측면에서 Transformer와 동등하며 COCO 감지 및 ADE20K 분할에서 87.8% ImageNet 상위 1 정확도를 달성하고 Swin Transformers를 능가합니다. 표준 ConvNet.

4. CLIP 잠재성을 사용한 계층적 텍스트 조건부 이미지 생성

문서 링크: https://arxiv.org/abs/2204.06125

인용수: 718

CLIP과 같은 대조 모델은 의미와 스타일을 포착하는 강력한 이미지 표현을 학습하는 것으로 입증되었습니다.

이러한 표현을 활용하여 이미지를 생성하기 위해 연구원들은 2단계 모델을 제안합니다. 즉, 텍스트 캡션이 제공된 CLIP 이미지 임베딩을 생성하는 사전 모델과 이미지 임베딩을 조건으로 이미지를 생성하는 디코더입니다.

실험을 통해 이미지 표현을 명시적으로 생성하면 충실도와 제목 유사성의 손실을 최소화하면서 이미지 다양성을 향상할 수 있으며, 이미지 표현에 조건을 맞춘 디코더는 의미와 스타일을 유지하는 동시에 이미지의 변경을 생성할 수 있다는 사실이 입증되었습니다. 이미지 표현에는 존재하지 않습니다.

또한 CLIP의 공동 임베딩 공간을 통해 언어 안내 이미지 작업을 제로샷 방식으로 수행할 수 있습니다.

디코더에 확산 모델을 사용하고 선험적 자동 회귀 및 확산 모델로 실험해 보면 후자가 계산적으로 더 효율적이고 더 높은 품질의 샘플을 생성할 수 있다는 것을 알 수 있습니다.

5. PaLM: 경로를 통한 언어 모델링 확장

논문 링크: https://arxiv.org/pdf/2204.02311.pdf

인용수: 426

대형 언어 모델은 다양한 자연어 작업에 대한 소수 학습을 사용하여 더 높은 성능을 달성하는 것으로 나타났으며, 모델을 특정 애플리케이션에 적용하는 데 필요한 작업별 교육 인스턴스 수를 크게 줄였습니다.

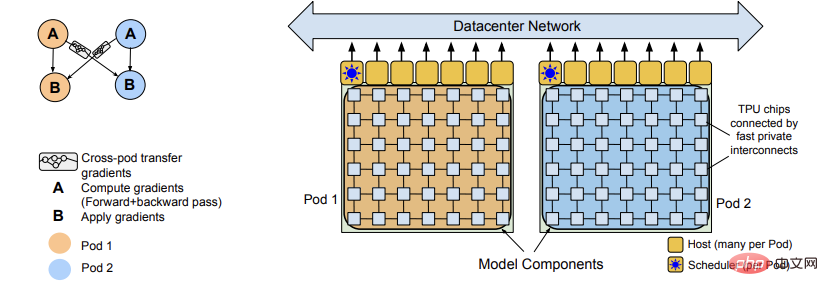

Few-Shot 학습에 대한 규모의 영향을 더 자세히 이해하기 위해 연구원들은 5,400억 개의 매개변수, 조밀하게 활성화된 Transformer 언어 모델 PaLM(Pathways Language Model)을 훈련했습니다.

PaLM은 Pathways(여러 TPU Pod에서 효율적으로 교육할 수 있는 새로운 ML 시스템)를 사용하여 6144 TPU v4 칩에서 교육을 받았으며, 수백 가지 언어 이해 및 생성 벤치마크에서 최첨단 기술을 달성했습니다. 학습 결과는 이점을 보여줍니다. 스케일링의.

이러한 작업 중 일부에서 PaLM 540B는 일련의 다단계 추론 작업에 대한 미세 조정에서 최첨단 성능을 능가하고 최근 출시된 BIG 벤치 벤치마크에서 평균 인간 성능을 능가하는 획기적인 성능을 달성합니다.

많은 수의 BIG-bench 작업에서 모델 크기가 불연속적으로 개선되는데, 이는 규모가 가장 큰 모델로 확장되면 성능이 갑자기 향상된다는 의미이기도 합니다.

PaLM은 또한 다국어 작업 및 소스 코드 생성에 대한 강력한 기능을 갖추고 있으며 이는 일련의 벤치마크 테스트에서도 입증되었습니다.

또한 연구자들은 편견과 독성에 대한 종합적인 분석을 수행하고 모델 크기와 관련하여 훈련 데이터가 어느 정도 기억될 수 있는지 조사합니다. 마지막으로 연구자들은 대규모 언어 모델과 관련된 윤리적 고려 사항에 대해 논의합니다. 잠재적 완화 전략.

2022년 국내 상위 5개 논문

1. Swin Transformer V2: 용량 및 해상도 확장

문서 링크: https://arxiv.org/pdf/2111.09883.pdf

코드 링크: https://github.com/microsoft/Swin-Transformer

인용 횟수: 266

대규모 NLP 모델은 포화 징후 없이 언어 작업의 성능을 크게 향상시키는 동시에 인간과 같은 놀라운 소수 능력을 입증하는 것으로 나타났습니다.

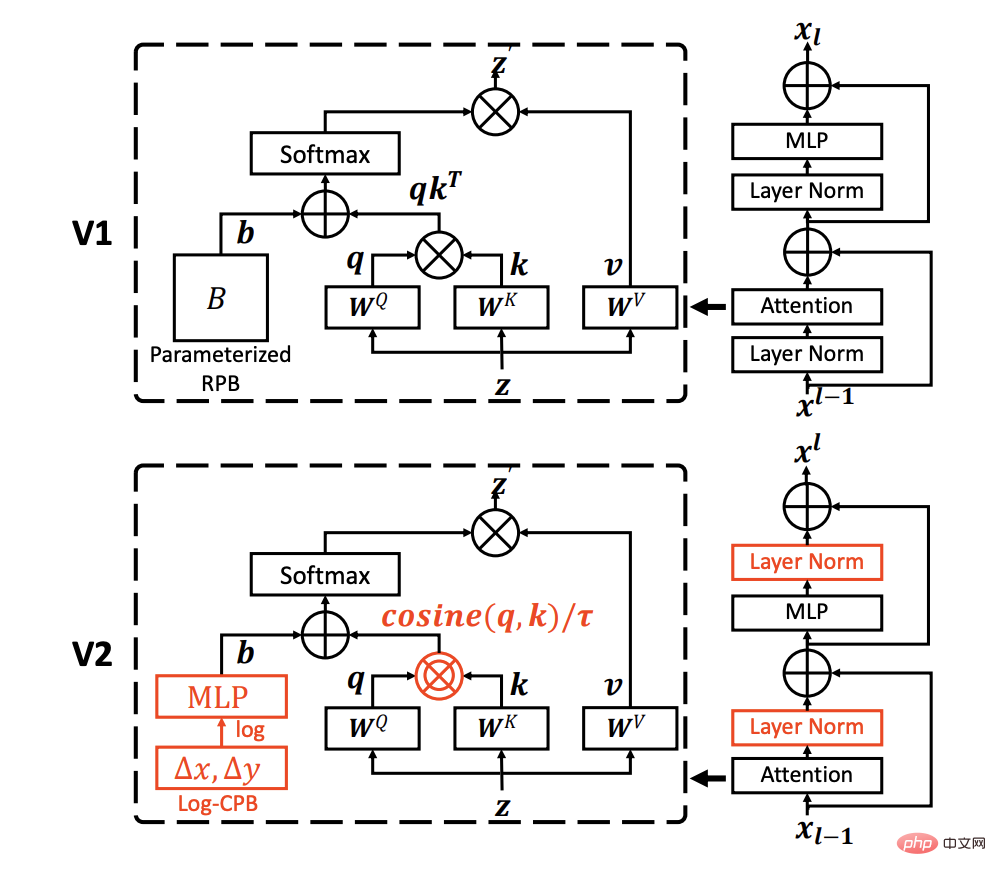

이 문서는 컴퓨터 비전의 대규모 모델을 탐색하여 훈련의 불안정성, 사전 훈련과 미세 조정 사이의 해상도 격차, 그리고 필요성을 포함하여 대규모 비전 모델의 훈련 및 적용에 관한 세 가지 주요 문제를 해결하는 것을 목표로 합니다. 라벨이 붙은 데이터의 경우.

연구원들은 세 가지 주요 기술을 제안했습니다.

1) 훈련의 안정성을 향상시키기 위해 코사인 주의와 결합된 잔여 사후 정규화 방법

2) 효과적인 로그 A 간격 연속 위치 바이어스 방법; 저해상도 이미지로 사전 학습된 모델을 고해상도 입력이 포함된 다운스트림 작업으로 전송합니다.

3) 이미지 라벨링에 대한 대규모 요구 사항을 줄이기 위한 자체 감독 사전 학습 방법인 SimMIM.

이러한 기술을 통해 현재까지 최대 규모의 Dense Vision 모델인 30억 매개변수 Swin Transformer V2 모델을 성공적으로 학습했으며, 최대 1,536×1,536 해상도의 이미지로 학습이 가능했습니다.

ImageNet-V2 이미지 분류, COCO 객체 감지, ADE20K 의미론적 분할 및 Kinetics-400 비디오 동작 분류를 포함한 4가지 대표적인 비전 작업에서 새로운 성능 기록을 설정합니다.

동시에 훈련은 Google의 10억 레벨 비전 모델의 훈련보다 훨씬 효율적이며 레이블이 지정된 데이터와 훈련 시간이 40배 더 적게 소모된다는 점을 알 수 있습니다.

2. 사이버 공격 탐지를 위한 앙상블 비지도 자동 인코더 및 가우스 혼합 모델

이전 연구에서는 네트워크 탐지를 위해 차원 축소 기능을 갖춘 비지도 기계 학습을 사용했는데, 이는 고차원 및 희소 데이터에 대한 강력한 탐지로 제한되었습니다.

대부분의 방법은 일반적으로 각 도메인의 매개변수가 동질적이고 특정 가우스 분포를 갖는다고 가정하며 데이터 왜도에 대한 견고성 테스트를 무시합니다.

논문 링크: https://www.sciencedirect.com/science/article/pii/S0306457321003162

인용 횟수: 145

이 논문에서는 ( GMM) 비지도 앙상블 오토인코더는 각 도메인의 왜도를 고려하지 않고 여러 도메인에 적응합니다.

앙상블 오토인코더의 잠재 공간에서는 Attention 기반 잠재 표현과 재구성의 최소 오류 특징을 활용하고 GMM에서 샘플 밀도를 추정하기 위해 EM(기대 최대화) 알고리즘을 사용합니다. 추정된 샘플 밀도가 초과됨 훈련 단계에서 학습 임계값이 획득되면 해당 샘플은 이상치와 관련된 이상값으로 식별됩니다.

마지막으로, 목적 함수의 최적화를 라그랑지안 이중 문제로 변환하기 위해 통합 오토인코더와 GMM이 공동으로 최적화되었습니다. 3개의 공개 데이터 세트에 대해 수행된 실험은 제안된 모델과 선택된 모델의 성능을 검증합니다. 이상 탐지 기준선은 상당히 경쟁력이 있습니다. .

논문의 공동 저자는 Ningbo Institute of Technology의 An Peng 교수와 Tongji University의 Zhiyuan Wang입니다.

안펑 교수는 현재 닝보공과대학 전자정보공학부 부학장을 맡고 있습니다. 그는 2000년부터 2009년까지 칭화대학교 공학물리학과에서 공부하고 공학 학사 및 박사 학위를 받았습니다. CERN, National Pardo, 이탈리아 독일 Warburg 대학 및 Heidelberg 대학 방문 학자, 중국 자동화 협회의 인지 컴퓨팅 및 시스템 전문 위원회 회원, 중국 인공 지능 협회의 인지 시스템 및 정보 처리 전문 위원회 회원 , 중국 지휘통제학회 청년 실무위원회 위원이며 국가 주요 프로젝트 기본 연구 개발 계획(973 계획), 중국 국립자연과학재단, 국가 스파크 프로그램 및 기타 여러 과학 연구 프로젝트를 의장으로 참여했습니다.

3. 커널을 31x31로 확장: CNN에서 대규모 커널 디자인 재검토

문서 링크: https://arxiv.org/abs/2203.06717

코드 링크: https://github.com/megvii-research/RepLKNet

인용 횟수: 127

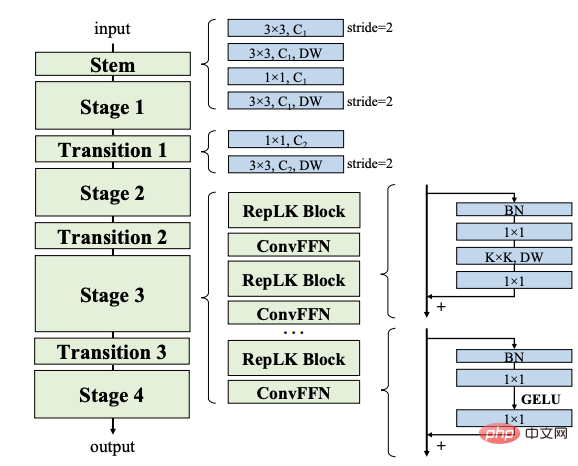

이 기사에서는 최신 CNN(컨볼루션 신경망)의 대형 코어 설계를 검토합니다.

최근 ViT(Visual Transformers)의 발전에 영감을 받은 이 문서는 여러 개의 작은 커널 대신 여러 개의 큰 컨벌루션 커널을 사용하는 것이 더 강력한 패러다임이 될 수 있음을 보여줍니다.

연구원들은 효율적인 고성능 대형 커널 CNN을 설계하기 위해 다시 매개변수화된 대규모 심층 컨볼루션을 적용하는 등 5가지 지침을 제안했습니다.

이러한 지침을 기반으로 우리는 일반적으로 사용되는 3x3과 달리 커널 크기가 31x31인 순수 CNN 아키텍처인 RepLKNet을 제안합니다. RepLKNet은 CNN과 ViT 간의 성능 격차를 크게 줄입니다. 또는 ImageNet 및 일부 일반적인 다운스트림 작업에서 대기 시간이 짧은 Swin Transformer보다 우수합니다.

RepLKNet은 또한 유사한 모델 크기로 ImageNet에서 87.8%, ADE20K에서 56.0% mIoU, 최첨단 기술에서 56.0% mIoU의 최고 정확도를 달성하는 등 빅데이터 및 대규모 모델에 대해 우수한 확장성을 보여줍니다. 경쟁력 있는.

이 연구는 또한 소형 코어 CNN과 비교하여 대형 코어 CNN이 텍스처 편향이 아닌 더 큰 유효 수용 필드와 더 높은 모양 편향을 가지고 있음을 보여줍니다.

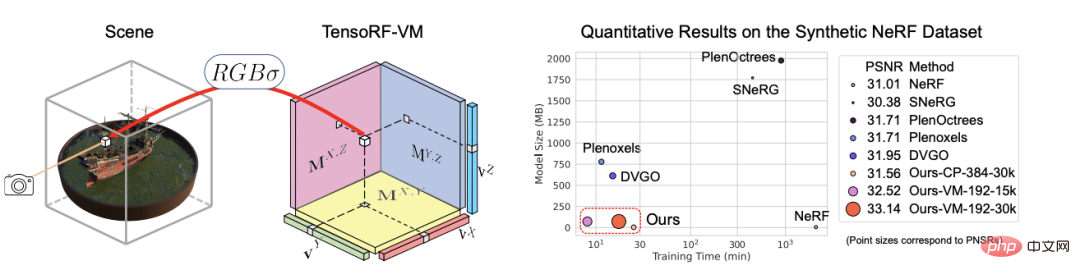

4. TensoRF: Tensorial Radiance Fields

논문 링크: https://arxiv.org/abs/2203.09517

인용 수: 110

TensoRF는 기사에서 제안되었습니다. , 방사선장을 모델링하고 재구성하는 새로운 방법.

순전히 MLP를 사용하는 NeRF와 달리 연구원들은 장면의 방사선장을 4D 텐서로 모델링하여 복셀별 다중 채널 기능을 갖춘 3차원 복셀 그리드를 표현하며, 중심 아이디어는 4D 장면을 분해하는 것입니다. 텐서를 여러 개의 소형 하위 텐서 구성요소로 변환합니다.

이 프레임워크에 전통적인 CP 분해를 적용하면 텐서를 컴팩트 벡터를 사용하여 순위 1 구성 요소로 분해하면 일반 NeRF보다 더 나은 성능을 얻을 수 있다는 것이 입증되었습니다.

성능을 더욱 향상시키기 위해 이 논문에서는 두 가지 텐서 모드의 낮은 순위 제약 조건을 완화하고 텐서를 컴팩트 벡터 및 행렬 인자로 분해하는 새로운 벡터 행렬(VM) 분해도 도입했습니다. .

더 나은 렌더링 품질 외에도 픽셀당 기능을 직접 최적화하기 위한 이전 및 동시 작업으로 인해 CP 및 VM 분해에 비해 이 모델의 메모리 공간이 상당히 늘어났습니다.

CP 분해를 사용하는 TensoRF는 NeRF에 비해 빠른 재구성(

또한, VM 분해 기능을 갖춘 TensoRF는 렌더링 품질을 더욱 향상시키고 이전의 최첨단 방법을 능가하는 동시에 재구성 시간(

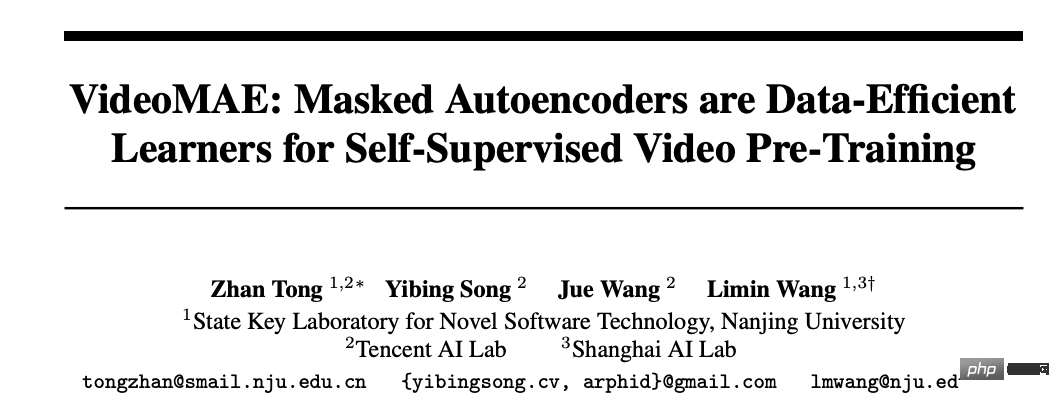

5. VideoMAE: Masked Autoencoders는 자가 감독 비디오 사전 훈련을 위한 데이터 효율적인 학습자입니다

문서 링크: https://arxiv.org/abs/2203. 12 602

코드 링크: https://github.com/MCG-NJU/VideoMAE

인용 수: 100

비교적 작은 데이터 세트에서 더 높은 성능을 달성하기 위해 일반적으로 추가 대규모 데이터 세트에 대한 비디오 변환기 사전 교육이 필요합니다.

이 문서에서는 VideoMAE(Video Masked Autoencoder)가 SSVP(자기 감독 비디오 사전 훈련)를 위한 데이터 효율적인 학습자임을 보여줍니다.

최근 ImageMAE에서 영감을 받아 연구원들은 마스크 비율이 매우 높은 맞춤형 비디오 튜브를 제안합니다. 이 단순한 디자인은 비디오 재구성을 더욱 어려운 자기 감독 작업으로 만들어 사전 훈련 과정에서 보다 효과적인 비디오 표현을 추출하도록 장려합니다.

SSVP에서 세 가지 중요한 결과를 얻었습니다.

(1) 매우 높은 비율의 마스킹 비율(예: 90% ~ 95%)은 여전히 VideoMAE의 유리한 성능을 생성할 수 있습니다. 일시적으로 중복된 비디오 콘텐츠는 이미지보다 마스킹 비율이 더 높습니다.

(2) VideoMAE는 추가 데이터를 사용하지 않고도 매우 작은 데이터 세트(예: 약 3k-4k 비디오)에서 매우 높은 성능을 달성합니다.

(3) VideoMAE는 SSVP의 경우 데이터 수량보다 데이터 품질이 더 중요하다는 것을 보여줍니다.

사전 학습 데이터세트와 대상 데이터세트 간의 도메인 이전은 중요한 문제입니다.

일반 ViT를 사용하는 VideoMAE는 추가 데이터를 사용하지 않고도 Kinetics-400에서 87.4%, Something-Something V2에서 75.4%, UCF101에서 91.3%, HMDB51에서 62.6%를 달성할 수 있다는 점에 주목할 가치가 있습니다.

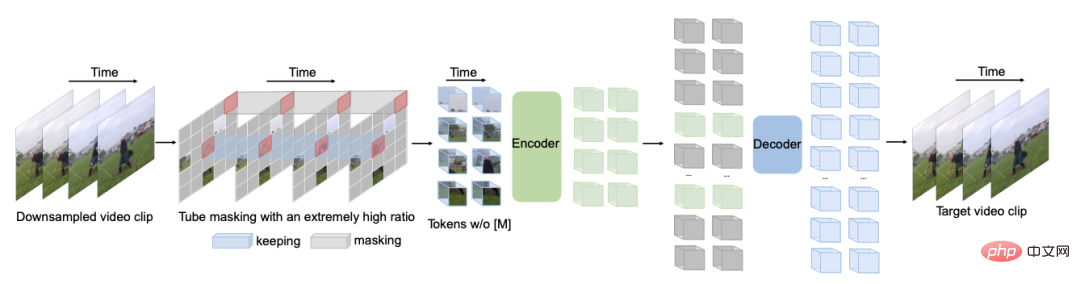

상위 100개 논문의 전체 목록

위 내용은 2022년 'AI 100대 논문' 발표: 칭화는 구글에 이어 2위, 닝보공업대학은 최대 다크호스 등극의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!