너무 멋있어서 폭발한다! HuggingGPT 온라인 시연은 놀라운 모습을 보였고, 네티즌들은 이미지 생성을 직접 테스트했습니다.

- 王林앞으로

- 2023-04-10 14:39:281640검색

가장 강력한 조합 HuggingFace+ChatGPT="Jarvis"가 이제 데모용으로 공개되었습니다.

얼마 전 절강대학교와 마이크로소프트는 대형 모델 협업 시스템인 HuggingGPT를 출시해 즉시 히트를 쳤습니다.

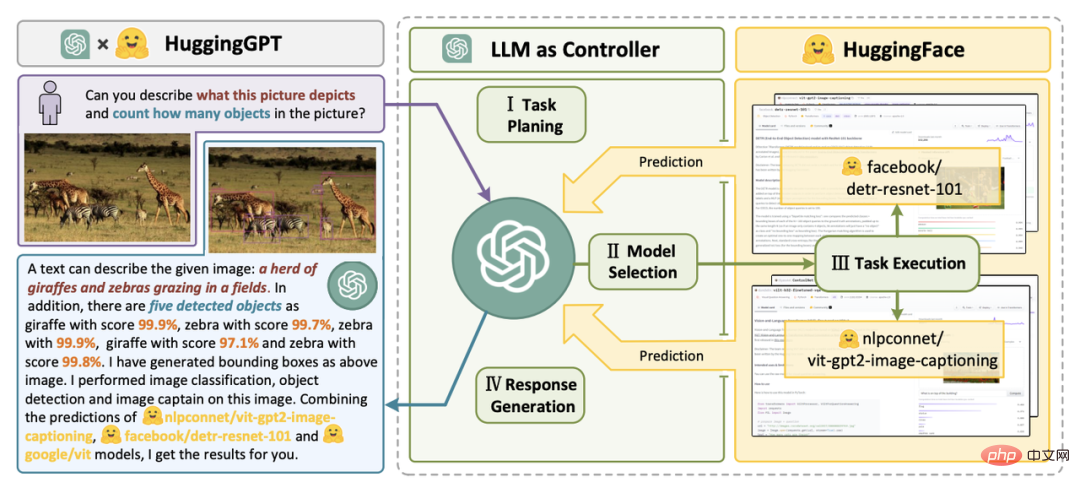

연구원들은 ChatGPT를 컨트롤러로 사용하여 HuggingFace 커뮤니티의 다양한 AI 모델을 연결하여 다중 모드의 복잡한 작업을 완료할 것을 제안했습니다.

전체 프로세스에서 해야 할 일은 요구사항을 자연어로 출력하는 것뿐입니다.

NVIDIA 과학자들은 이것이 제가 이번 주에 읽은 논문 중 가장 흥미로운 논문이라고 말했습니다. 그 아이디어는 앞서 언급한 "Everything App"과 매우 유사합니다. 즉, 모든 것이 App이고 정보가 AI에 의해 직접 읽혀진다는 것입니다.

경험해 보세요

이제 HuggingGPT에 Gradio 데모가 추가되었습니다.

프로젝트 주소 : https://github.com/microsoft/JARVIS

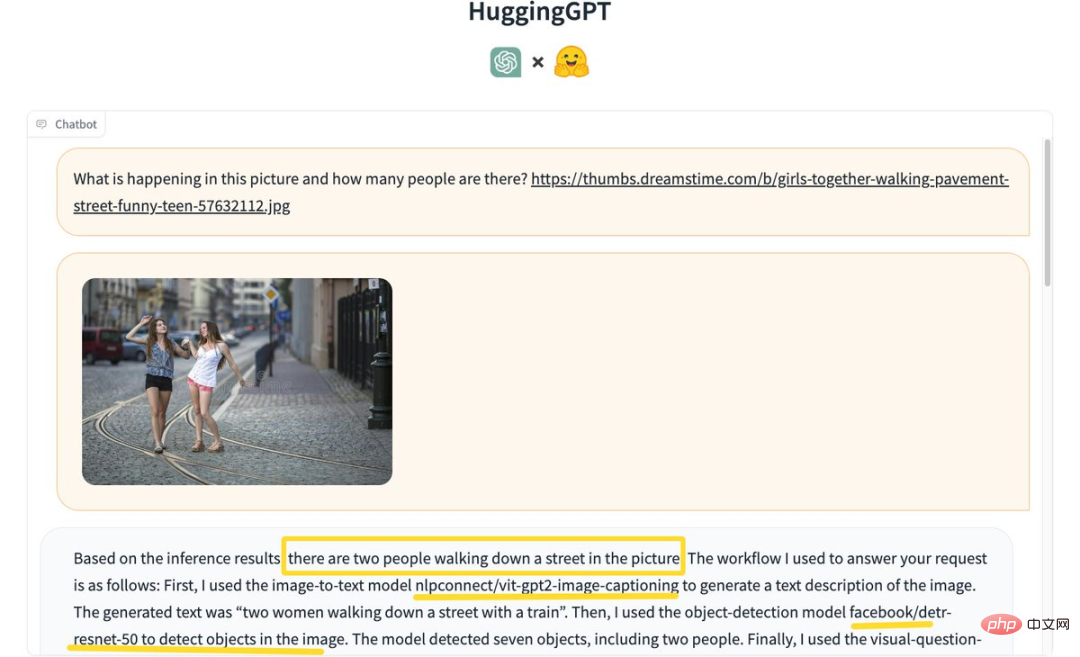

일부 네티즌들이 체험하기 시작했습니다. 먼저 "사진에 사람이 몇 명인지 알아보세요"?

HuggingGPT는 추론 결과를 바탕으로 사진 속 거리를 걷고 있는 사람이 2명이라는 결론을 내렸습니다.

구체적인 프로세스는 다음과 같습니다.

먼저 이미지를 설명하기 위해 이미지를 텍스트 모델 nlpconnect/vit-gpt2-image-captioning에 사용하고, 생성된 텍스트 "기차를 타고 거리를 걷는 두 여성" ".

다음으로, 물체 감지 모델인 facebook/detrresnet 50을 사용하여 사진 속 사람 수를 감지합니다. 모델은 7개의 물체와 2명의 사람을 감지했습니다.

그런 다음 시각적 질문 응답 모델 dandelin/vilt-b32-finetuned-vqa를 사용하여 결과를 얻으세요. 마지막으로, 시스템은 질문에 답하기 위한 상세한 답변과 모델 정보를 제공합니다.

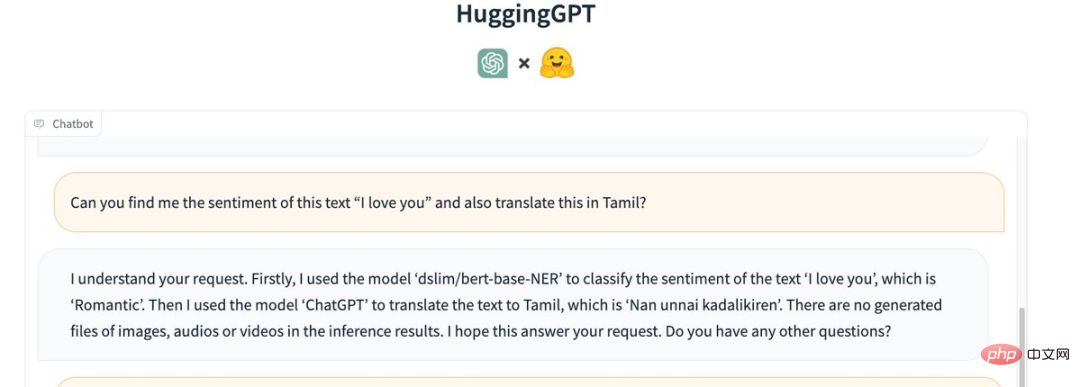

그리고 "사랑해"라는 문장의 감정을 이해하고 타밀어(타미ḻ)로 번역해보세요.

HuggingGPT는 다음 모델을 호출했습니다.

먼저 "l love you"라는 텍스트의 감정, 즉 "낭만적"을 분류하기 위해 "dslim/bert-base-NER" 모델을 사용했습니다.

그런 다음 "ChatGPT"를 사용하여 텍스트를 "Nan unnai kadalikiren"인 타밀어로 번역하세요.

추론 결과에는 생성된 이미지, 오디오 또는 비디오 파일이 없습니다.

MP3 파일을 텍스트로 변환하는 중에 HuggingGPT가 실패했습니다. 한 네티즌은 "입력 파일에 문제가 있는 것인지 모르겠다"고 말했다.

이미지 생성 기능을 살펴보자.

"춤추는 고양이"라는 이미지를 입력하고 "I LOVE YOU"라는 텍스트를 오버레이로 추가하세요.

HuggingGPT는 먼저 "runwayml/stable-diffusion-1-5" 모델을 사용하여 주어진 텍스트를 기반으로 "춤추는 고양이" 그림을 생성했습니다.

그런 다음, 동일한 모델을 사용하여 주어진 텍스트를 기반으로 "I LOVE YOU"라는 이미지를 생성했습니다.

마지막으로 두 사진을 병합하면 출력은 다음과 같습니다.

Jarvis가 현실로 다가옵니다

프로젝트가 공개된 지 며칠 만에 Jarvis는 이미 GitHub 포크에서 별 12.5,000개와 별 811개를 받았습니다. .

연구원들은 LLM(대형 언어 모델)의 현재 문제를 해결하는 것이 AGI를 향한 첫 번째이자 중요한 단계일 수 있다고 지적했습니다.

대규모 언어 모델의 현재 기술에는 여전히 일부 단점이 있기 때문에 AGI 시스템을 구축하는 과정에는 몇 가지 시급한 과제가 있습니다.

복잡한 AI 작업을 처리하려면 LLM이 외부 모델과 협력하여 해당 기능을 활용할 수 있어야 합니다.

따라서 LLM과 AI 모델을 연결하기 위해 적절한 미들웨어를 선택하는 방법이 핵심입니다.

이 연구 논문에서 연구원은 언어가 HuggingGPT의 보편적인 인터페이스라고 제안합니다. 작업 흐름은 주로 4단계로 나뉩니다:

문서 주소: https://arxiv.org/pdf/2303.17580.pdf

첫 번째는 사용자 요청을 구문 분석하고 변환합니다. 이를 여러 작업으로 분해하고 해당 지식을 기반으로 작업 순서와 종속성을 계획합니다.

다음으로 모델 선택을 진행합니다. LLM은 HuggingFace의 모델 설명을 기반으로 전문가 모델에 구문 분석된 작업을 할당합니다.

그런 다음 작업을 수행하세요. 전문가 모델은 추론 엔드포인트에서 할당된 작업을 실행하고 실행 정보와 추론 결과를 LLM에 기록합니다.

마지막 단계는 응답 생성입니다. LLM은 실행 프로세스 로그와 추론 결과를 요약하여 사용자에게 반환합니다.

다음과 같은 요청이 있다고 가정해 보겠습니다.

책을 읽고 있는 소녀의 사진을 생성하세요. 소녀의 자세는 example.jpg의 소년과 같습니다. 그런 다음 음성을 사용하여 새 이미지를 설명하세요.

HuggingGPT가 이를 6개의 하위 작업으로 분해하고 각각 실행할 모델을 선택하여 최종 결과를 얻는 방법을 확인할 수 있습니다.

AI 모델 설명을 프롬프트에 통합함으로써 ChatGPT는 AI 모델을 관리하는 두뇌로 간주될 수 있습니다. 따라서 이 방법을 사용하면 ChatGPT가 외부 모델을 호출하여 실제 작업을 해결할 수 있습니다.

간단히 말하면 HuggingGPT는 대형 모델이 아닌 협업 시스템입니다.

그 기능은 ChatGPT와 HuggingFace를 연결하여 다양한 양식의 입력을 처리하고 많은 복잡한 인공 지능 작업을 해결하는 것입니다.

따라서 HuggingFace 커뮤니티의 모든 AI 모델은 HuggingGPT 라이브러리에 해당 모델 설명이 있으며 ChatGPT와의 연결을 설정하기 위해 프롬프트에 통합됩니다.

HuggingGPT는 ChatGPT를 두뇌로 사용하여 질문에 대한 답을 결정합니다.

지금까지 HuggingGPT는 ChatGPT를 중심으로 HuggingFace에 수백 개의 모델을 통합했으며, 이는 텍스트 분류, 대상 감지, 의미론적 분할, 이미지 생성, 질문 및 답변, 텍스트 음성 변환, 텍스트를 비디오로 변환 등 24개 작업을 포괄합니다.

실험 결과는 HuggingGPT가 다양한 형태의 복잡한 작업에서 좋은 성능을 발휘할 수 있음을 입증합니다.

네티즌들의 뜨거운 댓글

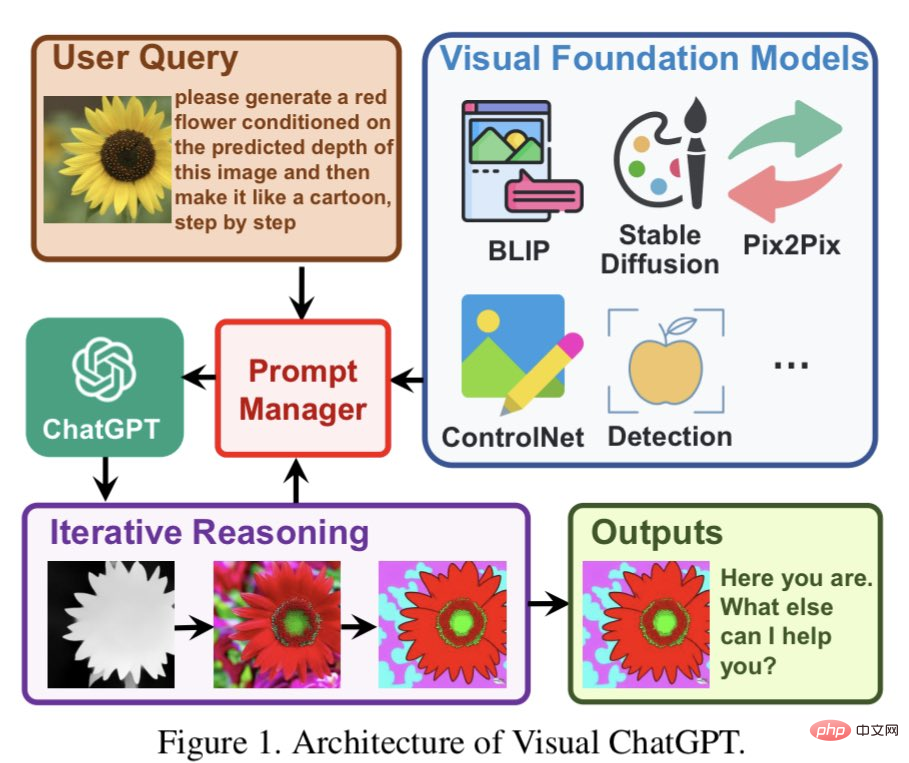

일부 네티즌들은 HuggingGPT가 이전에 Microsoft가 제안한 Visual ChatGPT와 유사하다고 말했습니다. 원래 아이디어를 사전 훈련된 대규모 모델 세트로 확장한 것 같습니다.

Visual ChatGPT는 ChatGPT에 직접 구축되었으며 여기에 많은 시각적 모델(VFM)을 주입합니다. 프롬프트 관리는 기사에서 제안됩니다.

PM의 도움으로 ChatGPT는 이러한 VFM을 활용하고 사용자 요구 사항이 충족되거나 최종 조건에 도달할 때까지 반복적인 방식으로 피드백을 받을 수 있습니다.

일부 네티즌들은 이 아이디어가 실제로 ChatGPT와 매우 유사하다고 생각합니다. LLM을 의미론적 이해 및 작업 계획의 중심으로 사용하면 LLM의 기능이 무한히 향상될 수 있습니다. LLM을 다른 기능 또는 도메인 전문가와 결합함으로써 다양한 작업과 요구 사항에 더 잘 적응할 수 있는 더욱 강력하고 유연한 AI 시스템을 만들 수 있습니다.

이것이 제가 AGI에 대해 항상 생각해온 것입니다. 인공 지능 모델은 복잡한 작업을 이해한 다음 더 전문적인 다른 AI 모델에 더 작은 작업을 할당할 수 있습니다.

뇌와 마찬가지로 뇌도 특정 작업을 수행하기 위한 다양한 부분을 가지고 있어 매우 논리적으로 들립니다.

위 내용은 너무 멋있어서 폭발한다! HuggingGPT 온라인 시연은 놀라운 모습을 보였고, 네티즌들은 이미지 생성을 직접 테스트했습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!