장애물 없이 두 모델을 병합하면 대규모 ResNet 모델의 선형 연결이 단 몇 초 만에 완료되어 신경망에 대한 새로운 연구에 영감을 줍니다.

- 王林앞으로

- 2023-04-09 15:41:031692검색

딥 러닝이 이러한 성과를 거둘 수 있었던 것은 대규모의 비볼록 최적화 문제를 비교적 쉽게 해결할 수 있는 능력 덕분입니다. 비볼록 최적화는 NP-하드이지만 일반적으로 SGD(확률적 경사하강법)의 변형인 일부 간단한 알고리즘은 실제로 대규모 신경망을 피팅하는 데 놀라운 효율성을 보여주었습니다.

이 기사에서 University of Washington의 여러 학자들은 "Git Re-Basin: Merging Models modulo Permutation Symmetries"를 작성하여 딥 러닝의 고차원 비볼록 최적화 문제에 대한 SGD 알고리즘의 비합리적인 효율성을 연구했습니다. . 그들은 세 가지 질문에서 영감을 얻었습니다:

1. SGD가 고차원 비볼록 딥 러닝 손실 환경의 최적화에서 우수한 성능을 보이는 반면, 정책 학습, 궤적 최적화 및 추천과 같은 기타 비볼록 최적화 설정에서는 견고함을 유지하는 이유 시스템 대폭 감소?

2. 지역 최소값은 어디인가요? 초기화 가중치와 최종 훈련 가중치 사이를 선형 보간할 때 손실이 부드럽고 단조롭게 감소하는 이유는 무엇입니까?

3. 무작위 초기화와 데이터 일괄 처리 순서가 다른 두 개의 독립적으로 훈련된 모델이 거의 동일한 성능을 달성하는 이유는 무엇입니까? 또한 훈련 손실 곡선이 왜 동일하게 보이므로 다양한 훈련이 거의 동일한 성능을 나타냅니까?

왜 이런 일이 일어나는 걸까요? 2019년에 Brea 등은 신경망의 숨겨진 단위가 배열 대칭을 가지고 있음을 발견했습니다. 간단히 말해서, 네트워크의 숨겨진 계층에서 두 개의 유닛을 교환할 수 있으며 네트워크 기능은 동일하게 유지됩니다. Entezari et al.(2021)은 이러한 순열 대칭을 통해 손실을 타협하지 않고 가중치 공간의 점을 선형으로 연결할 수 있다고 추측했습니다.

왜 이런 일이 일어나는 걸까요? 2019년에 Brea 등은 신경망의 숨겨진 단위가 배열 대칭을 가지고 있음을 발견했습니다. 간단히 말해서, 네트워크의 숨겨진 계층에서 두 개의 유닛을 교환할 수 있으며 네트워크 기능은 동일하게 유지됩니다. Entezari et al.(2021)은 이러한 순열 대칭을 통해 손실을 타협하지 않고 가중치 공간의 점을 선형으로 연결할 수 있다고 추측했습니다.

아래에서는 모든 사람이 기사를 더 명확하게 이해할 수 있도록 기사의 주요 목적을 설명하기 위해 기사 작성자 중 한 사람의 예를 사용합니다.

나는 A 모델을 훈련했고 친구는 B 모델을 훈련했다고 가정하면, 두 모델의 훈련 데이터는 다를 수 있습니다. 문제가 되지 않습니다. 이 기사에서 제안한 Git Re-Basin을 사용하면 손실을 손상시키지 않고 가중치 공간에서 두 모델 A+B를 병합할 수 있습니다.

논문의 저자는 Git Re-Basin이 모든 신경망(NN)에 적용될 수 있다고 밝혔습니다. 그들은 처음으로 독립적으로 훈련된(사전 훈련되지 않은) 두 모델 사이를 시연했습니다. (ResNets), 장애물이 없는 선형 연결이 가능합니다.

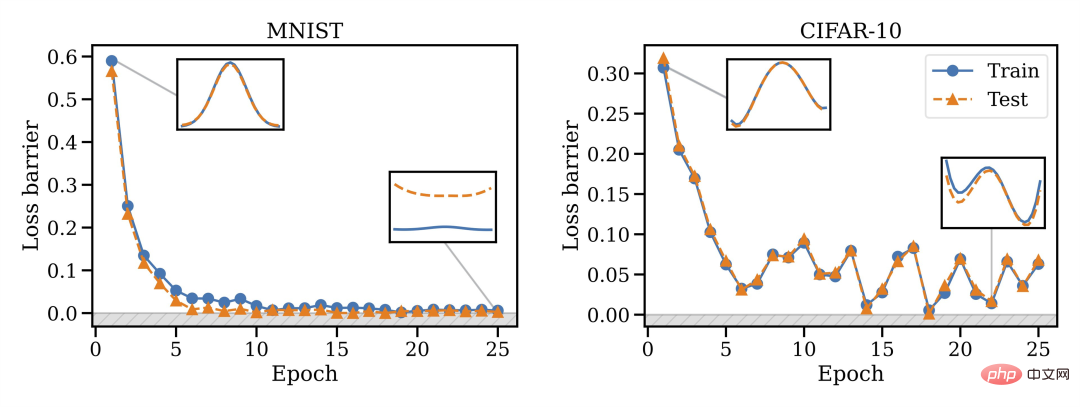

병합 능력은 SGD 교육의 속성이며, 초기화 시에는 병합이 작동하지 않지만 위상 변화가 발생하므로 시간이 지나면 병합이 가능해짐을 발견했습니다.

또한 모든 아키텍처를 병합할 수 있는 것은 아닙니다. VGG는 ResNets보다 병합하기가 더 어려운 것 같습니다.

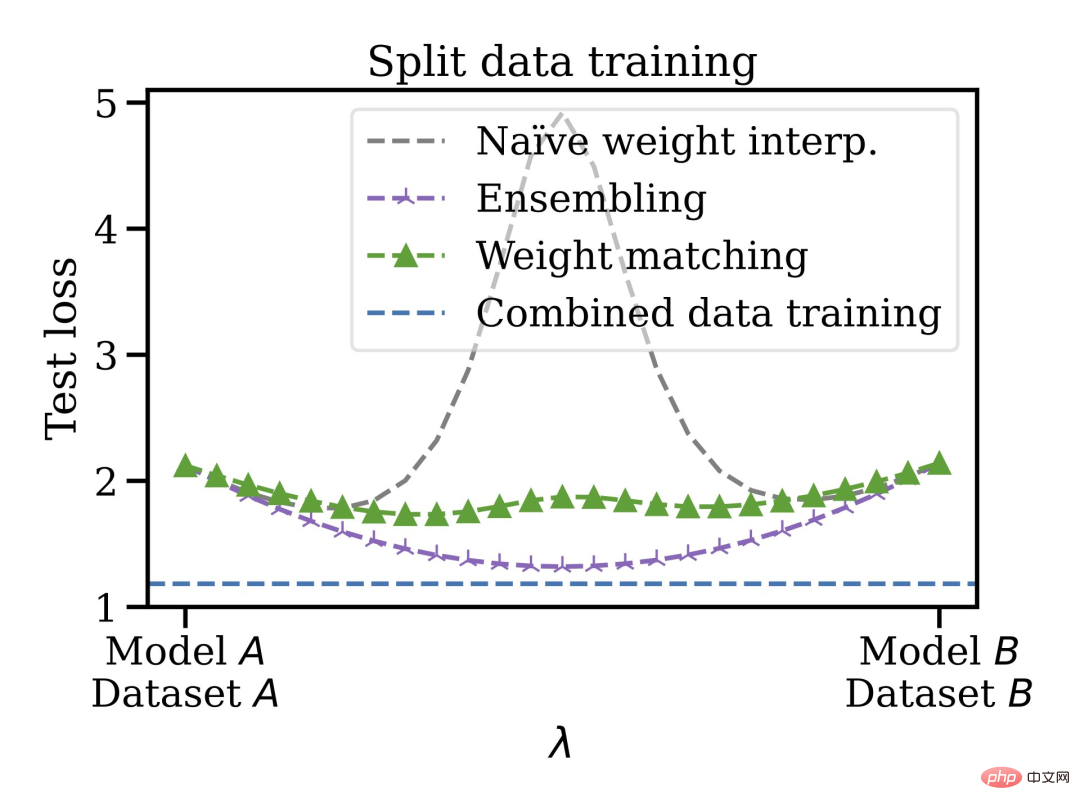

이 병합 방법에는 또 다른 장점이 있습니다. 분리되고 편향된 데이터 세트에 대해 모델을 훈련한 다음 가중치 공간에서 함께 병합할 수 있습니다. 예를 들어 일부 데이터는 미국에 있고 일부는 EU에 있습니다. 어떤 이유로 인해 데이터를 혼합할 수 없습니다. 먼저 별도의 모델을 훈련한 다음 가중치를 병합하고 마지막으로 병합된 데이터 세트로 일반화할 수 있습니다.

따라서 사전 훈련이나 미세 조정 없이 훈련된 모델을 혼합할 수 있습니다. 저자는 연합 학습, 분산 학습, 딥 러닝 최적화 등의 분야에 적용될 수 있는 선형 모드 연결 및 모델 패칭의 향후 개발 방향에 관심이 있다고 밝혔습니다.

마지막으로 3.2장의 가중치 일치 알고리즘은 실행하는 데 약 10초밖에 걸리지 않아 시간이 많이 절약된다고 언급합니다. 논문의 3장에서는 모델 A와 모델 B 유닛을 매칭하는 세 가지 방법을 소개합니다. 매칭 알고리즘이 확실하지 않은 친구들은 원본 논문을 확인해 보세요.

네티즌 댓글 및 저자 질문

이 논문은 트위터에서 열띤 토론을 촉발시켰고, PyTorch 공동 창립자인 Soumith Chintala는 이 연구가 더 큰 환경으로 옮겨질 수 있다면 달성할 수 있는 방향이 더 훌륭할 것이라고 말했습니다. . 두 모델(가중치 포함)을 병합하면 ML 모델 개발이 확장될 수 있으며 모델의 오픈 소스 공동 개발에 큰 역할을 할 수 있습니다.

다른 사람들은 순열 불변이 대부분의 등가성을 효율적으로 포착할 수 있다면 신경망에 대한 이론적 연구에 영감을 줄 것이라고 믿습니다.

논문의 제1저자이자 워싱턴 대학의 박사 학위인 Samuel Ainsworth도 네티즌들이 제기한 몇 가지 질문에 답변했습니다.

먼저 누군가가 "훈련에서 고유한 유역을 타겟팅하는 방법에 대한 팁이 논문에 있습니까? 순열을 추상화하는 방법이 있다면 훈련이 더 빨라질 수 있습니다."라고 물었습니다.

Ainsworth는 이렇게 대답했습니다. 그는 이것을 생각하지 않았습니다. 그는 정말로 어떻게든 더 빨리 훈련할 수 있기를 희망하지만 지금까지는 그것이 매우 어려운 것으로 입증되었습니다. 문제는 SGD가 본질적으로 로컬 검색이므로 고차 기하학을 활용하는 것이 쉽지 않다는 것입니다. 아마도 분산 교육이 갈 길일 것입니다.

RNN이나 Transformers에도 적용 가능한지 문의하시는 분들도 계시죠? Ainsworth는 이것이 원칙적으로는 작동하지만 아직 실험해 본 적은 없다고 말했습니다. 시간이 모든 것을 증명할 것입니다. ㅋㅋㅋ 그 자신은 DDPM에 대해 잘 알지 못하지만 이를 분산 교육에 사용하면 매우 흥미로울 것이라고 퉁명스럽게 말했습니다.

위 내용은 장애물 없이 두 모델을 병합하면 대규모 ResNet 모델의 선형 연결이 단 몇 초 만에 완료되어 신경망에 대한 새로운 연구에 영감을 줍니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!