AI가 회화 예술을 만나면 어떤 불꽃이 튀어나올까?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB앞으로

- 2023-04-08 18:21:011478검색

머리말

AI란 무엇인가요? 여러분은 마음속에 뉴런이 하나씩 쌓여 있는 신경망을 생각할 수 있습니다. 그렇다면 회화 예술이란 무엇인가? 다빈치의 '모나리자 스마일'인가요, 반고흐의 '별이 빛나는 밤'과 '해바라기'인가요, 아니면 요하네스 베르메르의 '진주 귀걸이를 한 소녀'인가요? AI가 회화예술을 만났을 때, 그들 사이에는 어떤 불꽃이 일어날 수 있을까?

2021년 초 OpenAI 팀은 텍스트 설명을 기반으로 이미지를 생성할 수 있는 DALL-E 모델을 출시했습니다. 강력한 크로스 모달 이미지 생성 기능으로 인해 자연어 및 시각적 원형 기술 애호가들 사이에서 강한 관심을 불러일으켰습니다. 불과 1년여 만에 멀티모달 이미지 생성 기술이 비가 내린 뒤 버섯처럼 등장하기 시작했습니다. 이 기간 동안 최근 인기를 끌고 있는 Disco Diffusion과 같이 이러한 기술을 AI 예술 창작에 사용하는 많은 애플리케이션이 탄생했습니다. 요즘 이러한 응용 프로그램은 점차 예술 창작자와 일반 대중의 시야에 들어가고 있으며 많은 사람들의 입에서 "마술 펜 Ma Liang"이 되었습니다.

이 글은 기술적 관심에서 시작하여 다중 모드 이미지 생성 기술과 고전 작품을 소개하고 마지막으로 다중 모드 이미지 생성을 사용하여 마법 같은 AI 페인팅 아트를 만드는 방법을 탐구합니다.  저자가 Disco Diffusion을 이용하여 만든 AI 페인팅 작품

저자가 Disco Diffusion을 이용하여 만든 AI 페인팅 작품

멀티 모달 이미지 생성 개념

멀티 모달 이미지 생성은 텍스트, 오디오 등의 모달 정보를 활용하는 것을 가이드로 삼음 , 자연스러운 질감으로 사실적인 이미지를 생성합니다. 노이즈를 기반으로 이미지를 생성하는 기존의 단일 모드 생성 기술과 달리 다중 모드 이미지 생성은 항상 매우 어려운 작업이었습니다. 해결해야 할 문제는 주로 다음과 같습니다.

(1) "의미적 격차"를 해소하는 방법, Break 양식들 사이의 본질적인 장벽을 무너뜨리는가?

(2) 논리적이고 다양하며 고해상도의 이미지를 생성하는 방법은 무엇입니까? 지난 2년간 자연어 처리(GPT 등), 컴퓨터 비전(ViT 등), 멀티모달 사전 훈련(CLIP 등), 이미지 생성 기술 등 분야에서 Transformer를 성공적으로 적용한 것으로 대표됩니다. VAE와 GAN에 의해 점차 떠오르는 스타인 확산 모델에 의해 추월당하고 있으며, 다중 모드 이미지 생성의 개발은 통제 불능입니다.

멀티모달 이미지 생성 기술과 고전 작업

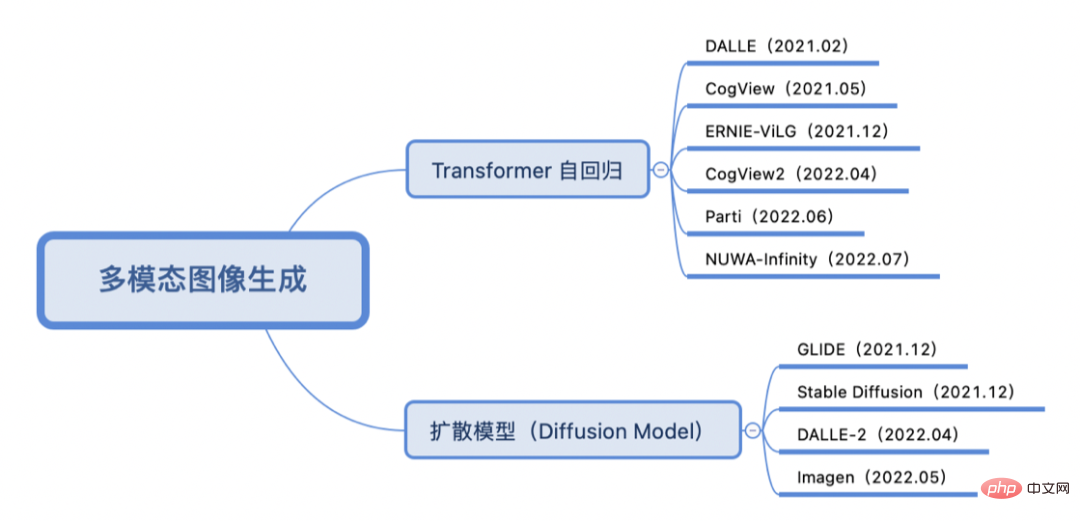

분류

훈련 방법이 Transformer autoregressive 모델인지 확산 모델인지에 따라 지난 2년간 멀티모달 이미지 생성의 핵심 작업은 다음과 같이 분류됩니다.

Transformer Autoregressive

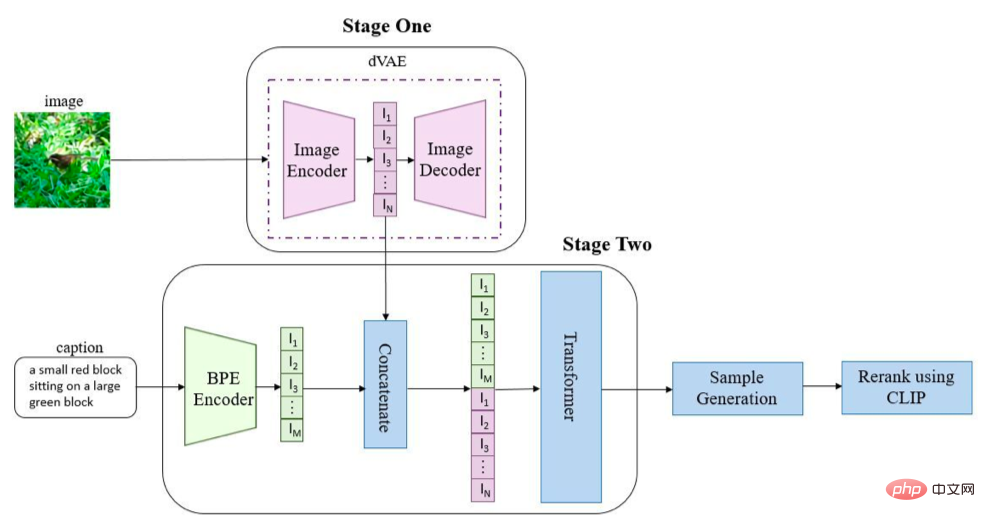

Transformer 자동 회귀 방법을 사용하는 관행에서는 종종 텍스트와 이미지를 각각 토큰 시퀀스로 변환한 다음 생성적 Transformer 아키텍처를 사용하여 텍스트 시퀀스(및 선택적 이미지 시퀀스)에서 데이터를 추출합니다. 이미지 시퀀스를 예측하고 최종적으로 이미지 생성 기술(VAE, GAN 등)을 사용하여 이미지 시퀀스를 디코딩하여 최종 생성 이미지를 얻습니다. DALL-E(OpenAI) [1]을 예로 들어 보겠습니다.

이미지와 텍스트는 해당 인코더를 통해 시퀀스로 변환되고 함께 연결되어 자동 회귀 시퀀스를 위해 Transformer(여기에서는 GPT3가 사용됨)로 전송됩니다. 세대 . 추론 단계에서는 사전 훈련된 CLIP을 사용하여 텍스트와 생성된 이미지 간의 유사성을 계산하고 정렬 후 최종 생성된 이미지의 출력을 얻습니다. DALL-E와 유사하게 Tsinghua의 CogView 시리즈[2, 3] 및 Baidu의 ERNIE-ViLG[4]도 VQ-VAE + Transformer 아키텍처 설계를 사용하는 반면 Google의 Parti[5]는 이미지 코덱을 ViT-VQGAN으로 대체합니다. Microsoft의 NUWA-Infinity[6]는 자동 회귀 방법을 사용하여 무한한 시각적 생성을 달성합니다.

Diffusion Model

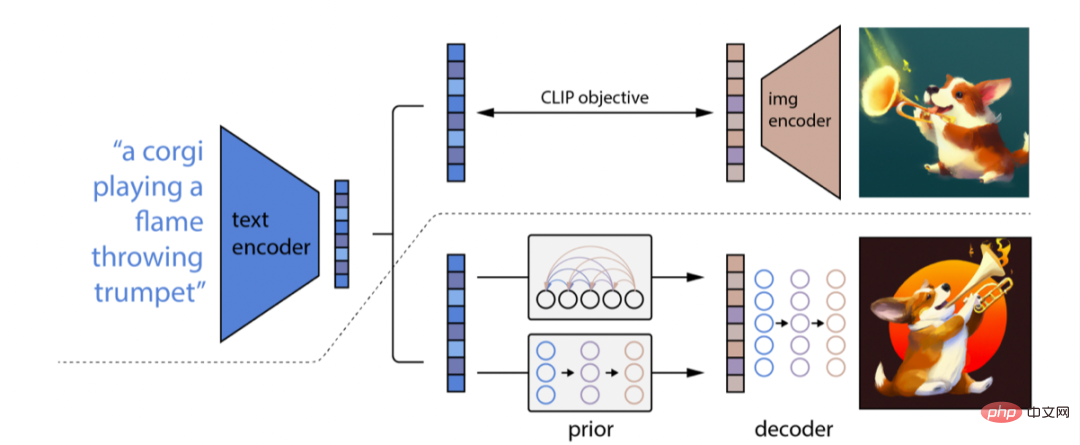

Diffusion Model은 지난 1년 동안 급속도로 발전한 이미지 생성 기술로 GAN의 종결자라 불립니다. 그림에 표시된 것처럼 확산 모델은 두 단계로 나뉩니다. (1) 노이즈: Markov 체인 확산 과정을 따라 이미지에 무작위 노이즈를 점진적으로 추가합니다. (2) 노이즈 제거: 이미지를 복원하기 위한 역확산 과정을 학습합니다. 일반적인 변형에는 DDPM(Denoising Diffusion Probabilistic Model) 등이 포함됩니다.

확산 모델을 이용한 다중 모드 이미지 생성 방법은 주로 조건부 안내가 있는 확산 모델을 통해 텍스트 특징과 이미지 특징의 매핑을 학습하고, 이미지 특징을 디코딩하여 최종 생성된 이미지를 얻습니다. DALL-E-2(OpenAI) [7]를 예로 들어보겠습니다. 비록 DALL-E의 후속작이지만 DALL-E와는 완전히 다른 기술 경로를 취하며 그 원리는 GLIDE [8]와 비슷합니다. GLIDE DALL-E-1.5로 전화하세요). DALL-E-2의 전체 아키텍처는 그림에 나와 있습니다.

DALL-E-2는 CLIP을 사용하여 텍스트를 인코딩하고 확산 모델을 사용하여 이미지 A에 대한 텍스트 특징을 얻기 위한 사전 프로세스를 학습합니다. 특징 매핑; 마지막으로 이미지 특징을 최종 이미지로 디코딩하기 위해 CLIP을 반전시키는 과정을 학습합니다. DALL-E-2와 비교하여 Google의 Imagen [9]은 사전 훈련된 T5-XXL을 사용하여 텍스트 인코딩을 위해 CLIP을 대체한 다음 초해상도 확산 모델(U-Net 아키텍처)을 사용하여 이미지 크기를 늘려 1024를 얻습니다. ✖️1024개의 HD 생성 이미지.

요약

자동 회귀 변환기의 도입과 CLIP 비교 학습 방법은 조건부 안내 확산 모델을 기반으로 텍스트와 이미지 사이의 가교를 동시에 구축하여 다양하고 높은 수준의 콘텐츠를 생성할 수 있는 기반을 마련했습니다. 해상도 이미지. 그러나 이미지 생성 품질을 평가하는 것은 주관적인 경우가 많기 때문에 여기서 Transformer 자동회귀 또는 확산 모델 기술을 비교하기는 어렵습니다. 그리고 DALL-E 시리즈, Imagen, Parti 등의 모델은 대규모 데이터 세트를 대상으로 학습되며, 이를 사용하면 윤리적 문제와 사회적 편견이 발생할 수 있으므로 이러한 모델은 아직 오픈 소스가 아닙니다. 그러나 여전히 이 기술을 사용하려는 열성팬이 많으며 이 기간 동안 플레이 가능한 애플리케이션도 많이 제작되었습니다.

AI 예술 창작

다중 모드 이미지 생성 기술의 발전은 AI 예술 창작에 더 많은 가능성을 제공합니다. 현재 널리 사용되는 AI 제작 애플리케이션 및 도구로는 CLIPDraw, VQGAN-CLIP, Disco Diffusion, DALL-E Mini, Midjourney(초대 자격 필요), DALL-E-2(내부 베타 자격 필요), Dream By Wombo(앱), Meta “Make-A-Scene”, Tiktok “AI Green Screen” 기능, Stable Diffusion[10], Baidu “Yige” 등 본 글에서는 AI 미술 창작에 주로 미술 창작계에서 유행하고 있는 Disco Diffusion을 사용하고 있습니다.

Disco Diffusion 소개

Disco Diffusion[11]은 Github에서 많은 기술 애호가들이 공동으로 관리하는 AI 예술 창작 애플리케이션입니다. 이미 여러 버전이 반복되었습니다. Disco Diffusion이라는 이름에서 그것이 사용하는 기술이 주로 CLIP을 기반으로 한 확산 모델이라는 것을 쉽게 알 수 있습니다. Disco Diffusion은 지정된 텍스트 설명(및 선택적 베이스맵)을 기반으로 예술적인 이미지나 비디오를 생성할 수 있습니다. 예를 들어 "Sea of Flowers"를 입력하면 모델이 무작위로 노이즈 이미지를 생성하고 Diffusion의 노이즈 제거 과정을 단계별로 반복하여 특정 단계에 도달하면 아름다운 이미지가 렌더링됩니다. 확산 모델의 다양한 생성 방법 덕분에 프로그램을 실행할 때마다 다른 이미지를 얻을 수 있는 이 "블라인드 박스 오프닝" 경험은 정말 매력적입니다.

Disco Diffsion에는 문제가 있습니다

현재 다중 모드 이미지 생성 모델인 Disco Diffusion(DD)을 기반으로 한 AI 생성에는 몇 가지 문제가 있습니다.

(1) 생성된 이미지의 품질은 다음과 같이 달라집니다. 생성과제, 대략적인 추정으로는 어려운 설명 내용을 포함하는 생성과제의 수율은 20~30%이며, 쉬운 설명 내용을 포함하는 생성과제의 수율은 60~70%로 대부분의 작업이 수율을 보이고 있다. 30%에서 40% 사이.

(2) 느린 생성 속도 + 많은 메모리 소비: 예를 들어 1280*768 이미지를 생성하는 데 250단계를 반복하면 약 6분이 소요되며 V100 16G 비디오 메모리를 사용합니다.

(3) 전문가 경험에 크게 의존: 적합한 설명자 세트를 선택하려면 텍스트 내용 및 가중치 설정에 대한 많은 시행착오가 필요하고, 화가의 스타일 및 예술 커뮤니티에 대한 이해가 필요하며, 텍스트 수정자를 조정해야 합니다. DD 포함 CLIP 가이드 시간/채도/대비/노이즈/컷 시간/내부 및 외부 컷/그라디언트 크기/대칭 등의 개념에 대한 깊은 이해가 있어야 하며 특정 아트 기술이 있어야 합니다. 매개변수 수가 많다는 것은 적절한 생성 이미지를 얻으려면 강력한 전문 경험이 필요하다는 것을 의미합니다.

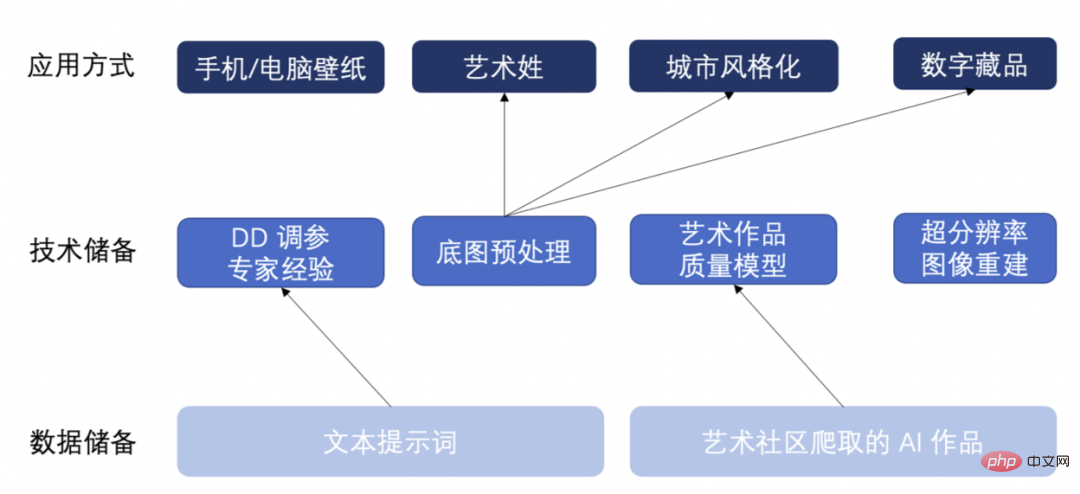

Skills Reserve

위의 문제에 대응하여 우리는 일부 데이터 및 기술을 비축했으며 YY는 향후 몇 가지 가능한 응용 프로그램을 적용했습니다. 아래 그림과 같이 :

- 첫 번째 질문에 대한 응답으로 우리는 예술 창작 커뮤니티에서 약 20,000개의 AI 생성 예술 작품을 크롤링하고 생성된 이미지의 기본 속성과 콘텐츠의 합리성을 기반으로 이를 세 가지 범주(좋은 품질/평균 품질)로 표시했습니다. /품질이 좋지 않습니다. 예술 품질 평가 모델을 훈련합니다. 이 모델은 AI가 생성한 이미지의 품질을 자동으로 평가하고 수율이 높은 이미지를 선택할 수 있어 수동으로 고품질 이미지를 선택할 때 효율성이 낮은 문제를 해결할 수 있습니다.

- 두 번째 문제는 반복 횟수를 줄이고 작은 크기의 이미지를 생성한 후 고해상도 이미지 재구성을 위해 초해상도 알고리즘 ESRGAN을 사용하여 DD의 생성 효율성을 향상시킵니다. 이 방법은 DD의 일반 반복으로 생성된 것과 동일한 이미지 효과를 얻을 수 있으며 생성 효율성과 비디오 메모리 최적화가 최소 두 배 이상 향상됩니다.

- 세 번째 질문에 대한 응답으로 우리는 다양한 베이스맵 생성 작업을 동시에 빠르게 적용할 수 있는 색온도 및 색조 조정/전경 및 배경 색상 조정/노이즈 추가 등을 포함한 일련의 베이스맵 전처리 로직을 축적했습니다. 그동안 우리는 텍스트 프롬프트 단어에 대해 많은 양의 DD 매개변수 조정 시행착오를 많이 축적했으며 전문가의 경험을 바탕으로 개인화되고 다양하며 고품질의 이미지를 생성했습니다.

이러한 데이터와 기술 보유량을 활용하여 휴대폰/컴퓨터 배경화면, 예술적 성/이름, 랜드마크 도시 스타일화, 디지털 컬렉션 등 다중 모드 이미지 생성 응용 방법을 축적했습니다. 아래에서는 AI로 생성된 구체적인 작품을 보여드리겠습니다.

AI 아트웍

도시 랜드마크 건물 스타일화

텍스트 설명과 랜드마크 도시 기본 지도를 입력하여 다양한 스타일의 그림(애니메이션 스타일/사이버펑크 스타일/픽셀 아트 스타일)이 생성됩니다.

(1) 애니메이션이 있는 건물 스타일, 작성자: makoto shinkai 및 beeple, Trending on artstation.

(2) 사이버펑크 스타일의 건물, 작성자: Gregory Grewdson, Trending on artstation.

(3) 픽셀 스타일의 건물, 작성자: Stefan Bogdanovi, Trending on artstation.

디지털 컬렉션

텍스트 설명과 베이스맵을 입력하여 베이스맵에 생성합니다.

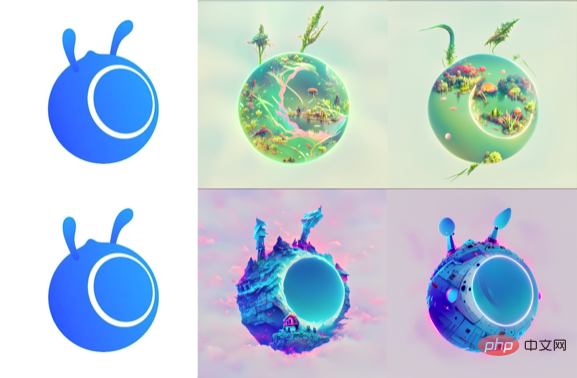

- 개미 로고 시리즈(개미 숲/개미집/개미 우주선):

(1) 식물과 호수가 있는 풍경, 작성자: RAHDS 및 beeple, Trending on artstation.(2) 절벽 가장자리에 있는 마법에 걸린 오두막 불길한 불길한 환상의 풍경, 작성자: RAHDS 및 beeple, Trending on artstation.

(3) RAHDS 및 beeple의 우주선, Trending on artstation.

- 개미-치킨 시리즈(치킨 트랜스포머/치킨 스폰지밥):

(1) 기계 갑옷을 갖춘 트랜스포머, 작성자: Alex Milne, Trending on artstation.

(2) Spongebob: RAHDS 및 beeple, Trending on artstation.

모바일/컴퓨터 배경화면

- Generate mobile wallpaper by 텍스트 설명 입력:

(1) Dan Luvisi의 난해한 꿈의 풍경, Artstation의 트렌드, 매트 페인팅 광활한 풍경.

(2) 흩어진 테라스, 겨울, 눈, Makoto Shinka의 Artstation 트렌드, 4k 배경 화면.

(3) 픽사 로코코 스타일의 스팀펑크 고래가 예고한 심연에서 솟아오르는 아틀란티스의 아름다운 클라우드펑크 그림, 아트스테이션, 볼류메트릭 조명.

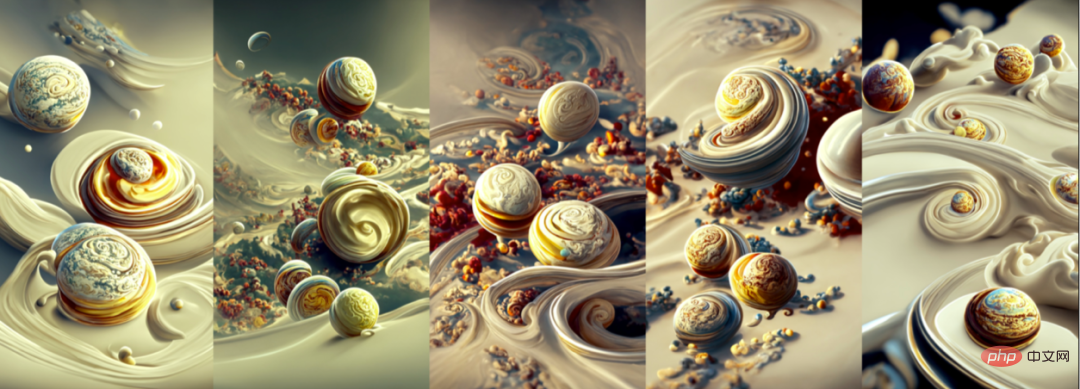

(4~8) 샹티이 크림 사이로 회전하는 행성들의 풍경 작성자: Ernst Haeckel 및 Pixar의 Artstation 트렌드, 4k 배경화면.

- 텍스트 설명을 입력하여 컴퓨터 배경화면을 생성합니다:

(1) 아름답고 아름다운 시골 들판, 초광각, 내려다보이는, 아침 작성자: Makoto Shinkai .

(2) 해바라기 바다를 가로질러 빛을 비추는 별이 빛나는 밤의 아름다운 그림 - James Gurney, Trending on artstation.

(3) 동화 증기 나라 - greg rutkowski 및 thomas kinkade Trending on artstation.

(4) Daniel Merriam, 부드러운 조명, 4K HD 배경화면, artstation 및 behance에서 인기 급상승한 꿈결 같은 풍경에 마법 같은 건물을 아름답게 렌더링했습니다.描述与姓氏底图,生成不同风格的艺术姓:

(1) 대규모 군사 공장, 기계 테스트 기계, 반제품 기계, 엔지니어링 차량, 자동화 관리, 표시기, 미래, 공상 과학, 조명 효과 , 고화질 사진.

(1) 대규모 군사 공장, 기계 테스트 기계, 반제품 기계, 엔지니어링 차량, 자동화 관리, 표시기, 미래, 공상 과학, 조명 효과 , 고화질 사진.

(2) 매시룸, 나무, 아트스테이션, 아트스테이션, 4k HD 배경화면의 아름다운 그림.(3) 소란스러운 바다를 가로질러 빛을 비추는 해바라기, 안개, 언리얼 엔진의 아름다운 그림 of blood 작성자: greg rutkowski 및 thomas kinkade, Artstation, Andreas Rocha, Greg Rutkowski.

- (4) 물 위의 파빌리온의 아름다운 그림은 John Howe, Albert Bierstadt, Alena Aenami 및 dan mumford 컨셉 아트의 반영을 제공합니다. wallpaper 4k, artstation 트렌드, 컨셉 아트, 시네마틱, 언리얼 엔진, behance 트렌드.

- (5) John Howe, Albert Bierstadt, Alena Aenami 및 dan mumford의 이국적인 식물과 나무가 있는 울창한 정글의 아름다운 풍경 컨셉 아트 배경 화면 4k, artstation의 인기, 컨셉 아트, 시네마틱, 언리얼 엔진, behance의 인기.

(6) Contra Force, Red Fortress, 우주선, Ernst Haeckel 및 Pixar 제작, 배경 화면 HD 4K, artstation의 인기.

” ” 의 刻画上更加突流.下图是笔者利用 안정적인 확산, 根据文本创작성 AI 绘画작품:

总结展望 本文主要介绍了近两年来多模态图 Image生成技术及Photo关的进展工작품, 并尝试使用多模态图image生成进行多种 AI 艺术创작품.接下来,我们还将探索多模态图image生成技术以及结会务产 AI智能创作赋能,并尝试更多如电影AI (AIGC, AI 생성 콘텐츠) 의 一种应사용 방법입니다.于当前海数据与预训练大模型的发进,AIGC 能够加速落地,为人类提供更多优质内容。了一小步? ,欢迎共创交流。 参考文献

参考文献

[1] Ramesh A, Pavlov M, Goh G, et al. 제로샷 텍스트-이미지 생성[C]//기계 학습에 관한 국제 회의. PMLR, 2021: 8821-8831.[2] Ding M, Yang Z, Hong W, et al. Cogview: Transformers[J]를 통한 텍스트-이미지 생성 마스터링. 신경 정보 처리 시스템의 발전, 2021, 34: 19822-19835.

[3] Ding M, Zheng W, Hong W, et al. CogView2: 계층적 변환기를 통해 더 빠르고 더 나은 텍스트-이미지 생성[J]. arXiv 사전 인쇄 arXiv:2204.14217, 2022.

[4] Zhang H, Yin W, Fang Y, et al. ERNIE-ViLG: 양방향 비전 언어 생성을 위한 통합 생성 사전 훈련[J]. arXiv 사전 인쇄 arXiv:2112.15283, 2021.

[11] Github: https://github.com/alembics/disco-diffusion

[12] Github: https://github.com/CompVis/stable-diffusion

위 내용은 AI가 회화 예술을 만나면 어떤 불꽃이 튀어나올까?의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!