ChatGPT 모델 매개변수 ≠ 1,750억, 누군가 모순에 의한 증명으로 증명했습니다.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB앞으로

- 2023-04-08 11:51:061141검색

ChatGPT의 인기는 오늘날까지 계속되고 있으며 이를 둘러싼 최신 뉴스와 기술적 해석이 끊임없이 등장하고 있습니다. 매개변수 수와 관련하여 ChatGPT가 GPT-3 문서에 소개된 1,750억 매개변수 모델과 동일한 수의 매개변수를 갖는다는 일반적인 가정이 있습니다. 그러나 대규모 언어 모델 분야에 깊이 종사하는 사람들은 이것이 사실이 아니라는 것을 알고 있습니다. A100 GPU의 메모리 대역폭을 분석한 결과, ChatGPT API의 실제 추론 속도는 1,750억 Dense 등가 모델의 이론상 최대 추론 속도보다 훨씬 빠르다는 것을 알 수 있습니다.

이 기사에서는 대학에서 배운 일부 이론적 지식만을 사용하여 모순 증명을 사용하여 위 주장을 증명하고 뒷받침할 것입니다. 또한 반대의 문제도 있다는 점에 유의하세요. 즉 일부 사람들은 ChatGPT에 X0억 개의 매개변수만 있다고 주장합니다(X는 1750보다 훨씬 낮습니다). 그러나 이러한 주장은 주장하는 사람들이 일반적으로 소문에 근거하여 말하기 때문에 검증될 수 없습니다.

다음 단계는 상세한 논쟁 과정입니다.

모순에 의한 증명

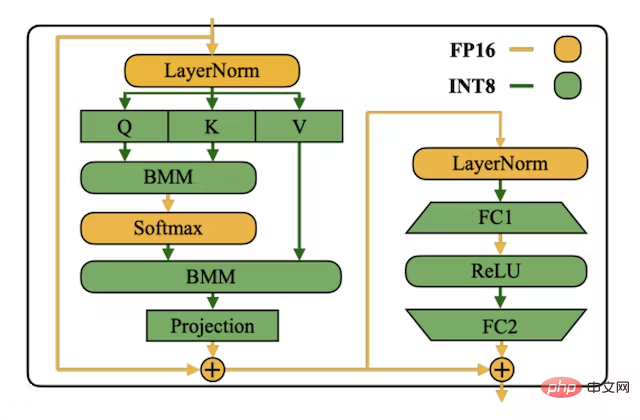

먼저 ChatGPT 모델에 1,750억 개의 매개변수가 있다고 가정합니다. 일반적으로 INT8 형식은 낮은 지연 추론, 높은 처리량 및 낮은 메모리 요구 사항을 위해 LLM 가중치를 저장하는 데 사용됩니다(float16 형식을 사용하는 것보다 두 배의 메모리가 필요함). 저장). 각 INT8 매개변수에는 저장을 위해 1바이트가 필요합니다. 간단히 계산해 보면 이 모델에는 175GB의 저장 공간이 필요하다는 것을 알 수 있습니다.

INT8 SmoothQuant 논문의 이미지: https://arxiv.org/abs/2211.10438

추론 측면에서 GPT 스타일 언어 모델은 각 순방향 패스에서 수행됩니다. 항상 "자동 회귀"이며 다음으로 가능성이 가장 높은 토큰을 예측합니다(ChatGPT와 같은 RLHF 모델의 경우 인간 주석자가 선호하는 다음 토큰을 예측합니다). 즉, 200개의 토큰이 생성되므로 200개의 정방향 패스를 수행해야 합니다. 각 순방향 패스마다 모델의 모든 가중치를 고대역폭(HBM) 메모리에서 매트릭스 컴퓨팅 장치(GPU의 텐서 컴퓨팅 코어)로 로드해야 합니다. 즉, 각 순방향 패스마다 175GB의 가중치를 로드해야 합니다. 포워드 패스.

Microsoft Azure 플랫폼에서 노드에 할당할 수 있는 최대 A100 수는 8개입니다. 이는 모델 인스턴스당 최대 텐서 병렬 처리가 8임을 의미합니다. 따라서 정방향 패스당 175GB의 가중치를 로드하는 대신, 텐서 병렬 처리가 모든 GPU에서 가중치와 계산을 병렬화할 수 있으므로 정방향 패스당 GPU당 21.87GB만 로드하면 됩니다.

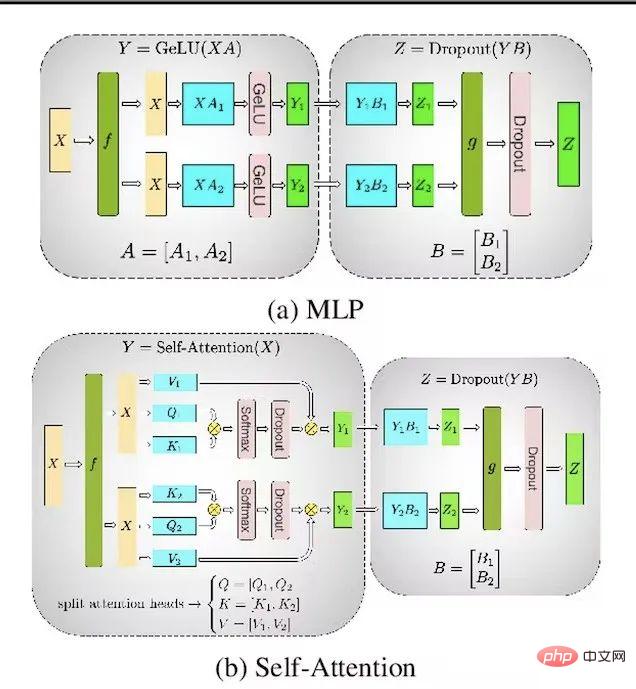

Megatron-LM 논문의 사진, 주소: https://arxiv.org/abs/1909.08053

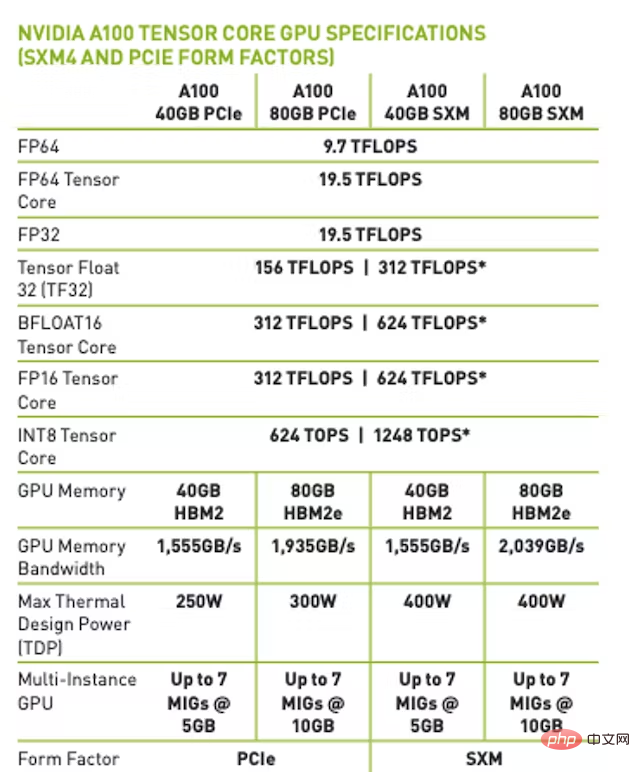

A100 80GB SXM 버전에서 최대 메모리 대역폭은 2TB/s입니다. . 이는 배치 크기=1(메모리 대역폭으로 제한됨)을 사용하면 이론적 최대 전달 속도가 초당 91회라는 의미입니다. 또한 대부분의 시간은 행렬 곱셈을 계산하는 대신 가중치를 로드하는 데 소요됩니다.

참고: fp16/bfloat16의 경우 메모리 대역폭으로 제한되면 이론상 최대 정방향 전달 속도는 45.5회/초에 도달합니다.

ChatGPT의 실제 지연 시간은 얼마나 되나요?

밤에 Python으로 작성된 스크립트를 실행하여 OpenAI API를 통해 ChatGPT 사용의 대기 시간을 테스트합니다. 정방향 패스로 달성한 최대 경험적 속도는 101회/초입니다. 본 논문에서는 OpenAI의 백엔드 및 동적 배치 처리 시스템에서 가장 낮은 오버헤드를 얻어야 하기 때문에 실험의 최대 실증적 결과를 사용합니다.

결론

이전의 가정과 주장을 바탕으로 A100 플랫폼의 메모리 대역폭을 기준으로 한 최대 이론 결과보다 실증적 결과가 훨씬 빠르기 때문에 모순이 있음을 알 수 있습니다. 따라서 OpenAI가 추론을 위해 사용하는 ChatGPT 모델은 1,750억 개의 매개변수로 구성된 밀도 모델과 확실히 동일하지 않다는 결론을 내릴 수 있습니다.

FAQ

1. 훈련 모델의 매개변수 수 대신 ChatGPT 추론 모델의 매개변수 수를 예측하는 이유는 무엇입니까?

추론 모델에만 적용되는 모델 매개변수 수를 추정하기 위해 메모리 대역폭 방법을 사용합니다. OpenAI가 추론 모델을 훈련 모델보다 작게 만들기 위해 증류와 같은 기술을 적용하는지 여부는 확실하지 않습니다.

많은 곤충은 환경에서 에너지와 영양분을 추출하는 데 최적화된 유충 형태와 여행 및 번식을 위한 매우 다양한 요구 사항에 최적화된 완전히 다른 성체 형태를 가지고 있습니다. —— Geoffrey Hinton 저, Oriol Vinyals, Jeff Dean, 2015.

2. 다른 가정이 있나요?

증명에는 실제로 3가지 가정이 포함됩니다.

- 거대한 행렬 곱셈을 계산하는 데 필요한 시간은 각 순방향 패스에서 매개변수를 로드하는 시간에 비해 0이라고 가정합니다.

- GPU는 다음과 같습니다. 통신에 소요되는 시간도 0이 됩니다. GPU 간의 통신 및 행렬 곱셈에 필요한 시간이 0으로 가정되지 않으면 1,750억 매개변수 모델의 초당 최대 이론적 토큰이 감소합니다.

- ChatGPT가 Transformer 아키텍처를 기반으로 하는 변형이라고 가정합니다.

3. 밀도 등가는 무엇을 의미하나요?

지난 몇 년 동안 연구원들은 Switch Transformer와 같은 희소 혼합 전문 LLM에 대한 연구를 수행했습니다. Dense Equivalent는 각 정방향 전달에 사용되는 매개변수 수를 나타냅니다. 이 기사에 설명된 방법을 사용하면 ChatGPT가 1,750억 개의 매개변수 희소 MoE 모델이 아니라는 것을 증명할 방법이 없습니다.

4. KV 캐시 Transformer 추론 최적화를 고려해 보셨나요?

KV 캐시 최적화를 사용하더라도 각 순방향 패스는 여전히 전체 모델을 로드해야 하며, KV 캐시는 FLOP만 절약하지만 메모리 대역폭 소비는 줄이지 않습니다(각 순방향 패스가 필요하기 때문에 실제로 증가합니다. 둘 다). KV 캐시를 로드합니다.)

5. Flash Attention을 고려해 보셨나요?

Flash Attention은 메모리 대역폭 효율성과 실시간 속도 측면에서 더 나은 성능을 발휘하지만 각 정방향 패스에는 여전히 전체 모델을 로드해야 하므로 이전 주장이 여전히 유효합니다.

6. 파이프라인 병렬 처리/보다 세분화된 병렬 전략을 고려해 보셨나요?

파이프라인 병렬성을 사용하면 최대 전달 패스 수가 동일해집니다. 그러나 마이크로 배치와 더 큰 배치 크기를 사용하면 처리량(초당 총 토큰 수)이 증가할 수 있습니다.

7. 텐서 병렬성을 8 이상으로 늘리는 것을 고려해 보셨나요?

A100 플랫폼은 노드당 16개의 A100을 지원하지만 Azure는 이 기능을 지원하지 않습니다. Google Cloud만이 이 기능을 지원하지만 이를 사용하는 사람은 거의 없습니다. Azure가 OpenAI용 16개의 A100으로 노드를 사용자 지정하고 새 노드 설계 또는 유지 관리 비용을 분산시키기 위해 공개 GA 버전으로 출시하지 않을 가능성은 거의 없습니다. 노드 간의 텐서 병렬성에 관해서는 그것은 단지 가능성일 뿐이지만 A100에서 추론을 수행하는 비용 효율성이 떨어지는 방법입니다. NVIDIA조차도 노드 간 텐서의 병렬 처리를 권장하지 않습니다.

8. INT4를 사용하여 가중치를 저장하는 것을 고려해 보셨나요?

INT4 사용이 효과적인 것으로 입증되었지만 OpenAI의 GPU 커널 컴파일러는 INT4 로드, 저장 또는 행렬 곱셈을 지원하지 않으며 기술 로드맵에 INT를 추가할 계획이 없습니다. INT4 로드 또는 저장에 대한 지원이 없기 때문에 가중치를 INT4로 저장한 다음 고정밀 형식(INT8, bfloat16 등)으로 다시 양자화할 수도 없습니다.

위 내용은 ChatGPT 모델 매개변수 ≠ 1,750억, 누군가 모순에 의한 증명으로 증명했습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!