아직도 ChatGPT를 플레이할 수 없어 걱정되시나요? 또한 다음과 같은 12가지 오픈 소스 대안을 통해 지능적인 대화를 경험할 수도 있습니다.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB앞으로

- 2023-04-08 11:41:032203검색

ChatGPT가 처음 출시된 지 거의 4개월이 지났습니다. 이 기간 동안 ChatGPT의 놀라운 성능으로 인해 AIGC가 사전에 구현될 수 있을지 궁금해졌습니다.

그러나 잘 알려진 비밀은 ChatGPT가 오픈 소스가 아닐 가능성이 높다는 것입니다. 컴퓨팅 성능과 대규모 교육 데이터에 대한 막대한 투자와 함께 연구 커뮤니티가 구현 프로세스를 복사하는 데 많은 장애물을 설정했습니다.

ChatGPT의 맹공격에 직면한 오픈 소스 대안은 유사한 기능을 달성하지만 대안을 통해 ChatGPT의 작동 메커니즘을 이해할 수도 있습니다.

기술의 발전으로 ChatGPT와 유사한 다른 많은 새로운 AI 모델이 등장했습니다. 이 기사에서는 ChatGPT의 오픈 소스 대체 프로젝트를 살펴보겠습니다. 콘텐츠는 두 부분으로 나누어집니다. 하나는 ChatGPT와 유사한 오픈 소스 프로젝트에 대한 요약이고, 다른 하나는 프로젝트 요약에 대한 보충입니다.

프로젝트 요약

프로젝트 작성자 nichtdax는 9개의 오픈 소스 ChatGPT 대체 프로젝트를 컴파일했습니다. 앞으로 하나씩 소개하겠습니다.

프로젝트 주소: https://github.com/nichtdax/awesome-totally-open-chatgpt

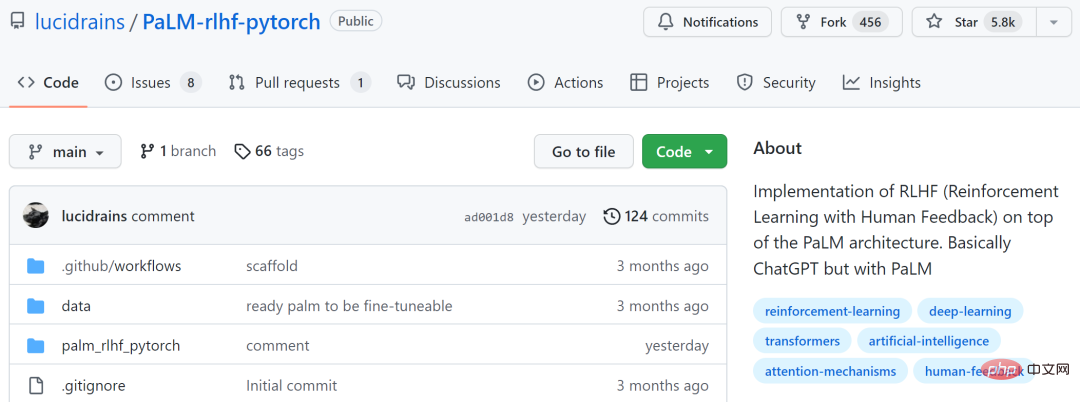

PaLM-rlhf-pytorch

번째 그 중 하나의 프로젝트는 "PaLM-rlhf-pytorch"이고, 프로젝트 작성자는 Phil Wang입니다. 이 프로젝트는 기본적으로 PaLM을 사용하는 ChatGPT인 PaLM 아키텍처 위에 RLHF(인간 피드백을 통한 강화 학습)를 구현한 것입니다.

이 프로젝트는 GitHub에서 별 5.8,000개를 받았습니다.

프로젝트 주소: https://github.com/lucidrains/PaLM-rlhf-pytorch

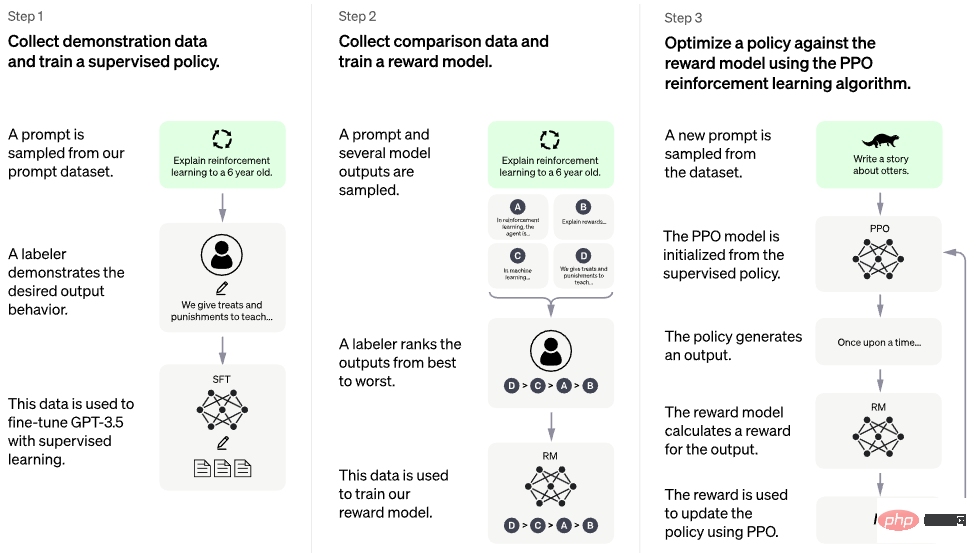

아래 그림은 훈련 과정을 보여줍니다.

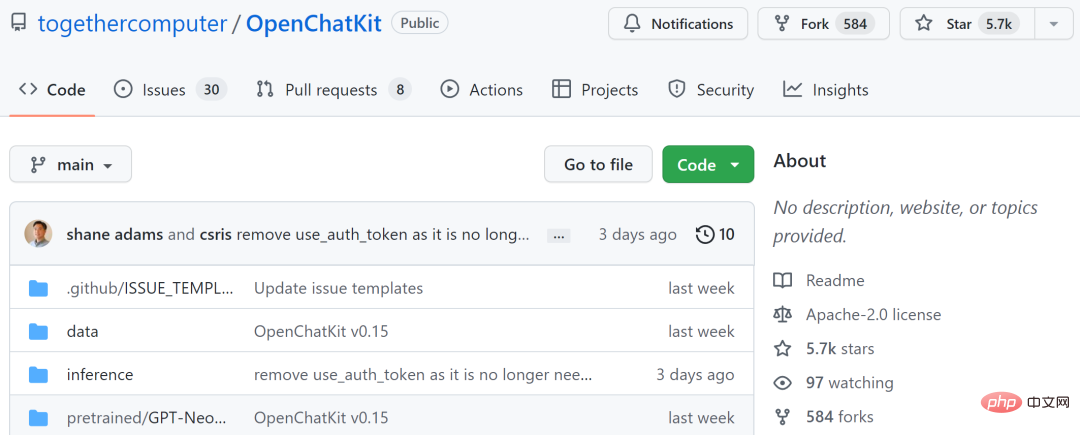

OpenChatKit

두 번째 프로젝트는 "OpenChatKit"으로, 다양한 애플리케이션에 대한 전문 및 일반 챗봇을 만들기 위한 강력한 오픈 소스 기반을 제공합니다. 이 키트에는 명령 조정된 200억 개의 매개변수 언어 모델, 60억 개의 매개변수 조정 모델 및 사용자 정의 저장소의 최신 응답을 처리하는 확장 가능한 검색 시스템이 포함되어 있습니다.

OpenChatKit은 Together, LAION 및 Ontocord.ai가 결합된 OIG-43M 교육 데이터 세트로 교육됩니다. 프로젝트 작성자는 이것이 모델의 출시일 뿐만 아니라 오픈 소스 프로젝트의 시작이라고 말했습니다. 그들은 일련의 도구와 프로세스를 출시하고 커뮤니티 기여를 통해 지속적으로 개선하고 있습니다.

이 프로젝트는 GitHub에서 별 57,000개를 받았습니다.

프로젝트 주소: https://github.com/togethercomputer/OpenChatKit

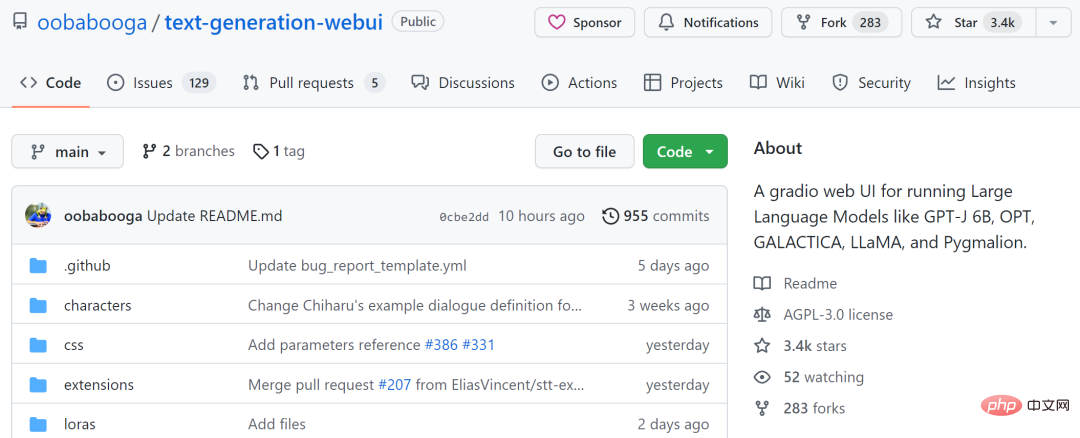

text- Generation-webui

세 번째 프로젝트는 "text- Generation-webui"입니다. GPT-J 6B, OPT, GALACTICA, LLaMA 및 Pygmalion과 같은 대규모 언어 모델을 실행하기 위한 그래디언트 웹 UI입니다. 본 프로젝트는 텍스트 생성의 AUTOMATIC1111/stable-diffusion-webui를 목표로 합니다.

드롭다운 메뉴를 사용하여 다양한 모델 간 전환, OpenAI 플레이그라운드와 유사한 노트북 모드 제공, 대화 및 롤플레잉을 위한 채팅 모드, GPT-4chan을 위한 아름다운 HTML 출력 생성 등의 기능이 포함되어 있습니다.

이 프로젝트는 GitHub에서 3.4k를 받았습니다.

프로젝트 주소: https://github.com/oobabooga/text- Generation-webui

KoboldAI-Client

네 번째 프로젝트는 "KoboldAI-Client"입니다. 여러 로컬 및 원격 AI 모델을 통해 AI 지원 쓰기를 구현하는 브라우저 기반 프런트 엔드입니다.

KoboldAI-Client는 메모리, 작성자 노트, 세계 정보, 저장 및 로드, 조정 가능한 AI 설정, 서식 지정 옵션 및 기존 텍스트 어드벤처 게임 AI Dungeon 가져오기 기능을 포함한 표준 도구 세트를 제공합니다. Adventure 모드를 켜거나 AI Dungeon Unleashed와 같은 게임을 플레이할 수 있습니다.

이 프로젝트는 GitHub에서 1.4k를 받았습니다.

프로젝트 주소 : https://github.com/KoboldAI/KoboldAI-Client

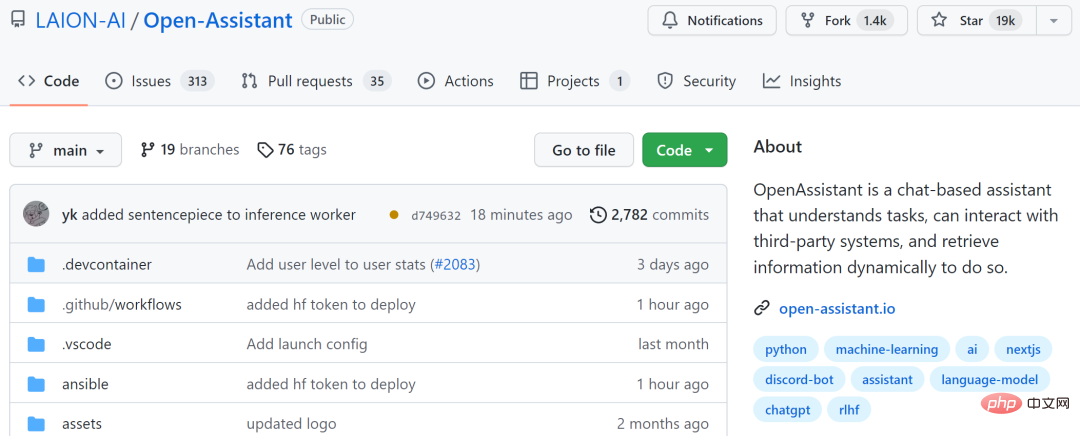

Open-Assistant

다섯 번째 프로젝트는 "Open-Assistant"로 누구나 접근할 수 있는 대규모 채팅 기반 언어 모델. 안정적인 확산이 세계가 새로운 방식으로 예술과 이미지를 창조하는 데 도움이 되는 것처럼 프로젝트 작성자는 언어 혁신에 혁명을 일으키기를 희망합니다.

프로젝트 작성자는 50,000개 이상의 목표를 가지고 수동으로 생성된 고품질 명령 실행 샘플(명령 + 응답)을 수집할 계획입니다. 수집된 각 표시에 대해 여러 완료 결과를 샘플링합니다. 다음으로, 지시 및 보상 모델을 기반으로 RLHF 훈련 단계에 들어갑니다.

이 프로젝트는 GitHub에서 19,000개의 별을 받았습니다.

프로젝트 주소 : https://github.com/LAION-AI/Open-Assistant

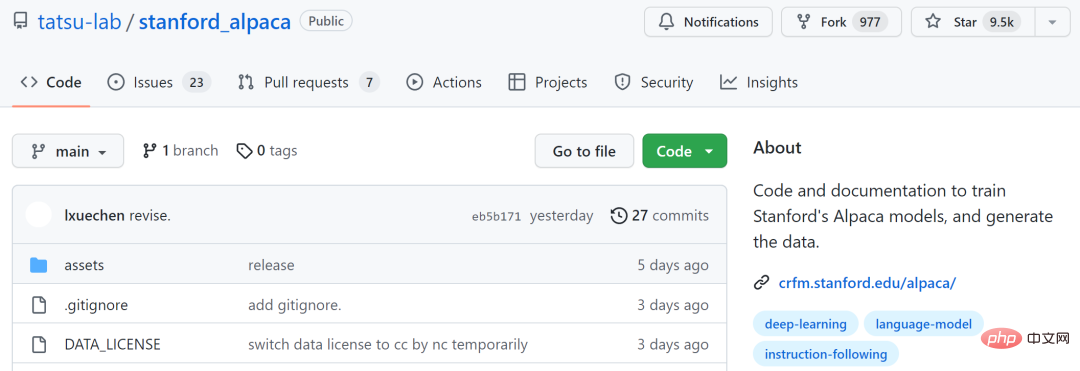

stanford_alpaca

여섯 번째 프로젝트는 "stanford_alpaca"로, 구축하고 공유하는 것을 목표로 합니다. 지침이 따르는 LLaMA 모델. 이 저장소에는 모델 미세 조정을 위한 52k 데이터, 데이터 생성을 위한 코드 및 모델 미세 조정을 위한 코드가 포함되어 있습니다.

이 프로젝트는 GitHub에서 별 9.5,000개를 받았습니다.

프로젝트 주소: https://github.com/tatsu-lab/stanford_alpaca

ChatRWKV

7번째 프로젝트는 "ChatRWKV"로, ChatGPT와 유사하지만 RWKV(100% RNN) 모델을 기반으로 지원되며 오픈 소스입니다. 프로젝트 작성자에 따르면 RWKV는 현재 품질과 확장성 측면에서 트랜스포머와 일치할 수 있는 동시에 더 빠르고 VRAM을 절약할 수 있는 유일한 RNN 모델입니다.

이 프로젝트는 GitHub에서 별 3.5,000개를 받았습니다.

프로젝트 주소: https://github.com/BlinkDL/ChatRWKV

ChatGLM-6B

8번째 프로젝트는 Zhipu AI사의 오픈 소스 중국어-영어 이중 언어 대화 언어 모델인 "ChatGLM-6B"입니다. 이는 Tsinghua의 기술 성과를 변형한 GLM(일반 언어 모델) 아키텍처를 기반으로 합니다. 62억 개의 매개변수. 모델 양자화 기술과 결합하여 사용자는 이를 소비자급 그래픽 카드에 로컬로 배포할 수 있습니다(INT4 양자화 수준에서는 최소 6GB의 비디오 메모리가 필요함).

ChatGLM-6B는 ChatGPT와 유사한 기술을 사용하며 중국어 Q&A 및 대화에 최적화되어 있습니다. 감독된 미세 조정, 피드백 셀프 서비스, 인간 피드백 강화 학습 및 기타 기술로 보완된 약 1T 식별자를 사용하여 중국어와 영어로 된 이중 언어 교육을 마친 후 62억 개의 매개변수 ChatGLM-6B는 다음과 상당히 일치하는 답변을 생성할 수 있었습니다. 인간의 선호.

그러나 ChatGLM-6B의 규모가 작기 때문에 현재는 사실적/수학적 논리 오류, 유해/편향된 콘텐츠 생성 가능성, 취약한 상황별 기능, 자체 처리 능력 등 몇 가지 제한 사항이 있는 것으로 알려져 있습니다. 혼란, 그리고 중국어 지시와 완전히 모순되는 영어 지시의 생성.

이 프로젝트는 GitHub에서 6,000개의 별을 받았습니다.

프로젝트 주소 : https://github.com/THUDM/ChatGLM-6B

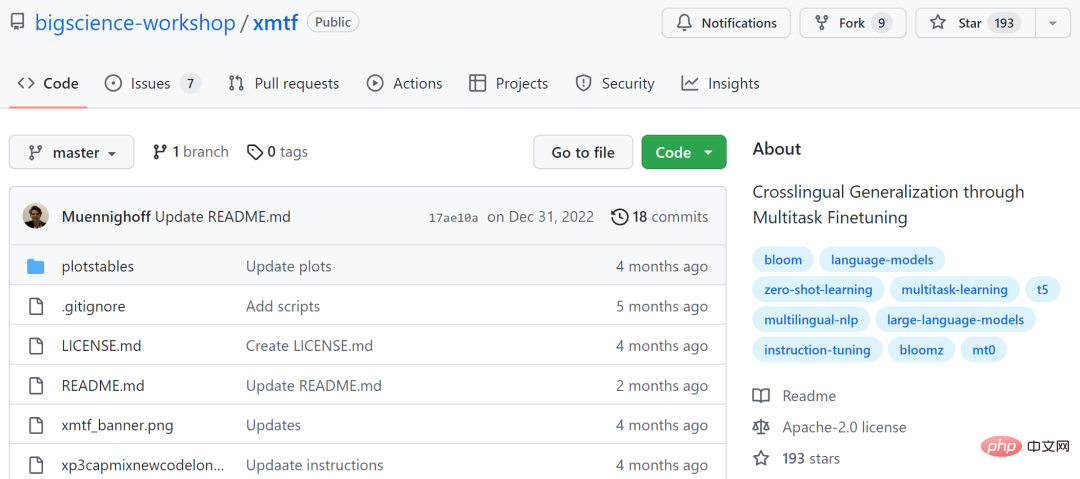

xmtf

9번째 프로젝트는 "xmtf"로, "Crosslingual Generalization"이라는 창작논문을 담고 있습니다. " BLOOMZ, mT0, xP3의 모든 구성 요소는 "멀티태스크 미세 조정을 통해"에서 소개되었습니다.

그중 BLOOMZ는 1,760억 개의 매개변수와 개방형 액세스 다중 언어 모델입니다. mT0(여기서는 구체적으로 Google의 T5X를 나타냄)는 영어와 기계 번역으로 된 프롬프트가 포함된 46개 언어로 관리되는 데이터 세트입니다.

프로젝트 주소: https://github.com/bigscience-workshop/xmtf

ChatGPT 대체 프로젝트에는 위에서 언급한 모델 외에도 Meta 기반의 대형 모델도 포함되어 있습니다. 오픈 소스 LLaMA(Large Language Model Meta AI) 시리즈에 대한 일부 연구 이 모델 시리즈의 매개변수 수는 70억 ~ 650억 개입니다. 130억 개의 매개변수가 있는 LLaMA 모델은 "대부분의 벤치마크에서" GPT-3(1,750억 개의 매개변수)보다 성능이 뛰어나고 단일 V100 GPU에서 실행될 수 있으며, 650억 개의 매개변수가 있는 가장 큰 LLaMA 모델은 Google Chinchilla-70B 및 PaLM과 비슷합니다. 540B.

- 논문 링크: https://research.facebook.com/publications/llama-open-and-efficient-foundation-언어-models/

- GitHub 링크: https://github. com/facebookresearch/llama

이 연구를 바탕으로 개발자들은 여러 오픈 소스 프로젝트도 제안했습니다.

llama.cpp는 GPU 없이 LLaMA를 실행할 수 있습니다

llama.cpp 프로젝트는 MacBook에서 실행되는 LLaMA를 구현했으며 개발자는 4GB RAM이 있는 Raspberry Pi에서 LLaMA 7B를 성공적으로 실행했습니다. 요약하면 개발자는 GPU가 없어도 LLaMA 모델을 실행할 수 있습니다.

프로젝트 주소: https://github.com/ggerganov/llama.cpp

ChatLLaMA

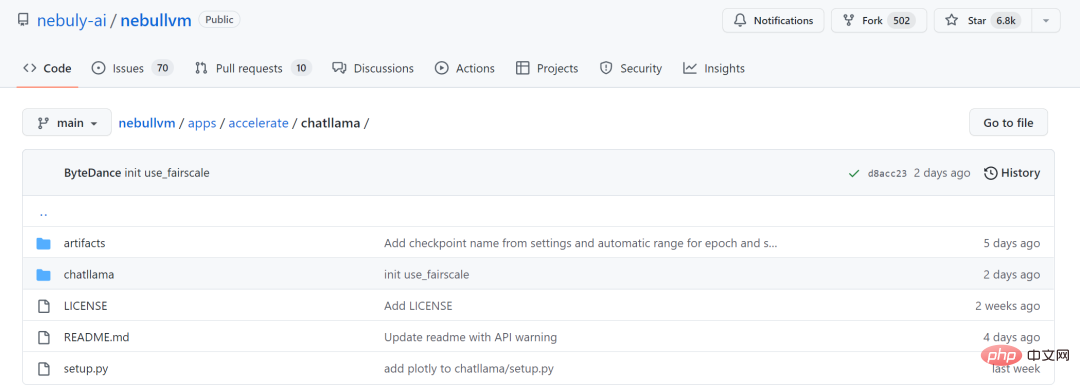

LLaMA 대형 모델 시리즈는 RLHF 방식을 사용하지 않기 때문에 스타트업 Nebuly AI는 LLaMA(ChatLLaMA)의 RLHF 버전 훈련 방식을 오픈소스화했습니다. 훈련 과정은 ChatGPT와 유사하며, 이 프로젝트를 통해 사전 훈련된 LLaMA 모델을 기반으로 ChatGPT 스타일 서비스를 구축할 수 있습니다. ChatGPT에 비해 LLaMA는 아키텍처가 더 작지만 훈련 프로세스와 단일 GPU 추론이 더 빠르고 저렴합니다. 또한 라이브러리는 모든 LLaMA 모델 아키텍처(7B, 13B, 33B, 65B)를 지원하므로 사용자는 다음과 같은 성능 선호도를 추론할 수 있습니다. 모델을 미세 조정합니다.

프로젝트 주소: https://github.com/nebuly-ai/nebullvm/tree/main/apps/accelerate/chatllama

더 많은 오픈 소스 프로젝트 참여를 기대합니다. 미래.

위 내용은 아직도 ChatGPT를 플레이할 수 없어 걱정되시나요? 또한 다음과 같은 12가지 오픈 소스 대안을 통해 지능적인 대화를 경험할 수도 있습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!